Справочная информация о семействе видеокарт NV4X

Справочная информация о семействе видеокарт G7X

Справочная информация о семействе видеокарт G8X/G9X

Справочная информация о семействе видеокарт GT2XX

Справочная информация о семействе видеокарт GF1XX

Справочная информация о семействе видеокарт GK1XX/GM1XX

Справочная информация о семействе видеокарт GM2XX

Спецификации чипов семейства GK1XX/GM1XX

| кодовое имя | GK110 | GK104 | GK106 | GK107 | GM107 |

| базовая статья | здесь | здесь | здесь | здесь | здесь |

| технология, нм | 28 | ||||

| транзисторов, млрд | 7,1 | 3,5 | 2,5 | 1,3 | 1,9 |

| универсальных процессоров | 2880 | 1536 | 960 | 384 | 640 |

| текстурных блоков | 240 | 128 | 80 | 32 | 40 |

| блоков блендинга | 48 | 32 | 24 | 16 | |

| шина памяти | 384 | 256 | 192 | 128 | |

| типы памяти | DDR3, GDDR5 | ||||

| системная шина | PCI Express 3.0 | ||||

| интерфейсы | DVI Dual Link HDMI DisplayPort | ||||

| вершинные шейдеры | 5.0 | ||||

| пиксельные шейдеры | 5.0 | ||||

| точность вычислений | FP32/FP64 | ||||

| Сглаживание | MSAA CSAA FXAA TXAA | ||||

Спецификации референсных карт на базе семейства GK1XX/GM1XX

| карта | чип | блоков ALU/TMU/ROP | частота ядра, МГц | частота памяти, МГц | объем памяти, ГБ | ПСП, ГБ/c (бит) | текстури- рование, Гтекс | филлрейт, Гпикс | TDP, Вт |

| GeForce GTX Titan Z | 2xGK110 | 2x(2880/240/48) | 705(876) | 1750(7000) | 2×6 GDDR5 | 2×336,4 (2×384) | 2×169 | 2×33,8 | 375 |

| GeForce GTX Titan Black | GK110 | 2880/240/48 | 889(980) | 1750(7000) | 6 GDDR5 | 336,4 (384) | 213 | 42,7 | 250 |

| GeForce GTX Titan | GK110 | 2688/224/48 | 836(876) | 1500(6000) | 6 GDDR5 | 288,4 (384) | 187,3 | 40,1 | 250 |

| GeForce GTX 780 Ti | GK110 | 2880/240/48 | 875(928) | 1750(7000) | 3 GDDR5 | 336 (384) | 210 | 42 | 250 |

| GeForce GTX 780 | GK110 | 2304/192/48 | 863(900) | 1500(6000) | 3 GDDR5 | 288,4 (384) | 165,7 | 41,4 | 250 |

| GeForce GTX 770 | GK104 | 1536/128/32 | 1046(1085) | 1750(7000) | 2-4 GDDR5 | 224,3 (256) | 133,9 | 33,5 | 230 |

| GeForce GTX 760 Ti | GK104 | 1344/112/32 | 915(980) | 1500(6000) | 2 GDDR5 | 192,3 (256) | 102,5 | 29,3 | 170 |

| GeForce GTX 760 | GK104 | 1152/96/32 | 980(1033) | 1500(6000) | 2 GDDR5 | 192,3 (256) | 94,1 | 31,4 | 170 |

| GeForce GTX 750 Ti | GM107 | 640/40/16 | 1020(1085) | 1350(5400) | 2-4 GDDR5 | 88 (128) | 40,8 | 16,3 | 60 |

| GeForce GTX 750 | GM107 | 512/32/16 | 1020(1085) | 1250(5000) | 1-2 GDDR5 | 80 (128) | 32,6 | 16,3 | 55 |

| GeForce GTX 740 | GK107 | 384/32/16 | 993 | 1250(5000) | 1-2 GDDR5 | 80,1 (128) | 31,8 | 7,9 | 64 |

| GeForce GTX 690 | 2xGK104 | 2x(1536/128/32) | 915(1019) | 1502(6008) | 2×2 GDDR5 | 384,6 (2×256) | 234,2 | 58,6 | 300 |

| GeForce GTX 680 | GK104 | 1536/128/32 | 1006(1058) | 1502(6008) | 2 GDDR5 | 192,3 (256) | 128,8 | 32,2 | 195 |

| GeForce GTX 670 | GK104 | 1344/112/32 | 915(980) | 1502(6008) | 2 GDDR5 | 192,3 (256) | 102,5 | 29,3 | 170 |

| GeForce GTX 660 Ti | GK104 | 1344/112/24 | 915(980) | 1502(6008) | 2 GDDR5 | 144,2 (192) | 102,5 | 22,0 | 150 |

| GeForce GTX 660 | GK106 | 960/80/24 | 980(1033) | 1502(6008) | 2 GDDR5 | 144,2 (192) | 78,4 | 23,5 | 140 |

| GeForce GTX 650 Ti | GK106 | 768/64/16 | 925 | 1350(5400) | 1-2 GDDR5 | 86,4 (128) | 59,2 | 14,8 | 110 |

| GeForce GTX 650 | GK107 | 384/32/16 | 1058 | 1250(5000) | 1-2 GDDR5 | 80,0 (128) | 33,9 | 16,9 | 64 |

| GeForce GT 640 | GK107 | 384/32/16 | 900 | 900(1800) | 2 DDR3 | 28,5 (128) | 28,8 | 14,4 | 65 |

Подробности: семейство GeForce GTX 600

Спецификации GK104

- Кодовое имя чипа GK104;

- Технология производства 28 нм;

- 3.54 миллиардов транзисторов;

- Площадь ядра 294 мм²;

- Унифицированная архитектура с массивом процессоров для потоковой обработки различных видов данных: вершин, пикселей и др.;

- Аппаратная поддержка DirectX 11 API, в том числе шейдерной модели Shader Model 5.0, геометрических и вычислительных шейдеров, а также тесселяции;

- 256-битная шина памяти, четыре независимых контроллера шириной по 64 бита каждый, с поддержкой GDDR5 памяти;

- Базовая частота ядра 1006 МГц;

- Средняя турбо-частота ядра 1058 МГц;

- 8 потоковых мультипроцессоров, включающих 1536 скалярных ALU для расчётов с плавающей запятой (поддержка вычислений в целочисленном формате, с плавающей запятой, с FP32 и FP64 точностью в рамках стандарта IEEE 754-2008);

- 128 блоков текстурной адресации и фильтрации с поддержкой FP16 и FP32 компонент в текстурах и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов;

- 4 широких блока ROP (32 пикселя) с поддержкой режимов антиалиасинга до 32 выборок на пиксель, в том числе при FP16 или FP32 формате буфера кадра. Каждый блок состоит из массива конфигурируемых ALU и отвечает за генерацию и сравнение Z, MSAA, блендинг;

- Интегрированная поддержка RAMDAC, двух портов Dual Link DVI, а также HDMI и DisplayPort.

- Интегрированная поддержка четырёх мониторов, включая два порта Dual Link DVI, а также HDMI 1.4a и DisplayPort 1.2

- Поддержка шины PCI Express 3.0

Спецификации референсной видеокарты GeForce GTX 690

- Базовая частота ядра 915 МГц;

- Средняя турбо-частота 1019 МГц;

- Количество универсальных процессоров 2×1536;

- Количество текстурных блоков — 2×128, блоков блендинга — 2×32;

- Эффективная частота памяти 6008 (1502×4) МГц;

- Тип памяти GDDR5, 2×256-бит шина памяти;

- Объем памяти 2×2 ГБ;

- Пропускная способность памяти 2×192.3 ГБ/с;

- Теоретическая максимальная скорость закраски 58.6 гигапикселей в секунду;

- Теоретическая скорость выборки текстур 234.2 гигатекселей в секунду;

- Три Dual Link DVI-I разъема, один DisplayPort;

- Одинарный SLI-разъем;

- Шина PCI Express 3.0;

- Энергопотребление до 300 Вт;

- Два 8-контактных разъёма питания;

- Двухслотовое исполнение;

- Рекомендуемая цена для американского рынка $999 (для России — 35999 руб)

Спецификации референсной видеокарты GeForce GTX 680

- Базовая частота ядра 1006 МГц;

- Средняя турбо-частота 1058 МГц;

- Количество универсальных процессоров 1536;

- Количество текстурных блоков — 128, блоков блендинга — 32;

- Эффективная частота памяти 6008 (1502*4) МГц;

- Тип памяти GDDR5, 256-бит шина памяти;

- Объем памяти 2 ГБ;

- Пропускная способность памяти 192.3 ГБ/с;

- Теоретическая максимальная скорость закраски 32.2 гигапикселей в секунду;

- Теоретическая скорость выборки текстур 128.8 гигатекселей в секунду;

- Два Dual Link DVI-I разъема, один HDMI, один DisplayPort;

- Двойной SLI разъем;

- Энергопотребление до 195 Вт (два 6-контактных разъёма);

- Двухслотовое исполнение;

- Рекомендуемая цена для американского рынка $499 (для России — 17999 руб).

Спецификации референсной видеокарты GeForce GTX 670

- Базовая частота ядра 915 МГц;

- Средняя турбо-частота 980 МГц;

- Количество универсальных процессоров 1344;

- Количество текстурных блоков — 112, блоков блендинга — 32;

- Эффективная частота памяти 6008 (1502×4) МГц;

- Тип памяти GDDR5, 256-бит шина памяти;

- Объем памяти 2 ГБ;

- Пропускная способность памяти 192,3 ГБ/с;

- Теоретическая максимальная скорость закраски 29,3 гигапикселей в секунду;

- Теоретическая скорость выборки текстур 102,5 гигатекселей в секунду;

- Два Dual Link DVI-I разъема, один HDMI, один DisplayPort;

- Двойной SLI разъем;

- Шина PCI Express 3.0;

- Энергопотребление до 170 Вт;

- Два 6-контактных разъёма питания;

- Двухслотовое исполнение;

- Рекомендуемая цена для американского рынка $399 (для России — 13999 руб).

Первой видеокартой на основе графического процессора GK104 стала GeForce GTX 680. Она заменила переставший выпускаться GTX 580 на базе GF110. С одной стороны, принцип наименования видеокарт NVIDIA вроде бы не изменился, топовая модель получила изменение первой цифры индекса. С другой — даже судя по кодовому имени чипа GK104, он изначально вряд ли планировался в роли именно топового решения.

Вполне вероятно, изначально это должна была быть GTX 670 (приставка Ti по вкусу) или что-то в этом роде, но потом решили повременить с настоящим топовым чипом, раз у TSMC с новым техпроцессом до сих пор дела неидеальны, и выпустить в качестве верхней модели менее мощный чип. Впрочем, мы не раз говорили о том, что наименование видеокарт всегда является маркетинговым решением, которое не особенно влияет на технические характеристики.

Правда, оно сильно влияет на розничную цену решений. По всем внешним признакам (сложность чипа, сложность печатной платы, энергопотребление, да и себестоимость, скорее всего), GTX 680 больше похожа на решение из верхнего среднего диапазона. На это же намекают и кодовые имена чипов: GF104 — GK104. Впрочем, после выхода видеоплат AMD по высоким ценам, которые не слишком сильно обогнали GeForce GTX 580, у NVIDIA появился большой соблазн поднять GK104 в верхний ценовой диапазон, заработав самим и давая заработать своим партнёрам по выпуску видеокарт.

Дело хозяйское, и рекомендуемая рыночная цена в $499 для североамериканского рынка на момент выхода стала весьма выгодной (с российской ценой чуть похуже, Radeon HD 7970 продавался у нас дешевле). Сначала на основе чипа GK104 выпущена лишь одна модель видеокарты — GeForce GTX 680, которая в будущем дополнилась более интересным для масс решением с урезанными возможностями и двухчиповой платой. Потенциальные покупатели с ещё большим удовольствием выберут GTX 670 с меньшей ценой и не слишком зарезанной производительностью, как это всегда и бывает. Но сначала NVIDIA вступила в более дорогой сектор, ведь оставшиеся GTX 570 и GTX 580 им нужно было сначала распродать.

В отличие от предшественниц на базе Fermi, новая модель платы имеет 256-битную шину памяти и соответствующий объём видеопамяти, равный 2 ГБ. Конечно, это гораздо лучше, чем 1.5 ГБ, но в современных условиях уже хуже, чем 3 ГБ, имеющиеся у некоторых моделей GTX 580 и у всех Radeon HD 7900. К сожалению, 2 ГБ — по сути, единственно возможное значение, так как 1 ГБ — это слишком мало, а 4 ГБ быстрейшей GDDR5 памяти — чересчур дорого даже для 500-долларовой видеокарты. Так что тут у конкурента есть небольшое преимущество, которое может сказаться в тяжёлых режимах и сверхвысоких разрешениях вроде 2560×1600.

Глядя на плату, сразу же отмечаешь изменившийся дизайн разъёмов дополнительного питания и то, что их два 6-контактных, что весьма удивительно для топовой модели. Изменение разъемов и их ориентации сделано для экономии места на PCB, освободившееся место заняли другие полезные элементы и кожух кулера. К слову, о полезных элементах — GPU питается от четырёх фаз, а от дополнительных двух запитана GDDR5 память. Чего вполне хватает для нетребовательной к питанию GTX 680, и даже оставляет некоторый (но, вероятно, всё же не слишком большой для любителей экстремального разгона) запас для разгона.

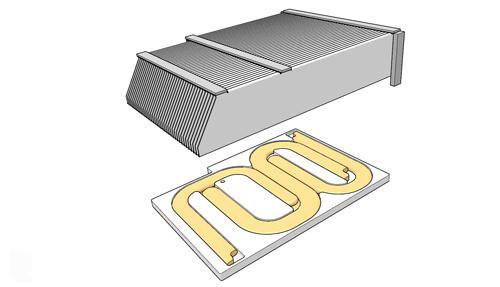

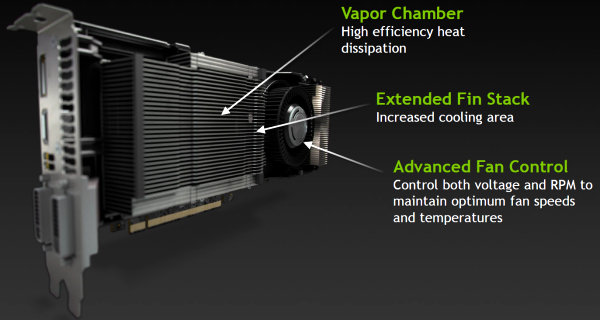

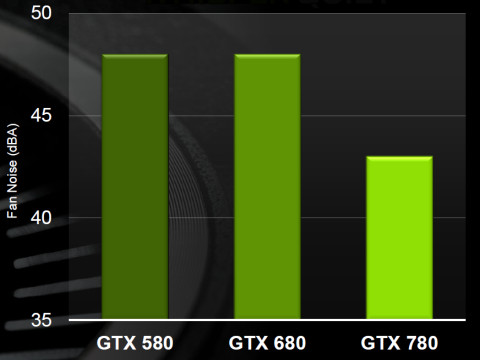

Кроме того, что GeForce GTX 680 отличается высокой производительностью и сравнительно низким потреблением энергии, новая видеокарта имеет новую систему охлаждения. Понятно, что менее греющийся чип не требует столь продвинутых кулеров, как топовые решения предыдущих поколений, поэтому система охлаждения у GTX 680 в целом стала тише. Да и в конструкции используется специальный акустический материал, снижающий уровень шума.

В подошву радиатора встроены три тепловые трубки, которые отводят основное тепло от GPU. Которое далее рассеивается двухслотовым алюминиевым радиатором с рёбрами изменённого дизайна, для лучшего его продувания вентилятором. Укороченный (по сравнению с предыдущими решениями) радиатор позволяет добиться более эффективного воздухообмена, а также сэкономить лишнюю пару баксов. Ну а для чего ещё нужны энергоэффективные решения? В том числе и для этого.

В результате, по оценкам компании NVIDIA, GeForce GTX 680 тише своего прямого конкурента (понятно, что речь о Radeon HD 7970) на 5 дБ — 46 дБ вместо 52 дБ в одинаковых условиях..

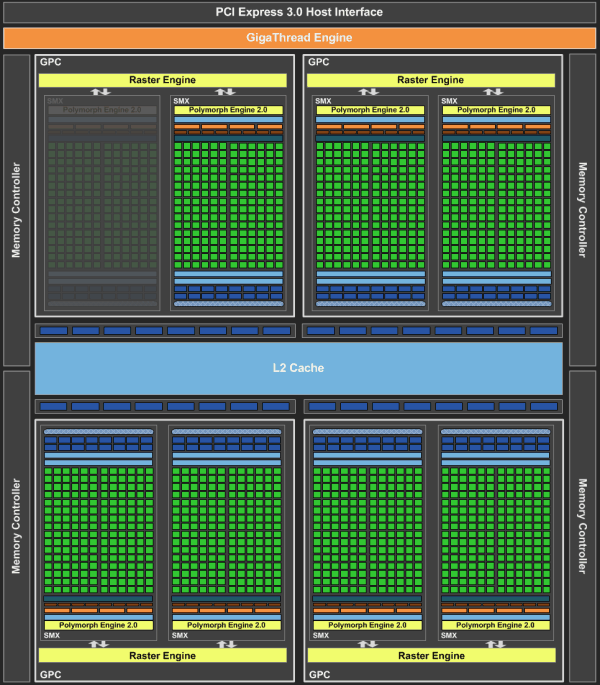

Архитектура и нововведения в Kepler

GeForce GTX 680 основана на первом графическом процессоре компании NVIDIA, имеющем новейшую архитектуру Kepler. Основы архитектуры были заложены ещё в вышедшем в 2010 году Fermi (GeForce GTX 480), а некоторые детали даже ещё раньше, но, несмотря на все сходства, в целом Kepler вполне можно назвать полностью переработанной архитектурой, продолжающей тенденции оптимизации эффективного исполнения сложных вычислительных задач, а также имеющей очень быструю обработку геометрии и тесселяции.

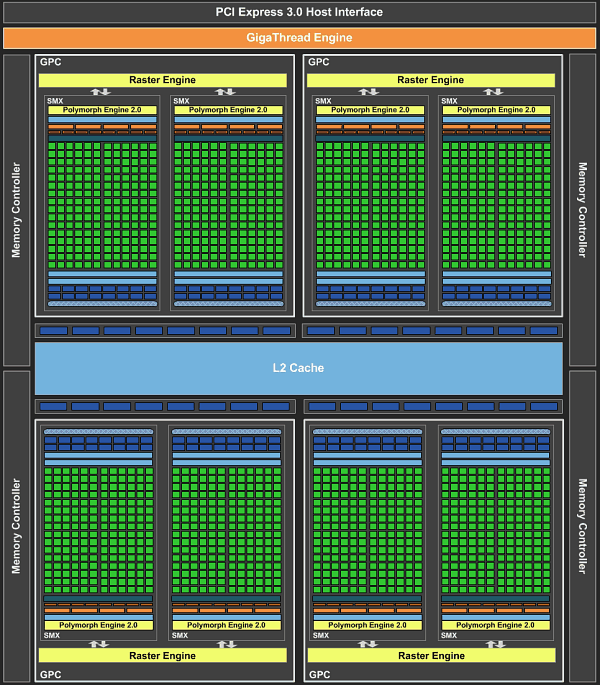

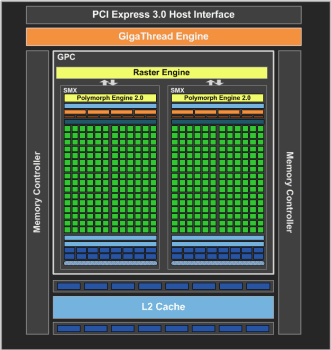

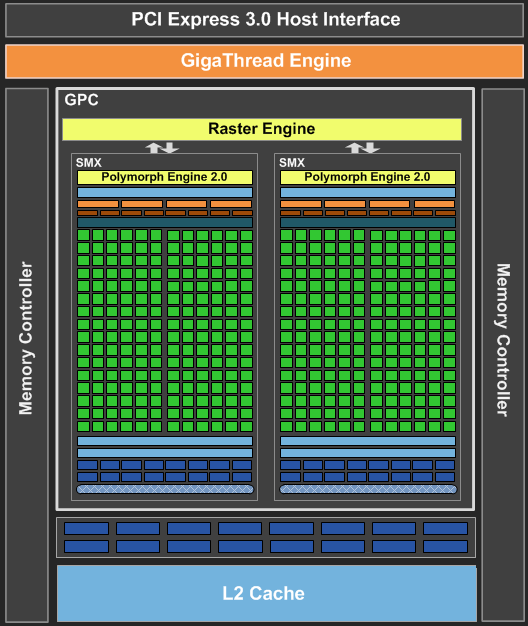

Как и в случае с Fermi, новый GPU имеет в своём составе несколько блоков GPC (кластеры графической обработки — Graphics Processing Clusters), которые являются независимыми устройствами в составе видеочипа, способными работать сами как отдельные устройства, так как в их составе есть все необходимые собственные ресурсы: растеризаторы, геометрические движки и текстурные модули. То есть, большинство функционала выполняется внутри блоков GPC. Блок-схема GK104 выглядит так:

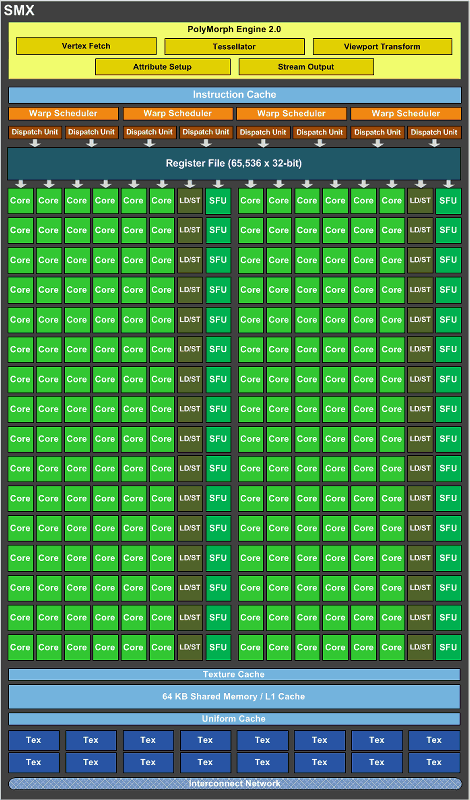

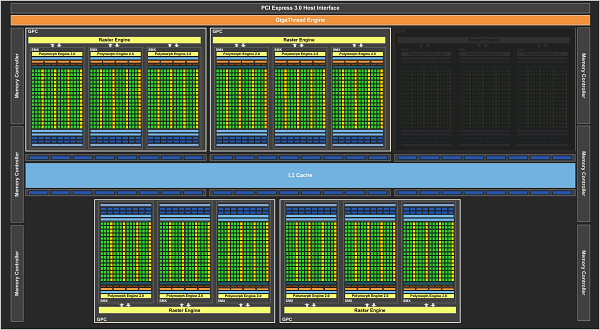

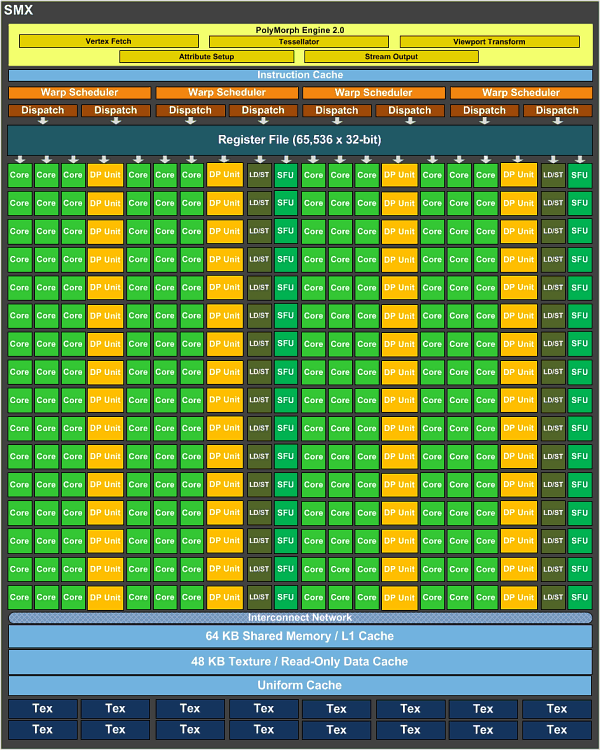

Новый GPU имеет четыре блока GPC, как и предыдущий топовый чип GF100/GF110, но в отличие от них, каждый из этих блоков содержит по два потоковых мультипроцессора, отличающихся от того, что мы видели во всех предыдущих чипов NVIDIA. Новое решение использует следующее поколение потоковых мультипроцессоров (Streaming Multiprocessor), которые теперь называются SMX, в отличие от SM в предыдущих чипах. Сразу скажем, что название с приставкой буквы «X» — весьма условное, она не означает ничего определённого, кроме указания на то, что эти блоки в Kepler изменились по структуре. Давайте рассмотрим SMX, потому что важнейшие изменения произошли именно в них:

Мультипроцессоры — это основная составная часть GPU компании NVIDIA, и именно они претерпели больше всего изменений в Kepler. По сравнению с предыдущими SM, новые SMX обеспечивают более высокую производительность, что видно по количеству функциональных устройств в составе SMX, но при этом потребляют значительно меньше энергии. А уменьшенное количество мультипроцессоров на GPU (8 в отличие от 16 в GF100/GF110) было продиктовано установленными рамками по площади ядра.

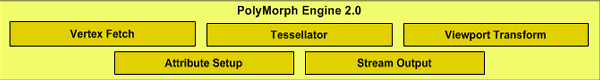

Большая часть ключевых блоков GPU включена в состав SMX: потоковые процессоры (CUDA Cores) выполняют все математические операции над пикселями, вершинами и занимаются неграфическими вычислениями, текстурные модули (TMU) фильтруют текстурные данные, загружают и записывают их из/в видеопамять, блоки специальных функций (Special Function Units, SFU) выполняют сложные операции (вычисление синуса, косинуса, квадратного корня и т.п.) и интерполяции графических атрибутов. Ну а движок PolyMorph обеспечивает выборку вершин, занимается тесселяцией, преобразованием в экранные координаты, установкой атрибутов и потоковым выводом (stream output).

Как вы можете видеть на схеме SMX, количество блоков загрузки-сохранения (Load-Store Unit — LSU) в GK104 в расчёте на каждые шесть потоковых блоков снизилось. Блоки LSU используются для передачи данных из/в кэш и разделяемую память, что может негативно сказаться на задачах GPU вычислений. Впрочем, это уменьшение количества LSU не должно значительно повлиять на производительность в графических применениях, но очень похоже, что GK104 всё же немного упростили в смысле оптимальности для GPGPU задач.

Темп FP64 вычислений в GK104 даже ниже, чем у предыдущих чипов, так как в SMX организация потоковых процессоров изменилась. В остальном, GK104 по балансу очень похож на предыдущий чип аналогичного класса — GF104, кроме уже указанных изменений и ожидаемо увеличенного количества памяти для регистров и некоторых других модификаций.

На схеме выше видно, что каждый блок SMX содержит 192 потоковых вычислительных ядра, и это в шесть раз больше, чем в SM у Fermi. Поэтому, по сравнению с аналогичными блоками мультипроцессоров в Fermi, SMX обеспечивает значительно большую мощность по обработке пикселей, текстур и геометрии. Даже с учётом того, что предыдущие чипы имели удвоенную частоту работы для потоковых ядер (CUDA cores).

Увеличенная вдвое частота ALU требует и вдвое большее число стадий конвейера, который работает на вдвое большей частоте, потребляя в целом вчетверо больше энергии. И эта увеличенная частота для потоковых процессоров в Fermi привела к вдвое большим затратам энергии, чем они могли бы быть бы при вдвое большем количестве ALU, но работающих на обычной, не удвоенной частоте. Но решение о применении так называемого «hotclock» в Tesla и Fermi было принято исключительно из-за невозможности засунуть требуемое число ALU, работающих на обычной частоте, в определённую площадь чипа.

В Fermi (и ещё раньше, в Tesla) такое решение позволило обеспечить относительно высокую производительность GPU при сравнительно небольшом расходе площади ядра на CUDA cores, что было крайне важным при менее совершенных техпроцессах. Ну а негативным побочным эффектом этого решения было серьёзно завышенное энергопотребление. В Kepler уже не нужно было экономить площадь по понятным причинам, ведь из-за 28 нм технологии чип и так очень маленький — менее 300 мм², и оказалось эффективнее отказаться от удвоенной тактовой частоты, разместив больше потоковых процессоров на каждый мультипроцессор. Что в результате позволило добиться минимизации накладных расходов, меньшего энергопотребления и лучшей энергоэффективности.

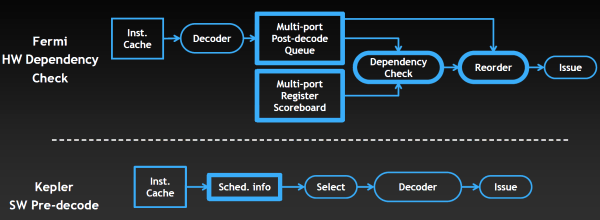

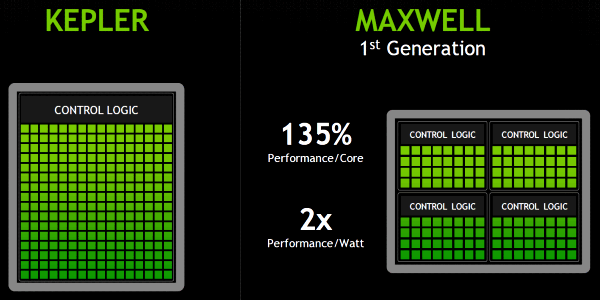

Но это ещё далеко не все изменения. Чтобы «прокормить» данными вычислительные блоки SMX, каждый из них содержит по четыре блока планировщика варпов (warp scheduler), каждый из которых, в свою очередь, обрабатывает по две инструкции за такт на один варп. Интересно, что по сравнению с SM в Fermi, в новой архитектуре SMX уменьшено количество управляющей логики в чипе. Именно уменьшено, а не увеличено! Получается, что NVIDIA в Fermi логику усложнила, затем в Kepler упростила, а их конкурент AMD усложнил логику в GCN, по сравнению с предыдущей архитектурой. Поэтому, можно сказать, что последние архитектуры этих компаний сблизились ещё плотнее (мы об этом немного рассказывали в обзоре Radeon HD 7970).

Функциональность блоков управления в Kepler была переработана в угоду большей энергоэффективности. Хотя и Kepler и Fermi содержат схожие аппаратные блоки, занимающиеся управлением загрузкой данных и варпов, управлением потоками команд, но планировщик Fermi также содержит ещё и сложную аппаратную стадию, служащую для предотвращения конфликтов доступа к данным. Специальная таблица регистров (multi-port register scoreboard) отслеживает регистры, данные в которых ещё не готовы, а блок проверки зависимостей (dependency check) анализирует их использование, проверяя зависимости команд.

Но раз информация о задержках при доступе известна заранее и они не меняются, то подобный анализ можно провести ещё в компиляторе. И в Kepler часть управляющей логики решили перенести из GPU в компилятор, который частично занимается планированием. Как видно на схеме выше, проверка зависимостей и упорядочивание команд на Fermi осуществляется аппаратно, внутри GPU, а в случае Kepler эти задачи выполняет компилятор. И как тут снова не вспомнить конкурента, у которого в GPU так и было — программные решения вместо аппаратной логики. То есть, снова мы видим подтверждение сближения архитектур AMD и NVIDIA.

Конечно, упрощающие начиповую логику нововведения наверняка снизили эффективность обработки потоковых данных в некоторых задачах. Но, что интересно, по данным NVIDIA, в большинстве задач она мало отличается от эффективности Fermi. Зато принятое решение позволило убрать сложные и весьма энергоёмкие блоки, заменив их простыми, которые просто берут предопределённые данные о задержках от компилятора и используют их при планировании.

Предполагаем, что для графических применений такой подход вполне имеет смысл, ведь GK104 — это чип, предназначенный скорее для игр, чем для глобальных вычислений на GPU в составе больших серверов. Скорее всего, для GPGPU задач в обозримом будущем выйдет ещё более сложный графический процессор на базе архитектуры Kepler. Для настольных же систем важно то, что по данным NVIDIA, радикально изменённая архитектура мультипроцессоров SMX позволила вдвое улучшить энергоэффективность, по сравнению с решениями на базе архитектуры Fermi. Причём, имеется в виду не первенец GeForce GTX 480, основанный на чипе GF100, а более удачная по этим параметрам модель GTX 580, созданная на основе чипа GF110.

Изменения в Kepler коснулись далеко не только блоков потоковой обработки и мультипроцессоров SMX. Кроме этого, первый GPU архитектуры Kepler получил совершенно новый интерфейс памяти. Как вы помните, семейства GTX 400 и GTX 500 имели сравнительно широкие шины памяти, но сами микросхемы памяти на них работали на относительно низкой частоте. Полностью переработанная подсистема памяти в GK104 позволила значительно увеличить рабочие частоты GDDR5 видеопамяти, повысив их сразу в полтора раза — до 1500(6000) МГц!

Для использования такой быстрой памяти пришлось внести массу изменений в контроллеры памяти, их логический и физический дизайн. В результате, GeForce GTX 680 на момент выхода имеет быстрейшую видеопамять. Впрочем, желание получить максимально быструю память могло быть вызвано другой характеристикой чипа — шириной шины памяти. Вероятно, исходя из планируемого размера GPU, при его проектировании было решено оснастить чип лишь четырьмя 64-битными каналами памяти. Это вполне привычное решение для чипов NVIDIA из среднего ценового диапазона, таких как GF104, но топовые видеокарты компании уже давно имеют более широкую ширину памяти.

Да и объём той же кэш-памяти второго уровня «привязан» к числу контроллеров памяти (по 128 КБ на канал), и поэтому её тут столько же, сколько и у GF1x4 — 512 КБ. Правда, параметры пропускной способности этого L2 кэша в Kepler заметно улучшились, чтобы поддержать увеличенную скорость математических вычислений. Так, полоса пропускания кэш-памяти второго уровня выросла на 73% (из-за возросшей частоты и ширины доступа — 512 байт за такт, вместо 384 байт), а для атомарных операций так и вовсе в несколько раз.

Всё же, мы считаем весьма вероятным то, что GK104 изначально проектировался как видеочип для среднего ценового диапазона, поэтому и был оснащён лишь 256-битной шиной, но потом, когда топовое решение задержалось, а конкурент выпустил не такой уж быстрый GPU, было решено быстренько изменить рыночную стратегию, выпустив mid-end GPU в качестве high-end решения. И по соответствующей цене. В общем-то, смену стратегии нам подтвердили и представители NVIDIA, вопрос лишь в том, а не временная ли эта смена, пока не вышло более мощное решение?

Впрочем, мы сейчас рассматриваем не вопросы рыночного позиционирования, а архитектуру нового GPU. И ширина шины памяти и сложность/размер чипа — это всегда некий компромисс, на который приходится идти его создателям. Видимо, в случае GK104 поставить больше каналов памяти не позволил размер и/или целевая сложность чипа. Тем более, если изначально планировали и выход более мощного решения.

Некоторые изменения в новом графическом процессоре коснулись и блоков обработки геометрии. Обновленный движок PolyMorph получил версию 2.0, но единственным изменением в нём стала увеличенная вдвое скорость обработки геометрических примитивов. То есть, по сравнению с Fermi, каждый из блоков PolyMorph способен обрабатывать вдвое больше данных за такт. Собственно, это стало необходимым уже только потому, что таких блоков в GK104 стало вдвое меньше, чем в GF100/GF110.

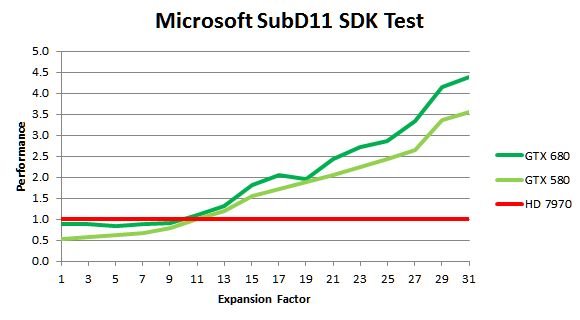

Но из-за значительно возросшей тактовой частоты GPU, задачи тесселяции выполняются на первом из Kepler заметно быстрее и по сравнению с GeForce GTX 580, и до четырёх раз быстрее, чем на быстрейшем решении конкурента — Radeon HD 7970. Это справедливо для синтетических тестов, вроде примера SubD11 из Microsoft DirectX 11 SDK, в котором NVIDIA и намеряла четыре раза, а в реальных приложениях скорость не упирается в скорость обработки геометрии.

Как видите, даже в геометрической синтетике при малом количестве обрабатываемой геометрии (малых степенях разбиения примитивов) решение AMD оказывается быстрее по тем или иным причинам — в таких случаях скорость упирается в другие блоки. Но уж когда геометрии обрабатывается много, то тут новому GK104 конкурентов быть просто не может — он быстрее не только конкурента, но опережает даже GF110, правда не в разы.

Помимо блоков PolyMorph, отметим изменения в балансе между количеством ROP и движков растеризации — в Kepler их количество равное и обеспечивается 1:1 баланс между растеризацией и работой блоков ROP. У GF100 и GF110 было четыре блока растеризации и шесть ROP, а у GF114 их соотношение и вовсе было 2:4, а у GeForce GTX 680 четыре блока растеризации и четыре же блока ROP.

NVIDIA считает, что такая архитектура сбалансированнее и блоки в GK104 будут использоваться эффективнее. Ведь растеризатор вычисляет, какие пиксели для каждого треугольника закрашивать, а ROP непосредственно записывает данные в память, и за одно и то же время они выполняют равное количество работы. И теперь эти блоки не простаивают, так как могут обработать равное количество данных, а для полной загрузки ROP не обязательно нужно использовать блендинг.

По некоторым данным, в Kepler применяется изменённый алгоритм сжатия для передачи данных между памятью и ROP, повышающий эффективность использования имеющейся полосы пропускания. Есть у нас сведения и об ускорении темпа скорости заполнения и блендинга для буферов формата R11G11B10, иногда используемого для экономии ПСП вместо полноценного 16-битного.

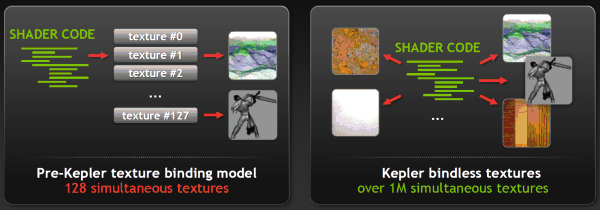

Ещё одним изменением, связанным с графической архитектурой Kepler, можно назвать поддержку «bindless» текстур. В предыдущих графических процессорах модели привязки текстур обеспечивают поддержку одновременной работы лишь с 128 текстурами, которым выделялся свой фиксированный слот в таблице привязки. В Kepler же внедрили так называемые «не привязанные» текстуры, и шейдерная программа может обращаться к текстурам напрямую, без использования таблицы привязки.

Это решение увеличивает одновременное количество обрабатываемых текстур в одной шейдерной программе более чем до 1 миллиона. Может быть это покажется не слишком большим изменением, но оно позволит увеличить количество уникальных текстур и материалов в одной сцене (что может использоваться в техниках, аналогичных известной MegaTexture, применяемой в движке id Software, например), а также теоретически поможет снизить загрузку CPU при рендеринге.

К сожалению, у этой возможности пока что нет широкой программной поддержки. Пока что bindless текстурирование можно использовать только в OpenGL, а её добавление в самый популярный графический API DirectX планируется в будущих версиях или при помощи специального интерфейса NVAPI. Будем ждать, сама по себе возможность многообещающая.

Теоретическая оценка производительности GeForce GTX 680

Хотя изменения в Kepler коснулись множества исполнительных блоков, всё же корни архитектуры явно имеют под собой основу в виде Fermi. Основная архитектура чипа почти не изменилась, он всё так же состоит из крупных блоков GPC, содержащих мультипроцессоры SM, имеющих почти всё необходимое для независимой работы. Блоки обработки геометрии такие же, только вдвое быстрее (но их и вдвое меньше), текстурные модули и ROP остались почти без изменений, разве что количество первых увеличилось вдвое.

Наверное, это и правильно — зачем что-то менять, когда оно и так работает хорошо? Да и новых версий графических API не появилось, не считать же большим обновлением DirectX 11.1, некоторые из возможностей которого, кстати, Kepler поддерживает, но скорее всего не все. Нужно было просто улучшить все блоки, подтянув имеющиеся слабые места, укрепив сильные. С чем, похоже, в NVIDIA отлично справились. Тем интереснее сравнить теоретические показатели нового решения NVIDIA с предыдущим топовым GeForce GTX 580 и Radeon HD 7970 от их конкурента — какие у GTX 680 есть слабости?

| Видеокарта | Radeon HD 7970 | GeForce GTX 580 | GeForce GTX 680 |

|---|---|---|---|

| Графический процессор | Tahiti XT | Fermi (GF110) | Kepler (GK104) |

| Сложность чипа, млрд.транз. | 4,3 | 3,0 | 3,5 |

| Потоковых ядер, шт | 2048 | 512 | 1536 |

| Текстурных модулей (TMU), шт | 128 | 64 | 128 |

| Блоков ROP, шт | 32 | 48 | 32 |

| Шина памяти, бит | 384 | 384 | 256 |

| Частота GPU, МГц | 925 | 772/1544 | 1006(1058) |

| Частота видеопамяти, МГц | 5500 | 4000 | 6000 |

| Пропускная способность, ГБ/с | 264 | 192 | 192 |

| Производительность ALU, терафлопс | 3.79 | 1.58 | 3.09 |

| Скорость заполнения, ГП/с | 29,6 | 37,1 | 32,2 |

| Скорость выборки текстур, ГТ/с | 118,4 | 49,4 | 128,8 |

| Макс. энергопотребление | 250 | 244 | 195 |

В NVIDIA решили убрать многие недостатки своего предыдущего решения, серьёзно увеличив математическую и текстурную производительность, но оставив при этом производительность блоков ROP и ПСП примерно той же, что и у GeForce GTX 580. Увеличив вдвое количество блоков текстурирования и втрое — математических (правда, тут надо помнить об удвоенной частоте ALU в Fermi), инженеры компании этим самым оставили хорошую заявку на высочайшую производительность.

Сначала о том, что у GeForce GTX 680 отлично или очень хорошо. Во-первых, текстурирование. По этому параметру (по крайней мере, в теории) они превзошли даже быстрейшую видеокарту AMD, а их решения всегда отличались большим количеством блоков выборки и фильтрации текстур. Но особенно мощно достижение выглядит на фоне GTX 580 — текстурирование ускорилось в 2,6 раза и оно точно не будет ограничивающим производительность фактором!

Второй параметр, на который мы обращаем особое внимание — вычислительные возможности. Хотя лучшая видеокарта AMD всё ещё быстрее решения NVIDIA, но разрыв значительно сократился, 22% — это уже не несколько раз в предыдущих поколениях. Тем более, что чип имеет примерно на столько же меньше транзисторов. Сравнение с GF110 и вовсе опустим, по причине слишком лёгкой победы нового решения по этой пиковой теоретической характеристике.

Рассмотрим скорость заполнения (филлрейт), которая до сих пор зачастую является одним из ограничителей производительности в играх, особенно старых. Если сравнивать GeForce GTX 680 с конкурентом, то тут наблюдаем небольшой выигрыш, а если с предшествующей моделью — то не слишком большой проигрыш. Но почему в NVIDIA не увеличили количество блоков ROP? Во-первых, потому, что они «привязаны» к контроллерам памяти, которых в GK104 лишь четыре. Во-вторых, инженеры NVIDIA увеличили эффективность использования ресурсов ROP (см. выше), поэтому этой скорости должно быть достаточно.

Итак, переходим к самой неоднозначной характеристике нового решения — ширине шины памяти, её частоте и, соответственно, пропускной способности. С частотой памяти всё хорошо, мы писали выше, а вот её ПСП может быть главным ограничителем производительности для GeForce GTX 680! Это отлично видно из сравнения теоретических показателей в табличке. И пусть своей предшественнице новая модель не проигрывает (но она имеет значительно меньшую производительность и не упирается в ПСП), но конкурент впереди по одному из важнейших показателей аж на 37.5%!

Мы уж не повторяемся, что из-за 256-битной шины на карту установлено лишь 2 ГБ памяти, чего может не хватать в высоких разрешениях и степенях полноэкранного сглаживания, ради которых и покупаются топовые видеоплаты. В общем, если где-то в играх будут отставания от Radeon HD 7970, то можете быть уверены почти на 100%, что дело либо в объёме памяти, либо в её пропускной способности. В случае отсутствия явных багов в драйверах, конечно.

Несмотря на эти недостатки, многочисленные положительные улучшения в GPU не могли не сказаться и на практической производительности новой видеокарты компании NVIDIA — и на день своего выхода, она скорее всего станет быстрейшим одночиповым решением на рынке. Ну и GTX 680 является наименее требовательным к электропитанию, то есть — весьма и весьма энергоэффективным. В то время как конкурирующее решение схожей производительности имеет набор из одного 8-контактного и одного 6-контактного разъёмов дополнительного питания, что стало фактическим стандартом для высокопроизводительных видеокарт, GeForce GTX 680 имеет лишь два 6-контактных разъёма и установленное максимальное энергопотребление в 195 Вт, что явно ниже максимальных 250 Вт у главного конкурента.

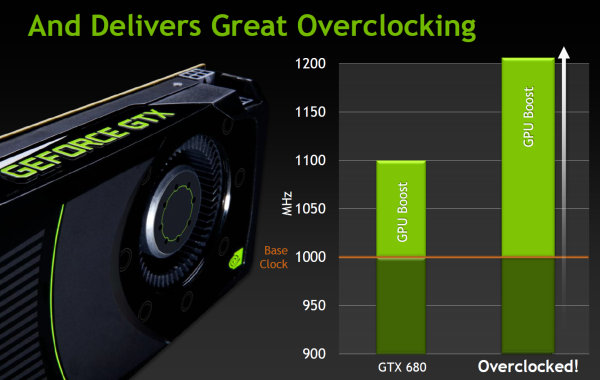

GPU Boost

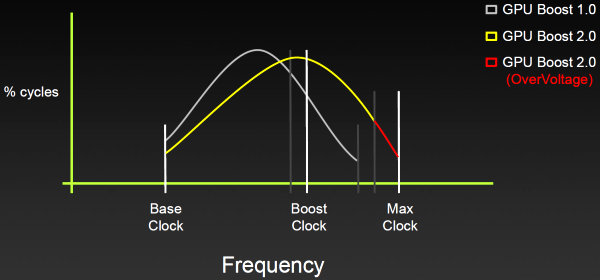

Одной из наиболее интересных особенностей первенца архитектуры Kepler является технология GPU Boost. Уже по названию понятно, что она неким образом должна ускорять производительность. Это комбинированная программно-аппаратная технология, появившаяся в GeForce GTX 680, которая динамически изменяет частоту GPU, исходя из условий его работы и некоторых характеристик.

Специализированный аппаратный блок в чипе постоянно отслеживает потребление энергии видеокартой и некоторые другие параметры, такие как температура, и автоматически изменяет частоту графического процессора, повышая её для получения максимально возможной производительности в пределах установленного пакета теплопотребления.

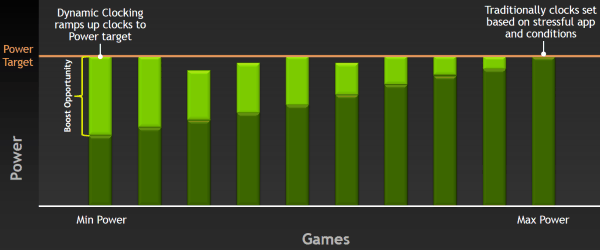

Но каким образом принимается решение о повышении частоты? Не секрет, что в большинстве игровых приложений GPU работают с потреблением энергии, далёким от максимально возможного для видеоплаты. Так, GeForce GTX 680 на базовой частоте в 1 ГГц в играх потребляет в среднем лишь около 170 Вт, хотя в принципе может использовать 195 Вт и даже больше. То есть, никто не мешает поднять частоту и напряжение GPU и повысить производительность, при этом, не выйдя за рамки TDP. Что, собственно, уже давно делают и на CPU и GPU.

Отличие GPU Boost от предыдущих, значительно менее продвинутых методов ограничения теплопотребления от компании NVIDIA, в том, что новая технология основана на работе преимущественно аппаратного блока и работает независимо от программных профилей в драйвере и не требует никаких действий от пользователя, обеспечивая «бесплатный» прирост производительности. При этом на изменение частоты уходит лишь 100 мс, т.е. оно почти мгновенное с точки зрения человека.

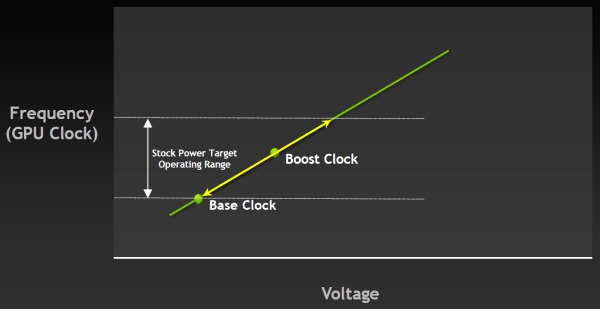

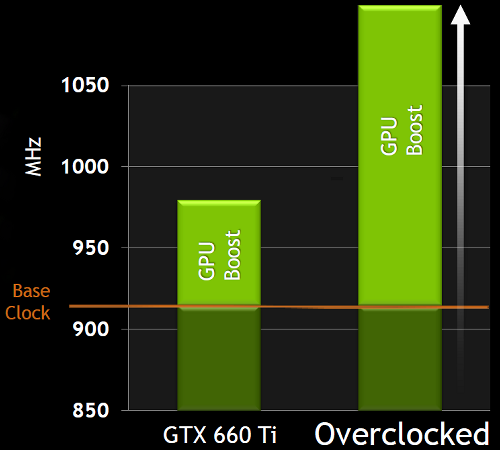

И теперь в спецификациях GPU производства NVIDIA будет как базовая частота (base clock), так и турбо-частота (boost clock). Для GeForce GTX 680 базовая частота равна 1006 МГц, и это — гарантированная частота работы во всех 3D приложениях, даже нетипичных — тех, которые максимально загружают работой GPU. А турбо-частота — это средняя частота, которая достигается в типичных приложениях, требующих меньшего энергопотребления. Мы не зря выделили слово «средняя», так как в реальности частота скачет не только от приложения к приложению, но и запросто может изменяться в пределах одной игры, в зависимости от нагрузки на видеоплату.

И в среднем, турбо-частота в играх составляет как раз около 1058 МГц, что даёт прирост скорости порядка 5%. Можно подумать, что игра не стоит свеч, ибо прирост в среднем небольшой. Но в некоторых играх есть ещё больший запас по потреблению, и турбо-частота GeForce GTX 680 вырастает и до 1100 МГц. GPU Boost повышает частоту, пока не достигается выбранный предел потребления, и для многих игр частота будет близка именно к верхнему пределу. Понятно, что вместе с частотой растёт и напряжение, подаваемое на GPU, причём оно изменяется плавно, как и рабочая частота.

Например, 3DMark 11 является весьма требовательным к мощности GPU приложением, при работе в котором GeForce GTX 680 часто упирается в предел TDP даже при базовой частоте в 1 ГГц. Но потребление GK104 в реальных играх ниже, к примеру, в игре Crysis 2 чип способен работать на частоте в 1.05 ГГц, а в Battlefield 3 так и вовсе на 1.1 ГГц. Почему бы не воспользоваться этим «бесплатным» ускорением, решили в NVIDIA.

В отличие от аналогичной технологии компании-конкурента на графическом рынке, GPU Boost может не только снижать частоту при превышении TDP, но и увеличивать её — для этого и задана boost clock. Хотя, надо сказать, что в целом все подобные технологии схожи и отличие между разными реализациями весьма небольшое. Главное — что теперь у NVIDIA тоже есть весьма продвинутая технология по управлению частотами в зависимости от потребления, и она реально работает.

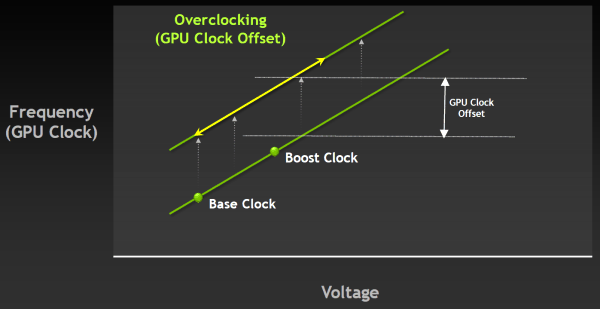

Кстати, сама по себе технология не мешает дальнейшему разгону, а работает вместе с ним. При разгоне меняется только базовая частота, а турбо-частота выбирается самим GPU в зависимости от достижения установленного уровня TDP. Который, кстати, теперь также можно регулировать, в том числе из утилит вроде EVGA Precision, использующих NVAPI. Правда, из-за более «умного» мониторинга и постоянного изменения частоты GPU под нагрузкой, подход к экстремальному разгону придётся менять в каких-то деталях, привыкая к новому принципу работы. Зато массовому пользователю подход NVIDIA с турбо-частотой будет вполне удобен.

Правда, к сожалению, динамическое изменение частоты GPU Boost нельзя ни отключить, ни отрегулировать разность между частотами. То есть, при разгоне изменяется только базовая частота, а прирост от GPU Boost будет постоянным. Было бы значительно удобнее, если бы можно было бы изменять верхний предел или среднюю турбо-частоту, а то и вовсе отключать технологию. Особенно это было бы удобно для нас, тестеров.

Полноэкранное сглаживание методами FXAA и TXAA

Очень интересно наблюдать за развитием полноэкранного сглаживания на протяжении нескольких лет. На смену суперсэмплингу (SSAA), который первым появился в игровых видеокартах и является наиболее качественным, но весьма требовательным к ресурсам, пришёл мультисэмплинг (MSAA), более быстрый метод, но имеющий свои недостатки в плане качества. А теперь и его потихоньку вытесняют более современные методы сглаживания, основанные на постобработке отрендеренного кадра.

Один из таких методов сглаживания — FXAA, он известен уже какое-то время и появился в нескольких современных играх. Этот алгоритм использует мощность потоковых процессоров при постфильтрации и производится совместно с другими фильтрами, вроде размытия в движении (motion blur), bloom и другими аналогичными.

Использование методов вроде FXAA и схожего метода от конкурента — MLAA, особенно актуально для игровых движков, использующих отложенное затенение (deferred shading), так как они снижают требования к объёму видеопамяти и менее затратны по вычислительной мощности, по сравнению с более привычным для нас мультисэмплингом (MSAA). Кроме того, применение MSAA сглаживания при HDR рендеринге может приводить к появлению видимых артефактов, когда разность между значениями яркостей соседних участков изображения слишком велика. Так как FXAA выполняется в конце процесса рендеринга, уже в виде постфильтра, то он лишён многих проблем.

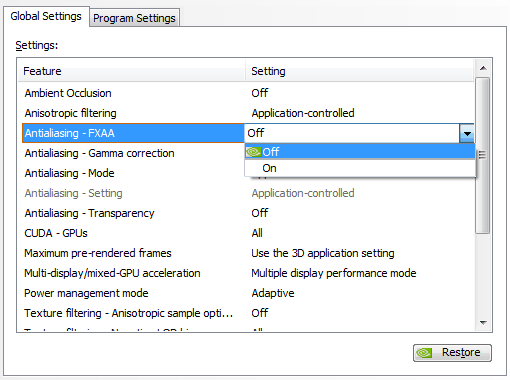

Метод FXAA также менее требователен, по сравнению с MSAA — по оценке компании NVIDIA примерно на 60%. Новый вид сглаживания впервые появился в 2011 году в игре Age of Conan и затем использовался в 15 проектах. А теперь, начиная с видеодрайверов NVIDIA версии 300, метод сглаживания FXAA можно будет форсировать из панели управления драйвера для сотен игровых приложений.

В качестве демонстрации эффективности FXAA по сравнению с MSAA, NVIDIA совместно с Epic показала на Kepler Editor's Day (и на выставке игровых разработчиков GDC 2012, которая проходила рядом в то же время) уже известную демонстрационную программу Samaritan, показывающую как может выглядеть игра с поддержкой возможностей DirectX 11. Эта демо-программа использует тесселяцию и карты смещения (displacement mapping), подповерхностное рассеивание (subsurface scattering), эффект имитации глубины резкости (depth of field), динамические отражения, тени и многие другие эффекты, и она очень сложна с точки зрения вычислительной мощи GPU.

Так вот, в отличие от GDC 2011, когда впервые показанное демо Samaritan использовало MSAA и было запущено на системе из трёх GeForce GTX 580, работающих в SLI связке, в этом году Epic показывала демку на системе с одной видеокартой GeForce GTX 680. Естественно, это не говорит о том, что новинка такая же по мощности, как три GTX 580. Есть сразу несколько объяснений этому: а) SLI не обеспечивает 100% эффективности, особенно на системе из трёх GPU; б) вместо MSAA в 2012 году использовался менее затратный метод FXAA; в) GTX 680 — это действительно очень мощная видеокарта!

Вы спросите, а что там с качеством? Наверняка же оно было хуже при FXAA и на одной GTX 680. Да, скорее всего, оно было хуже. Вот только настолько ли хуже стало итоговое качество, насколько MSAA требовательнее к GPU? В этом как раз основная польза метода FXAA — оно обеспечивает значительно лучшую скорость при примерно таком же качестве сглаживания, что и у MSAA. Вы можете оценить разницу на скриншотах:

И то же самое, но в статическом полноразмерном виде:

Важно понимать, что есть разница между несколькими типами FXAA, включаемыми в играх и из панели драйвера NVIDIA. Первоначальная версия FXAA (FXAA 1), внедрённая в такие игры, как Age of Conan, F.E.A.R. 3 и Duke Nukem Forever, обеспечивает высокое качество ценой несколько большего падения производительности. А более новый метод FXAA, вроде FXAA 3 в Battlefield 3, обеспечивает оптимальный компромисс между качеством и падением производительности, и для него можно регулировать качество, производительность и резкость, что и делается создателями игр на стадии разработки.

Включаемая из панели настроек драйвера версия FXAA — это нечто среднее между методами FXAA 1 и FXAA 3 с некоторыми изменениями, которые улучшают восприятие таких элементов, как сглаженный текст. По сравнению с FXAA 3, внедрённым в игры, «драйверный» метод сглаживания обеспечивает лучшее качество на всём, кроме текста и других элементов интерфейса, так как постфильтр в этом случае применяется уже к картинке целиком, когда она полностью готова, а игровые разработчики обычно накладывают текстовые элементы уже после всей постфильтрации. Ну и по понятной причине этот метод несколько медленнее внедрённого в игры FXAA 3.

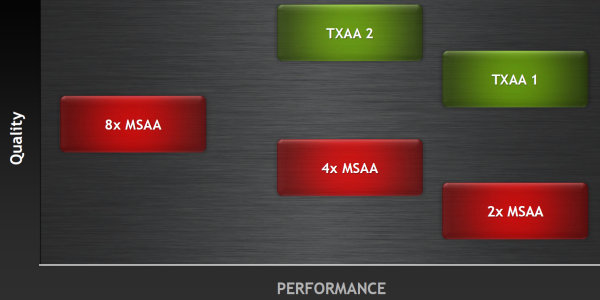

Но одним FXAA дело не заканчивается. Как известно, нет предела совершенству. Не то, чтобы FXAA был к нему близок, ведь совершеннее всего по качеству сглаживания примитивный суперсэмплинг (SSAA), но он и самый требовательный — слишком требовательный. Чтобы улучшить качество сглаживания, почти не повысив ресурсоёмкость, в NVIDIA был разработан ещё один метод — TXAA. Кстати, на мероприятии для прессы об этом методе рассказывал русскоязычный сотрудник компании Юрий Уральский.

Основная цель TXAA в том, чтобы добиться качества сглаживания, максимально близкого к тому, что делается в пререндеренной графике (полнометражные мультфильмы и эффекты в кино). Так вот, TXAA — это ещё один метод сглаживания, разработанный сотрудниками компании, который становится весьма актуальным, в том числе из-за высокой текстурной производительности Kepler. TXAA также использует постобработку, но не только её, ведь в том и отличие, что это — гибридный метод, которые включает как использование аппаратных MSAA мультисэмплов, так и специальный качественный сглаживающий постфильтр и даже опциональную временную (temporal) компоненту.

Метод сглаживания TXAA доступен в двух режимах: TXAA 1 и TXAA 2. Первый режим предлагает качество сглаживания, аналогичное методу 8x MSAA, но с производительностью, идентичной 2x MSAA, а второй обеспечивает ещё лучшее качество, но с производительностью, примерно соответствующей 4x MSAA. Соответственно, они используют 2 или 4 аппаратных мультисэмпла. Мы обязательно исследуем все эти методы в отдельном материале, сравнив их в том числе и с тем, что предлагает конкурент — компания AMD.

Временная (temporal) компонента в данном случае позволяет увеличить качество сглаживания за счёт небольших смещений субпикселей каждый кадр (так называемый jitter). Такой метод уже применялся ранее компанией ATI — в этом случае расположение субсэмплов внутри пикселя не является фиксированным и меняется каждый кадр. И так как устройства вывода и человеческое зрение инерционны, то человеческий мозг просто не успевает увидеть каждый кадр отдельно и объединяет информацию из соседних. И если при рендеринге каждого кадра немного изменять положение субпикселей, то субъективное восприятие качества сглаживания будет лучше — как будто субпикселей больше, чем их есть на самом деле.

Будет проще понять, если пояснить на примере. Допустим, если использовать 2х сглаживание, но в чётных и нечётных кадрах использовать два сэмпла на разных позициях (по диагонали: то слева-снизу и справа-сверху, то слева-сверху и справа-снизу), то при достаточно высокой частоте кадров человеческий глаз увидит, а мозг усреднит эти кадры и получится как будто 4х сглаживание с четырьмя субпикселями, а не двумя. Конечно, если число субпикселей слишком мало, то это будет заметно на глаз, но в случае TXAA всё должно быть хорошо.

Как и метод сглаживания FXAA, новый алгоритм будет внедряться в выходящие игровые приложения, начиная уже с этого года — для этого все заинтересованные игровые разработчики, среди которых мы можем отметить Crytek, Epic, Bitsquid и многих других, уже получили исходный код, так что мы надеемся, что появление TXAA не заставит себя ждать. Отдельной радостной новостью для владельцев видеокарт NVIDIA на основе архитектуры Fermi будет то, что TXAA будет работать в том числе и на их системах. А вот форсировать TXAA в драйвере не удастся, придётся ждать появления игр с его поддержкой.

Вопросы субъективной оценки качества сглаживания у таких методов вроде: «Да оно же всё замыливает!» мы пока что оставим в стороне, до подробного исследования качества сглаживания на видеокартах NVIDIA и AMD. А пока же поясним, что полностью убрать алиасинг полностью без некоторого снижения чёткости физически невозможно. Тем более тот, который видно только в динамике. На статических скриншотах всё может быть прекрасно, но в движении проявится алиасинг. И как раз TXAA отлично справляется в таких случаях и призван приблизить качество сглаженной картинки к тому, что мы видим в кино.

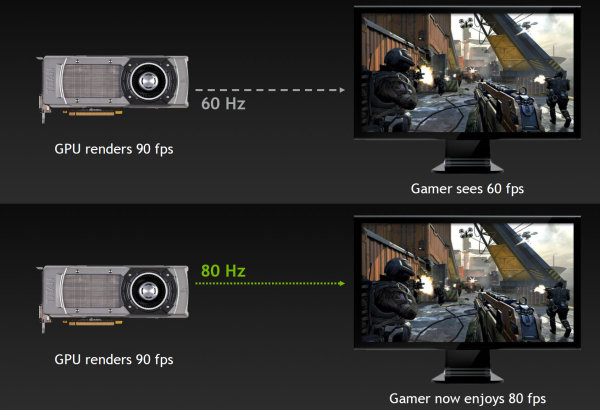

Адаптивная вертикальная синхронизация (Adaptive VSync)

Это — ещё одна программная технология, поддержка которой появилась в новейших драйверах компании NVIDIA. Пусть она и не относится напрямую к GeForce GTX 680, но совершенно точно направлена на улучшение комфортности при игре на видеокартах компании.

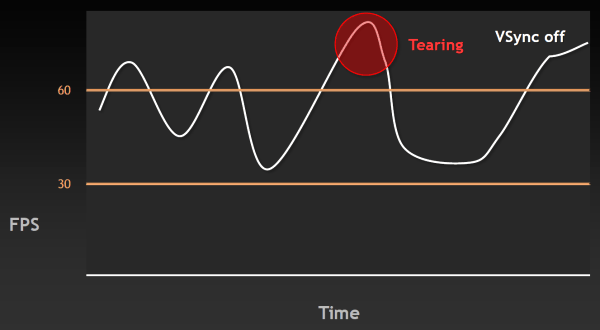

Напомним, что вертикальная синхронизация (VSync) придумана и используется для того, чтобы минимизировать артефакты изображения в виде разрывов кадра (tearing), заметные тогда, когда FPS в игре вырастает выше частоты обновления монитора. Такие артефакты видны и в случае, когда FPS ниже, но заметнее они именно при очень высоком FPS. На следующем графике указан момент, когда возникают разрывы изображения:

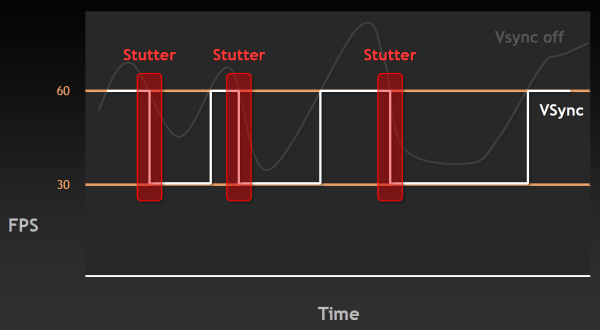

Естественно, такие вещи раздражают пользователя — казалось бы, частота кадров у системы высокая, а плавности нет. Поэтому была придумана вертикальная синхронизация, ограничивающая FPS сверху, привязывая её к частоте обновления монитора. Но при включении этой синхронизации появляется другая известная проблема — рывки или скачки в частоте кадров (stutter). Они случаются, когда частота кадров падает ниже 60 FPS, вызывая резкое двукратное падение частоты кадров до 30 Гц и ниже (20 Гц, 15 Гц) в случае включенной синхронизации. Естественно, это также не улучшает восприятия видеоряда в играх.

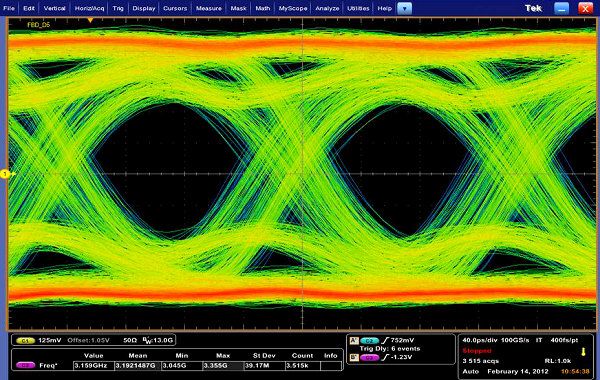

Чтобы решить обе эти проблемы и приблизиться к идеальной плавности в частоте кадров, инженеры NVIDIA сделали в драйверах то, что давно делается на игровых консолях — изменили работу алгоритма вертикальной синхронизации так, чтобы избавиться от разрывов кадра и одновременно минимизировать скачки FPS. Разработанную технологию назвали адаптивной вертикальной синхронизацией (Adaptive VSync), она динамически включает и выключает VSync так, чтобы приблизиться к идеальной плавности и постоянной частоте смены кадров. Проще всего это продемонстрировать на графиках — лучше один раз увидеть, чем сто раз прочитать.

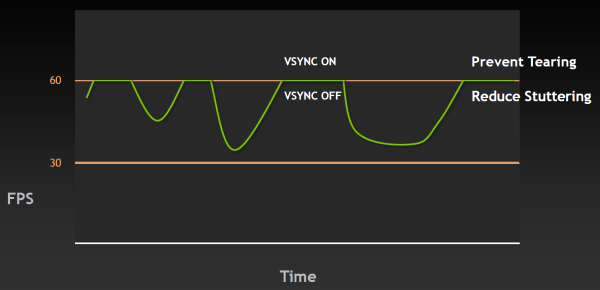

При частоте кадров выше 60 FPS в случае адаптивной синхронизации будет работать обычный VSync, но когда FPS падает ниже отметки 60 (или другого значения частоты обновления экрана), то адаптивная вертикальная синхронизация временно отключает VSync, позволяя частоте кадров достигнуть своего обычного значения, не «придушенного» синхронизацией до половины частоты обновления. А уже после того, как FPS возвращается к отметке выше 60, VSync снова автоматически включается, чтобы не появились разрывы в изображении.

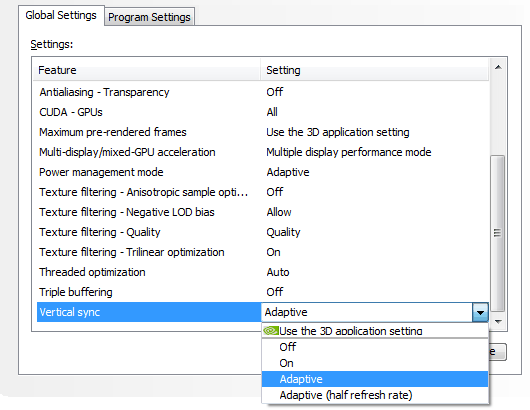

Таким образом, эта технология значительно увеличивает плавность вывода движущейся картинки на экран, приближая её к плавности консольных игр. Начиная с версии 300, в видеодрайверах NVIDIA появилась поддержка этой технологии. Она включается из панели настроек драйвера, причём можно включить синхронизацию и на половинной частоте обновления экрана, что также может быть полезно в случаях, когда производительность в игре скорее ближе к 30 FPS, чем к 60 FPS (ведь обычный VSync в таких случаях просто не будет работать):

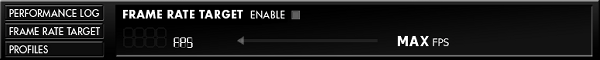

К слову, у NVIDIA есть и ещё одна программная возможность — ограничение количества FPS сверху так, чтобы частота GPU динамически снижалась в случае избытка производительности. Например, вы играете в старую игру, в которой с лёгкостью получаете 200-300 FPS. Зачем вам столько, если их всё равно не видно? И зачем гонять видеочип на частоте в 1 ГГц, если игре более чем достаточно и половины от этого значения?

К сожалению, эта возможность (пока?) недоступна из драйверов, но есть в NVAPI. И при помощи утилиты EVGA Precision 3.0 (а в дальнейшем эта настройка появится и в панели управления видеодрайвера) в играх, использующих DirectX или OpenGL, вы можете ограничить потолок FPS, к примеру, на уровне 60 кадров в секунду и получить при этом идеальную плавность и достаточно высокую производительность, да ещё и сниженную частоту GPU и меньшее напряжение, а значит и потребление энергии. Все они будут ровно такими, которые потребуются для достижения 60 FPS в игре.

Возможно, эти программные технологии не так эффектны, как некоторые аппаратные усовершенствования, появившиеся в Kepler, но нам кажется, что вместе с Adaptive VSync это очень интересные программные возможности, значительно улучшающие комфортность игры и энергоэффективность системы. И для некоторых пользователей эти технологии могут оказаться даже более важными, чем некоторые из аппаратных изменений.

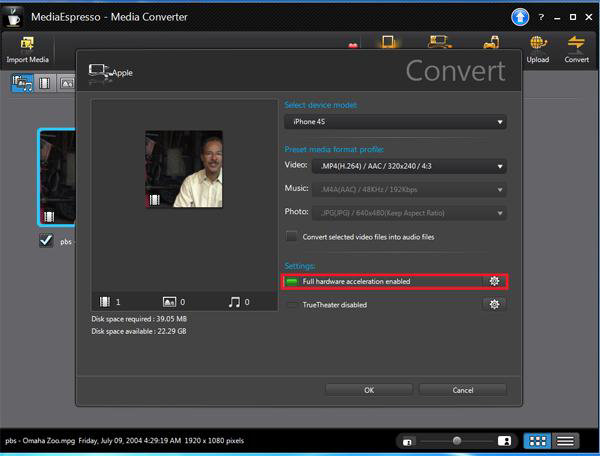

Аппаратное кодирование видео — NVENC

NVIDIA не могла пройти мимо современных тенденций на рынке GPU и CPU, связанных с включением в производимые чипы специализированных блоков для аппаратного кодирования видеоданных. Аналогично последним продуктам конкурентов, производящих CPU и GPU, все видеочипы архитектуры Kepler получат аппаратный блок кодирования видео в формате H.264 — NVENC.

Вы, конечно же, помните, как все предыдущие годы нам долго и упорно рассказывали об ускорении видеокодирования на GPU, но это дело толком так и не пошло. По разным причинам, тут и сложности переноса эффективного кода на GPU и недостатки в качестве картинки закодированного таким образом видео, а главное, что энергопотребление топовых чипов при такой загрузке отнюдь не низкое и ресурсы тратятся расточительно. В общем, если раньше ПО для кодирования видео на GPU использовало потоковые процессоры видеочипов, то теперь этим делом будет заниматься выделенный аппаратный блок.

Кодировщик видеоданных NVENC почти вчетверо быстрее предыдущих методов, основанных на использовании CUDA, и это — при гораздо меньшем потреблении энергии (буквально менее 10 Вт). Вот что значит специализированное «железо», в отличие от универсального! Стоило ли городить огород с CUDA-кодированием — большой вопрос. Но зато теперь пользовательские приложения могут использовать возможности NVENC и CUDA-кодирования параллельно, если это кому понадобится.

Блок NVENC, имеющийся в GeForce GTX 680, способен кодировать видео в полном FullHD (1920×1080 пикселей) разрешении со скоростью в 4-8 раз быстрее реального времени. То есть, в высокопроизводительном режиме 16-минутное видео в формате 1080p при 30 FPS закодируется за две минуты. Аппаратным кодировщиком NVIDIA поддерживаются разрешения вплоть до 4096×4096 и следующие версии формата H.264: Base, Main и High Profile Level 4.1 (стандарт Blu-ray), в том числе и многоканальное кодирование MVC (Multiview Video Coding) для стереоскопического видео.

Кроме задач перекодирования видео, NVENC будет полезен и в других близких задачах, вроде программ видеомонтажа, беспроводной передачи изображения и при проведении видеоконференций. Прямо со дня анонса GeForce GTX 680, блок аппаратного видеокодирования будет поддерживаться в Cyberlink MediaEspresso, а в ближайшем будущем ожидается поддержка в Cyberlink PowerDirector, Arcsoft MediaConverter и других программах.

А для разработчиков NVIDIA выпустила специальный SDK, в котором раскрываются возможности API для видеокодирования при помощи NVENC. Вскоре CUDA-программисты получат возможность и одновременного использования NVENC и CUDA в своём ПО, что может быть очень полезно в задачах обработки и монтажа видео. К примеру, видеоданные будут обрабатываться на потоковых ядрах, и затем посылаться на кодирование в NVENC, и всё это будет работать одновременно и без лишних пересылок данных туда-сюда.

Расширенная поддержка многомониторного вывода

Довольно длительное время у NVIDIA не было ответа на конкурирующую технологию (а по сути — просто одну из технических характеристик) AMD Eyefinity, которая позволяет выводить изображение более чем на два монитора. И вот теперь, начиная с GeForce GTX 680, аналогичное решение поддерживается и видеокартами NVIDIA. Новая плата поддерживает до четырёх устройств вывода одновременно, в отличие от двух в предыдущих моделях.

Причём, новая видеокарта в одиночку способна выводить стереоизображение на три монитора одновременно, что называется 3D Vision Surround и ранее было доступно лишь на двухчиповых системах, и даже использовать четвёртый монитор для вывода какой-то другой информации, вроде окна с браузером, электронной почтой или Skype. Для подключения самых современных устройств вывода изображения, обновленный движок вывода в GK104 поддерживает DisplayPort 1.2, HDMI 1.4a, мониторы высокого разрешения (3840×2160, так называемые «4K») и многопоточный вывод звука, для чего имеет все необходимые разъёмы:

Было сделано и несколько чисто программных изменений: теперь панель задач Windows можно расположить на центральном мониторе, разворачивать окно лишь на текущий монитор, задавать собственные разрешения экрана, а также использовать «горячие клавиши» для управления корректировкой экранных рамок — ведь этот функционал может мешать в некоторых играх, закрывая важные элементы интерфейса.

Кстати, по поводу поддержки нескольких мониторов одновременно. Многие из наших читателей знают, что подключение второго монитора с другими характеристиками (разрешение, частота обновления) на видеокартах семейства Fermi вызывало одновременный переход GPU в режим большего энергопотребления, по сравнению со стандартным режимом простоя при подключении одного устройства вывода. Так вот, в Kepler эта досадная оплошность была устранена и теперь GPU всегда работает в стандартном режиме питания при скольки угодно подключенных мониторах (речь о 2D режиме, естественно).

Особенности модели GeForce GTX 670

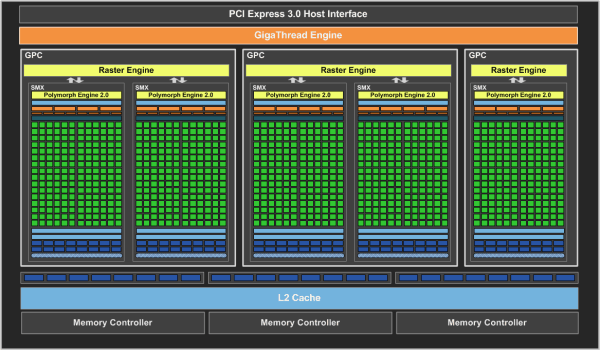

Следующей после GTX 680 вышла видеокарта GeForce GTX 670, основанная на всё том же графическом процессоре архитектуры Kepler, известном нам под кодовым именем GK104. Установленный на GeForce GTX 670 графический процессор GK104 состоит из четырёх кластеров графической обработки Graphics Processing Clusters, и отличается от GPU, который мы рассматривали в обзоре GTX 680, только количеством активных блоков:

Чтобы обеспечить достаточно высокую производительность для успешной конкуренции с ускорителями компании AMD, в GeForce GTX 670 было решено использовать графический процессор GK104 с одним из восьми отключенных мультипроцессоров SMX. То есть, один из блоков SMX в чипе отключен аппаратно, и GTX 670 предлагает мощь 1344 вычислительных CUDA ядер, собранных в 7 мультипроцессоров.

Базовая тактовая частота чипа в GeForce GTX 670 равна 915 МГц, что на 10% ниже, чем у топовой GTX 680. Но средняя турбо-частота GPU Boost равна 980 МГц, что уже лишь на 8% меньше. Напомним, что GPU Boost позволяет графическим процессорам архитектуры Kepler автоматически увеличивать частоту GPU для достижения максимально возможной производительности. Об этой технологии можно подробно прочитать в базовом обзоре GeForce GTX 680. Реальная турбо-частота GK104 в случае GTX 670 зависит от конкретного 3D-приложения, и чаще всего составляет значение даже выше, чем 1 ГГц. Она обеспечивается в большом количестве игр и других приложений, использующих мощности GPU, хотя реальная турбо-частота для каждого приложения своя.

А вот подсистема памяти GeForce GTX 670 полностью идентична той, что мы видели в модели GTX 680, да и в двухчиповой GeForce GTX 690 тоже. Как и в случае этих моделей, работу графического процессора обеспечивает четыре 64-битных канала и контроллера памяти, что в сумме превращается в 256-битную шину памяти с достаточно высокой пропускной способностью, учитывая высокую тактовую частоту чипов видеопамяти. Её объём также остался неизменным — на плате установлено два гигабайта памяти GDDR5, работающей на той же высокой частоте в 6008 МГц.

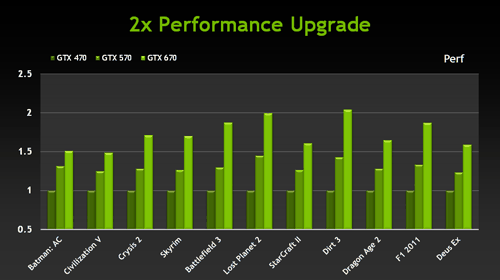

Как и следовало ожидать, производительность GeForce GTX 670 получилась довольно высокой. По тестам NVIDIA, во многих популярных игровых приложениях новинка догоняет по скорости даже Radeon HD 7970. И для тех активных игроков, кто планирует скорый апгрейд графической подсистемы, GeForce GTX 670 может стать неплохим вариантом. По сравнению с GeForce GTX 570 из предыдущего поколения, новая модель на Kepler обеспечивает 30-40% преимущества по скорости в самых требовательных играх, не говоря уже о более старых видеокартах, вроде GeForce GTX 470:

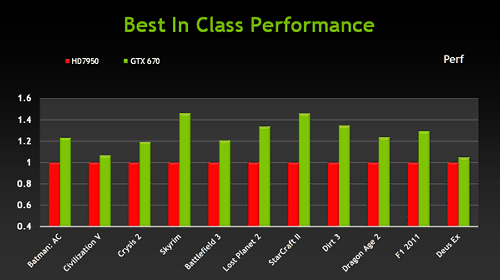

Но не только со своими предыдущими решениями сравнивает NVIDIA выпущенную сегодня модель GeForce GTX 670. Аналогичное сравнение по скорости GeForce GTX 670 проведено и с Radeon HD 7950 в играх вроде Elder Scrolls V: Skyrim и StarCraft 2, а также таких требовательных DirectX 11 приложениях, как Battlefield 3 и Crysis 2:

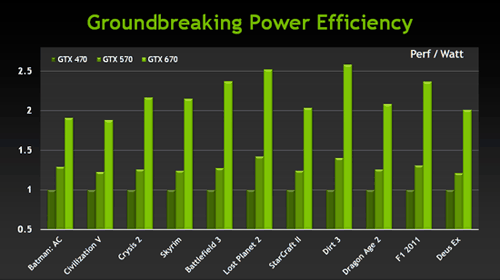

Как обычно в случае решений на базе архитектуры NVIDIA Kepler, более высокая частота кадров у GeForce GTX 670 дополняется улучшенной функциональностью (стереорендеринг и поддержка четырёх мониторов одной видеокартой) и отличными потребительскими свойствами в виде меньшего энергопотребления, а значит и шума от системы охлаждения. NVIDIA сравнивает энергоэффективность новинки с показателем GeForce GTX 470, получая почти 2,5-кратное преимущество:

Как и её более производительная сестра, новая модель GeForce GTX 670 поддерживает все технологии компании NVIDIA, в том числе Adaptive VSync, PhysX и 3D Vision Surround. И это не пустые слова, ведь скорости мощного чипа GK104 должно хватать даже для тяжёлых приложений с включением физических эффектов и стереорендеринга, кроме тех условий, когда рекомендуется применение выделенного GPU для PhysX-эффектов.

Дизайн и охлаждение платы

Референсная плата GeForce GTX 670 имеет длину 24 см (сравните с 25,5 см у GTX 680), но сама по себе печатная плата весьма короткая. Чтобы GeForce GTX 670 была совместимой с большинством систем, в PCB эталонного дизайна были внесены некоторые модификации. Из-за сниженных требований по питанию GK104, силовая часть была перемещена на другую сторону платы, ближе к видеоразъёмам. Сам графический процессор был повёрнут вокруг оси, часть элементов перенесены на заднюю часть платы, и схема питания теперь расположена к GPU гораздо ближе, чем обычно.

Такое решение в плате GeForce GTX 670 референсного дизайна позволило облегчить правую сторону печатной платы настолько, что появилась возможность значительно её укоротить. Но это касается лишь самой PCB, а кулер остался такой же, что и у GeForce GTX 680. Так как чип применён тот же GK104, да и его мощность отличается в GTX 670 не более чем на четверть, поэтому и система охлаждения применяется такая же.

О кулере этой модели подробно написано в выше GeForce GTX 680, в подошву радиатора встроены тепловые трубки, отводящие тепло от GPU, а в конструкции вентилятора используются специальные звукопоглощающие материалы, минимизирующие наиболее раздражающие слух частоты в шуме системы охлаждения. Вентилятор GTX 670 выдувает нагретый воздух из системного блока, что улучшает общее охлаждение системы и особенно важно для сравнительно небольших корпусов.

Но небольшой физический размер эталонной платы GeForce GTX 670 и её невысокое потребление энергии не значит, что она медленная. Новая модель предоставляет отличную производительность, так как основана на лишь незначительно «урезанном» чипе GK104, турбо-частота которого зачастую превышает 1 ГГц в большом количестве приложений, в среднем составляя 980 МГц. Кроме этого, обещается ещё и приличный разгон до частот выше 1,1 ГГц.

GeForce GTX 670 обеспечивает высочайшую производительность, ожидаемую от платы высокопроизводительного рыночного сегмента. По сравнению с решениями предыдущего поколения (GeForce GTX 580 и GTX 570) новинка не только быстрее, но и потребляет значительно меньше энергии — типичное потребление энергии в играх в среднем равно 141 Вт. Это значение справедливо для стандартных настроек, а при разгоне можно изменить параметр «power target» со 100% до +122%, получив улучшение разгонного потенциала и прирост типичного потребления до 173 Вт в среднем.

Применение эффективного кулера обеспечивает невысокий нагрев и тишину, а из-за нового дизайна PCB, видеокарта занимает меньше места в системном блоке. Кроме того, что производители готовых систем смогут создавать на основе GeForce GTX 670 компактные игровые системы высокой мощности, ожидается появление видеокарт оригинального дизайна с уменьшенными физическими габаритами, в том числе даже и с однослотовой системой охлаждения.

В случае с видеокартой модели GeForce GTX 670, партнёры компании NVIDIA получили возможность разработать платы собственного дизайна прямо с самого начала продаж. Поэтому, начиная с сегодняшнего дня, в рознице должны появиться различные модели GeForce GTX 670 от разных компаний, имеющие оригинальный дизайн печатных плат, систем питания и охлаждения, а также увеличенные частоты.

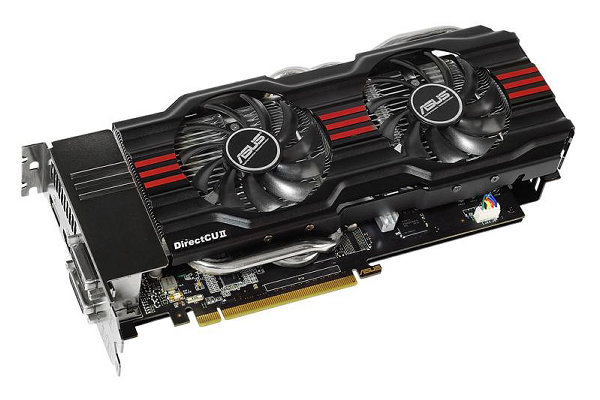

Такие решения появились у большинства партнёров калифорнийской компании, в том числе: ASUS, EVGA, Gainward, Galaxy, Gigabyte, MSI, Zotac и других. В качестве примера приведём две наиболее мощные модели. ASUS GeForce GTX 670 DirectCU II TOP имеет GPU, работающий на базовой частоте в 1058 МГц со средней турбо-частотой в 1137 МГц.

А ещё производительнее Zotac GeForce GTX 670 AMP! Edition, графический процессор в котором разогнан до 1098 МГц, турбо-частота равна 1176 МГц, и память также работает на увеличенной частоте в 6608 МГц. Пожалуй, это — один из наиболее мощных вариантов, способных догнать и GeForce GTX 680, работающие на эталонных частотах.

Многие из подобных моделей имеют усиленные системы питания с 8- и 6-контактными разъёмами дополнительного питания, увеличенным числом фаз и т.п. То же самое касается и систем охлаждения. Фабрично разогнанные варианты GeForce GTX 670 имеют ещё более эффективные кулеры с увеличенным количеством вентиляторов большого диаметра, что позволяет дополнительно улучшить эффективность охлаждения.

Всё остальное в GeForce GTX 670 мало чем отличается от того, что мы уже видели в предыдущей видеокарте GeForce GTX 680. Для вывода изображения GeForce GTX 670, как и старшая модель, имеет два выхода Dual Link DVI, один HDMI и один DisplayPort. Также отметим, что это решение позволяет вывести стереоизображение сразу на несколько мониторов при помощи технологии 3D Vision Surround, что ранее было доступно лишь в SLI-конфигурации.

Особенности модели GeForce GTX 690

Видеокарта на базе двух графических процессоров GK104 стала верхней моделью линейки GeForce GTX 600 и расположилась над быстрейшей одночиповой GeForce GTX 680. Что касается сравнения с конкурентом, то аналога по мощности и цене компания AMD так и не выпустила. Топовая плата GeForce на базе двух быстрейших GPU имеет название, отличающееся от аналогичной одночиповой модели лишь средней цифрой (680→690). Рекомендованная розничная цена решения для североамериканского рынка равна $999. Для нашей розницы цена ещё выше. Впрочем, подобные имиджевые решения в небольших количествах покупаются энтузиастами за любые деньги, и их цена не является определяющим фактором для покупки.

Так как двухчиповая модель имеет сдвоенную 256-битную шину памяти, то общий объём установленной на неё видеопамяти равен 2×2 ГБ. Это вполне достаточный объём, а 4 ГБ на чип — это было бы слишком много по разным причинам. Двух гигабайт на GPU должно хватать в большинстве режимов, и разве что в сверхвысоких разрешениях со стереорендерингом и/или сглаживанием может потребоваться больший объём.

Систему охлаждения и дизайн GeForce GTX 690 мы рассмотрим далее, а тут отметим, что плата двухслотовая, на неё установлено два 8-контактных разъёма питания, а также три выхода Dual-Link DVI и один mini-DisplayPort. Двухчиповая плата и не имеет HDMI выходов, в отличие от одночиповой GeForce GTX 680.

Имеющиеся на GeForce GTX 690 графические процессоры GK104 используют одинаковую конфигурацию мультипроцессоров, эти чипы состоят из четырёх кластеров графической обработки Graphics Processing Clusters каждый, и не отличаются от тех, что мы рассматривали в случае одночипового аналога.

Подсистема памяти двухчиповой GeForce GTX 690 также аналогична той, что мы видели в GeForce GTX 680, просто удвоенная — на каждый GPU приходится по четыре 64-битных канала памяти (256-бит на чип), и всего на плате установлено два набора по 2 ГБ быстрой GDDR5 видеопамяти. Причём её частота не отличается от частоты памяти в GTX 680 (то есть, 6008 МГц эффективной частоты) и это — правильное решение, так как нехватка пропускной способности видеопамяти в одночиповой модели иногда проявлялась.

Базовая (основная) частота графических процессоров в GTX 690 составляет 915 МГц, что на 10% ниже частоты GK104, установленного в одночиповой GTX 680. Но GK104 поддерживает технологию GPU Boost, которая позволяет GeForce GTX 690 автоматически увеличивать частоту GPU для достижения максимально возможной производительности. Об этой технологии можно подробно прочитать в базовом обзоре Kepler, а средняя турбо-частота для GeForce GTX 690 равна 1019 МГц, что лишь на 4% меньше, чем у одночипового варианта.

Высокая рабочая частота не отменяет её дальнейший возможный рост в рамках разгона. Наоборот, судя по всему, GeForce GTX 690 спроектирована для достижения максимальной производительности в том числе и в режиме разгона. Так, типичное потребление энергии в играх в среднем равно лишь 263 Вт, но плата оснащена двумя 8-контактными разъёмами дополнительного питания, которые вместе с PCI Express интерфейсом дают в сумме до 375 Вт доступной энергии. И даже с учётом максимального потребления в 300 Вт, у GTX 690 явно остаётся определённый запас по питанию. Вероятно, у энтузиастов разгона получится увеличить рабочую частоту GPU до 1,2 ГГц и даже выше.

Это важно, так как на предыдущих двухчиповых видеокартах компании NVIDIA важнейшим фактором ограничения производительности было высокое энергопотребление. К примеру, на GeForce GTX 295 и GTX 590 устанавливались видеочипы, работающие на значительно сниженных частотах, по сравнению с их одночиповыми собратьями GTX 285 и GTX 580. В случае GeForce GTX 690 удалось снизить влияние этого фактора, так как архитектура Kepler отличается весьма высокой энергоэффективностью.

Поэтому графические процессоры GK104, на которых основана новая модель GeForce GTX 690, имеют турбо-частоту, мало отличающуюся от той, что имеет GPU одночиповой GeForce GTX 680. При этом чипы GK104 и там и там идентичны и не имеют отключенных исполнительных блоков. Частоты и шины памяти также абсолютно одинаковы, и пропускная способность видеопамяти не пострадала. В результате, GeForce GTX 690 обеспечивает уровень производительности, сравнимый с тем, который даёт пара видеокарт GeForce GTX 680, работающих в SLI-режиме.

Но у GeForce GTX 690 есть и преимущества перед двумя одночиповыми платами. Во-первых, эта модель нуждается лишь в одном полноразмерном слоте PCI Express. Во-вторых, GeForce GTX 690 потребляет значительно меньше энергии, чем две платы GTX 680, и выделяет тепла меньше, что даёт меньший уровень шума от системы охлаждения. И, в-третьих, две GeForce GTX 690 можно объединить в ещё более производительную монструозную систему Quad SLI.

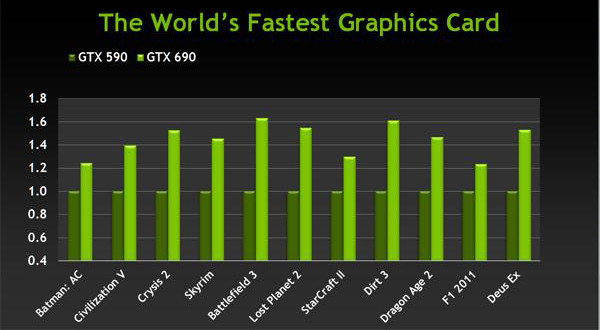

Кстати, о производительности. Понятно, что GeForce GTX 690 обеспечивает высочайшую скорость рендеринга в 3D приложениях. На момент выхода это быстрейшая видеокарта на рынке, и по данным компании NVIDIA, она в среднем на 45% быстрее, чем предыдущий двухчиповый вариант — GeForce GTX 590, хотя такой разрыв в скорости между ними наблюдается не везде:

Но не только производительность важна в современных условиях. Сейчас всё чаще упирают на показатель энергоэффективности, который становится всё более важным, особенно в случае таких мощных двухчиповых решений как GeForce GTX 690. По сравнению с той же двухчиповой GeForce GTX 590, новая плата обеспечивает до двух раз более высокую энергоэффективность (в среднем — 70-75%):

Как и её младшая сестра, новая двухчиповая модель GeForce GTX 690 поддерживает все технологии компании, в том числе Adaptive VSync, PhysX и 3D Vision Surround. Причём, некоторые технологии, такие как PhysX и 3D Vision Surround, в случае этой модели имеют даже больше смысла, так как GeForce GTX 690 обеспечивает более высокую производительность, которая никогда не помешает в тяжёлых приложениях, особенно с включением тяжёлых физических эффектов и стереорендеринга.

Например, в некоторых играх для оптимальной производительности в высоких разрешениях с максимальными настройками качества, NVIDIA рекомендует применение выделенного GPU для PhysX-эффектов. А GeForce GTX 690 уже содержит два графических процессора на борту, что позволяет выделить один из них под физические расчёты при такой необходимости. То же самое касается и стереорежима, особенно в высоких разрешениях на несколько экранов — GeForce GTX 690 обеспечивает достаточно производительности, чтобы насладиться высокой частотой кадров в таких условиях.

Но самой любопытной новой функциональностью в вышедшей двухчиповой видеокарте NVIDIA нам видится аппаратное измерение частоты кадров, позволяющее минимизировать проблемы мультичиповых решений, такие как небольшие, но неприятные скачки частоты кадров, более известные как micro-stuttering.

В режиме SLI современные видеочипы работают в режиме AFR-рендеринга, когда каждый графический процессор занимается своими кадрами: один чётными, другой — нечётными. И из-за того, что нагрузка на GPU в разных кадрах может отличаться, видеочипы справляются с работой за разное время, а при выводе отрендеренных кадров на экран возникает нестабильность FPS. В GeForce GTX 690 появился механизм аппаратного измерения FPS и регулирования потока кадров. Он постоянно отслеживает частоту кадров и сглаживает пики FPS, возникающие по причине разности во времени обработки кадров, и в результате смена кадров происходит плавнее, по сравнению с предыдущими SLI-системами.

Дизайн и охлаждение платы

Рассматриваемая двухчиповая плата компании NVIDIA имеет необычный даже для топовых плат дизайн, отражающий её непревзойдённую игровую производительность и цену. Так, каждый GPU двухчиповой видеокарты имеет свой отдельный радиатор — они видны в прозрачных пластиковых окошках на плате. А для любителей прозрачных корпусов и светодиодов на торце платы есть светящийся логотип GeForce GTX.

Кожух системы охлаждения новой видеокарты сделан из покрытого хромом алюминия, а кожух вентилятора выполнен из магниевого сплава — лёгкого материала с хорошей теплопроводностью — эти же характеристики и послужили причиной его применения в GeForce GTX 690. Эти необычные решения явно придают видеокарте солидный вид, что важно для топового сегмента. Ведь если пользователь заплатил за видеокарту столько денег, то ему явно хотелось бы, чтобы она и выглядела дорого.

Как всегда, создание двухчиповой видеокарты экстремальной мощности — не самое простое занятие. В процессе её проектирования возникает масса интересных и сложных задач, в числе которых питание двух GPU от одного источника (а сейчас цепи питания даже на одночиповых картах довольно сложны) и достаточно эффективное охлаждение графических процессоров, расположенных близко друг к другу на одной печатной плате.

Больше всего ограничивает полёт фантазии конструкторов физически доступное пространство — ведь помимо двух GPU, на печатной плате нужно расположить два комплекта видеопамяти с собственной шиной, а также коммутатор, обеспечивающий работу двух чипов с одним слотом PCI Express. Несмотря на это, для обеспечения более широкой совместимости с игровыми системами, в NVIDIA решили ограничить длину двухчиповой платы 11 дюймами (28 см). Можете сравнить её с 25,5-сантиметровой GeForce GTX 680, имеющей вдвое меньшее кол-во микросхем памяти и самих GPU.

Сюда же относятся и трудности с обеспечением приемлемого охлаждения. Та же GeForce GTX 680 имеет чуть меньшую PCB, зато большой кулер с тепловыми трубками и крупными радиатором и вентилятором. В случае двух графических чипов на почти такой же площади охладить их заметно сложнее. Чтобы решить эту задачу, инженеры компании NVIDIA постарались использовать площадь и объём платы максимально эффективно. Печатная плата десятислойная (у GTX 590 было 12 слоёв, но там две 384-битные шины памяти), а в слоях питания применяется много меди, что обеспечивает высокую надёжность и эффективность, а также улучшает тепловые характеристики.

Для достижения лучшей эффективности охлаждения в столь сложных условиях недостатка места на плате, каждый GPU имеет свой выделенный радиатор, основанный на медной испарительной камере и рёбрах радиатора двухслотовой высоты. А для лучшего охлаждения задней стороны платы и установленных на неё компонентов, используется дополнительная алюминиевая пластина.

Кулер оснащен низкоскоростным вентилятором с крыльчаткой большого диаметра. Для увеличения эффективности охлаждения и снижения шума от вентилятора был проработан кожух системы охлаждения — прямо под вентилятором спроектированы специальные каналы низкого профиля для направления потока воздуха на радиаторы. Также инженеры NVIDIA улучшили управляющую логику вентилятора, скорость его вращения изменяется плавно, а не пошагово.

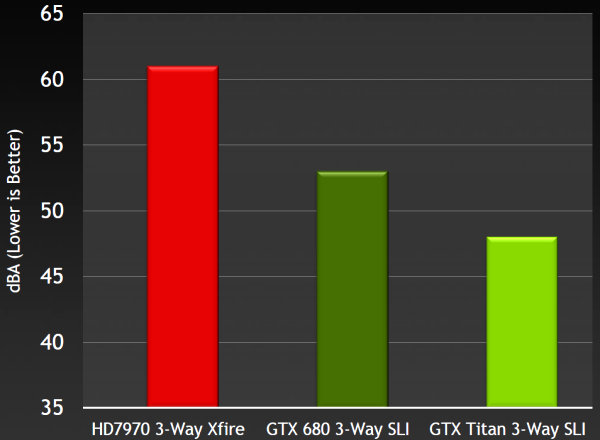

В результате всех оптимизаций, уровень шума не просто снизился, а были приглушены отчётливо слышимые высокочастотные звуки, вызывающие наибольшие нарекания. Ну а об общем уровне шума можно судить по цифрам для GeForce GTX 690 и пары GeForce GTX 680 в режиме SLI. Если вентиляторы двух одночиповых карт шумят на 51 децибел (дБА), то новая GeForce GTX 690 лишь на 47 дБА — приличная разница.

Выше написано, что графический процессор GK104 обладает поддержкой PCI Express 3.0. Эта версия обладает скоростью передачи 8 гигатранзакций в секунду вместо 5 ГТ/с для версии 2.0, и его пропускная способность выросла вдвое, по сравнению со стандартом предыдущей версии. Поэтому старый чип-коммутатор NF200, который применялся ещё со времён GeForce GTX 295, в данном случае не подходит, так как не рассчитан на шину PCI Express 3.0.

Компания AMD использовала в своих двухчиповых видеокартах решения компании PLX Technology (пусть и со своей маркировкой) ещё давно, а NVIDIA ранее применяла собственные давние разработки. Но NF200 тут не подходит, а новый коммутатор они решили не разрабатывать, используя коммутатор PEX 8747 от PLX Technology. Микросхема коммутатора обеспечивает независимый доступ двух GPU к PCI Express 3.0 x16 интерфейсу, разделяя пропускную способность одного слота на два графических процессора.

PLX Technology — хорошо известный разработчик подобных решений, их микросхемы встречаются на видеокартах, системных платах и разнообразных контроллерах и адаптерах. Интересно, что на днях появилось сообщение о покупке PLX Technology компанией Integrated Device Technology (IDT), который близки по специализации.

Коммутатор PEX 8747 — 48-канальный и пятипортовый, он поддерживает третье поколение PCI Express. В конфигурации двухчиповой видеокарты коммутатор раздаёт каждому GPU по 16 каналов PCI-E, но с вдвое меньшей пропускной способностью (ведь один x16 слот делится на два чипа). PEX 8747 оптимизирован для использования в высокопроизводительных графических задачах и обеспечивает высокую скорость и малые задержки. К слову, данный чип-коммутатор производится по 40 нм технологическому процессу и потребляет до 8 Вт энергии, что также необходимо учитывать при конструировании двухчиповой платы и её системы охлаждения.

Всё остальное в GeForce GTX 690 мало чем отличается от систем из двух видеокарт GeForce GTX 680, объединённых в режиме SLI. Например, для повышения качества изображения можно использовать специфичные для SLI-конфигураций режимы с большим количеством выборок. Для вывода изображения GeForce GTX 690 имеет три разъёма Dual Link DVI и один mini DisplayPort. Это решение позволяет вывести стереоизображение на несколько мониторов при помощи технологии 3D Vision Surround.

Особенности модели GeForce GTX 660 Ti

- Базовая частота ядра 915 МГц;

- Средняя турбо-частота 980 МГц;

- Количество универсальных процессоров 1344;

- Количество текстурных блоков — 112, блоков блендинга — 24;

- Эффективная частота памяти 6008 (1502×4) МГц;

- Тип памяти GDDR5, 192-битная шина памяти;

- Объем памяти 2 ГБ;

- Пропускная способность памяти 144,2 ГБ/с;

- Теоретическая максимальная скорость закраски 22,0 гигапикселей в секунду;

- Теоретическая скорость выборки текстур 102,5 гигатекселей в секунду;

- Два разъема Dual Link DVI-I, один HDMI, один DisplayPort;

- Двойной SLI-разъем;

- Шина PCI Express 3.0;

- Энергопотребление до 150 Вт;

- Два 6-контактных разъёма питания;

- Двухслотовое исполнение;

- Рекомендуемая цена для России 11 999 руб.

В линейке решений компании NVIDIA модель GeForce GTX 660 Ti занимает место между старшей GeForce GTX 670 и младшей GeForce GTX 660, замещая топовые платы предыдущего поколения, вроде GeForce GTX 570 и GTX 580, предлагаемые до выхода решений на базе архитектуры Kepler среднего уровня. Принцип наименования видеокарт NVIDIA сохранился, модель в шаге от более старших получила изменение средней цифры индекса, а также суффикс «Ti», означающий то, что существует ещё и GTX 660 без этой приставки, как в линейке предыдущего поколения.

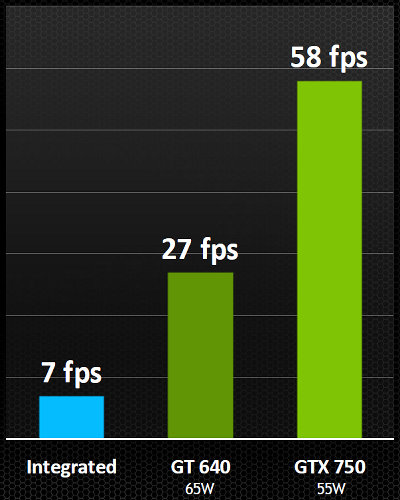

Интересно, что до выхода ожидаемого чипа GK106 и видеокарт среднего уровня на его основе, было принято решение выпустить ещё более урезанную модель на базе GK104. Вероятно, и с производством на TSMC получше стало, и бракованные GK104 уже накопились, да и запас топовых видеокарт серии GTX 500 потихоньку иссякает. Кроме того — надо уже конкурировать с Radeon HD 7870 чем-то более современным. Кстати, ещё одним конкурентом для GTX 660 Ti стала модель Radeon HD 7950, с ними и нужно сравнивать новинку. Рекомендуемая рыночная цена GeForce GTX 660 Ti для российского рынка на старте продаж была установлена равной 11 999 руб.