–°–Њ–і–µ—А–ґ–∞–љ–Є–µ

- –І–∞—Б—В—М 1 вАФ –Ґ–µ–Њ—А–Є—П –Є –∞—А—Е–Є—В–µ–Ї—В—Г—А–∞

- –І–∞—Б—В—М 2 вАФ –Я—А–∞–Ї—В–Є—З–µ—Б–Ї–Њ–µ –Ј–љ–∞–Ї–Њ–Љ—Б—В–≤–Њ

- –І–∞—Б—В—М 3 вАФ –†–µ–Ј—Г–ї—М—В–∞—В—Л –Є–≥—А–Њ–≤—Л—Е —В–µ—Б—В–Њ–≤ (–њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М)

–Э–µ—Б–Љ–Њ—В—А—П –љ–∞ —Б–∞–Љ—Л–µ –Љ—А–∞—З–љ—Л–µ –њ—А–Њ–≥–љ–Њ–Ј—Л, –њ—А–µ–і–≤–µ—Й–∞—О—Й–Є–µ —А—Л–љ–Ї—Г –Я–Ъ —В—П–ґ–µ–ї—Л–µ –≤—А–µ–Љ–µ–љ–∞, –±–Є–Ј–љ–µ—Б –њ—А–Њ–і–Њ–ї–ґ–∞–µ—В—Б—П –Є –і–∞–ґ–µ —А–∞–Ј–≤–Є–≤–∞–µ—В—Б—П. –Я—Г—Б—В—М –≤ IT-–Є–љ–і—Г—Б—В—А–Є–Є –і–Њ–ї—П, –≤—Л–њ–∞–і–∞—О—Й–∞—П –љ–∞ –њ—А–Њ–Є–Ј–≤–Њ–і—Б—В–≤–Њ –Ї–Њ–Љ–њ–ї–µ–Ї—В—Г—О—Й–Є—Е –і–ї—П –Я–Ъ, —Г–Љ–µ–љ—М—И–∞–µ—В—Б—П, –љ–Њ –Њ–љ–∞ –µ—Й–µ –Њ—З–µ–љ—М –≤–µ–ї–Є–Ї–∞, –і–∞ –Є –љ–µ —Г–њ–∞–і–µ—В —В–∞–Ї –Ї–∞—В–∞—Б—В—А–Њ—Д–Є—З–љ–Њ, –Ї–∞–Ї —Г–ґ–µ –Ї—А–Є—З–∞—В –Є—Б—В–µ—А–Є—З–љ—Л–µ –∞–љ–∞–ї–Є—В–Є–Ї–Є –Є –њ—Б–µ–≤–і–Њ—Н–Ї—Б–њ–µ—А—В—Л. –Т—Л–њ—Г—Б–Ї –љ–Њ–≤–Є–љ–Њ–Ї –і–ї—П —Н—В–Њ–≥–Њ —Б–µ–≥–Љ–µ–љ—В–∞ —А—Л–љ–Ї–∞ –±—Л–ї, –µ—Б—В—М –Є –±—Г–і–µ—В.

–Ш –≤–Њ—В —Б–µ–≥–Њ–і–љ—П –Љ—Л –±—Г–і–µ–Љ –Є–Ј—Г—З–∞—В—М –љ–Њ–≤—Л–є —Д–ї–∞–≥–Љ–∞–љ Nvidia вАФ –Њ–і–љ–Њ–њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ–Њ–µ —А–µ—И–µ–љ–Є–µ, –њ—А–Є–Ј–≤–∞–љ–љ–Њ–µ –љ–µ —В–Њ–ї—М–Ї–Њ –њ–Њ–±–µ–і–Є—В—М –≤—Б–µ—Е –Ї–Њ–љ–Ї—Г—А–µ–љ—В–Њ–≤ —Б—А–µ–і–Є —Г—Б–Ї–Њ—А–Є—В–µ–ї–µ–є —Б –Њ–і–љ–Є–Љ GPU, –љ–Њ –Є –≤–њ–ї–Њ—В–љ—Г—О –њ—А–Є–±–ї–Є–Ј–Є—В—М—Б—П –Ї –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –љ—Л–љ–µ—И–љ–Є—Е –і–≤—Г—Е–њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ—Л—Е –Ї–Њ—А–Њ–ї–µ–є. –Я–Њ—З–µ–Љ—Г ¬Ђ–Ї–Њ—А–Њ–ї–µ–є¬ї, –∞ –љ–µ ¬Ђ–Ї–Њ—А–Њ–ї—П¬ї (–≤ —Г—Б–ї–Њ–≤–Є—П—Е –Њ—Д–Є—Ж–Є–∞–ї—М–љ–Њ–≥–Њ –≤—Л–њ—Г—Б–Ї–∞ —В–Њ–ї—М–Ї–Њ –Њ–і–љ–Њ–≥–Њ –њ—А–Њ–і—Г–Ї—В–∞ вАФ Geforce GTX 690)? –Я–Њ—В–Њ–Љ—Г —З—В–Њ —Г–ґ–µ –µ—Б—В—М Asus ARES II (–і–≤–∞ Radeon HD 7970 GHz –љ–∞ –Њ–і–љ–Њ–є –њ–ї–∞—В–µ), –і–∞ –Є –Њ—Д–Є—Ж–Є–∞–ї—М–љ—Л–є –≤—Л–њ—Г—Б–Ї Radeon HD 7990 –Њ—З–µ–љ—М –±–ї–Є–Ј–Њ–Ї. –Ш—В–∞–Ї, –Њ –љ–Њ–≤–Є–љ–Ї–µ —А–∞—Б—Б–Ї–∞–ґ–µ—В –Р–ї–µ–Ї—Б–µ–є –С–µ—А–Є–ї–ї–Њ.

–І–∞—Б—В—М 1: –Ґ–µ–Њ—А–Є—П –Є –∞—А—Е–Є—В–µ–Ї—В—Г—А–∞

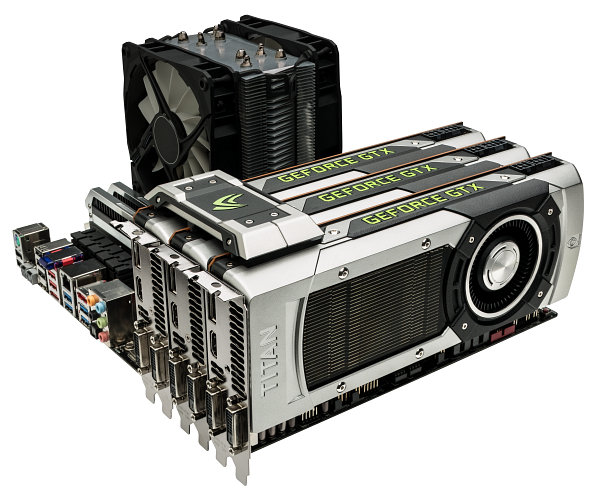

–Э—Г –≤–Њ—В –Љ—Л –Є –і–Њ–ґ–і–∞–ї–Є—Б—М –љ–∞—Б—В–Њ—П—Й–µ–≥–Њ —В–Њ–њ–Њ–≤–Њ–≥–Њ —А–µ—И–µ–љ–Є—П –Ї–Њ–Љ–њ–∞–љ–Є–Є Nvidia. –Р–љ–Њ–љ—Б–Є—А–Њ–≤–∞–љ–љ–∞—П –љ–µ–і–∞–≤–љ–Њ –Љ–Њ–і–µ–ї—М Geforce GTX Titan, –Ї–Њ—В–Њ—А—Г—О –Љ—Л —Б–µ–≥–Њ–і–љ—П —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞–µ–Љ, –Њ—Б–љ–Њ–≤–∞–љ–∞ –љ–∞ —Б–∞–Љ–Њ–Љ –Љ–Њ—Й–љ–Њ–Љ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–Љ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–µ –Є –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ–∞ –і–ї—П —Н–Ї—Б—В—А–µ–Љ–∞–ї—М–љ—Л—Е –Є–≥—А–Њ–≤—Л—Е –Я–Ъ –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ–є –Љ–Њ—Й–љ–Њ—Б—В–Є. –Ъ–Њ–Љ–њ–∞–љ–Є—П Nvidia –і–µ–ї–∞–µ—В —Б–µ—А—М–µ–Ј–љ—Г—О —Б—В–∞–≤–Ї—Г –љ–∞ —Н–љ—В—Г–Ј–Є–∞—Б—В–Њ–≤, –њ—А–µ–і–њ–Њ–ї–∞–≥–∞—П —И–Є—А–Њ–Ї–Њ–µ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є–µ –Є –Љ–љ–Њ–≥–Њ—З–Є–њ–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ, –≤ —В–Њ–Љ —З–Є—Б–ї–µ 3-way SLI –Є–Ј —В—А–µ—Е –≤–Є–і–µ–Њ–Ї–∞—А—В Geforce GTX Titan, –љ–Њ —В–∞–Ї–ґ–µ –њ—А–µ–і–њ–Њ–ї–∞–≥–∞–µ—В—Б—П –Є –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –љ–Њ–≤–Њ–є –Љ–Њ–і–µ–ї–Є –≤ –Ї–Њ–Љ–њ–∞–Ї—В–љ—Л—Е –Є–≥—А–Њ–≤—Л—Е –Я–Ъ вАФ —В–∞–Ї –љ–∞–Ј—Л–≤–∞–µ–Љ—Л—Е –Љ–Њ–і–µ–ї—П—Е small form factor (SFF).

–Э–Њ–≤–∞—П –≤–Є–і–µ–Њ–Ї–∞—А—В–∞ –±–∞–Ј–Є—А—Г–µ—В—Б—П –љ–∞ –і–Њ–ї–≥–Њ–ґ–і–∞–љ–љ–Њ–Љ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–Љ —З–Є–њ–µ Nvidia GK110, –Ї–Њ—В–Њ—А—Л–є –µ—Й–µ –і–∞–≤–љ–Њ –і–Њ–ї–ґ–µ–љ –±—Л–ї —Б—В–∞—В—М –Њ—Б–љ–Њ–≤–Њ–є —В–Њ–њ–Њ–≤—Л—Е —А–µ—И–µ–љ–Є–є –Ї–Њ–Љ–њ–∞–љ–Є–Є, –љ–Њ –њ–Њ –љ–µ–Ї–Њ—В–Њ—А—Л–Љ –њ—А–Є—З–Є–љ–∞–Љ —В–∞–Ї –Є –љ–µ —Б—В–∞–ї. –Т —Б–≤–Њ–µ –≤—А–µ–Љ—П –њ—А–µ–і—Б—В–∞–≤–Є—В–µ–ї–Є Nvidia –≤—Л—Б–Ї–∞–Ј—Л–≤–∞–ї–Є—Б—М –љ–∞ —В–µ–Љ—Г —В–Њ–≥–Њ, —З—В–Њ –љ–∞ —А—Л–љ–Ї–µ –Є–≥—А–Њ–≤—Л—Е –≤–Є–і–µ–Њ–Ї–∞—А—В –і–ї—П —Г—Б–њ–µ—И–љ–Њ–є –Ї–Њ–љ–Ї—Г—А–µ–љ—Ж–Є–Є –Є–Љ —Е–≤–∞—В–Є—В –Є –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞, –њ—А–µ–і–љ–∞–Ј–љ–∞—З–∞–≤—И–µ–≥–Њ—Б—П –Є–Ј–љ–∞—З–∞–ї—М–љ–Њ –і–ї—П –≤–µ—А—Е–љ–µ–≥–Њ/—Б—А–µ–і–љ–µ–≥–Њ —Ж–µ–љ–Њ–≤–Њ–≥–Њ —Г—А–Њ–≤–љ—П вАФ GK104. –°–Њ–±—Б—В–≤–µ–љ–љ–Њ, –њ—А–∞–Ї—В–Є–Ї–∞ –њ–Њ–Ї–∞–Ј–∞–ї–∞, —З—В–Њ –Њ–љ–Є –љ–µ –Њ—И–Є–±–ї–Є—Б—М, Geforce GTX 660 Ti, GTX 670 –Є GTX 680 —Г—Б–њ–µ—И–љ–Њ –Ї–Њ–љ–Ї—Г—А–Є—А–Њ–≤–∞–ї–Є —Б –њ—А–µ–і–ї–Њ–ґ–µ–љ–Є—П–Љ–Є AMD –љ–∞ —А—Л–љ–Ї–µ –≤–Є–і–µ–Њ–Ї–∞—А—В, –∞ –і–≤—Г—Е—З–Є–њ–Њ–≤–∞—П GTX 690 —Б—В–∞–ї–∞ –±—Л—Б—В—А–µ–є—И–µ–є –≤–Є–і–µ–Њ–Ї–∞—А—В–Њ–є –≤–Њ–Њ–±—Й–µ.

–Э–Њ –≤—А–µ–Љ—П —И–ї–Њ, –Ї–Њ–љ–Ї—Г—А–µ–љ—В —Г—Б–њ–µ–ї –≤—Л–≤–µ—Б—В–Є –љ–∞ —А—Л–љ–Њ–Ї —Б–≤–Њ–µ –љ–∞–Є–±–Њ–ї–µ–µ –Љ–Њ—Й–љ–Њ–µ –Њ–і–љ–Њ—З–Є–њ–Њ–≤–Њ–µ —А–µ—И–µ–љ–Є–µ вАФ Radeon HD 7970 GHz, –Є Nvidia –≤—Б–µ-—В–∞–Ї–Є —А–µ—И–Є–ї–∞ –≤—Л–њ—Г—Б—В–Є—В—М —А–µ—И–µ–љ–Є—П –љ–∞ –±–∞–Ј–µ GK110 –Є –љ–∞ –Є–≥—А–Њ–≤–Њ–є —А—Л–љ–Њ–Ї. –†–∞–љ–µ–µ —В–∞–Ї–Є–µ –њ–ї–∞—В—Л –≤—Л—И–ї–Є –і–ї—П –њ—А–Њ—Д–µ—Б—Б–Є–Њ–љ–∞–ї—М–љ—Л—Е –њ—А–Є–Љ–µ–љ–µ–љ–Є–є –≤ –љ–µ–≥—А–∞—Д–Є—З–µ—Б–Ї–Є—Е –≤—Л—З–Є—Б–ї–µ–љ–Є—П—Е –≤ –≤–Є–і–µ –њ—А–Њ–і—Г–Ї—В–Њ–≤ —Б–µ—А–Є–Є Tesla, –∞ —В–µ–њ–µ—А—М –Є –≤—А–µ–Љ—П Geforce –њ–Њ–і–Њ—И–ї–Њ. –Т–µ—А–Њ—П—В–љ–Њ, –Є —Б –њ—А–Њ–Є–Ј–≤–Њ–і—Б—В–≤–Њ–Љ —Б–ї–Њ–ґ–љ—Л—Е —З–Є–њ–Њ–≤ –љ–∞ TSMC —Б—В–∞–ї–Њ –њ–Њ–њ—А–Њ—Й–µ, –і–∞ –Є –Ј–∞–Є–љ—В–µ—А–µ—Б–Њ–≤—Л–≤–∞—В—М –Ј–∞—Б—В–Њ—П–≤—И–Є–є—Б—П —А—Л–љ–Њ–Ї –Ї–∞–Ї–Є–Љ–Є-—В–Њ –љ–Њ–≤—Л–Љ–Є –њ—А–Њ–і—Г–Ї—В–∞–Љ–Є –љ—Г–ґ–љ–Њ, –і–∞–ґ–µ –µ—Б–ї–Є —Г –љ–Є—Е –љ–µ—В –Ї–Њ–љ–Ї—Г—А–µ–љ—В–Њ–≤.

–Х—Б—В–µ—Б—В–≤–µ–љ–љ–Њ, —З—В–Њ —Г Nvidia –њ–Њ–ї—Г—З–Є–ї–∞—Б—М –≤–µ—Б—М–Љ–∞ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–∞—П –≤–Є–і–µ–Њ–Ї–∞—А—В–∞. –Х—Б–ї–Є –љ–µ–Љ–љ–Њ–≥–Њ –Ј–∞–±–µ–ґ–∞—В—М –≤–њ–µ—А–µ–і, —В–Њ –Љ–Њ–ґ–љ–Њ –≤—Л–і–µ–ї–Є—В—М, —З—В–Њ —З–Є–њ GK110 –Њ—В–ї–Є—З–∞–µ—В—Б—П –Њ–≥—А–Њ–Љ–љ–Њ–є –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ–Њ–є –Љ–Њ—Й—М—О, –Њ–љ –≤–Ї–ї—О—З–∞–µ—В 14 –Љ—Г–ї—М—В–Є–њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ SMX, —Б–Њ–і–µ—А–ґ–∞—Й–Є—Е 2688 –њ–Њ—В–Њ–Ї–Њ–≤—Л—Е –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л—Е —П–і–µ—А, —З—В–Њ –≤ –Є—В–Њ–≥–µ –і–∞–µ—В –њ–Є–Ї–Њ–≤—Г—О –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –і–Њ 4,5 —В–µ—А–∞—Д–ї–Њ–њ—Б –і–ї—П —А–∞—Б—З–µ—В–Њ–≤ —Б –Њ–і–Є–љ–∞—А–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О (FP32) –Є –і–Њ 1,3 —В–µ—А–∞—Д–ї–Њ–њ—Б –і–ї—П —А–∞—Б—З–µ—В–Њ–≤ —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О (FP64). –Э–Њ –≤–Њ–Ј—А–Њ—Б–ї–Є –љ–µ —В–Њ–ї—М–Ї–Њ –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л–µ —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В–Є, Geforce GTX Titan —В–∞–Ї–ґ–µ –Є–Љ–µ–µ—В 6 –≥–Є–≥–∞–±–∞–є—В –≤–Є–і–µ–Њ–њ–∞–Љ—П—В–Є, —Б–Њ–µ–і–Є–љ–µ–љ–љ–Њ–є —Б GPU –њ—А–Є –њ–Њ–Љ–Њ—Й–Є 384-–±–Є—В–љ–Њ–є —И–Є–љ—Л –њ–∞–Љ—П—В–Є, —З—В–Њ –і–∞–µ—В –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П —Б–≤–µ—А—Е–≤—Л—Б–Њ–Ї–Є—Е —А–∞–Ј—А–µ—И–µ–љ–Є–є –Є –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Л—Е —Г—А–Њ–≤–љ–µ–є –њ–Њ–ї–љ–Њ—Н–Ї—А–∞–љ–љ–Њ–≥–Њ —Б–≥–ї–∞–ґ–Є–≤–∞–љ–Є—П, –∞ —В–∞–Ї–ґ–µ –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Л—Е –≥—А–∞—Д–Є—З–µ—Б–Ї–Є—Е –љ–∞—Б—В—А–Њ–µ–Ї –≤ –ї—О–±—Л—Е –њ—А–Є–ї–Њ–ґ–µ–љ–Є—П—Е.

–Ъ—А–Њ–Љ–µ —Н—В–Њ–≥–Њ, –і–ї—П Geforce GTX Titan –±—Л–ї–∞ —Г–ї—Г—З—И–µ–љ–∞ —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П GPU Boost, –њ–Њ–ї—Г—З–Є–≤—И–∞—П –≤ –Є—В–Њ–≥–µ –≤–µ—А—Б–Є—О 2.0, –∞ —В–∞–Ї–ґ–µ —А–∞–Ј—А–∞–±–Њ—В–∞–љ–Њ –љ–Њ–≤–Њ–µ –≤—Л—Б–Њ–Ї–Њ—Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ–µ —Г—Б—В—А–Њ–є—Б—В–≤–Њ –Њ—Е–ї–∞–ґ–і–µ–љ–Є—П, –Ї–Њ—В–Њ—А–Њ–µ –Њ—В–ї–Є—З–∞–µ—В—Б—П —Г–ї—Г—З—И–µ–љ–љ—Л–Љ–Є –∞–Ї—Г—Б—В–Є—З–µ—Б–Ї–Є–Љ–Є —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–∞–Љ–Є. –Ю–±–µ—Й–∞–µ—В—Б—П, —З—В–Њ –≤—Б–µ —Н—В–Њ –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –љ–µ —В–Њ–ї—М–Ї–Њ –≤—Л—Б–Њ—З–∞–є—И—Г—О –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М, –љ–Њ –Є —В–Є—Е—Г—О —А–∞–±–Њ—В—Г –њ—А–Є –≤—Л—Б–Њ–Ї–Њ–є —Н–љ–µ—А–≥–Њ—Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є. –Э–Њ –і–∞–≤–∞–є—В–µ –Њ–±–Њ –≤—Б–µ–Љ –њ–Њ –њ–Њ—А—П–і–Ї—ГвА¶

–Ґ–∞–Ї –Ї–∞–Ї —А–∞—Б—Б–Љ–∞—В—А–Є–≤–∞–µ–Љ–∞—П —Б–µ–≥–Њ–і–љ—П –≤–Є–і–µ–Њ–Ї–∞—А—В–∞ Nvidia –Њ—Б–љ–Њ–≤–∞–љ–∞ –љ–∞ –±–∞–Ј–µ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞ –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л ¬ЂKepler¬ї, –Њ –Ї–Њ—В–Њ—А–Њ–є –Љ—Л —Г–ґ–µ –љ–µ —А–∞–Ј –њ–Њ–і—А–Њ–±–љ–Њ —А–∞—Б—Б–Ї–∞–Ј—Л–≤–∞–ї–Є –Є –Ї–Њ—В–Њ—А–∞—П –±–ї–Є–Ј–Ї–∞ –Ї —А–Њ–і—Б—В–≤–µ–љ–љ–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А–µ ¬ЂFermi¬ї, —В–Њ —З–Є—В–∞—В–µ–ї—П–Љ –±—Г–і–µ—В –њ–Њ–ї–µ–Ј–љ–Њ –Њ–Ј–љ–∞–Ї–Њ–Љ–Є—В—М—Б—П —Б–Њ —Б—В–∞—В—М—П–Љ–Є –Є –Њ –±–Њ–ї–µ–µ —А–∞–љ–љ–Є—Е –Љ–Њ–і–µ–ї—П—Е –≥—А–∞—Д–Є—З–µ—Б–Ї–Є—Е —А–µ—И–µ–љ–Є–є –Ї–Њ–Љ–њ–∞–љ–Є–Є:

- [31.10.12] Nvidia Geforce GTX 650 Ti вАФ —Б–Њ–њ–µ—А–љ–Є–Ї GTX 560, –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ –Њ–њ–µ—А–µ–ґ–∞—О—Й–Є–є GTX 550 Ti

- [13.09.12] Nvidia Geforce GTX 660 вАФ —Е–Њ—А–Њ—И–Є–є –і–Њ–±—А–Њ—В–љ—Л–є —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–є —Б–µ—А–µ–і–љ—П—З–Њ–Ї

- [10.05.12] Nvidia Geforce GTX 670 вАФ 7/8 –Њ—В –Њ–і–љ–Њ–њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ–Њ–≥–Њ –ї–Є–і–µ—А–∞ GTX 670: –Љ–љ–Њ–≥–Њ —Н—В–Њ –Є–ї–Є –Љ–∞–ї–Њ?

- [22.03.12] Nvidia Geforce GTX 680 вАФ –љ–Њ–≤—Л–є –Њ–і–љ–Њ–њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ—Л–є –ї–Є–і–µ—А 3D-–≥—А–∞—Д–Є–Ї–Є

- [09.11.10] Nvidia Geforce GTX 580 вАФ –љ–Њ–≤—Л–є –Ї–Њ—А–Њ–ї—М 3D-–≥—А–∞—Д–Є–Ї–Є –љ–∞ –Ј–∞–Ї–∞—В–µ 2010 –≥–Њ–і–∞

- [27.03.10] Nvidia Geforce GTX 480 вАФ –∞—А—Е–Є—В–µ–Ї—В—Г—А–∞ –љ–Њ–≤–Њ–≥–Њ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞ –Є–Ј–љ—Г—В—А–Є; –Ї–∞–Ї —А–µ–∞–ї–Є–Ј–Њ–≤–∞–љ–∞ –њ–Њ–і–і–µ—А–ґ–Ї–∞ DirectX 11

–Р —Б–µ–є—З–∞—Б –і–∞–≤–∞–є—В–µ —А–∞—Б—Б–Љ–Њ—В—А–Є–Љ –њ–Њ–і—А–Њ–±–љ—Л–µ —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є –љ–µ–і–∞–≤–љ–Њ –∞–љ–Њ–љ—Б–Є—А–Њ–≤–∞–љ–љ–Њ–є –≤–Є–і–µ–Њ–њ–ї–∞—В—Л Geforce GTX Titan, –Њ—Б–љ–Њ–≤–∞–љ–љ–Њ–є –љ–∞ —В–Њ–њ–Њ–≤–Њ–Љ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–Љ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–µ GK110.

–У—А–∞—Д–Є—З–µ—Б–Ї–Є–є —Г—Б–Ї–Њ—А–Є—В–µ–ї—М Geforce GTX Titan

- –Ъ–Њ–і–Њ–≤–Њ–µ –Є–Љ—П —З–Є–њ–∞ GK110;

- –Ґ–µ—Е–љ–Њ–ї–Њ–≥–Є—П –њ—А–Њ–Є–Ј–≤–Њ–і—Б—В–≤–∞ 28 –љ–Љ;

- 7,1 –Љ–Є–ї–ї–Є–∞—А–і–Њ–≤ —В—А–∞–љ–Ј–Є—Б—В–Њ—А–Њ–≤;

- –£–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ–љ–∞—П –∞—А—Е–Є—В–µ–Ї—В—Г—А–∞ —Б –Љ–∞—Б—Б–Є–≤–Њ–Љ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ –і–ї—П –њ–Њ—В–Њ–Ї–Њ–≤–Њ–є –Њ–±—А–∞–±–Њ—В–Ї–Є —А–∞–Ј–ї–Є—З–љ—Л—Е –≤–Є–і–Њ–≤ –і–∞–љ–љ—Л—Е: –≤–µ—А—И–Є–љ, –њ–Є–Ї—Б–µ–ї–µ–є –Є –і—А.;

- –Р–њ–њ–∞—А–∞—В–љ–∞—П –њ–Њ–і–і–µ—А–ґ–Ї–∞ DirectX 11 API, –≤ —В–Њ–Љ —З–Є—Б–ї–µ —И–µ–є–і–µ—А–љ–Њ–є –Љ–Њ–і–µ–ї–Є Shader Model 5.0, –≥–µ–Њ–Љ–µ—В—А–Є—З–µ—Б–Ї–Є—Е –Є –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л—Е —И–µ–є–і–µ—А–Њ–≤, –∞ —В–∞–Ї–ґ–µ —В–µ—Б—Б–µ–ї—П—Ж–Є–Є;

- 384-–±–Є—В–љ–∞—П —И–Є–љ–∞ –њ–∞–Љ—П—В–Є, —И–µ—Б—В—М –љ–µ–Ј–∞–≤–Є—Б–Є–Љ—Л—Е –Ї–Њ–љ—В—А–Њ–ї–ї–µ—А–Њ–≤ —И–Є—А–Є–љ–Њ–є –њ–Њ 64 –±–Є—В–∞ –Ї–∞–ґ–і—Л–є, —Б –њ–Њ–і–і–µ—А–ґ–Ї–Њ–є GDDR5-–њ–∞–Љ—П—В–Є;

- –І–∞—Б—В–Њ—В–∞ —П–і—А–∞ 836 (—В—Г—А–±–Њ—З–∞—Б—В–Њ—В–∞ вАФ 876) –Ь–У—Ж;

- 15 –њ–Њ—В–Њ–Ї–Њ–≤—Л—Е –Љ—Г–ї—М—В–Є–њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤, –≤–Ї–ї—О—З–∞—О—Й–Є—Е 2880 —Б–Ї–∞–ї—П—А–љ—Л—Е ALU –і–ї—П —А–∞—Б—З–µ—В–Њ–≤ —Б –њ–ї–∞–≤–∞—О—Й–µ–є –Ј–∞–њ—П—В–Њ–є –Њ–і–Є–љ–∞—А–љ–Њ–є —В–Њ—З–љ–Њ—Б—В–Є (FP32) –Є 960 —Б–Ї–∞–ї—П—А–љ—Л—Е ALU –і–ї—П —А–∞—Б—З–µ—В–Њ–≤ –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В–Є (FP64) –≤ —А–∞–Љ–Ї–∞—Е —Б—В–∞–љ–і–∞—А—В–∞ IEEE 754-2008;

- 240 –±–ї–Њ–Ї–Њ–≤ —В–µ–Ї—Б—В—Г—А–љ–Њ–є –∞–і—А–µ—Б–∞—Ж–Є–Є –Є —Д–Є–ї—М—В—А–∞—Ж–Є–Є —Б –њ–Њ–і–і–µ—А–ґ–Ї–Њ–є FP16- –Є FP32-–Ї–Њ–Љ–њ–Њ–љ–µ–љ—В –≤ —В–µ–Ї—Б—В—Г—А–∞—Е –Є –њ–Њ–і–і–µ—А–ґ–Ї–Њ–є —В—А–Є–ї–Є–љ–µ–є–љ–Њ–є –Є –∞–љ–Є–Ј–Њ—В—А–Њ–њ–љ–Њ–є —Д–Є–ї—М—В—А–∞—Ж–Є–Є –і–ї—П –≤—Б–µ—Е —В–µ–Ї—Б—В—Г—А–љ—Л—Е —Д–Њ—А–Љ–∞—В–Њ–≤;

- 6 —И–Є—А–Њ–Ї–Є—Е –±–ї–Њ–Ї–Њ–≤ ROP (48 –њ–Є–Ї—Б–µ–ї–µ–є) —Б –њ–Њ–і–і–µ—А–ґ–Ї–Њ–є —А–µ–ґ–Є–Љ–Њ–≤ —Б–≥–ї–∞–ґ–Є–≤–∞–љ–Є—П –і–Њ 32 –≤—Л–±–Њ—А–Њ–Ї –љ–∞ –њ–Є–Ї—Б–µ–ї—М, –≤ —В–Њ–Љ —З–Є—Б–ї–µ –њ—А–Є FP16- –Є–ї–Є FP32-—Д–Њ—А–Љ–∞—В–µ –±—Г—Д–µ—А–∞ –Ї–∞–і—А–∞. –Ъ–∞–ґ–і—Л–є –±–ї–Њ–Ї —Б–Њ—Б—В–Њ–Є—В –Є–Ј –Љ–∞—Б—Б–Є–≤–∞ –Ї–Њ–љ—Д–Є–≥—Г—А–Є—А—Г–µ–Љ—Л—Е ALU –Є –Њ—В–≤–µ—З–∞–µ—В –Ј–∞ –≥–µ–љ–µ—А–∞—Ж–Є—О –Є —Б—А–∞–≤–љ–µ–љ–Є–µ Z, MSAA, –±–ї–µ–љ–і–Є–љ–≥;

- –Ш–љ—В–µ–≥—А–Є—А–Њ–≤–∞–љ–љ–∞—П –њ–Њ–і–і–µ—А–ґ–Ї–∞ RAMDAC, –і–≤—Г—Е –њ–Њ—А—В–Њ–≤ Dual Link DVI, –∞ —В–∞–Ї–ґ–µ HDMI –Є DisplayPort;

- –Ш–љ—В–µ–≥—А–Є—А–Њ–≤–∞–љ–љ–∞—П –њ–Њ–і–і–µ—А–ґ–Ї–∞ 4 –Љ–Њ–љ–Є—В–Њ—А–Њ–≤, –≤–Ї–ї—О—З–∞—П –і–≤–∞ –њ–Њ—А—В–∞ Dual Link DVI, –∞ —В–∞–Ї–ґ–µ HDMI 1.4a –Є DisplayPort 1.2;

- –Я–Њ–і–і–µ—А–ґ–Ї–∞ —И–Є–љ—Л PCI Express 3.0.

–°–њ–µ—Ж–Є—Д–Є–Ї–∞—Ж–Є–Є —А–µ—Д–µ—А–µ–љ—Б–љ–Њ–є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л Geforce GTX Titan

- –І–∞—Б—В–Њ—В–∞ —П–і—А–∞ 836 (876) –Ь–У—Ж;

- –Ъ–Њ–ї–Є—З–µ—Б—В–≤–Њ —Г–љ–Є–≤–µ—А—Б–∞–ї—М–љ—Л—Е –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ 2688;

- –Ъ–Њ–ї–Є—З–µ—Б—В–≤–Њ —В–µ–Ї—Б—В—Г—А–љ—Л—Е –±–ї–Њ–Ї–Њ–≤ вАФ 224, –±–ї–Њ–Ї–Њ–≤ –±–ї–µ–љ–і–Є–љ–≥–∞ вАФ 48;

- –≠—Д—Д–µ–Ї—В–Є–≤–љ–∞—П —З–∞—Б—В–Њ—В–∞ –њ–∞–Љ—П—В–Є 6000 (1500×4) –Ь–У—Ж;

- –Ґ–Є–њ –њ–∞–Љ—П—В–Є GDDR5, 384-–±–Є—В–љ–∞—П —И–Є–љ–∞ –њ–∞–Љ—П—В–Є;

- –Ю–±—К–µ–Љ –њ–∞–Љ—П—В–Є 6 –У–С;

- –Я—А–Њ–њ—Г—Б–Ї–љ–∞—П —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –њ–∞–Љ—П—В–Є 288,4 –У–С/—Б;

- –Т—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ–∞—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М (FP32/FP64) 4,5/1,3 —В–µ—А–∞—Д–ї–Њ–њ—Б;

- –Ґ–µ–Њ—А–µ—В–Є—З–µ—Б–Ї–∞—П –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–∞—П —Б–Ї–Њ—А–Њ—Б—В—М –Ј–∞–Ї—А–∞—Б–Ї–Є 40,1 –≥–Є–≥–∞–њ–Є–Ї—Б–µ–ї–µ–є –≤ —Б–µ–Ї—Г–љ–і—Г;

- –Ґ–µ–Њ—А–µ—В–Є—З–µ—Б–Ї–∞—П —Б–Ї–Њ—А–Њ—Б—В—М –≤—Л–±–Њ—А–Ї–Є —В–µ–Ї—Б—В—Г—А 187,3 –≥–Є–≥–∞—В–µ–Ї—Б–µ–ї–µ–є –≤ —Б–µ–Ї—Г–љ–і—Г;

- –Ф–≤–∞ —А–∞–Ј—К–µ–Љ–∞ Dual Link DVI-I, –Њ–і–Є–љ mini HDMI, –Њ–і–Є–љ DisplayPort 1.2;

- –®–Є–љ–∞ PCI Express 3.0;

- –≠–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ –і–Њ 250 –Т—В;

- –Ю–і–Є–љ 8-–Ї–Њ–љ—В–∞–Ї—В–љ—Л–є –Є –Њ–і–Є–љ 6-–Ї–Њ–љ—В–∞–Ї—В–љ—Л–є —А–∞–Ј—К–µ–Љ—Л –њ–Є—В–∞–љ–Є—П;

- –Ф–≤—Г—Е—Б–ї–Њ—В–Њ–≤–Њ–µ –Є—Б–њ–Њ–ї–љ–µ–љ–Є–µ;

- –†–µ–Ї–Њ–Љ–µ–љ–і—Г–µ–Љ–∞—П —Ж–µ–љ–∞ –і–ї—П —А—Л–љ–Ї–∞ –°–®–Р вАФ $999 (–і–ї—П –†–Њ—Б—Б–Є–Є вАФ 34990 —А—Г–±).

Nvidia –Њ—В–Њ—И–ї–∞ –Њ—В —Б–≤–Њ–µ–≥–Њ –њ—А–Є–љ—Ж–Є–њ–∞ –љ–∞–Є–Љ–µ–љ–Њ–≤–∞–љ–Є—П –≤–Є–і–µ–Њ–Ї–∞—А—В –і–ї—П Titan, –љ–Њ –≤ –њ–Њ–і–Њ–±–љ–Њ–є —Н–Ї—Б–Ї–ї—О–Ј–Є–≤–љ–Њ–є –Љ–Њ–і–µ–ї–Є –≤–њ–Њ–ї–љ–µ –Љ–Њ–ґ–љ–Њ –њ–Њ–є—В–Є –љ–∞ —В–∞–Ї–Њ–є —И–∞–≥. –Х–і–Є–љ—Б—В–≤–µ–љ–љ–∞—П –Є—Б–Ї–ї—О—З–Є—В–µ–ї—М–љ–∞—П –Љ–Њ–і–µ–ї—М –њ–Њ–ї—Г—З–Є–ї–∞ —Б–ї–Њ–≤–Њ, –∞ –љ–µ —Ж–Є—Д—А—Л –≤ –Ї–Њ–љ—Ж–µ –љ–∞–Ј–≤–∞–љ–Є—П, —З—В–Њ –Њ—В–ї–Є—З–∞–µ—В –љ–Њ–≤–Є–љ–Ї—Г –Њ—В –≤—Б–µ—Е –≤–Є–і–µ–Њ–Ї–∞—А—В –ї–Є–љ–µ–є–Ї–Є Geforce GTX 600. –£—Б–Ї–Њ—А–Є—В–µ–ї—М –≤—Л—З–Є—Б–ї–µ–љ–Є–є Nvidia Tesla K20X —В–∞–Ї–ґ–µ –Њ—Б–љ–Њ–≤–∞–љ –љ–∞ –љ–∞–Є–±–Њ–ї–µ–µ –Љ–Њ—Й–љ–Њ–Љ —З–Є–њ–µ —Б–µ–Љ–µ–є—Б—В–≤–∞ Kepler, —Б–Њ–і–µ—А–ґ–∞—Й–µ–Љ 2688 –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л—Е CUDA-—П–і–µ—А, –Є –≤–Њ–Њ–±—Й–µ вАФ —Н—В–Њ –њ–Њ—З—В–Є —З—В–Њ –±–ї–Є–Ј–љ–µ—Ж –≤—Л—И–µ–і—И–µ–є –Є–≥—А–Њ–≤–Њ–є –Ї–∞—А—В—Л –љ–∞ —Н—В–Њ–Љ –ґ–µ GPU, –Ї–Њ—В–Њ—А—Л–є –њ—А–Є–Љ–µ–љ—П–µ—В—Б—П –≤ –±—Л—Б—В—А–µ–є—И–µ–Љ —Б—Г–њ–µ—А–Ї–Њ–Љ–њ—М—О—В–µ—А–µ –Љ–Є—А–∞ –њ–Њ–і –љ–∞–Ј–≤–∞–љ–Є–µ–Љ Titan. –Я–Њ—Н—В–Њ–Љ—Г –љ–µ—Г–і–Є–≤–Є—В–µ–ї—М–љ–Њ, —З—В–Њ Nvidia —А–µ—И–Є–ї–∞ –љ–∞–Ј–≤–∞—В—М —Б–≤–Њ—О –Є–≥—А–Њ–≤—Г—О –Ї–∞—А—В—Г Geforce GTX Titan, —З—В–Њ–±—Л —А—Л–љ–Њ–Ї –∞—Б—Б–Њ—Ж–Є–Є—А–Њ–≤–∞–ї –Є—Е –Є–≥—А–Њ–≤—Л–µ —А–µ—И–µ–љ–Є—П —Б —Г—Б–њ–µ—И–љ—Л–Љ–Є —Б—Г–њ–µ—А–Ї–Њ–Љ–њ—М—О—В–µ—А–љ—Л–Љ–Є.

–Э–∞ —А—Л–љ–Ї–µ Geforce GTX Titan –љ–µ –Ј–∞–Љ–µ–љ—П–µ—В –љ–Є–Ї–∞–Ї—Г—О –Љ–Њ–і–µ–ї—М –≤–Є–і–µ–Њ–Ї–∞—А—В—Л –≤ –ї–Є–љ–µ–є–Ї–µ –Ї–Њ–Љ–њ–∞–љ–Є–Є Nvidia, –∞ –±—Г–і–µ—В —Б–Њ—Б—Г—Й–µ—Б—В–≤–Њ–≤–∞—В—М —Б –і–≤—Г—Е—З–Є–њ–Њ–≤–Њ–є Geforce GTX 690 –≤ —Б–∞–Љ—Л—Е –≤–µ—А—Е–љ–Є—Е –µ–µ —Б—В—А–Њ—З–Ї–∞—Е. –Ь–Њ–і–µ–ї—М GTX 690 –±—Г–і–µ—В –њ—А–Њ–і–Њ–ї–ґ–∞—В—М –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В—М—Б—П –Є –њ—А–Њ–і–∞–≤–∞—В—М—Б—П, —В–∞–Ї –Ї–∞–Ї —Н—В–Є –і–≤–µ –≤–Є–і–µ–Њ–Ї–∞—А—В—Л –і—А—Г–≥ –і—А—Г–≥—Г –љ–Є—З—Г—В—М –љ–µ –Љ–µ—И–∞—О—В вАФ –Њ–љ–Є –Њ—З–µ–љ—М —А–∞–Ј–љ—Л–µ. Geforce GTX 690 –ї—Г—З—И–µ –њ–Њ–і—Е–Њ–і–Є—В –і–ї—П –Њ–і–љ–Є—Е —Ж–µ–ї–µ–є, –Ї–Њ–≥–і–∞ –≤–∞–ґ–µ–љ –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Л–є FPS, –љ–µ—Б–Љ–Њ—В—А—П –љ–∞ –Њ–±—К–µ–Ї—В–Є–≤–љ—Л–µ –љ–µ–і–Њ—Б—В–∞—В–Ї–Є –Љ—Г–ї—М—В–Є—З–Є–њ–Њ–≤–Њ–≥–Њ AFR-—А–µ–љ–і–µ—А–Є–љ–≥–∞, –∞ Titan –ї—Г—З—И–µ –њ–Њ–і–Њ–є–і–µ—В –≤ –Ї–∞—З–µ—Б—В–≤–µ —Г–љ–Є–≤–µ—А—Б–∞–ї—М–љ–Њ–≥–Њ —А–µ—И–µ–љ–Є—П —Б –±–Њ–ї—М—И–Є–Љ –Њ–±—К–µ–Љ–Њ–Љ –ї–Њ–Ї–∞–ї—М–љ–Њ–є –њ–∞–Љ—П—В–Є –Є –±—Л—Б—В—А—Л–Љ –Ї –љ–µ–є –і–Њ—Б—В—Г–њ–Њ–Љ, —З—В–Њ —Б–Ї–∞–ґ–µ—В—Б—П –≤ —Б–≤–µ—А—Е–≤—Л—Б–Њ–Ї–Є—Е —А–∞–Ј—А–µ—И–µ–љ–Є—П—Е. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, Titan –Ї–Њ–Љ–њ–∞–Ї—В–љ–µ–µ –Є —В—А–µ–±—Г–µ—В –Љ–µ–љ—М—И–µ —Н–љ–µ—А–≥–Є–Є, –њ–Њ—Н—В–Њ–Љ—Г –њ–Њ–і–Њ–є–і–µ—В –і–ї—П –±–Њ–ї—М—И–µ–≥–Њ –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ —Б–Є—Б—В–µ–Љ, –∞ –µ—Й–µ –Њ–љ —В–Є—И–µ –Є –њ—А–µ–і–ї–∞–≥–∞–µ—В –і–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ—Л–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –≤—А–Њ–і–µ GPU Boost 2.0 –Є –њ–Њ–ї–љ–Њ—Б–Ї–Њ—А–Њ—Б—В–љ—Л—Е –≤—Л—З–Є—Б–ї–µ–љ–Є–є —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О.

–І—В–Њ –Ї–∞—Б–∞–µ—В—Б—П —А–µ—И–µ–љ–Є–є –Ї–Њ–љ–Ї—Г—А–µ–љ—В–∞ вАФ –Ї–Њ–Љ–њ–∞–љ–Є–Є AMD вАФ —В–Њ –≤–њ–Њ–ї–љ–µ –њ–Њ–љ—П—В–љ–Њ, —З—В–Њ –љ–Њ–≤–∞—П Geforce GTX Titan –Њ—Б—В–∞–ї–∞—Б—М –±–µ–Ј –њ—А—П–Љ–Њ–≥–Њ —Б–Њ–њ–µ—А–љ–Є–Ї–∞. –£ AMD –њ—А–Њ—Б—В–Њ –љ–µ—В —З–Є–њ–Њ–≤ —В–∞–Ї–Њ–є —Б–ї–Њ–ґ–љ–Њ—Б—В–Є, –і–∞ –і–∞–ґ–µ –Є –Њ—Д–Є—Ж–Є–∞–ї—М–љ–Њ–є –і–≤—Г—Е—З–Є–њ–Њ–≤–Њ–є –њ–ї–∞—В—Л –љ–∞ –Љ–µ–љ–µ–µ —Б–ї–Њ–ґ–љ—Л—Е –њ–Њ–Ї–∞ —З—В–Њ –љ–µ —Б—Г—Й–µ—Б—В–≤—Г–µ—В, —Е–Њ—В—П –њ–∞—А—В–љ–µ—А—Л –Ї–Њ–Љ–њ–∞–љ–Є–Є –Є –њ—А–µ–і–ї–∞–≥–∞—О—В –њ–Њ–і–Њ–±–љ—Л–µ –Љ–Њ–і–µ–ї–Є, –≤ —В. —З. —Б–Њ–≤—Б–µ–Љ —Г–ґ —Н–Ї—Б—В—А–µ–Љ–∞–ї—М–љ—Л–µ –≤–∞—А–Є–∞–љ—В—Л, –≤—А–Њ–і–µ Asus Ares II —Б —В—А–µ–Љ—П 8-–Ї–Њ–љ—В–∞–Ї—В–љ—Л–Љ–Є (!!!) —А–∞–Ј—К–µ–Љ–∞–Љ–Є –њ–Є—В–∞–љ–Є—П. –Я—А—П–Љ–Њ–≥–Њ —Б–Њ–њ–µ—А–љ–Є–Ї–∞ –і–ї—П Titan –≤ –ї–Є–љ–µ–є–Ї–µ Radeon HD 7000 –Љ–Њ–ґ–љ–Њ –Є –љ–µ –ґ–і–∞—В—М, —Е–Њ—В—П –Њ—Д–Є—Ж–Є–∞–ї—М–љ–∞—П –і–≤—Г—Е—З–Є–њ–Њ–≤–∞—П –Љ–Њ–і–µ–ї—М –≤—А–Њ–і–µ Radeon HD 7990 –≤—Б–µ –ґ–µ –Њ–ґ–Є–і–∞–µ—В—Б—П.

–Т –Њ—В–ї–Є—З–Є–µ –Њ—В –њ—А–µ–і—Л–і—Г—Й–Є—Е –±—Л—Б—В—А–µ–є—И–Є—Е –≤–Є–і–µ–Њ–Ї–∞—А—В –љ–∞ –±–∞–Ј–µ –Њ–і–љ–Њ–≥–Њ GPU –Ї–Њ–Љ–њ–∞–љ–Є–Є Nvidia –њ–Њ—Б–ї–µ–і–љ–µ–≥–Њ –њ–Њ–Ї–Њ–ї–µ–љ–Є—П, Titan —Б–і–µ–ї–∞–љ –љ–∞ –±–∞–Ј–µ —З–Є–њ–∞ GK110 –Є –Є–Љ–µ–µ—В 384-–±–Є—В–љ—Г—О —И–Є–љ—Г –њ–∞–Љ—П—В–Є. –Я–Њ—Н—В–Њ–Љ—Г –Њ–±—К–µ–Љ —Г—Б—В–∞–љ–Њ–≤–ї–µ–љ–љ–Њ–є –љ–∞ –љ–µ–µ –≤–Є–і–µ–Њ–њ–∞–Љ—П—В–Є —В–µ–Њ—А–µ—В–Є—З–µ—Б–Ї–Є –Љ–Њ–≥ –±—Л—В—М —А–∞–≤–µ–љ 3 –Є–ї–Є 6 –У–С. –Т —Б–ї—Г—З–∞–µ —Б—В–Њ–ї—М –і–Њ—А–Њ–≥–Њ–є –Є —Н–ї–Є—В–љ–Њ–є –Љ–Њ–і–µ–ї–Є —Г—Б—В–∞–љ–Њ–≤–Ї–∞ 6 –У–С –њ–∞–Љ—П—В–Є —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ –Њ–њ—А–∞–≤–і–∞–љ–∞, —Е–Њ—В—П –Є–Ј –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є—Е —Б–Њ–Њ–±—А–∞–ґ–µ–љ–Є–є –±—Л–ї–Њ –±—Л –≤–њ–Њ–ї–љ–µ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –Є 3 –У–С. –Э–Њ –≤–µ–і—М —Н—В–Њ —А–Њ–≤–љ–Њ –Ї–∞–Ї —Г –ї—Г—З—И–Є—Е –Љ–Њ–і–µ–ї–µ–є –Ї–Њ–љ–Ї—Г—А–µ–љ—В–∞, —Б—В–∞–≤–Є—В—М —Б –Ї–Њ—В–Њ—А—Л–Љ–Є Titan –љ–∞ –Њ–і–љ—Г –њ–Њ–ї–Ї—Г Nvidia —П–≤–љ–Њ –љ–µ —Е–Њ—З–µ—В. –Э—Г –Є –і–ї—П —Б–µ—А—М–µ–Ј–љ—Л—Е –≤—Л—З–Є—Б–ї–µ–љ–Є–є –Њ–±—К–µ–Љ –≤ 6 –У–С –Љ–Њ–ґ–µ—В –±—Л—В—М –≤–њ–Њ–ї–љ–µ –∞–Ї—В—Г–∞–ї—М–љ—Л–Љ. –Ґ–∞–Ї —З—В–Њ –і–∞–ґ–µ –≤ —Г—Б–ї–Њ–≤–Є—П—Е —Б–∞–Љ—Л—Е —В—А–µ–±–Њ–≤–∞—В–µ–ї—М–љ—Л—Е –њ—А–Є–ї–Њ–ґ–µ–љ–Є–є –Є –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Л—Е –љ–∞—Б—В—А–Њ–µ–Ї –Ї–∞—З–µ—Б—В–≤–∞ —Б –њ–Њ–ї–љ–Њ—Н–Ї—А–∞–љ–љ—Л–Љ —Б–≥–ї–∞–ґ–Є–≤–∞–љ–Є–µ–Љ –ї—О–±–Њ–≥–Њ —Г—А–Њ–≤–љ—П –≤–Є–і–µ–Њ–њ–∞–Љ—П—В–Є —Г Titan –≤—Б–µ–≥–і–∞ —Е–≤–∞—В–Є—В.

–Ъ–Њ–љ—Б—В—А—Г–Ї—Ж–Є—П –њ–ї–∞—В—Л –Є —Б–Є—Б—В–µ–Љ—Л –Њ—Е–ї–∞–ґ–і–µ–љ–Є—П

–Ф–ї–Є–љ–∞ –њ–ї–∞—В—Л Geforce GTX Titan вАФ 10,5 –і—О–є–Љ–Њ–≤ (267 –Љ–Љ), –і–ї—П –њ–Є—В–∞–љ–Є—П –Њ–љ–∞ –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В –Њ–і–Є–љ 8-–Ї–Њ–љ—В–∞–Ї—В–љ—Л–є –Є –Њ–і–Є–љ 6-–Ї–Њ–љ—В–∞–Ї—В–љ—Л–є —А–∞–Ј—К–µ–Љ—Л –Њ—В –±–ї–Њ–Ї–∞ –њ–Є—В–∞–љ–Є—П. –Ф–ї—П –≤—Л–≤–Њ–і–∞ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є—П –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П —Б—В–∞–љ–і–∞—А—В–љ—Л–є –љ–∞–±–Њ—А –Є–Ј –і–≤—Г—Е —А–∞–Ј—К–µ–Љ–Њ–≤ Dual-Link DVI, –Њ–і–љ–Њ–≥–Њ HDMI –Є –Њ–і–љ–Њ–≥–Њ —А–∞–Ј—К–µ–Љ–∞ DisplayPort.

–Ф–Є–Ј–∞–є–љ –Ї–Њ—А–њ—Г—Б–∞ Geforce GTX Titan —Б—Е–Њ–ґ —Б –і–Є–Ј–∞–є–љ–Њ–Љ –і—А—Г–≥–Њ–є —В–Њ–њ–Њ–≤–Њ–є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л Nvidia вАФ Geforce GTX 690. –Т—Л–≥–ї—П–і–Є—В –њ–ї–∞—В–∞ –≤ —Ж–µ–ї–Њ–Љ –Њ—З–µ–љ—М —Б–Њ–ї–Є–і–љ–Њ, –Є –Ї–∞—З–µ—Б—В–≤–Њ —Б–±–Њ—А–Ї–Є –Є –Љ–∞—В–µ—А–Є–∞–ї–Њ–≤ –љ–∞ —Г—А–Њ–≤–љ–µ. –Я–Њ–љ—П—В–љ–Њ, —З—В–Њ –і–ї—П –њ—А–µ–Љ–Є—Г–Љ-—Б–µ–≥–Љ–µ–љ—В–∞ –њ—А–Є–љ—П—В–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–Є–µ –Љ–∞—В–µ—А–Є–∞–ї—Л, –Є –Є–љ–ґ–µ–љ–µ—А—Л Nvidia —А–µ—И–Є–ї–Є –љ–∞–Ї—А—Л—В—М –Ї–Њ–љ—Б—В—А—Г–Ї—Ж–Є—О ¬Ђ–Ґ–Є—В–∞–љ–∞¬ї –∞–ї—О–Љ–Є–љ–Є–µ–≤–Њ–є –Ї—А—Л—И–Ї–Њ–є. –Т —Ж–µ–љ—В—А–µ –Ї—А—Л—И–Ї–Є –µ—Б—В—М –њ—А–Њ–Ј—А–∞—З–љ–Њ–µ –њ–ї–∞—Б—В–Є–Ї–Њ–≤–Њ–µ –Њ–Ї–љ–Њ, –Њ—В–Ї—А—Л–≤–∞—О—Й–µ–µ –њ—Л—В–ї–Є–≤–Њ–Љ—Г –≤–Ј–Њ—А—Г —З—Г–і–µ—Б–љ—Л–є –≤–Є–і –љ–∞ –Є—Б–њ–∞—А–Є—В–µ–ї—М–љ—Г—О –Ї–∞–Љ–µ—А—Г –Є –і–≤—Г—Е—Б–ї–Њ—В–Њ–≤—Л–є –∞–ї—О–Љ–Є–љ–Є–µ–≤—Л–є —А–∞–і–Є–∞—В–Њ—А, —Г—З–∞—Б—В–≤—Г—О—Й–Є–є –≤ –Њ—Е–ї–∞–ґ–і–µ–љ–Є–Є —З–Є–њ–∞ GK110.

–Ы–Њ–≥–Њ—В–Є–њ Geforce GTX –љ–∞ –±–Њ–Ї–Њ–≤–Њ–Љ —В–Њ—А—Ж–µ –≤–Є–і–µ–Њ–Ї–∞—А—В—Л –Є–Љ–µ–µ—В —Б–≤–µ—В–Њ–і–Є–Њ–і–љ—Г—О –њ–Њ–і—Б–≤–µ—В–Ї—Г. –Ю–љ–∞ —Б–ї—Г–ґ–Є—В —В–∞–Ї–ґ–µ –Є–љ–і–Є–Ї–∞—В–Њ—А–Њ–Љ –≤–Ї–ї—О—З–µ–љ–Є—П, –∞ –Є–љ—В–µ–љ—Б–Є–≤–љ–Њ—Б—В—М –њ–Њ–і—Б–≤–µ—В–Ї–Є —Б–≤–µ—В–Њ–і–Є–Њ–і–∞–Љ–Є –Љ–Њ–ґ–љ–Њ –Њ—В—А–µ–≥—Г–ї–Є—А–Њ–≤–∞—В—М –≤—А—Г—З–љ—Г—О, –Є—Б–њ–Њ–ї—М–Ј—Г—П —Б–њ–µ—Ж–Є–∞–ї—М–љ–Њ–µ –Я–Ю –Њ—В –њ–∞—А—В–љ–µ—А–Њ–≤ Nvidia. –Ь–Њ–ґ–љ–Њ –і–∞–ґ–µ –љ–∞—Б—В—А–Њ–Є—В—М —Б–≤–µ—В–Њ–і–Є–Њ–і—Л —В–∞–Ї, —З—В–Њ–±—Л –Є–љ—В–µ–љ—Б–Є–≤–љ–Њ—Б—В—М –Є—Е —Б–≤–µ—З–µ–љ–Є—П –Є–Ј–Љ–µ–љ—П–ї–∞—Б—М –≤ –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В–Є –Њ—В –љ–∞–≥—А—Г–Ј–Ї–Є –љ–∞ GPU.

–Ґ–∞–Ї –Ї–∞–Ї Geforce GTX Titan —Б–њ—А–Њ–µ–Ї—В–Є—А–Њ–≤–∞–љ –Є –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ –і–ї—П —Н–љ—В—Г–Ј–Є–∞—Б—В–Њ–≤ –Є –ї—О–±–Є—В–µ–ї–µ–є –≤—Л–ґ–∞—В—М –Є–Ј —Б–Є—Б—В–µ–Љ—Л –≤—Б–µ –і–Њ –њ–Њ—Б–ї–µ–і–љ–µ–≥–Њ, —Н—В–Њ –љ–µ –Љ–Њ–≥–ї–Њ –љ–µ —Б–Ї–∞–Ј–∞—В—М—Б—П –љ–∞ –љ–µ–Ї–Њ—В–Њ—А—Л—Е —В–µ—Е–љ–Є—З–µ—Б–Ї–Є—Е —А–µ—И–µ–љ–Є—П—Е, –њ—А–Є–Љ–µ–љ–µ–љ–љ—Л—Е –≤ –Ї–Њ–љ—Б—В—А—Г–Ї—Ж–Є–Є. –°–∞–Љ —З–Є–њ GK110 —Б–љ–∞–±–ґ–∞–µ—В —Н–љ–µ—А–≥–Є–µ–є 6-—Д–∞–Ј–љ–∞—П —Б—Е–µ–Љ–∞ –њ–Є—В–∞–љ–Є—П —Б –Ј–∞—Й–Є—В–Њ–є –Њ—В –њ–µ—А–µ–љ–∞–њ—А—П–ґ–µ–љ–Є—П, –∞ –і–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ–∞—П —Б—Е–µ–Љ–∞ —Б –і–≤—Г–Љ—П —Д–∞–Ј–∞–Љ–Є –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –і–ї—П –њ–Є—В–∞–љ–Є—П GDDR5 –≤–Є–і–µ–Њ–њ–∞–Љ—П—В–Є. 6+2-—Д–∞–Ј–љ–∞—П —Б—Е–µ–Љ–∞ –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –њ–ї–∞—В—Г –њ–Є—В–∞–љ–Є–µ–Љ –і–∞–ґ–µ —Б —Г—З–µ—В–Њ–Љ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ–≥–Њ —А–∞–Ј–≥–Њ–љ–∞, –њ—А–Њ—Ж–µ—Б—Б –Ї–Њ—В–Њ—А–Њ–≥–Њ —Б—В–∞–ї –µ—Й–µ –ї–µ–≥—З–µ –±–ї–∞–≥–Њ–і–∞—А—П –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –њ–Њ–≤—Л—И–µ–љ–Є—П –љ–∞–њ—А—П–ґ–µ–љ–Є—П (—З–Є—В–∞–є—В–µ –Њ–± —Н—В–Њ–Љ –љ–Є–ґ–µ). –Ъ —Б–ї–Њ–≤—Г, —Б–∞–Љ–∞ Nvidia —Г–≤–µ—А—П–µ—В, —З—В–Њ –њ—А–Є —Б—В–∞–љ–і–∞—А—В–љ–Њ–Љ –Њ—Е–ї–∞–ґ–і–µ–љ–Є–Є –і–ї—П –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ –і–Њ—Б—В–Є–ґ–µ–љ–Є–µ —В–∞–Ї—В–Њ–≤–Њ–є —З–∞—Б—В–Њ—В—Л –≤—Л—И–µ 1 –У–У—Ж.

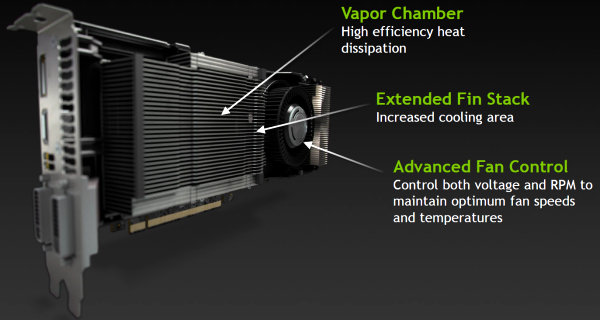

–Ф–ї—П —Б–≤–Њ–µ–є –љ–Њ–≤–Њ–є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л –≤—Л—Б—И–µ–≥–Њ –Ї–ї–∞—Б—Б–∞ –Є–љ–ґ–µ–љ–µ—А—Л Nvidia —А–∞–Ј—А–∞–±–Њ—В–∞–ї–Є –љ–Њ–≤—Г—О —Б–Є—Б—В–µ–Љ—Г –Њ—Е–ї–∞–ґ–і–µ–љ–Є—П, –Ї–Њ—В–Њ—А–∞—П –Њ—В–ї–Є—З–∞–µ—В—Б—П –≤—Л—Б–Њ–Ї–Њ–є —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В—М—О. –Т –Ї—Г–ї–µ—А–µ –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П –Є—Б–њ–∞—А–Є—В–µ–ї—М–љ–Њ–є –Ї–∞–Љ–µ—А—Л, –Ї–Њ—В–Њ—А–∞—П –Њ—В–ї–Є—З–љ–Њ —А–∞—Б—Б–µ–Є–≤–∞–µ—В —В–µ–њ–ї–Њ, –±—Л–ї–Є —Г–≤–µ–ї–Є—З–µ–љ—Л —А–µ–±—А–∞ —А–∞–і–Є–∞—В–Њ—А–∞, –∞ —В–∞–Ї–ґ–µ –≤ –Њ—З–µ—А–µ–і–љ–Њ–є —А–∞–Ј —Г–ї—Г—З—И–µ–љ–∞ —Б—Е–µ–Љ–∞ —Г–њ—А–∞–≤–ї–µ–љ–Є—П –≤–µ–љ—В–Є–ї—П—В–Њ—А–Њ–Љ, –Є–Ј–Љ–µ–љ—П—О—Й–∞—П —А–∞–±–Њ—З–µ–µ –љ–∞–њ—А—П–ґ–µ–љ–Є–µ –Є —З–∞—Б—В–Њ—В—Г –µ–≥–Њ –≤—А–∞—Й–µ–љ–Є—П –і–ї—П –і–Њ—Б—В–Є–ґ–µ–љ–Є—П –Њ–њ—В–Є–Љ–∞–ї—М–љ–Њ–≥–Њ —Б–Њ—З–µ—В–∞–љ–Є—П –∞–Ї—Г—Б—В–Є—З–µ—Б–Ї–Њ–≥–Њ –Є —В–µ–Љ–њ–µ—А–∞—В—Г—А–љ–Њ–≥–Њ —А–µ–ґ–Є–Љ–Њ–≤.

–Ь–µ–і–љ–∞—П –Є—Б–њ–∞—А–Є—В–µ–ї—М–љ–∞—П –Ї–∞–Љ–µ—А–∞ –≤ –Ї—Г–ї–µ—А–µ Geforce GTX Titan —А–∞–±–Њ—В–∞–µ—В –Ї–∞–Ї —В–µ–њ–ї–Њ–≤–∞—П —В—А—Г–±–Ї–∞, –љ–Њ –Њ–љ–∞ –±–Њ–ї–µ–µ –Љ–Њ—Й–љ–∞—П –Є —Н—Д—Д–µ–Ї—В–Є–≤–љ–∞—П. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, –і–ї—П —Г–ї—Г—З—И–µ–љ–Є—П —А–∞–±–Њ—В—Л –Ї–∞–Љ–µ—А—Л –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –љ–Њ–≤—Л–є –Љ–∞—В–µ—А–Є–∞–ї —В–µ—А–Љ–Њ–Є–љ—В–µ—А—Д–µ–є—Б–∞ –Њ—В –Ї–Њ–Љ–њ–∞–љ–Є–Є Shin-Etsu, –Ї–Њ—В–Њ—А—Л–є –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –і–≤—Г–Ї—А–∞—В–љ–Њ–µ –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–Њ –њ–µ—А–µ–і —В–µ–Љ, —З—В–Њ –њ—А–Є–Љ–µ–љ—П–ї—Б—П —А–∞–љ–µ–µ –≤ Geforce GTX 680. –Т —А–µ–Ј—Г–ї—М—В–∞—В–µ, –љ–Њ–≤–∞—П –Є—Б–њ–∞—А–Є—В–µ–ї—М–љ–∞—П –Ї–∞–Љ–µ—А–∞ –Є —В–µ—А–Љ–Њ–Є–љ—В–µ—А—Д–µ–є—Б –њ–Њ–Ј–≤–Њ–ї—П—О—В –Њ—В–≤–Њ–і–Є—В—М –±–Њ–ї—М—И–µ —В–µ–њ–ї–∞ –Њ—В GK110, –і–∞–≤–∞—П –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М —А–∞–±–Њ—В—Л –љ–∞ –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Њ–є —В–∞–Ї—В–Њ–≤–Њ–є —З–∞—Б—В–Њ—В–µ.

–Ґ–µ–њ–ї–Њ –Њ—В –Є—Б–њ–∞—А–Є—В–µ–ї—М–љ–Њ–є –Ї–∞–Љ–µ—А—Л –Њ—В–≤–Њ–і–Є—В—Б—П –њ—А–Є –њ–Њ–Љ–Њ—Й–Є –±–Њ–ї—М—И–Њ–≥–Њ –і–≤—Г—Е—Б–ї–Њ—В–Њ–≤–Њ–≥–Њ —А–∞–і–Є–∞—В–Њ—А–∞ –Є–Ј –∞–ї—О–Љ–Є–љ–Є–µ–≤–Њ–≥–Њ —Б–њ–ї–∞–≤–∞. –Я–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б –њ—А–µ–і—Л–і—Г—Й–Є–Љ–Є —А–µ—И–µ–љ–Є—П–Љ–Є –ї–Є–љ–µ–є–Ї–Є Geforce GTX 600, –≤ –Ї—Г–ї–µ—А–µ Titan –њ—А–Є–Љ–µ–љ—П—О—В—Б—П —Г–і–ї–Є–љ–µ–љ–љ—Л–µ —А–µ–±—А–∞ —А–∞–і–Є–∞—В–Њ—А–∞, —З—В–Њ —Г–≤–µ–ї–Є—З–Є–≤–∞–µ—В –њ–ї–Њ—Й–∞–і—М —А–∞—Б—Б–µ–Є–≤–∞–љ–Є—П –Є –њ–Њ–≤—Л—И–∞–µ—В –µ–≥–Њ —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В—М. –Э–∞ Geforce GTX Titan —В–∞–Ї–ґ–µ —Г—Б—В–∞–љ–Њ–≤–ї–µ–љ–∞ –∞–ї—О–Љ–Є–љ–Є–µ–≤–∞—П –њ–ї–∞—Б—В–Є–љ–∞ —Б –Њ–±—А–∞—В–љ–Њ–є —Б—В–Њ—А–Њ–љ—Л, –Ї–Њ—В–Њ—А–∞—П –і–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ–Њ –Њ—Е–ї–∞–ґ–і–∞–µ—В –њ–µ—З–∞—В–љ—Г—О –њ–ї–∞—В—Г –Є –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В—Л –љ–∞ –љ–µ–є. –Т –Ї–Њ–љ—Б—В—А—Г–Ї—Ж–Є–Є –≤–µ–љ—В–Є–ї—П—В–Њ—А–∞ –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П —В–µ –ґ–µ –і–µ–Љ–њ—Д–Є—А—Г—О—Й–Є–µ –Љ–∞—В–µ—А–Є–∞–ї—Л, —З—В–Њ –Є –≤ Geforce GTX 680 вАФ –Њ–љ–Є —Б–ї—Г–ґ–∞—В –і–ї—П —Б–љ–Є–ґ–µ–љ–Є—П —Г—А–Њ–≤–љ—П —И—Г–Љ–∞.

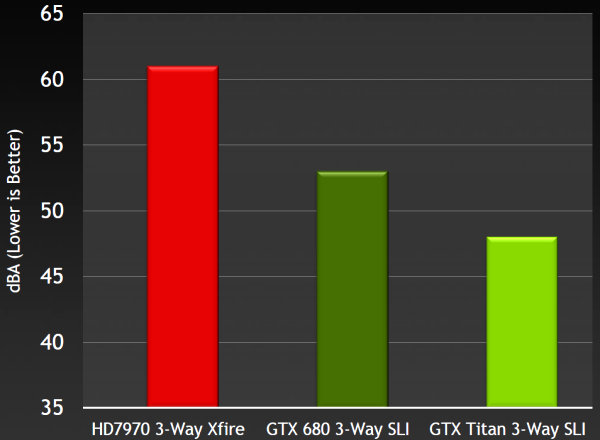

–Ъ —Б–ї–Њ–≤—Г, –Њ —И—Г–Љ–µ. Nvidia –њ—А–Є–≤–Њ–і–Є—В —Ж–Є—Д—А—Л —Б–Њ–±—Б—В–≤–µ–љ–љ—Л—Е –∞–Ї—Г—Б—В–Є—З–µ—Б–Ї–Є—Е –Ј–∞–Љ–µ—А–Њ–≤, –љ–Њ –љ–µ –і–ї—П –Њ–і–љ–Њ—З–Є–њ–Њ–≤—Л—Е –≤–Є–і–µ–Њ—Б–Є—Б—В–µ–Љ, –∞ –і–ї—П —Н–Ї—Б—В—А–µ–Љ–∞–ї—М–љ—Л—Е –Љ–љ–Њ–≥–Њ—З–Є–њ–Њ–≤—Л—Е вАФ —З—В–Њ–±—Л —А–∞–Ј–љ–Є—Ж–∞ –±—Л–ї–∞ –Њ—Й—Г—В–Є–Љ–µ–є. –Ґ–∞–Ї –≤–Њ—В, –њ—А–Є –Ј–∞–њ—Г—Б–Ї–µ –±–µ–љ—З–Љ–∞—А–Ї–∞ Unigine Heaven –≤ —А–∞–Ј—А–µ—И–µ–љ–Є–Є 1920×1080 —Б –њ–Њ–ї–љ–Њ—Н–Ї—А–∞–љ–љ—Л–Љ —Б–≥–ї–∞–ґ–Є–≤–∞–љ–Є–µ–Љ –Є —Н–Ї—Б—В—А–µ–Љ–∞–ї—М–љ—Л–Љ —Г—А–Њ–≤–љ–µ–Љ —В–µ—Б—Б–µ–ї—П—Ж–Є–Є —А–∞–Ј–ї–Є—З–љ—Л–µ —Б–Є—Б—В–µ–Љ—Л –љ–∞ –±–∞–Ј–µ —В—А–µ—Е –≤–Є–і–µ–Њ–Ї–∞—А—В –њ–Њ–Ї–∞–Ј–∞–ї–Є —Б–ї–µ–і—Г—О—Й–Є–є —Г—А–Њ–≤–µ–љ—М —И—Г–Љ–∞:

–Ъ–∞–Ї –≤–Є–і–Є—В–µ, –Ї—Г–ї–µ—А Geforce GTX Titan —Б–њ—А–∞–≤–ї—П–µ—В—Б—П —Б —А–∞–±–Њ—В–Њ–є –њ—А–Њ—Б—В–Њ –Њ—В–ї–Є—З–љ–Њ. –Ь–∞–ї–Њ —В–Њ–≥–Њ, —З—В–Њ —А–∞–±–Њ—В–∞ —В—А–µ—Е GK110 –і–Њ–ї–ґ–љ–∞ –Њ–±–µ—Б–њ–µ—З–Є–≤–∞—В—М –Ј–∞–Љ–µ—В–љ–Њ –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї—Г—О –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М (–Њ–± —Н—В–Њ —З–Є—В–∞–є—В–µ –і–∞–ї–µ–µ), —В–∞–Ї —Н—В–Є —В—А–Є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л GTX Titan –µ—Й–µ –Є —В–Є—И–µ —А–∞–±–Њ—В–∞—О—В, –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О –Ї–∞–Ї —Б —В—А–µ–Љ—П GTX 680, —В–∞–Ї –Є —Б —В—А–µ–Љ—П Radeon HD 7970. –Я—А–Є—З–µ–Љ, –µ—Б–ї–Є –Ј–∞–Љ–µ—А—Л –Ї–Њ—А—А–µ–Ї—В–љ—Л, —А–∞–Ј–љ–Є—Ж–∞ –≤ —И—Г–Љ–µ –Љ–µ–ґ–і—Г –ї—Г—З—И–Є–Љ–Є —А–µ—И–µ–љ–Є—П–Љ–Є AMD –Є Nvidia –і–Њ–ї–ґ–љ–∞ –±—Л—В—М –њ—А–Њ—Б—В–Њ –Ї–Њ–ї–Њ—Б—Б–∞–ї—М–љ–Њ–є!

–У—А–∞—Д–Є—З–µ—Б–Ї–∞—П –∞—А—Е–Є—В–µ–Ї—В—Г—А–∞

–Э–Њ–≤–∞—П –Љ–Њ–і–µ–ї—М Geforce GTX Titan –Њ—Б–љ–Њ–≤–∞–љ–∞ –љ–∞ –±–∞–Ј–µ —Б–∞–Љ–Њ–≥–Њ —Б–ї–Њ–ґ–љ–Њ–≥–Њ –≤–Є–і–µ–Њ—З–Є–њ–∞ Nvidia, –і–∞ –Є –≤–Њ–Њ–±—Й–µ –≤ –Љ–Є—А–µ. –Ш–љ—В–µ—А–µ—Б–љ–Њ, —З—В–Њ –њ–µ—А–≤–Њ–µ –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Њ–µ –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –њ—А–Њ—Ж–µ—Б—Б–Њ—А GK110 –≤–њ–µ—А–≤—Л–µ –њ–Њ–ї—Г—З–Є–ї –≤ —Б—Г–њ–µ—А–Ї–Њ–Љ–њ—М—О—В–µ—А–µ –Ю–Ї—А–Є–і–ґ—Б–Ї–Њ–є –љ–∞—Ж–Є–Њ–љ–∞–ї—М–љ–Њ–є –ї–∞–±–Њ—А–∞—В–Њ—А–Є–Є, –Ї–Њ—В–Њ—А—Л–є –њ–Њ–ї—Г—З–Є–ї –Є–Љ—П —Б–Њ–±—Б—В–≤–µ–љ–љ–Њ–µ вАФ Titan. –Х—Й–µ –≤ –љ–Њ—П–±—А–µ –њ—А–Њ—И–ї–Њ–≥–Њ –≥–Њ–і–∞ —Н—В–Њ—В —Б—Г–њ–µ—А–Ї–Њ–Љ–њ—М—О—В–µ—А –±—Л–ї –≤–Ї–ї—О—З–µ–љ –≤ ¬Ђ—Б—Г–њ–µ—А–Ї–Њ–Љ–њ—М—О—В–µ—А–љ—Л–є¬ї —Б–њ–Є—Б–Њ–Ї TOP500 –Ї–∞–Ї —Б–∞–Љ–Њ–µ –±—Л—Б—В—А–Њ–µ –њ–Њ–і–Њ–±–љ–Њ–µ —Г—Б—В—А–Њ–є—Б—В–≤–Њ. –Т—Б–µ–≥–Њ –≤ –Ї–Њ–љ—Б—В—А—Г–Ї—Ж–Є–Є Titan –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П 18668 –њ—А–Њ—Д–µ—Б—Б–Є–Њ–љ–∞–ї—М–љ—Л—Е –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л—Е —Б–Є—Б—В–µ–Љ Nvidia Tesla K20X, —З—В–Њ –њ–Њ–Ј–≤–Њ–ї–Є–ї–Њ —Б—Г–њ–µ—А–Ї–Њ–Љ–њ—М—О—В–µ—А—Г –њ–Њ–Ї–∞–Ј–∞—В—М —А–µ–Ї–Њ—А–і–љ—Л–є —А–µ–Ј—Г–ї—М—В–∞—В –≤ 17,59 –њ–µ—В–∞—Д–ї–Њ–њ—Б (—А–µ—З—М –Њ –≤—Л—З–Є—Б–ї–µ–љ–Є—П—Е –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В–Є) –≤ –Њ–±—Й–µ–њ—А–Є–Ј–љ–∞–љ–љ–Њ–Љ —В–µ—Б—В–µ Linpack.

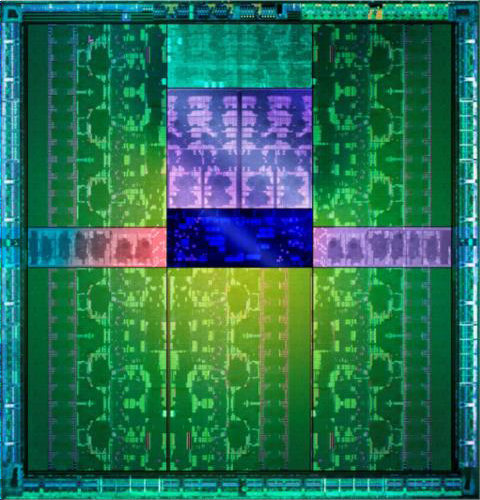

–Ґ–Њ–њ–Њ–≤—Л–є GPU –Ї–Њ–Љ–њ–∞–љ–Є–Є –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ—В –≤—Б–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є, –њ–Њ—П–≤–Є–≤—И–Є–µ—Б—П –≤ GK104 (Geforce GTX 680), –Є –≤—Б–µ –Њ—Б–Њ–±–µ–љ–љ–Њ—Б—В–Є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л Kepler –Њ—В–љ–Њ—Б—П—В—Б—П –Є –Ї –љ–µ–Љ—Г, –≤–Ї–ї—О—З–∞—П –Њ—А–≥–∞–љ–Є–Ј–∞—Ж–Є—О –Љ—Г–ї—М—В–Є–њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ SMX, —Е–Њ—В—П –µ—Б—В—М –Є —П–≤–љ—Л–µ –Њ—В–ї–Є—З–Є—П. –У—А–∞—Д–Є—З–µ—Б–Ї–Є–є –њ—А–Њ—Ж–µ—Б—Б–Њ—А GK110 –Є–Љ–µ–µ—В –≤ —Б–≤–Њ–µ–Љ —Б–Њ—Б—В–∞–≤–µ –њ—П—В—М (–љ–µ—З–µ—В–љ–Њ–µ —З–Є—Б–ї–Њ, —З—В–Њ –љ–µ–Њ–±—Л—З–љ–Њ) –Ї–ї–∞—Б—В–µ—А–Њ–≤ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–є –Њ–±—А–∞–±–Њ—В–Ї–Є Graphics Processing Cluster (GPC), —Б–Њ—Б—В–Њ—П—Й–Є—Е –Є–Ј —В—А–µ—Е (—Б–љ–Њ–≤–∞ –љ–µ—З–µ—В–љ–Њ–µ!) –Љ—Г–ї—М—В–Є–њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ SMX –Ї–∞–ґ–і—Л–є, —В–Њ –µ—Б—В—М —Б—Е–µ–Љ–∞ 5×3, –≤ –Њ—В–ї–Є—З–Є–µ –Њ—В —Б—Е–µ–Љ—Л 4×2 –і–ї—П GK104. –Т–Є–і–Є–Љ–Њ, –њ—А–Є —Б—Е–µ–Љ–µ 8×2 —З–Є–њ –њ–Њ–ї—Г—З–∞–ї—Б—П —Б–ї–Є—И–Ї–Њ–Љ —Б–ї–Њ–ґ–љ—Л–Љ. –Ф–ї—П –љ–∞–≥–ї—П–і–љ–Њ—Б—В–Є —А–∞—Б—Б–Љ–Њ—В—А–Є–Љ –і–Є–∞–≥—А–∞–Љ–Љ—Г —В–Њ–њ–Њ–≤–Њ–≥–Њ —З–Є–њ–∞:

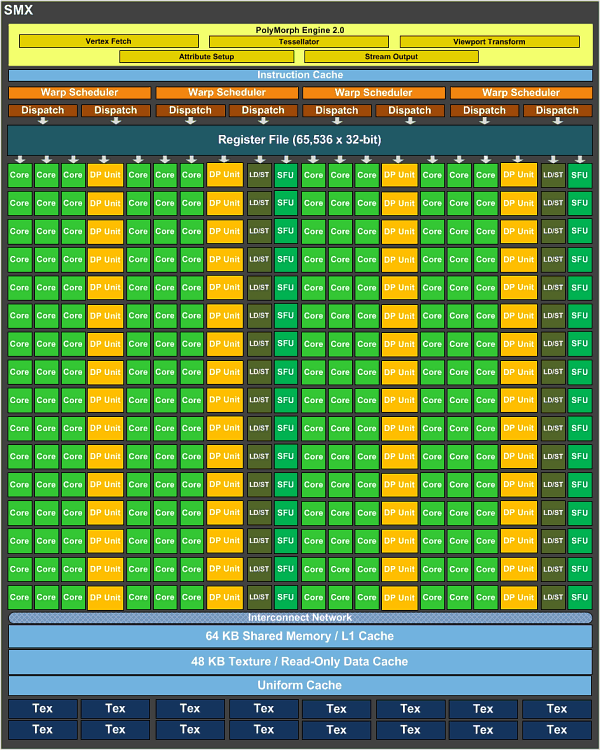

–Ъ—А–Њ–Љ–µ –љ–µ—З–µ—В–љ—Л—Е —З–Є—Б–µ–ї, –≤—А–Њ–і–µ –±—Л –≤—Б–µ –њ–Њ—З—В–Є –њ—А–Є–≤—Л—З–љ–Њ –і–ї—П Kepler вАФ –њ—А–Є–Љ–µ—А–љ–Њ —В–µ –ґ–µ –Љ—Г–ї—М—В–Є–њ—А–Њ—Ж–µ—Б—Б–Њ—А—Л SMX, –љ–Њ –µ—Б—В—М –Њ—В–ї–Є—З–Є—П. –Ъ–∞–Ї –Є GK104, GK110 —Б–Њ—Б—В–Њ–Є—В –Є–Ј –Љ—Г–ї—М—В–Є–њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ SMX, —Б–Њ–і–µ—А–ґ–∞—Й–Є—Е –њ–Њ 192 –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л—Е –±–ї–Њ–Ї–∞ (—Б–∞–Љ—Л–µ –Љ–∞–ї–µ–љ—М–Ї–Є–µ –Ј–µ–ї–µ–љ—Л–µ –Ї–≤–∞–і—А–∞—В–Є–Ї–Є), –љ–Њ —З—В–Њ —Н—В–Њ –Ј–∞ –Њ—А–∞–љ–ґ–µ–≤—Л–µ –±–ї–Њ–Ї–Є –≤ –Ї–Њ–ї–Є—З–µ—Б—В–≤–µ 64 —И—В—Г–Ї–Є –љ–∞ –Ї–∞–ґ–і—Л–є SMX? –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ Nvidia –≤—Л–і–µ–ї—П–µ—В ALU, —Б–њ–Њ—Б–Њ–±–љ—Л–µ –≤—Л—З–Є—Б–ї—П—В—М —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О (FP64), –≤ –Њ—В–ї–Є—З–Є–µ –Њ—В FP32-—В–Њ—З–љ–Њ—Б—В–Є ¬Ђ–Ј–µ–ї–µ–љ—Л—Е¬ї. –≠—В–Њ –Њ—Б–љ–Њ–≤–љ–Њ–µ –Њ—В–ї–Є—З–Є–µ —Г—Б—В—А–Њ–є—Б—В–≤–∞ SMX –≤ GK110 –Њ—В –≤—Б–µ—Е –і—А—Г–≥–Є—Е —З–Є–њ–Њ–≤.

–Т –Њ—Б—В–∞–ї—М–љ–Њ–Љ –≤—Б–µ —А–Њ–≤–љ–Њ —В–∞–Ї –ґ–µ, –Ї–∞–Ї –Є –≤ GK104, –Ї–∞–ґ–і—Л–є SMX –Є–Љ–µ–µ—В –њ–Њ –і–≤–Є–ґ–Ї—Г PolyMorph Engine, 64 –Ъ–С –Њ–±—Й–µ–є –њ–∞–Љ—П—В–Є, 48 –Ъ–С —В–µ–Ї—Б—В—Г—А–љ–Њ–є –Ї—Н—И-–њ–∞–Љ—П—В–Є –Є –њ–Њ 16 –±–ї–Њ–Ї–Њ–≤ —В–µ–Ї—Б—В—Г—А–љ–Њ–є —Д–Є–ї—М—В—А–∞—Ж–Є–Є (–≤—Б–µ–≥–Њ 240 TMU –≤ —З–Є–њ–µ —Д–Є–Ј–Є—З–µ—Б–Ї–Є). –Я–Њ–і—Б–Є—Б—В–µ–Љ–∞ –њ–∞–Љ—П—В–Є GK110, –ї–µ–ґ–∞—Й–µ–≥–Њ –≤ –Њ—Б–љ–Њ–≤–µ Geforce GTX Titan, —Б–Њ–і–µ—А–ґ–Є—В —И–µ—Б—В—М 64-–±–Є—В–љ—Л—Е –Ї–∞–љ–∞–ї–Њ–≤ –њ–∞–Љ—П—В–Є, —З—В–Њ –≤ —Б—Г–Љ–Љ–µ –і–∞–µ—В 384-–±–Є—В–љ—Л–є –і–Њ—Б—В—Г–њ –Ї –љ–µ–є. –Ш —В–∞–Ї –Ї–∞–Ї –±–ї–Њ–Ї–Є —А–∞—Б—В—А–Њ–≤—Л—Е –Њ–њ–µ—А–∞—Ж–Є–є ROP ¬Ђ–њ—А–Є–≤—П–Ј–∞–љ—Л¬ї –Ї –Ї–Њ–љ—В—А–Њ–ї–ї–µ—А–∞–Љ –њ–∞–Љ—П—В–Є, —В–Њ –Є—Е –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –≤ –і–∞–љ–љ–Њ–Љ GPU —А–∞–≤–љ–Њ 48 –±–ї–Њ–Ї–∞–Љ. –Ю–±—К–µ–Љ –Ї—Н—И-–њ–∞–Љ—П—В–Є –≤—В–Њ—А–Њ–≥–Њ —Г—А–Њ–≤–љ—П –љ–∞ –≤–µ—Б—М —З–Є–њ —Б–Њ—Б—В–∞–≤–ї—П–µ—В 1,5 –Ь–С.

–Ъ–∞–Ї –Љ—Л —Г–ґ–µ –њ–Є—Б–∞–ї–Є, –Њ–±—К–µ–Љ –ї–Њ–Ї–∞–ї—М–љ–Њ–є GDDR5 –≤–Є–і–µ–Њ–њ–∞–Љ—П—В–Є –і–ї—П Titan —А–∞–≤–µ–љ 6 –У–С. –°—В–Њ–ї—М –Њ–≥—А–Њ–Љ–љ—Л–є –і–∞–ґ–µ –њ–Њ –љ—Л–љ–µ—И–љ–Є–Љ –Љ–µ—А–Ї–∞–Љ –Њ–±—К–µ–Љ –њ–∞–Љ—П—В–Є —П–≤–љ–Њ –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ –і–ї—П —Н–љ—В—Г–Ј–Є–∞—Б—В–Њ–≤. –Ъ–Њ–Љ–њ–∞–љ–Є—П Nvidia –љ–µ–Њ–і–љ–Њ–Ї—А–∞—В–љ–Њ –њ–Њ–ї—Г—З–∞–ї–∞ –Ј–∞–њ—А–Њ—Б—Л –Њ–± —Г–≤–µ–ї–Є—З–µ–љ–љ–Њ–Љ –Њ–±—К–µ–Љ–µ –њ–∞–Љ—П—В–Є –Њ—В –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–µ–є вАФ –Њ–љ–Є —Е–Њ—В—П—В –µ—Й–µ –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Њ–є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –≤ –≤—Л—Б–Њ–Ї–Є—Е —А–∞–Ј—А–µ—И–µ–љ–Є—П—Е —Б –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ–Љ –љ–µ—Б–Ї–Њ–ї—М–Ї–Є—Е –Љ–Њ–љ–Є—В–Њ—А–Њ–≤ –≤ —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л—Е –Є–≥—А–∞—Е –Є –њ—А–Њ–µ–Ї—В–∞—Е –±—Г–і—Г—Й–µ–≥–Њ. –Я–Њ–ґ–∞–ї—Г–є, –≤ —Б–ї—Г—З–∞–µ –њ—А–Њ–і—Г–Ї—В–∞ –њ—А–µ–Љ–Є—Г–Љ-–Ї–ї–∞—Б—Б–∞ –Є —В–∞–Ї–Њ–є –Њ–±—К–µ–Љ –њ–∞–Љ—П—В–Є –≤–њ–Њ–ї–љ–µ –Њ–њ—А–∞–≤–і–∞–љ. –Р –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є –Њ–љ –Љ–Њ–ґ–µ—В –њ–Њ–љ–∞–і–Њ–±–Є—В—М—Б—П —А–∞–Ј–≤–µ —З—В–Њ –≤ —А–∞—Б—З–µ—В–љ—Л—Е GPGPU-–Ј–∞–і–∞—З–∞—Е –і–∞ –њ—А–Є –њ–Њ—П–≤–ї–µ–љ–Є–Є –њ–µ—А–≤—Л—Е –Љ—Г–ї—М—В–Є–њ–ї–∞—В—Д–Њ—А–Љ–µ–љ–љ—Л—Е –Є–≥—А, –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ–љ—Л—Е –і–ї—П –±—Г–і—Г—Й–µ–≥–Њ –њ–Њ–Ї–Њ–ї–µ–љ–Є—П –Ї–Њ–љ—Б–Њ–ї–µ–є, –Ї–Њ—В–Њ—А—Л–µ –±—Г–і—Г—В –Є–Љ–µ—В—М –і–Њ–≤–Њ–ї—М–љ–Њ –±–Њ–ї—М—И–Њ–є –Њ–±—К–µ–Љ –њ–∞–Љ—П—В–Є. 6 –У–С –њ–∞–Љ—П—В–Є —Б 384-–±–Є—В–љ—Л–Љ –Є–љ—В–µ—А—Д–µ–є—Б–Њ–Љ –і–Њ–ї–ґ–љ—Л –і–∞—В—М Geforce GTX Titan –≤—Б–µ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ–µ –і–ї—П –і–Њ—Б—В–Є–ґ–µ–љ–Є—П –≤—Л—Б–Њ–Ї–Њ–є —З–∞—Б—В–Њ—В—Л –Ї–∞–і—А–Њ–≤ –≤–Њ –≤—Б–µ—Е –≤–Њ–Ј–Љ–Њ–ґ–љ—Л—Е –Є–≥—А–∞—Е –Є —Г—Б–ї–Њ–≤–Є—П—Е, –і–∞–ґ–µ –≤ –±–ї–Є–ґ–∞–є—И–Є–µ –≥–Њ–і—Л.

–Ъ–∞–Ї –Є –і—А—Г–≥–Є–µ —Б—В–∞—А—И–Є–µ –Љ–Њ–і–µ–ї–Є, Geforce GTX Titan –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ—В —Д–Є—А–Љ–µ–љ–љ—Г—О —В–µ—Е–љ–Њ–ї–Њ–≥–Є—О GPU Boost, —В–µ–њ–µ—А—М —Г–ґ–µ –≤—В–Њ—А–Њ–є –≤–µ—А—Б–Є–Є (–њ–Њ–і—А–Њ–±–љ–µ–µ —Б–Љ. –љ–Є–ґ–µ). –≠—В–Њ –Ї–Њ–Љ–±–Є–љ–∞—Ж–Є—П –њ—А–Њ–≥—А–∞–Љ–Љ–љ–Њ-–∞–њ–њ–∞—А–∞—В–љ—Л—Е —А–µ—И–µ–љ–Є–є, –њ–Њ–Ј–≤–Њ–ї—П—О—Й–∞—П –∞–≤—В–Њ–Љ–∞—В–Є—З–µ—Б–Ї–Є —Г–≤–µ–ї–Є—З–Є–≤–∞—В—М —А–∞–±–Њ—З–Є–µ —З–∞—Б—В–Њ—В—Л GPU –≤ –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В–Є –Њ—В –µ–≥–Њ —Н–љ–µ—А–≥–Њ–њ–Њ—В—А–µ–±–ї–µ–љ–Є—П –і–ї—П –і–Њ—Б—В–Є–ґ–µ–љ–Є—П –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ–є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є. –С–∞–Ј–Њ–≤–∞—П —В–∞–Ї—В–Њ–≤–∞—П —З–∞—Б—В–Њ—В–∞ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞ GK110 –≤ Geforce GTX Titan —А–∞–≤–љ–∞ 836 –Ь–У—Ж, –∞ —Б—А–µ–і–љ—П—П —В—Г—А–±–Њ—З–∞—Б—В–Њ—В–∞ (Boost Clock) —А–∞–≤–љ–∞ 876 –Ь–У—Ж, —З—В–Њ –љ–µ–Љ–љ–Њ–≥–Є–Љ –±–Њ–ї—М—И–µ. –Ъ–∞–Ї –Є –≤ —Б–ї—Г—З–∞–µ –њ—А–µ–і—Л–і—Г—Й–Є—Е —А–µ—И–µ–љ–Є–є, —Н—В–Њ –ї–Є—И—М —Б—А–µ–і–љ—П—П —З–∞—Б—В–Њ—В–∞, –Ї–Њ—В–Њ—А–∞—П –Є–Ј–Љ–µ–љ—П–µ—В—Б—П –≤ –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В–Є –Њ—В –Є–≥—А—Л –Є –љ–∞–≥—А—Г–Ј–Ї–Є, –∞ —А–µ–∞–ї—М–љ—Л–µ —З–∞—Б—В–Њ—В—Л GPU –≤ –Є–≥—А–∞—Е –Љ–Њ–≥—Г—В –±—Л—В—М –Є –≤—Л—И–µ. –І–∞—Б—В–Њ—В–∞ –њ–∞–Љ—П—В–Є GDDR5 –≤ Geforce GTX Titan —Б–Њ—Б—В–∞–≤–ї—П–µ—В —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л–µ 6008 –Ь–У—Ж, –Ї–∞–Ї –Є –≤ –њ—А–µ–і—Л–і—Г—Й–µ–є —В–Њ–њ–Њ–≤–Њ–є –њ–ї–∞—В–µ –Ї–Њ–Љ–њ–∞–љ–Є–Є. –†–µ–Ј—Г–ї—М—В–Є—А—Г—О—Й–µ–є –њ—А–Њ–њ—Г—Б–Ї–љ–Њ–є —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В–Є –≤ 187 –У–С/—Б –і–Њ–ї–ґ–љ–Њ –±—Л—В—М –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –і–∞–ґ–µ –і–ї—П —В–∞–Ї–Њ–≥–Њ –Љ–Њ—Й–љ–Њ–≥–Њ —А–µ—И–µ–љ–Є—П, –љ–Њ –≤ –љ–µ–Ї–Њ—В–Њ—А—Л—Е —Б–ї—Г—З–∞—П—Е –µ–µ –Љ–Њ–ґ–µ—В –Є –љ–µ —Е–≤–∞—В–Є—В—М.

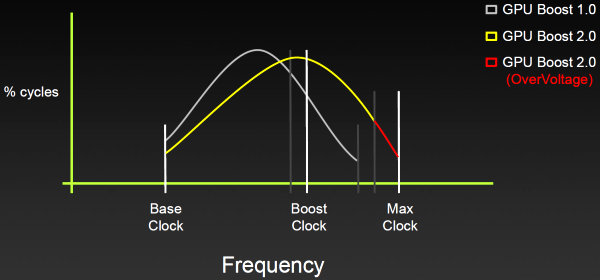

–Ґ–µ—Е–љ–Њ–ї–Њ–≥–Є—П GPU Boost 2.0

–Т Geforce GTX Titan –≤–љ–µ–і—А–µ–љ–∞ –њ–Њ–і–і–µ—А–ґ–Ї–∞ –≤—В–Њ—А–Њ–є –≤–µ—А—Б–Є–Є —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є GPU Boost. –Ю–љ–∞ –≤–Ї–ї—О—З–∞–µ—В –≤—Б–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є GPU Boost 1.0 –Є —Б–ї—Г–ґ–Є—В –і–ї—П —В–Њ–≥–Њ –ґ–µ —Б–∞–Љ–Њ–≥–Њ вАФ –∞–≤—В–Њ–Љ–∞—В–Є—З–µ—Б–Ї–Є —Г–≤–µ–ї–Є—З–Є–≤–∞–µ—В —А–∞–±–Њ—З—Г—О —З–∞—Б—В–Њ—В—Г GPU –≤ –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В–Є –Њ—В –љ–∞–≥—А—Г–Ј–Ї–Є, –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П –Є —В–µ–Љ–њ–µ—А–∞—В—Г—А—Л. –Ґ–µ—Е–љ–Њ–ї–Њ–≥–Є—П GPU Boost –≤–њ–µ—А–≤—Л–µ –њ–Њ—П–≤–Є–ї–∞—Б—М –≤ Geforce GTX 680, –Є –Њ–љ–∞ –і–Є–љ–∞–Љ–Є—З–µ—Б–Ї–Є —Г–њ—А–∞–≤–ї—П–µ—В —З–∞—Б—В–Њ—В–Њ–є –≤ –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В–Є –Њ—В —Г—Б–ї–Њ–≤–Є–є —А–∞–±–Њ—В—Л –≤–Є–і–µ–Њ—З–Є–њ–∞, –∞ –≥–ї–∞–≤–љ–Њ–є —Ж–µ–ї—М—О —П–≤–ї—П–µ—В—Б—П –і–Њ—Б—В–Є–ґ–µ–љ–Є–µ –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ–є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –≤ —А–∞–Љ–Ї–∞—Е –Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–≥–Њ –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П (–Є –≤—Л–і–µ–ї–µ–љ–Є—П) —Н–љ–µ—А–≥–Є–Є. –Ъ –њ—А–Є–Љ–µ—А—Г, —З–∞—Б—В–Њ—В–∞ GPU –≤ GTX 680 –∞–≤—В–Њ–Љ–∞—В–Є—З–µ—Б–Ї–Є –њ–Њ–≤—Л—И–∞–µ—В—Б—П, –µ—Б–ї–Є —Г—А–Њ–≤–µ–љ—М –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П –љ–µ –њ—А–µ–≤—Л—И–∞–µ—В 170 –Т—В.

–Э–Њ –≤ Titan –Є–љ–ґ–µ–љ–µ—А—Л –њ–Њ—И–ї–Є –і–∞–ї—М—И–µ. –Ю–љ–Є –Њ–њ—А–µ–і–µ–ї–Є–ї–Є, —З—В–Њ —Г—А–Њ–≤–µ–љ—М –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П GPU –љ–µ –≤—Б–µ–≥–і–∞ –Њ–≥—А–∞–љ–Є—З–Є–≤–∞–µ—В –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –њ—А–Є –љ–Є–Ј–Ї–Є—Е —А–∞–±–Њ—З–Є—Е —В–µ–Љ–њ–µ—А–∞—В—Г—А–∞—Е –≤–Є–і–µ–Њ—З–Є–њ–∞. –Ш –≤–Њ –≤—В–Њ—А–Њ–є –≤–µ—А—Б–Є–Є GPU Boost –Њ–≥—А–∞–љ–Є—З–Є—В–µ–ї–µ–Љ –і–ї—П —А–Њ—Б—В–∞ —З–∞—Б—В–Њ—В—Л —Б–ї—Г–ґ–Є—В —Г–ґ–µ –љ–µ —Г—А–Њ–≤–µ–љ—М –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П, –∞ —А–∞–±–Њ—З–∞—П —В–µ–Љ–њ–µ—А–∞—В—Г—А–∞ GPU, —Г—Б—В–∞–љ–Њ–≤–ї–µ–љ–љ–∞—П –і–ї—П Titan –љ–∞ 80 –≥—А–∞–і—Г—Б–Њ–≤.

–Т —Б–ї—Г—З–∞–µ –Љ–Њ–і–µ–ї–Є Geforce GTX Titan, —З–∞—Б—В–Њ—В–∞ –≤–Є–і–µ–Њ—З–Є–њ–∞ –∞–≤—В–Њ–Љ–∞—В–Є—З–µ—Б–Ї–Є —Г–≤–µ–ї–Є—З–Є–≤–∞–µ—В—Б—П, –њ–Њ–Ї–∞ —В–µ–Љ–њ–µ—А–∞—В—Г—А–∞ —П–і—А–∞ –Њ—Б—В–∞–µ—В—Б—П —А–∞–≤–љ–Њ–є –Є–ї–Є –љ–Є–ґ–µ 80 –≥—А–∞–і—Г—Б–Њ–≤. –°–∞–Љ GPU –Њ—В—Б–ї–µ–ґ–Є–≤–∞–µ—В —В–µ–Љ–њ–µ—А–∞—В—Г—А—Г, –Є–Ј–Љ–µ–љ—П—П —З–∞—Б—В–Њ—В—Г –Є –љ–∞–њ—А—П–ґ–µ–љ–Є–µ —В–∞–Ї, —З—В–Њ–±—Л –њ–Њ–і–і–µ—А–ґ–Є–≤–∞—В—М —Н—В–Њ—В —Г—А–Њ–≤–µ–љ—М –љ–∞–≥—А–µ–≤–∞. –Ґ–∞–Ї–Њ–µ –Є–Ј–Љ–µ–љ–µ–љ–Є–µ –≤ GPU Boost 2.0 —Б–Ї–∞–Ј—Л–≤–∞–µ—В—Б—П –Є –љ–∞ —Г—А–Њ–≤–љ–µ —И—Г–Љ–∞ –Њ—В –≤–µ–љ—В–Є–ї—П—В–Њ—А–∞ —Б–Є—Б—В–µ–Љ—Л –Њ—Е–ї–∞–ґ–і–µ–љ–Є—П вАФ –њ—А–Є –≤—Л–±–Њ—А–µ —Ж–µ–ї–µ–≤–Њ–є —В–µ–Љ–њ–µ—А–∞—В—Г—А—Л –µ–µ –њ—А–Њ—Й–µ –Ї–Њ–љ—В—А–Њ–ї–Є—А–Њ–≤–∞—В—М, –Є —З–∞—Б—В–Њ—В–∞ –≤—А–∞—Й–µ–љ–Є—П –≤–µ–љ—В–Є–ї—П—В–Њ—А–∞ –Є–Ј–Љ–µ–љ—П–µ—В—Б—П –≤ –Љ–µ–љ—М—И–Є—Е –њ—А–µ–і–µ–ї–∞—Е, —З—В–Њ —Б–љ–Є–ґ–∞–µ—В –Њ–±—Й–Є–є —Г—А–Њ–≤–µ–љ—М —И—Г–Љ–∞.

–Т –і–Њ–њ–Њ–ї–љ–µ–љ–Є–µ –Ї –њ–µ—А–µ—Е–Њ–і—Г –Њ—В –Ї–Њ–љ—В—А–Њ–ї—П –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П –Ї —В–µ–Љ–њ–µ—А–∞—В—Г—А–љ–Њ–Љ—Г –њ—А–µ–і–µ–ї—Г, Nvidia –і–∞–ї–∞ —Н–љ—В—Г–Ј–Є–∞—Б—В–∞–Љ —И–Є—А–Њ–Ї–Є–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –њ–Њ –љ–∞—Б—В—А–Њ–є–Ї–µ —А–∞–±–Њ—В—Л GPU Boost. –Я—А–Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–Є –њ—А–Њ–≥—А–∞–Љ–Љ–љ–Њ–≥–Њ –Њ–±–µ—Б–њ–µ—З–µ–љ–Є—П, —А–∞–Ј—А–∞–±–Њ—В–∞–љ–љ–Њ–≥–Њ –њ–∞—А—В–љ–µ—А–∞–Љ–Є Nvidia, —Б—З–∞—Б—В–ї–Є–≤—Л–µ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–Є –≤–Є–і–µ–Њ–Ї–∞—А—В Titan –Љ–Њ–≥—Г—В –Є–Ј–Љ–µ–љ—П—В—М —Ж–µ–ї–µ–≤—Г—О —В–µ–Љ–њ–µ—А–∞—В—Г—А—Г GPU –љ–∞ —Б–≤–Њ–є –≤–Ї—Г—Б. –Ъ –њ—А–Є–Љ–µ—А—Г, –µ—Б–ї–Є –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М —Е–Њ—З–µ—В –і–Њ—Б—В–Є—З—М –±–Њ–ї—М—И–µ–є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –Њ—В Geforce GTX Titan, —В–Њ –Њ–љ –Љ–Њ–ґ–µ—В –Є–Ј–Љ–µ–љ–Є—В—М —В–µ–Љ–њ–µ—А–∞—В—Г—А–љ—Л–є –њ—А–µ–і–µ–ї —Б 80 –і–Њ 85 –≥—А–∞–і—Г—Б–Њ–≤. –Ґ–Њ–≥–і–∞ —Г GPU –±—Г–і–µ—В –±–Њ–ї—М—И–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–µ–є –і–ї—П –њ–Њ–і–љ—П—В–Є—П —З–∞—Б—В–Њ—В—Л –Є –љ–∞–њ—А—П–ґ–µ–љ–Є—П, –њ–Њ–Ї–∞ –Є–Љ –љ–µ –і–Њ—Б—В–Є–≥–љ—Г—В–∞ –Є–Ј–Љ–µ–љ–µ–љ–љ–∞—П —Ж–µ–ї–µ–≤–∞—П —В–µ–Љ–њ–µ—А–∞—В—Г—А–∞.

–Ш–Ј-–Ј–∞ —Н—В–Є—Е –Є–Ј–Љ–µ–љ–µ–љ–Є–є –≤ –ї–Њ–≥–Є–Ї–µ —А–∞–±–Њ—В—Л GPU Boost 2.0 —Ж–µ–ї–µ–≤–Њ–є —Г—А–Њ–≤–µ–љ—М –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П (power target) —Г–ґ–µ –љ–µ –њ–Њ–Ї–∞–Ј—Л–≤–∞–µ—В —В–Є–њ–Є—З–љ–Њ–µ –њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ –≤ —Б—А–µ–і–љ–µ–Љ, –∞ —П–≤–ї—П–µ—В—Б—П –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ –≤–Њ–Ј–Љ–Њ–ґ–љ—Л–Љ –Ј–љ–∞—З–µ–љ–Є–µ–Љ –і–ї—П –і–∞–љ–љ–Њ–є –Љ–Њ–і–µ–ї–Є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л. –Я—А–Є —Г—Б—В–∞–љ–Њ–≤–Ї–µ —Ж–µ–ї–µ–≤–Њ–≥–Њ –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П –≤ 100% –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ–µ –њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ –±—Г–і–µ—В –Њ–≥—А–∞–љ–Є—З–µ–љ–Њ –Ј–љ–∞—З–µ–љ–Є–µ–Љ –≤ 250 –Т—В, –∞ –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ–µ –Ј–љ–∞—З–µ–љ–Є–µ –≤ 106% —Г—Б—В–∞–љ–Њ–≤–Є—В —Н—В–Њ—В —Г—А–Њ–≤–µ–љ—М –љ–∞ –њ–ї–∞–љ–Ї–µ –≤ 265 –Т—В. –Ґ–Є–њ–Є—З–љ—Л–є –ґ–µ —Г—А–Њ–≤–µ–љ—М –њ–Њ—В—А–µ–±–ї–µ–љ–Є—П –≤–Є–і–µ–Њ–Ї–∞—А—В–Њ–є –±—Г–і–µ—В –Є–Ј–Љ–µ–љ—П—В—М—Б—П –≤ –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В–Є –Њ—В —В–µ–Љ–њ–µ—А–∞—В—Г—А—Л —Б—А–µ–і—Л.

–Ъ —Б–ї–Њ–≤—Г, –њ–Њ—Н—В–Њ–Љ—Г GPU Boost 2.0 —Е–Њ—А–Њ—И–Њ –њ–Њ–і—Е–Њ–і–Є—В –і–ї—П —Н–Ї—Б—В—А–µ–Љ–∞–ї—М–љ–Њ–≥–Њ —А–∞–Ј–≥–Њ–љ–∞ —Б –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ–Љ –≤–Њ–і—П–љ–Њ–≥–Њ –Њ—Е–ї–∞–ґ–і–µ–љ–Є—П, –≤–µ–і—М –Њ–љ–Њ –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В —В–µ–Љ–њ–µ—А–∞—В—Г—А—Г —П–і—А–∞ GPU –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ –љ–Є–ґ–µ —Ж–µ–ї–µ–≤–Њ–є, —З—В–Њ –≤ —А–µ–Ј—Г–ї—М—В–∞—В–µ –і–Њ–ї–ґ–љ–Њ –њ—А–Є–≤–µ—Б—В–Є –Ї –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –і–Њ—Б—В–Є–ґ–µ–љ–Є—П –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Є—Е —З–∞—Б—В–Њ—В –Є –љ–∞–њ—А—П–ґ–µ–љ–Є–є. –Ш–љ—Л–Љ–Є —Б–ї–Њ–≤–∞–Љ–Є, –µ—Б–ї–Є —А–∞–љ—М—И–µ –љ–µ–Ї–Њ—В–Њ—А—Л–µ —Н–љ—В—Г–Ј–Є–∞—Б—В—Л —А–∞–Ј–≥–Њ–љ–∞ —А—Г–≥–∞–ї–Є—Б—М –љ–∞ —В–Њ, —З—В–Њ GPU Boost 1.0 –Є–Љ –Љ–µ—И–∞–µ—В, —В–Њ —В–µ–њ–µ—А—М –Њ–љ–Є –±—Г–і—Г—В –љ–µ–і–Њ–≤–Њ–ї—М–љ—Л —З—Г—В—М –Љ–µ–љ—М—И–µ, –Ї–∞–Ї –Љ–Є–љ–Є–Љ—Г–Љ. –С–Њ–ї–µ–µ —В–Њ–≥–Њ, –і–ї—П –љ–Є—Е –µ—Б—В—М –µ—Й–µ –Њ–і–љ–∞ —Е–Њ—А–Њ—И–∞—П –љ–Њ–≤–Њ—Б—В—М, —Б–≤—П–Ј–∞–љ–љ–∞—П —Б –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М—О –њ–Њ–≤—Л—И–µ–љ–Є—П –љ–∞–њ—А—П–ґ–µ–љ–Є—П.

–Я–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П–Љ Geforce GTX Titan –і–Њ—Б—В—Г–њ–љ–∞ –µ—Й–µ –Њ–і–љ–∞ –љ–Њ–≤–∞—П –љ–∞—Б—В—А–Њ–є–Ї–∞ GPU Boost 2.0 вАФ —Г–њ—А–∞–≤–ї–µ–љ–Є–µ –њ–µ—А–µ–љ–∞–њ—А—П–ґ–µ–љ–Є–µ–Љ (overvoltage). –Ґ–∞–Ї –Ї–∞–Ї –≤ Titan —В—Г—А–±–Њ—З–∞—Б—В–Њ—В–∞ –Є —Г—А–Њ–≤–µ–љ—М –љ–∞–њ—А—П–ґ–µ–љ–Є—П —В–µ–њ–µ—А—М –Ј–∞–≤–Є—Б—П—В –Њ—В —А–∞–±–Њ—З–µ–є —В–µ–Љ–њ–µ—А–∞—В—Г—А—Л GPU, —В–Њ —В–µ–њ–µ—А—М –љ–µ—В –њ—А–Є—З–Є–љ –Њ–≥—А–∞–љ–Є—З–Є–≤–∞—В—М –љ–∞–њ—А—П–ґ–µ–љ–Є–µ –≤–Є–і–µ–Њ—З–Є–њ–∞ —Б–ї–Є—И–Ї–Њ–Љ —Б—В—А–Њ–≥–Њ. –Р –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –њ–Њ–≤—Л—И–µ–љ–Є—П –љ–∞–њ—А—П–ґ–µ–љ–Є—П —Б–µ—А—М–µ–Ј–љ–Њ —Г–њ—А–Њ—Й–∞–µ—В –і–Њ—Б—В–Є–ґ–µ–љ–Є–µ –≤—Л—Б–Њ–Ї–Є—Е —В–∞–Ї—В–Њ–≤—Л—Е —З–∞—Б—В–Њ—В. –Я–Њ —Г–Љ–Њ–ї—З–∞–љ–Є—О –љ–∞–њ—А—П–ґ–µ–љ–Є–µ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞ Titan –Њ–≥—А–∞–љ–Є—З–µ–љ–Њ —А–∞–Љ–Ї–∞–Љ–Є, —Г—Б—В–∞–љ–Њ–≤–ї–µ–љ–љ—Л–Љ–Є –≤ Nvidia. –≠—В–Њ—В –њ—А–µ–і–µ–ї –љ–∞–њ—А—П–ґ–µ–љ–Є—П –љ—Г–ґ–µ–љ –і–ї—П —В–Њ–≥–Њ, —З—В–Њ–±—Л –њ—А–µ–і–Њ—В–≤—А–∞—В–Є—В—М –љ–µ–Њ–±—А–∞—В–Є–Љ—Л–µ –њ–Њ–≤—А–µ–ґ–і–µ–љ–Є—П –Ї—А–Є—Б—В–∞–ї–ї–∞, –Њ–±–µ—Б–њ–µ—З–Є–≤ —А–∞–±–Њ—В–Њ—Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –Є –љ–∞–і–µ–ґ–љ—Г—О —А–∞–±–Њ—В—Г –≤–Є–і–µ–Њ–Ї–∞—А—В—Л. –Т–µ–і—М –њ–Њ–і–∞—З–∞ —Б–ї–Є—И–Ї–Њ–Љ –≤—Л—Б–Њ–Ї–Њ–≥–Њ –љ–∞–њ—А—П–ґ–µ–љ–Є—П –љ–∞ GPU –Љ–Њ–ґ–µ—В –њ—А–Є–≤–µ—Б—В–Є –Ї –±—Л—Б—В—А–Њ–є –і–µ–≥—А–∞–і–∞—Ж–Є–Є —З–Є–њ–∞ –Є –≤—Л–Ј–≤–∞—В—М –њ–Њ–ї–Њ–Љ–Ї—Г.

–Э–Њ —Н–Ї—Б—В—А–µ–Љ–∞–ї—М–љ—Л—Е —Н–љ—В—Г–Ј–Є–∞—Б—В–Њ–≤ —А–∞–Ј–≥–Њ–љ–∞ —Н—В–Њ –љ–µ —Б—В—А–∞—И–Є—В, –Њ–љ–Є –≤—Б–µ–≥–і–∞ —Е–Њ—В—П—В –њ–Њ–ї—Г—З–Є—В—М –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Л–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –њ–Њ –њ–Њ–≤—Л—И–µ–љ–Є—О –љ–∞–њ—А—П–ґ–µ–љ–Є—П. –Ш GPU Boost 2.0 –і–∞–µ—В –Є–Љ —Н—В—Г –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М, –Њ—В–Ї—А—Л–≤–∞—П –љ–∞—Б—В—А–Њ–є–Ї—Г ¬Ђ–њ–µ—А–µ–љ–∞–њ—А—П–ґ–µ–љ–Є—П¬ї. –Х—Б—В–µ—Б—В–≤–µ–љ–љ–Њ, –Њ–љ–∞ –Њ—В–Ї–ї—О—З–µ–љ–∞ –њ–Њ —Г–Љ–Њ–ї—З–∞–љ–Є—О –Є –њ—А–Є –њ–Њ–њ—Л—В–Ї–µ –≤–Ї–ї—О—З–µ–љ–Є—П –њ–Њ–Ї–∞–ґ–µ—В —Г—Б—В—А–∞—И–∞—О—Й–µ–µ –њ—А–µ–і—Г–њ—А–µ–ґ–і–µ–љ–Є–µ –Њ —А–Є—Б–Ї–µ –њ–Њ–≤—А–µ–ґ–і–µ–љ–Є—П –≤–Є–і–µ–Њ–Ї–∞—А—В—Л. –Я–Њ–ї–љ–Њ–є –і–µ–Љ–Њ–Ї—А–∞—В–Є–Є –љ–µ—В –Є —В—Г—В, –Ї–∞–ґ–і—Л–є –Є–Ј –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї–µ–є –≤–Є–і–µ–Њ–Ї–∞—А—В –Љ–Њ–ґ–µ—В –Њ–≥—А–∞–љ–Є—З–Є–≤–∞—В—М –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –њ–Њ –њ–Њ–≤—Л—И–µ–љ–Є—О –љ–∞–њ—А—П–ґ–µ–љ–Є—П –і–ї—П –Љ–Њ–і–µ–ї–µ–є, –≤—Л—И–µ–і—И–Є—Е –њ–Њ–і –Є—Е –Љ–∞—А–Ї–Њ–є. –Ф–∞ –Є –≤ —Ж–µ–ї–Њ–Љ –њ–Њ–і–і–µ—А–ґ–Ї–∞ —Н—В–Њ–є –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –љ–µ–Њ–±—П–Ј–∞—В–µ–ї—М–љ–∞ –Є –Љ–Њ–ґ–µ—В –±—Л—В—М –Ј–∞–±–ї–Њ–Ї–Є—А–Њ–≤–∞–љ–∞ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї–µ–Љ –≤ BIOS –≤–Є–і–µ–Њ–Ї–∞—А—В—Л.

–†–∞–Ј—Г–Љ–µ–µ—В—Б—П, –њ—А–Є –њ–Њ–≤—Л—И–µ–љ–љ–Њ–Љ –љ–∞–њ—А—П–ґ–µ–љ–Є–Є Geforce GTX Titan —Б–Љ–Њ–ґ–µ—В –і–Њ—Б—В–Є—З—М –µ—Й–µ –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Є—Е —З–∞—Б—В–Њ—В, –Њ—Б–Њ–±–µ–љ–љ–Њ –њ—А–Є —Г—Б–ї–Њ–≤–Є–Є —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–µ–≥–Њ —Н–Ї—Б—В—А–µ–Љ–∞–ї—М–љ–Њ–≥–Њ –Њ—Е–ї–∞–ґ–і–µ–љ–Є—П. –Ф–∞ –Є –≤ –љ–µ–Ї–Њ—В–Њ—А—Л—Е —Б–ї—Г—З–∞—П—Е –њ—А–Њ—Б—В–Њ–µ –њ–Њ–≤—Л—И–µ–љ–Є–µ –њ—А–µ–і–µ–ї–∞ —З–∞—Б—В–Њ—В—Л GPU –љ–µ –≤—Л–Ј—Л–≤–∞–µ—В —А–Њ—Б—В–∞ —А–µ–∞–ї—М–љ–Њ–є —З–∞—Б—В–Њ—В—Л, —З—В–Њ —Б–ї—Г—З–∞–µ—В—Б—П —В–Њ–≥–і–∞, –Ї–Њ–≥–і–∞ –њ—А–Є—А–Њ—Б—В –Њ–≥—А–∞–љ–Є—З–µ–љ –љ–µ–і–Њ—Б—В–∞—В–Ї–Њ–Љ –њ–Є—В–∞–љ–Є—П. –Ш–Љ–µ–љ–љ–Њ –≤ —Н—В–Є—Е —Б–ї—Г—З–∞—П—Е –њ–Њ–≤—Л—И–µ–љ–Є–µ –њ—А–µ–і–µ–ї–∞ –љ–∞–њ—А—П–ґ–µ–љ–Є—П –і–ї—П GPU –њ–Њ–Љ–Њ–ґ–µ—В –і–Њ—Б—В–Є—З—М –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Њ–є —З–∞—Б—В–Њ—В—Л —А–∞–±–Њ—В—Л.

–Э–Њ–≤–Њ–≤–≤–µ–і–µ–љ–Є—П GPU Boost 2.0 –њ–Њ–Ј–≤–Њ–ї–Є–ї–Є Nvidia –і–Њ—Б—В–Є—З—М –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Њ–є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –Є –≤ —В–Є–њ–Є—З–љ—Л—Е —Г—Б–ї–Њ–≤–Є—П—Е –±–µ–Ј –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М—Б–Ї–Њ–≥–Њ —А–∞–Ј–≥–Њ–љ–∞, –њ–Њ–Ј–≤–Њ–ї—П—П –≤—Л—Б—В–∞–≤–Є—В—М –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Њ–µ –љ–∞–њ—А—П–ґ–µ–љ–Є–µ –Є —З–∞—Б—В–Њ—В—Г GPU. –Я—А–Є –≤–Ї–ї—О—З–µ–љ–Є–Є –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –њ—А–µ–≤—Л—И–µ–љ–Є—П —Б—В–∞–љ–і–∞—А—В–љ–Њ–≥–Њ –љ–∞–њ—А—П–ґ–µ–љ–Є—П GPU –њ–Њ—П–≤–ї—П–µ—В—Б—П –і–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ–∞—П –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М —Г–≤–µ–ї–Є—З–Є—В—М –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М, –љ–Њ –њ–Њ–≤—Л—И–∞–µ—В—Б—П –Є —А–Є—Б–Ї –њ–Њ–≤—А–µ–ґ–і–µ–љ–Є—П GPU –Є –≤—Л—Е–Њ–і–∞ –µ–≥–Њ –Є–Ј —Б—В—А–Њ—П.

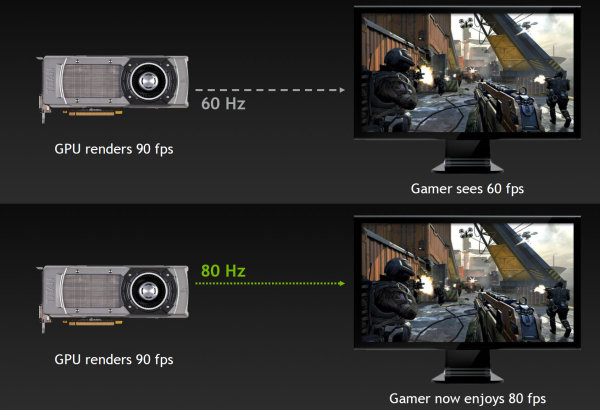

–Х—Й–µ –Њ–і–љ–Є–Љ –Є–љ—В–µ—А–µ—Б–љ—Л–Љ –љ–Њ–≤–Њ–≤–≤–µ–і–µ–љ–Є–µ–Љ GPU Boost 2.0 –Љ–Њ–ґ–љ–Њ –љ–∞–Ј–≤–∞—В—М ¬Ђ—А–∞–Ј–≥–Њ–љ –і–Є—Б–њ–ї–µ—П¬ї, –Ї–∞–Ї –µ–≥–Њ –љ–∞–Ј—Л–≤–∞–µ—В —Б–∞–Љ–∞ Nvidia. –Ь–љ–Њ–≥–Є–Љ –Є–≥—А–Њ–Ї–∞–Љ –љ—А–∞–≤–Є—В—Б—П –Є–≥—А–∞—В—М —Б –≤–Ї–ї—О—З–µ–љ–љ–Њ–є –≤–µ—А—В–Є–Ї–∞–ї—М–љ–Њ–є —Б–Є–љ—Е—А–Њ–љ–Є–Ј–∞—Ж–Є–µ–є (VSync), –њ–Њ—В–Њ–Љ—Г —З—В–Њ —Н—В–Њ –њ–Њ–Ј–≤–Њ–ї—П–µ—В –Є–Ј–±–µ–ґ–∞—В—М –∞—А—В–µ—Д–∞–Ї—В–Њ–≤ –≤—А–Њ–і–µ —А–∞–Ј—А—Л–≤–∞ –Ї–∞—А—В–Є–љ–Ї–Є, –Ї–Њ–≥–і–∞ VSync –≤—Л–Ї–ї—О—З–µ–љ. –Э–Њ –њ—А–Є –≤–Ї–ї—О—З–µ–љ–Є–Є –≤–µ—А—В–Є–Ї–∞–ї—М–љ–Њ–є —Б–Є–љ—Е—А–Њ–љ–Є–Ј–∞—Ж–Є–Є, —З–∞—Б—В–Њ—В–∞ –Ї–∞–і—А–Њ–≤ –Њ–≥—А–∞–љ–Є—З–Є–≤–∞–µ—В—Б—П —Б–≤–µ—А—Е—Г —З–∞—Б—В–Њ—В–Њ–є –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П –Љ–Њ–љ–Є—В–Њ—А–∞, –Њ–±—Л—З–љ–Њ —А–∞–≤–љ–Њ–є 60 –У—Ж –і–ї—П –≤—Б–µ—Е —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л—Е —Г—Б—В—А–Њ–є—Б—В–≤ –≤—Л–≤–Њ–і–∞ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є—П. –Т —А–µ–Ј—Г–ї—М—В–∞—В–µ, –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –Є–≥—А—Л –Њ–≥—А–∞–љ–Є—З–µ–љ–∞ –љ–∞ —Г—А–Њ–≤–љ–µ 60 FPS, –љ–µ—Б–Љ–Њ—В—А—П –љ–∞ —В–Њ, —З—В–Њ –≤–Є–і–µ–Њ—З–Є–њ –Љ–Њ–ґ–µ—В —А–µ–љ–і–µ—А–Є—В—М —Б—Ж–µ–љ—Г –Є –љ–∞ –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Њ–є —Б–Ї–Њ—А–Њ—Б—В–Є.

–Ш —В–Њ–ї—М–Ї–Њ —Г–≤–µ–ї–Є—З–µ–љ–Є–µ —З–∞—Б—В–Њ—В—Л –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П —Н–Ї—А–∞–љ–∞ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ —Б–Ї–∞–ґ–µ—В—Б—П –Є –љ–∞ –Є—В–Њ–≥–Њ–≤–Њ–є —З–∞—Б—В–Њ—В–µ –Ї–∞–і—А–Њ–≤ –≤ —Б–µ–Ї—Г–љ–і—Г. –°–Ї–∞–ґ–µ–Љ, –µ—Б–ї–Є GPU –Љ–Њ–ґ–µ—В –Њ—В—А–µ–љ–і–µ—А–Є—В—М 90 FPS, —В–Њ –њ—А–Є –≤–Ї–ї—О—З–µ–љ–љ–Њ–Љ VSync –Љ–Њ–љ–Є—В–Њ—А —Б–Љ–Њ–ґ–µ—В –њ–Њ–Ї–∞–Ј–∞—В—М –ї–Є—И—М 60 FPS, –љ–Њ –µ—Б–ї–Є –њ–Њ–≤—Л—Б–Є—В—М —З–∞—Б—В–Њ—В—Г –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П –і–Њ 80 –У—Ж, —В–Њ GPU –њ–Њ–ї—Г—З–Є—В –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М —А–∞–±–Њ—В–∞—В—М –±—Л—Б—В—А–µ–µ вАФ –љ–∞ 80 FPS –њ—А–Є —В–Њ–Љ –ґ–µ –Њ—В—Б—Г—В—Б—В–≤–Є–Є –∞—А—В–µ—Д–∞–Ї—В–Њ–≤ —А–∞–Ј—А—Л–≤–∞ –Ї–∞—А—В–Є–љ–Ї–Є.

–Т GPU Boost 2.0 –±—Л–ї–∞ –і–Њ–±–∞–≤–ї–µ–љ–∞ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М ¬Ђ—А–∞–Ј–≥–Њ–љ–∞ –і–Є—Б–њ–ї–µ—П¬ї. –Я—А–Є –њ–Њ–Љ–Њ—Й–Є —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–Є—Е —Г—В–Є–ї–Є—В –Њ—В –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї–µ–є –≤–Є–і–µ–Њ–Ї–∞—А—В, –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М Geforce GTX Titan –њ–Њ–ї—Г—З–∞–µ—В –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М —Г–≤–µ–ї–Є—З–µ–љ–Є—П —З–∞—Б—В–Њ—В—Л —Б–ї–µ–і–Њ–≤–∞–љ–Є—П –њ–Є–Ї—Б–µ–ї–µ–є (pixel clock) –і–ї—П —Б–Њ–±—Б—В–≤–µ–љ–љ–Њ–≥–Њ –і–Є—Б–њ–ї–µ—П, —З—В–Њ –њ–Њ–Ј–≤–Њ–ї—П–µ—В –і–Њ–±–Є—В—М—Б—П –±–Њ–ї–µ–µ –≤—Л—Б–Њ–Ї–Њ–є —З–∞—Б—В–Њ—В—Л –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П —Н–Ї—А–∞–љ–∞, –∞ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ –Є —Г–≤–µ–ї–Є—З–µ–љ–Є—П –Є—В–Њ–≥–Њ–≤–Њ–є —З–∞—Б—В–Њ—В—Л –Ї–∞–і—А–Њ–≤. –Х—Б—В–µ—Б—В–≤–µ–љ–љ–Њ, –љ–µ –≤—Б–µ –Љ–Њ–љ–Є—В–Њ—А—Л –њ–Њ–і–і–µ—А–ґ–Є–≤–∞—О—В —В–∞–Ї–Њ–є —А–∞–Ј–≥–Њ–љ, —В–∞–Ї —З—В–Њ —В—Г—В —Г –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–µ–є –µ—Б—В—М –±–Њ–≥–∞—В–Њ–µ –њ–Њ–ї–µ –і–ї—П —Н–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–Њ–≤.

–Т—Л—З–Є—Б–ї–µ–љ–Є—П —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О –љ–∞ Geforce GTX Titan

–Ш–љ—В–µ—А–µ—Б–љ–Њ, —З—В–Њ –Ї–Њ–Љ–њ–∞–љ–Є—П Nvidia —А–µ—И–Є–ї–∞ —Б–і–µ–ї–∞—В—М –Є–Ј Geforce GTX Titan –њ–µ—А–≤—Г—О –Є–≥—А–Њ–≤—Г—О –≤–Є–і–µ–Њ–Ї–∞—А—В—Г —Б–µ—А–Є–Є Geforce, –Ї–Њ—В–Њ—А–∞—П –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –љ–µ–≥—А–∞—Д–Є—З–µ—Б–Ї–Є–µ –≤—Л—З–Є—Б–ї–µ–љ–Є—П –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В–Є —Б –њ–Њ–ї–љ–Њ–є —Б–Ї–Њ—А–Њ—Б—В—М—О, –њ—А–µ–і—Г—Б–Љ–Њ—В—А–µ–љ–љ–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А–Њ–є –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞, –і–∞ –µ—Й–µ –Є –љ–µ –Њ–≥—А–∞–љ–Є—З–µ–љ–љ—Г—О –њ—А–Њ–≥—А–∞–Љ–Љ–љ–Њ. –Э–µ —Б–µ–Ї—А–µ—В, —З—В–Њ –њ—А–µ–і—Л–і—Г—Й–Є–µ –≤–Є–і–µ–Њ–Ї–∞—А—В—Л Geforce –Є–Љ–µ—О—В –≤–µ—Б—М–Љ–∞ –љ–Є–Ј–Ї—Г—О —Б–Ї–Њ—А–Њ—Б—В—М –≤—Л—З–Є—Б–ї–µ–љ–Є–є —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О (double-precision, DP). –Ъ –њ—А–Є–Љ–µ—А—Г, –Ї–∞–ґ–і—Л–є –Љ—Г–ї—М—В–Є–њ—А–Њ—Ж–µ—Б—Б–Њ—А –≤ GK104, –њ—А–Є–Љ–µ–љ—П–µ–Љ—Л–є –≤ Geforce GTX 680, –Є–Љ–µ–µ—В –њ–Њ 192 –њ–Њ—В–Њ–Ї–Њ–≤—Л—Е —П–і—А–∞ –і–ї—П –≤—Л—З–Є—Б–ї–µ–љ–Є–є —Б –Њ–і–Є–љ–∞—А–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О (single-precision, SP) –Є –ї–Є—И—М 8 —П–і–µ—А –і–ї—П DP-–≤—Л—З–Є—Б–ї–µ–љ–Є–є. –Я–Њ—Н—В–Њ–Љ—Г —Б–Ї–Њ—А–Њ—Б—В—М –≤—Л—З–Є—Б–ї–µ–љ–Є–є —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О –±—Л–ї–∞ —А–∞–≤–љ–∞ –ї–Є—И—М 1/24 –Њ—В —Б–Ї–Њ—А–Њ—Б—В–Є SP-–≤—Л—З–Є—Б–ї–µ–љ–Є–є. –Т —Б–ї—Г—З–∞–µ —З–Є–њ–∞ GK110, –Ї–Њ—В–Њ—А—Л–є –ї–µ–ґ–Є—В –≤ –Њ—Б–љ–Њ–≤–µ Geforce GTX Titan, –љ–∞ –Ї–∞–ґ–і—Л–є SMX –њ—А–Є—Е–Њ–і–Є—В—Б—П –њ–Њ 64 —П–і–µ—А, —Б–њ–Њ—Б–Њ–±–љ—Л—Е –љ–∞ –≤—Л—З–Є—Б–ї–µ–љ–Є—П —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О (–Є —В–µ –ґ–µ 192 SP-—П–і—А–∞), —В–∞–Ї —З—В–Њ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –≤ DP-–≤—Л—З–Є—Б–ї–µ–љ–Є—П—Е —Б–Њ—Б—В–∞–≤–ї—П–µ—В 1/3 –Њ—В SP-—Б–Ї–Њ—А–Њ—Б—В–Є, —З—В–Њ –Ј–∞–Љ–µ—В–љ–Њ –≤—Л—И–µ.

–Х—Й–µ –і–Њ –≤—Л—Е–Њ–і–∞ Titan –≤ –°–µ—В–Є –њ–Њ—П–≤–Є–ї–Є—Б—М —Б–ї—Г—Е–Є –Њ —В–Њ–Љ, —З—В–Њ –≤ Geforce –љ–∞ –Њ—Б–љ–Њ–≤–µ —З–Є–њ–∞ GK110 —Б–Ї–Њ—А–Њ—Б—В—М –≤—Л—З–Є—Б–ї–µ–љ–Є–є —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О –±—Г–і–µ—В –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ–Њ –Њ–≥—А–∞–љ–Є—З–µ–љ–∞, —З—В–Њ–±—Л –љ–µ —Б–Њ–Ј–і–∞–≤–∞—В—М –Ї–Њ–љ–Ї—Г—А–µ–љ—Ж–Є—О —Б –ї–Є–љ–µ–є–Ї–Њ–є Tesla. –Ъ —Б—З–∞—Б—В—М—О, —Б–ї—Г—Е–Є –Њ—Б—В–∞–ї–Є—Б—М –ї–Є—И—М —Б–ї—Г—Е–∞–Љ–Є –Є Nvidia —А–µ—И–Є–ї–∞ –Њ—Б—В–∞–≤–Є—В—М –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М DP-–≤—Л—З–Є—Б–ї–µ–љ–Є–є –љ–∞ –њ–Њ–ї–љ–Њ—Ж–µ–љ–љ–Њ–Љ —Г—А–Њ–≤–љ–µ, —З—В–Њ–±—Л –Њ–±–µ—Б–њ–µ—З–Є—В—М —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Њ–≤ –Я–Ю, –Є–љ–ґ–µ–љ–µ—А–Њ–≤ –Є —Б—В—Г–і–µ–љ—В–Њ–≤ –љ–µ–і–Њ—А–Њ–≥–Є–Љ –∞–њ–њ–∞—А–∞—В–љ—Л–Љ –Њ–±–µ—Б–њ–µ—З–µ–љ–Є–µ–Љ, –Ї–Њ—В–Њ—А–Њ–µ —Б–њ–Њ—Б–Њ–±–љ–Њ –Њ–±–µ—Б–њ–µ—З–Є—В—М –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –≤—Л—И–µ 1 —В–µ—А–∞—Д–ї–Њ–њ—Б–∞ –њ—А–Є DP-–≤—Л—З–Є—Б–ї–µ–љ–Є—П—Е. –Т–µ—А–Њ—П—В–љ–Њ, –Ї–Њ–Љ–њ–∞–љ–Є—П —А–∞—Б—Б—З–Є—В—Л–≤–∞–µ—В, —З—В–Њ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є–µ —Б—А–∞–≤–љ–Є—В–µ–ї—М–љ–Њ –љ–µ–і–Њ—А–Њ–≥–Њ–≥–Њ (–њ–Њ –Љ–µ—А–Ї–∞–Љ –њ—А–Њ—Д–µ—Б—Б–Є–Њ–љ–∞–ї—М–љ—Л—Е —А–µ—И–µ–љ–Є–є) Geforce GTX Titan –≤ —Б—А–µ–і–µ —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Њ–≤, –Є—Б–њ–Њ–ї—М–Ј—Г—О—Й–Є—Е –љ–µ–≥—А–∞—Д–Є—З–µ—Б–Ї–Є–µ –≤—Л—З–Є—Б–ї–µ–љ–Є—П –љ–∞ GPU, –њ–Њ–Ј–≤–Њ–ї–Є—В –Є–Љ —А–∞–Ј—А–∞–±–∞—В—Л–≤–∞—В—М –Є –Њ–њ—В–Є–Љ–Є–Ј–Є—А–Њ–≤–∞—В—М —Б–≤–Њ–Є –њ—А–Є–ї–Њ–ґ–µ–љ–Є—П –њ–Њ–і –њ—А–Њ—Ж–µ—Б—Б–Њ—А—Л Nvidia, —З—В–Њ —Г–≤–µ–ї–Є—З–Є—В —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є–µ GPGPU –Ј–∞–і–∞—З, —Б—В–Њ–ї—М –ґ–µ–ї–∞–љ–љ–Њ–µ –Ї–Њ–Љ–њ–∞–љ–Є–µ–є.

–Т–Ї–ї—О—З–µ–љ–Є–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –њ–Њ–ї–љ–Њ—Б–Ї–Њ—А–Њ—Б—В–љ—Л—Е DP-–≤—Л—З–Є—Б–ї–µ–љ–Є–є –љ–∞ Geforce GTX Titan –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ –Є–Ј –љ–∞—Б—В—А–Њ–µ–Ї –і—А–∞–є–≤–µ—А–∞. –Я–Њ —Г–Љ–Њ–ї—З–∞–љ–Є—О Geforce GTX Titan –Ј–∞–њ—Г—Б–Ї–∞–µ—В DP-–≤—Л—З–Є—Б–ї–µ–љ–Є—П –ї–Є—И—М –љ–∞ 1/24 –Њ—В —Б–Ї–Њ—А–Њ—Б—В–Є –≤—Л—З–Є—Б–ї–µ–љ–Є–є —Б –Њ–і–Є–љ–∞—А–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О (–Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–Є—Е –Љ—Г–ї—М—В–Є–њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ SMX –Љ–µ–љ—М—И–µ –≤—В—А–Њ–µ, –љ–Њ –Њ–љ–Є –µ—Й–µ –Є —А–∞–±–Њ—В–∞—О—В –≤ 8 —А–∞–Ј –Љ–µ–і–ї–µ–љ–љ–µ–µ), –∞–љ–∞–ї–Њ–≥–Є—З–љ–Њ Geforce GTX 680. –І—В–Њ–±—Л –≤–Ї–ї—О—З–Є—В—М –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –њ–Њ–ї–љ–Њ—Б–Ї–Њ—А–Њ—Б—В–љ—Л—Е –≤—Л—З–Є—Б–ї–µ–љ–Є–є, –љ—Г–ґ–љ–Њ –Њ—В–Ї—А—Л—В—М –њ–∞–љ–µ–ї—М —Г–њ—А–∞–≤–ї–µ–љ–Є—П Nvidia –Є –≤ –њ–∞–љ–µ–ї–Є ¬Ђ–£–њ—А–∞–≤–ї–µ–љ–Є–µ –њ–∞—А–∞–Љ–µ—В—А–∞–Љ–Є 3D¬ї (¬ЂManage 3D Settings¬ї) –љ–∞–є—В–Є –љ–∞—Б—В—А–Њ–є–Ї—Г ¬ЂCUDA вАФ Double Precision¬ї –Є –њ–Њ–Љ–µ—В–Є—В—М –≥–∞–ї–Њ—З–Ї—Г –љ–∞–њ—А–Њ—В–Є–≤ —Б—В—А–Њ–Ї–Є ¬ЂGeforce GTX Titan¬ї. –Я—А–Є –≤–Ї–ї—О—З–µ–љ–Є–Є –љ–∞—Б—В—А–Њ–є–Ї–Є –Њ–љ–∞ –±—Г–і–µ—В –њ—А–Є–Љ–µ–љ–µ–љ–∞ —Б—А–∞–Ј—Г –ґ–µ, –±–µ–Ј –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ—Б—В–Є –њ–µ—А–µ–Ј–∞–≥—А—Г–Ј–Ї–Є. –Я—А–Є—З–µ–Љ, –Ј–∞–њ–Є—Б—Л–≤–∞–µ—В—Б—П –≤ BIOS –≤–Є–і–µ–Њ–Ї–∞—А—В—Л –Є –љ–µ —В—А–µ–±—Г–µ—В –њ–Њ—Б—В–Њ—П–љ–љ–Њ–≥–Њ –≤–Ї–ї—О—З–µ–љ–Є—П –њ–Њ—Б–ї–µ –Ї–∞–ґ–і–Њ–є –њ–µ—А–µ–Ј–∞–≥—А—Г–Ј–Ї–Є.

–Ч–∞—З–µ–Љ –љ—Г–ґ–љ—Л —Б—В–Њ–ї—М —Б–ї–Њ–ґ–љ—Л–µ —В–µ–ї–Њ–і–≤–Є–ґ–µ–љ–Є—П, –љ–µ –ї—Г—З—И–µ –ї–Є –±—Л–ї–Њ –њ—А–Њ—Б—В–Њ –≤–Ї–ї—О—З–Є—В—М –±—Л—Б—В—А—Л–µ DP-–≤—Л—З–Є—Б–ї–µ–љ–Є—П –љ–∞ –њ–Њ—Б—В–Њ—П–љ–љ–Њ–є –Њ—Б–љ–Њ–≤–µ? –°–µ–Ї—А–µ—В –Ї—А–Њ–µ—В—Б—П –≤ —В–Њ–Љ, —З—В–Њ –њ—А–Є –њ–Њ–ї–љ–Њ—Б–Ї–Њ—А–Њ—Б—В–љ–Њ–є —А–∞–±–Њ—В–µ DP-—П–і–µ—А –≥—А–∞—Д–Є—З–µ—Б–Ї–Є–є –њ—А–Њ—Ж–µ—Б—Б–Њ—А GK110 –њ–Њ—В—А–µ–±–ї—П–µ—В –±–Њ–ї—М—И–µ —Н–љ–µ—А–≥–Є–Є –Є –љ–µ –Љ–Њ–ґ–µ—В —А–∞–±–Њ—В–∞—В—М –љ–∞ —З–∞—Б—В–Њ—В–µ, –≤—Л–±—А–∞–љ–љ–Њ–є –і–ї—П ¬Ђ–Є–≥—А–Њ–≤–Њ–≥–Њ¬ї —А–µ–ґ–Є–Љ–∞ Geforce. –Ъ–Њ–Љ–њ–∞–љ–Є—П Nvidia –Њ–±–Њ—И–ї–∞ –њ—А–Њ–±–ї–µ–Љ—Г –Њ—З–µ–љ—М –њ—А–Њ—Б—В–Њ вАФ –њ—А–Є –≤–Ї–ї—О—З–µ–љ–Є–Є —Н—В–Њ–є –љ–∞—Б—В—А–Њ–є–Ї–Є –≤–Є–і–µ–Њ—З–Є–њ Geforce GTX Titan –±—Г–і–µ—В –≤—Б–µ–≥–і–∞ —А–∞–±–Њ—В–∞—В—М –љ–∞ –њ–Њ–љ–Є–ґ–µ–љ–љ–Њ–є —З–∞—Б—В–Њ—В–µ –Є –њ—А–Є –Љ–µ–љ—М—И–µ–Љ –љ–∞–њ—А—П–ґ–µ–љ–Є–Є.

–°–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ, –µ—Б–ї–Є –≤—Л –љ–µ –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В–µ –љ–Є–Ї–∞–Ї–Є—Е —Б–њ–µ—Ж–Є—Д–Є—З–µ—Б–Ї–Є—Е GPGPU-–њ—А–Є–ї–Њ–ґ–µ–љ–Є–є, –Є—Б–њ–Њ–ї—М–Ј—Г—О—Й–Є—Е —А–∞—Б—З–µ—В—Л —Б –і–≤–Њ–є–љ–Њ–є —В–Њ—З–љ–Њ—Б—В—М—О, —В–Њ –≤ –љ–∞—Б—В—А–Њ–є–Ї–µ –љ–µ—В –љ–Є–Ї–∞–Ї–Њ–≥–Њ —Б–Љ—Л—Б–ї–∞ вАФ –Њ–љ–∞ —В–Њ–ї—М–Ї–Њ —Б–љ–Є–Ј–Є—В –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –≤ –Є–≥—А–Њ–≤—Л—Е –њ—А–Є–ї–Њ–ґ–µ–љ–Є—П—Е –Є –і—А—Г–≥–Є—Е 3D-–Ј–∞–і–∞—З–∞—Е. –Ш–≥—А, –Є—Б–њ–Њ–ї—М–Ј—Г—О—Й–Є—Е —В–∞–Ї–Є–µ –≤—Л—З–Є—Б–ї–µ–љ–Є—П, –њ—А–Њ—Б—В–Њ –љ–µ —Б—Г—Й–µ—Б—В–≤—Г–µ—В (–і–∞ –Є –љ–µ —Д–∞–Ї—В, —З—В–Њ –Њ–љ–Є –њ–Њ—П–≤—П—В—Б—П –≤ –Њ–±–Њ–Ј—А–Є–Љ–Њ–Љ –±—Г–і—Г—Й–µ–Љ). –Я–Њ—Н—В–Њ–Љ—Г, —З—В–Њ–±—Л –Њ—В–Ї–ї—О—З–Є—В—М –њ–Њ–ї–љ–Њ—Б–Ї–Њ—А–Њ—Б—В–љ—Л–µ DP-–≤—Л—З–Є—Б–ї–µ–љ–Є—П, –љ—Г–ґ–љ–Њ –њ—А–Њ–і–µ–ї–∞—В—М –Њ–±—А–∞—В–љ–Њ–µ –і–µ–є—Б—В–≤–Є–µ, —Б–љ—П–≤ ¬Ђ–≥–∞–ї–Њ—З–Ї—Г¬ї –≤ –љ–∞—Б—В—А–Њ–є–Ї–µ ¬ЂCUDA вАФ Double Precision¬ї –≤ –њ–∞–љ–µ–ї–Є —Г–њ—А–∞–≤–ї–µ–љ–Є—П Nvidia.

–Ю—Ж–µ–љ–Ї–∞ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є

–Я–µ—А–µ—Е–Њ–і–Є–Љ –Ї –≤–Њ–њ—А–Њ—Б—Г –њ—А–µ–і–≤–∞—А–Є—В–µ–ї—М–љ–Њ–є –Њ—Ж–µ–љ–Ї–Є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –љ–Њ–≤–Њ–≥–Њ —А–µ—И–µ–љ–Є—П вАФ –Љ–Њ–і–µ–ї–Є Geforce GTX Titan. –Я–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б Geforce GTX 680, –≤ Titan –Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ –±–Њ–ї—М—И–µ –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л—Е —П–і–µ—А –Є —В–µ–Ї—Б—В—Г—А–љ—Л—Е –±–ї–Њ–Ї–Њ–≤, –њ–Њ—Н—В–Њ–Љ—Г —Б–Ї–Њ—А–Њ—Б—В—М —И–µ–є–і–µ—А–љ—Л—Е –≤—Л—З–Є—Б–ї–µ–љ–Є–є, –Њ–±—А–∞–±–Њ—В–Ї–Є –≥–µ–Њ–Љ–µ—В—А–Є–Є –Є —В–µ–Ї—Б—В—Г—А–љ–Њ–є —Д–Є–ї—М—В—А–∞—Ж–Є–Є —Б–µ—А—М–µ–Ј–љ–Њ –≤—Л—А–Њ—Б–ї–∞. –Я—А–∞–≤–і–∞, —Б —Г—З–µ—В–Њ–Љ –њ–Њ–љ–Є–ґ–µ–љ–љ–Њ–є –і–Њ 836(876) –Ь–У—Ж —В–∞–Ї—В–Њ–≤–Њ–є —З–∞—Б—В–Њ—В—Л –і–ї—П GPU, —А–µ–∞–ї—М–љ—Л–є —В–µ–Њ—А–µ—В–Є—З–µ—Б–Ї–Є–є –њ—А–Є—А–Њ—Б—В –њ–Њ —Н—В–Є–Љ –њ–∞—А–∞–Љ–µ—В—А–∞–Љ –љ–µ –њ—А–µ–≤—Л—Б–Є—В 45%. –Я–Њ —В–µ–Њ—А–µ—В–Є—З–µ—Б–Ї–Њ–є —Б–Ї–Њ—А–Њ—Б—В–Є –Ј–∞–њ–Њ–ї–љ–µ–љ–Є—П –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–Њ –њ–µ—А–µ–і GTX 680 –µ—Й–µ –Љ–µ–љ—М—И–µ вАФ –ї–Є—И—М 25%, –Ј–∞—В–Њ –њ–Њ–Ї–∞–Ј–∞—В–µ–ї—М —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ–≥–Њ —Д–Є–ї–ї—А–µ–є—В–∞ –≤—Л—А–Њ—Б –Њ—Й—Г—В–Є–Љ–µ–µ. –Ґ–∞–Ї –Ї–∞–Ї Geforce GTX Titan –Є–Љ–µ–µ—В 384-–±–Є—В–љ—Г—О —И–Є–љ—Г –њ–∞–Љ—П—В–Є, –∞ –µ–µ –Љ–Є–Ї—А–Њ—Б—Е–µ–Љ—Л —А–∞–±–Њ—В–∞—О—В –љ–∞ —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ–є —З–∞—Б—В–Њ—В–µ –≤ 6 –У–У—Ж, —В–Њ –Њ–±—Й–∞—П –њ—А–Њ–њ—Г—Б–Ї–љ–∞—П —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –њ–∞–Љ—П—В–Є Geforce GTX Titan –≤—Л—А–Њ—Б–ї–∞ –љ–∞ 50%, –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б –ї—Г—З—И–Є–Љ —А–µ—И–µ–љ–Є–µ–Љ, –Њ—Б–љ–Њ–≤–∞–љ–љ—Л–Љ –љ–∞ —З–Є–њ–µ GK104.

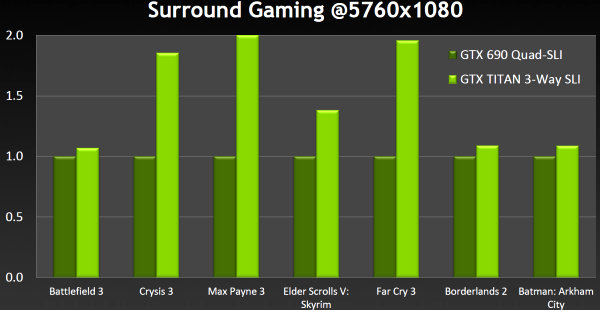

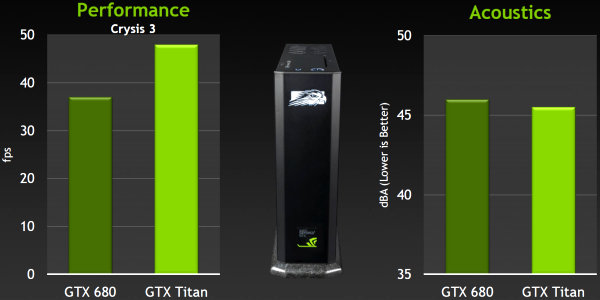

–Т –і–∞–љ–љ–Њ–є —В–µ–Њ—А–µ—В–Є—З–µ—Б–Ї–Њ–є —З–∞—Б—В–Є —Б—В–∞—В—М–Є –Љ—Л –њ—А–Є–≤–Њ–і–Є–Љ —В–Њ–ї—М–Ї–Њ —Б–Њ–±—Б—В–≤–µ–љ–љ—Л–µ –і–∞–љ–љ—Л–µ —В–µ—Б—В–Њ–≤ —Б–∞–Љ–Њ–є –Ї–Њ–Љ–њ–∞–љ–Є–Є Nvidia. –Я–Њ–љ—П—В–љ–Њ, —З—В–Њ Geforce GTX Titan –і–Њ–ї–ґ–µ–љ —Б—В–∞—В—М –±—Л—Б—В—А–µ–є—И–Є–Љ –Њ–і–љ–Њ—З–Є–њ–Њ–≤—Л–Љ —А–µ—И–µ–љ–Є–µ–Љ –љ–∞ —А—Л–љ–Ї–µ –≤–Є–і–µ–Њ–Ї–∞—А—В, –љ–Њ –љ–∞—Б–Ї–Њ–ї—М–Ї–Њ –Њ–љ –±—Л—Б—В—А–µ–µ? –Я–Њ–і—А–Њ–±–љ—Л–µ —В–µ—Б—В—Л –±—Г–і—Г—В –і–∞–ї–µ–µ, –∞ –Љ—Л –њ—А–Є–≤–µ–і–µ–Љ –Њ—Ж–µ–љ–Ї—Г Nvidia, –Ї–Њ—В–Њ—А–∞—П —Г—В–≤–µ—А–ґ–і–∞–µ—В, —З—В–Њ —В—А–Є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л Geforce GTX Titan вАФ –µ–і–Є–љ—Б—В–≤–µ–љ–љ–∞—П –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –њ–Њ–Є–≥—А–∞—В—М –≤ –Њ–і–љ—Г –Є–Ј —Б–∞–Љ—Л—Е —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л—Е –Є–≥—А Crysis 3 —Б –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Л–Љ–Є –љ–∞—Б—В—А–Њ–є–Ї–∞–Љ–Є –љ–∞ —В—А–µ—Е –і–Є—Б–њ–ї–µ—П—Е –≤ –Є—В–Њ–≥–Њ–≤–Њ–Љ —А–∞–Ј—А–µ—И–µ–љ–Є–Є 5760×1080, –і–∞ –µ—Й–µ —Б –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ–Љ –њ–Њ–ї–љ–Њ—Н–Ї—А–∞–љ–љ–Њ–≥–Њ —Б–≥–ї–∞–ґ–Є–≤–∞–љ–Є—П –Љ–µ—В–Њ–і–Њ–Љ –Љ—Г–ї—М—В–Є—Б—Н–Љ–њ–ї–Є–љ–≥–∞ MSAA 2x. –Т —В–∞–Ї–Њ–Љ —А–µ–ґ–Є–Љ–µ —В—А–Є –Ї–∞—А—В—Л –Њ–±–µ—Б–њ–µ—З–Є–ї–Є 46 FPS.

–Х—Б—В–µ—Б—В–≤–µ–љ–љ–Њ, —З—В–Њ —В—Г—В —Б–≤–Њ—О —А–Њ–ї—М –Є–≥—А–∞—О—В –Ї–∞–Ї –Њ–≥—А–Њ–Љ–љ—Л–є –Њ–±—К–µ–Љ –ї–Њ–Ї–∞–ї—М–љ–Њ–є –≤–Є–і–µ–Њ–њ–∞–Љ—П—В–Є –≤ 6 –У–С, —В–∞–Ї –Є 384-–±–Є—В–љ–∞—П —И–Є–љ–∞, –Њ–±–µ—Б–њ–µ—З–Є–≤–∞—О—Й–∞—П –≤—Л—Б–Њ–Ї—Г—О –Я–°–Я. –Э–Њ –љ–µ —В–Њ–ї—М–Ї–Њ Crysis 3 –≤—Л–і–µ–ї—П–µ—В—Б—П, –≤–Њ –Љ–љ–Њ–≥–Є—Е —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л—Е –Є–≥—А–∞—Е —В—А–Є GTX Titan –±—Л—Б—В—А–µ–µ, —З–µ–Љ —З–µ—В—Л—А–µ GTX 690. –•–Њ—В—П –≤ –љ–µ–Ї–Њ—В–Њ—А—Л—Е –њ—А–Њ–µ–Ї—В–∞—Е –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М —В–∞–Ї–Є—Е —Б–Є—Б—В–µ–Љ –≤–µ—Б—М–Љ–∞ –±–ї–Є–Ј–Ї–∞, —З—В–Њ —В–Њ–ґ–µ –љ–µ–њ–ї–Њ—Е–Њ:

–Ф–∞–љ–љ–Њ–µ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є–µ –њ—А–Њ–≤–Њ–і–Є–ї–Њ—Б—М –љ–∞ —Б–Є—Б—В–µ–Љ–µ —Б –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–Љ Intel Core i7 3960X, —А–∞–±–Њ—В–∞—О—Й–Є–Љ –љ–∞ —З–∞—Б—В–Њ—В–µ 3,3 –У–У—Ж, –∞ —В–∞–Ї–ґ–µ –њ—А–Є –≤–Ї–ї—О—З–µ–љ–љ–Њ–Љ 4x MSAA-—Б–≥–ї–∞–ґ–Є–≤–∞–љ–Є–Є –Є –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Л—Е –љ–∞—Б—В—А–Њ–є–Ї–∞—Е. –Я–Њ—Е–Њ–ґ–µ, —З—В–Њ –Є–Љ–µ–љ–љ–Њ —В—А–Є Geforce GTX Titan, —А–∞–±–Њ—В–∞—О—Й–Є–µ –≤ —Б–≤—П–Ј–Ї–µ 3-Way SLI —Б—В–∞–ї–Є –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ–є –≤–Є–і–µ–Њ—Б–Є—Б—В–µ–Љ–Њ–є, —В–∞–Ї –Ї–∞–Ї –≤ —Б—А–µ–і–љ–µ–Љ –Њ–љ–Є –њ—А–µ–≤–Њ—Б—Е–Њ–і—П—В –і–≤–µ Geforce GTX 690, —А–∞–±–Њ—В–∞—О—Й–Є–µ –≤ —А–µ–ґ–Є–Љ–µ Quad SLI.

–Э–Њ Geforce GTX Titan –њ–Њ–і—Е–Њ–і–Є—В –љ–µ —В–Њ–ї—М–Ї–Њ –і–ї—П —Н–љ—В—Г–Ј–Є–∞—Б—В–Њ–≤ –Є –ї—О–±–Є—В–µ–ї–µ–є —А–∞–Ј–≥–Њ–љ–∞, –Є–Љ–µ—О—Й–Є—Е –њ—А–Њ—Б—В–Њ—А–љ—Л–µ –Ї–Њ—А–њ—Г—Б–∞. –£ –љ–Є—Е —В–Њ –Є —Б –і–≤—Г—Е—З–Є–њ–Њ–≤—Л–Љ–Є Geforce GTX 690 –љ–Є–Ї–∞–Ї–Є—Е –њ—А–Њ–±–ї–µ–Љ –љ–µ –±—Л–ї–Њ. –Р –≤–Њ—В —Г —В–µ—Е, –Ї–Њ–Љ—Г –љ—Г–ґ–љ–∞ –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–∞—П –Љ–Њ—Й—М –≤ –Ї–Њ–Љ–њ–∞–Ї—В–љ–Њ–Љ –Ї–Њ—А–њ—Г—Б–µ, –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є —Г—Б—В–∞–љ–Њ–≤–Ї–Є —В–∞–Ї–Є—Е ¬Ђ–≥–Њ—А—П—З–Є—Е¬ї —Г—Б–Ї–Њ—А–Є—В–µ–ї–µ–є –њ—А–Њ—Б—В–Њ –љ–µ –±—Л–ї–Њ. –Ъ –њ—А–Є–Љ–µ—А—Г, –і–ї—П —В–∞–Ї –љ–∞–Ј—Л–≤–∞–µ–Љ—Л—Е –Љ–Њ–і–µ–ї–µ–є small form factor (SFF), –Є–Љ–µ—О—Й–Є—Е –Љ–∞–ї—Л–µ —А–∞–Ј–Љ–µ—А—Л –Є —Б—А–∞–≤–љ–Є—В–µ–ї—М–љ–Њ —В–Є—Е–Њ–µ –Њ—Е–ї–∞–ґ–і–µ–љ–Є–µ, –≤–Є–і–µ–Њ–Ї–∞—А—В–∞ Geforce GTX 690 —Б–ї–Є—И–Ї–Њ–Љ –Ї—А—Г–њ–љ–∞—П –њ–Њ —А–∞–Ј–Љ–µ—А—Г, –њ–Њ—В—А–µ–±–ї—П–µ—В —Б–ї–Є—И–Ї–Њ–Љ –Љ–љ–Њ–≥–Њ —Н–љ–µ—А–≥–Є–Є –Є –≤—Л–і–µ–ї—П–µ—В —Б—В–Њ–ї—М –ґ–µ –Љ–љ–Њ–≥–Њ —В–µ–њ–ї–∞, –і–∞ –µ—Й–µ –Є –Ї—Г–ї–µ—А —И—Г–Љ–Є—В –Њ—Й—Г—В–Є–Љ–Њ. –Я–Њ—Н—В–Њ–Љ—Г –≤ –љ–Є—Е –њ—А–Є—Е–Њ–і–Є–ї–Њ—Б—М –Њ–±—Е–Њ–і–Є—В—М—Б—П –Њ–і–љ–Њ—З–Є–њ–Њ–≤—Л–Љ–Є Geforce GTX 680.

–Ґ–µ–њ–µ—А—М –ґ–µ –≤ —В–∞–Ї–Є–µ —Б–Є—Б—В–µ–Љ—Л –Љ–Њ–ґ–љ–Њ —Г—Б—В–∞–љ–Њ–≤–Є—В—М –Є Geforce GTX Titan, –Њ–±–ї–∞–і–∞—О—Й–Є–є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М—О, –±–ї–Є–Ј–Ї–Њ–є –Ї Geforce GTX 690, –љ–Њ –Є–Љ–µ—О—Й–Є–є –Њ—Б—В–∞–ї—М–љ—Л–µ —Г–Ї–∞–Ј–∞–љ–љ—Л–µ –њ–∞—А–∞–Љ–µ—В—А—Л, –±–ї–Є–Ј–Ї–Є–µ –Ї GTX 680. –Ґ–∞–Ї–∞—П –≤–Є–і–µ–Њ–Ї–∞—А—В–∞ –≤–њ–Њ–ї–љ–µ –њ–Њ–Љ–µ—Й–∞–µ—В—Б—П –≤ SFF-—Б–Є—Б—В–µ–Љ—Л –Є –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В —А–Њ—Б—В –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б GTX 680, –Њ—Б—В–∞–≤–∞—П—Б—М –њ—А–Є —Н—В–Њ–Љ –і–∞–ґ–µ –љ–µ–Љ–љ–Њ–≥–Њ –±–Њ–ї–µ–µ —В–Є—Е–Њ–є!

–Ґ–µ—Б—В—Л –њ—А–Њ–≤–Њ–і–Є–ї–Є—Б—М –љ–∞ —Б–Є—Б—В–µ–Љ–µ —Б —Ж–µ–љ—В—А–∞–ї—М–љ—Л–Љ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–Љ Intel Core i7-3770K, —А–∞–±–Њ—В–∞—О—Й–Є–Љ –љ–∞ —З–∞—Б—В–Њ—В–µ 3,5 –У–У—Ж, –≤ —А–∞–Ј—А–µ—И–µ–љ–Є–Є 1920×1080, —Б –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Л–Љ–Є –љ–∞—Б—В—А–Њ–є–Ї–∞–Љ–Є –Є –≤–Ї–ї—О—З–µ–љ–љ—Л–Љ –њ–Њ–ї–љ–Њ—Н–Ї—А–∞–љ–љ—Л–Љ —Б–≥–ї–∞–ґ–Є–≤–∞–љ–Є–µ–Љ 4x MSAA. –Э–µ–Љ—Г–і—А–µ–љ–Њ, —З—В–Њ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї–Є –њ–Њ–і–Њ–±–љ—Л—Е —Б–Є—Б—В–µ–Љ –њ—А–Њ—Б—В–Њ –≤ –≤–Њ—Б—В–Њ—А–≥–µ –Њ—В —В–∞–Ї–Њ–є –Љ–Њ—Й–Є –≤ —Б—В–Њ–ї—М –Љ–∞–ї–Њ–Љ —А–∞–Ј–Љ–µ—А–µ –Є —Г–ґ–µ –љ–∞—Ж–µ–ї–Є–ї–Є—Б—М –љ–∞ –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ –љ–Њ–≤–Њ–є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л –≤ SFF-—Б–Є—Б—В–µ–Љ–∞—Е. –Ъ–Њ–Љ–њ–∞–Ї—В–љ—Л–µ –Є–≥—А–Њ–≤—Л–µ –Я–Ъ —Б—В–∞–ї–Є –µ—Й–µ –Љ–Њ—Й–љ–µ–µ.

–Ш—В–∞–Ї, Geforce GTX Titan вАФ —Н—В–Њ —Н–Ї—Б—В—А–µ–Љ–∞–ї—М–љ–∞—П –≤–Є–і–µ–Њ–Ї–∞—А—В–∞ –і–ї—П —В–µ—Е —Н–љ—В—Г–Ј–Є–∞—Б—В–Њ–≤ –Ї–Њ–Љ–њ—М—О—В–µ—А–љ—Л—Е –Є–≥—А –Є –ї—О–±–Є—В–µ–ї–µ–є —А–∞–Ј–≥–Њ–љ–∞, –Ї—В–Њ –љ–µ —Б—В–µ—Б–љ–µ–љ –≤ —Б—А–µ–і—Б—В–≤–∞—Е. –Я–µ—А–µ–і –і–≤—Г—Е—З–Є–њ–Њ–≤—Л–Љ–Є —А–µ—И–µ–љ–Є—П–Љ–Є –≤—А–Њ–і–µ GTX 690 —Г –љ–µ–µ –µ—Б—В—М –≤–∞–ґ–љ–Њ–µ –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–Њ –≤ —В–Њ–Љ, —З—В–Њ –љ–µ–Ї–Њ—В–Њ—А—Л–µ –Є–≥—А—Л –њ—А–µ–і–њ–Њ—З–Є—В–∞—О—В –Њ–і–љ–Њ—З–Є–њ–Њ–≤—Л–µ —А–µ—И–µ–љ–Є—П, –і–∞ –Є –≤ —Ж–µ–ї–Њ–Љ –Є–≥—А—Л —А–∞–±–Њ—В–∞—О—В –љ–∞ –Њ–і–љ–Њ–Љ GPU –ї—Г—З—И–µ, —З–µ–Љ –љ–∞ –і–≤—Г—Е –Є –±–Њ–ї–µ–µ (–њ—А–Њ–±–ї–µ–Љ—Л AFR-—А–µ–љ–і–µ—А–Є–љ–≥–∞ –Є –Є—Е –њ—А–Є—З–Є–љ—Л –Љ—Л –љ–µ —А–∞–Ј –љ–∞–Ј—Л–≤–∞–ї–Є –≤ —Б–≤–Њ–Є—Е –Љ–∞—В–µ—А–Є–∞–ї–∞—Е). –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, –Љ–Њ–ґ–љ–Њ —Г—Б—В–∞–љ–Њ–≤–Є—В—М —В—А–Є —И—В—Г–Ї–Є—Е —В–∞–Ї–Є—Е –Ї–∞—А—В, –Є —Н—В–Њ –±—Г–і–µ—В –Њ—З–µ–љ—М –±—Л—Б—В—А–∞—П —Б–Є—Б—В–µ–Љ–∞, –∞ –≤–Њ—В –і–≤—Г—Е—З–Є–њ–Њ–≤—Л—Е —В—А–Є вАФ —Г–ґ–µ –љ–µ –њ–Њ—Б—В–∞–≤–Є—В—М.

–Х—Б—В–µ—Б—В–≤–µ–љ–љ–Њ, —З—В–Њ Titan –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ—В –≤—Б–µ —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–µ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є –Ї–Њ–Љ–њ–∞–љ–Є–Є Nvidia, –Њ –Ї–Њ—В–Њ—А—Л—Е –Љ—Л —А–∞–љ–µ–µ –љ–µ–Њ–і–љ–Њ–Ї—А–∞—В–љ–Њ –њ–Є—Б–∞–ї–Є, –≤ —В–Њ–Љ —З–Є—Б–ї–µ Adaptive VSync –Є PhysX. –Ю–±–Њ –≤—Б–µ—Е —Н—В–Є—Е —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П—Е –њ–Њ–і—А–Њ–±–љ–Њ –љ–∞–њ–Є—Б–∞–љ–Њ –≤ –±–∞–Ј–Њ–≤–Њ–Љ –Њ–±–Ј–Њ—А–µ Geforce GTX 680 вАФ –њ–µ—А–≤–Њ–є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л —Б–µ–Љ–µ–є—Б—В–≤–∞ Kepler. –Ш —В–∞–Ї –Ї–∞–Ї Geforce GTX Titan –Є–Љ–µ–µ—В –≤ —Б–≤–Њ–µ–є –Њ—Б–љ–Њ–≤–µ —В–Њ–њ–Њ–≤—Л–є –≥—А–∞—Д–Є—З–µ—Б–Ї–Є–є –њ—А–Њ—Ж–µ—Б—Б–Њ—А GK110 –љ–∞ –Њ—Б–љ–Њ–≤–µ —Н—В–Њ–є –∞—А—Е–Є—В–µ–Ї—В—Г—А—Л, —В–Њ –љ–Њ–≤–∞—П –Љ–Њ–і–µ–ї—М –њ—А–µ–і–ї–∞–≥–∞–µ—В –≤—Б–µ —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –≤ –≤–Є–і–µ DirectX 11, PhysX, TXAA, –∞–і–∞–њ—В–Є–≤–љ–Њ–≥–Њ VSync –Є –і—А—Г–≥–Є—Е —В–µ—Е–љ–Њ–ї–Њ–≥–Є–є.

–°–ї–µ–і—Г—О—Й–∞—П —З–∞—Б—В—М –љ–∞—И–µ–є —Б—В–∞—В—М–Є –њ–Њ—Б–≤—П—Й–µ–љ–∞ –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Њ–є —З–∞—Б—В–Є –Є—Б—Б–ї–µ–і–Њ–≤–∞–љ–Є—П –≤ –њ—А–Є–≤—Л—З–љ–Њ–Љ –љ–∞–±–Њ—А–µ —Б–Є–љ—В–µ—В–Є—З–µ—Б–Ї–Є—Е —В–µ—Б—В–Њ–≤, –≤ –Ї–Њ—В–Њ—А—Л—Е –Љ—Л —Б—А–∞–≤–љ–Є–Љ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –љ–Њ–≤–Њ–є —В–Њ–њ–Њ–≤–Њ–є –≤–Є–і–µ–Њ–Ї–∞—А—В—Л –љ–∞ –±–∞–Ј–µ –Њ–і–љ–Њ–≥–Њ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–≥–Њ —З–Є–њ–∞ Geforce GTX Titan —Б–Њ —Б–Ї–Њ—А–Њ—Б—В—М—О –Њ—Б—В–∞–ї—М–љ—Л—Е —А–µ—И–µ–љ–Є–є –Ї–Њ–Љ–њ–∞–љ–Є–є Nvidia –Є AMD.