Особенности архитектуры

Совсем недавно компания Nvidia анонсировала новую графическую архитектуру Ada Lovelace, которая продолжила дело предыдущих поколений Turing и Ampere, обеспечив значительно более высокую производительность в графических и неграфических применениях, и особенно — при аппаратной трассировке лучей. Новые графические процессоры оказались в полтора-два раза производительнее предыдущих при растеризации и трассировке лучей, и обеспечивают даже еще большее преимущество с учетом технологии увеличения производительности DLSS 3.

Графические процессоры архитектуры Ada Lovelace поддерживают DLSS 3, которая отличается генерацией дополнительных кадров на основе существующих, для чего используется движок Optical Flow Accelerator, который занимается синтезом новых кадров. RT-ядра новой архитектуры обеспечивают вдвое большую производительность теста пересечения луча и треугольника, а также имеют и дополнительные аппаратные блоки: Opacity Micromap Engine — ускоряющий трассировку полупрозрачной геометрии до двух раз, и Displaced Micro-Mesh Engine — использующий микротреугольники для достижения большей геометрической сложности. Еще более важным изменением новой архитектуры, связанным с трассировкой лучей, является изменяемый порядок шейдерных вычислений — Shader Execution Reordering, который может дать до 40%-50% прироста производительности при интенсивной трассировке.

Создать сложные и большие GPU новой архитектуры с увеличенной производительностью при сохранившемся уровне потреблении энергии, позволил новый техпроцесс — модифицированный под потребности Nvidia процесс TSMC 4N с технологическими нормами 5 нм. Обзор топового GPU новой линейки у нас уже был, а сегодня мы рассмотрим средний из трех графических процессоров, анонсированных в октябре. Чип AD103 содержит 45,9 миллиарда транзисторов, а основанная на нем видеокарта GeForce RTX 4080 имеет пиковую вычислительную производительность до 49 терафлопс, что значительно превышает возможности GeForce RTX 3080 Ti в 34 терафлопса, а если учесть все технологии семейства Ada Lovelace, направленные на повышение эффективности GPU, то эта разница в некоторых случаях может достичь и двукратной.

Итак, Nvidia заявляет, что GeForce RTX 4080 до двух раз производительнее, чем GeForce 3080 Ti — при той же рекомендованной цене на старте продаж и при меньшем на 10% энергопотреблении. А вместе с технологией DLSS 3, новая модель может отрисовать до трех раз большее количество кадров в секунду, по сравнению с все той же RTX 3080 Ti — например, в таких вычислительно тяжелых случаях с применением трассировки лучей, как демонстрационная программа Racer RTX и игра Cyberpunk 2077 в специальном режиме RT: Overdrive, появление которого ожидается в ноябре-декабре.

Новая модель видеокарты также отлично подходит для применения в профессиональных задачах по созданию цифрового контента — она высокопроизводительная, имеет достаточно большой объем видеопамяти для рендеринга больших 3D-сцен и работы с видеороликами высокого разрешения, а также позволит комфортно работать в нескольких таких приложениях одновременно. В общем, GeForce RTX 4080 предназначена для обеспеченных игроков и профессионалов, которые хотят получить близкую к максимальной производительности при меньшей цене, по сравнению с топовой моделью линейки. Она предназначена исключительно для 4K-разрешения и максимальных графических настроек.

Так как графическая архитектура Ada Lovelace во многом схожа с архитектурой Ampere, на которой основаны различные модификации чипов GA10x, обе эти архитектуры имеют достаточно много общего и с предыдущими архитектурами Turing и Volta, то перед прочтением материала будет полезно ознакомиться с нашими предыдущими статьями по теме:

- [26.10.22] Обзор видеоускорителя Nvidia GeForce RTX 4090 (24 ГБ)

- [10.10.22] Теоретический обзор Nvidia GeForce RTX 4090 и RTX 4080

- [30.09.20] Nvidia GeForce RTX 3090: самое производительное, но не чисто игровое решение

- [16.09.20] Nvidia GeForce RTX 3080, часть 1: теория, архитектура, синтетические тесты

- [19.09.18] Nvidia GeForce RTX 2080 Ti — обзор флагмана 3D-графики 2018 года

- [14.09.18] Игровые видеокарты Nvidia GeForce RTX — первые мысли и впечатления

| Графический ускоритель GeForce RTX 4080 | |

|---|---|

| Кодовое имя чипа | AD103 |

| Технология производства | 5 нм (TSMC 4N) |

| Количество транзисторов | 45,9 млрд |

| Площадь ядра | 378,6 мм² |

| Архитектура | унифицированная, с массивом процессоров для потоковой обработки любых видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12 Ultimate, с поддержкой уровня возможностей Feature Level 12_2 |

| Шина памяти | 256-битная: 8 независимых 32-битных контроллеров памяти с поддержкой памяти типа GDDR6X |

| Частота графического процессора | до 2510 МГц |

| Вычислительные блоки | 76 (из 80 в полном чипе) потоковых мультипроцессоров, включающих 9728 (из 10240) CUDA-ядра для целочисленных расчетов INT32 и вычислений с плавающей запятой FP16/FP32/FP64 |

| Тензорные блоки | 304 (из 320) тензорных ядра для матричных вычислений INT4/INT8/FP16/FP32/BF16/TF32 |

| Блоки трассировки лучей | 76 (из 80) RT-ядер для расчета пересечения лучей с треугольниками и ограничивающими объемами BVH |

| Блоки текстурирования | 304 (из 320) блока текстурной адресации и фильтрации с поддержкой FP16/FP32-компонент и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 14 широких блоков ROP на 112 пикселей с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра |

| Поддержка мониторов | поддержка HDMI 2.1 и DisplayPort 1.4a (со сжатием DSC 1.2a) |

| Спецификации референсной видеокарты GeForce RTX 4080 | |

|---|---|

| Частота ядра | 2210/2510 МГц |

| Количество универсальных процессоров | 9728 |

| Количество текстурных блоков | 304 |

| Количество блоков блендинга | 112 |

| Эффективная частота памяти | 22,4 ГГц |

| Тип памяти | GDDR6X |

| Шина памяти | 256-бит |

| Объем памяти | 16 ГБ |

| Пропускная способность памяти | 717 ГБ/с |

| Вычислительная производительность (FP32) | до 48,7 терафлопс |

| Теоретическая максимальная скорость закраски | 281 гигапикселей/с |

| Теоретическая скорость выборки текстур | 762 гигатекселей/с |

| Шина | PCI Express 4.0 x16 |

| Разъемы | по выбору производителя |

| Энергопотребление | до 320 Вт |

| Дополнительное питание | один 16-контактный разъем |

| Число слотов, занимаемых в системном корпусе | по выбору производителя |

| Рекомендуемая цена | $1199 |

Название рассматриваемой сегодня модели видеокарты из нового семейства соответствует принципу наименования решений компании — изменилась лишь первая цифра поколения. GeForce RTX 4080 стоит на шаг ниже топовой модели, рассмотренной нами ранее. Из интересного — в Nvidia за октябрь догадались, что называть одинаково две абсолютно разные видеокарты RTX 4080 с 16 ГБ и 12 ГБ было плохой идеей, и выход второго варианта, основанного на чипе AD104, отменили. По слухам, он выйдет в виде модели RTX 4070 Ti в январе, и это будет уже куда более корректным названием для видеокарты с такими характеристиками.

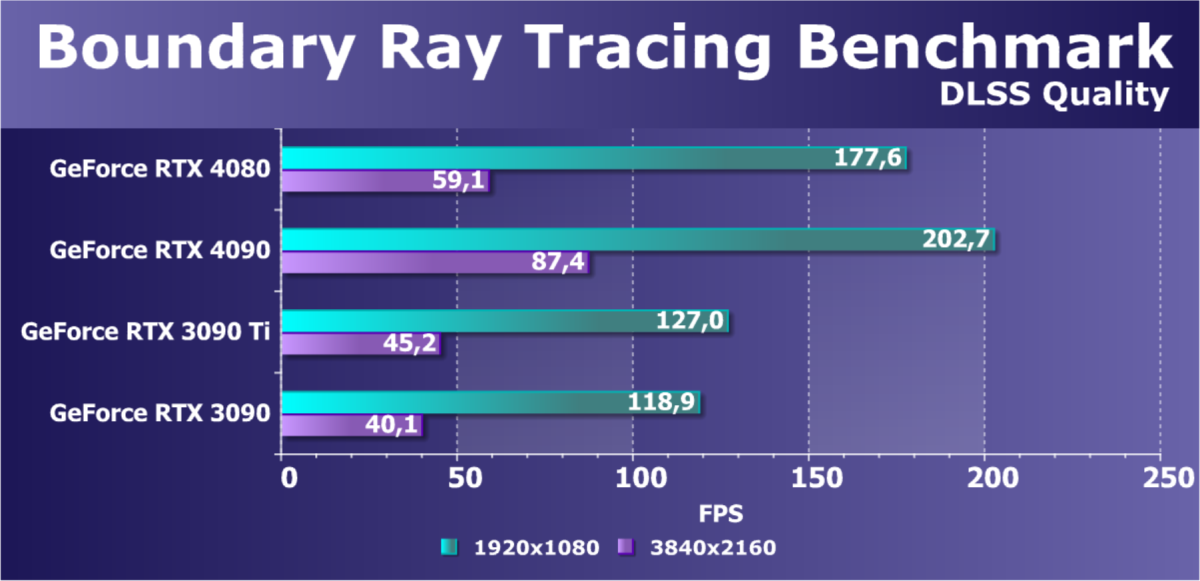

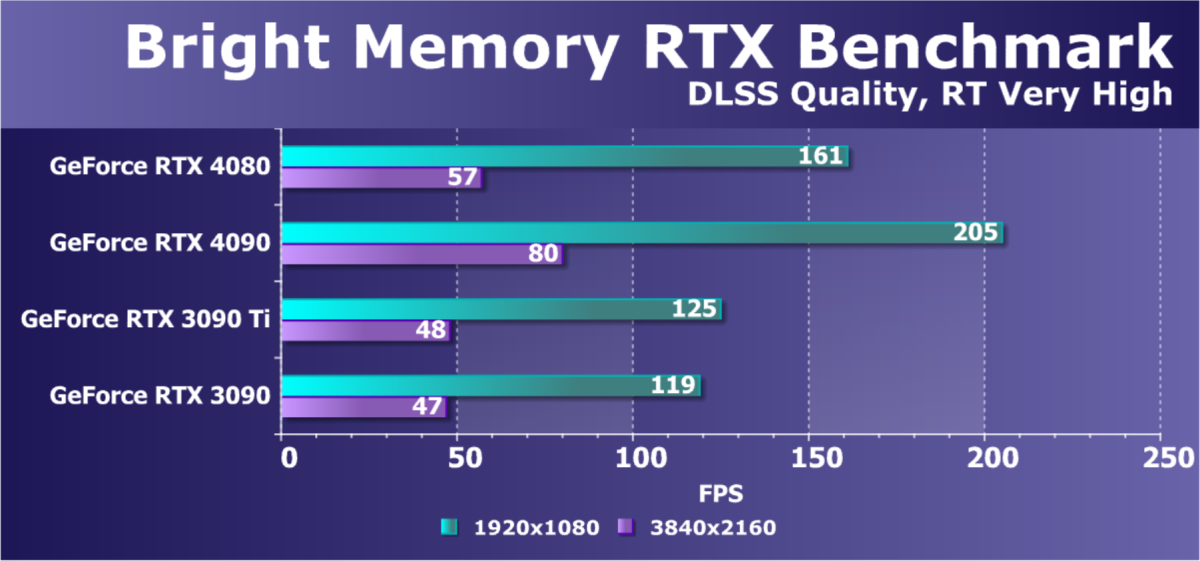

На рынке видеокарт у RTX 4080 пока что нет конкуренции, но решения нового семейства AMD уже объявлены и ожидаются в продаже с середины декабря. Конкурент привычно будет брать несколько меньшей ценой и ее сочетанием с близким уровнем производительности, но... только в растеризации, скорее всего. При первой же возможности мы протестируем все новинки и в трассировке лучей, но даже по данным самой AMD, их новое поколение по эффективности аппаратной трассировки догоняет разве что Ampere, но не Ada. А ведь именно производительность трассировки лучей становится важнейшей для новых графических процессоров, так как скорости растеризации для топовых GPU уже давно достаточно, чтобы обеспечить сотни кадров в секунду, а вот с трассировкой достичь 60 FPS получается не всегда.

С объемом видеопамяти новой видеокарты Nvidia всё сделала верно и в соответствии с шириной шины памяти — 16 ГБ для RTX 4080 кажутся попаданием в золотую середину на данный момент. Вряд ли наличие 20-24 ГБ видеопамяти против 16 ГБ принесет преимущество конкуренту новинки в виде Radeon RX 79xx — по крайней мере, в существующих играх, хотя как некоторый запас прочности на будущие проекты это превосходство рассматривать можно. В любом случае, пока что 16 ГБ памяти будет вполне достаточно при любых графических настройках.

Как и RTX 4090, модель RTX 4080 предлагается и в варианте самой Nvidia — в виде решений специального издания Founders Edition. Для подобных видеокарт прошлого поколения, в частности моделей GeForce RTX 3090 и RTX 3080, инженеры компании Nvidia придумали специальный дизайн со сквозной продувкой радиатора в задней части, и системы охлаждения GeForce RTX 4090 и 4080 выглядят схоже с дизайном того кулера, но он был дополнительно улучшен для повышения эффективности системы охлаждения. Для увеличения потока воздуха в FE-модели семейства Ada Lovelace были установлены вентиляторы большего размера, также они получили более качественные подшипники. В результате, система охлаждения Founders Edition вариантов RTX 4090 и RTX 4080 при том же уровне шума обеспечивает воздушный поток на 15% больше, по сравнению с RTX 3090.

Понятно, что для питания новых карт используется новый 16-контактный разъем питания PCIe 5.0, который мы видели на GeForce RTX 3090 Ti, ставший стандартом для ATX 3.0. Блоки питания с подобным разъемом уже представлены на рынке, ну или можно обойтись переходником с трех или четырех привычных 8-контактных разъемов. Правда, в последнее время у некоторых пользователей RTX 4090 возникли проблемы с оплавлением новых разъемов, и до сих пор не полностью понятно, что является главной причиной этих проблем, качество переходников или излишний изгиб кабелей. Понятно одно — у нового разъема слишком мал запас прочности, и даже небольшие проблемы с надежностью контактов могут привести к оплавлению разъема. Впрочем, конкретно RTX 4080 это касается в меньшей мере, так как уровень энергопотребления для нее установлен в 320 Вт, и проблем с ней быть не должно.

Партнеры компании Nvidia, производящие видеокарты, анонсировали и выпустили на рынок по несколько решений собственного дизайна, включая разогнанные варианты, имеющие весьма массивные системы охлаждения. Модели GeForce RTX 4080 уже доступны в разных модификациях у партнеров компании: Asus, Colorful, Gainward, Galaxy, Gigabyte, Innovision 3D, MSI, Palit, PNY и Zotac. Кроме этого, на этих видеокартах будут основаны и готовые игровые системы компаний Acer, Alienware, Asus, Dell, HP, Lenovo и MSI.

В линейке видеокарт GeForce RTX 40 применяются графические процессоры AD10x, основанные на графической архитектуре Ada Lovelace. Инженеры компании Nvidia создали графическую архитектуру, которая не только кратно повысила производительность операций трассировки лучей и машинного вычисления на тензорных ядрах, но и предоставила некоторые новые возможности, позволяющие еще больше повысить качество и производительность, в чем помог переход на продвинутый технологический процесс 4N тайваньской компании TSMC, который позволил поместить в AD10x большое количество CUDA-ядер и других исполнительных блоков. Новые чипы получились более сложными, но при этом они работают на высокой тактовой частоте — турбо-частота новинок заметно выше, чем у предыдущих решений.

Графический процессор AD103 включает в себя все возможности и особенности AD102 из топового решения, включая RT-ядра третьего поколения и тензорные ядра четвертого — то есть, поддерживает все улучшения трассировки лучей, а также DLSS 3 и новый ускоритель оптического потока OFA. Чип AD103 в составе модели видеокарты GeForce RTX 4080 обеспечивает высокий уровень производительности — более чем у флагманского решения на чипе GA102 предыдущего поколения, и при гораздо меньшем энергопотреблении.

Как и все графические процессоры компании Nvidia, чип состоит из укрупненных кластеров Graphics Processing Cluster (GPC), которые включают несколько кластеров текстурной обработки Texture Processing Cluster (TPC), содержащих потоковые процессоры Streaming Multiprocessor (SM), блоки растеризации ROP и контроллеры памяти. Как и в предыдущих архитектурах, кластер GPC самостоятельно производит все основные вычисления внутри кластера, и включает свой движок растеризации Raster Engine, шесть кластеров TPC, состоящих из 12 мультипроцессоров SM. Рассмотрим диаграмму графического процессора — в его урезанной конфигурации для GeForce RTX 4080:

Чип AD103 содержит 45,9 миллиардов транзисторов и полная его версия включает 7 вычислительных кластеров GPC, 40 кластеров текстурной обработки TPC, 80 потоковых мультипроцессоров SM и восемь 32-битных контроллеров памяти (256-бит всего). В целом, полноценный GPU содержит 10240 CUDA-ядра, 80 RT-ядер, 320 тензорных ядер, 320 текстурных блока TMU и 112 блоков ROP. Подсистема памяти включает 10240 КБ L1-кэша, 20480 КБ регистрового файла и 64 МБ L2-кэша.

На основе графического процессора AD103 выпущена модель видеокарты GeForce RTX 4080, имеющая GPU с парой отключенных кластеров TPC и четыре неактивных SM в одном из кластеров GPC. Соответственно снижено и количество большинства исполнительных блоков: осталось активными 9728 CUDA-ядер, 304 блока TMU и столько же тензорных ядер, 76 RT-ядер. А вот подсистему памяти не урезали — все контроллеры активны, что дает чипу 256-битную шину памяти. То же самое и с блоками ROP, их тут тоже 112 штук, как и в полном чипе. Количество блоков растеризации возросло по сравнению с аналогами из семейства Ampere, что должно сказаться при упоре в скорость растеризации, что иногда встречается в играх.

Каждый мультипроцессор в чипах AD10x содержит по 128 CUDA-ядер, по одному RT-ядру третьего поколения, по четыре тензорных ядра четвертого поколения, по четыре текстурных блока TMU, регистровый файл на 256 КБ и 128 КБ L1-кэша или разделяемой памяти, объем которых конфигурируется по необходимости. Всего RTX 4080 содержит 9728 КБ кэш-памяти первого уровня, по сравнению с 10752 КБ в топовой версии прошлого поколения — RTX 3090 Ti.

Память в GeForce RTX 4080 применяется уже знакомая нам GDDR6X, но в случае новой модели ее эффективная рабочая частота составляет рекордные 22,4 ГГц — и общая пропускная способность памяти в случае GeForce RTX 4080 равна 717 ГБ/с, что не так мало, но все же меньше, чем у тех же RTX 3090 и 3090 Ti из предыдущего поколения. Это один из потенциальных недостатков новой видеокарты — в каких-то случаях ее производительность может упереться в ПСП. Общий объем видеопамяти составляет 16 ГБ, и этого вполне достаточно для решения такого уровня.

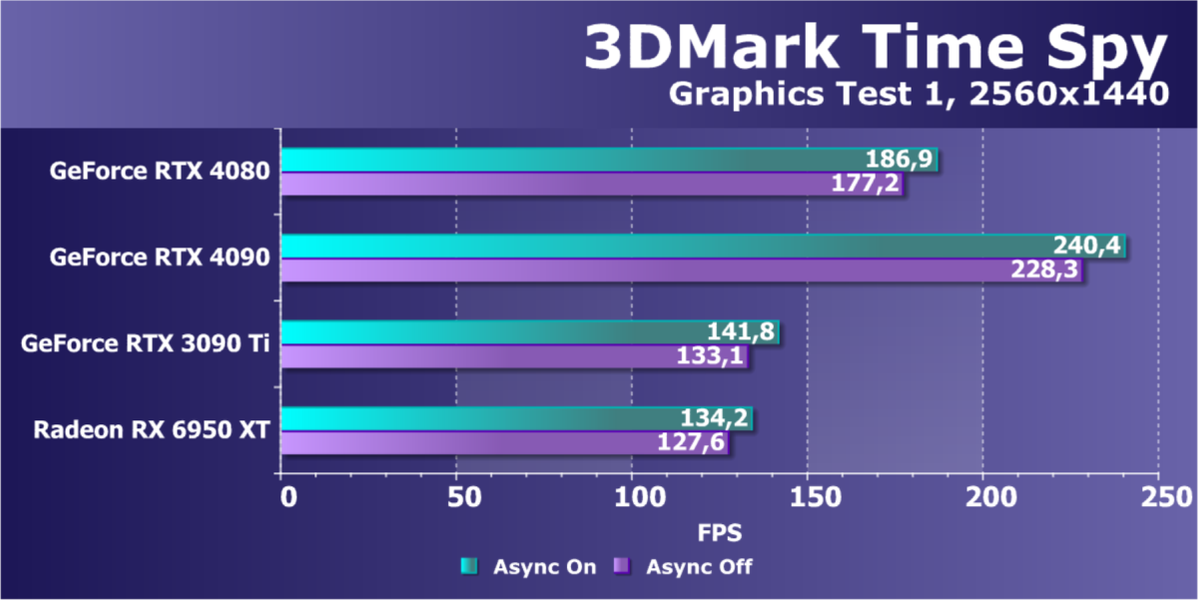

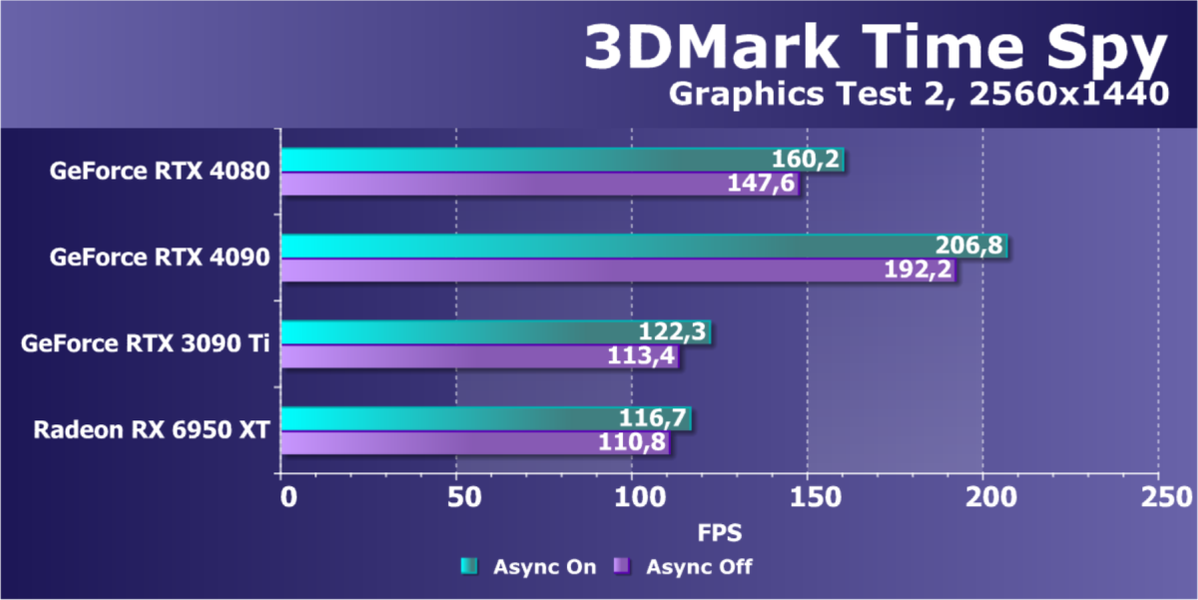

Как и в топовом чипе, значительно вырос объем кэш-памяти второго уровня — тут его 64 МБ, в отличие от лишь 6 МБ в RTX 3080 Ti, например. Многие приложения получают преимущество от столь объемной кэш-памяти — в частности, большой объем L2-кэша положительно сказывается в сложных вычислительных задачах, при аппаратной трассировке лучей, да и при растеризации — особенно в играх и тестах с большим количество полупрозрачных частиц, вроде бенчмарка FireStrike из пакета 3DMark.

Сравним теоретические показатели двух уже выпущенных моделей видеокарт серии GeForce RTX 40, основанных на разных чипах AD10x, с некоторыми моделями предыдущей линейки Ampere, что позволит наглядно оценить разницу между ними.

| RTX 4090 | RTX 4080 | RTX 3090 Ti | RTX 3080 Ti | |

|---|---|---|---|---|

| CUDA-ядра | 16384 | 9728 | 10752 | 10240 |

| Тензорные ядра | 512 | 304 | 336 | 320 |

| RT-ядра | 128 | 76 | 84 | 80 |

| Базовая частота, ГГц | 2,23 | 2,21 | 1,56 | 1,37 |

| Турбо-частота, ГГц | 2,52 | 2,51 | 1,86 | 1,67 |

| Объем памяти, ГБ | 24 | 16 | 24 | 12 |

| Шина памяти, бит | 384 | 256 | 384 | 384 |

| ПСП, ГБ/с | 1008 | 717 | 1008 | 912 |

| Потребление, Вт | 450 | 320 | 450 | 350 |

Мы уже отмечали выше очень большую разницу между RTX 4090 и RTX 4080 по количеству исполнительных блоков и по энергопотреблению. Если RTX 4090 — бескомпромиссная топовая модель, то RTX 4080 уже более приземленный вариант, подходящий для большего количества пользователей. При теоретической производительности выше, чем у RTX 3090 Ti, она имеет заметно меньшее потребление энергии — спасибо за это 5 нм техпроцессу TSMC. Также хорошо заметны и сильно повысившиеся рабочие частоты GPU по сравнению с Ampere, это также связано с улучшением техпроцесса.

А вот что почти не изменилось, так это пропускная способность видеопамяти. Даже у RTX 4090 она осталась на уровне RTX 3090 Ti, не говоря уже о ПСП у рассматриваемой сегодня RTX 4080. 717 ГБ/с не выглядят впечатляющими на фоне 912-1008 ГБ/с у видеокарт предыдущей серии. Впрочем, мы уже говорили о серьезно увеличившемся объеме L2-кэша, который во многих случаях позволяет нивелировать недостаток ПСП. Так что в большинстве реальных применений RTX 4080 должна быть явно производительнее RTX 3090 Ti, и уж точно энергоэффективнее ее как минимум вдвое.

Все архитектурные улучшения семейства Ada Lovelace были разобраны нами в теоретическом обзоре, там подробно описаны все изменения в RT-ядрах новой архитектуры, включая аппаратные блоки Opacity Micromap Engine и Displaced Micro-Mesh Engine, а также дополнительный планировщик для изменения порядка выполнения шейдеров Shader Execution Reordering, позволяющие повысить эффективность аппаратной трассировки лучей.

С теоретической точки зрения там же подробно расписана и работа технологии DLSS 3, которая стала не просто технологией масштабирования разрешения, как DLSS 3, но приобрела возможность вставки дополнительных кадров на основе информации из существующих, что увеличивает их частоту и плавность видеоряда в итоге.

Технология DLSS 3 состоит из трех частей: генерация кадров Frame Generation, увеличение разрешения Super Resolution (то, что мы знаем под именем DLSS 2) и технология снижения задержек Reflex. Видеокарты серии RTX 40 поддерживают все три, а предыдущие модели — две, за исключением генерации кадров, и DLSS будет работать на всех GPU, просто с разными возможностями. Технология увеличения разрешения Super Resolution не брошена и будет дальше улучшаться — Nvidia планирует продолжать тренировать нейросеть для достижения более качественных результатов.

Для поддержки DLSS 3 разработчикам игр не нужно делать практически ничего сверх того, что они уже делали для поддержки DLSS 2. Неудивительно, что DLSS 3 уже получила поддержку большого количества игровых разработчиков и игровых движков — более 35 игр анонсировали такую поддержку. Те игровые разработчики, которые внедрили DLSS 2 с помощью Nvidia Streamline SDK, уже сделали все необходимое для интеграции технологии DLSS 3 и всех трех ее компонент: AI Super Resolution, AI Frame Generation и Reflex. Nvidia Streamline — это SDK с открытым кодом, упрощающий интеграцию технологий вроде DLSS и других аналогичных (любых производителей GPU). Этот пакет позволяет игровым разработчикам внедрить технологии повышения разрешения и качества картинки, поддерживаемые аппаратным обеспечением.

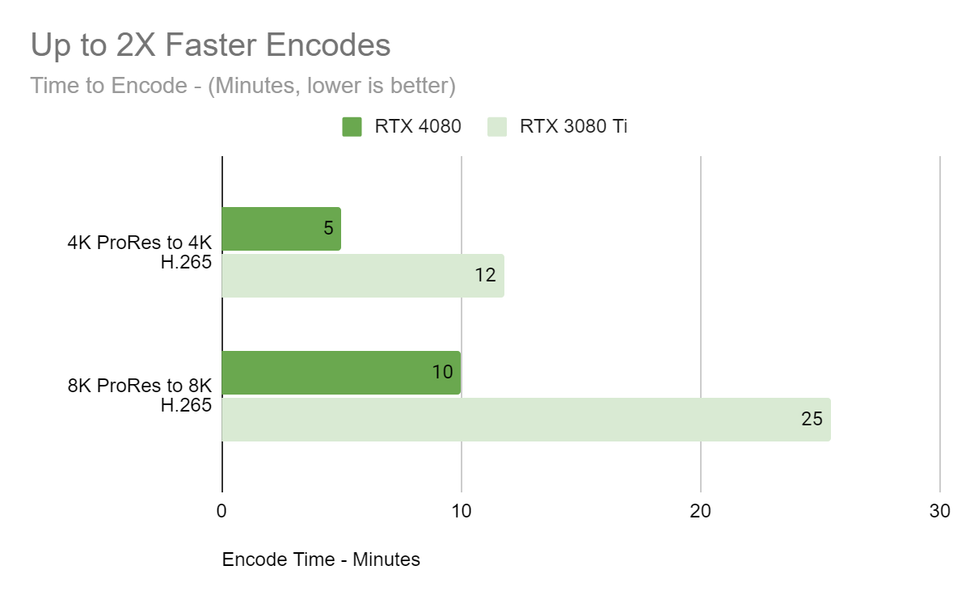

Возможности GeForce RTX 4080 по работе с видеоданными не отличаются от таковых у топовой модели. Графические процессоры нового семейства умеют больше предыдущих — в специализированном аппаратном кодировщике NVEnc восьмого поколения появилась поддержка кодирования видео в формате AV1, кодировщик AV1 в Ada на 40%-50% эффективнее кодировщика H.264, используемого в графических процессорах предыдущей серии, и новый формат AV1 позволит увеличить разрешение видеопотока при стриминге с 1080p до 1440p при том же битрейте. Кроме этого, представленные графические процессоры Ada имеют по два аппаратных кодировщика NVEnc на борту, что позволяет кодировать видео с разрешением 8K при 60 FPS или сразу четыре видео разрешения 4K при 60 FPS — и гораздо быстрее, чем RTX 3080 Ti, к примеру.

Кроме NVEnc, в графические процессоры архитектуры Ada включен аппаратный декодер пятого поколения NVDec, который появился в Ampere. Он поддерживает декодирование видеоданных с аппаратным ускорением в форматах: MPEG-2, VC-1, H.264 (AVCHD), H.265 (HEVC), VP8, VP9 и AV1. Также полностью поддерживается и декодирование в разрешении 8K при 60 FPS. А теперь перейдем к рассмотрению практических возможностей видеокарты GeForce RTX 4080 в исполнении компании Palit.

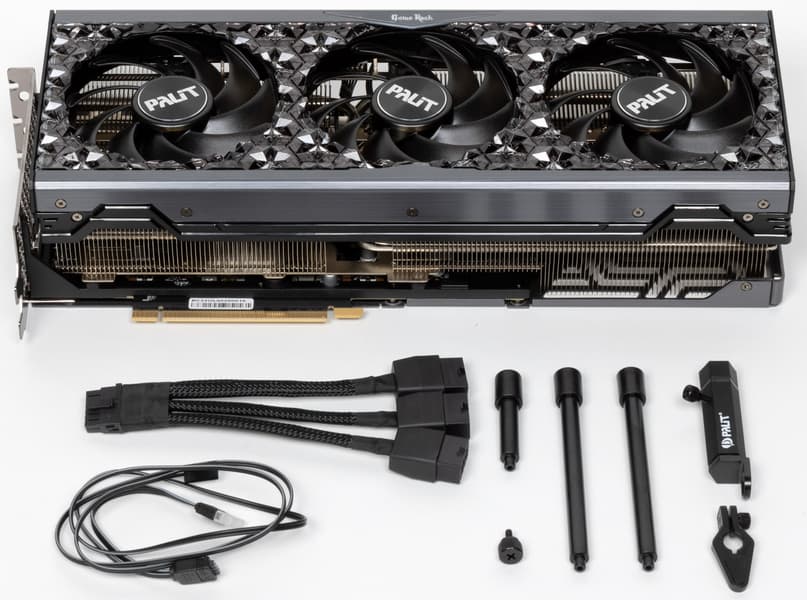

Особенности карты Palit GeForce RTX 4080 GameRock 16 ГБ

Сведения о производителе: Компания Palit Microsystems (торговая марка Palit) основана в 1988 году в Китайской Республике (Тайвань). Штаб-квартира — в Тайбэе/Тайвань, крупный центр по логистике — в Гонконге, второй офис (по продажам в Европе) — в Германии. Фабрики — в Китае. На рынке в России — с 1995 года (начинались продажи как безымянных продуктов, так называемых Noname, а под маркой Palit продукты начали идти только после 2000 года). В 2005 году компания приобрела торговую марку и ряд активов Gainward (после, по сути, банкротства одноименной компании), после чего был образован холдинг Palit Group. Был открыт еще один офис в Шеньжене, направленный на продажи в Китае. На сегодня внутри Palit Group сосредоточено еще несколько торговых марок и брендов.

Объект исследования: серийно выпускаемый ускоритель трехмерной графики (видеокарта) Palit GeForce RTX 4080 GameRock 16 ГБ 256-битной GDDR6X

| Palit GeForce RTX 4080 GameRock 16 ГБ 256-битной GDDR6X | ||

|---|---|---|

| Параметр | Значение | Номинальное значение (референс) |

| GPU | GeForce RTX 4080 (AD103) | |

| Интерфейс | PCI Express x16 4.0 | |

| Частота работы GPU (ROPs), МГц | BIOS P: 2505(Boost)—2850(Max) BIOS S: 2505(Boost)—2850(Max) | 2505(Boost)—2725(Max) |

| Частота работы памяти (физическая (эффективная)), МГц | 2800 (22400) | 2800 (22400) |

| Ширина шины обмена с памятью, бит | 256 | |

| Число вычислительных блоков в GPU | 76 | |

| Число операций (ALU/CUDA) в блоке | 128 | |

| Суммарное количество блоков ALU/CUDA | 9728 | |

| Число блоков текстурирования (BLF/TLF/ANIS) | 304 | |

| Число блоков растеризации (ROP) | 112 | |

| Число блоков Ray Tracing | 76 | |

| Число тензорных блоков | 304 | |

| Размеры, мм | 330×138×72 | 310×130×70 |

| Количество слотов в системном блоке, занимаемые видеокартой | 4 | 4 |

| Цвет текстолита | черный | черный |

| Энергопотребление пиковое в 3D, Вт (BIOS P/BIOS S) | 350/351 | 350 |

| Энергопотребление в режиме 2D, Вт | 40 | 40 |

| Энергопотребление в режиме «сна», Вт | 11 | 11 |

| Уровень шума в 3D (максимальная нагрузка), дБА (BIOS P/BIOS S) | 29,4/28,3 | 32,0 |

| Уровень шума в 2D (просмотр видео), дБА | 18,0 | 18,0 |

| Уровень шума в 2D (в простое), дБА | 18,0 | 18,0 |

| Видеовыходы | 1×HDMI 2.1, 3×DisplayPort 1.4a | 1×HDMI 2.1, 3×DisplayPort 1.4a |

| Поддержка многопроцессорной работы | нет | |

| Максимальное количество приемников/мониторов для одновременного вывода изображения | 4 | 4 |

| Питание: 8-контактные разъемы | 0 | 0 |

| Питание: 6-контактные разъемы | 0 | 0 |

| Питание: 16-контактные разъемы | 1 | 1 |

| Вес карты с комплектом поставки (брутто), кг | 2,6 | 3,0 |

| Вес карты чистый (нетто), кг | 2,0 | 2,2 |

| Максимальное разрешение/частота, DisplayPort | 3840×2160@144 Гц, 7680×4320@60 Гц | |

| Максимальное разрешение/частота, HDMI | 3840×2160@144 Гц, 7680×4320@60 Гц | |

| Средняя цена карты Palit | единичные предложения в районе 115-125 тысяч рублей на момент подготовки обзора | |

Память

Карта имеет 16 ГБ памяти GDDR6X SDRAM, размещенной в 8 микросхемах по 16 Гбит на лицевой стороне PCB. Микросхемы памяти Micron (GDDR6X, MT61K512M32KPA-24 / D8BZF) рассчитаны на номинальную частоту работы в 3000 (24000) МГц.

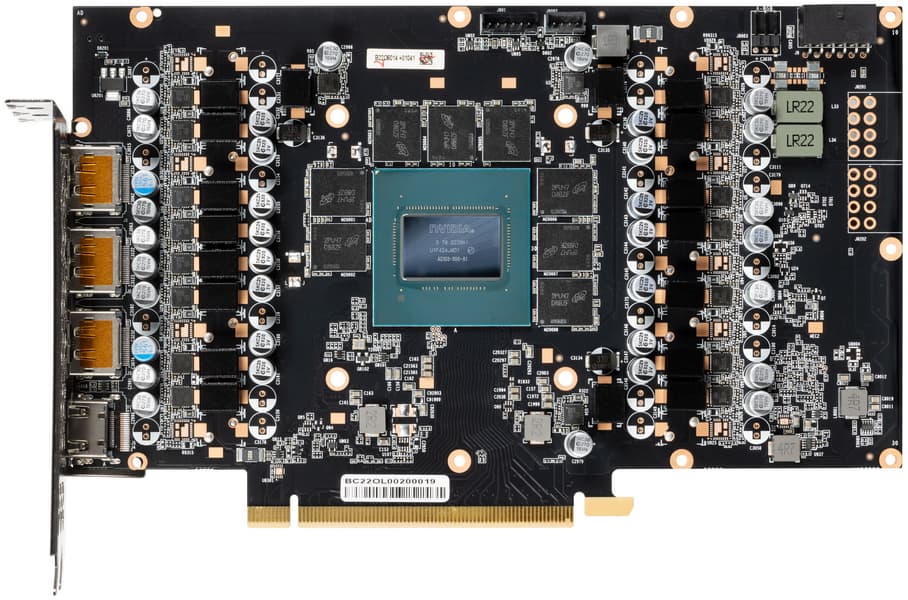

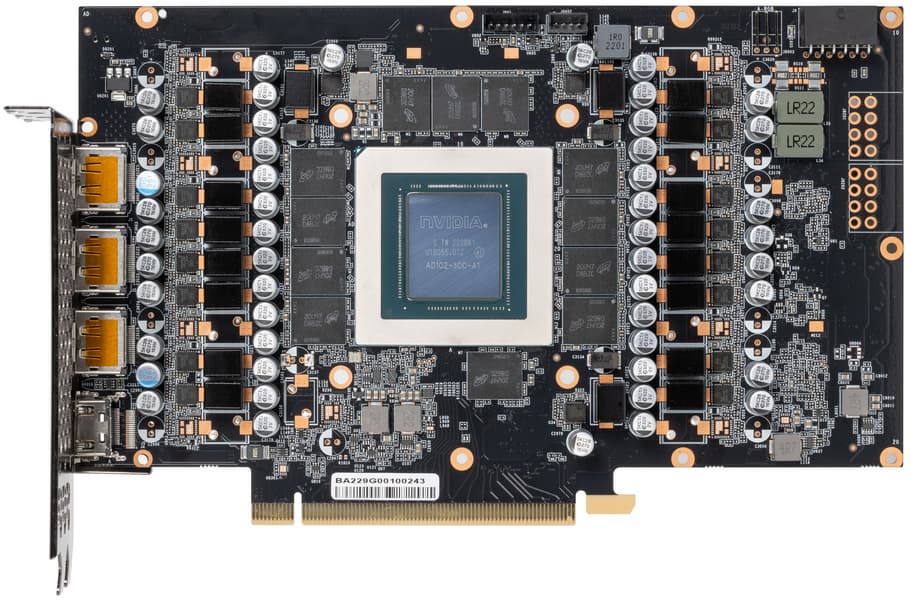

Особенности карты и сравнение с Palit GeForce RTX 4090 GameRock

| Palit GeForce RTX 4080 GameRock (16 ГБ) | Palit GeForce RTX 4090 GameRock (24 ГБ) |

|---|---|

| вид спереди | |

|  |

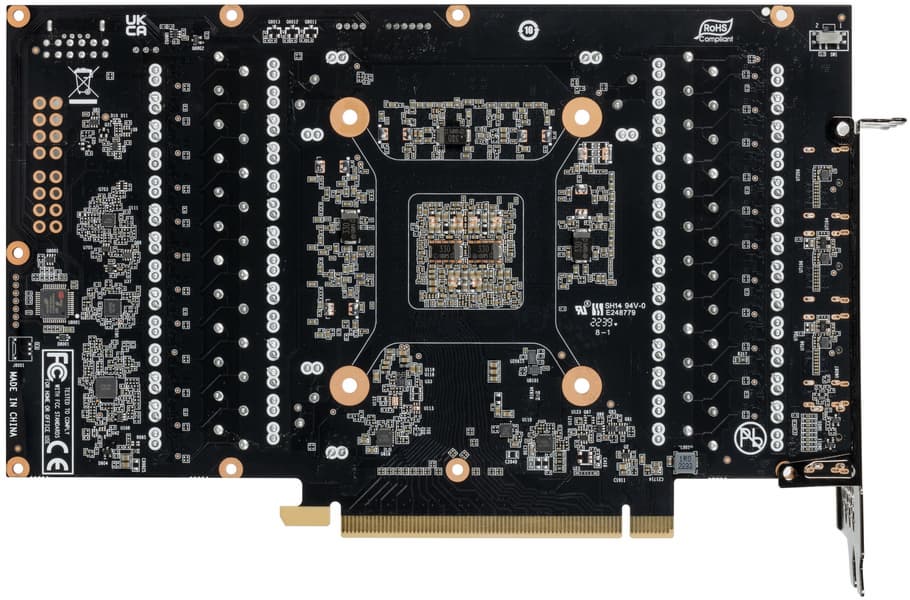

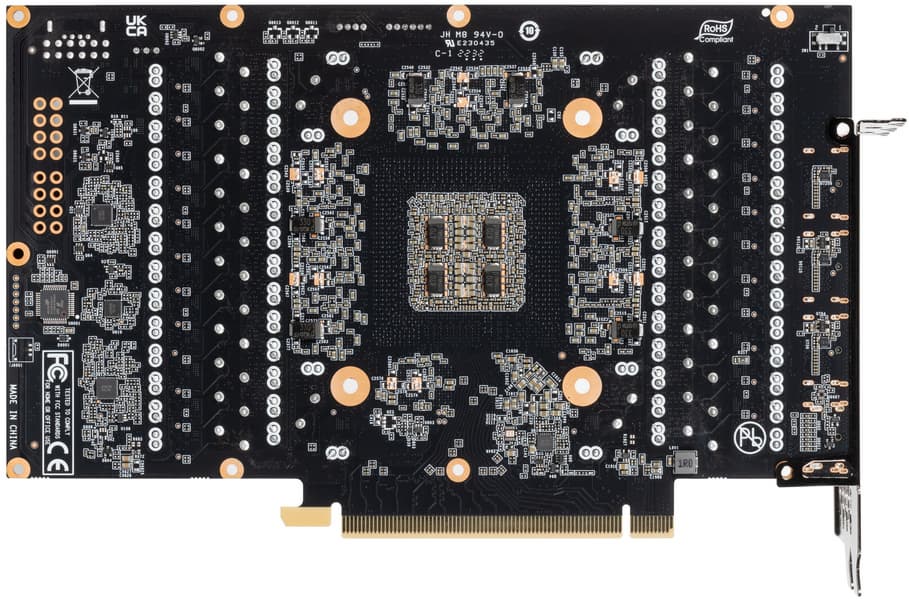

| вид сзади | |

|  |

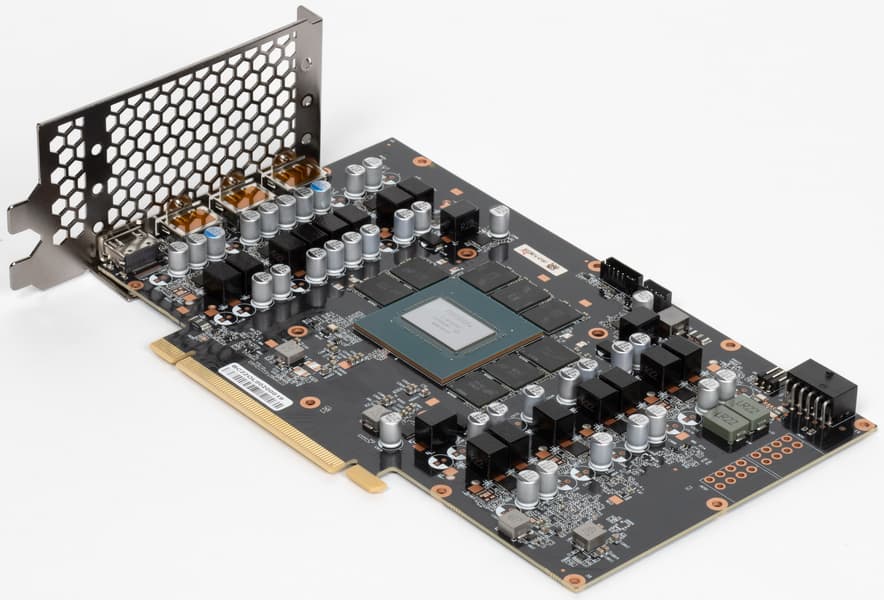

Мы сравниваем карту Palit с ее же продуктом на базе RTX 4090 по двум причинам: во-первых, эталонной карты Nvidia на базе RTX 4080 (16 ГБ) никто из медиасообщества в РФ не получал; во-вторых, интересно сравнить рассматриваемую сейчас карту со «старшей сестрой». В целом мы видим, что общего много, схема питания почти одинаковая. Однако GPU у данных плат разные, они отличаются по размерам не только кристаллов, но и их упаковки, поэтому использовать одну и ту же PCB все-таки не представляется возможным — иначе можно было бы просто убрать с карты RTX 4090 четыре микросхемы памяти, получив тем самым и объем 16 ГБ, и 256-битную шину обмена с памятью. В случае поколения RTX 30 часто делалось именно так, когда карты, имеющие в качестве GPU один и тот же физический чип, использовали разводку PCB под максимальную ширину шины, комплектуя карты разным количеством микросхем памяти. Печатная же плата под RTX 4080 имеет максимальную ширину шины 256 бит.

Сбоку справа мы видим посадочные места, похожие на те, куда устанавливаются 8-контактные разъемы питания. На самом деле они предназначены для подключения мощных внешних вентиляторов в системах, использующих профессиональные версии подобных видеокарт (для игровых и профессиональных видеокарт используются одни и те же GPU, разница может быть лишь в объеме памяти, конфигурации рабочих блоков и, конечно же, в программном обеспечении).

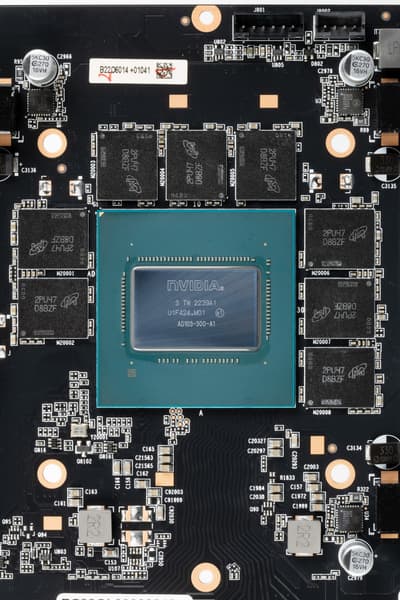

Ядро имеет маркировку AD103-300, защиты от майнинга нет, дата выпуска — 39-я неделя этого года (сентябрь).

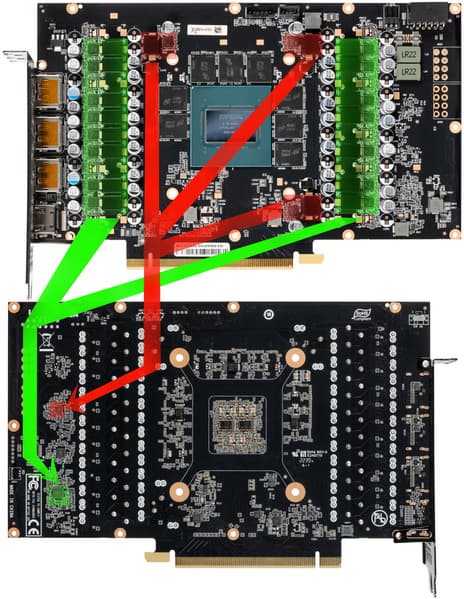

Суммарное количество фаз питания у карты Palit GeForce RTX 4080 GameRock (16 ГБ) — 18, а у ее аналога на 4090 — 19.

При этом распределение фаз такое: у Palit GeForce RTX 4090 GameRock — 16 фаз на ядро и 3 на микросхемы памяти, у карты Palit GeForce RTX 4080 GameRock (16 ГБ) — 15 + 3.

Зеленым цветом отмечена схема питания ядра, красным — памяти. Все контроллеры расположены на оборотной стороне PCB. Фазами питания ядра управляет ШИМ-контроллер uP9512R (максимум 8—12 фаз в зависимости от модификации).

Очевидно, что 16 фаз питания ядра работают по параллельной схеме (контроллер управляет двумя фазами как одной).

Трехфазной схемой питания микросхем памяти заведует другой ШИМ-контроллер той же компании uPI Semi — uP9529Q (до 3 фаз).

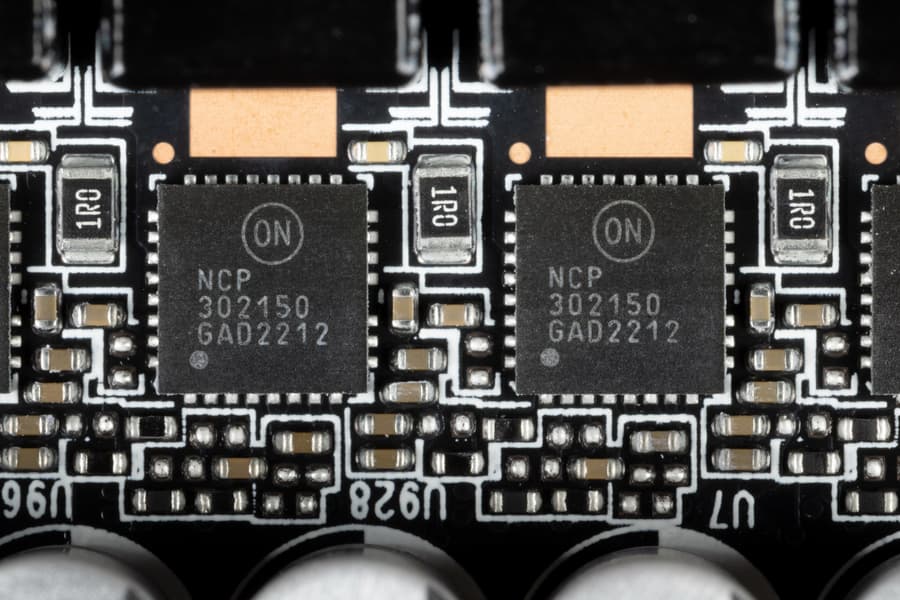

В преобразователе питания, традиционно для всех видеокарт Nvidia, используются транзисторные сборки DrMOS — в данном случае NCP302150 (On Semiconductor), каждая из которых рассчитана максимально на 50 А.

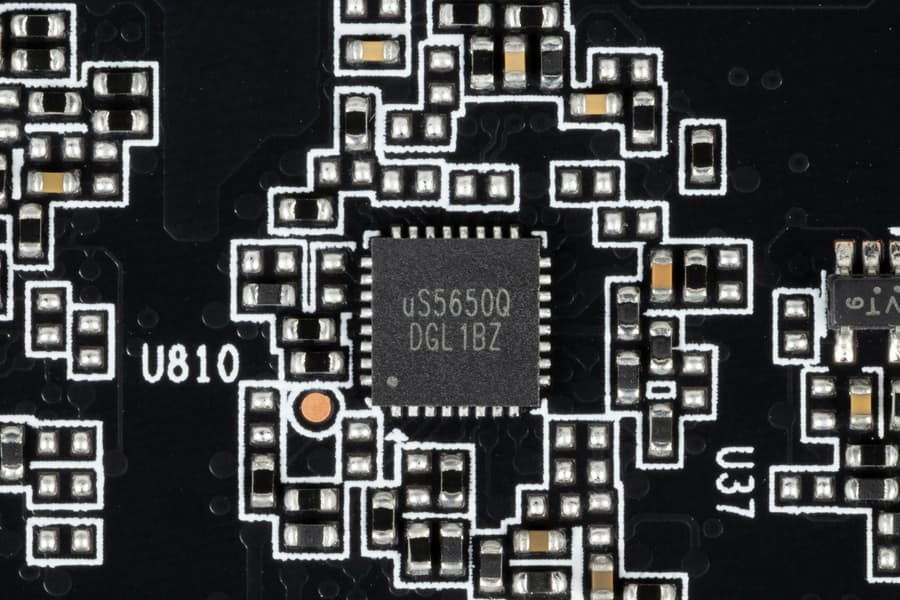

Также на тыльной стороне карты имеется контроллер uS5650Q (uPI Semi), который отвечает за мониторинг карты (отслеживание напряжений и температуры).

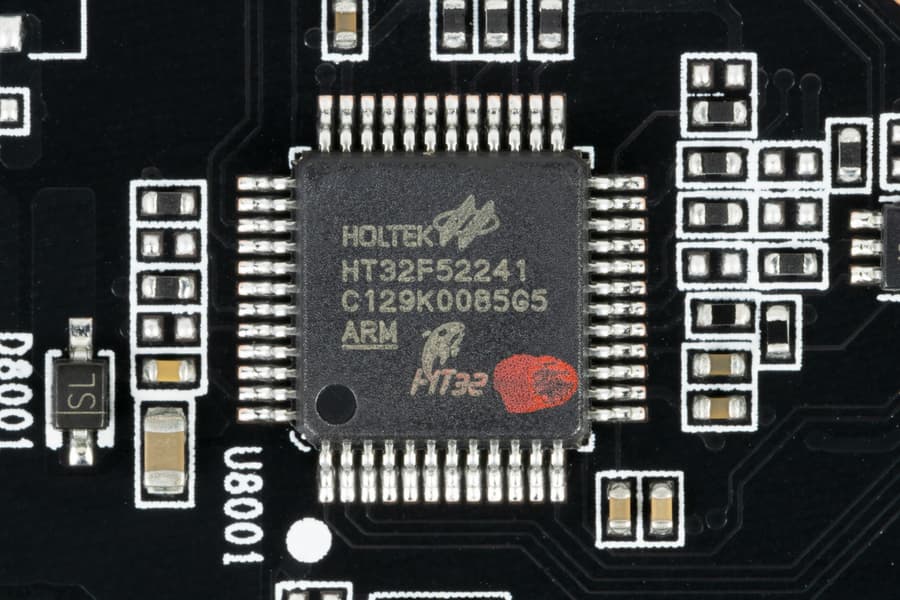

Управление подсветкой традиционно возложено на контроллер Holtek.

Карта имеет два режима работы, они заложены в двух вариантах BIOS, которые переключаются с помощью переключателя на верхнем торце карты: P (performance / производительный, он же 1) и S (silent / тихий, он же 2). Разница между режимами минимальная: по сути только в оборотах вентиляторов, ну и небольшая разница в лимитах: предел энергопотребления для BIOS P заложен в 350 Вт, а для BIOS S — 340 Вт.

Штатные частоты памяти, а также Boost-значение частоты работы ядра в обоих режимах BIOS 1(P)/BIOS 2(S) равны референсным значениям. При этом максимальная частота GPU выше референс-аналога почти на 2,5%. Исследования показали, что в среднем мы получили в играх крайне незначительный прирост производительности на 1,5% относительно референс-карты.

Энергопотребление карты Palit в тестах доходило до 350 Вт (в режиме BIOS P) и до 351 Вт (BIOS S).

Я попробовал ручной разгон и получил максимальные частоты 3015/24500 МГц, что обеспечило прирост в играх в разрешении 4К в среднем почти... на 3% относительно референсных значений (лимит потребления можно поднять всего до 102%, поэтому несмотря на сильно поднятые частоты работы, реальные приросты по скорости оказались крайне малы, да энергопотребление карты почти не выросло: 352 Вт (в пиковых всплесках).

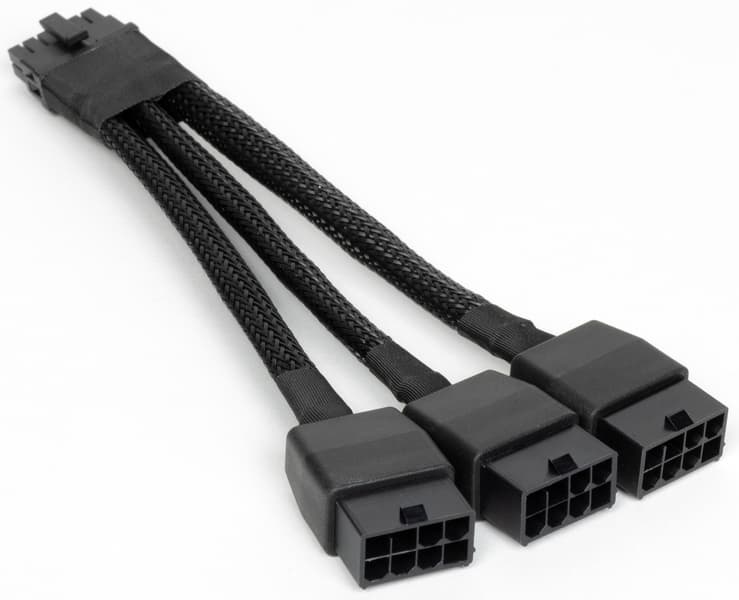

Питание на карту Palit подается через новый 16-контактный разъем питания стандарта PCIe 5.0.

В комплекте поставки карты имеется переходник на такой разъем с трех обычных 8-контактных (хорошо всем знакомых).

Отметим приличные габариты данной карты, особенно по толщине: 7 см. В результате видеокарта занимает 4 слота в системном блоке.

RTX 4080 не обладает поддержкой мультиграфической конфигурации, то есть технологией SLI, и у карты нет специального разъема на верхнем торце.

Карта имеет стандартный набор видеовыходов: три DP 1.4a и один HDMI 2.1.

Управление работой карты обеспечивается с помощью фирменной утилиты ThunderMaster. Мы о ней уже много раз писали: программа предоставляет управление вентиляторами, частотами работы карты, напряжением ядра и слежение за состоянием карты (мониторинг).

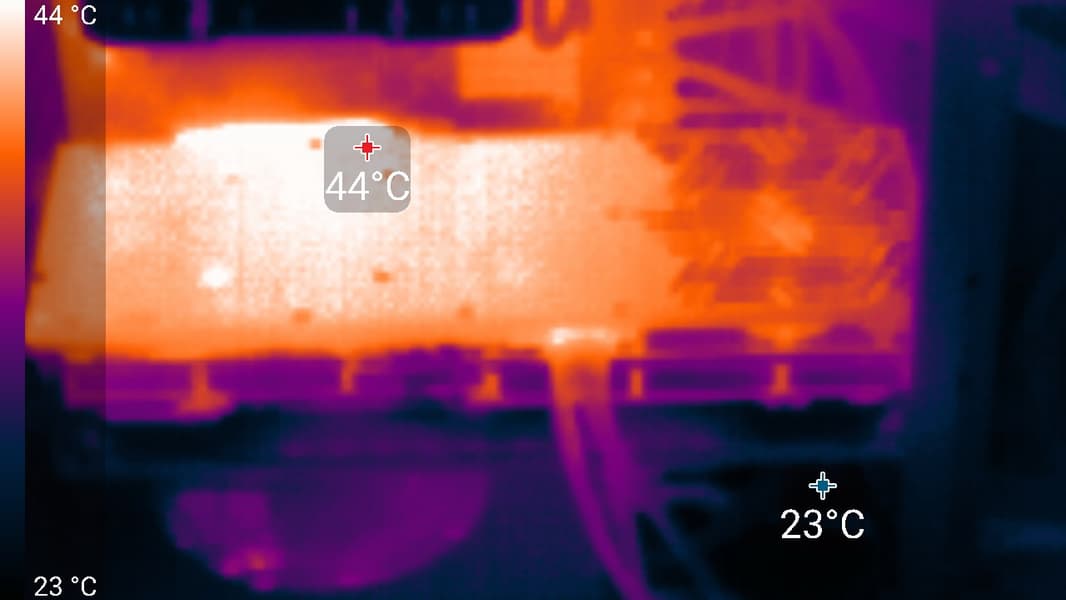

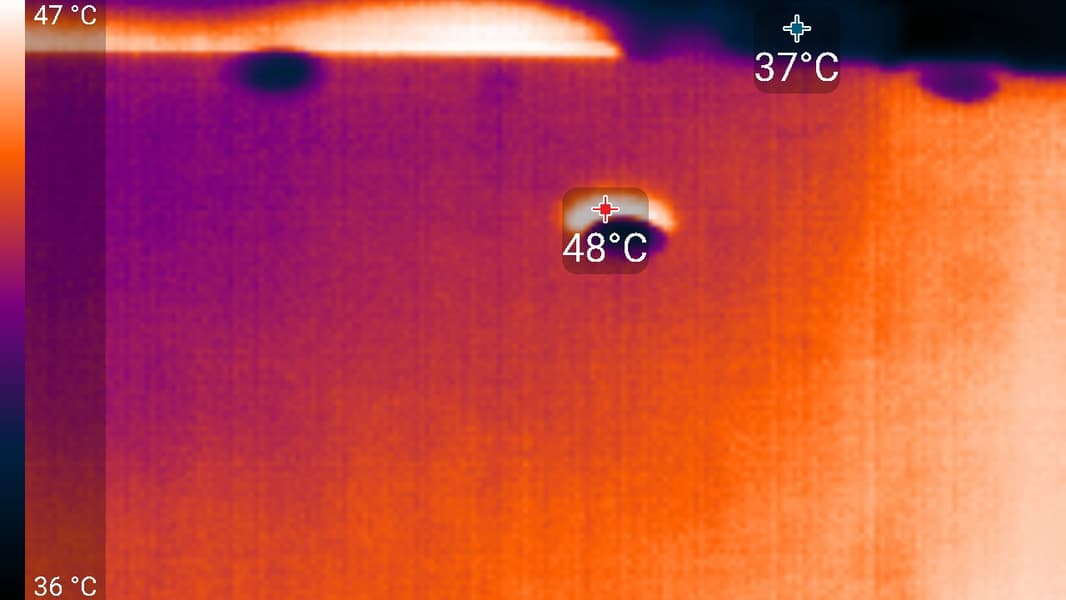

Нагрев и охлаждение

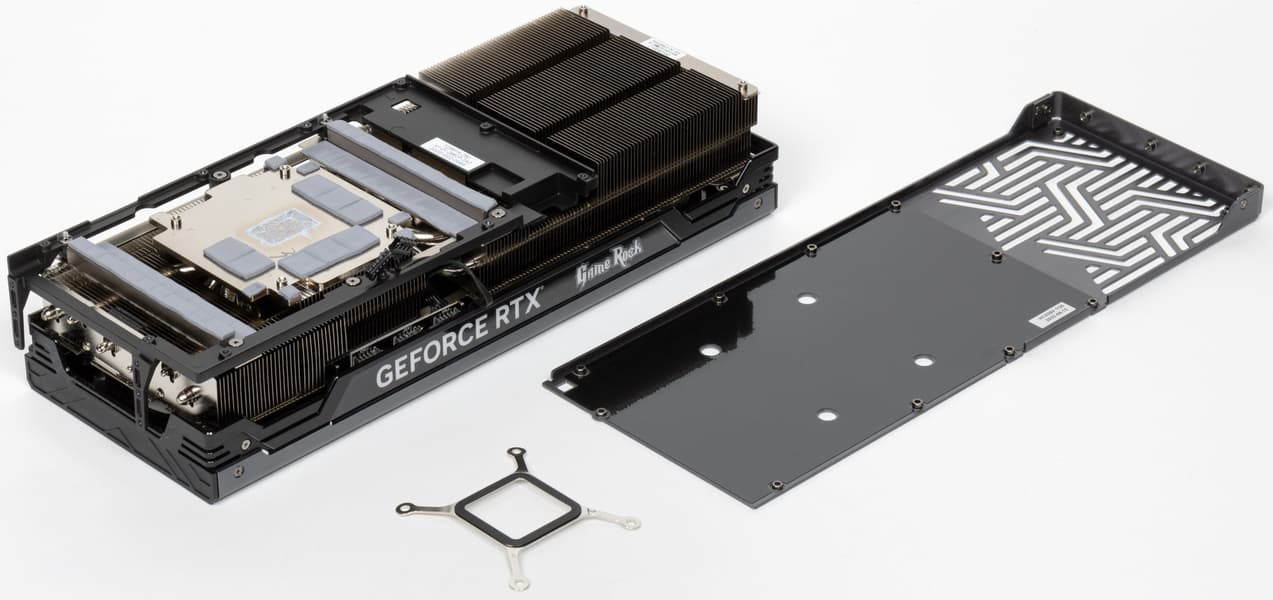

Основой кулера является огромный многосекционный пластинчатый никелированный радиатор с восемью тепловыми композитными трубками, распределяющими тепло по ребрам радиатора.

Трубки припаяны к огромному медному и никелированному плато, с помощью которого охлаждаются ядро и микросхемы памяти (через термопрокладки). Для охлаждения преобразователей питания VRM имеются свои узкие подошвы у того же радиатора.

В зависимости от расположения в радиаторе пластины имеют разные углы поворота, улучшая прохождение воздушного потока.

Задняя пластина служит только элементом защиты PCB и является составной частью общей концепции дизайна.

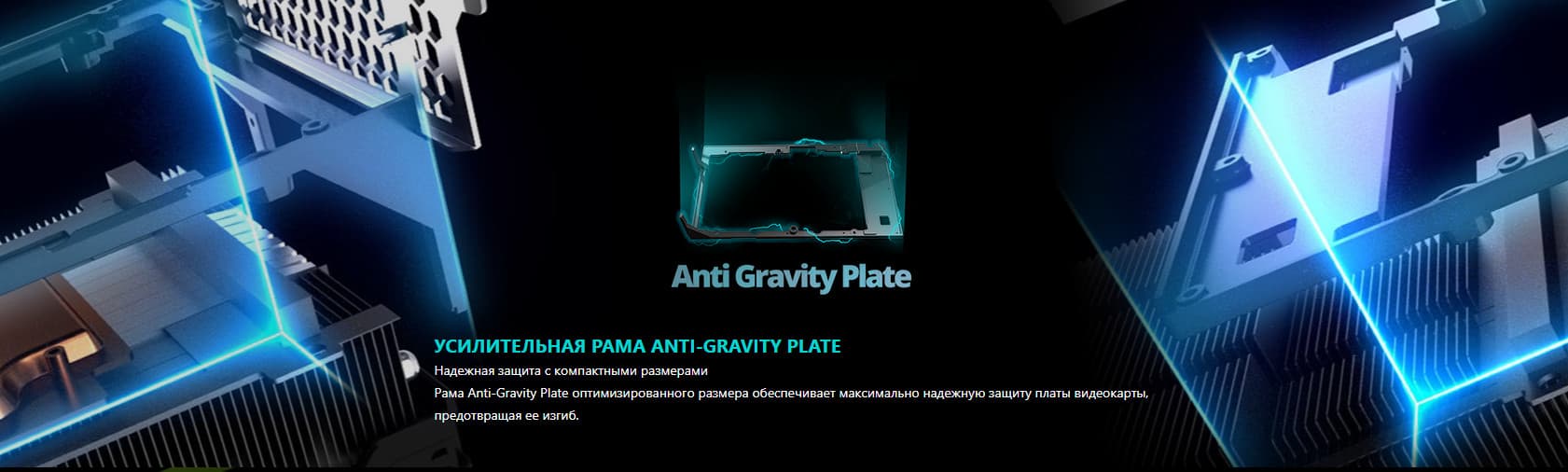

Как видно из снимка выше, к радиатору прикручена специальная черная рама, усиливающая конструкцию и противостоящая провисанию (изгибу) карты в слоте PCIe.

Поверх радиатора установлен кожух с тремя вентиляторами ∅90 мм, имеющими по 9 лопастей и работающими на единой частоте вращения (по умолчанию, но через программу ThunderMaster можно настроить их работу раздельно по двум группам: центральный — одна группа, два крайних — другая группа).

Остановка вентиляторов при малой нагрузке видеокарты происходит, если температура GPU опускается ниже 50 градусов, а нагрев микросхем памяти — ниже 80 градусов. Разумеется, СО при этом становится бесшумной. При запуске ПК вентиляторы работают, однако после загрузки видеодрайвера идет опрос рабочей температуры, и они выключаются. Ниже есть видеоролик на эту тему.

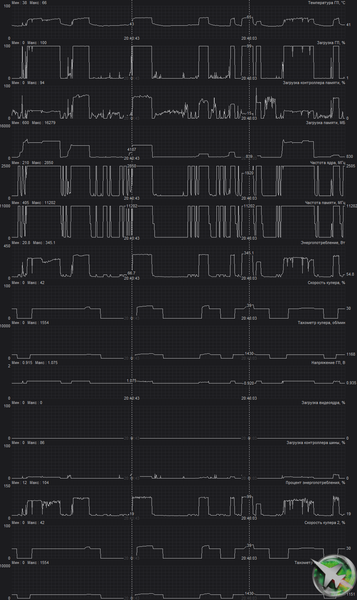

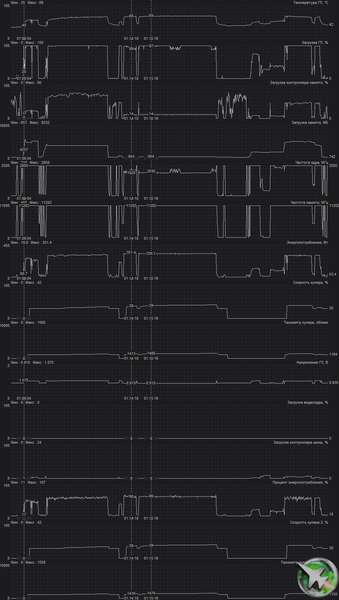

Мониторинг температурного режима с помощью MSI Afterburner:

Режим BIOS 1(P):

После 2-часового прогона под нагрузкой максимальная температура ядра не превысила 66 градусов, а температура микросхем памяти — 75 градусов, что является великолепным результатом для видеокарт флагманского уровня! Энергопотребление карты доходило до 350 Вт. Напомним, что безопасный предел нагрева памяти GDDR6X — 105 °C.

Режим BIOS 2(S):

В этом случае максимальная температура ядра достигала 69 градусов, а микросхем памяти — 76 °C, что также является отличным результатом для видеокарт такого уровня. Энергопотребление карты почти не изменилось (351 Вт).

При ручном разгоне (режим BIOS 1(P)) при выставлении лимита потребления в 102% параметры нагрева и шума менялись мало (максимальная температура ядра достигла 70 градусов, памяти — 79 градусов), потребление также почти не вырастало.

Мы засняли и ускорили в 50 раз 8-минутный прогрев (BIOS 1(P)):

Максимальный нагрев наблюдался около ядра и микросхем памяти.

Шум

Методика измерения шума подразумевает, что помещение шумоизолировано и заглушено, снижены реверберации. Системный блок, в котором исследуется шум видеокарт, не имеет вентиляторов, не является источником механического шума. Фоновый уровень 18 дБА — это уровень шума в комнате и уровень шумов собственно шумомера. Измерения проводятся с расстояния 50 см от видеокарты на уровне системы охлаждения.

Режимы измерения:

- Режим простоя в 2D: загружен интернет-браузер с сайтом iXBT.com, окно Microsoft Word, ряд интернет-коммуникаторов

- Режим 2D с просмотром фильмов: используется SmoothVideo Project (SVP) — аппаратное декодирование со вставкой промежуточных кадров

- Режим 3D с максимальной нагрузкой на ускоритель: используется тест FurMark

Оценка градаций уровня шума следующая:

- менее 20 дБА: условно бесшумно

- от 20 до 25 дБА: очень тихо

- от 25 до 30 дБА: тихо

- от 30 до 35 дБА: отчетливо слышно

- от 35 до 40 дБА: громко, но терпимо

- выше 40 дБА: очень громко

В режиме простоя в 2D в обоих режимах 1/2 температура была не выше 37 °C, вентиляторы не работали, уровень шума был равен фоновому — 18 дБА.

При просмотре фильма с аппаратным декодированием ничего не менялось.

Режим BIOS 1(P):

В режиме максимальной нагрузки в 3D температура достигала 66/75 °C (ядро/память). Вентиляторы при этом раскручивались до 1480 оборотов в минуту, шум вырастал до 29,4 дБА: это тихо относительно типичного шумового фона. В видеоролике ниже можно оценить, как вырастает шум (он фиксировался на пару секунд через каждые 30 секунд).

Режим BIOS 2(S):

В режиме максимальной нагрузки в 3D температура достигала 69/76 °C (ядро/память). Вентиляторы при этом раскручивались до 1440 оборотов в минуту, шум вырастал до 28,3 дБА: это также тихо. В видеоролике ниже это продемонстрировано (шум фиксировался на пару секунд через каждые 30 секунд).

С учетом того, сколько данная карта потребляет, тихая работа системы охлаждения заслуживает похвалы.

Подсветка

Карта имеет шикарную красивейшую подсветку Midnight Kaleidoscope практически по всей площади кожуха СО, где установлены несколько десятков адресуемых светодиодов под акриловым покрытием «под кристаллы».

Также на верхнем торце карты подсвечены логотипы серий.

Это не новый тип подсветки, такой дизайн появился в 2020 году с выходом RTX 30 в серии GameRock, сейчас он лишь немного изменен. Управление режимами подсветки, в том числе и ее отключением, осуществляется той же утилитой ThunderMaster.

Имеется возможность сохранения выбранного режима в самой карте, то есть при желании можно настроить подсветку один раз и больше не запускать программу.

Отметим, что в комплект поставки карт серии GameRock входит кабель для подключения к разъему ARGB (5 В) на материнской плате, чтобы синхронизировать работу подсветки с платой. В этом случае запускать утилиту ThunderMaster вообще не требуется: карта самостоятельно определит подключение, и подсветка по умолчанию будет синхронизирована.

Комплект поставки и упаковка

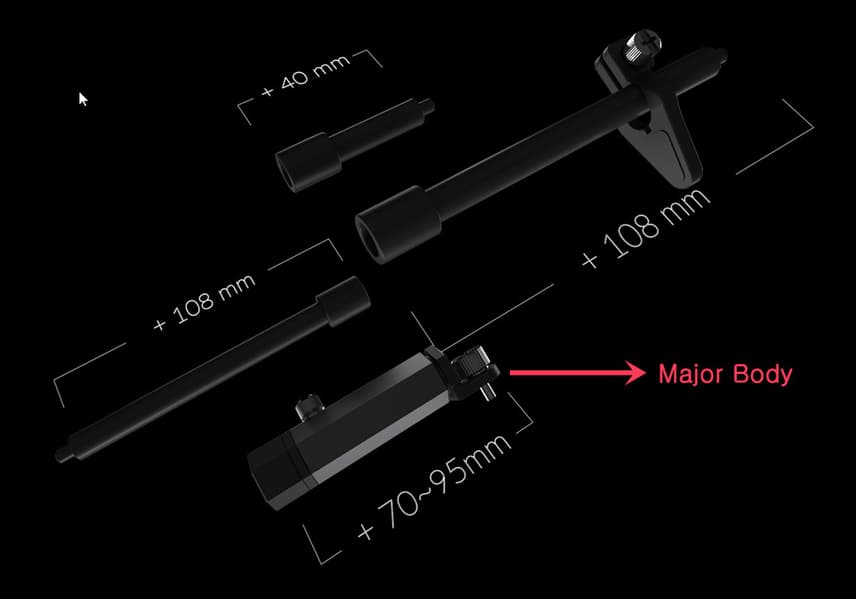

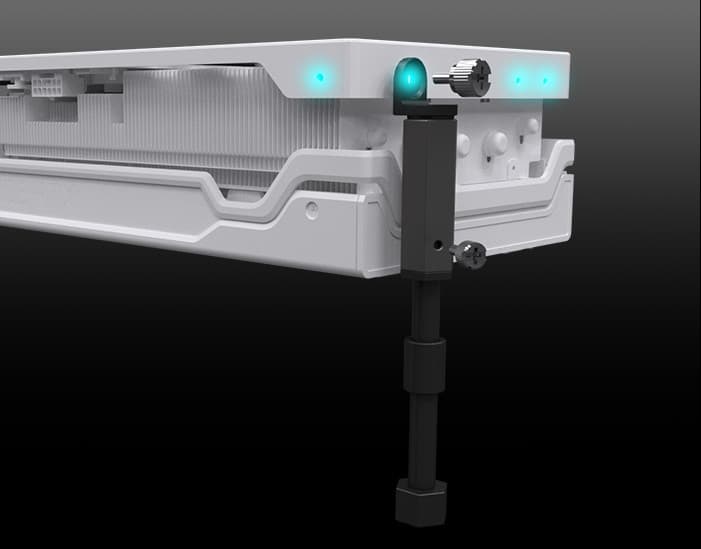

В комплекте поставки уже нет даже традиционного краткого руководства пользователя (все переведено в интернет!), но зато имеются: разборная металлическая подставка-штатив под карту, переходник питания, кабель синхронизации подсветки.

Стоит обратить внимание на переходник питания с трех 8-контактных разъемов на один 16-контактный.

Несмотря на, казалось бы, очень толстые оплетенные кабели и наличие оплетки у входа в 16-контактный разъем, данный адаптер крайне не рекомендуется сгибать в месте той самой оплетки.

Мы еще раз рекомендуем приобретать полноценные БП ATX 3.0 с разъемом 12VHPWR и кабелем с 16 контактами для видеокарт новых поколений.

Подставка типа штатив, упирающаяся в дно корпуса, состоит из трех секций, на ней установлен кронштейн, регулируемый по высоте, так что можно подобрать нужный вариант. Такой способ поддержки не перекрывает слоты ниже видеокарты в системном блоке. Однако не всегда прямо под видеокартой имеется открытое пустое пространство на дне корпуса для установки такой подставки-штатива (корпуса сейчас делают очень разные). Сама подставка не просто подпирает карту в углу, а крепится к ней.

Подставка способна поддерживать и две карты, если они установлены в одном системном блоке. Для этого имеется дополнительный кронштейн, надеваемый на опору. В целом идея отличная, ибо ранее мы видели комплектацию карт акриловым кронштейном-подставкой, который крепится под видеокартой, занимая два слота под ней.

Тестирование: синтетические тесты

Конфигурация тестового стенда

- Компьютер на базе процессора Intel Core i9-12900K (Socket LGA1700):

- Платформа:

- процессор Intel Core i9-12900K (разгон до 5,1 ГГц по всем ядрам);

- ЖСО Asus ROG Ryujin II 360;

- системная плата Asus ROG Maximus Z690 Extreme на чипсете Intel Z690;

- оперативная память Kingston Fury (KF552C40BBK2-32) 32 ГБ (2×16) DDR5 4800 МГц (XMP 5200 МГц);

- SSD Intel 760p NVMe 1 ТБ PCI-E;

- жесткий диск Seagate Barracuda 7200.14 3 ТБ SATA3;

- блок питания Palit UD1000GM PG5 (1000 Вт);

- корпус Thermaltake Level20 XT;

- операционная система Windows 11 Pro 64-битная;

- телевизор LG 55Nano956 (55″ 8K HDR, HDMI 2.1);

- драйверы AMD версии 22.10.2;

- драйверы Nvidia версии 526.47/526.76;

- VSync отключен.

- Платформа:

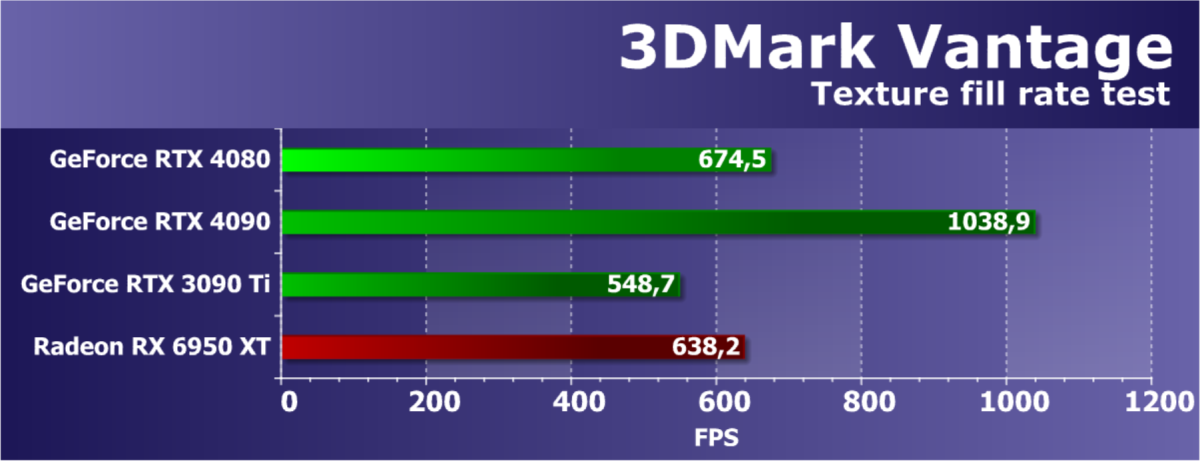

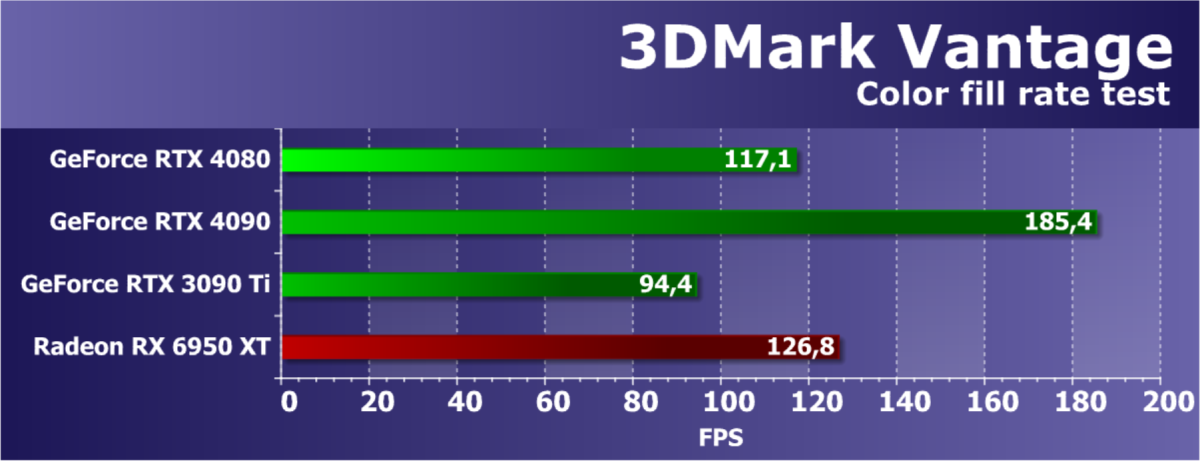

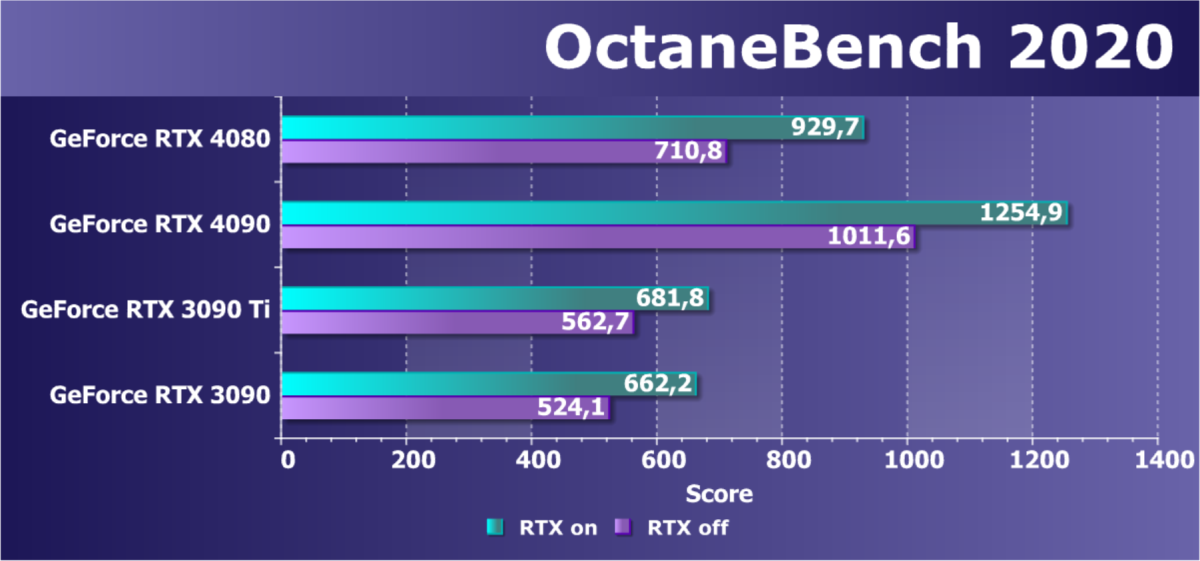

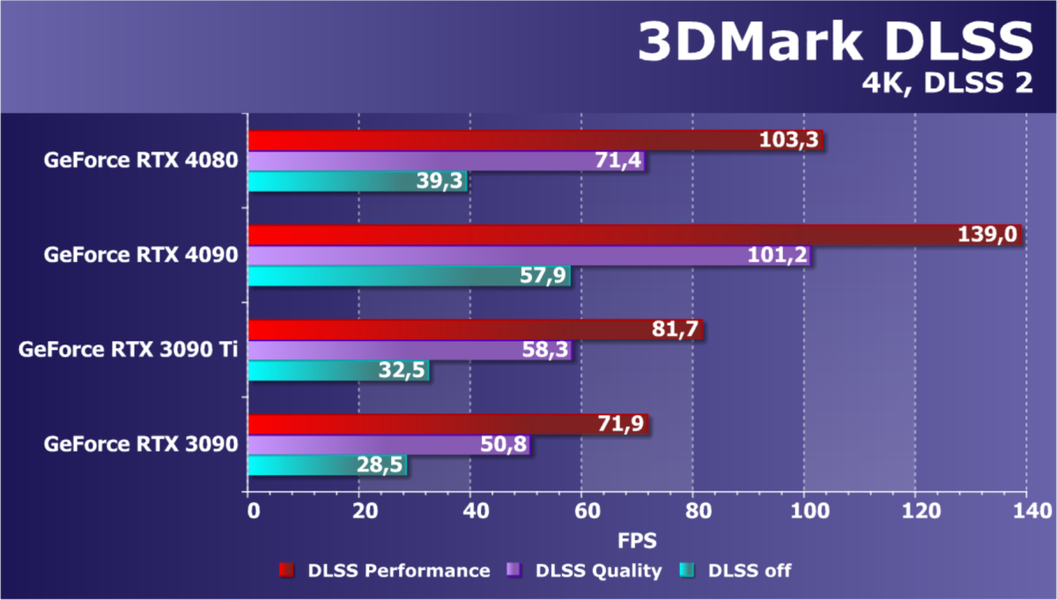

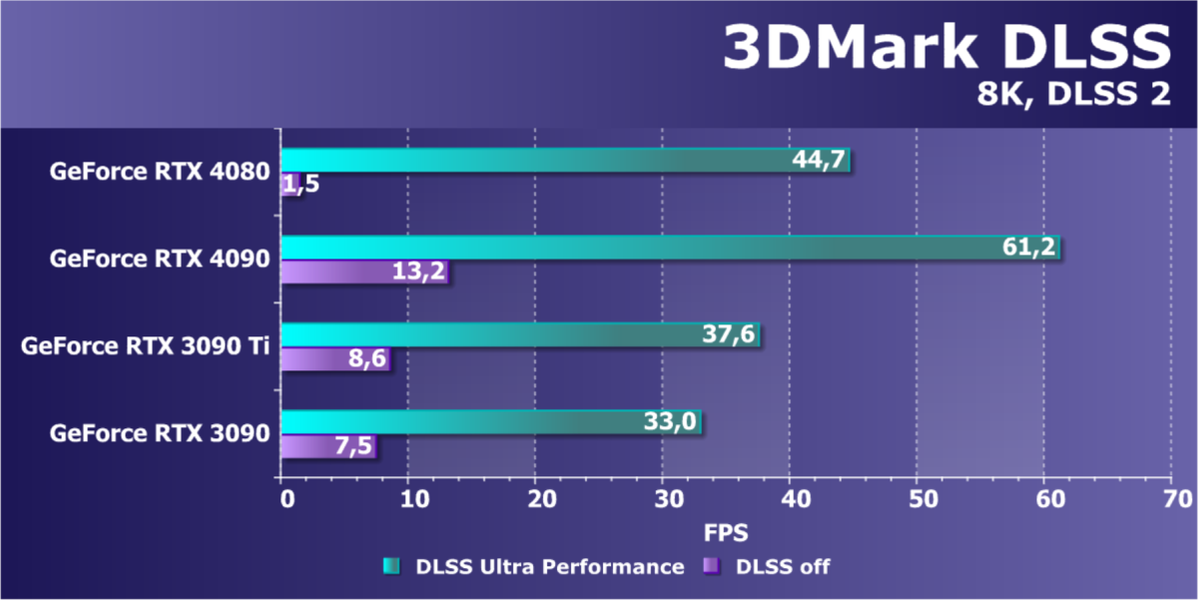

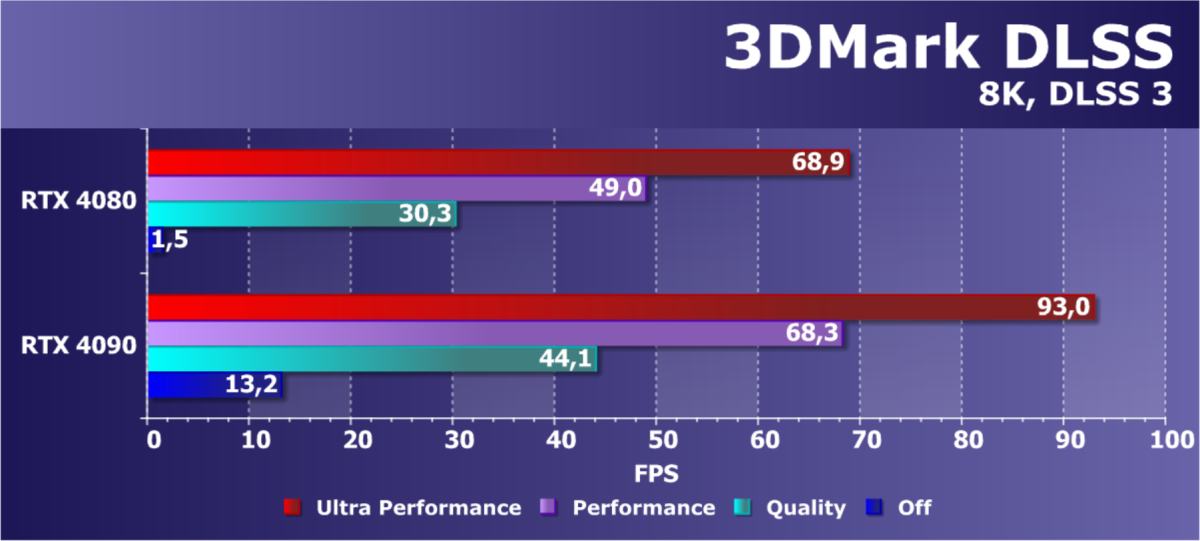

Мы провели тестирование новой модели видеокарты Nvidia со стандартными частотами в нашем наборе синтетических тестов. Он продолжает меняться, иногда добавляются новые тесты, а устаревшие постепенно убираются. Мы бы хотели добавить еще больше примеров с вычислениями, но с этим есть определенные сложности. Мы постоянно стараемся расширять и улучшать набор синтетических тестов, и если у вас есть четкие и обоснованные предложения — напишите их в комментариях к статье или отправьте авторам.

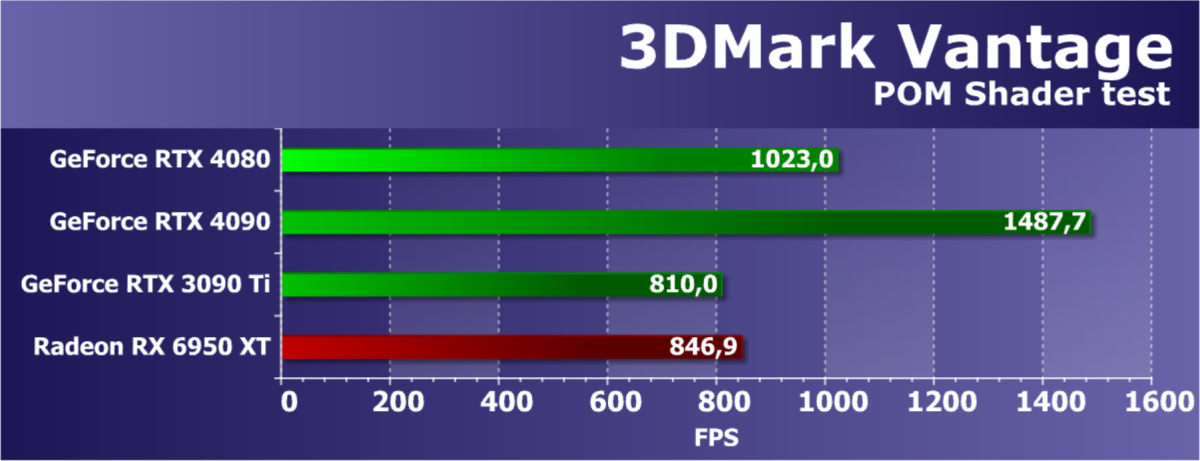

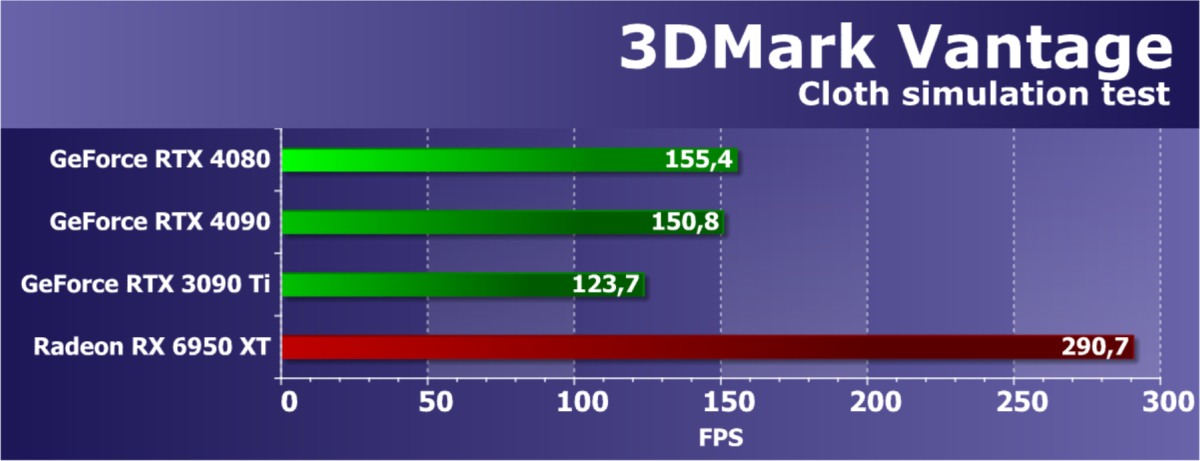

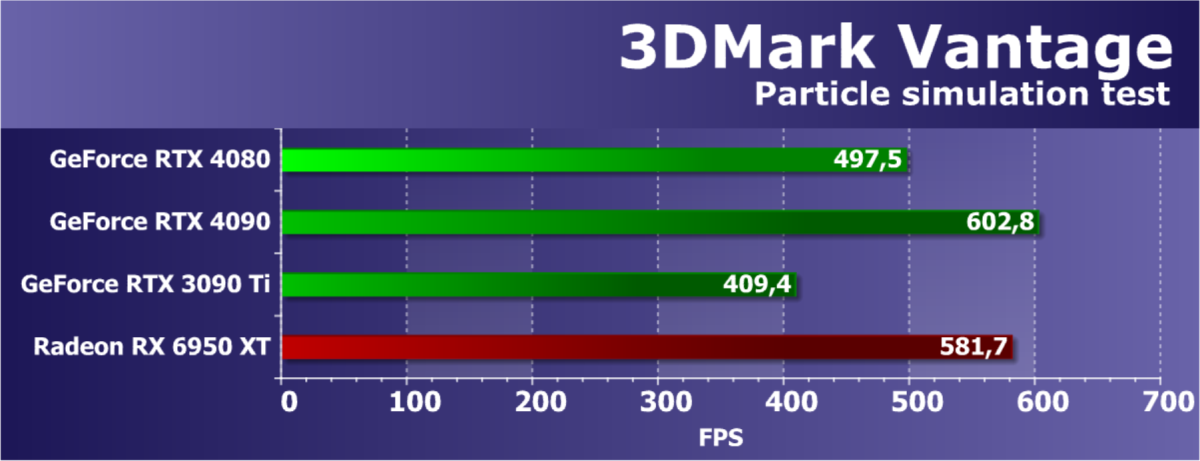

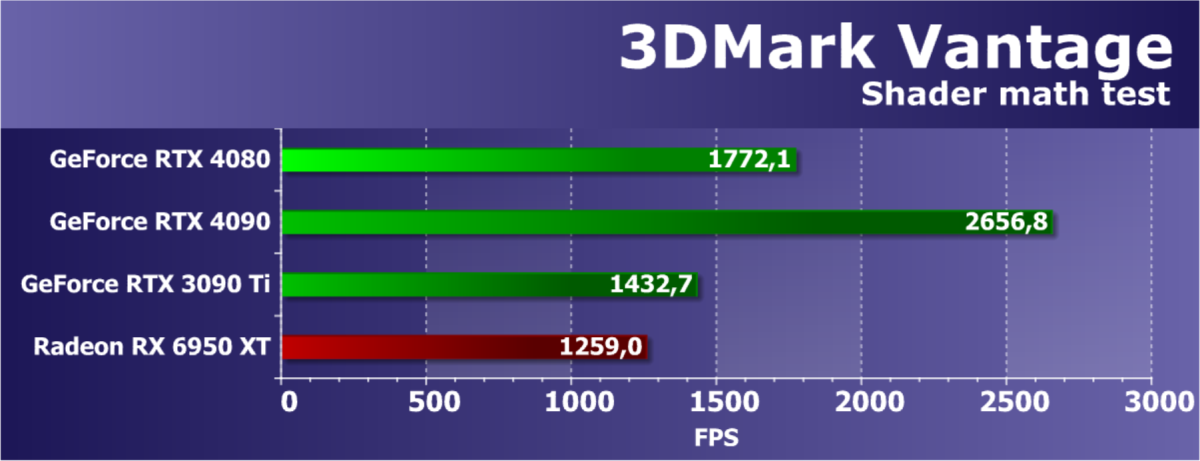

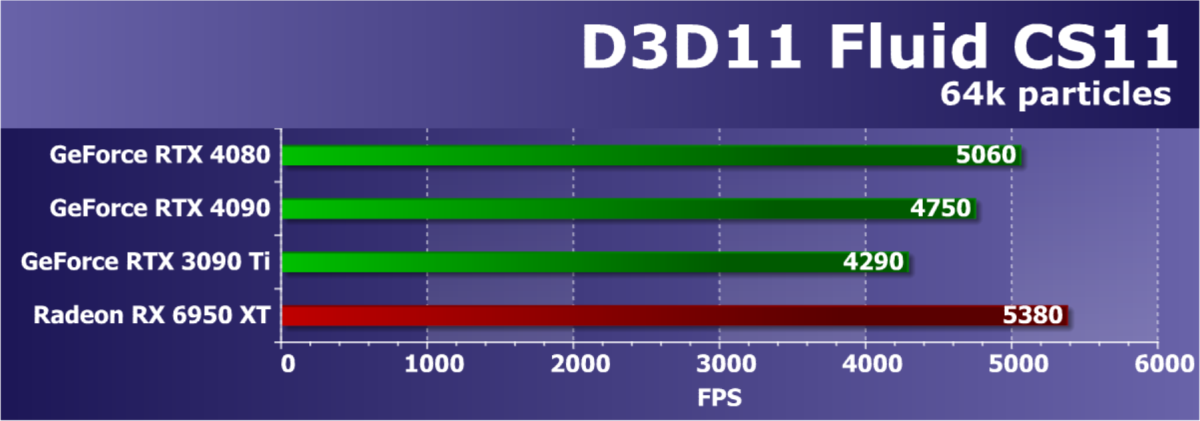

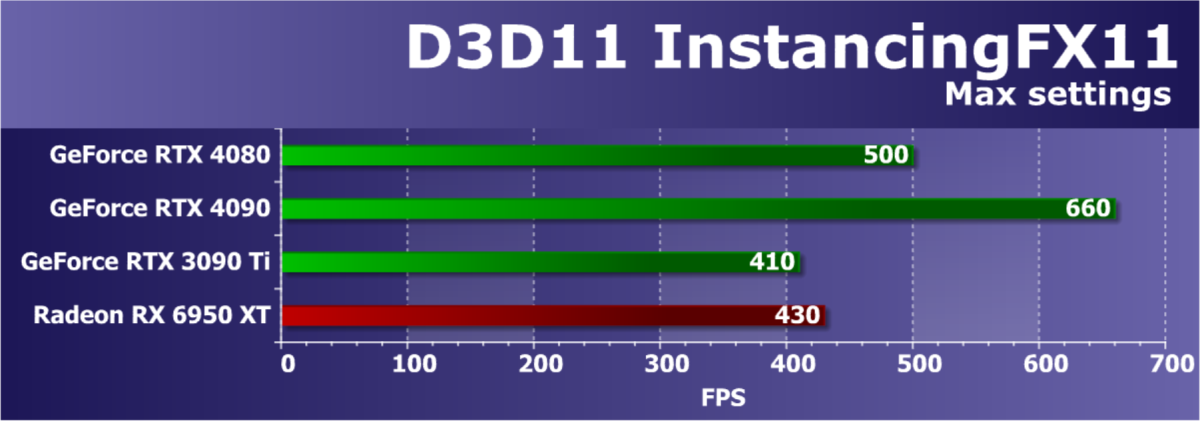

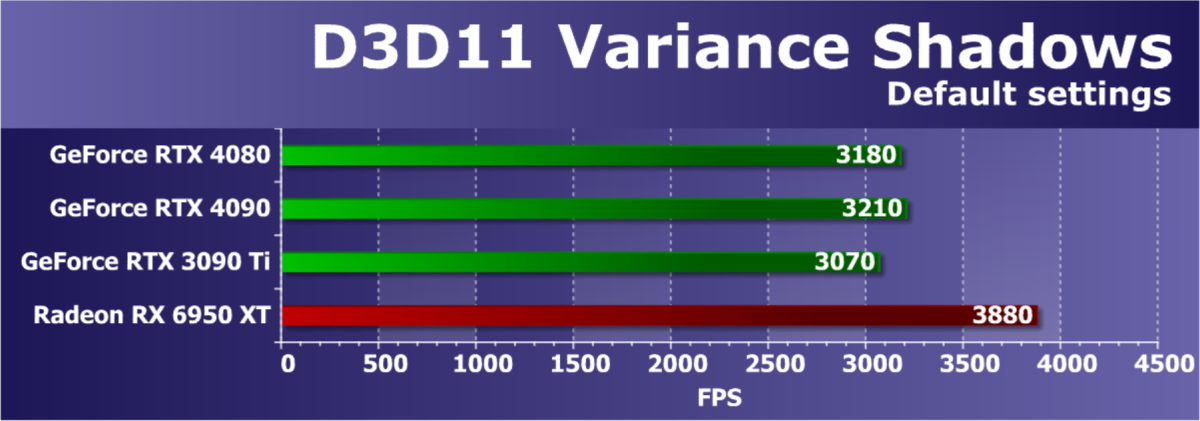

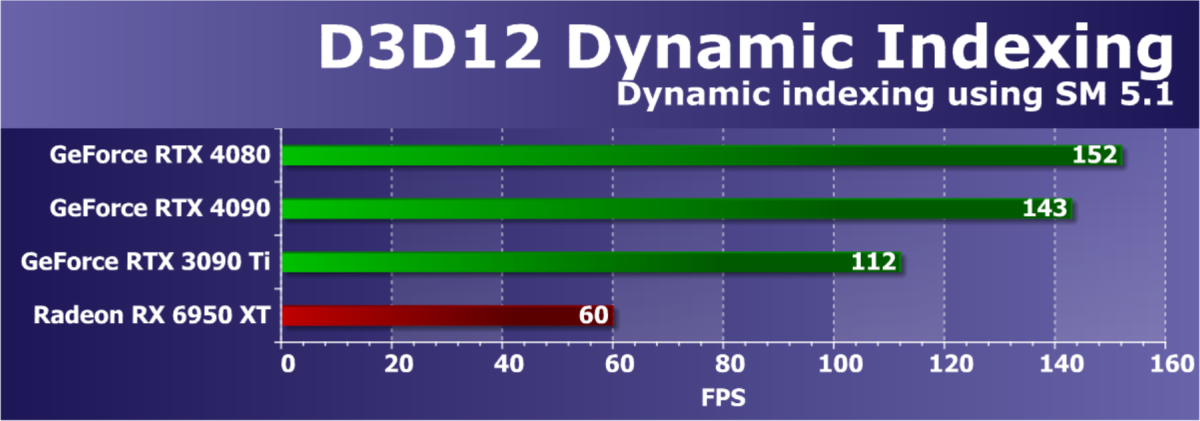

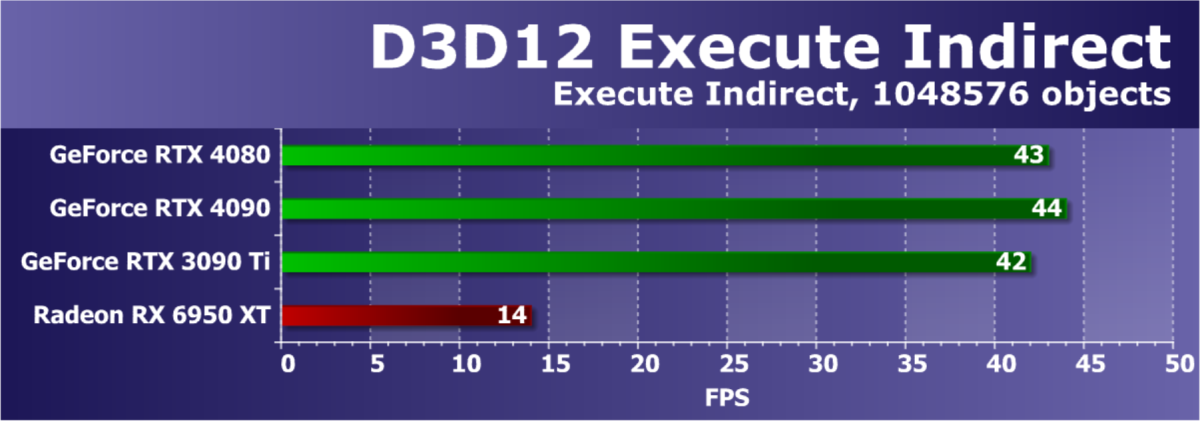

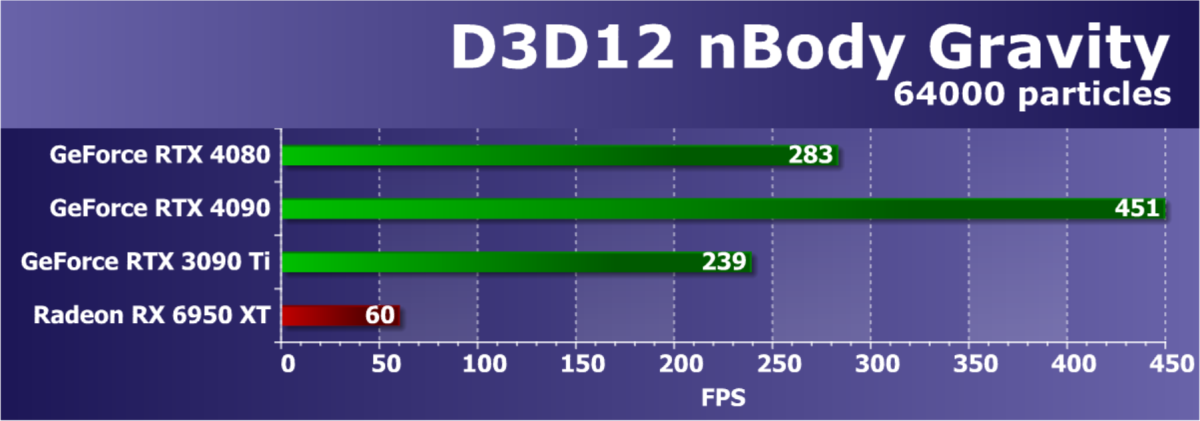

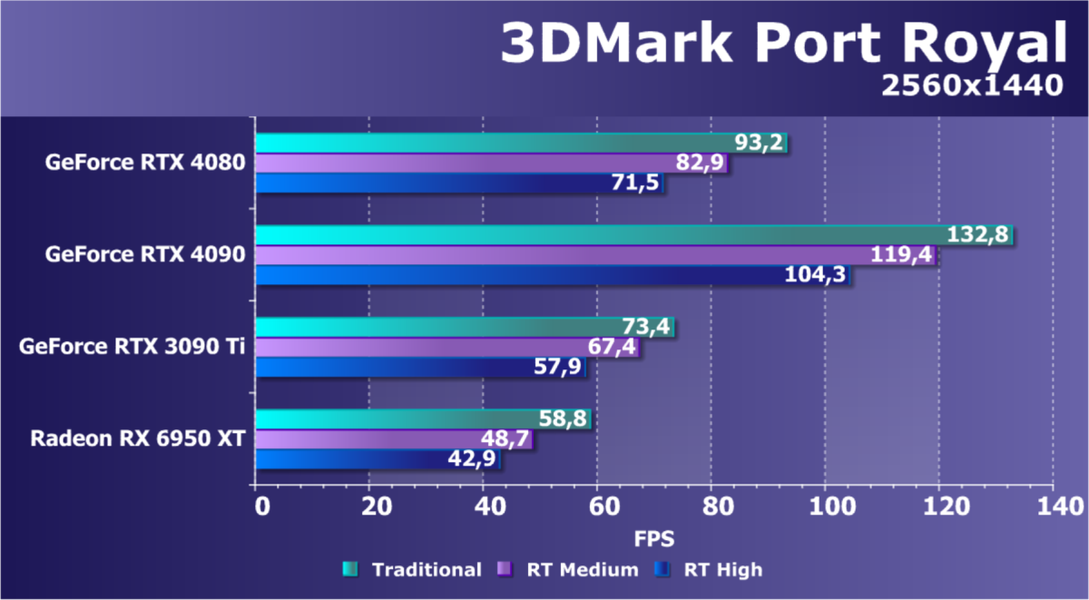

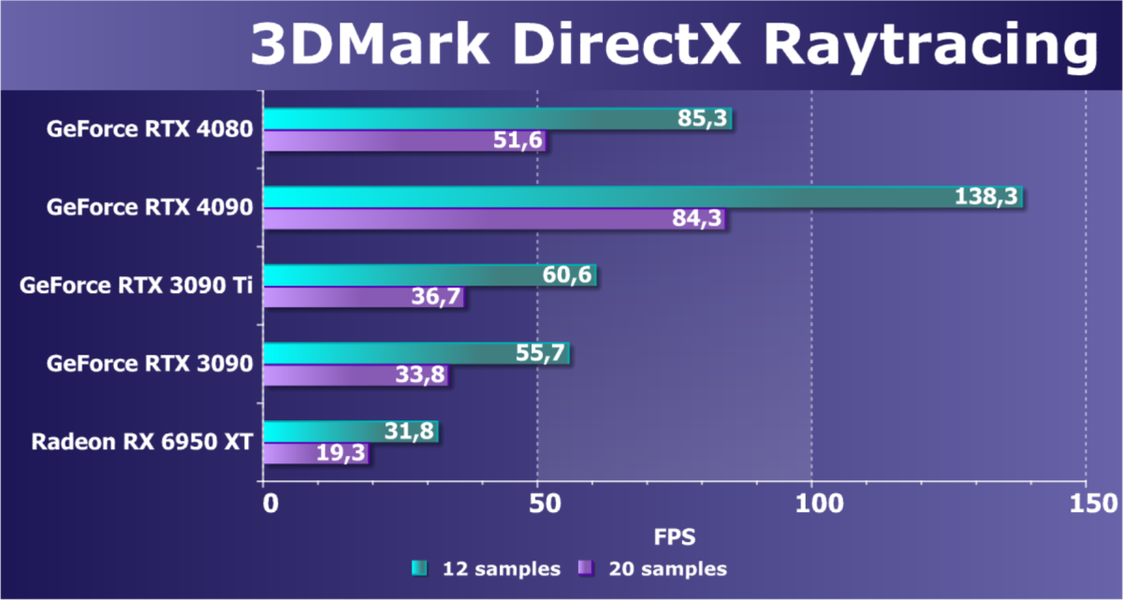

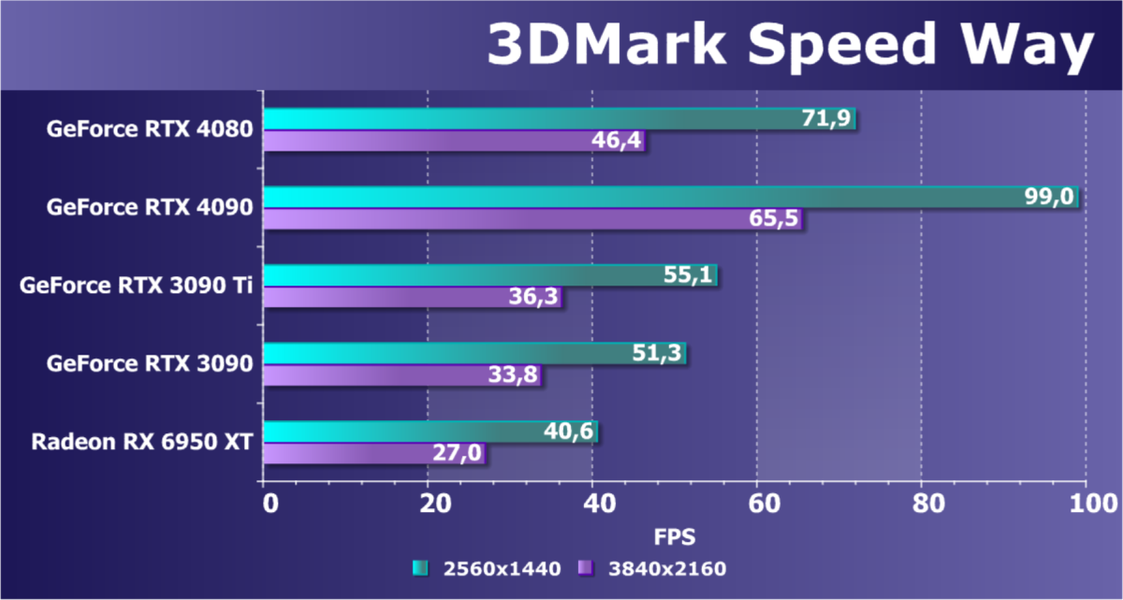

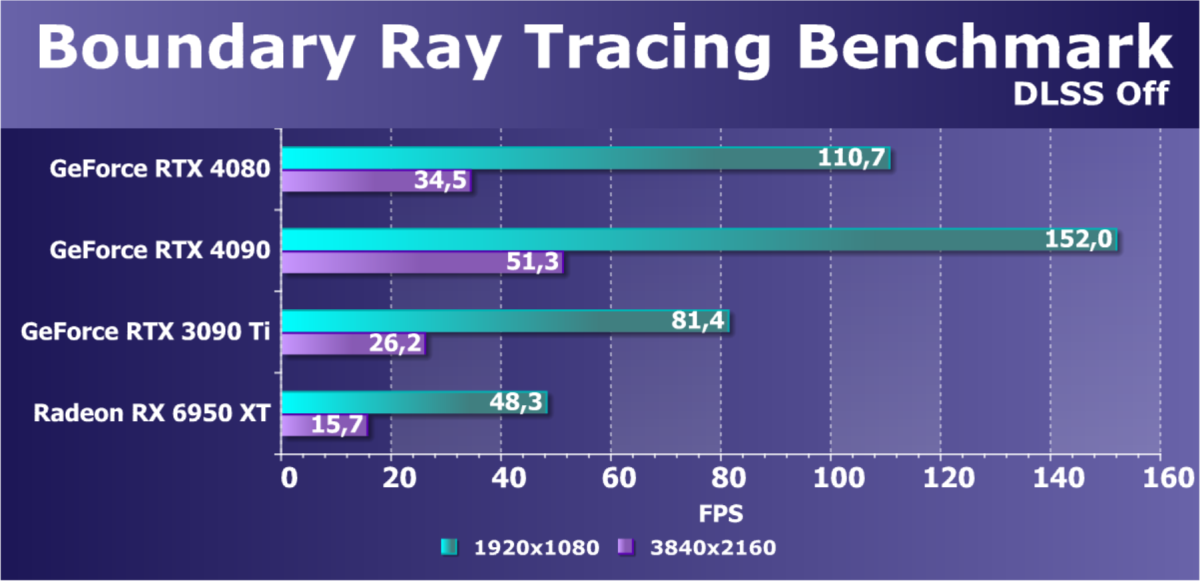

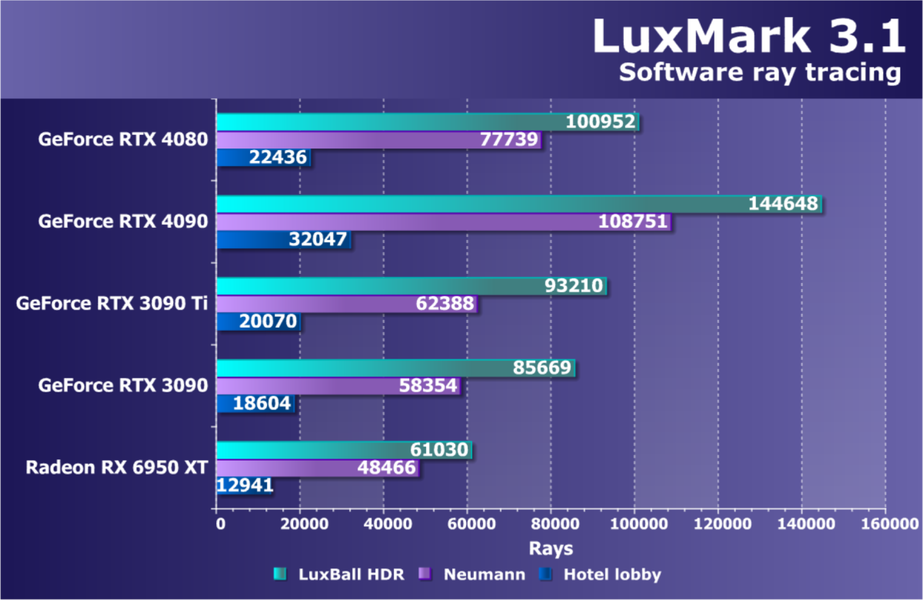

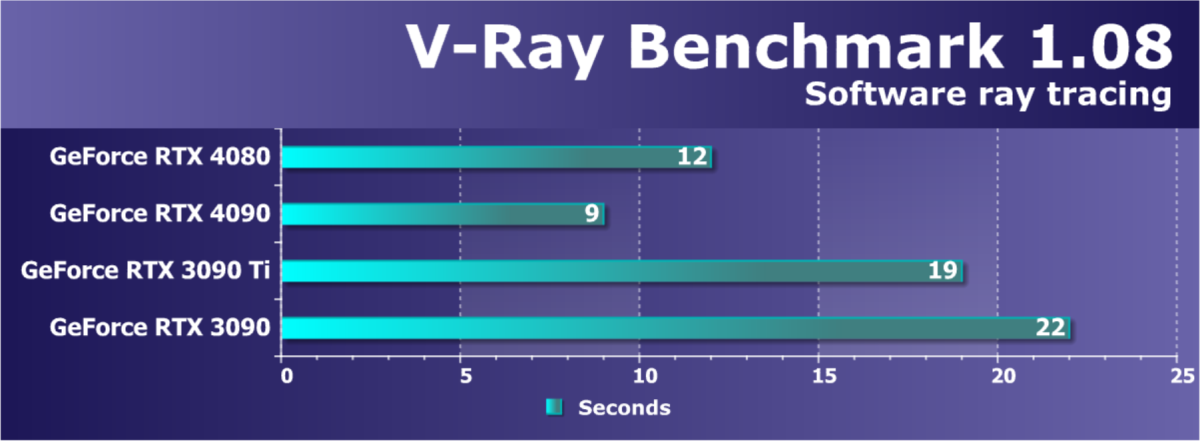

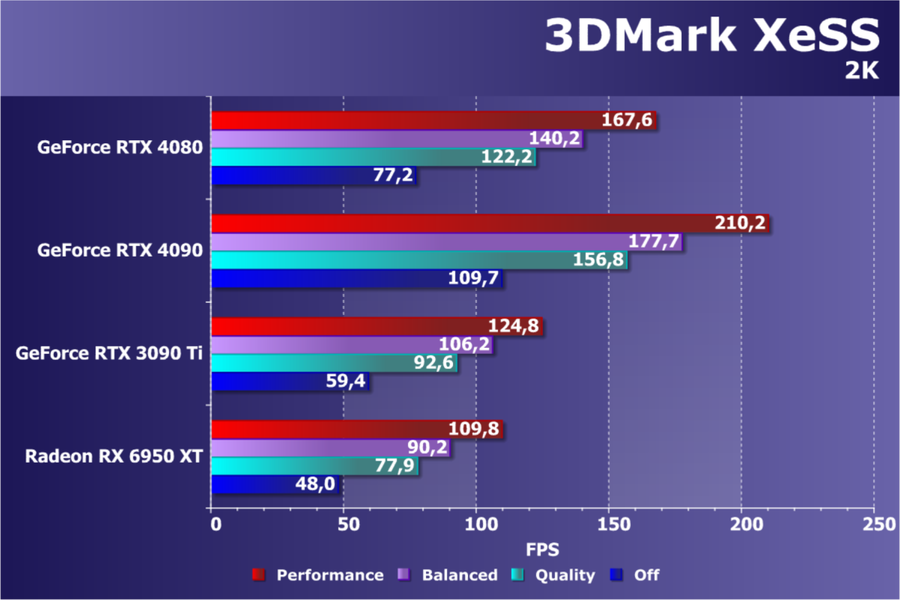

Из более-менее новых бенчмарков мы начали использовать несколько примеров, входящих в DirectX SDK и пакет SDK компании AMD (скомпилированные примеры применения D3D11 и D3D12), а также несколько разнообразных тестов для измерения производительности трассировки лучей, программной и аппаратной. В качестве полусинтетических тестов у нас также используется набор подтестов из довольно популярного пакета 3DMark: Time Spy, Port Royal, DX Raytracing, Speed Way и др.

Синтетические тесты проводились на следующих видеокартах:

- GeForce RTX 4080 со стандартными параметрами (RTX 4080)

- GeForce RTX 4090 со стандартными параметрами (RTX 4090)

- GeForce RTX 3090 Ti со стандартными параметрами (RTX 3090 Ti)

- GeForce RTX 3090 со стандартными параметрами (RTX 3090)

- Radeon RX 6950 XT со стандартными параметрами (RX 6950 XT)

Для анализа производительности видеокарты GeForce RTX 4080 мы взяли модель, которая стоит выше в новой линейке — RTX 4090, по этому сравнению мы поймем, насколько новинка медленнее топового решения нового семейства. Также в тесты вошла пара топовых видеокарт компании Nvidia из предыдущего поколения — чтобы понять, насколько новинка быстрее их (ну или медленнее, хотя вряд ли). Это модели RTX 3090 Ti и RTX 3090 из прошлого семейства, основанные на самом сложном графическом процессоре семейства Ampere с разной степенью урезанности.

Настоящих соперников для новинки компания AMD пока что не выпустила, они ожидаются в лучшем случае ближе к новогодним праздникам, а то и позже. Поэтому, пока не вышла в продажу новая линейка на основе архитектуры RDNA3, остается лишь один номинальный конкурент для GeForce RTX 4080 — Radeon RX 6950 XT, самый быстрый вариант из решений на архитектуре RDNA2. Однако по цене и производительности они далеки друг от друга, поэтому остается ждать выхода RDNA3 и пока что оценивать лишь условно.

Тестирование: игровые тесты

Список инструментов тестирования

Во всех игровых тестах использовалось максимальное качество графики в настройках.

- Hitman III (IO Interactive/IO Interactive)

- Cyberpunk 2077 (Софтклаб/CD Projekt RED), патч 1.4 (версия 1.5 еще не тестировалась)

- God of War (Sony IE/Sony IE)

- Assassin’s Creed Valhalla (Ubisoft/Ubisoft)

- Marvel’s Guardians of the Galaxy (Eldos/Square Enix)

- The Medium (Bloober/Bloober)

- Godfall (Gearbox Publishing/Counterplay Games)

- Resident Evil Village (Capcom/Capcom)

- Far Cry 6 (Ubisoft/Ubisoft)

- Battlefield 2042 (DICE/EA)

Кратко о производительности в 3D-играх

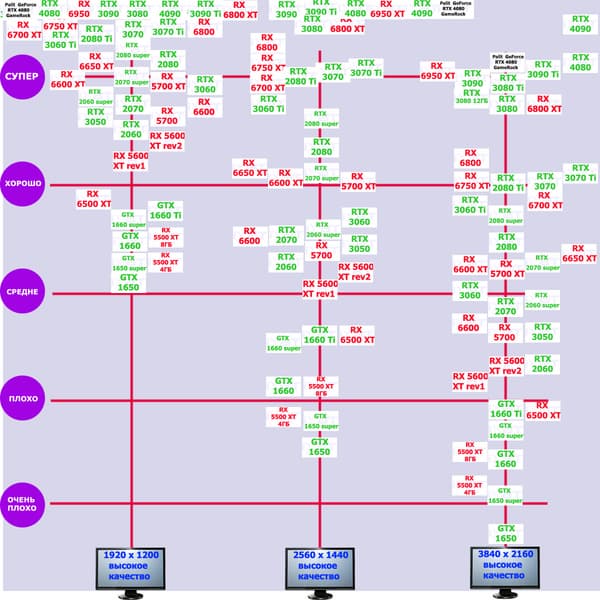

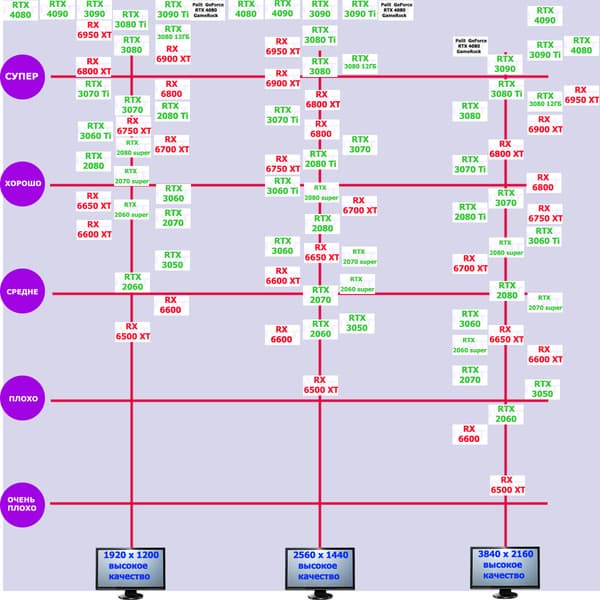

Перед демонстрацией детальных тестов мы приводим краткие сведения о производительности семейства, к которому относится конкретный исследуемый ускоритель, а также его соперников. Все это нами субъективно оценивается по шкале из пяти градаций.

Игры без использования трассировки лучей (классическая растеризация):

При оценке исходим из того, что совсем недавно лидерами производительности в классических играх были GeForce RTX 3090 Ti и Radeon RX 6950 XT. Учитывая, что RTX 4080 в среднем на 12%-15% (а в разрешении 4K — на 19%) быстрее, чем RTX 3090 Ti, то выводы очевидны: перед нами реальный серебряный «призер гонки в 3D» после RTX 4090.

Игры с использованием трассировки лучей и DLSS/FSR:

C учетом некоторого падения производительности при активации в играх трассировки лучей (при этом появляется все больше и больше игр с поддержкой Nvidia DLSS, а эта технология «умного» антиалиасинга позволяет резко поднять производительность, в том числе компенсируя падение от включения RT) , а также того факта, что у Radeon RX 6950 XT падение FPS куда более драматично, новинка RTX 4080 смотрится еще ярче относительно былых лидеров. А когда массово начнет внедряться DLSS 3, то можно будет вообще никогда отключать трассировку в играх.

Как и RTX 4090, RTX 4080 и в играх с RT способен обеспечить полный комфорт на максимальных настройках графики в разрешении 4К.

Результаты тестирования в 3D-играх

Стандартные результаты тестов без использования аппаратной трассировки лучей в разрешениях 1920×1200, 2560×1440 и 3840×2160

Все регулярно тестируемые нами видеокарты сейчас поддерживают технологию RT, поэтому мы проводим тесты не только с использованием обычных методов растеризации, но и с включением RT и/или DLSS/FSR.

Результаты тестов со включенной аппаратной трассировкой лучей и/или DLSS/FSR в разрешениях 1920×1200, 2560×1440 и 3840×2160

Результаты тестов с включенной аппаратной трассировкой лучей и DLSS/FSR в разрешении 7680×4320 (8К)

Сегодня нормально поиграть в таком разрешении можно только на самых флагманских и дорогих видеокартах, да и то для приемлемого комфорта в таких играх требуется обязательная поддержка DLSS (или FSR). Однако поиграть все же можно.

Рейтинг iXBT.com

Рейтинг ускорителей iXBT.com демонстрирует нам функциональность видеокарт друг относительно друга и представлен в двух вариантах:

- Вариант рейтинга iXBT.com без включения RT

Рейтинг составлен по всем тестам без использования технологий трассировки лучей. Этот рейтинг нормирован по наиболее слабому ускорителю из группы карт — Radeon RX 6500 XT (то есть сочетание скорости и функций Radeon RX 6500 XT приняты за 100%). Рейтинги ведутся по 22 ежемесячно исследуемым нами акселераторам в рамках проекта Лучшая видеокарта месяца. В данном случае из общего списка выбрана группа карт для анализа, в которую входят GeForce RTX 4080 и его конкуренты.

Рейтинг приведен суммарно для всех трех разрешений.

| № | Модель ускорителя | Рейтинг iXBT.com | Рейтинг полезности | Цена, руб. |

|---|---|---|---|---|

| 01 | RTX 4090 24 ГБ, 2520—2640/21000 | 570 | 42 | 136 000 |

| 02 | Palit RTX 4080 GameRock, разгон до 3015/24500 | 506 | 43 | 118 000 |

| 03 | Palit RTX 4080 GameRock, 2505—2850/22400 | 500 | 42 | 118 000 |

| 04 | RTX 4080 16 ГБ, 2505—2725/22400 | 498 | 42 | 118 000 |

| 05 | RTX 3090 Ti 24 ГБ, 1860—1965/21000 | 449 | 49 | 91 000 |

| 06 | RX 6950 XT 16 ГБ, 2310—2525/18000 | 448 | 54 | 83 600 |

| 07 | RX 6900 XT 16 ГБ, 2250—2470/16000 | 422 | 56 | 75 000 |

| 08 | RTX 3090 24 ГБ, 1695—1965/19500 | 419 | 54 | 77 000 |

Отлично видно, что в классических играх средний прирост производительности относительно RTX 3090 Ti и RX 6950 XT по всем разрешениям составляет около 13%, а в разрешении 4К — и вовсе 18%. Карта Palit практически равна референс-аналогу по скорости.

- Вариант рейтинга iXBT.com с включением RT/DLSS/FSR

Рейтинг составлен по 9 тестам, в которых используется технология трассировки лучей и одновременно технология Nvidia DLSS или AMD FSR. Этот рейтинг нормирован по самому слабому ускорителю в данной группе — Radeon RX 6500 XT (то есть сочетание скорости и функций Radeon RX 6500 XT приняты за 100%).

Рейтинг приведен суммарно для всех трех разрешений.

| № | Модель ускорителя | Рейтинг iXBT.com | Рейтинг полезности | Цена, руб. |

|---|---|---|---|---|

| 01 | RTX 4090 24 ГБ, 2520—2640/21000 | 965 | 71 | 136 000 |

| 02 | Palit RTX 4080 GameRock, разгон до 3015/24500 | 884 | 75 | 118 000 |

| 03 | Palit RTX 4080 GameRock, 2505—2850/22400 | 876 | 74 | 118 000 |

| 04 | RTX 4080 16 ГБ, 2505—2725/22400 | 875 | 74 | 118 000 |

| 05 | RTX 3090 Ti 24 ГБ, 1860—1965/21000 | 765 | 84 | 91 000 |

| 06 | RTX 3090 24 ГБ, 1695—1965/19500 | 711 | 92 | 77 000 |

| 08 | RX 6950 XT 16 ГБ, 2310—2525/18000 | 650 | 78 | 83 600 |

| 09 | RX 6900 XT 16 ГБ, 2250—2470/16000 | 619 | 83 | 75 000 |

В данном случае лидерство RTX 4080 выражено еще более ярко относительно флагманов AMD вследствие большего падения производительности у тех при включении RT. В среднем прирост производительности относительно RTX 3090 Ti по всем разрешениям составляет 14%, а в разрешении 4К — 20%. Разница же в производительности с RX 6950 XT в данном случае составляет 34% по всем разрешениям и аж 78%(!) в 4К.

Рейтинг полезности

Рейтинг полезности тех же карт получается, если показатель предыдущего рейтинга разделить на цены соответствующих ускорителей. Для расчета рейтинга полезности использованы розничные цены на середину ноября 2022 года. Учитывая нацеленность RTX 4080 на разрешение 4К, мы привели рейтинг, подсчитанный только при использовании разрешения 3840×2160. Поэтому цифры отличаются от рейтинга iXBT.com.

- Вариант рейтинга полезности без включения RT

| № | Модель ускорителя | Рейтинг полезности | Рейтинг iXBT.com | Цена, руб. |

|---|---|---|---|---|

| 14 | RTX 3090 24 ГБ, 1695—1965/19500 | 84 | 650 | 77 000 |

| 15 | RX 6900 XT 16 ГБ, 2250—2470/16000 | 84 | 631 | 75 000 |

| 16 | RX 6950 XT 16 ГБ, 2310—2525/18000 | 81 | 675 | 83 600 |

| 17 | RTX 3090 Ti 24 ГБ, 1860—1965/21000 | 78 | 710 | 91 000 |

| 18 | RTX 4090 24 ГБ, 2520—2640/21000 | 77 | 1050 | 136 000 |

| 19 | Palit RTX 4080 GameRock, разгон до 3015/24500 | 71 | 843 | 118 000 |

| 20 | Palit RTX 4080 GameRock, 2505—2850/22400 | 70 | 827 | 118 000 |

| 21 | RTX 4080 16 ГБ, 2505—2725/22400 | 70 | 823 | 118 000 |

Конечно же, сразу бросается в глаза, что начальная стоимость RTX 4080 высоковата, однако мы не знаем, на сколько цена упадет с относительно массовом появлением в продаже таких карт. Ибо даже RTX 4090 пока получается более выгодным.

- Вариант рейтинга полезности с включением RT

| № | Модель ускорителя | Рейтинг полезности | Рейтинг iXBT.com | Цена, руб. |

|---|---|---|---|---|

| 10 | RTX 3090 Ti 24 ГБ, 1860—1965/21000 | 132 | 1200 | 91 000 |

| 12 | RTX 4090 24 ГБ, 2520—2640/21000 | 125 | 1705 | 136 000 |

| 16 | Palit RTX 4080 GameRock, разгон до 3015/24500 | 121 | 1432 | 118 000 |

| 17 | Palit RTX 4080 GameRock, 2505—2850/22400 | 119 | 1407 | 118 000 |

| 18 | RTX 4080 16 ГБ, 2505—2725/22400 | 119 | 1405 | 118 000 |

| 19 | RX 6900 XT 16 ГБ, 2250—2470/16000 | 111 | 832 | 75 000 |

| 20 | RX 6950 XT 16 ГБ, 2310—2525/18000 | 107 | 891 | 83 600 |

Да, «ахиллесова пята» карт AMD 6000-й серии (падение FPS от трассировки лучей) и здесь четко видна: сейчас уже нет смысла приобретать флагманы AMD 6000-й серии вообще. А вот RTX 3090 Ti еще будут какое-то время популярны из-за упавших на них цен и с учетом завышенных в первое время цен на RTX 40хх. Так оно и вышло: RTX 3090/3090 Ti пока значительно выгоднее.

Выводы

Nvidia GeForce RTX 4080 (16 ГБ) — один из лидеров игровой 3D-графики для ПК, уступающий на текущий момент лишь топовому GeForce RTX 4090. При всё еще очень высокой производительности он имеет немного более низкую стоимость, которая, впрочем, на старте продаж может быть сильно завышена. Наши исследования показали, что между GeForce RTX 4090 и GeForce RTX 4080 должен быть приличный разрыв по стоимости, иначе GeForce RTX 4090 будет оставаться более выгодным приобретением для энтузиастов. На сегодня же разница в цене между этими ускорителями слишком уж невелика, тогда как по скорости они отличаются заметно. Если брать рекомендованные цены для североамериканского рынка, то оправданная возможностями и производительностью цена на модель GeForce RTX 4080 не должна превышать $1000, иначе по соотношению этих характеристик старшая модель явно выигрывает.

Если GeForce RTX 4090 имеет GPU с просто фантастическим количеством активных вычислительных блоков, включая текстурные, тензорные и RT-ядра, то у GeForce RTX 4080 суммарное количество потоковых процессоров меньше, чем у GeForce RTX 3090 Ti, но всё же он намного быстрее. Здесь сыграли свою роль более тонкий техпроцесс и сильно повышенные частоты работы ядра, а также несколько более высокая ПСП, плюс, конечно же, элементы новой архитектуры с увеличенными кэшами.

Как и в случае GeForce RTX 3090/Ti и GeForce RTX 4090, изюминкой нового ускорителя является поддержка разрешения 8К, поскольку GeForce RTX 4080 уже обладает достаточной производительностью, чтобы некоторые игры с использованием DLSS обеспечивали игроку нормальный комфорт на максимальных настройках графики в 8К (а когда в игры массово внедрят поддержку DLSS 3, комфорт станет еще выше). Объема памяти в 16 ГБ еще долго будет достаточно для игр даже в столь высоком разрешении. Наши тесты показали, что у GeForce RTX 4080, как и у GeForce RTX 4090, заметно повышена эффективность блоков трассировки лучей, обновлены тензорные ядра, так что чем больше та или иная игра использует возможности RT, тем заметнее будет превосходство нового поколения.

Как мы уже отметили, в новой архитектуре Ada Lovelace возможности исполнительных блоков были серьезно улучшены, особенно это касается аппаратной трассировки лучей. Само определение пересечений луча и треугольника в третьем поколении RT-ядер было ускорено вдвое, но еще интереснее дополнительные аппаратные блоки в RT-ядрах: Opacity Micromap Engine, ускоряющий обработку полупрозрачных объектов, вроде языков пламени и листьев, и Displaced Micro-Mesh Engine, способный снизить время построения структур BVH и сократить требования к объему геометрических данных для очень сложных объектов. Еще одна важная новая возможность — переупорядочивание выполнения шейдеров при трассировке лучей — Shader Execution Reordering. Специальный планировщик способен на лету оптимизировать загрузку вычислительных блоков мультипроцессора SM, что потенциально может обеспечить двух-трехкратное ускорение для многих алгоритмов трассировки лучей.

Отдельно стоит упомянуть и новую версию DLSS 3, использующую ускоритель оптического потока Optical Flow Accelerator, улучшенный в архитектуре Ada Lovelace. DLSS 3 использует как масштабирование разрешения из DLSS 2, так и удвоение частоты кадров при помощи вставки промежуточных, используя поле оптического потока. Данные из него комбинируются с векторами движения, и искусственный интеллект при помощи тензорных ядер генерирует промежуточные кадры, чтобы видеоряд был плавнее. А для того, чтобы задержки при этом не слишком увеличивались, используется известная технология компании Reflex. В результате игрок может получить вдвое больше кадров в секунду при визуальном качестве, сравнимом с DLSS 2.

Конкретная протестированная нами карта Palit GeForce RTX 4080 GameRock (16 ГБ) — это опять-таки очень производительное решение для энтузиастов, желающих играть как минимум в 4K при максимальных настройках графики, причем без компромиссов. Однако следует помнить, что длина карты в 33 см позволит уместить ее далеко не в каждый корпус. При этом видеокарта еще и очень толстая, она занимает 4 слота в корпусе, что надо учитывать при планировании апгрейда своего ПК. В комплекте поставки есть поддерживающий штатив с опорой на дно корпуса, поэтому за прогибание карты в системном блоке можно не волноваться (к тому же жесткая рама в конструкции самой карты помогает ей не провисать даже без опоры). В целом данная карта точь-в-точь похожа на свою сестру на базе GeForce RTX 4090. Система охлаждения тихая в обоих режимах BIOS. Карта может потреблять до 350 Вт (даже ручной разгон не способен преодолеть эту планку), она требует использовать три 8-контактных разъема питания (которые подключаются к прилагаемому переходнику на 16-контактный разъем на самой плате), так что наличие мощного БП обязательно! Особо отметим, что такой переходник питания ни в коем случае нельзя изгибать непосредственно после 16-контактного разъема. А еще лучше заиметь современный БП ATX 3.0 с наличием отдельного кабеля для подключения питания к таким картам напрямую. Конечно же, требуется хорошо продуваемый корпус, поскольку почти весь нагретый воздух видеокарта оставляет внутри системного блока.

Производитель декларирует наличие 3-летней гарантии на эту карту.

Отметим еще раз, что GeForce RTX 4080 отлично подходит для игры в разрешении 4К с максимальным качеством графики с трассировкой лучей даже без DLSS, а в ряде игр с поддержкой DLSS можно получить приемлемый комфорт и в разрешении 8К. Также отметим поддержку стандарта HDMI 2.1, позволяющего выводить 4K-изображение со 120 FPS или 8K-разрешение при помощи одного кабеля, поддержку аппаратного декодирования видеоданных в формате AV1, технологию RTX IO, способную обеспечить быструю передачу и распаковку данных с накопителей прямо в GPU, а также технологию снижения задержек Reflex, полезную для киберспортсменов. Разумеется, выход RTX 40 означает начало распространения DLSS 3, но об этой технологии мы поговорим отдельно, когда в свет выйдут соответствующие патчи для популярных и используемых нами игр, а также новые игры с уже реализованной поддержкой DLSS 3.

Справочные материалы:

- Руководство покупателя игровой видеокарты

- Справочник по AMD Radeon HD 7xxx/Rx

- Справочник по Nvidia GeForce GTX 6xx/7xx/9xx/1xxx

В номинации «Оригинальный дизайн» карта Palit GeForce RTX 4080 GameRock (16 ГБ) получила награду:

В номинации «Отличная поставка» карта Palit GeForce RTX 4080 GameRock (16 ГБ) получила награду: