В период с 27 по 29 октября 2010 года в рамках пресс-тура группа журналистов из России посетила CERN и центры разработки Intel в Германии. В данной статье будет рассказано о результатах проведенных встреч.

Наверняка многие слышали про CERN, научно-исследовательский центр Европейского совета по ядерным исследованиям (Conseil Europeen pour la Recherche Nucleaire), расположенный в Швейцарии, под городом Женева недалеко от границы с Францией. Кстати, благодаря близости Франции многие приезжие, работающие в CERN, снимают квартиры именно там, так дешевле.

Наверняка многие слышали про CERN, научно-исследовательский центр Европейского совета по ядерным исследованиям (Conseil Europeen pour la Recherche Nucleaire), расположенный в Швейцарии, под городом Женева недалеко от границы с Францией. Кстати, благодаря близости Франции многие приезжие, работающие в CERN, снимают квартиры именно там, так дешевле.

В CERN расположен Large Hadron Collider (LHC, Большой Адронный Коллайдер). В двух словах расскажем, что это такое и зачем создано. Большой Адронный Коллайдер — это ускоритель частиц в виде закольцованной трубы длинной 27 км, которая закопана в землю. В трубе LHC ускоряют адроны, частицы, состоящие из трёх кварков. Частицы разгоняют в противоположных направлениях и сталкивают, собственно процесс столкновений это и есть коллайдер. Процесс столкновения фиксируют и изучают полученные данные.

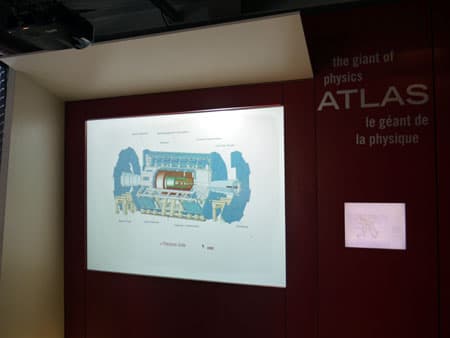

Место для LHC выбиралось исходя из набора критериев, в частности гранитные породы гарантируют стабильность трубы-ускорителя. В четырех местах LHC расположены лаборатории, одну из которых, Atlas, мы посетили.

Именно в Atlas расположена камера, в которой происходит столкновение частиц и фиксация его результатов. Про то, чем занимается CERN и для чего создан LHC, рассказал Sergio Bertolucci (Серджио Бертолучи), директор по исследовательским и научным расчетам CERN.

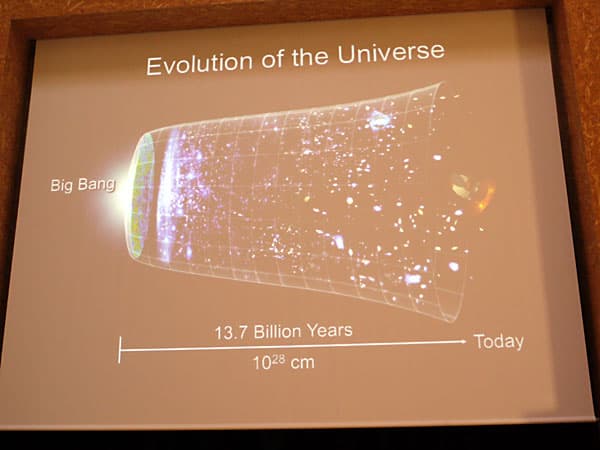

Чтобы узнать, что происходило в момент образования вселенной и как это происходило нет иного способа, как смоделировать этот процесс. Кроме того, есть ряд теорий, которые требуют экспериментального подтверждения, потому что в науке нет демократии — все решается не путем голосования, а экспериментами, которые можно независимо повторить и подтвердить результаты и выводы. Впрочем, демократия в науке есть, ведь доступ к результатам исследований получают все желающие.

Одной из основных целей экспериментов на LHC является доказательство существования бозона Хиггса — частицы, предсказанной шотландским физиком Питером Хиггсом в 1960 году. Бозон Хиггса является квантом так называемого поля Хиггса, при прохождении через которое частицы испытывают сопротивление, представляемое как поправки к массе. Сам бозон нестабилен и имеет большу́ю массу (более 120 ГэВ/c²). На самом деле, физиков интересует не столько сам бозон Хиггса, сколько хиггсовский механизм нарушения симметрии электрослабого взаимодействия. Именно изучение этого механизма, возможно, натолкнёт физиков на новую теорию устройства вселенной.

Конечно, кроме экспериментального подтверждения существования частицы Хиггса будут проверяться и другие теории, например теория суперсимметрии, согласно которой во вселенной у каждой элементарной частицы есть гораздо более тяжёлая античастица. Например у бозона должен быть фемион. Также в рамках экспериментов на LHC могут быть получены доказательства существования темной материи, но создать черную дыру не получится, т. к. все подтверждения могут быть получены лишь косвенно.

Чтобы поймать частицу Хиггса, нужно произвести столкновение частиц, а именно протонов, при энергии не менее 5 ТэВ, сейчас LHC работает при энергиях 2,3 ТэВ, что само по себе уже рекордное значение. Создавался же LHC в расчете на достижение энергий порядка 7 ТэВ. Внутри LHC частицы разгоняются до 99,9% скорости света. Для удержания, коррекции и фокусировки протонных пучков используются 1624 сверхпроводящих магнита, общая длина которых превышает 22 км. Магниты работают при температуре 1,9 K (−271 °C), что немного ниже температуры перехода гелия в сверхтекучее состояние.

Стоимость проекта колоссальна, поэтому он реализован за счет финансирования разных стран, в частности и России. Для сравнения, за вложенные средства можно было несколько раз с нуля разработать программу полетов на Луну и слетать туда.

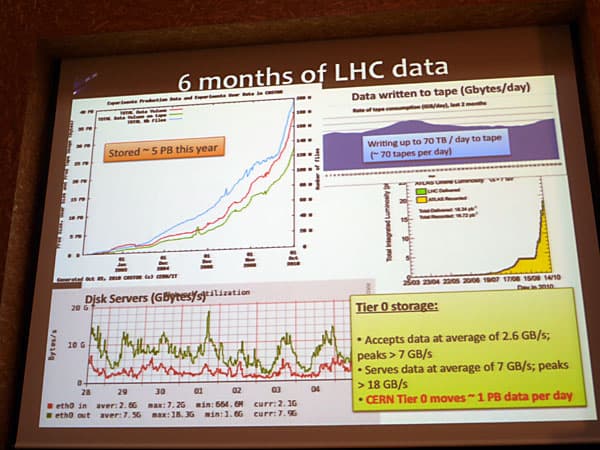

Сегодня к данным, получаемым на базе LHC, имеют доступ более 140 научных центров. В сутки сохраняется порядка 70 ТБ собранных данных, а массив собранной информации уже превышает 100 ПБ дискового пространства. Тут нужно пояснить, что система сбора и хранения данных, получаемых при работах на базе LHC, устроена иерархически. Первое кольцо (Tier 0), расположенное в самом CERN выполняет задачу первоначального накопления и раздачи данных в 11 международных центров (Tier 1) по 10 Гбит оптическим каналам связи. Tier 0 записывает результаты испытаний на базе LHC со средней скоростью 2,6 ГБ/с, в пике до 7 ГБ/с и передает наружу, во внешние дата-центры данные со средней скоростью 7 ГБ/с (в пике до 18 ГБ/с). В итоге в сутки передается до 1 ПБ данных.

По сути Tier 1 это дублирующая сеть хранения данных, полученных в результате испытаний на базе LHC, но кроме хранения эти дата-центры раздают данные научным центрам и лабораториям (Tier 2), которые уже занимаются анализом. В кольцо Tier 2 входят научные подразделения из разных стран мира, в частности и из России.

Описанная организация сбора данных и их передачи для анализа обеспечивает избыточную надежность, что гарантирует отсутствие сбоев в работе.

Кстати, на случай если частицу Хиггса не обнаружат экспериментально, уже есть теории объясняющие всё и без неё. Впрочем, серьезные физики считают, что частицу обнаружат, это вопрос времени. Сейчас LHC калибруют и отлаживают, т. е. проверяют на практике все давно известные и доказанные физические события, за счет чего и проверяют правильность и точность работы LHC и главное всего массива датчиков. Потому что от того где и как что-то ищем зависит результат.

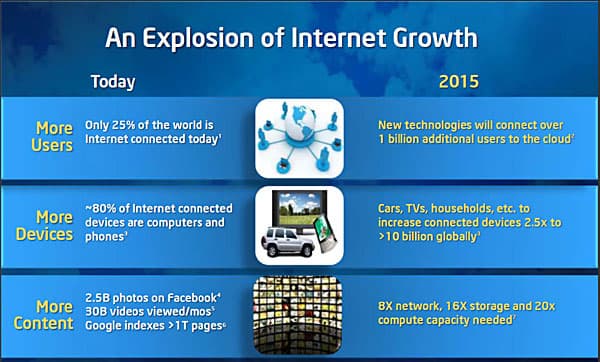

Поездка в CERN была не просто ради расширения общих знаний о том, что такое LHC. В CERN Globe (специально построенное здание в виде шара для проведения конференций) вице-президент BMW Group и руководитель её IT-инфраструктуры — Марио Мюллер (Mario Mueller), официально анонсировал создание нового индустриального альянса — Open Data Center Alliance. Идея альянса простая и очевидная. В современном мире нужно обеспечивать клиентов сервисами по всему миру, поэтому международные компании, такие как автоконцерны, банки, нефтеперерабатывающие предприятия и т. д. вынуждены создавать множество дата центров и сетевую инфраструктуру. Это очень дорого и с каждым витком технологий становится всё более дорогим удовольствием. Но если объединиться, создавая дата-центры и совместно использовать их ресурсы, то затраты снижаются. Кроме задачи снижения расходов на создание и содержание дата-центров, альянс планирует вырабатывать рекомендации по стандартизации в области аппаратных и программных решений. Любые стандарты опять же способствуют снижению стоимости конечных решений.

Понятно, что идея объединения ресурсов разных дата-центров и совместный доступ к ним — это и есть облачные вычисления. Причем не просто какие-то абстрактные, а что ни на есть реальные. Потому что когда говорят о том, что облачные вычисления очень нужны конечному пользователю — это довольно туманно и размыто. Да, здорово имея в кармане MID получать доступ к приложениям и базам, да вот только основным узким местом будет связь. Причем нужна не просто связь, а широкополосный доступ, да еще и мобильный. И пока такой широкополосной связи не будет повсеместно, облачные сервисы останутся уделом корпоративного сектора.

Возглавляют альянс такие компании, как BMW, Shell и UBS, а в качестве технологического советника приглашена корпорация Intel.

Почему в качестве технологического советника выбрана была корпорация Intel? Дело в том, что в области облачных вычислений именно Intel имеет нужный уровень экспертизы и опыта. Этой теме было посвящено выступление вице-президента Intel, возглавляющего Intel Artchitect Group, Бойда Девиса (Boyd Davis).

Облачные вычисления в понимании Intel базируются на трех принципах: эффективность (оптимизация энергопотребления и трудовых ресурсов), простота (дата-центры строятся так, чтобы не было излишних усложнений и ненужных кабельных структур) и безопасность (снижение рисков и повышение устойчивости за счет применения гибридных моделей).

Корпорация Intel занимается вопросами облачных вычислений уже давно. Понятно, что сегодня сам термин «облачные вычисления» в моде, но от названия суть не меняется. Суть же в том, что организация вычислительных массивов в виде кластеров из серверов или массивов серверов, устанавливаемых в дата-центрах, а также модернизация существующих серверных мощностей — области, непосредственно входящие в сферу интересов Intel, лидера в разработке и производстве микропроцессоров и решений для высокоскоростных вычислений (HPC, High performance computing). Потребность в вычислительных мощностях с каждым годом лишь возрастает. При этом просто наращивать количество серверов невозможно — есть ограничивающие факторы, в виде энергопотребления и охлаждения. Разумеется, нельзя забывать и такой важный момент, как стоимость конечного решения, включая стоимость владения. Финальным штрихом в изменениях на рынке HPC стала потребность в публичном доступе к вычислительным мощностям и к хранилищам данных, наряду с традиционным широким использованием всего этого в корпоративном секторе.

По сути облачные вычисления это результат естественной эволюции информационных технологий, главным положительным моментом от их применения является масштабируемость, в зависимости от потребностей потребителей. Тем не менее, пока не всё безоблачно в области облачных вычислений. Главный вопрос, волнующий потребителей — безопасность информации. Затем в списке идут энергопотребление, отсутствие единых стандартов, высокая стоимость владения и т. д. Корпорация Intel имеет богатый и успешный опыт в построении дата-центров с парадигмой облачных вычислений и решении вопросов, волнующих потребителей, на современном эффективном уровне. Всё это обеспечивается за счет внедрения серверных решений на базе архитектуры Xeon.

Текущая платформа Xeon характеризуется высокой энергоэффективностью и производительностью, а также поддержкой на аппаратном уровне инструкций для шифрования данных (AES) и технологии TXT (Trusted Execution Technology), предотвращающей запуск вредоносного ПО. Завершают целостную картину решения для хранения данных на основе SSD и для сетевой инфраструктуры (оптические сетевые интерфейсы, обеспечивающие соединение сетевых узлов на скоростях 10 Гбит/с).

Для упрощения внедрения партнерами проектов по созданию дата-центров, корпорацией Intel поддерживается специальная программа Cloud Builder, в рамках которой ведутся разработки новых решений и инструментов, организуются совместные лаборатории, тестируются идеи и внедряются оптимальные продукты. По сути Intel предлагает готовые блоки для построения масштабируемых дата-центров, энергоэффективных и оптимальных по затратам на владение.

После посещения CERN мы переместились в офис Intel, расположенный недалеко от Мюнхена (Munchen) в городке Feldkirchen (Фелдькёрхен). Здесь работы ведутся по трем основным направлениям: активное участие в различных образовательных программах, инициатива Intel Open Labs и кооперация с автомобильной промышленностью.

Про участие корпорации Intel в образовательных программах рассказала Дайана Каасерер (Diana Kaaserer), которая прекрасно владеет русским языком.

Известно, что Intel финансирует ряд образовательных проектов. Зачем это нужно? Дело в том, что корпорация не без оснований считает, что вложения в образование окупаются сторицей. Образование ускоряет внедрение инноваций. Это легко проиллюстрировать на простейшем примере. Выдайте школьникам персональные компьютеры. Что они будут делать с ними? В лучшем случае найдут игру из комплекта поставки и будут играть. Научите школьников использовать компьютер для доступа в интернет и поиска информации, например, для подготовки доклада к уроку. Теперь у них в руках удобный инструмент образования. И так с любыми инновациями — если пользователи не знают, как их применять, толку от инноваций не будет. Именно поэтому образовательные программы так важны и поддерживаются Intel во многих странах мира. Корпорация фокусируется на трех основных направлениях: подготовка преподавательского состава, технологическое оснащение и участие в международных программах (под эгидой ООН, Юнеско и т. д.). К настоящему времени переподготовку по программам, поддерживаемым Intel, прошли уже более 7 миллионов учителей в 50 странах мира. Кроме того, Intel активно поддерживает различные математические олимпиады и летние школы по параллельному программированию. Именно хорошее владение математикой и программированием позволит сегодняшним школьникам завтра двигать ИТ-индустрию вперед.

Затем Дитер Хоффенд (Dieter Hoffend), глобальный менеджер Intel по связям с BMW Group и Daimler, рассказал о структуре под названием Intel Open Labs, объединяющей подразделения корпорации, расположенные в разных городах.

Идея Open Labs заключается в том, что к исследованиям в области новых технологий привлекаются специалисты, которые не являются сотрудниками корпорации Intel. Принципы работы просты и очевидны — все получают возможность заниматься исследованиями и все обязаны делиться полученными результатами. В итоге к работе над проблемой привлекаются специалисты Intel из разных офисов и ученые из профильных университетов и профессионалы из других компаний, пожелавших участвовать в совместном решении задачи.

Подразделение в Мюнхенском офисе занимается вопросами внедрения ИТ-решений в автомобильной промышленности, а сами исследования идут в областях управления движением и автомобильных инфоразвлекательных систем (IVI или In-Vehicle Infortainment). Вот о том, как идут работы в области универсальной системы для доступа к информации и развлечениям в автомобиле нам и рассказали подробнее. В настоящее время каждый автоконцерн использует в качестве инфоразвлекательной системы свою собственную разработку. Корпорация Intel предложила универсальную стандартную платформу на базе процессоров Atom и операционной системы MeeGo, которую решили внедрять концерны BMW и Daimler. Серьезную заинтересованность в проекте проявила и компания Nissan Motor.

Применение универсальной платформы позволит снизить затраты на разработку новых решений и упростит создание линейки инфоразвлекательных комплексов. Использование открытой программной среды расширяет спектр доступных приложений. Подчеркнем, что пока речь не идет о бортовых компьютерах автомобилей, управляющих системами активной безопасности, двигателем и прочей электроникой, связанной с движением. Но даже применение универсальной платформы в инфоразвлекательных целях — уже технологическая революция, учитывая специфику автомобильной отрасли. Проблема в том, что все новации в автопромышленности внедряются очень медленно по меркам ИТ-индустрии — стандартный цикл от идеи до конвейера занимает до шести лет.

Что даст внедрение универсальной платформы Intel в автомобилях для конечных пользователей? Кроме уже привычных вещей, таких как прослушивание радио, музыки, GPS-навигации и просмотра видео, пользователям предлагается концепция Connected Vehicle. Идея в том, что пользователь, передвигаясь на машине, остается подключенным к нужным сервисам через интернет, его коммуникатор синхронизирует почту, список дел и контакты с бортовым компьютером, но самое интересное — внедрение проекта DSRC (Dedicated Short-Range Communication, специальный канал связи на коротких дистанциях). Применение DSRC позволит связать бортовой компьютер автомобиля с управляющим центром дорожной инфраструктуры. В результате компьютер диспетчера будет знать расположение автомобилей и их скорость, что позволит гибко управлять работой светофоров и дорожных знаков, а при необходимости направлять в точное местоположение машины полиции и скорой помощи.

Интереснаю идея есть в BMW — сделать интернет-магазин по модернизации авто. Скажем вы покупаете бюджетную версию машины, в которой электроникой ограничена мощность двигателя и его динамика. Но при необходимости можно будет прямо за рулем купить на пару часов разблокировку и получить мощную машину за небольшие деньги. Идея пока на уровне курьезов, но кто знает, куда заведет вендоров желание заработать еще денег.

Затем мы переместились в город Braunschweig (Брауншвайг), где расположен еще один офис Intel, занимающийся разработками в области микропроцессорных архитектур.

Sebastian Steibl (Себастиан Штейбл) — глава подразделения Intel в Брауншвайге рассказал историю создания центра разработок. В 2000 году была образована компания Giga Germany GmbH, которую в 2001 году приобрела корпорация Intel и на её базе было создано подразделение в Брауншвайге. В 2003 году в Брайншвайге была открыта лаборатория проверки качества оптических сетей (Intel Optical Networking Validation Lab). В 2004 году разработанный в Брайншвайге оптический сетевой контроллер шестого поколения (Tenabo) начал производиться в массовых количествах и был закуплен девятью из десяти крупнейших мировых телекоммуникационных компаний. С 2005 года подразделение в Брауншвайге переориентировано на разработки в области архитектур микропроцессоров. В 2006 году подразделение преобразовано в исследовательский центр Intel в Германии.

Sebastian Steibl на заднем плане, а Michael Konow на переднем плане

С 2007 года более 120 инженеров в Брайншвайге занимаются R&D и создают завтрашние и послезавтрашние процессоры.

В 2010 году крупнейшему в Европе подразделению Intel, занимающемуся R&D в области архитектур микропроцессоров в Брауншвайге исполнилось десять лет.

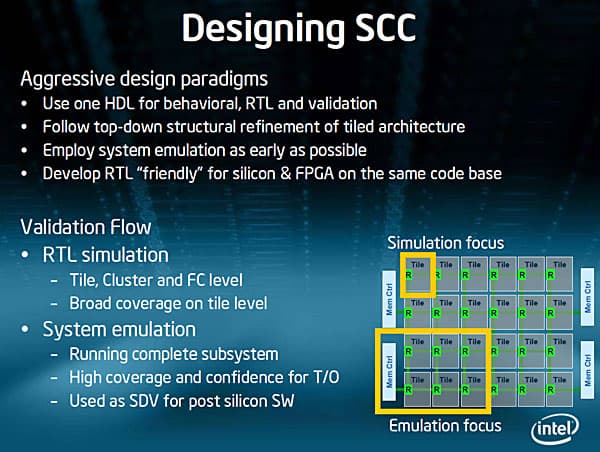

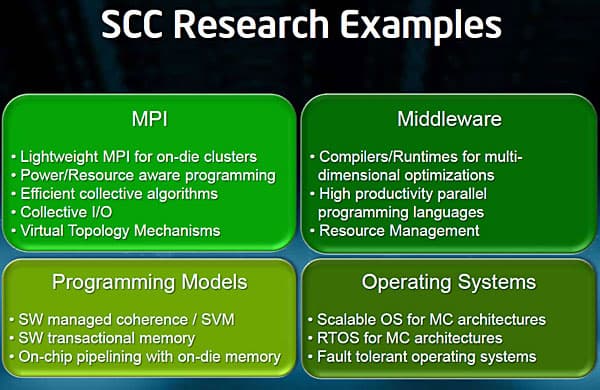

Сегодня все понимают, что постоянное наращивание объемов памяти и/или количества процессоров при жестких требованиях к энергоэффективности является конечным во времени процессом. Но производительности не бывает много. Поэтому в Брайншвайге занимаются разработкой Single-Chip Cloud Computer (SCC, облачные вычисления на базе одного чипа или суперкомпьютер в одном чипе), который содержит 48 вычислительных ядер. Сразу подчеркнем, речь не идет о создании конечного продукта, который будет массово производиться и продаваться. Это в чистом виде исследовательский проект. Кроме исследований в области многоядерных процессорных архитектур (Tera-Scale Processor Architecture) и разработки прототипов, исследования в Брауншвайге направлены на решение проблемы с объемами памяти (т. н. memory wall, когда наращиванию объемов оперативной памяти мешают проблемы в виде ограничения количества контактов и сложность в разводке печатных плат). Особое внимание в центре уделяют работе с эмуляторами, позволяющими оптимизировать архитектуры процессоров без изготовления дорогостоящих образцов, исполненных в кремнии. Кроме того, часть проектов ведется совместно с университетами и в рамках академических исследовательских программ.

В частности, в Брауншвайге разработаны архитектурные проекты микропроцессоров для изготовления по технологическим нормам вплоть до 22 нм. Именно в этом исследовательском центре проводились и проводятся программы по эмуляции и проверке на качество таких процессорных архитектур, как Westmere, Haswell и перспективных решений по программе многоядерных процессоров (Many Integrated Core, MIC). Собственно и центр компетенции региона EMEA в области решений выскопроизводительных вычислений (HPC) находится именно в Брауншвайге.

Подробнее про проект SCC рассказал Michael Konow (Микаэль Конов).

Такие проекты, как SCC и Larrabee объединяются в рамках общей идеи по перспективным разработкам в области многоядерных процессорных архитектур (Many Integrated Core, MIC), суть которой как раз в ускорении параллельных вычислений. Кстати, одним из первых примеров применения MIC является специальный внутренний тест, написанный на C++ в лаборатории CERN, который используется для оценки производительности серверов.

Мотивацией для начала работ в области SCC был ряд факторов. Среди которых важнейшими являются: создание высокопроизводительных и при этом энергоэффективных вычислительных систем с использованием программной поддержки в виде системы обмена сообщений (message based), которая применяется в серверных кластерах. Такие начальные условия выбраны с целью более легкого перехода на перспективные аппаратные решения с сохранением наработанных программных решений. Потому как именно исследования в области параллельного программирования (включая языки программирования, библиотеки и операционные системы), точнее результаты таких исследований, позволят полноценно использовать масштабируемые аппаратные решения с применением SCC.

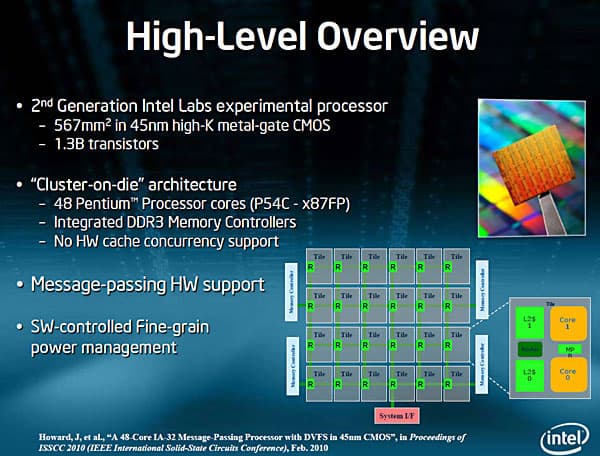

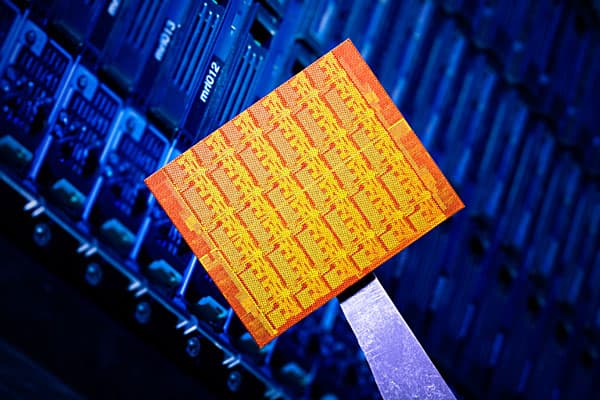

Работы в области many-core (многоядерных) решений в лаборатории Брайншвайга идут с 2006 года и в частности тут велись работы над Larrabee. Текущая разработка это уже второе поколение экспериментальных процессоров. SCC содержит 48 процессорных ядер, встроенный контроллер памяти DDR3 и аппаратную поддержку системы обмена сообщений. В качестве ядер в SCC используются старые добрые Pentium P54C. Выбор обусловлен исключительно простотой, доступностью и сбалансированностью данных CPU для поставленных задач. В кремнии SCC занимает площадь 567 кв. мм, содержит 1,3 миллиарда транзисторов и производится по 45 нм High-K CMOS технологическому процессу.

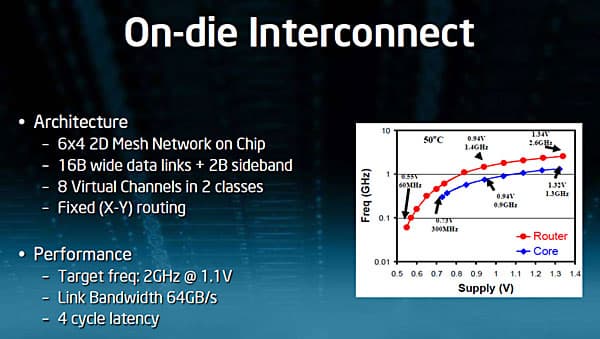

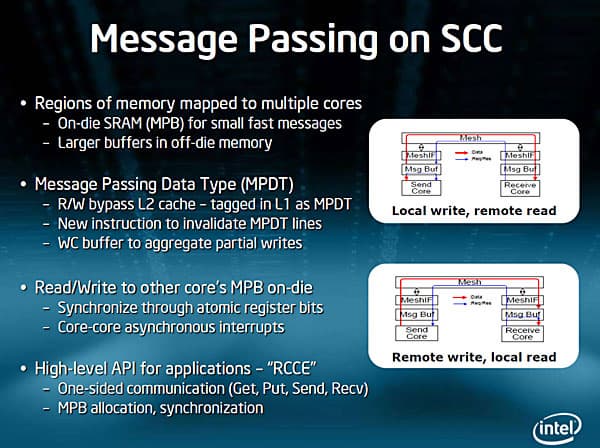

Итак, на одном чипе SCC объединено 24 двухъядерных процессора, по сути реализована архитектура кластера, когда много компьютеров объединены, например, через InfiniBand соединение. Отсюда и применение термина cloud (облако). Зато в случае объединения нескольких процессоров в одном чипе сразу устраняется проблема интерконнекта — все делается по внутренней шине и бесплатно в смысле топологии, задержек и прочего. Внутренний интерконенкт построен на основе архитектуры обмена сообщений, которая давно применяется в индустрии, с фиксированной длиной пути и частотой 2 ГГц.

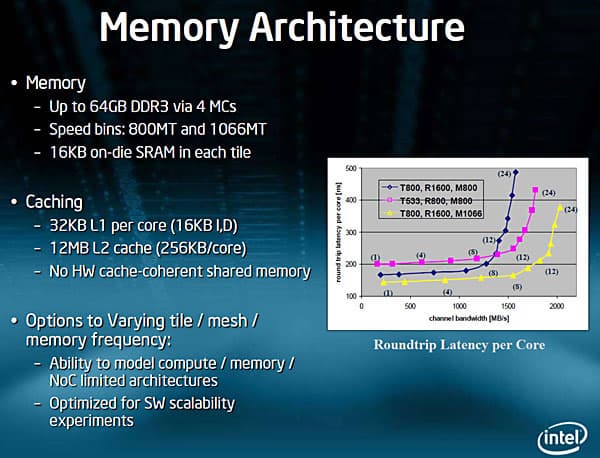

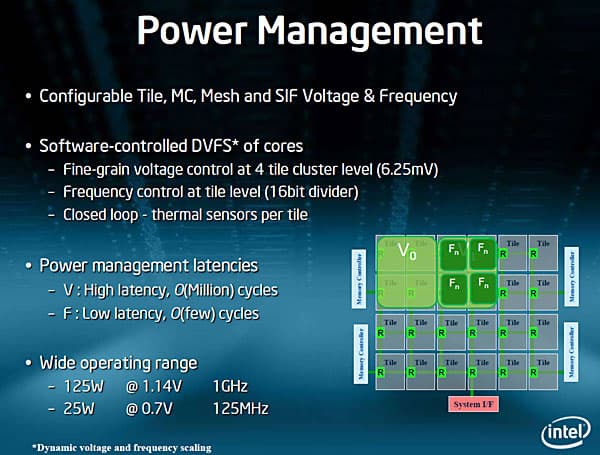

Для каждого тайла (тайл или блок состоит их двухъядерного процессора) можно индивидуально и динамически изменять тактовую частоту и напряжение. В SCC применяется четырехканальный контроллер памяти, по одному каналу на каждые 12 ядер. Каждый канал памяти поддерживает установку до 16 ГБ DDR3 (всего до 64 ГБ на SCC), при этом память работает на частоте 800 МГц. Если бы память работала на штатной частоте в 1600 МГц, то тогда каждый контроллер памяти мог бы обслуживать лишь восемь процессорных ядер при приемлемом уровне задержек (латентности).

Каждое ядро SCC может читать буфер с сообщениями (message buffer), а управляющее программное обеспечение может проверять корректность содержимого буфера. Буфер сообщений образуется из L1-кэша каждого ядра.

SCC разделен на шесть блоков по восемь ядер, каждый из которых имеет отдельную линию электропитания. При этом каждая пара ядер может иметь индивидуальную тактовую частоту. SCC построен по принципу тайловой архитектуры (tile-based), т. е. из блоков, что обеспечивает гибкость как в смысле сокращения блоков, так и их наращивания для масштабирования вычислительных возможностей.

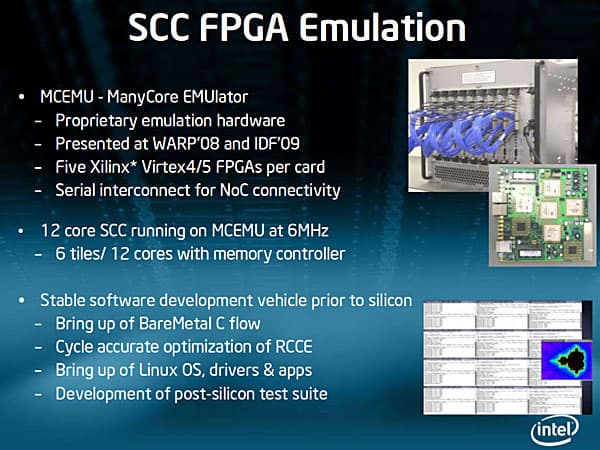

Основная масса архитектурных тестов проводится на одном тайле (2 процессорных ядра). Этого достаточно. Часть тестов проводится на кластере из шести тайлов. При этом большая часть тестов ведется не на реальных ядрах, а на FPGA-эмуляторе (кстати и тестирование программного обеспечение в основном проводят на эмуляторах). Дело в том, что для освоения программирования под многоядерные системы, чтобы научиться строить сложные параллельные системы и управлять ими — достаточно эмуляторов. Причина проста — параллелизм на уровне аппаратной части развивается и внедряется быстрее, чем параллелизм на уровне программного обеспечения.

Тем не менее есть реализация SCC и в виде реальных процессорных ядер, собранных на одной подложке, а комплекты (в разных вариантах реализации) для разработчиков носят общее кодовое имя Knights Ferry.

На фото выше можно посмотреть на структуру SCC и тестовую систему с реальным 48-ядерным чипом. Есть вариант SCC в виде карты расширения с интерфейсом PCI. Именно в таком виде SCC обычно рассылают разработчикам, т. к. это проще в использовании с имеющимся оборудованием.

Первая реализация SCC, которую планируется поставлять на рынок в виде готовых решений носит кодовое имя Knights Corner. Этот продукт ориентирован на высокопроизводительные вычисления, в частности, в научной, финансовой и гидрометеорологической сфере. Он будет изготавливаться по нормам 22 нм. Количество ядер в этом процессоре будет более 48 (точнее Intel говорит о более чем 50 ядрах). Ожидается, что архитектура Intel Many Integrated Core (MIC) поможет кардинально ускорить выполнение хорошо распараллеленных приложений.

В Брайншвайге нам было показано, как работает SCC. На тестовых стендах используется специальная версии операционной системы SCC Linux, адаптированная под многоядерные системы. Сами SCC выполнены под стандартный процессорный разъем LGA 1567, применяемый для Xeon. На одном из ядер запускается сама ОС, а на других запускаются отдельные приложения или диспетчер отдает приложению нужное количество ядер. Впрочем, на каждом ядре можно запускать свою отдельную ОС. Неиспользуемые тайлы можно отключать.

Про инициативу MARC рассказал Ulrich Hoffman (Улрик Хофман).

Впервые Intel открывает доступ к своим перспективным разработкам всем желающим. Условие простое — вы должны заниматься параллельными вычислениями и взамен на доступ к эмулятору и реальному «железу» должны делиться результатами своих исследований. Всё справедливо. При этом большинству хватает удаленного доступа для запуска приложений. В Орегоне (США) создан специальный SCC дата-центр, к которому получают доступ исследователи через VPN. Но если разработчику нужен доступ непосредственно к реальному «железу», например для замера температур или напряжений, то ему предоставляют работающие образцы SCС. В итоге вокруг SCC образовалось сообщество разработчиков, которое решили назвать по смыслу — Many-core Applications Research Community (MARC).

Сейчас в рамках MARC ведется более 50 исследовательских проектов. В ближайшие шесть месяцев ожидаются завершение части из них.

В качестве заключения хочется отметить, что сотрудники лабораторий корпорации Intel в Германии занимаются настоящими исследованиями и разработками, причем это их любимое дело. Никто их не подгоняет, не ставит нереальных сроков, не требует сделать всё сразу и именно завтра. Они веселые и расслабленные, у них нет стресса и нет проблем с финансированием. В результате исследований не всегда можно получить ожидаемый результат и далеко не всегда результат получается в нужные сроки и пригоден к внедрению на производстве. Руководство корпорации и акционеры это понимают, а еще есть понимание, что без вложения огромных финансовых средств в R&D сегодня, уже завтра может не оказаться готовых к применению на производстве технологий и архитектур, а значит нечего будет предложить рынку. Даже в период кризиса Intel не снизила объемы финансирования R&D, тратя на это более 60% годовой прибыли. Именно постоянное вложение финансовых средств в R&D является фундаментом успеха Intel на рынке высоких технологий.