Содержание

- Введение

- Новая вычислительная архитектура Volta

- Другие анонсы с ключевого выступления Дженсена Хуанга

- Первым делом — автопилоты

- Искусственный интеллект в трассировке лучей и профессиональное использование VRWorks

- Институт глубокого обучения для 100000 разработчиков в год

- Платформа для умных городов Metropolis

- Имитатор роботов Isaac и референсные платформы для роботов

- Роботы и другие практические применения ИИ

- Проект Endeavor — новый дом для компании Nvidia

- Выводы

Введение

Все знают, что компания Nvidia вот уже несколько лет занимается далеко не только традиционным для них рынком игровых графических процессоров, они постоянно пробуют другие рынки, открывая новые ниши. Не все их начинания были успешными, в мобильных устройствах дела толком так и не пошли, зато в сфере профессиональных графических и вычислительных решений дела компании продвигаются отменно. Более того, если в сегменте профессиональной графики их успехи известны давно, то на рынки процессоров для высокопроизводительных вычислений и автомобильных систем они вышли сравнительно недавно и уже имеют некоторый успех.

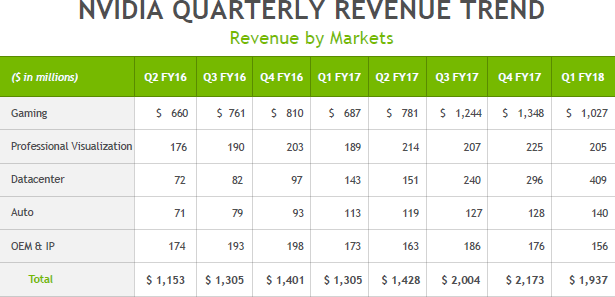

Например, если посмотреть на ежеквартальные финансовые отчеты Nvidia на протяжении пары последних лет (в таблице ниже приведены финансовые годы, отличающиеся от календарных), то можно отчетливо увидеть несколько интересных трендов. Так, несмотря на все сложности индустрии ПК, конкретно игрового применения они практически не касаются, и компания смогла значительно увеличить выручку в этой сфере за последние кварталы, а ведь именно ПК-игроки в основном и оплачивают разработки и в других сферах деятельности Nvidia, как минимум частично.

Но самое интересное в таблице совсем в других строчках. Если доходы от поставок профессиональных графических решений за пару лет практически не изменились, то в сфере автомобильных решений есть хоть и не огромный, но все же очень приличный двукратный рост за два года. Но самое важное кроется в строке Datacenter, которая и обозначает получающие все большее распространения решения для высокопроизводительных вычислений: серверов, дата-центров и т. д. Именно в этой сфере продажи выросли за два с небольшим года более чем в пять раз! Неудивительно, что Nvidia прикладывает большое количество сил для того, чтобы тренд продолжался. А пройдет несколько лет, и игровые решения компании и вовсе уступят первенство серьезным вычислительным задачам. Хотя ПК-игрокам в любом случае большой почет за то, что они оплачивают технический прогресс.

Кстати, а что такое высокопроизводительные вычисления вообще? К примеру, искусственный интеллект (ИИ), мощность которого растет в полтора-два раза каждый год, что позволяет разработчикам различных программно-аппаратных решений входить в различные сферы деятельности. Так, нейросети и прочие системы искусственного интеллекта, которым ранее тупо не хватало вычислительной производительности, уже сейчас умеют: полностью автономно пилотировать автомобили (этим сейчас занимаются практически все, начиная с Tesla), распознавать речь и быть интеллектуальными помощниками на мобильных устройствах (Siri, Cortana, Google Assistant, Bixby и другие), распознавать объекты на фото и видео и описывать их лучше человека, распознавать лица, увеличивать разрешение изображений (почти как в старых кинофильмах о спецслужбах), копировать голоса (стартап Lyrebird), играть во многие логические игры (шахматы и го) лучше человека, писать какие-никакие стихи, музыку, тексты (робот от стартапа Keywee пишет статьи и новости для издательств BBC, CNN, The New York Times, AOL и Forbes), рисовать картины на основе стилей существующих художников (Prisma), делать видеомонтаж (банальный Ассистент Google Photo на современном смартфоне делает из нескольких фотографий и видео один ролик — неидеально, но вполне приемлемо), приложение Google Now умеет подсказывать человеку то, что ему может пригодиться: расписание транспорта, прогноз погоды и т. д., помогать искать лекарства от болезней (очень много компаний), бороться со старением, помогать распознавать различные болезни, вроде различных видов рака, помогать при разработке нефтяных месторождений (поиск оптимальных мест для бурения), и многое-многое другое.

Взрывного роста от применения ИИ можно ожидать от любой из этих сфер, та же медицина вскоре должна сделать большой рывок в повышении эффективности и точности диагностики с применением систем обработки и систематизации анализов, использующих искусственный интеллект. Давно известно, что установка правильного диагноза является важнейшей задачей, да и при лечении системы ИИ применяться будут. Одна из североамериканских компаний уже получила одобрение контролирующих органов на использование подобной системы с применением искусственного интеллекта для расшифровки результатов обследований сердечно-сосудистой системы, и это только начало.

Уже сейчас во многих областях ИИ выполняет задачи лучше и/или быстрее человека, и это будет лишь усугубляться. Если добавить к указанному выше и различных роботов, то можно добавить к списку кучу умений, которые приведут к тому, что масса профессий и занятий человека просто отомрет, начиная с тех самых дальнобойщиков (этого бы им уже нужно начинать опасаться, а не взимания оплаты при доставке грузов) и таксистов — компаниям типа Uber в не таком уж и далеком будущем они просто не понадобятся! Туда же отправятся актеры с операторами и монтажерами, и многие-многие другие. Бухгалтеры, экономисты, журналисты... Да много кто. Конечно, для всего этого понадобится время, но кое-что из описанного выше мы имеем шанс увидеть еще при нашей жизни. И уже сейчас нужно готовиться ко всему этому. Даже если вы повар, к примеру, и относительно спокойны за ваше будущее — это совсем не значит, что о нем не нужно позаботиться. Например, придумав, как применять искусственный интеллект в своей работе.

Вычислительная мощность современных вычислительных систем растет, и если раньше содержать нейронные сети было слишком дорого или вообще невозможно, сейчас глубокое обучение и нейронные сети для решения своих задач могут позволить себе даже небольшие компании. Рост вычислительных возможностей дает возможность применять нейросети во все большем круге применений. И эксперты действительно прогнозируют планомерный рост внедрения решений с применением систем искусственного интеллекта в широком спектре отраслей промышленности. По мнению аналитиков компании IDC, использование технологий на основе искусственного интеллекта через пять лет принесет 47 миллиардов долларов дохода — по сравнению с 8 миллиардами долларов в 2016 году.

Посмотрите еще раз на табличку с финансовыми показателями компании Nvidia, где доход с HPC-рынка пока еще более чем вдвое уступает игровым решениям. Вероятно, уже через несколько лет все перевернется с ног на голову. Конечно, не они одни будут получать дивиденды с этого рынка, который гранды не отдадут им просто так, но у Nvidia сейчас на нем очень неплохие позиции и явно виден их большой потенциал. Конечно, большой куш им вовсе не обеспечен, так как существует полно конкурентов, обладающих большим капиталом и опытом в этой сфере. Однако именно Nvidia вовремя вскочила на этот поезд одной из первых, у них есть действительно отличное аппаратное и программное обеспечение, и компания продолжает улучшать свое положение, развивая связи с разработчиками по всему миру.

Как сами видите, интерес к вычислительным применениям когда-то исключительно графических процессоров в последние годы значительно вырос, и сейчас решения компании Nvidia, основанные на их вычислительных архитектурах, успешно применяются во многих сферах. Еще много лет назад компания организовала собственное мероприятие, посвященное применению их решений в широком наборе задач — GPU Technology Conference. В этом году очередная ежегодная конференция в Калифорнии проходила не в привычном марте, а в мае, но все так же традиционно в городе Сан-Хосе — сердце Кремниевой Долины.

И даже больше того — технологическая конференция GTC сейчас проходит несколько раз в год в разных городах мира, в том числе в Китае, Европе, Израиле, Японии и паре городов США (Сан-Хосе и Вашингтон). В калифорнийской части GTC этого года участвовало 7000 человек (крупнейшие компании из разных сфер деятельности, AI-стартапы, разработчики программного обеспечения, инвесторы, пресса, аналитики и многие другие), было проведено 600 технических сессий и 310 сессий, посвященных именно искусственному интеллекту, расположено 150 стендов, 178 постеров и 67 лабораторий по технологиям глубокого обучения. GTC давно стала главным мероприятием для компании, и именно тут делаются главные анонсы Nvidia, а также становится понятно, к чему это все приведет через несколько лет. Вот об этом мы сегодня и поговорим.

Новая вычислительная архитектура Volta

В рамках ключевого выступления главы компании Дженсена Хуанга, им было сделано несколько самых важных анонсов, в том числе представлена новая архитектура графических процессоров Nvidia Volta, а также серия аппаратно-программных решений на их основе, которые ускорят и упростят работу с различного рода вычислениями, а особенно — искусственным интеллектом (в частности — глубоким обучением). Дженсен не разочаровывает публику на GTC, его выступления всегда интересны и многогранны. Неудивительно, что разговор с самого начала зашел о революции, которая происходит благодаря быстрому развитию искусственного интеллекта (ИИ).

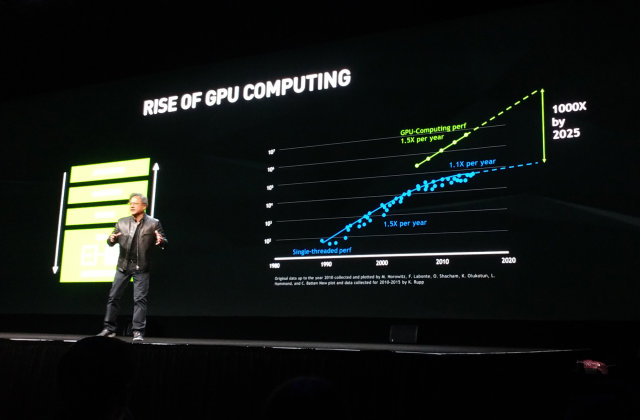

Nvidia как бы подстраивает закон Мура под себя, оценивая рост производительности систем, включающих вычисления на GPU. Если процессоры общего назначения ранее обеспечивали требуемый 1,5-кратный рост производительности, то в последние годы он снизился до +10% в год (речь об однопоточной производительности, конечно же), что не может удовлетворить индустрию. Но если учитывать прирост в скорости, даваемый графическими процессорами, то в целом полуторакратное ускорение в год вполне достижимо на практике и сейчас. А к 2025 году ожидается и тысячекратный прирост, а ведь это время настанет всего лишь через несколько лет.

За прошедшие годы вычислениями на графических процессорах производства Nvidia заинтересовались уже более полумиллиона разработчиков (это более чем в 10 раз больше, чем всего пять лет назад), число участников конференции GTC выросло втрое до 7000 человек, а число загрузок среды разработки CUDA за прошедший год составило более миллиона раз. И многие из существующих разработчиков используют мощь GPU именно для имитации искусственного интеллекта.

Круг задач, в которых применяется ИИ, весьма обширен: сложный поиск, распознавание изображений и голоса, роботизация, автопилотируемые самолеты и автомобили, медицина, перевод с разных языков и многое-многое другое. Инвестиции в ИИ-стартапы достигли пяти миллиардов долларов в прошлом году, а количество обучающихся по соответствующим программам выросло в сотни раз. Компания Nvidia уже некоторое время очень плотно занимается задачами, связанными с ИИ и машинным обучением, они выпускают множество аппаратных и программных решений для этих сфер применения. И сложность задач, поставленных перед ними, постоянно растет, каждый год требуя вдвое, а то и втрое-вчетверо большей общей производительности.

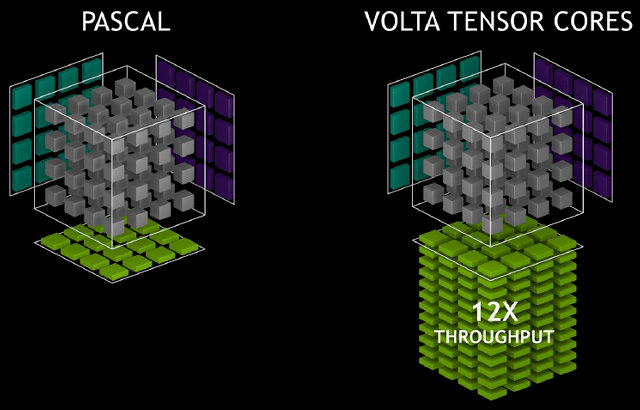

Именно поэтому индустрии высокопроизводительных вычислений потребовался даже еще больший скачок, чем привычные 1,5 раза ускорения в год. Также на всю индустрию повлияли и анонсы специализированных решений для машинного обучения, вроде Tensor Processing Unit (TPU) от Google, вторая версия которого была объявлена чуть позднее. Вот и Nvidia решила не отставать, представив новое поколение вычислительной архитектуры Volta, в который вошли специализированные блоки, которые и обеспечили пятикратное преимущество по скорости по сравнению с Pascal в задачах глубокого обучения.

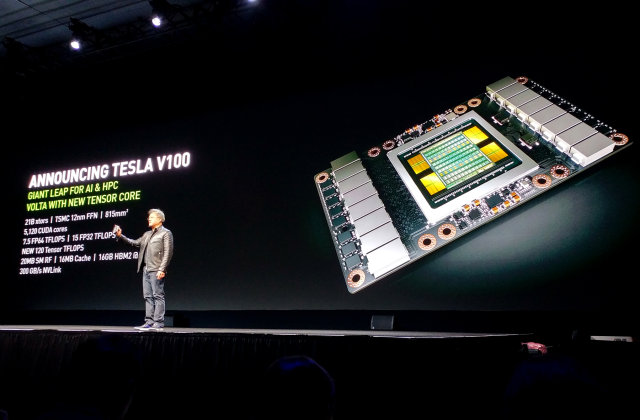

Для понимания сложности задачи, Дженсен привел такие данные: в процессе разработки архитектуры Volta и первого вычислительного процессора на его основе, получившего название Tesla V100, было потрачено три миллиарда долларов. Новый GPU включает более чем 21 млрд. транзисторов, объединяя ранее известные нам ядра CUDA и новые специализированные ядра Tensor core, обеспечивающие производительность в задачах обучения и инференса нейронных сетей, идентичную сотне CPU!

При огромной площади кристалла в 815 мм² неудивительно, что даже использование самого передового 12-нанометрового FFN-техпроцесса компании TSMC позволило сделать его лишь на самой грани нынешних возможностей фотолитографии. Чип получился очень большой и дорогой во всем, и инженерная команда Nvidia в лице Джона Албена (Jonah Alben), старшего вице-президента по проектированию GPU, благодарна Дженсену за то, что он дал им возможность поработать над столь сложным и многообещающим проектом.

Всего в графический процессор входит 5120 вычислительных ядер CUDA и 640 новых специализированных тензор-ядер (Tensor core), созданных для ускорения работы искусственного интеллекта. Для этого GPU поддерживает новые инструкции и форматы данных, удобные для обработки массивов матриц 4×4 следующим образом: D[FP32] = A[FP16] * B[FP16] + C[FP32]. Ядра считывают два значения с FP16-точностью, упакованные в один регистр, их перемножение осуществляется с FP32-точностью, результат суммируется с FP32-значением и записывается с 32-битной же точностью. Для задач глубокого обучения такой точности вполне достаточно, а может, эта возможность и в других задачах пригодится.

В итоге новое решение Tesla V100 имеет производительность в 1,5 раза выше в традиционных высокопроизводительных вычислениях по сравнению с Tesla P100 на архитектуре Pascal, а в задачах глубокого обучения, где включаются в работу тензор-ядра, прирост скорости составляет от 6 до 12 раз в зависимости от задачи! Об этом же говорят пиковые цифры производительности: 30 FP16 TFLOPS (удвоенная скорость вычислений с половинной точностью никуда не делась) или 15 FP32 TFLOPS или 7,5 FP64 TFLOPS или 120 новых тензор-TFLOPS. Возвращаясь к закону Мура, Nvidia заявляет, что эти цифры вчетверо больше тех, что он предсказывал.

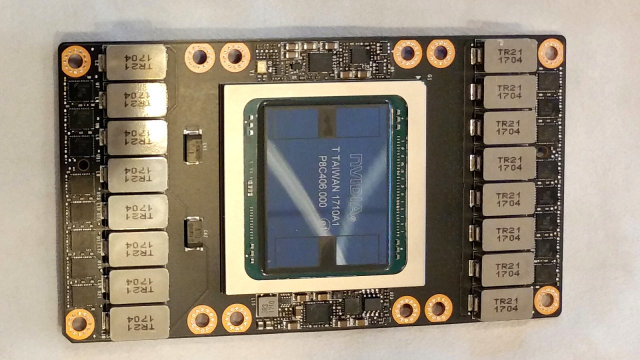

Кроме этого, первый GPU архитектуры Volta отличается применением 16 ГБ высокоскоростной HBM2-памяти, разработанной совместно с Samsung, имеющей пропускную способность в ПСП 900 ГБ/с — на 50% выше, по сравнению с предыдущим поколением. А для связи между графическими процессорами и между графическим и центральным процессорами применяется высокоскоростной интерфейс NVLink нового поколения, отличающийся вдвое увеличенной пропускной способностью по сравнению с предыдущим поколением — 300 ГБ/с.

Если говорить об архитектурных изменениях в традиционных ядрах, то и тут они есть. Декодеры и планировщик запускают по одной инструкции и одному варпу за каждый такт, и всего выполняется вдвое больше инструкций и варпов на каждый мультипроцессор за такт, по сравнению с Pascal. Новая архитектура позволяет чередовать два варпа на различных исполнительных устройствах. Так, GP100 не умеет выполнять FP32 и INT32 инструкции одновременно, а мультипроцессоры GV100 включают отдельные FP32 и INT32 ядра, позволяющие одновременное исполнение таких операций на полной скорости, что увеличивает общую эффективность GPU.

Специалисты компании говорят, что одно из самых больших изменений в Volta — новые планировщики потоков и декодеры (dispatch unit), а соответственно и алгоритмы управления потоками и варпами, которые стали более эффективными. Также в новом GPU есть L1-кэш объемом в 128 КБ, обладающий низкими задержками и большой пропускной способностью, который упростит исполнение задач, по каким-либо причинам не использующих разделяемую память.

Скажем пару слов о 12-нанометровом FFN-техпроцессе TSMC. Это действительно самый продвинутый техпроцесс тайваньской компании, подходящий для производства таких больших и сложных чипов, как GV100. Единственный момент, который нужно иметь в виду — по сути, это уменьшенная версия известного техпроцесса 16 нм FinFET, уже четвертый вариант этой технологии с улучшенными характеристиками, но отличающийся не столь разительно, как цифры 12 и 16. TSMC просто решила назвать его совершенно иначе — для того, чтобы было легче конкурировать с компаниями Samsung и Globalfoundries, которые предлагают техпроцесс 14 нм. Но, по сути, эти цифры давно не говорят ничего особо конкретного о реальных качествах техпроцесса и могут «гулять» туда-сюда в зависимости от желания производителя.

В любом случае, первое решение на архитектуре Volta является самым сложным и мощным чипом в индустрии, и оно производится по одной из лучших имеющихся на рынке технологий. Интересно, что электрически и физически новый чип совместим со старым — это сделано для ускорения производства и внедрения новинки, ведь можно использовать те же системные платы, системы питания и так далее.

Кстати, для осуществления inference в задачах глубокого обучения, Nvidia выпустила специальную версию ускорителя — более компактную и потребляющую лишь 150 Вт, но обеспечивающую в 15-25 раз большую производительность в таких задачах, по сравнению с CPU от Intel семейства Skylake. В итоге, вместо 500 узлов на базе CPU можно использовать лишь 33 узла на основе GPU, хотя это и будет специализированное решение.

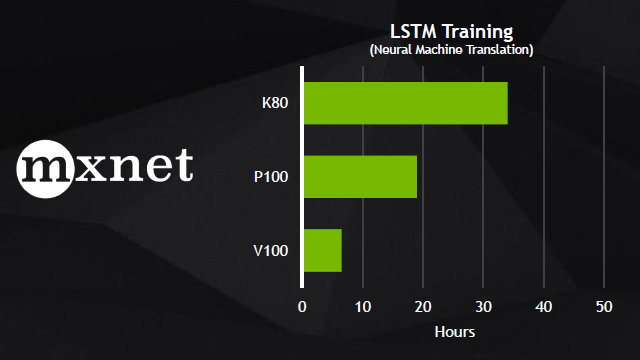

Пока что мы говорили лишь об аппаратной части, а ведь для современных вычислителей программная часть чуть ли не еще важнее. Оптимизированное для Volta программное обеспечение включает новую версию CUDA и ведущие фреймворки и приложения для ускорения ИИ. Программная поддержка Volta будет внедрена в следующие версии фреймворков глубокого обучения: Caffe 2, Microsoft Cognitive Toolkit, MXNet и TensorFlow, что даст возможность быстрого получения высокой производительности, которую может обеспечить Volta. Вот лишь несколько примеров сравнения V100 с P100 в некоторых задачах, использующих эти фреймворки:

Явно видно преимущество новой архитектуры в несколько раз, пусть и не 12 и даже не всегда 4-6 раз, но оно ощутимое. Также на GTC был анонсирован TensorRT для TensorFlow — оптимизированный для GPU компилятор для задач глубокого обучения, который может импортировать модели из Caffe и TensorFlow.

Если сравнивать скорость и задержки inference для нейросети ResNet-50, то Tesla V100 обеспечивает в разы лучшую скорость обработки изображений с несколько меньшей задержкой, не говоря уже о центральных процессорах или более старых GPU, сравнение с которыми новый GPU выигрывает с треском.

Представленная вычислительная архитектура получила поддержку CUDA 9 — новой версии широко известной программной платформы для вычислений на GPU. Девятая версия пакета полностью поддерживает архитектуру Volta, включая ускоритель вычислений Tesla V100, а также дает начальную поддержку специализированных тензор-ядер в API, которая обеспечивает огромный прирост при матричных операциях со смешанной точностью вычислений, распространенных в задачах глубокого обучения. Из других изменений в девятой версии отметим ускоренные библиотеки линейной алгебры, обработки изображений, FFT и других, улучшения в программной модели, поддержке унифицированной памяти, компиляторе и утилитах для разработчиков.

На данный момент, архитектура Nvidia Volta — это самая современная и продвинутая вычислительная (графическая) архитектура, которая призвана ускорить не только высокопроизводительные и графические вычисления, но и вычисления в сфере искусственного интеллекта. Благодаря объединению CUDA ядер и новых тензор-ядер, всего один сервер на базе Tesla V100 может заменить сотни центральных процессоров в специализированных высокопроизводительных вычислениях. Неудивительно, что такими решениями уже заинтересовались такие компании, как Amazon, Baidu, Facebook, Google, Microsoft, Oak Ridge National Laboratory, Tencent и многие другие.

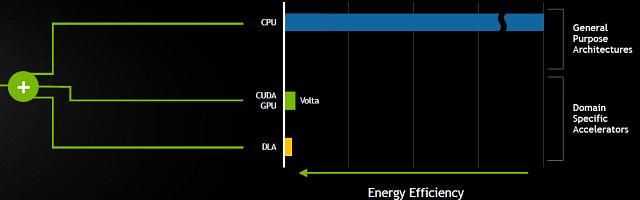

По сравнению с Pascal, новые решения Volta должны обеспечить еще большую энергоэффективность в обычных задачах, плюс серьезно вырваться вперед там, где применимы специализированные тензор-ядра (хотя это и не только глубокое обучение, но и другие операции с матрицами, но все же, эти ядра предназначены в первую очередь именно для задач обучения и инференса). Еще подробнее о вычислительной архитектуре Volta мы расскажем вам в отдельном материале, а далее переходим к другим интересным анонсам и событиям конференции.

Другие анонсы с ключевого выступления Дженсена Хуанга

Кроме новой вычислительной архитектуры Volta и ускорителя Tesla V100 на его основе, Дженсеном также была анонсирована и новая линейка суперкомпьютерных систем с искусственным интеллектом — Nvidia DGX, базирующаяся на этом же процессоре.

И предыдущая серия устройств DGX отличалась довольно высокой производительностью, а уж новые решения на базе Tesla V100, которые используют полностью оптимизированное для задач искусственного интеллекта аппаратное и программное обеспечение, включая специализированные тензор-ядра, и вовсе дают в задачах глубокого обучения производительность примерно втрое выше, чем у предыдущего поколения DGX (по оценке самой Nvidia), что соответствует мощности примерно 800 универсальных процессоров — и все это в одной системе!

Новые системы DGX-1, в состав которых включено восемь Tesla V100 на GPU архитектуры Volta, обеспечивают заметно большее количество выполняемых операций в секунду — 960 специализированных тензор TFLOPS. То есть, вместо 8 дней расчетов на Titan X, разработчикам будет достаточно 8 часов, а это — огромная разница! Заказать новые решения можно уже сейчас и их стоимость составляет $149000.

Также Дженсен сразу же представил и DGX Station — персональное решение с четырьмя ускорителями Tesla V100, соединенными по NVLink, обеспечивающими 480 тензор TFLOPS. Это решение имеет три видеовыхода DisplayPort, блок питания мощностью 1500 Вт и водяное охлаждение. Оно, в свою очередь, будет предлагаться на рынке за $69000.

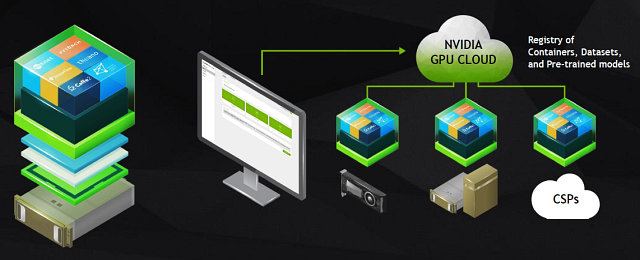

Кроме этих готовых аппаратных решений, Дженсен анонсировал облачную платформу Nvidia GPU Cloud (NGC). Эта облачная платформа предоставляет разработчикам удобный доступ к полноценному программному набору инструментов для внедрения систем искусственного интеллекта при помощи ПК, систем DGX или облака. Благодаря NGC, разработчики смогут легко и просто получить доступ к новейшим версиям оптимизированных фреймворков и самым современным ускорителям вычислений.

Эта система выгодна тем, что она полностью оптимизирована для решений Nvidia, все ПО в ней обновлено, протестировано и поддерживается самой компанией Nvidia. Предварительный доступ к облачной платформе будет доступен уже в июле.

И еще одним анонсом компании, связанным с системами DGX, стало объявление о партнерстве с компанией SAP. Сотрудничество двух компаний в сфере ускорения вычислений и глубокого обучения помогло компании SAP создать приложения для анализа видеоданных и отслеживания воздействия бренда, для анализа неструктурированной информации в жалобах клиентов, с целью направить их тем сотрудникам, кто способен их разрешить.

Так, проект SAP Brand Impact, использующий программные и аппаратные решения Nvidia, предназначенные для глубокого обучения, измеряет атрибуты бренда (размер и продолжительность показа логотипов компании) в видеороликах почти в реальном времени. Столь эффективный и быстрый анализ видеоконтента стал возможен благодаря использованию для этого анализа возможностей нейросетей, обученных при помощи Nvidia DGX-1 и TensorRT.

Первым делом — автопилоты

Тема автопилотируемых автомобилей развивается очень активно в последнее время, все знают и разработки Tesla, которые уже колесят по дорогам, особенно в Калифорнии, и решения других компаний, спешащих успеть на автопилотируемый поезд. Практически каждый автопроизводитель и поставщик соответствующих компонентов для автомобилей ведет разработки по автоматизации процесса управления автомобилем, а некоторые отраслевые лидеры объявили о создании альянсов в этом непростом деле: Daimler и Bosch или BMW, Intel, Mobileye и Delphi, которые займутся созданием платформы для автопилотируемых автомобилей для немецкой компании.

Высокая стоимость и сложность разработки новых технологий в сфере автопилотов заставляет участников рынка объединяться, и вполне вероятно, что количество глобальных платформ не будет слишком большим. Та же BMW планирует не просто сама использовать в своих автомобилях созданную альянсом платформу, но и лицензировать эти разработки сторонним компаниям, как и другие альянсы — те же Baidu с Volvo. Именно поэтому сотрудничество с разными автопроизводителями важно и для Nvidia, тут нужно не упустить момент.

На GTC было показано несколько таких вариантов с использованием самых современных решений Nvidia с применением искусственного интеллекта, в котором они уже собаку съели, что называется. Так, уже во время своего ключевого выступления, бессменный глава компании Дженсен Хуанг рассказал о некоторых достижениях компании по разработке автопилотов и представил новую вычислительную архитектуру, на которой будет основано будущее решение для автономных автомобилей — Drive PX Xavier.

DRIVE PX Xavier — это полноценное решение для автомобилей, использующее новую систему-на-чипе Xavier, включающую кастомный CPU с ARM64-ядрами, 512-ядерный графический процессор на основе архитектуры Volta и новые тензор-ядра, о которых мы уже писали. Они специально предназначены для задач искусственного интеллекта (в частности — глубокого обучения), и обеспечат приличный прирост производительности именно в таких применениях, выведя возможности автопилотирования на новый уровень.

Новый DRIVE PX обеспечивает скорость вычислений до 30 млрд. операций глубокого обучения в секунду (30 TOPS DL) при потреблении до 30 Вт, но самое интересное в Xavier — Deep Learning Accelerator (DLA). Это специализированный ускоритель операций глубокого обучения, весьма энергоэффективный, но самое главное — его программная часть будет иметь открытый исходный код. Ранний доступ для автопроизводителей обещан уже в июле, а для всех остальных — в сентябре.

Решения Nvidia для автомобилей отличаются своей полнотой, они включают в себя и отличные аппаратные возможности, и полный программный стек, начиная от операционной системы, продолжая библиотеками: CUDA, cuDNN, TensorRT, компьютерное зрение и заканчивая готовыми решениями по построению маршрутов, распознаванию объектов и т. д. DRIVE PX умеет сканировать дорогу, отслеживать динамические и статические объекты (автомобили, знаки и другие), запоминать маршрут и помогать в пилотировании. Также поддерживается функция Guardian Angel (Ангел-Хранитель), которая будет помогать экстренно оттормаживаться в случае внезапной опасности — к примеру, большого черного джипа, завершающего проезд перекрестка на «темно-оранжевый».

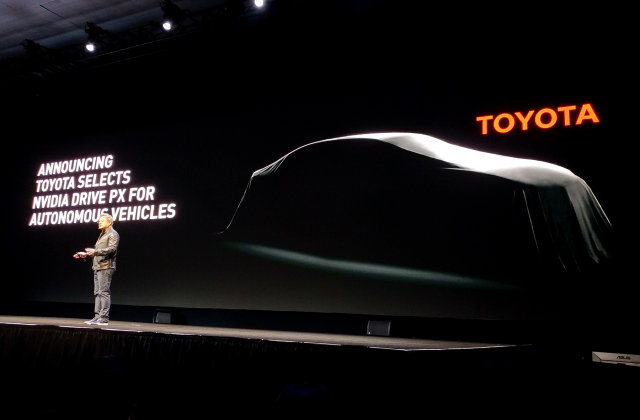

Неудивительно, что столь обширные возможности не остаются без внимания со стороны автопроизводителей. Мы уже знаем о некоторых компаниях, сотрудничающих с Nvidia в этом деле, а на GTC 2017 президентом компании Nvidia Дженсеном Хуангом было объявлено о том, что компания Toyota, известная высокими стандартами безопасности на дорогах, выбрала именно DRIVE PX для использования в своих будущих автономных автомобилях. Для Nvidia это важно в том числе и потому, что этот анонс может открыть азиатский авторынок для их решений.

Toyota уже начала внедрение автомобильной платформы Nvidia PX с поддержкой искусственного интеллекта в свои системы автономного вождения, которые должны выйти на рынок в ближайшие годы. Инженеры двух компаний уже работают над созданием качественного программного обеспечения, основанного на высокопроизводительной платформе Nvidia с применением ИИ, что позволит обрабатывать и принимать во внимание огромные объемы данных, получаемые с различных датчиков, чтобы справляться с полностью автономным пилотированием при любых ситуациях на дороге.

Для решения задач подобной вычислительной сложности, в прототипах автопилотируемых автомобилей часто используют мощные компьютеры, занимающие весь багажник, а платформа Nvidia DRIVE PX, основанная на процессоре нового поколения Xavier, способна дать те же возможности, обладая низким потреблением энергии в 30 Вт и компактными размерами, легко помещаясь даже в руке. Вот пример от самой Nvidia с DRIVE PX, занимающим малую часть багажника:

Таким образом, Toyota присоединилась к другим производителям легковых и грузовых автомобилей, которые разрабатывают системы автопилотирования на основе технологий Nvidia с использованием искусственного интеллекта. Среди этих компаний есть хорошо известные имена: Tesla, Audi, Volvo и Paccar — американская компания, третий по величине производитель тяжелых грузовиков в мире, известная по маркам Peterbilt, Kenworth, DAF и другим. К слову, они также были представлены на выставке:

Этот огромный грузовик Peterbilt затащили в выставочный зал для того, чтобы показать рабочий концепт автопилотируемого грузового автомобиля, соответствующего возможностям SAE Level 4, который использует решение Nvidia DRIVE PX 2, основанное на натренированных нейросетях. При наличии около 300 миллионов грузовиков по всему миру, проезжающих более 1,2 триллиона миль в год, применение автопилотов вместо дальнобойщиков может увеличить безопасность и сократить издержки.

В холле и выставочном центре GTC вообще было представлено много различных автомобилей, так или иначе использующих решения компании. Выставка самой Nvidia включала уже известный нам проект BB8 — самопилотируемый автомобиль для тестирования различных технологий компании с использованием самообучаемых нейросетей.

В дополнение к технологии PilotNet, которая использует нейросеть для управления автомобилем, тут применяются другие технологии: LaneNet — для определения полос и другой дорожной разметки, DriveNet — для распознавания движущихся и статичных объектов (автомобилей, пешеходов и знаков) и OpenRoadNet — для определения возможного маршрута автомобиля, в зависимости от дорожных условий. Все эти технологии на основе нейросетей работают в BB8 совместно, чтобы обеспечить безопасное передвижение в любых условиях.

Также на GTC 2017 были представлены автопилотируемые автомобили от Udacity, AutonomouStuff и Audi. Последняя компания уже показывала свое решение на CES 2017, этот концепт Audi Q7 включает в себя все возможности и технологии глубокого обучения Nvidia, известные по их собственному решению BB8.

Автомобиль от AutonomouStuff также использует решение на основе DRIVE PX 2, включающее в себя этот ИИ-суперкомпьютер и технологии Nvidia DriveWorks. А компания Udacity, также показывавшая собственный автопилотируемый автомобиль, представила еще и сессии для онлайн-обучения инженеров, занимающихся автопилотами — Self-Driving Car Engineer Nanodegree. Этот курс полностью покрывает тематику автопилотов, включая возможности глубокого обучения и компьютерного зрения, а также применение различных сенсоров.

Помимо выставочных автомобилей, на GTC было представлено более 50 технических сессий, посвященных автопилотируемым автомобилям и раскрывающих темы от роли глубокого обучения в автоспорте до применения высококачественных карт в целях облегчения задач автономного вождения. Выступали на конференции и известные в индустрии специалисты, такие как Raquel Urtasun из команды Uber по разработке ИИ для автономных автомобилей, а спикеры из Argo AI/Ford и Mercedes Benz рассказали о том, как большие автопроизводители работают над системами автопилотов.

Да и сама компания Nvidia провела несколько сессий по внедрению различных облачных и других технологий в автопилотируемые транспортные средства, выделив возможности DRIVE PX 2, открытой вычислительной платформы для автомобилей и показав несколько демонстраций по применению приложений, утилит и библиотек из DriveWorks SDK.

Была на конференции и специальная лаборатория, где показывали как можно интегрировать различные типы сенсоров и использовать их в модулях DriveWorks при написании собственного кода. Эти демонстрации показывали открытость и легкость использования DriveWorks в целом, а также раскрывали возможности отдельных техник с применением вычислительно-интенсивных алгоритмов для определения объектов и планирования маршрута. В общем, автомобильной теме была посвящена очень большая часть GTC.

Также на ключевом выступлении Дженсена была показана еще одна интересная технология, которая может изменить подход к разработке автомобилей — Project Holodeck. Это фотореалистичное окружение в виртуальной реальности, предназначенное для совместной работы нескольких сотрудников. VR-среда Holodeck позволяет видеть, слышать и осязать объекты в виртуальной реальности, позволяет импортировать качественные модели высокого разрешения для совместной работы вместе с коллегами.

Для демонстрации работы технологии Nvidia воспользовалась помощью со стороны Christian von Koenigsegg, основателя известной компании Koenigsegg Automotive AB из Швеции, производящей суперкары. Он присоединился к выступлению Дженсена при помощи VR-среды Holodeck и показал, как можно было бы использовать ее в разработке полностью карбонового кузова суперкара Koenigsegg Regera.

При помощи этой технологии в реальном времени можно рассмотреть в деталях то, как будет выглядеть та или иная часть автомобиля, при этом качество изображения обеспечивается фотореалистичное. К примеру, можно подготовить несколько вариантов одной детали в виртуальном пространстве и выбирать один из них, наблюдая в VR как они будут выглядеть уже в реальности. Среда Holodeck также отличается качественными интерактивными взаимодействиями в соответствии с законами физики, а ранний доступ к ней обещано обеспечить уже в сентября текущего года.

Искусственный интеллект в трассировке лучей и профессиональное использование VRWorks

Вычисления на графических процессорах применяются в разных сферах: при создании визуальных эффектов в кино- и телеиндустрии, при создании дизайна разнообразной продукции, в архитектуре, медицине и таких серьезных задачах, как нефтегазовые разработки. При этом для разработчиков всех этих вещей весьма важно качество изображения — они должны видеть объекты в виде изображения, как можно близкого к фотореалистичному, для того, чтобы повысить темпы разработки. Дизайнеры и разработчики постоянно и неоднократно что-то меняют и добавляют в своих проектах и они сразу же должны видеть результат, близкий к реальности — для того, чтобы избежать ошибок на какой-то стадии.

Поэтому чаше всего применяются такие ресурсоемкие методы, как трассировка лучей, которая использует сложные математические расчеты для того, чтобы реалистично имитировать взаимодействие света и поверхностей в сцене. И хотя применение графических процессоров для трассировки лучей значительно ускорило этот процесс, ждать окончания работы трассировщика лучей для получения качественной картинки чаще всего все равно приходится очень долго. А пока эта работа еще не закончена, изображение получается насыщенное шумами и выглядит оно не слишком привлекательно.

Для частичного решения этой проблемы можно применить методы удаления этого «шума» с картинки при сохранении всех деталей на гранях и поверхностях, что называется шумоподавлением. Но существующие алгоритмы требуют длительной обработки, что делает их непрактичными, а на GPU можно их серьезно ускорить. Именно для быстрого получения высокодетализированных изображений в Nvidia решили применить искусственный интеллект. Специалисты компании добавили в свой рендерер Nvidia Iray специальное шумоподавление — «дорисовку» еще не до конца рассчитанной информации (тех самых «шумных» пикселей), которая осуществляется при помощи алгоритмов глубокого обучения.

Во время своего ключевого выступления на GTC, президент Nvidia Дженсен Хуанг впервые публично продемонстрировал работу алгоритма глубокого обучения в комбинированном режиме рендерера Nvidia Iray, когда GPU сначала лишь частично отрисовывает картинку, затем работает ИИ, удаляя шум с картинки, и картинка сразу же становится гораздо качественней, хотя трассировка лучей еще не закончила свою работу над всеми пикселями.

Лучше один раз увидеть, чем сто раз прочитать, поэтому обратите внимание на иллюстрацию выше. Слева на ней показано изображение после одной секунды работы исключительно трассировщика лучей, а справа — после такой же одной секунды совместной работы трассировщика лучей и специального алгоритма шумоподавления с использованием глубокого обучения. В динамике это выглядит еще более впечатляюще, можете нам поверить — применение ИИ позволяет гораздо быстрее получить качественное изображение.

Для того, чтобы новый шумодав заработал, разработчики из Nvidia использовали класс нейронных сетей, который известен как называется автокодировщик (autoencoder). Аналогичные методы используются для увеличения разрешения изображений, при сжатии видеоданных и во многих других алгоритмах обработки изображений. С использованием суперкомпьютера Nvidia DGX-1, специалисты компании обучили нейронную сеть так, чтобы она переводила зашумленное изображение в чистое. Для этого, нейронная сеть была менее чем за 24 часа обучена с использованием 15000 пар изображений из 3000 разных сцен, имеющих различный уровень «шума».

И теперь, уже после обучения, сеть позволяет очистить шумы практически на любом изображении за доли секунды. Причем, Nvidia уже обучила эту нейросеть, и в грядущих версиях Iray она уже будет просто работать при наличии GPU семейства Pascal и более новых — пользователям не нужно разбираться в работе алгоритмов глубокого обучения и внедрять их, на системе с соответствующим графическим процессором просто будет работать GPU-ускоренный инференс (inference) алгоритм.

Для многих сфер индустрии, где требуется применение графики такого качества, подобное решение имеет не меньшее значение, чем сам по себе перенос трассировки лучей на GPU, произошедший несколько лет назад. Iray AI как бы дорисовывает частично рассчитанную картинку на основе готовых пикселей, производя фотореалистичные изображения практически без ошибок, что во многих случаях освобождает от длительного ожидания окончания работы алгоритма трассировки лучей.

Для специалистов из индустрии развлечения, промышленного дизайна, архитектуры и других, такой алгоритм может полностью поменять их подход при работе. Они смогут увидеть достаточно качественное изображение вчетверо быстрее для лучшего понимания того, как будет выглядеть готовый продукт в реальности. Подобные техники шумоподавления с использованием глубокого обучения можно применять в любых системах рендеринга, и специалисты из Nvidia уже занимаются интеграцией алгоритма ИИ во все собственные рендереры, начиная с Iray.

Функциональность Iray с шумодавом, использующим глубокое обучение, будет включена в Iray SDK, поставляемый компаниям-производителям ПО, а также будет раскрыта в плагинах Iray, которые станут доступны позднее в этом году. Также в Nvidia планируют добавить этот ИИ-режим и в Mental Ray. В дальнейшем, ожидается появление аналогичных алгоритмов и в других рендерерах, так как основа технологии будет опубликована на графической конференции SIGGraph, которая пройдет летом этого года.

Из других интересных анонсов Nvidia, связанных с профессиональной графикой, можно выделить интеграцию ключевых технологий пакета VRWorks в профессиональные приложения компаний Autodesk, ESI Group и Optis. Для того, чтобы корпоративные заказчики могли использовать возможности виртуальной реальности в своих проектах, разработчики популярных профессиональных приложений интегрировали VRWorks в свои продукты.

Это важно потому, что технологии VRWorks, в числе которых VR SLI, Single Pass Stereo и Lens Matched Shading, помогают повысить производительность, эффективность и качество изображения при рендеринге виртуальной реальности. И поэтому профессиональные VR-приложения при условии применения графических процессоров Nvidia Quadro VR-Ready смогут обеспечить отличную производительность в VR-среде.

А такие технологии VRWorks, как 360 Video, Audio и PhysX помогут получить реалистичный звук и физическое взаимодействие в VR-окружении. VRWorks Audio обеспечивает моделирование распространения звука в VR-окружении на базе технологий трассировки лучей, а технология 360 Video помогает при сшивании VR-видео в реальном времени. Кроме этих технологий, VRWorks также включает специальные возможности для платформы Quadro: Warp and Blend, Synchronization, GPU Affinity и GPUDirect for Video.

Институт глубокого обучения для 100000 разработчиков в год

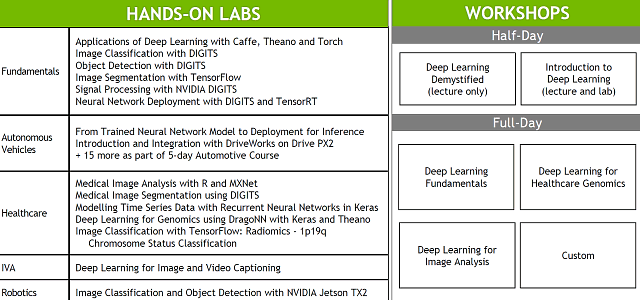

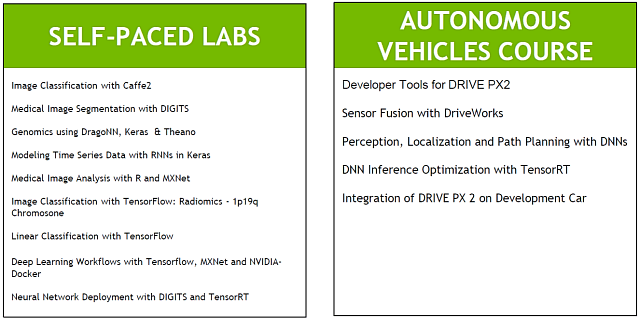

Одним из интереснейших анонсов Nvidia на GTC, которые касаются обучения разработчиков, стало объявление о том, что в этом году знания в стремительно развивающейся области искусственного интеллекта получат в десять раз больше желающих, чем это было в 2016. Для того, чтобы удовлетворить очень немалую потребность рынка в умельцах, знающих толк в области ИИ, в течение этого года компания Nvidia собирается обучить в Институте глубокого обучения (Deep Learning Institute или DLI) 100000 разработчиков.

Мы уже писали о том, что сфера систем искусственного интеллекта меняет индустрию вычисления, и она очень быстро развивается. Глубокое обучение уже применяется в разных сферах: здравоохранении, науке, производстве, финансах и т. д., а аналитики из IDC прогнозируют, что в 2020 году более 80% приложений будут содержать компоненты ИИ. Естественно, что для этого нужны новые сотрудники, а сфера привлечет к себе еще больше компаний и финансов.

Вот и Nvidia решила поучаствовать в деле образования, представив инициативу Институт глубокого обучения, который предлагает практическое обучение применению новейших инструментов и технологий искусственного интеллекта разработчикам, научным работникам и исследователям. В Институте глубокого обучения компании уже прошли обучение представители таких компаний, как Adobe, Alibaba и SAP.

Сессии DLI были проведены в таких исследовательских центрах, как Национальный институт здравоохранения США, Национальный институт науки и техники и Суперкомпьютерный центр Барселоны, а также в институтах высшего образования: Политехнический институт Сингапура и Индийский технологический институт Бомбея. И интерес к ним был вызван совсем немаленький, судя по отзывам.

Кроме самой по себе возможности посещения семинаров, участники DLI получат доступ к дистанционным курсам по глубокому обучению на основе ПО от Nvidia и виртуальным узлам на базе GPU в облаке Amazon Web Services (AWS) EC2 P2. С помощью этого сервиса, обучение прикладному использованию алгоритмов глубокого обучения уже прошли свыше 10000 разработчиков, а теперь в компании замахнулись на в 10 раз большее число обучающихся. Обучение проходит в онлайне на основе облачной платформы с применением графических процессоров Nvidia и сервисов Amazon Web Services и Google Qwiklabs, что делает его доступным для разработчиков в любых уголках мира.

В лабораториях Института глубокого обучения преподают как сертифицированные преподаватели из самой Nvidia, так и представители компаний-партнеров и известных университетов. Каждая лаборатория посвящена конкретной сфере применения алгоритмов глубокого обучения, вроде использования ИИ для распознавания объектов, применения ИИ для подбора методов лечения рака или использования технологии Nvidia DRIVE PX 2 и DriveWorks при создания автопилотов.

Так как искусственный интеллект является одной из важнейших сфер современности, то спрос на подобные курсы по разным темам, связанным с ИИ, весьма велик. Причем, больше всего нужны те разработчики, которые не только теоретически понимают, что такое ИИ, но и умеют внедрить его в коммерческие приложения на практике.

Nvidia добавила в перечень курсов DLI сессии по практическому применению алгоритмов глубокого обучения в самоуправляемых автомобилях, здравоохранении, робототехнике, видеоанализе и финансах. Также компания сотрудничает с Udacity, чтобы провести в рамках Института курсы для разработчиков приложений для самоуправляемых автомобилей. Чтобы удовлетворить растущий спрос со стороны компаний и университетов, Nvidia значительно расширила свои предложения на этот год. На GTC были представлены новые темы, освещаемые в рамках DLI в 2017 году:

В планах на этот год планируется расширение Института глубокого обучения по нескольким направлениям:

- создание новых лабораторий глубокого обучения: Nvidia уже работает для создания совместных лабораторий с Amazon Web Services, Facebook, Google, Mayo Clinic, Стэндфордским университетом и сообществами, поддерживающими основные фреймворки глубокого обучения: Caffe2, MXNet и TensorFlow;

- подготовка новых материалов для преподавателей: совместно с директором по исследованиям в области ИИ из Facebook и профессором информатики Нью-Йоркского университета, Nvidia разрабатывает комплект обучающих материалов DLI, который включает теорию и практическое применение глубоких сетей на GPU с помощью фреймворка PyTorch. Этот комплект уже применяют преподаватели в Оксфордском и Калифорнийском Университете в Беркли и других учебных заведениях;

- создание партнерской сети по сертифицированному обучению DLI: Nvidia предоставляет материалы и сертифицирует инструкторов из компаний Hewlett Packard Enterprise, IBM и Microsoft.

Также Nvidia работает вместе с командами Microsoft Azure, IBM Power и IBM Cloud для того, чтобы портировать лабораторные задачи в облачные решения. На одной только конференции GTC, Институт глубокого обучения от компании Nvidia провел занятия в 14 лабораториях и обучил прикладному использованию искусственного интеллекта более 2000 разработчиков.

Доступ к комплекту обучения DLI, в который входят материалы по ускоренным вычислениям и робототехнике, преподаватели могут получить на специальной странице сайта Nvidia для разработчиков.

Платформа для умных городов Metropolis

А вот еще одна важная тема для применения искусственного интеллекта — слежение за порядком на городских улицах, да и вообще в целом. К примеру, анализ видеоданных с многочисленных камер наблюдения позволяет отслеживать необычное поведение людей. Или столь же странную активность в соцсетях и мессенджерах для того, чтобы превентивно отлавливать террористов и просто преступников.

Например, нейронные сети будущего будут способны заподозрить пользователя на основе его высказываний, фотографий и видеороликов, а также общения в мессенджере и физического местоположения, совпадающего с другими подозрительными личностями, в том, что он готовит определенное преступление в таком то месте и с такой то вероятностью. Смотрели же кинофильм «Особое мнение»? Вот это почти оно, только еще глубже. Есть все предпосылки к тому, что в не столь уж отдаленном будущем, нейронные сети позволят выявлять потенциальных преступников еще на ранней стадии.

Мы уже сейчас находимся под колпаком у множества компаний, и в дальнейшем это будет только развиваться. Можете себе представить, сколько данных о нас у Facebook, Apple и Google с их кучей сервисов, в которые мы добровольно отдаем много чего? Эти компании каждый день получают от нас массу информации: видео, фото, аудио, данные о местоположении и интересах (поиск в вебе и соцсетях, посещаемые страницы и многое другое). Соответственно и выборка данных, на основе которых можно обучать нейросети, у них уже есть, и она просто огромная. А еще они наверняка поделятся ими с правительствами разных государств по их запросам, хотя это уже отдельный вопрос. Тема хоть и сложная с моральной точки зрения, но одновременно простая с точки зрения обеспечения безопасности будущего — подобные системы способны помочь в этом.

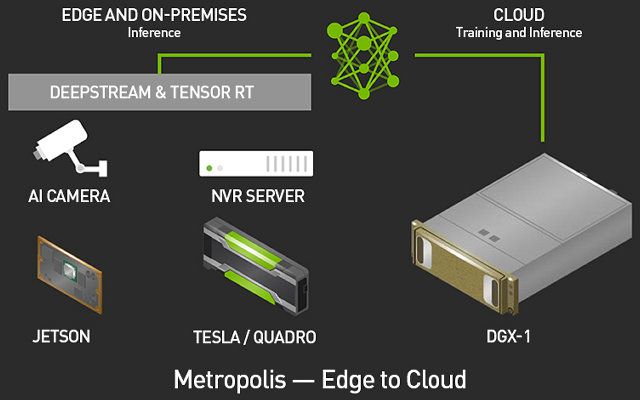

На технологической конференции GTC, компания Nvidia представила платформу для видеоанализа Metropolis, предназначенную для создания «умных городов» с искусственным интеллектом. И это логично, ведь уже более 50 партнеров компании применяют глубокое обучение для получения и анализа информации в реальном времени — для того, чтобы сделать города безопаснее, улучшить дорожное движение и оптимизировать использование имеющихся ресурсов (пропускной способности дорог, парковок и т. д.).

Платформа Metropolis способна сделать наши города безопаснее и умнее при помощи применения алгоритмов глубокого обучения к видеопотокам, получаемым с камер наблюдения. Глубокое обучение позволяет проводить сложный анализ видео в реальном времени, а эти данные — крупнейший источник информации. Сотни миллионов камер уже сейчас установлены в коммерческих зданиях, правительственных и общественных учреждениях, общественном транспорте, на улицах городов, а к 2020 году ожидается, что общее количество камер в мире достигнет миллиарда.

Сейчас дела обстоят так, что анализируется только малая часть записанных видеоданных, а большая часть просто хранится для будущего анализа, если это потребуется (кто-то запросит записи на конкретное число и время). Попытки же анализа видеоданных в реальном времени до недавнего времени были слишком сложны и ненадежны, по сравнению с просмотром роликов людьми. Хотя и сами люди могут пропустить какие-то детали, которые специально обученный ИИ может подметить. Применение алгоритмов глубокого обучения в камерах, видеорегистраторах, на серверах и в облаках позволяет решить проблему постоянного мониторинга видео с высокой точностью.

В состав платформы Metropolis входят различные решения компании Nvidia, работающие на единой вычислительной архитектуре. В камерах и видеорегистраторах быстро работает inference при помощи вычислительной платформы для встраиваемых систем Nvidia Jetson, в серверах и дата-центрах для анализа данных установлены ускорители Nvidia Tesla, а визуализация данных осуществляется при помощи профессиональных графических решений Nvidia Quadro. В состав платформы входят также пакеты инструментов для разработчиков: JetPack, DeepStream и TensorRT.

Поддержка инициативы Nvidia по созданию городов с ИИ постоянно растет, уже более 50 компаний в сфере создания умных городов, включая лидеров индустрии: Hikvision, Avigilon, Dahua, Milestone и Hanwha Techwin, предлагают своим клиентам получать необходимую информацию из видеопотоков при помощи алгоритмов глубокого обучения, и эта обработка основана на программно-аппаратных решениях компании Nvidia.

Потенциал у платформы Metropolis достаточно большой, она может применяться к видеопотокам для создания интеллектуальных приложений в различных областях применения, начиная от транспорта и заканчивая коммерческими задачами. Преимущество глубокого обучения с применением мощных графических процессоров Nvidia заключается в том, что данные можно анализировать гораздо быстрее и точнее. Это важно для того, чтобы обеспечить необходимую скорость реагирования на происходящее на улицах городов.

В выставочной части конференции GTC было представлено несколько рабочих вариантов подобных систем, которые не просто распознают объекты и лица с высокой точностью, но и запоминают их и каталогизируют. К примеру, «запомнив» одного из отмеченных на видео людей, система от Aviglion способна распознать этого человека в следующий раз, несмотря на то, что его лицо будет при других условиях освещения и иначе ориентировано по отношению к камере. При этом, все необходимое для инференса встроено прямо в камеру — конечно же, это встраиваемая вычислительная система Jetson.

Благодаря столь мощным решениям, как Jetson TX2 на местах и Tesla в центрах обработки данных, платформа Metropolis может стать основой для создания подобных умных городов, которые превратят не слишком полезные сырые видеоданные без какого-либо анализа в весьма ценную информацию о том, какой объект что делал и как себя вел — то есть, даст интеллектуальную аналитику, полезную для широкого спектра приложений.

Применение ИИ меняет весь подход к анализу данных, и его воздействие на безопасность в обществе, на дорогах и улицах, будет довольно значительным. Вот лишь часть из списка компаний, которые уже создают и демонстрируют подобные системы:

- Aeryon — беспилотные аппараты для обеспечения общественной безопасности

- Aqueti — 100-мегапиксельная суперкамера для наружного наблюдения над большими площадями

- Avigilon — анализ видеоданных с применением глубокого обучения

- BriefCam — быстрый поиск по видеоданным

- Dahua — определение и распознавание пешеходов и автомобилей

- Hikvision — определение и распознавание пешеходов и автомобилей

- Milestone — менеджмент видеоданных с GPU-ускорением

- MotionDSP — усовершенствование и редактирование видеоматериалов

- Motionloft — отслеживание активности пешеходов в реальном времени

- Netradyne — анализ действий водителей на основе глубокого обучения

- RAD — автономный робот для обеспечения общественной безопасности

- Sensetime — распознавание лиц и объектов

Имитатор роботов Isaac и референсные платформы для роботов

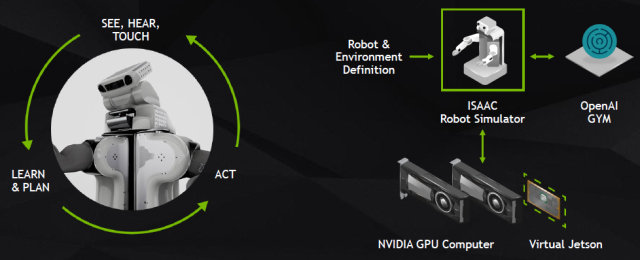

Одним из множества возможных применений для систем искусственного интеллекта является имитатор для тренировки роботов от Nvidia по имени Isaac (Айзек), который был представлен главой компании в его ключевом выступлении. В имитаторе применяются сложные технологии компании для того, чтобы эффективно обучать умные машины в виртуальной среде, имитирующей условия реального мира еще до того, как робота с ИИ отпустят в «свободное плавание» по реальности.

Ведь современные роботы не просто выполняют заранее запрограммированные задачи, они могут самостоятельно учиться и адаптироваться с использованием таких возможностей, как машинное обучение, компьютерное зрение и т. д. Искусственный интеллект открывает множество возможностей в роботизации для взаимодействия с окружением и объектами, но тренировка робота в реальном физическом мире может быть слишком дорогой, длительной и опасной затеей.

Имитатор роботов Isaac — это комплексная система симуляции, предназначенная для обучения и тестирования роботов с искусственным интеллектом в сложных трехмерных средах, в детализированных и реалистичных сценариях. Имитатор включает богатый набор инструментов для глубокого обучения, решателей (solvers) физики, роботизированных компонентов и продвинутого рендеринга, и предоставляет безопасный и эффективный способ для практического исследования и разработки элементов искусственного интеллекта перед их развертыванием в виде реальных роботов.

Isaac эмулирует виртуальную систему Jetson на основе десктопных графических процессоров на ПК и использует всю мощь встраиваемой системы Nvidia и глубокого обучения, чтобы натренировать и протестировать интеллектуальных роботов, предназначенных для разных сфер: от производства и сельского хозяйства до систем общественной безопасности.

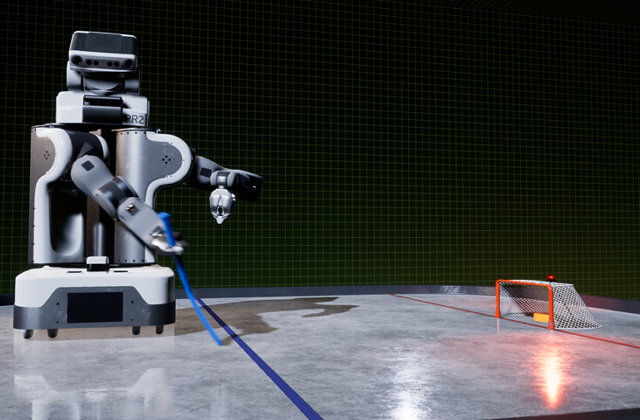

В своем выступлении на конференции, Дженсен Хуанг показал демонстрационную версию одного из возможных вариантов применения системы, где робота тренировали играть в хоккей и гольф, и он постепенно совершенствовал свои навыки хоккеиста и гольфиста в процессе обучения. Использование имитатора роботов Isaac позволяет сделать процесс тренировки безопаснее, быстрее и дешевле, так как разработчикам не требуется воплощать модель робота в реальности лишь для того, чтобы начать его тренировать.

Виртуальный симулятор роботов позволяет ускорить процесс создания умных машин, в нем можно запускать различные симуляции гораздо быстрее, чем в реальном мире. И так как система работает полностью в виртуальной среде, то нет риска физического повреждения чего-либо. После окончания процесса симуляции, натренированный ИИ легко переносится в реального физического робота, и его работу в реальности можно дополнительно отшлифовать, когда основная задача уже была сделана в виртуальности.

В показанной Дженсеном демонстрационной программе используется игровой движок Unreal Engine 4 от Epic Games — этот популярный графический движок использовали для того, чтобы обеспечить практически фотореалистичную графику и продвинутую физическую симуляцию. Так что от реальности процесс тренировки в Isaac отличает немногое.

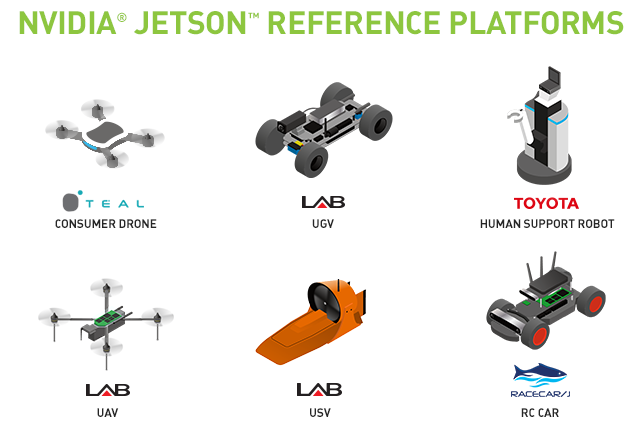

На своей конференции компания Nvidia также представила набор референсных платформ на базе решения Jetson, позволяющих ускорить процесс создания умных машин — Jetson Reference Platforms. В список референсных роботов входят разные их типы: дроны, автопилотируемые мини-автомобили, робот с манипулятором, катер и другие платформы. Основная идея таких платформ состоит в модуле с фиксированным стандартным API, который нужен для того, чтобы программисты ПО для роботов могли просто взять готовую программно-аппаратную платформу и сразу заниматься своим делом.

Без стандартизированных платформ было бы трудно масштабировать разработки и делиться друг с другом плодами своего труда, ведь разными модулями занимаются разные люди и компании: Nvidia делает встроенные компьютеры для роботов, компании (Toyota, enRoute и другие) производят сами «железки», а разработчики ПО занимаются программной частью. Вот именно для программистов и рассчитаны стандартные платформы Nvidia, в которых установлено стандартное железо, а программистам нужно только написать программное обеспечение. Также можно будет сравнить работу разного ПО, использующего одни и те же аппаратные платформы.

Референсные платформы Jetson были разработаны партнерами компании для того, чтобы ускорить создание умных машин другими разработчиками. Платформы идут в комплекте с программными утилитами и API в готовом для разработки ПО виде. Также возможно добавление дополнительных сенсоров и другого аппаратного обеспечения при условии поддержки со стороны программной части.

Платформы на основе Jetson включают в себя различные типа роботов. Например, легкого мобильного робота Toyota Human Support Robot (HSR), умеющего обходить препятствия и подавать предметы при помощи механической руки. Это помощник для пожилых и больных людей управляется голосом или с планшета, он умеет поднимать предметы с пола или доставать их с высоких полок.

Еще одной референсной платформой стал дрон Teal — самый быстрый дрон из выпускаемых серийно, способный летать на скоростях более 110 км/ч. Он также основан на платформе Jetson, обладающей мощными вычислительными способностями, которые очень полезны в самоуправляемых дронах. У дрона Teal есть как основное приложение для управления с различными режимами (от новичка до продвинутого пилота), так и специальные встроенные режимы следования за «хозяином» и «гоночный» режим.

Сразу три референсные платформы на основе Nvidia Jetson предлагает компания enRoute: Unmanned Ground Vehicle (UGV) — самопилотируемая тележка (почти автомобиль, только маленький), пригодная для разработки ПО для автопилотируемого наземного транспорта, Unmanned Surface Vehicle (USV) — надводный автопилотируемый транспорт, который несет до 8 кг груза и может использоваться для самостоятельного передвижения по волнам морей, озер и океанов, Unmanned Aerial Vehicle (UAV) — автопилотируемый дрон, разработанный для промышленных применений и поисковых операций и использующий автопилот Pixhawk.

И еще одной референсной платформой для Nvidia Jetson стал RACECAR/J. Уже из одного названия понятно, что это — автопилотируемый гоночный автомобиль. Он основан на проекте MIT RACECAR, аппаратного и программного обеспечения с открытым исходным кодом, и имеет максимальную скорость в 80 км/ч. Эта гоночная платформа также создана для тех разработчиков, кто создает приложения для автономных автомобилей. Ее отличительная черта — использование мощной версии платформы Nvidia Jetson TX2, в отличие от других роботов, использующих первую версию.

Роботы и другие практические применения ИИ

Что же лучше всего может показать всю важность применения систем искусственного интеллекта и глубокого обучения в частности, как не готовые и вполне работоспособные примеры подобных приложений? В этом году на конференции GTC было представлено множество демо-стендов, показывающих различные применения технологий компании Nvidia. Это автопилотируемые автомобили, о которых мы уже писали, дроны, роботы, системы распознавания и другие варианты применения ИИ.

Особенно много на выставке было роботов, включая робота-кладовщика, робота для подводного плавания, робота для ухаживания за людьми, робота для поддержки правопорядка и т. д. Одним из самых интересных нам показался даже не робот, а прицепное устройство к трактору для применения в сельском хозяйстве от компании Blue River — с технологией «See & Spray».

Это не совсем робот, конечно, ведь обычным трактором до сих пор управляет человек (но и это поправимо в самом ближайшем будущем, как вы знаете из предыдущих разделов материала), а просто умная система точечной доставки удобрений строго на те растения, которые необходимо опрыскивать. К примеру, вам нужно убить только сорняки, не тронув культурные растения. Система Blue River при проходе по полю снимает каждый его участок на видеокамеру, умная система искусственного интеллекта на основе Nvidia Jetson определяет участки для опрыскивания, и прицельно наносит удобрения в стиле струйного принтера.

Основной смысл всей затеи — химикатов в почву при таком подходе заносится минимальное количество и делается это строго по адресу — маленькими дозами прямо по сорнякам, не трогая нужные растения. Компания Blue River заявляет, что их сельскохозяйственные роботы помогают защищать уже 10% от всех посадок салата в США. И это только начало, применения умных систем найдутся и в сельском хозяйстве и в других сферах.

Как, к примеру, в роли роботов-полицейских, первый из которых на днях приступил к патрулированию улиц Дубая. Этот робот отдаленно схож с человеком по росту и весу, и использует распознавание лиц, чтобы помочь при поиске подозреваемых. Также он оснащен «детектором эмоций», распознающим жесты и эмоции людей на расстоянии до 1,5 м и может помогать людям на улицах города и в крупных торговых центрах. Для этого робот умеет общаться на шести языках, включая арабский и английский.

«Дубайский» робот не имеет отношения к Nvidia, он приведен просто в качестве примера. Но на выставке GTC было показано несколько других роботов с аналогичными задачами. Таких, как полицейский автомобиль будущего, который обеспечивает отслеживание активности автомобилей и пешеходов в реальном времени в качестве решения для будущих «умных городов».

Вероятно, пока что этот вариант не имеет полной автономности, так как в автомобиле установлен экран, который используется полицейскими в случае, если роботизированное ПО обнаружило что-то подозрительное — какие-то противоправные действия людей или отследило угнанный автомобиль. И пока что разбираться со всем подозрительным придется уже людям.

Но в ближайшем будущем достаточно просто совместить возможности автопилотируемых автомобилей и таких программно-аппаратных систем по отслеживанию активности людей и автомобилей, и как минимум автономный патрульный полицейский аппарат можно сделать довольно легко. Другое дело, что на какие-то более активные и разнообразные действия, вроде задержания преступников, пока что (пока что!) придется выезжать полицейским человеческим, а не роботам.

Были на выставке и роботы, помогающие в наведении общественного порядка, хотя и не человекоподобные, как дубайский вариант. Да оно и не всегда нужно, чтобы у робота были руки, ноги и голова. Главное, чтобы он выполнял возложенные на него задачи. Следующий робот умеет распознавать автомобили и номерные знаки, к примеру.

Ездит он себе спокойно по назначенному маршруту и проверяет автомобили на всевозможные нарушения, в том числе оплачена ли у них парковка, к примеру. И все это — в автоматическом режиме, без необходимости трудоустройства толпы парковочных комиссаров, которые будут работать в любом случае медленнее. Правда, не совсем понятно, как такой робот подвинет листик бумаги, совершенно случайно закрывающий номер автомобиля? Но, вероятно, и на такую хитрую гайку в будущем найдется свой робот с соответствующей резьбой...

Вообще, роботизация в сфере общественной безопасности на GTC была представлена довольно широко — вероятно, и спрос на такие решения больше, чем на другие. Следующий робот — Robotic Assistance Devices (RAD), основанный на платформе Nvidia Jetson, предназначен уже для более широкого круга задач, хотя и схожих с предыдущим — все они умеют двигаться и отслеживать активность людей и автомобилей.

При помощи высокопроизводительных и энергоэффективных решений Nvidia, робот RAD достигает высокого уровня автономии, при этом использует богатые возможности в сфере глубокого обучения и компьютерного зрения, которые помогают таким роботам обучаться в идентификации и классификации объектов интереса. При помощи искусственного интеллекта, такие роботы постоянно учатся, адаптируясь к изменениям, и могут быть переконфигурированы для решения других задач.

Еще одна интересная сфера, где роботы могут применяться уже сейчас — складские роботы и роботы-консультанты в розничных магазинах. Вторые могут заменить людей при решении задач по нахождению каких-либо товаров в магазинах и вполне способны проконсультировать по различным возможностям товаров, используя искусственный интеллект и общаясь с покупателями обычным голосом. А в случае чего, даже подведут их под ручку к нужной полке. Лишь бы те не убежали от них со страхом.

Или помощники на складе — на стенде Nvidia был показан рабочий образец такого «кладовщика», который также использует все ту же мегапопулярную систему Nvidia Jetson для того, чтобы с использованием возможностей ИИ общаться с покупателями или посетителями сервис-центра, находя и выдавая им необходимый товар со склада.

Да что тут говорить, уже в наше время очень многие вещи делаются без прямого участия человека. Так, в некоторых банках открывают экспериментальные отделения, которые полностью автоматизированы, лишены людей, и оснащены только банкоматом и переговорной комнатой для видеоконференций — в случае необходимости (для обсуждения сложных вопросов типа получения ипотечного кредита или составления плана накоплений), клиент назначает время через мобильное приложение и приходит в эту комнату для обсуждения вопросов по видеосвязи с живым сотрудником банка. А еще проще будет пообщаться с ним прямо из дома. В плюсах таких отделений — заметно меньшая требуемая площадь (роботизированные отделения позволяют вчетверо сократить занимаемую ими площадь) и затраты на рабочую силу.

Но далеко не только самоуправляемые автомобили и различные роботы были представлены на выставке конференции. К примеру, достаточно интересным нам показался демо-стенд компании Artec 3D, которая делает 3D-сканеры, в том числе очень интересные портативные модели, не требующие подключения к ПК. Компания была основана в середине 2000-х годов и является одним из лидеров на рынке 3D-сканеров, их технологии используются ведущими компаниями в разных отраслях, включая промышленное производство, дизайн, медицину и научные применения. Среди сотрудников компании много русскоязычных, хотя главный офис расположен в Люксембурге, но также есть офисы в Калифорнии и Москве.

Компания выпускает все новые и новые модели сканеров, обновляя и программное обеспечение для 3D-сканирования. Artec 3D известна своими портативными 3D-сканерами, а также системами полного сканирования человека. Одной из самых интересных моделей портативных сканеров является Artec Leo, включающий мощные вычислительные возможности, сенсорный экран и емкий аккумулятор, дающие устройству автономность и большую свободу действий при сканировании.

Artec Leo использует платформу Nvidia Jetson TX1, встроенную 9-осевую инерциальную систему, сочетающую акселерометр, гироскоп и компас, а также сдвоенную оптическую систему, созданную для точного распознавания текстур и геометрии. Также это самый быстрый на сегодня портативный профессиональный 3D-сканер, обеспечивающий скорость 3D-реконструции до 80 кадров в секунду. Широкий угол захвата изображения позволяет быстро сканировать и обрабатывать данные больших объектов. Главный плюс решения — отсутствие необходимости подключения к компьютеру и электрической сети, что позволяет удобно сканировать объекты любой формы и размера, получив почти полную свободу движений в процессе сканирования.

Для демонстрации возможностей сканеров компании в одном из залов выставочного центра Сан-Хосе был установлен специальный сканер для полноразмерного 3D-сканирования человека — Shapify. Технологии компании позволяют получить довольно точную модель человека примерно за 10 секунд сканирования, и эту модель затем можно получить в 3D-формате для того, чтобы использовать ее в трехмерных приложениях или распечатать на 3D-принтере.

Результирующая модель (прошу заметить, что люди на паре последних иллюстраций изображены разные!) получается практически без ошибок и артефактов, если выполнять все требования к сканированию (отсутствие близких и перекрывающих друг друга объектов типа очков и т. д.) и вполне годится для дальнейшего использования в указанных выше вариантах. Пожалуй, лучшей рекламы для продукции компании и не придумать.

Еще одной командой, о которой хотелось бы написать, является российская VisionLabs — один из лидеров в сфере распознавания объектов, разработчик уникальной технологии распознавания лиц, основанной на методах компьютерного зрения и глубокого обучения, что нас и интересует, прежде всего. Из преимуществ их технологий можно отметить высокую скорость, точное распознавание в различных условиях и работу с большим количеством изображений и видеороликов. Компания сотрудничает с такими компаниями, как Cisco, Intel, SAP, SAS, T-Systems и другими, что подтверждает их высокий класс. Так, более 25 банков уже используют возможности системы распознавания лиц, разработанную этой компанией.

На конференции GTC компания представляла свою новую технологию Face.DJ — построение фотореалистичной 3D-модели лица по одной двухмерной фотографии (селфи) за пару секунд. Компания заявляет, что это первая подобная технология, которая позволяет построить достаточно точную геометрическую сетку с реальной текстурой кожи с фотографии без использования специальных 3D-сканеров, а просто взяв любую камеру, в т. ч. фронтальную в смартфонах — никаких особенных требований к фото не предъявляется.

С технической точки зрения, технология Face.DJ сначала определяет само лицо на фото и такие его точки и детали, как глаза, брови, губы, нос и другие — вот эти шаги и используют алгоритмы машинного обучения на основе нейросети, натренированной на большой базе лиц с указанными вручную точками черт лица. Затем, на основе фотографии приложение строит геометрическую 3D-модель лица, деформируя (перемещая вершины) ее в зависимости от индивидуальных черт лица. И последним шагом на модель натягивается текстура. Технология дополнительно анализирует цвет кожи, чтобы продлить текстуру на все лицо — за пределы, которые видны на фото.

В дальнейшем, полученная 3D-модель может использоваться как угодно: в игровых приложениях для персонализации, в видео- и киноиндустрии, при создании аватаров в мессенджерах, в виртуальной и дополненной реальности и других сферах. Первым проектом, использующим новую технологию от VisionLabs, стало их же мобильное приложение Face.DJ, которое на данный момент доступно в App Store совершенно бесплатно.

Там уже сейчас можно немного поиграться со своей трехмерной моделью, примерив несколько вариантов очков и пару бород или причесок, хотя набор возможностей там пока что довольно скудный. Но компания планирует обновлять приложение, добавляя новую функциональность и улучшая точность сканирования.

Самой интересной функцией из списка запланированных, является возможность изменения эмоций и анимации для трехмерного аватара, в зависимости от эмоций пользователя, захватываемых фронтальной камерой. Обновленные версии приложения можно ожидать уже этим летом или осенью.

Если же у вас нет устройств на базе iOS, то можно опробовать новую технологию компании в веб-версии приложения, в которой доступно все то же самое.

Ну и последним применением технологий компании Nvidia в сфере искусственного интеллекта и глубокого обучения, на котором мы сегодня остановимся, является перенос стиля с одного изображения на другое (стилизация). Она дает возможность взять стиль художника (Моне, Рембрандта или любого другого на ваш вкус) и перенести его стиль на другое изображение.

Для статических картинок такая возможность появилась довольно давно, главное тут — натренировать нейросеть, а вот для обработки видеороликов высокого разрешения в реальном времени нужно, чтобы система могла быстро использовать уже обученную нейросеть (выполнять inference).

Компания Nvidia воспользовалась своими возможностями, написав демонстрационную версию такой программы, которая захватывает в реальном времени данные с видеокамеры и тут же, почти в реальном времени (с задержкой в 1-2 секунды) выводит их уже в измененном виде:

Пока что демонстрационная программа при видеозахвате в 4К-разрешении использует четыре вычислительных решения, основанных на чипах архитектуры Pascal (GP100), но уже на ускорителях Volta, которые появятся в ближайшем будущем, такая же задача будет выполняться в несколько раз быстрее, что позволит обойтись уже одним ускорителем вместо четырех — примерно такого скачка в производительности при использовании натренированных нейросетей мы и ожидаем от новой вычислительной архитектуры, представленной на GTC 2017.

Проект Endeavor — новый дом для компании Nvidia

В своих материалах мы неоднократно писали о четырех основных и нескольких вспомогательных зданиях компании Nvidia, расположенных в Санта-Кларе, но также мы давно уже знали, что компания вот уже несколько лет проектирует и строит новое здание большей площади рядом с нынешними.

И вот, после нескольких лет подготовки проекта и строительства, здание наконец-то обрело вид, достаточный для того, чтобы понять, как оно будет выглядеть. Проект получил название Endeavor (англ.: стремление), и в новом доме Nvidia есть на что посмотреть уже сейчас, когда оно все еще не достроено. Конец строительства намечен на осень этого года, когда после двухлетнего периода активного возведения строительных конструкций оно наконец-то обретет свой полноценный вид.

Если говорить о более точных датах основных этапов строительства, то начало работ над дизайном датируется июнем 2010 года, в июле 2015-го началась подготовка места строительства, в августе 2015-го приступили к самим строительным работам, возведя основу внешней конструкции в мае 2016-го, сейчас активно проводятся внутренние работы, а открытие планируется на сентябрь текущего года.

Здание спроектировано калифорнийской компанией Gensler, известной по дизайну Шанхайской башни — самого высокого здания Китая, оно имеет площадь в 500000 квадратных футов (46451,52 квадратных метров), рассчитано для размещения 2500 работников компании и содержит два уровня подземной парковки, что выгодно отличает новое здание от текущих, имеющих наружные парковочные места, занимающие очень много места, столь ценного в Кремниевой долине.

При проектировании здания использовались современные технологии компании, включая использование пакета Iray и виртуальной реальности, уникальный дизайн здания базируется на привычных для производителя графических процессоров треугольниках — именно такая форма была взята за основу в виде строительного блока, что видно на каждой фотографии с места строительства. И само здание имеет треугольный вид, и многие из деталей выполнены в виде треугольников, которые позволили выгодно сочетать эффективность и функциональность.

Форма у объекта симметричная, за исключением некоторых деталей, а уникальная волнообразная крыша здания выполнена из различных модулей в виде 245 равносторонних треугольников со стороной в 9 футов (2,74 метра). Над центральной частью (атриум) расположено большое окно для естественного освещения. Окон тут в принципе очень много — по сути, большая часть крыши, а всего здание имеет 6689 квадратных метров остекления.

Стеклянная крыша сделана из специальных видов стекла — в строительстве использованы четыре разных типа этого материала для того, чтобы поддерживать комфортную температуру внутри и максимально использовать возможности естественного освещения, что весьма актуально для солнечной Калифорнии.

Над атриумом используется чистое стекло, покрытое маленькими точками для того, чтобы смягчить солнечный свет и увеличить эффективность использования естественного освещения. Это стекло, которое используется еще и в световых люках над мезонином, дает пучки света там, где это необходимо. Мансардные окна, выходящие на юг, используют матовое стекло с точками, которое дает мягкий рассеянный свет, а окна в северной части с меньшим потоком солнечного света, застеклены простым матовым стеклом. В прозрачной «занавеске» вокруг здания используются тонированные панели, отрезающие половину поступающего света — также для управления температурой внутреннего воздуха и освещением.

Пространство внутри здания разделено на секции, предназначенные для работы и отдыха. Здание включает 22 больших конференц-зала, рассчитанных на 16 человек каждый, более 70 залов меньшего размера (на 6 и 11 человек), четыре очень больших зала на 150 человек, и много зон и комнат для открытой командной работы. Несмотря на то, что большая часть здания организована как открытое пространство, в нем есть множество небольших комнат для конфиденциальных переговоров, телефонных разговоров и других аналогичных задач.

Сердцем здания Endeavor является атриум высотой более 18 метров, который станет как бы центром притяжения для 2500 сотрудников компании. Целью этого пространства в центре является создание точка сбора и отдыха сотрудников, в нем же размещаются кафе на 800 мест, рассчитанное на приготовление 3000 ланчей ежедневно, как и прочие места для отдыха, где несколько более тепло и шумно, по сравнению с рабочим пространством. Которым со всех сторон и окружен атриум, включая конференц-залы и зоны совместной работы.

Решение open space для рабочих мест может показаться кому-то спорным и подходящим не для всех видов работы, но возможно это лишь дело привычки. А для задач, требующих конфиденциальности, всегда есть закрытые комнаты и залы. Выглядеть рабочие места будут примерно так:

Чтобы обеспечить конфиденциальность для работающих в центральных комнатах и снизить уровень шума, дизайнеры выполнили специальный навес, окружающий атриум, в виде облака, состоящего из сотен треугольных металлических панелей. Металл в качестве материала выбран для отражения света, поступающего в атриум сверху. Используется три типа панелей: некоторые из них имеют отверстия, пропускающие свет, другие цельные, а третьи заполнены звукоизоляционным материалом.

Можно сказать, что все в Endeavor посвящено повышению эффективности. К примеру, утверждается, что здание в активном виде будет потреблять на 75% меньше питьевой воды, по сравнению с существующими зданиями аналогичного размера — а ведь это сейчас важнейшая тема страдающей от засухи Калифорнии. Большая часть экономии воды получается за счет использования рециркуляции воды в системе охлаждения, туалетах и при поливе окружающей растительности.

В Nvidia решили подключиться к региональной системе рекультивации воды, управляемой специальным местным органом Santa Clara Water District. Рециркулированная вода будет поступать по трубам в специальную охлаждающую башню из нержавеющей стали, находящуюся в крыше здания, и будет использоваться для охлаждения здания при помощи испарительной системы и трех вентиляторов с лопастями диаметром в 2,4 метра. Знакомо по видеокартам, правда?