–Я—А–µ–∞–Љ–±—Г–ї–∞

–Я—А–Њ–і–Њ–ї–ґ–∞—П –≤–µ–Ї—В–Њ—А, –Ј–∞–і–∞–љ–љ—Л–є –µ—Й—С –≤ –Љ–µ—В–Њ–і–Є–Ї–µ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П 4.0 2009 –≥–Њ–і–∞, –Љ—Л –њ—А–µ–і—Б—В–∞–≤–ї—П–µ–Љ –≤–∞–Љ –Њ–±–љ–Њ–≤–ї—С–љ–љ—Г—О –≤–µ—А—Б–Є—О 4.5, –Ї–Њ—В–Њ—А–∞—П –±—Г–і–µ—В –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М—Б—П –і–ї—П —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ –Є –Ї–Њ–Љ–њ—М—О—В–µ—А–љ—Л—Е —Б–Є—Б—В–µ–Љ –љ–∞ –њ—А–Њ—В—П–ґ–µ–љ–Є–Є –≤—Б–µ–≥–Њ –Њ—Б—В–∞–≤—И–µ–≥–Њ—Б—П 2010 –≥–Њ–і–∞ –Є –љ–∞—З–∞–ї–∞ –≥–Њ–і–∞ 2011. –Ш—Б–Ї—Г—И—С–љ–љ—Л–µ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–Є –љ–∞–≤–µ—А–љ—П–Ї–∞ —Г–ґ–µ –њ–Њ–љ—П–ї–Є –њ–Њ –љ–Њ–Љ–µ—А—Г –≤–µ—А—Б–Є–Є, —З—В–Њ –љ–Є–Ї–∞–Ї–Є—Е –Ї–∞—А–і–Є–љ–∞–ї—М–љ—Л—Е –Є–Ј–Љ–µ–љ–µ–љ–Є–є –њ–Њ –Њ—В–љ–Њ—И–µ–љ–Є—О –Ї –њ—А–µ–і—Л–і—Г—Й–µ–є, –Љ—Л –≤–∞–Љ –љ–µ –њ—А–µ–і–ї–∞–≥–∞–µ–Љ: –±–Њ–ї–µ–µ-–Љ–µ–љ–µ–µ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л–Љ –Њ—Б—В–∞–љ–µ—В—Б—П –Є –њ–Њ–і—Е–Њ–і, –Є —Б–њ–Є—Б–Њ–Ї –≥—А—Г–њ–њ —В–µ—Б—В–Њ–≤, –Є —Б–њ–Є—Б–Њ–Ї –њ—А–Є–ї–Њ–ґ–µ–љ–Є–є. –Ю–і–љ–∞–Ї–Њ –Њ—В–ї–Є—З–Є–є —В–Њ–ґ–µ –љ–µ–Љ–∞–ї–Њ: –≤ –Љ–µ—В–Њ–і–Є–Ї—Г –≤–≤–µ–і–µ–љ—Л (–њ–Њ–Ї–∞ –≤ –Ї–∞—З–µ—Б—В–≤–µ –Њ–њ—Ж–Є–Њ–љ–∞–ї—М–љ—Л—Е) —В—А–Є –љ–Њ–≤—Л–µ –≥—А—Г–њ–њ—Л —В–µ—Б—В–Њ–≤, –і–∞ –Є –≤ —Б—В–∞—А—Л—Е –Є–љ–Њ–≥–і–∞ –њ—А–Є—Б—Г—В—Б—В–≤—Г—О—В –љ–µ —В–Њ–ї—М–Ї–Њ –Њ–±–љ–Њ–≤–ї—С–љ–љ—Л–µ –≤–µ—А—Б–Є–Є, –љ–Њ –Є —А–∞–љ–µ–µ –љ–µ –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ–Њ–µ –љ–∞–Љ–Є –Я–Ю. –Э–∞–њ–Њ–Љ–љ–Є–Љ, –≤–Ї—А–∞—В—Ж–µ, –≤ —З—С–Љ —Б–Њ—Б—В–Њ–Є—В —Б—Г—В—М –љ–∞—И–µ–≥–Њ –њ–Њ–і—Е–Њ–і–∞ –Ї —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—О –Є –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Є—О —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤.

–У—А—Г–њ–њ–Є—А–Њ–≤–Ї–∞ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤

–Ю–±—К–µ–і–Є–љ–µ–љ–Є–µ –њ—А–Є–ї–Њ–ґ–µ–љ–Є–є –≤ –≥—А—Г–њ–њ—Л –њ–Њ –љ–µ–Ї–Є–Љ –њ—А–Є–Ј–љ–∞–Ї–∞–Љ ¬Ђ—А–Њ–і—Б—В–≤–∞¬ї –њ—А–∞–Ї—В–Є–Ї—Г–µ—В—Б—П –љ–∞–Љ–Є —Г–ґ–µ –і–∞–≤–љ–Њ, —А–∞–≤–љ–Њ –Ї–∞–Ї –Є –њ—Г–±–ї–Є–Ї–∞—Ж–Є—П –≤ —В–µ–ї–µ —Б—В–∞—В—М–Є —В–Њ–ї—М–Ї–Њ –і–Є–∞–≥—А–∞–Љ–Љ —Б –Њ–±—Й–Є–Љ–Є –±–∞–ї–ї–∞–Љ–Є –њ–Њ –≥—А—Г–њ–њ–∞–Љ. –Я–Њ–і—А–Њ–±–љ—Л–µ —А–µ–Ј—Г–ї—М—В–∞—В—Л –њ–Њ –Ї–∞–ґ–і–Њ–Љ—Г —В–µ—Б—В—Г –≤—Л–Ї–ї–∞–і—Л–≤–∞—О—В—Б—П –≤ –≤–Є–і–µ –Њ—В–і–µ–ї—М–љ–Њ–є —В–∞–±–ї–Є—Ж—Л, —Б—Б—Л–ї–Ї–∞ –љ–∞ –Ї–Њ—В–Њ—А—Г—О –њ—А–Є—Б—Г—В—Б—В–≤—Г–µ—В –≤ —Б—В–∞—В—М–µ. –Я—А–Є—З–Є–љ–∞ —В–∞–Ї–Њ–≥–Њ –њ–Њ–і—Е–Њ–і–∞ –Њ—З–µ–≤–Є–і–љ–∞: —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤ –Њ—З–µ–љ—М –Љ–љ–Њ–≥–Њ. –Ґ–∞–Ї, –љ–∞–њ—А–Є–Љ–µ—А, –њ–Њ—Б–ї–µ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П –њ–Њ –Љ–µ—В–Њ–і–Є–Ї–µ, –Њ–њ–Є—Б–∞–љ–Є—О –Ї–Њ—В–Њ—А–Њ–є –њ–Њ—Б–≤—П—Й—С–љ –і–∞–љ–љ—Л–є –Љ–∞—В–µ—А–Є–∞–ї, –њ–Њ–ї—Г—З–∞–µ—В—Б—П –±–Њ–ї–µ–µ 100 —А–∞–Ј–ї–Є—З–љ—Л—Е —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤. –Я—А–µ–і—Б—В–∞–≤–ї—П–µ—В–µ —Б–µ–±–µ —Б—В–∞—В—М—О, –≤ –Ї–Њ—В–Њ—А–Њ–є 100+ –і–Є–∞–≥—А–∞–Љ–Љ? –Т–Њ—В –Є –Љ—Л —Б —В—А—Г–і–Њ–Љ. –Ш, —В–µ–Љ –±–Њ–ї–µ–µ, —В—А—Г–і–љ–Њ –њ—А–µ–і—Б—В–∞–≤–Є—В—М —З–µ–ї–Њ–≤–µ–Ї–∞, –Ї–Њ—В–Њ—А—Л–є –і–Њ—З–Є—В–∞–µ—В —В–∞–Ї—Г—О —Б—В–∞—В—М—О –і–Њ –Ї–Њ–љ—Ж–∞.

–Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –Њ–±—К–µ–і–Є–љ–µ–љ–Є–µ —В–µ—Б—В–Њ–≤ –≤ –≥—А—Г–њ–њ—Л, –Є, —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ, –Њ–±—К–µ–і–Є–љ–µ–љ–Є–µ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤ –≤ –љ–µ–Ї–Є–є –Њ–±—Й–µ–≥—А—Г–њ–њ–Њ–≤–Њ–є –±–∞–ї–ї, –њ—А–Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–Є –±–Њ–ї–µ–µ-–Љ–µ–љ–µ–µ –њ–Њ–і—А–Њ–±–љ–Њ–є –Љ–µ—В–Њ–і–Є–Ї–Є (–њ—А–µ–і–њ–Њ–ї–∞–≥–∞—О—Й–µ–є –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –±–Њ–ї—М—И–Њ–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ —В–µ—Б—В–Њ–≤) вАФ –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є –љ–µ–Є–Ј–±–µ–ґ–љ–Њ. –Ю–і–љ–∞–Ї–Њ –Њ—В –∞–Ї–Ї—Г—А–∞—В–љ–Њ—Б—В–Є –њ–ї–∞–љ–Є—А–Њ–≤–∞–љ–Є—П –Њ–±—К–µ–і–Є–љ—П—О—Й–Є—Е –≥—А—Г–њ–њ –љ–∞–њ—А—П–Љ—Г—О –Ј–∞–≤–Є—Б–Є—В, —З—В–Њ –њ–Њ–ї—Г—З–Є—В—Б—П –≤ —А–µ–Ј—Г–ї—М—В–∞—В–µ: –Є–ї–Є –њ—А–Њ—Б—В–Њ –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –≥—А—Г–њ–њ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤ –≤–Љ–µ—Б—В–Њ –Њ–і–љ–Њ–є –±–Њ–ї—М—И–Њ–є –≥—А—Г–њ–њ—Л, –Є–ї–Є –љ–µ—З—В–Њ —Б—В—А–Њ–є–љ–Њ–µ, –ї–Њ–≥–Є—З–љ–Њ–µ –Є –Њ—Б–Љ—Л—Б–ї–µ–љ–љ–Њ–µ. –Э–∞—З–Є–љ–∞—П —Б –њ—А–µ–і—Л–і—Г—Й–µ–є –≤–µ—А—Б–Є–Є –Љ–µ—В–Њ–і–Є–Ї–Є, –Љ—Л –Њ–Ї–Њ–љ—З–∞—В–µ–ї—М–љ–Њ –њ–µ—А–µ—И–ї–Є –Ї –њ—А–Є–љ—Ж–Є–њ—Г –Њ–±—К–µ–і–Є–љ–µ–љ–Є—П –њ–Њ —Б—Е–Њ–і—Б—В–≤—Г –≤—Л–њ–Њ–ї–љ—П–µ–Љ—Л—Е –Ј–∞–і–∞—З.

–Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, –Љ—Л —А–µ—И–Є–ї–Є –Њ–Ї–Њ–љ—З–∞—В–µ–ї—М–љ–Њ —А–∞–Ј–≥—А–∞–љ–Є—З–Є—В—М —В–µ—Е–љ–Є—З–µ—Б–Ї—Г—О –Є –Њ–њ–Є—Б–∞—В–µ–ї—М–љ—Г—О —З–∞—Б—В—М –Љ–µ—В–Њ–і–Є–Ї–Є, –Њ–≥—А–∞–љ–Є—З–Є–≤—И–Є—Б—М –њ—Г–±–ї–Є–Ї–∞—Ж–Є–µ–є –њ–Њ—Б–ї–µ–і–љ–µ–є. –≠—В–Њ –љ–µ –Ј–љ–∞—З–Є—В, —З—В–Њ –љ–∞—И–∞ –Љ–µ—В–Њ–і–Є–Ї–∞ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П —Б—В–∞–ї–∞ ¬Ђ–Ј–∞–Ї—А—Л—В–Њ–є¬ї вАФ –ї—О–±–Њ–є –ґ–µ–ї–∞—О—Й–Є–є –≤ –ї—О–±–Њ–є –Љ–Њ–Љ–µ–љ—В –≤—А–µ–Љ–µ–љ–Є –Љ–Њ–ґ–µ—В –Њ–±—А–∞—В–Є—В—М—Б—П –њ–Њ –∞–і—А–µ—Б—Г, —Г–Ї–∞–Ј–∞–љ–љ–Њ–Љ—Г –≤ –Ї–Њ–љ—Ж–µ —Б—В–∞—В—М–Є, –Є –њ–Њ–ї—Г—З–Є—В—М –≤—Б–µ –љ–µ–Њ–±—Е–Њ–і–Є–Љ—Л–µ —А–∞–Ј—К—П—Б–љ–µ–љ–Є—П –Њ—В–љ–Њ—Б–Є—В–µ–ї—М–љ–Њ —В–µ—Е–љ–Є—З–µ—Б–Ї–Є—Е –њ–Њ–і—А–Њ–±–љ–Њ—Б—В–µ–є –Њ—А–≥–∞–љ–Є–Ј–∞—Ж–Є–Є –Є –њ—А–Њ–≤–µ–і–µ–љ–Є—П —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П. –Я—А–Њ—Б—В–Њ –љ–∞–Љ –Ї–∞–ґ–µ—В—Б—П, —З—В–Њ –љ–µ —Б—В–Њ–Є—В –њ—А–µ–≤—А–∞—Й–∞—В—М –Њ–Ј–љ–∞–Ї–Њ–Љ–Є—В–µ–ї—М–љ—Г—О —Б—В–∞—В—М—О –≤ –њ–Њ–і—А–Њ–±–љ—Л–є —В–µ—Е–љ–Є—З–µ—Б–Ї–Є–є –і–Њ–Ї—Г–Љ–µ–љ—В, –Є–ї–Є –ґ–µ –њ—Л—В–∞—В—М—Б—П —Б–Ї—А–µ—Б—В–Є—В—М —Н—В–Є –ґ–∞–љ—А—Л –≤ —А–∞–Љ–Ї–∞—Е –Њ–і–љ–Њ–≥–Њ –Љ–∞—В–µ—А–Є–∞–ї–∞. –Ф–ї—П —В–µ—Е, –Ї—В–Њ –ґ–µ–ї–∞–µ—В –њ–Њ–љ—П—В—М –Њ–±—Й–Є–µ –њ—А–Є–љ—Ж–Є–њ—Л, –њ–Њ –Ї–Њ—В–Њ—А—Л–Љ –Њ—А–≥–∞–љ–Є–Ј–Њ–≤–∞–љ—Л –љ–∞—И–Є —В–µ—Б—В—Л, –±—Г–і–µ—В –≤–њ–Њ–ї–љ–µ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ—А–Є–≤–µ–і–µ–љ–љ—Л—Е –Ј–і–µ—Б—М –Њ–њ–Є—Б–∞–љ–Є–є, ¬Ђ—В–µ—Е–љ–∞—А—П–Љ¬ї –ґ–µ –Љ—Л –ї—Г—З—И–µ –њ—А–µ–і–Њ—Б—В–∞–≤–Є–Љ –Є—Б—З–µ—А–њ—Л–≤–∞—О—Й—Г—О —В–µ—Е–љ–Є—З–µ—Б–Ї—Г—О –і–Њ–Ї—Г–Љ–µ–љ—В–∞—Ж–Є—О, –±–µ–Ј –љ–µ–љ—Г–ґ–љ–Њ–є –Є–Љ ¬Ђ–ї–Є—В–µ—А–∞—В—Г—А–љ–Њ–є¬ї —Б–Њ—Б—В–∞–≤–ї—П—О—Й–µ–є.

–Я–Њ—Б—В–Њ—П–љ–љ–∞—П —Б–Њ—Б—В–∞–≤–ї—П—О—Й–∞—П

–Я—А–Є –ї—О–±—Л—Е —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П—Е –≤ —А–∞–Љ–Ї–∞—Е –Љ–µ—В–Њ–і–Є–Ї–Є –≤–µ—А—Б–Є–Є 4.5, –њ–Њ—Б—В–Њ—П–љ–љ—Л–Љ–Є –Њ—Б—В–∞—О—В—Б—П —Б–ї–µ–і—Г—О—Й–Є–µ –њ—А–Њ–≥—А–∞–Љ–Љ–љ—Л–µ –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В—Л:

- Microsoft Windows 7 Ultimate x64;

- ATI Catalyst Drivers 10.3.

–Ґ–∞–Ї–ґ–µ, –µ—Б–ї–Є —А–µ—З—М –Є–і—С—В –Њ –њ—А–Є–Љ–µ–љ–µ–љ–Є–Є –Љ–µ—В–Њ–і–Є–Ї–Є –і–ї—П —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤, –њ–Њ—Б—В–Њ—П–љ–љ—Л–Љ–Є –Њ—Б—В–∞—О—В—Б—П —Б–ї–µ–і—Г—О—Й–Є–µ –∞–њ–њ–∞—А–∞—В–љ—Л–µ –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В—Л:

- 22" –Љ–Њ–љ–Є—В–Њ—А —Б —А–∞–Ј—А–µ—И–µ–љ–Є–µ–Љ 1680x1050.

- –Т–Є–і–µ–Њ–Ї–∞—А—В–∞ ATI Radeon HD 5870, 1 GB GDDR5;

- –С–ї–Њ–Ї –њ–Є—В–∞–љ–Є—П Cooler Master Real Power M1000;

- –Т–Є–љ—З–µ—Б—В–µ—А Samsung HD103SJ, 1 TB.

3D-–≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є—П

–Я–Ю, –≤—Е–Њ–і—П—Й–µ–µ –≤ —Н—В—Г –≥—А—Г–њ–њ—Г, –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Њ –і–≤—Г–Љ—П –±–Њ–ї—М—И–Є–Љ–Є –Ї–ї–∞—Б—Б–∞–Љ–Є: —Н—В–Њ –њ–∞–Ї–µ—В—Л –і–ї—П —А–∞–±–Њ—В—Л —Б —В—А—С—Е–Љ–µ—А–љ–Њ–є –≥—А–∞—Д–Є–Ї–Њ–є (3ds max, Maya, Lightwave) –Є —Б–Є—Б—В–µ–Љ—Л –∞–≤—В–Њ–Љ–∞—В–Є–Ј–Є—А–Њ–≤–∞–љ–љ–Њ–≥–Њ –њ—А–Њ–µ–Ї—В–Є—А–Њ–≤–∞–љ–Є—П (SolidWorks, Pro/ENGINEER, UGS NX). –Ю—Б–Њ–±–µ–љ–љ–Њ—Б—В–Є —Н—В–Є—Е –і–≤—Г—Е –Ї–ї–∞—Б—Б–Њ–≤ —Б–Њ—Б—В–Њ—П—В –≤ —В–Њ–Љ, —З—В–Њ –Ї–∞–ґ–і—Л–є –Є–Ј –љ–Є—Е, –Ї—А–Њ–Љ–µ –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є–Є, –≤—Л–њ–Њ–ї–љ—П–µ—В –Є –і—А—Г–≥–Є–µ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ —А–µ—Б—Г—А—Б–Њ—С–Љ–Ї–Є–µ –Њ–њ–µ—А–∞—Ж–Є–Є: –≤ —Б–ї—Г—З–∞–µ –њ–∞–Ї–µ—В–Њ–≤ —В—А—С—Е–Љ–µ—А–љ–Њ–≥–Њ –Љ–Њ–і–µ–ї–Є—А–Њ–≤–∞–љ–Є—П —Н—В–Њ —А–µ–љ–і–µ—А–Є–љ–≥, –≤ —Б–ї—Г—З–∞–µ –°–Р–Я–† (CAD) вАФ –Є–љ–ґ–µ–љ–µ—А–љ—Л–µ —А–∞—Б—З—С—В—Л. –Я–Њ—Н—В–Њ–Љ—Г –Љ—Л —А–µ—И–Є–ї–Є –≤ —А–∞–Љ–Ї–∞—Е –≥—А—Г–њ–њ—Л ¬Ђ3D-–≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є—П¬ї —А–µ–Ј—Г–ї—М—В–∞—В—Л —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П –≤–Њ –≤—Б–µ—Е —Н—В–Є—Е –њ—А–Њ–≥—А–∞–Љ–Љ–∞—Е –Њ–±—К–µ–і–Є–љ–Є—В—М, –∞ —А–µ–Ј—Г–ї—М—В–∞—В—Л, –Њ—В–љ–Њ—Б—П—Й–Є–µ—Б—П –Ї –і—А—Г–≥–Є–Љ —В–Є–њ–∞–Љ –љ–∞–≥—А—Г–Ј–Ї–Є, —Г—З–Є—В—Л–≤–∞—В—М –≤ –і—А—Г–≥–Є—Е –≥—А—Г–њ–њ–∞—Е. –°–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ, –і–ї—П –њ–∞–Ї–µ—В–Њ–≤ 3D-–Љ–Њ–і–µ–ї–Є—А–Њ–≤–∞–љ–Є—П —Н—В–Њ –≥—А—Г–њ–њ–∞ ¬Ђ–Ґ—А—С—Е–Љ–µ—А–љ—Л–є —А–µ–љ–і–µ—А–Є–љ–≥¬ї, –∞ –і–ї—П –°–Р–Я–† вАФ –≥—А—Г–њ–њ–∞ ¬Ђ–Ш–љ–ґ–µ–љ–µ—А–љ—Л–µ –Є –љ–∞—Г—З–љ—Л–µ —А–∞—Б—З—С—В—Л¬ї. –Ґ–µ–њ–µ—А—М —А–∞—Б—Б–Љ–Њ—В—А–Є–Љ –±–Њ–ї–µ–µ –њ–Њ–і—А–Њ–±–љ–Њ –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–љ–Њ–µ –≤ –≥—А—Г–њ–њ–µ –Я–Ю –Є —В–µ—Б—В—Л.

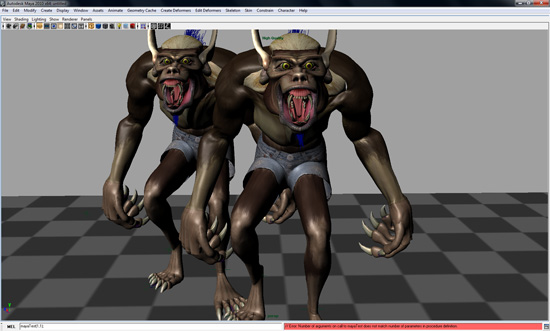

3ds max

–Ь—Л –њ—А–Њ–і–Њ–ї–ґ–∞–µ–Љ —Б —Б–Њ–ґ–∞–ї–µ–љ–Є–µ–Љ –Ї–Њ–љ—Б—В–∞—В–Є—А–Њ–≤–∞—В—М –Њ—В—Б—Г—В—Б—В–≤–Є–µ —В–µ—Б—В–∞ SPECapc –і–ї—П –∞–Ї—В—Г–∞–ї—М–љ–Њ–є –љ–∞ –і–∞–љ–љ—Л–є –Љ–Њ–Љ–µ–љ—В –≤–µ—А—Б–Є–Є 3ds max, —З—В–Њ –≤—Л–љ—Г–ґ–і–∞–µ—В –љ–∞—Б –њ—А–Є–±–µ–≥–∞—В—М –Ї –≤—Б—С –±–Њ–ї—М—И–µ–Љ—Г –Ї–Њ–ї–Є—З–µ—Б—В–≤—Г —Г—Е–Є—Й—А–µ–љ–Є–є, —З—В–Њ–±—Л –њ—А–Њ–і–Њ–ї–ґ–∞—В—М –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М —Б –љ–Њ–≤–Њ–є –≤–µ—А—Б–Є–µ–є –њ–∞–Ї–µ—В–∞ –±–µ–љ—З–Љ–∞—А–Ї, –≤—Л–њ—Г—Й–µ–љ–љ—Л–є –µ—Й—С –≤ 2007 –≥–Њ–і—Г. –£–≤—Л, —А–∞–≤–љ–Њ–≥–Њ –њ–Њ —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї—Г SPECapc for 3ds max 9 –∞–ї—М—В–µ—А–љ–∞—В–Є–≤–љ–Њ–≥–Њ –±–µ–љ—З–Љ–∞—А–Ї–∞, –Љ—Л –љ–µ –Ј–љ–∞–µ–Љ. –Ю–і–љ–∞–Ї–Њ —Б–Є—В—Г–∞—Ж–Є—П –≥–Њ–і –Њ—В –≥–Њ–і–∞ —Г—Е—Г–і—И–∞–µ—В—Б—П: –љ–µ –≤—Б–µ —Д—А–∞–≥–Љ–µ–љ—В—Л —В–µ—Б—В–Њ–≤–Њ–≥–Њ —Б–Ї—А–Є–њ—В–∞ –Ї–Њ—А—А–µ–Ї—В–љ–Њ —А–∞–±–Њ—В–∞—О—В —Б –љ–Њ–≤—Л–Љ–Є –≤–µ—А—Б–Є—П–Љ–Є, —В–∞–Ї —З—В–Њ –µ–≥–Њ –њ—А–Є—Е–Њ–і–Є—В—Б—П –Љ–Њ–і–Є—Д–Є—Ж–Є—А–Њ–≤–∞—В—М, –Є—Б–Ї–ї—О—З–∞—П –љ–µ—Б–Њ–≤–Љ–µ—Б—В–Є–Љ—Л–µ —Д—А–∞–≥–Љ–µ–љ—В—Л. –Т —Н—В–Њ–є –≤–µ—А—Б–Є–Є –Љ–µ—В–Њ–і–Є–Ї–Є, –љ–∞–Љ –њ—А–Є—И–ї–Њ—Б—М –њ–Њ—Б—В—Г–њ–Є—В—М –µ—Й—С –±–Њ–ї–µ–µ —А–∞–і–Є–Ї–∞–ї—М–љ–Њ, —З–µ–Љ –≤ –њ—А–µ–і—Л–і—Г—Й–Є—Е: —В–µ—Б—В—Л –љ–∞ —Б–Ї–Њ—А–Њ—Б—В—М —А–µ–љ–і–µ—А–Є–љ–≥–∞ –Љ—Л —Г–±—А–∞–ї–Є –≤–Њ–Њ–±—Й–µ, —Б–Њ–Ј–і–∞–≤ —Б–≤–Њ–є —Б–Њ–±—Б—В–≤–µ–љ–љ—Л–є –љ–∞ –Њ—Б–љ–Њ–≤–µ –Њ–і–љ–Њ–є –Є–Ј —Б—Ж–µ–љ –Є–Ј –±–µ–љ—З–Љ–∞—А–Ї–∞ –Њ—В SPEC, –љ–Њ –≤ ¬Ђ—Г—Б–ї–Њ–ґ–љ—С–љ–љ–Њ–є —А–µ–і–∞–Ї—Ж–Є–Є¬ї –Є —Б –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ–Љ —А–µ–љ–і–µ—А-–і–≤–Є–ґ–Ї–∞ V-Ray. –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, —В–µ–њ–µ—А—М, —В–Њ—З–љ–Њ —В–∞–Ї –ґ–µ –Ї–∞–Ї —А–∞–љ–µ–µ –≤ Maya, —В–µ—Б—В –Њ—В SPEC –Њ—В–≤–µ—З–∞–µ—В —В–Њ–ї—М–Ї–Њ –Ј–∞ ¬Ђ–≥—А–∞—Д–Є—З–µ—Б–Ї–Є–є¬ї –±–∞–ї–ї, –∞ —А–µ–љ–і–µ—А–Є–љ–≥ —В–µ—Б—В–Є—А—Г–µ—В—Б—П –Њ—В–і–µ–ї—М–љ–Њ, —Б –њ–Њ–Љ–Њ—Й—М—О —В–µ—Б—В–∞ –љ–∞—И–µ–є —Б–Њ–±—Б—В–≤–µ–љ–љ–Њ–є —А–∞–Ј—А–∞–±–Њ—В–Ї–Є.

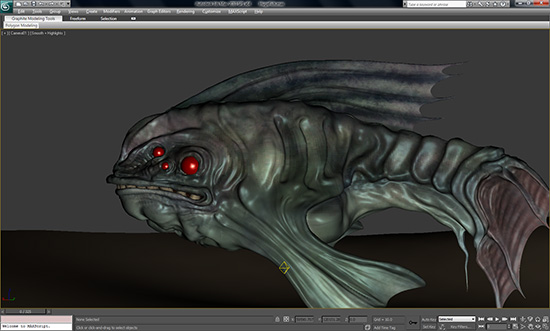

Maya

SPEC —В–∞–Ї–Є –≤—Л–њ—Г—Б—В–Є–ї–∞ –Њ–±–љ–Њ–≤–ї—С–љ–љ—Г—О –≤–µ—А—Б–Є—О –±–µ–љ—З–Љ–∞—А–Ї–∞ –і–ї—П Maya, –Њ–і–љ–∞–Ї–Њ ¬Ђ–і–Њ–≥–љ–∞—В—М¬ї —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–∞ вАФ Autodesk вАФ –µ–є –≤—Б—С —А–∞–≤–љ–Њ –љ–µ —Г–і–∞–ї–Њ—Б—М. –Я–Њ—Н—В–Њ–Љ—Г –≤ –і–∞–љ–љ–Њ–є –≤–µ—А—Б–Є–Є –Љ–µ—В–Њ–і–Є–Ї–Є –Љ—Л –њ—А–Є–Љ–µ–љ—П–µ–Љ —В–µ—Б—В SPECapc for Maya 2009 –≤ –Ї–Њ–Љ–±–Є–љ–∞—Ж–Є–Є —Б Autodesk Maya 2010. –С–ї–∞–≥–Њ, –≤—Л—И–µ—Г–њ–Њ–Љ—П–љ—Г—В—Л–µ –њ–∞–Ї–µ—В—Л –≤–њ–Њ–ї–љ–µ —Е–Њ—А–Њ—И–Њ ¬Ђ–і—А—Г–ґ–∞—В¬ї –Љ–µ–ґ–і—Г —Б–Њ–±–Њ–є, —А–∞–±–Њ—В–∞—П –≤ –њ–∞—А–µ –±–µ–Ј —Б–±–Њ–µ–≤ –Є –≤—Л–і–∞–≤–∞—П –≤–њ–Њ–ї–љ–µ –∞–і–µ–Ї–≤–∞—В–љ—Л–µ —А–µ–Ј—Г–ї—М—В–∞—В—Л. –Ґ—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ, —В–µ—Б—В –Њ—В SPEC —Б–Њ–і–µ—А–ґ–Є—В —В–Њ–ї—М–Ї–Њ –Є–љ—В–µ—А–∞–Ї—В–Є–≤–љ—Г—О —Б–Њ—Б—В–∞–≤–ї—П—О—Й—Г—О, –Є –љ–µ –Њ—Ж–µ–љ–Є–≤–∞–µ—В —Б–Ї–Њ—А–Њ—Б—В—М —А–µ–љ–і–µ—А–Є–љ–≥–∞. –Ь—Л –Є—Б–њ—А–∞–≤–ї—П–µ–Љ —Н—В–Њ—В –љ–µ–і–Њ—Б—В–∞—В–Њ–Ї –Њ–њ—П—В—М-—В–∞–Ї–Є —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л–Љ –і–ї—П –љ–∞—Б —Б–њ–Њ—Б–Њ–±–Њ–Љ: —Б –њ–Њ–Љ–Њ—Й—М—О –Ј–∞–Љ–µ—А–∞ –≤—А–µ–Љ–µ–љ–Є —А–µ–љ–і–µ—А–Є–љ–≥–∞ –љ–∞—И–µ–є —Б–Њ–±—Б—В–≤–µ–љ–љ–Њ–є —Б—Ж–µ–љ—Л –і–ї—П Maya (–Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П —А–µ–љ–і–µ—А MentalRay). –Ь–Њ–ґ–љ–Њ —Б–Ї–∞–Ј–∞—В—М, —З—В–Њ –≤ –і–∞–љ–љ–Њ–Љ —В–µ—Б—В–µ –њ–Њ –Њ—В–љ–Њ—И–µ–љ–Є—О –Ї –њ—А–µ–і—Л–і—Г—Й–µ–є –≤–µ—А—Б–Є–Є –Љ–µ—В–Њ–і–Є–Ї–Є –љ–Є—З–µ–≥–Њ –љ–µ –Є–Ј–Љ–µ–љ–Є–ї–Њ—Б—М, –Ј–∞ –Є—Б–Ї–ї—О—З–µ–љ–Є–µ–Љ –≤–µ—А—Б–Є–є –±–µ–љ—З–Љ–∞—А–Ї–∞ –Є –Я–Ю. –Я—А–∞–≤–і–∞, —Б–∞–Љ –±–µ–љ—З–Љ–∞—А–Ї SPEC –і–Њ—Б—В–∞—В–Њ—З–љ–Њ —Б–Є–ї—М–љ–Њ –њ–µ—А–µ—А–∞–±–Њ—В–∞–ї–∞: –њ–Њ—П–≤–Є–ї–Є—Б—М —Б–Њ–≤—Б–µ–Љ –љ–Њ–≤—Л–µ —Б—Ж–µ–љ—Л, –±—Л–ї–Є —Б—Г—Й–µ—Б—В–≤–µ–љ–љ–Њ ¬Ђ—Г—В—П–ґ–µ–ї–µ–љ—Л¬ї —Б—В–∞—А—Л–µ.

Lightwave

–Ґ–µ—Б—В SPEC –і–ї—П Lightwave 3 D 9.6, –Љ—Л –≤–њ–µ—А–≤—Л–µ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–ї–Є –≤ –њ—А–µ–і—Л–і—Г—Й–µ–є –≤–µ—А—Б–Є–Є –Љ–µ—В–Њ–і–Є–Ї–Є, –Є –њ–Њ —А–µ–Ј—Г–ї—М—В–∞—В–∞–Љ –±–Њ–ї–µ–µ —З–µ–Љ –≥–Њ–і–Є—З–љ–Њ–≥–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П, –Њ–љ –Њ–Ї–∞–Ј–∞–ї—Б—П –≤–њ–Њ–ї–љ–µ –∞–і–µ–Ї–≤–∞—В–љ—Л–Љ. –Т —Н—В—Г –Љ–µ—В–Њ–і–Є–Ї—Г –і–∞–љ–љ—Л–є —В–µ—Б—В –њ–µ—А–µ–Ї–Њ—З–µ–≤–∞–ї –њ–Њ–ї–љ–Њ—Б—В—М—О –±–µ–Ј –Є–Ј–Љ–µ–љ–µ–љ–Є–є, —А–∞–≤–љ–Њ –Ї–∞–Ї –Є —Б–∞–Љ –њ—А–Њ–≥—А–∞–Љ–Љ–љ—Л–є –њ–∞–Ї–µ—В вАФ NewTek Lightwave 3D 9.6 x64.

SolidWorks

–≠—В–Њ—В –њ—А–Њ–≥—А–∞–Љ–Љ–љ—Л–є –њ–∞–Ї–µ—В –њ—А–Є—Б—Г—В—Б—В–≤—Г–µ—В –≤ –љ–∞—И–µ–є –Љ–µ—В–Њ–і–Є–Ї–µ —Г–ґ–µ –љ–µ –њ–µ—А–≤—Л–є –≥–Њ–і. –Э–Њ, –Ї —Б–Њ–ґ–∞–ї–µ–љ–Є—О, –Ј–∞ –≤—Б–µ —Н—В–Є –≥–Њ–і—Л SPEC —В–∞–Ї –Є –љ–µ –≤—Л–њ—Г—Б—В–Є–ї–∞ –љ–Є –Њ–і–љ–Њ–≥–Њ –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П —Б–≤–Њ–µ–≥–Њ –±–µ–љ—З–Љ–∞—А–Ї–∞, –њ–Њ—Н—В–Њ–Љ—Г —Б –≤—Л—Е–Њ–і–Њ–Љ –Ї–∞–ґ–і–Њ–є –љ–Њ–≤–Њ–є –≤–µ—А—Б–Є–Є SolidWorks, –Љ—Л, –Ј–∞—В–∞–Є–≤ –і—Л—Е–∞–љ–Є–µ, –Ј–∞–њ—Г—Б–Ї–∞–µ–Љ –љ–∞ –љ–µ–є –≤ –њ–µ—А–≤—Л–є —А–∞–Ј SPECaps for SolidWorks 2007... –Є –Њ–±–ї–µ–≥—З—С–љ–љ–Њ –≤–Ј–і—Л—Е–∞–µ–Љ: –Њ–њ—П—В—М –њ–Њ–≤–µ–Ј–ї–Њ вАФ —А–∞–±–Њ—В–∞–µ—В. –°–∞–Љ –±–µ–љ—З–Љ–∞—А–Ї, –њ–Њ —Б—Г—В–Є, –Њ—З–µ–љ—М –њ–Њ—Е–Њ–ґ (–і–∞–ґ–µ –≤–љ–µ—И–љ–µ) –љ–∞ –њ—А–Њ—З–Є–µ —В–µ—Б—В—Л SPECapc вАФ –≤ —В–Њ–Љ —З–Є—Б–ї–µ –Є –і–ї—П –њ–∞–Ї–µ—В–Њ–≤ —В—А—С—Е–Љ–µ—А–љ–Њ–≥–Њ –Љ–Њ–і–µ–ї–Є—А–Њ–≤–∞–љ–Є—П: –Њ–љ –Ј–∞–Љ–µ—А—П–µ—В –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –≤ —В—А—С—Е –∞—Б–њ–µ–Ї—В–∞—Е вАФ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–Ј–∞–≤–Є—Б–Є–Љ—Л–µ –Њ–њ–µ—А–∞—Ж–Є–Є, –≥—А–∞—Д–Є–Ї–∞, –Њ–њ–µ—А–∞—Ж–Є–Є –≤–≤–Њ–і–∞-–≤—Л–≤–Њ–і–∞ (–і–µ-—Д–∞–Ї—В–Њ —А–µ—З—М –Є–і—С—В –Њ —Б–Ї–Њ—А–Њ—Б—В–Є –і–Є—Б–Ї–Њ–≤–Њ–є –њ–Њ–і—Б–Є—Б—В–µ–Љ—Л). –†–µ–Ј—Г–ї—М—В–∞—В—Л –њ—А–µ–і—Б—В–∞–≤–ї—П—О—В —Б–Њ–±–Њ–є –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ —Б–µ–Ї—Г–љ–і, –Ї–Њ—В–Њ—А–Њ–µ –±—Л–ї–Њ –Ј–∞—В—А–∞—З–µ–љ–Њ –љ–∞ –≤—Л–њ–Њ–ї–љ–µ–љ–Є–µ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–Є—Е —З–∞—Б—В–µ–є –±–µ–љ—З–Љ–∞—А–Ї–∞ (—Б–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ, –ї—Г—З—И–Є–Љ —П–≤–ї—П–µ—В—Б—П –Љ–µ–љ—М—И–Є–є —А–µ–Ј—Г–ї—М—В–∞—В). –Э–∞–њ–Њ–Љ–љ–Є–Љ, —З—В–Њ –≤ –і–∞–љ–љ–Њ–Љ —А–∞–Ј–і–µ–ї–µ —Г—З–∞—Б—В–≤—Г–µ—В —В–Њ–ї—М–Ї–Њ –Њ–і–Є–љ —А–µ–Ј—Г–ї—М—В–∞—В —В–µ—Б—В–∞ вАФ ¬ЂGraphics¬ї.

Pro/ENGINEER

–Ф–ї—П Pro/ENGINEER –Љ—Л –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ OCUS Benchmark, —В–∞–Ї –Ї–∞–Ї —Н—В–Њ—В —В–µ—Б—В —А–∞–Ј–≤–Є–≤–∞–µ—В—Б—П –љ–∞–Љ–љ–Њ–≥–Њ –і–Є–љ–∞–Љ–Є—З–љ–µ–µ SPECapc for Pro/ENGINEER вАФ —Г –љ–µ–≥–Њ –µ—Б—В—М 64-–±–Є—В–љ–∞—П –≤–µ—А—Б–Є—П, –≤ –Ї–Њ—В–Њ—А–Њ–є –Ј–∞–і–µ–є—Б—В–≤—Г–µ—В—Б—П –±–Њ–ї—М—И–Њ–є –Њ–±—К—С–Љ –Ю–Ч–£ (–∞ —Н—В–Њ –љ–∞ –њ—А–∞–Ї—В–Є–Ї–µ –Њ–Ї–∞–Ј–∞–ї–Њ—Б—М –Њ–і–љ–Є–Љ –Є–Ј —Б–∞–Љ—Л—Е –≥–ї–∞–≤–љ—Л—Е –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤ 64-–±–Є—В–љ—Л—Е —Б–Є—Б—В–µ–Љ), –±–µ–љ—З–Љ–∞—А–Ї –њ–Њ–і–і–µ—А–ґ–Є–≤–∞–µ—В —Б–∞–Љ—Г—О —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Г—О –≤–µ—А—Б–Є—О Pro/ENGINEER Wildfire. –Ґ–Њ –µ—Б—В—М –љ–µ—В –љ–Є –Њ–і–љ–Њ–≥–Њ –њ–Њ–≤–Њ–і–∞ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М —Б—В–∞—А—Л–є —В–µ—Б—В –Њ—В SPEC. –Э–µ—Б–Љ–Њ—В—А—П –љ–∞ —В–Њ, —З—В–Њ OCUS Benchmark —А–∞–Ј—А–∞–±–∞—В—Л–≤–∞–µ—В—Б—П —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ –љ–µ–Ј–∞–≤–Є—Б–Є–Љ–Њ, –≤ –љ—С–Љ —В–∞–Ї–ґ–µ –њ—А–Є—Б—Г—В—Б—В–≤—Г—О—В —В—А–Є —А–µ–Ј—Г–ї—М—В–∞—В–∞ —Г–ґ–µ –Ј–љ–∞–Ї–Њ–Љ–Њ–≥–Њ –љ–∞–Љ —В–Є–њ–∞: ¬ЂGraphics related tasks¬ї, ¬ЂCPU related tasks¬ї –Є ¬ЂDisk related tasks¬ї. –Ъ–∞–Ї –Є –≤ —Б–ї—Г—З–∞–µ —Б –њ—А–µ–і—Л–і—Г—Й–Є–Љ —В–µ—Б—В–Њ–Љ, —Н—В–Њ —Б—Г–Љ–Љ–∞ —Б–µ–Ї—Г–љ–і, –њ–Њ—В—А–∞—З–µ–љ–љ—Л—Е –љ–∞ –≤—Л–њ–Њ–ї–љ–µ–љ–Є–µ –Ј–∞–і–∞–љ–Є–є, –Њ—В–љ–Њ—Б—П—Й–Є—Е—Б—П –Ї —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–µ–є –≥—А—Г–њ–њ–µ. –Т —А–∞–Ј–і–µ–ї–µ –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є–Є –Є–Ј –≤—Б–µ—Е –±–∞–ї–ї–Њ–≤ —Г—З–∞—Б—В–≤—Г–µ—В —В–Њ–ї—М–Ї–Њ ¬ЂGraphics related tasks¬ї.

UGS NX

–Х—Й—С –Њ–і–Є–љ CAD/CAM –њ–∞–Ї–µ—В, –Є –µ—Й—С –Њ–і–Є–љ —Б—В–∞—А—Л–є —В–µ—Б—В –Њ—В SPEC вАФ SPECapc for UGS NX 4 (–≤ –і–∞–љ–љ–Њ–є –Љ–µ—В–Њ–і–Є–Ї–µ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П —Б–∞–Љ –њ–∞–Ї–µ—В –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ —Б–≤–Њ–µ–є 6-–є –≤–µ—А—Б–Є–µ–є). –Ъ —Б—З–∞—Б—В—М—О, —В–µ—Б—В —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ –љ–Њ—А–Љ–∞–ї—М–љ–Њ —А–∞–±–Њ—В–∞–µ—В —Б –Њ–±–љ–Њ–≤–ї—С–љ–љ—Л–Љ –њ–∞–Ї–µ—В–Њ–Љ. –Я–Њ —Б—Г—В–Є, –Њ–љ –Ї–∞–Ї –±–ї–Є–Ј–љ–µ—Ж –њ–Њ—Е–Њ–ґ –љ–∞ –і–≤–∞ –њ—А–µ–і—Л–і—Г—Й–Є—Е: —В—А–Є –Є—В–Њ–≥–Њ–≤—Л—Е –±–∞–ї–ї–∞, –Њ–і–Є–љ –Њ—В–≤–µ—З–∞–µ—В –Ј–∞ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –≥—А–∞—Д–Є–Ї–Є, –≤—В–Њ—А–Њ–є –Ј–∞ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞, —В—А–µ—В–Є–є вАФ –Ј–∞ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –Њ–њ–µ—А–∞—Ж–Є–є –≤–≤–Њ–і–∞-–≤—Л–≤–Њ–і–∞. –Э–∞—Б –≤ —А–∞–Љ–Ї–∞—Е –і–∞–љ–љ–Њ–≥–Њ —А–∞–Ј–і–µ–ї–∞ –Є–љ—В–µ—А–µ—Б—Г–µ—В, —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ, –њ–µ—А–≤—Л–є вАФ –≥—А–∞—Д–Є—З–µ—Б–Ї–Є–є.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- 3ds max 2010 x64 SP1;

- SPECapc for 3ds max 9;

- Maya 2010 x64;

- SPECapc for Maya 2009;

- Lightwave 3D 9.6 x64;

- SPECapc for Lightwave 3D 9.6;

- Pro/ENGINEER Wildfire 5.0 x64 ;

- OCUS Benchmark v5.1 x64;

- SolidWorks 2010 x64;

- SPECapc for SolidWorks 2007;

- UGS NX 6 x64;

- SPECapc for UGS NX 4.

–†–µ–љ–і–µ—А–Є–љ–≥ —В—А—С—Е–Љ–µ—А–љ—Л—Е —Б—Ж–µ–љ

–Т —Н—В–Њ–є –≥—А—Г–њ–њ–µ —Г—З–∞—Б—В–≤—Г—О—В –њ–∞–Ї–µ—В—Л 3ds max, Maya –Є Lightwave —Б —А–µ–Ј—Г–ї—М—В–∞—В–∞–Љ–Є —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П —Б–Ї–Њ—А–Њ—Б—В–Є —А–µ–љ–і–µ—А–Є–љ–≥–∞. –°–∞–Љ–∞ –њ–Њ —Б–µ–±–µ, —Н—В–∞ –Ј–∞–і–∞—З–∞ –Њ—В–љ–Њ—Б–Є—В—Б—П –Ї –і–Њ—Б—В–∞—В–Њ—З–љ–Њ —Г–Ј–Ї–Њ–Љ—Г –Є —Б–њ–µ—Ж–Є—Д–Є—З–µ—Б–Ї–Њ–Љ—Г –Ї–ї–∞—Б—Б—Г. –Т–Њ-–њ–µ—А–≤—Л—Е, —Н—В–Њ –њ–Њ—З—В–Є –Є–і–µ–∞–ї—М–љ–Њ —А–∞—Б–њ–∞—А–∞–ї–ї–µ–ї–Є–≤–∞–µ–Љ—Л–є –њ—А–Њ—Ж–µ—Б—Б: –њ—А–Є—А–Њ—Б—В –±—Л—Б—В—А–Њ–і–µ–є—Б—В–≤–Є—П –њ—А–Є –і–Њ–±–∞–≤–ї–µ–љ–Є–Є –µ—Й—С –Њ–і–љ–Њ–≥–Њ —П–і—А–∞ (–њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞) –≤ —Б–Є—Б—В–µ–Љ—Г –Ј–∞—З–∞—Б—В—Г—О —Б–Њ—Б—В–∞–≤–ї—П–µ—В —Ж–Є—Д—А—Г, –њ—А–Є–±–ї–Є–ґ–∞—О—Й—Г—О—Б—П –Ї 100%. –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –±—Г–і–µ—В –≤–њ–Њ–ї–љ–µ –ї–Њ–≥–Є—З–љ–Њ —Б—А–∞–≤–љ–Є–≤–∞—В—М –Љ–µ–ґ–і—Г —Б–Њ–±–Њ–є –њ—А–Њ—Ж–µ—Б—Б–Њ—А—Л —Б —А–∞–Ј–ї–Є—З–љ—Л–Љ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ–Љ —П–і–µ—А –Њ–±–Њ—Б–Њ–±–ї–µ–љ–љ–Њ –≤ —А–µ–љ–і–µ—А–Є–љ–≥–µ: —Б –Њ–і–љ–Њ–є —Б—В–Њ—А–Њ–љ—Л, —В–∞–Ї –≤–Є–і–љ–µ–µ –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤–Њ —Б–Є—Б—В–µ–Љ —Б –±–Њ–ї—М—И–Є–Љ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ–Љ —П–і–µ—А, –∞ —Б –і—А—Г–≥–Њ–є вАФ —А–µ–Ј—Г–ї—М—В–∞—В—Л —А–µ–љ–і–µ—А–Є–љ–≥–∞ –љ–µ —А–∞–Ј–±–∞–≤–ї—П—О—В —Б–Њ–±–Њ–є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М, –љ–∞–њ—А–Є–Љ–µ—А, –≤ –Њ–±–ї–∞—Б—В–Є –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є–Є (–≥–і–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ —П–і–µ—А –њ–Њ-–њ—А–µ–ґ–љ–µ–Љ—Г –љ–µ –Њ—З–µ–љ—М —Б–Є–ї—М–љ–Њ –≤–ї–Є—П–µ—В –љ–∞ —Б–Ї–Њ—А–Њ—Б—В—М). –Т–Њ-–≤—В–Њ—А—Л—Е, –Њ—В–љ—О–і—М –љ–µ –і–ї—П –≤—Б–µ—Е (–і–∞–ґ–µ —А–∞–±–Њ—В–∞—О—Й–Є—Е —Б –њ–∞–Ї–µ—В–∞–Љ–Є —В—А—С—Е–Љ–µ—А–љ–Њ–≥–Њ –Љ–Њ–і–µ–ї–Є—А–Њ–≤–∞–љ–Є—П) –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–µ–є —Б–Ї–Њ—А–Њ—Б—В—М —А–µ–љ–і–µ—А–Є–љ–≥–∞ –љ–∞ –Є—Е —А–∞–±–Њ—З–Є—Е —Б–Є—Б—В–µ–Љ–∞—Е –≤–∞–ґ–љ–∞. –Х—Б–ї–Є —А–µ—З—М –Є–і—С—В –Њ –Ї—А—Г–њ–љ–Њ–є –і–Є–Ј–∞–є–љ–µ—А—Б–Ї–Њ–є –Ї–Њ–Љ–њ–∞–љ–Є–Є вАФ —В–Њ —В–∞–Љ –і–ї—П —Д–Є–љ–∞–ї—М–љ–Њ–≥–Њ —А–µ–љ–і–µ—А–Є–љ–≥–∞ —Б—Ж–µ–љ –Ј–∞—З–∞—Б—В—Г—О –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П –Ї–Њ–Љ–њ—М—О—В–µ—А—Л, —Б–њ–µ—Ж–Є–∞–ї—М–љ–Њ –≤—Л–і–µ–ї–µ–љ–љ—Л–µ –Є—Б–Ї–ї—О—З–Є—В–µ–ї—М–љ–Њ –і–ї—П —Н—В–Њ–є –Ј–∞–і–∞—З–Є (–∞ –Є–љ–Њ–≥–і–∞ –Є —А–µ–љ–і–µ—А-—Д–µ—А–Љ—Л –Є–Ј –љ–µ—Б–Ї–Њ–ї—М–Ї–Є—Е –Ї–Њ–Љ–њ—М—О—В–µ—А–Њ–≤). –Х—Б–ї–Є —А–µ—З—М –Є–і—С—В –Њ –і–Є–Ј–∞–є–љ–µ—А–µ, —А–∞–±–Њ—В–∞—О—Й–µ–Љ –Є–љ–і–Є–≤–Є–і—Г–∞–ї—М–љ–Њ, вАФ —В–Њ –Њ–љ, –Ї–∞–Ї –њ—А–∞–≤–Є–ї–Њ, –і–Њ–≤–Њ–ї—М–љ–Њ —А–µ–і–Ї–Њ –Ј–∞–њ—Г—Б–Ї–∞–µ—В –њ—А–Њ—Ж–µ—Б—Б —Д–Є–љ–∞–ї—М–љ–Њ–≥–Њ (–љ–µ preview) —А–µ–љ–і–µ—А–Є–љ–≥–∞, –Є –і–∞–ґ–µ –Ї–Њ–≥–і–∞ –і–µ–ї–∞–µ—В —Н—В–Њ вАФ —Б–∞–Љ –Ј–∞ –Ї–Њ–Љ–њ—М—О—В–µ—А–Њ–Љ –≤ —Н—В–Њ –≤—А–µ–Љ—П –љ–µ —А–∞–±–Њ—В–∞–µ—В (–љ–∞–њ—А–Є–Љ–µ—А, –Ј–∞–њ—Г—Б–Ї–∞–µ—В –њ—А–Њ—Ж–µ—Б—Б —А–µ–љ–і–µ—А–Є–љ–≥–∞ –љ–∞ –љ–Њ—З—М, –Ї–Њ–≥–і–∞ –ї–Њ–ґ–Є—В—Б—П —Б–њ–∞—В—М). –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –і–∞–љ–љ–∞—П –≥—А—Г–њ–њ–∞ —Б –Њ–і–љ–Њ–є —Б—В–Њ—А–Њ–љ—Л –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В –љ–µ—Б–Њ–Љ–љ–µ–љ–љ—Л–є –Є–љ—В–µ—А–µ—Б –Ї–∞–Ї –Њ–±—А–∞–Ј–µ—Ж –Њ–і–љ–Њ–є –Є–Ј –≤–µ—Б—М–Љ–∞ —А–µ—Б—Г—А—Б–Њ—С–Љ–Ї–Є—Е —А–µ–∞–ї—М–љ—Л—Е –Ј–∞–і–∞—З, —Б –і—А—Г–≥–Њ–є –ґ–µ —Б—В–Њ—А–Њ–љ—Л вАФ –Є–љ—В–µ—А–µ—Б–љ–∞ –і–∞–ї–µ–Ї–Њ –љ–µ –≤—Б–µ–Љ, —З—В–Њ –Є –Њ–±—Г—Б–ї–Њ–≤–Є–ї–Њ –≤—Л–і–µ–ї–µ–љ–Є–µ —А–µ–љ–і–µ—А–Є–љ–≥–∞ –≤ –Њ—В–і–µ–ї—М–љ—Г—О –≥—А—Г–њ–њ—Г.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- 3ds max 2010 x64 SP1;

- 1.V-Ray 1.50 x64 SP3a ;

- Maya 2010 x64;

- Lightwave 3D 9.6 x64;

- SPECapc for Lightwave 3D 9.6.

–Э–∞—Г—З–љ—Л–µ –Є –Є–љ–ґ–µ–љ–µ—А–љ—Л–µ —А–∞—Б—З—С—В—Л

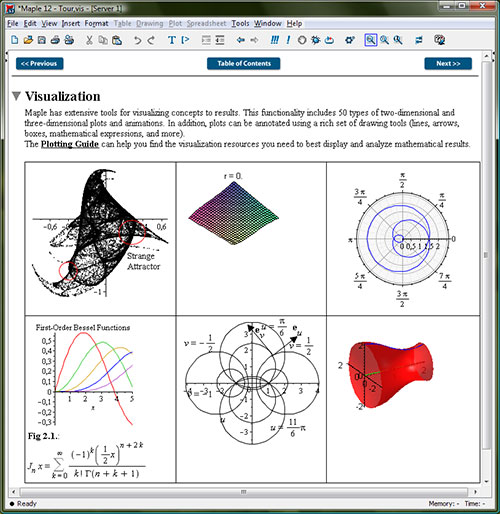

–Т —Н—В–Њ–Љ —А–∞–Ј–і–µ–ї–µ –∞–Ї–Ї—Г–Љ—Г–ї–Є—А—Г—О—В—Б—П —А–µ–Ј—Г–ї—М—В–∞—В—Л, –Њ—В–љ–Њ—Б—П—Й–Є–µ—Б—П –Ї –≤—Б–µ–≤–Њ–Ј–Љ–Њ–ґ–љ—Л–Љ —А–∞—Б—З—С—В–∞–Љ. –Х–≥–Њ –њ—А–Њ–Њ–±—А–∞–Ј–Њ–Љ –±—Л–ї —А–∞–Ј–і–µ–ї –Љ–µ—В–Њ–і–Є–Ї–Є 2008 –≥–Њ–і–∞, –њ–Њ—Б–≤—П—Й—С–љ–љ—Л–є –љ–∞—Г—З–љ–Њ-–Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Є–Љ –њ–∞–Ї–µ—В–∞–Љ. –Т –Љ–µ—В–Њ–і–Є–Ї–µ 2009 –≥–Њ–і–∞, –Љ—Л —А–µ—И–Є–ї–Є –∞–Ї–Ї—Г–Љ—Г–ї–Є—А–Њ–≤–∞—В—М –≤ –Њ–і–љ–Њ–Љ —А–∞–Ј–і–µ–ї–µ –≤—Б–µ —А–µ–Ј—Г–ї—М—В–∞—В—Л –њ–Њ–і–Њ–±–љ–Њ–≥–Њ –њ–ї–∞–љ–∞, –Є –њ—А–∞–Ї—В–Є–Ї–∞ –њ–Њ–Ї–∞–Ј–∞–ї–∞, —З—В–Њ —А–µ—И–µ–љ–Є–µ –Њ–Ї–∞–Ј–∞–ї–Њ—Б—М –≤ —Ж–µ–ї–Њ–Љ —Г–і–∞—З–љ—Л–Љ. –Ф–µ–є—Б—В–≤–Є—В–µ–ї—М–љ–Њ: –њ–Њ–љ—П—В–љ–Њ, —З—В–Њ MAPLE, Mathematica, MATLAB вАФ —Н—В–Њ –Є–љ—Б—В—А—Г–Љ–µ–љ—В—Л –і–ї—П —Г—З—С–љ—Л—Е –Є –Є–љ–ґ–µ–љ–µ—А–Њ–≤. –Ю–і–љ–∞–Ї–Њ —В–µ –ґ–µ CAD/CAM-–њ–∞–Ї–µ—В—Л вАФ SolidWorks, Pro/ENGINEER, UGS NX вАФ —В–Њ–ґ–µ –Њ—Б—Г—Й–µ—Б—В–≤–ї—П—О—В –Є–љ–ґ–µ–љ–µ—А–љ—Л–µ –≤—Л—З–Є—Б–ї–µ–љ–Є—П, –Є –≤ —В–µ—Б—В–∞—Е –і–ї—П —Н—В–Є—Е –њ–∞–Ї–µ—В–Њ–≤ —В–Њ–ґ–µ —Б—Г—Й–µ—Б—В–≤—Г–µ—В –Њ–±–Њ—Б–Њ–±–ї–µ–љ–љ—Л–є –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Л–є —А–µ–Ј—Г–ї—М—В–∞—В. –Я—А–Є —Н—В–Њ–Љ, –љ–µ—Б–Љ–Њ—В—А—П –љ–∞ –≤–љ–µ—И–љ–µ –≤–Є–і–Є–Љ—Л–µ —А–∞–Ј–ї–Є—З–Є—П, —Б—Г—В—М –Њ—Б—В–∞—С—В—Б—П —В–Њ–є –ґ–µ: –і–∞, Pro/ENGINEER –Љ–Њ–ґ–µ—В –Ї—А–∞—Б–Є–≤–Њ –њ–Њ–≤–µ—А—В–µ—В—М –і–µ—В–∞–ї—М –Є–ї–Є –Љ–µ—Е–∞–љ–Є–Ј–Љ –љ–∞ —Н–Ї—А–∞–љ–µ, –Њ–і–љ–∞–Ї–Њ –њ–µ—А–µ–і —Н—В–Є–Љ –Њ–љ –≤—Б—С —А–∞–≤–љ–Њ –і–Њ–ї–ґ–µ–љ –Є—Е –њ—А–Њ—Б—З–Є—В–∞—В—М. –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –≤ —Н—В–Њ—В —А–∞–Ј–і–µ–ї –Љ–µ—В–Њ–і–Є–Ї–Є –≤–Њ—И–ї–Є –Ї–∞–Ї —В–µ—Б—В—Л –і–ї—П –љ–∞—Г—З–љ–Њ-–Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Є—Е –њ–∞–Ї–µ—В–Њ–≤, —В–∞–Ї –Є –њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ—Л–µ –±–∞–ї–ї—Л –±–µ–љ—З–Љ–∞—А–Ї–Њ–≤ SolidWorks, Pro/ENGINEER –Є UGS NX. –Я–Њ—Б–Ї–Њ–ї—М–Ї—Г –њ–Њ—Б–ї–µ–і–љ–Є–µ —Г–ґ–µ –±—Л–ї–Є –Њ–њ–Є—Б–∞–љ—Л —А–∞–љ–µ–µ, –Њ—Б—В–∞–љ–Њ–≤–Є–Љ—Б—П –љ–∞ –Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Є—Е –њ–∞–Ї–µ—В–∞—Е.

–Ф–ї—П Mathematica –Љ—Л –њ–Њ-–њ—А–µ–ґ–љ–µ–Љ—Г –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ –і–≤–∞ —В–µ—Б—В–∞: –≤—Б—В—А–Њ–µ–љ–љ—Л–є –±–µ–љ—З–Љ–∞—А–Ї –Є —Б—В–Њ—А–Њ–љ–љ–Є–є MMA. –Я—А–∞–≤–і–∞, –њ–Њ—Б–ї–µ –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П —В–µ—Б—В–∞ MMA –і–Њ –≤–µ—А—Б–Є–Є 7, —Г –љ–µ–≥–Њ –њ–Њ—П–≤–Є–ї–∞—Б—М –Љ–љ–Њ–≥–Њ–њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ–∞—П –Є–Љ–њ–ї–µ–Љ–µ–љ—В–∞—Ж–Є—П, –Є —В–µ–њ–µ—А—М –Љ—Л, –µ—Б—В–µ—Б—В–≤–µ–љ–љ–Њ, –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ –Є–Љ–µ–љ–љ–Њ –µ—С. –Ґ–µ—Б—В –і–ї—П MAPLE –Њ—Б—В–∞–ї—Б—П —В–∞–Ї–Є–Љ –ґ–µ, –Ї–∞–Ї –≤ –Љ–µ—В–Њ–і–Є–Ї–µ 2009 –≥–Њ–і–∞. –Т MATLAB –Љ—Л —Б 2009 –≥–Њ–і–∞ –Њ—В–Ї–∞–Ј–∞–ї–Є—Б—М –Њ—В –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П –≤—Б—В—А–Њ–µ–љ–љ–Њ–≥–Њ –±–µ–љ—З–Љ–∞—А–Ї–∞ –≤–≤–Є–і—Г –Ї—А–∞–є–љ–µ–є –љ–µ—Б—В–∞–±–Є–ї—М–љ–Њ—Б—В–Є –≤—Л–і–∞–≤–∞–µ–Љ—Л—Е –Є–Љ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤, –Є –њ–µ—А–µ—И–ї–Є –љ–∞ –±–µ–љ—З–Љ–∞—А–Ї –Њ—В Sciviews.org. –° —В–µ—Е –њ–Њ—А –љ–Є—З–µ–≥–Њ –љ–µ –Є–Ј–Љ–µ–љ–Є–ї–Њ—Б—М, –ї–Є—И—М –Њ–±–љ–Њ–≤–Є–ї–∞—Б—М –≤–µ—А—Б–Є—П —Б–∞–Љ–Њ–≥–Њ –њ–∞–Ї–µ—В–∞.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- Wolfram Research Mathematica 7 x64;

- MMA 7.0 benchmark (parallel version);

- MathWorks MATLAB R2009b x64;

- Sciviews.org MATLAB benchmark;

- Maplesoft MAPLE 13 x64 ;

- SciGMark for Maple;

- Pro/ENGINEER Wildfire 5.0 x64 ;

- OCUS Benchmark v5.1 x64;

- SolidWorks 2010 x64;

- SPECapc for SolidWorks 2007;

- UGS NX 6 x64;

- SPECapc for UGS NX 4.

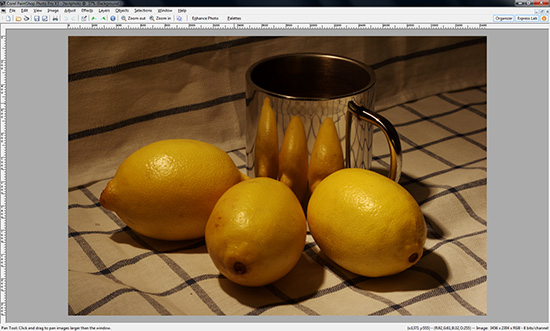

–†–∞—Б—В—А–Њ–≤–∞—П –≥—А–∞—Д–Є–Ї–∞

–Т –≥—А—Г–њ–њ–µ ¬Ђ–†–∞—Б—В—А–Њ–≤–∞—П –≥—А–∞—Д–Є–Ї–∞¬ї –і–ї—П —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П 4 –≥—А–∞—Д–Є—З–µ—Б–Ї–Є—Е –њ–∞–Ї–µ—В–∞, —В—А–Є –Є–Ј –Ї–Њ—В–Њ—А—Л—Е –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ—Л –і–ї—П —А–µ–і–∞–Ї—В–Є—А–Њ–≤–∞–љ–Є—П, –Є –µ—Й—С –Њ–і–Є–љ вАФ –і–ї—П –њ—А–Њ—Б–Љ–Њ—В—А–∞ —А–∞—Б—В—А–Њ–≤—Л—Е –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є: Adobe Photoshop (–Ї—Г–і–∞ –ґ–µ –±–µ–Ј –љ–µ–≥–Њ?), Corel PhotoImpact (–±—Л–≤—И–Є–є Ulead PhotoImpact), Corel PaintShop Pro Photo (–±—Л–≤—И–Є–є Jasc PaintShop) –Є —Б–∞–Љ—Л–є –њ–Њ–њ—Г–ї—П—А–љ—Л–є –≥—А–∞—Д–Є—З–µ—Б–Ї–Є–є –≤—М—О–≤–µ—А вАФ ACDSee. –Я–Њ—Б–ї–µ–і–љ–Є–є –≤—Л–њ–Њ–ї–љ—П–µ—В –Ј–∞–і–∞—З—Г –Ї–Њ–љ–≤–µ—А—В–∞—Ж–Є–Є RAW-—Д–Њ—А–Љ–∞—В–Њ–≤ –≤ JPEG. –Т –Ї–∞—З–µ—Б—В–≤–µ –Њ–±—К–µ–Ї—В–Њ–≤ –і–ї—П –Ї–Њ–љ–≤–µ—А—В–∞—Ж–Є–Є –≤—Л—Б—В—Г–њ–∞—О—В —Д–∞–є–ї—Л —Д–Њ—А–Љ–∞—В–∞ NEF (Nicon) –Є CR2 (Canon), —Б–Њ–±—А–∞–љ–љ—Л–µ –≤ –µ–і–Є–љ—Л–є —Д–∞–є–ї–Њ–≤—Л–є –љ–∞–±–Њ—А —А–∞–Ј–Љ–µ—А–Њ–Љ –Њ–Ї–Њ–ї–Њ 1 –У–С, –≤ –њ—А–Є–Љ–µ—А–љ–Њ —А–∞–≤–љ–Њ–Љ –Њ—В–љ–Њ—И–µ–љ–Є–Є. –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –≤ –±–µ–љ—З–Љ–∞—А–Ї–µ ACDSee –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б –њ—А–Њ—И–ї—Л–Љ –≥–Њ–і–Њ–Љ –љ–Є—З–µ–≥–Њ –љ–µ –Є–Ј–Љ–µ–љ–Є–ї–Њ—Б—М, –Ј–∞ –Є—Б–Ї–ї—О—З–µ–љ–Є–µ–Љ –≤–µ—А—Б–Є–Є –њ–∞–Ї–µ—В–∞. –Ъ —Б–Њ–ґ–∞–ї–µ–љ–Є—О, –Є–Ј –Љ–µ—В–Њ–і–Є–Ї–Є 2010 –≥–Њ–і–∞ –њ—А–Є—И–ї–Њ—Б—М –Є—Б–Ї–ї—О—З–Є—В—М —В–µ—Б—В –≤ –≥—А–∞—Д–Є—З–µ—Б–Ї–Њ–Љ —А–µ–і–∞–Ї—В–Њ—А–µ Paint.NET: –∞–≤—В–Њ—А –±–µ–љ—З–Љ–∞—А–Ї–∞, —Б—Г–і—П –њ–Њ –≤—Б–µ–Љ—Г, –Ј–∞–±—А–Њ—Б–Є–ї —Н—В—Г —А–∞–Ј—А–∞–±–Њ—В–Ї—Г, –∞ —Б—В–∞—А–∞—П –≤–µ—А—Б–Є—П –њ–Њ–і Windows 7 –Є —Б –њ–Њ—Б–ї–µ–і–љ–Є–Љ–Є –≤–µ—А—Б–Є—П–Љ–Є Paint.NET –њ—А–Њ—Б—В–Њ –љ–µ —А–∞–±–Њ—В–∞–µ—В.

–Ґ–µ—Б—В—Л –і–ї—П Photoshop, PhotoImpact –Є PaintShop Pro Photo –±—Л–ї–Є —Г–љ–Є—Д–Є—Ж–Є—А–Њ–≤–∞–љ—Л: —В–µ–њ–µ—А—М –≤—Б–µ –Њ–љ–Є –≤—Л–і–∞—О—В –Њ–і–Є–љ —А–µ–Ј—Г–ї—М—В–∞—В вАФ —Б—А–µ–і–љ–Є–є –±–∞–ї–ї –њ–Њ –≤—Б–µ–Љ –Њ–њ–µ—А–∞—Ж–Є—П–Љ. –Э–∞–њ–Њ–Љ–љ–Є–Љ, —З—В–Њ —Б—Г—В—М —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П —Б–Њ—Б—В–Њ–Є—В –≤ –≤—Л–њ–Њ–ї–љ–µ–љ–Є–Є —В–µ—Б—В–Њ–≤–Њ–≥–Њ —Б–Ї—А–Є–њ—В–∞, –Ї–Њ—В–Њ—А—Л–є –Ј–∞—Б–µ–Ї–∞–µ—В –≤—А–µ–Љ—П –≤—Л–њ–Њ–ї–љ–µ–љ–Є—П –љ–∞–і —В–µ—Б—В–Њ–≤—Л–Љ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–µ–Љ –љ–µ–Ї–Њ—В–Њ—А—Л—Е –љ–∞–Є–±–Њ–ї–µ–µ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ—С–љ–љ—Л—Е –і–µ–є—Б—В–≤–Є–є: —Н—Д—Д–µ–Ї—В—Л —А–∞–Ј–Љ—Л—В–Є—П –Є –њ–Њ–≤—Л—И–µ–љ–Є—П —А–µ–Ј–Ї–Њ—Б—В–Є, —Б–≤–µ—В–Њ–≤—Л–µ —Н—Д—Д–µ–Ї—В—Л, –Є–Ј–Љ–µ–љ–µ–љ–Є–µ —А–∞–Ј–Љ–µ—А–∞ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є—П, –≤—А–∞—Й–µ–љ–Є–µ, –њ—А–µ–Њ–±—А–∞–Ј–Њ–≤–∞–љ–Є–µ –Є–Ј –Њ–і–љ–Њ–є —Ж–≤–µ—В–Њ–≤–Њ–є –Љ–Њ–і–µ–ї–Є –≤ –і—А—Г–≥—Г—О, —В—А–∞–љ—Б—Д–Њ—А–Љ–∞—Ж–Є—П, ¬Ђ–∞—А—В–Є—Б—В–Є—З–µ—Б–Ї–Є–µ¬ї —Д–Є–ї—М—В—А—Л. –С—Л—В—М –Љ–Њ–ґ–µ—В, –љ–µ–Ї–Њ—В–Њ—А—Л–µ —З–Є—В–∞—В–µ–ї–Є –±—Г–і—Г—В —Б–Њ–ґ–∞–ї–µ—В—М –Њ ¬Ђ–њ—А–Њ–њ–∞–≤—И–µ–є¬ї –і–µ—В–∞–ї—М–љ–Њ–є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є –≤ —В–µ—Б—В–µ Photoshop, –Њ–і–љ–∞–Ї–Њ –≤ –і–∞–љ–љ–Њ–Љ —Б–ї—Г—З–∞–µ –Є—Б–Ї—Г—Б—Б—В–≤–Њ, –Ї —Б–Њ–ґ–∞–ї–µ–љ–Є—О, —В—А–µ–±—Г–µ—В –ґ–µ—А—В–≤: –≤ –љ–Њ–≤–Њ–є –Љ–µ—В–Њ–і–Є–Ї–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ —В–µ—Б—В–Њ–≤ —Б–љ–Њ–≤–∞ –≤—Л—А–Њ—Б–ї–Њ –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б –њ—А–µ–і—Л–і—Г—Й–µ–є, –Є –љ–∞–Љ –њ—А–Њ—Б—В–Њ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ ¬Ђ—Г–Ї—А—Г–њ–љ—П—В—М —В–Њ—З–Ї—Г –Ј—А–µ–љ–Є—П¬ї, —З—В–Њ–±—Л –љ–µ —Г—В–Њ–љ—Г—В—М –≤ –Љ–∞—Б—Б–µ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- Adobe Photoshop CS4 x64;

- Corel PhotoImpact X3;

- Corel PaintShop Photo Pro X3;

- ACDSee Photo Manager 2009 build 115 + RAW Plugin 4.0.76.

–°–ґ–∞—В–Є–µ –і–∞–љ–љ—Л—Е

–Ґ–µ—Б—В–Є—А–Њ–≤–∞–љ–Є–µ —Б–Ї–Њ—А–Њ—Б—В–Є —Б–ґ–∞—В–Є—П —А–∞–Ј–љ–Њ—А–Њ–і–љ—Л—Е –і–∞–љ–љ—Л—Е –±–µ–Ј –њ–Њ—В–µ—А—М (—Н—В–Њ—В –њ—А–Њ—Ж–µ—Б—Б –њ—А–Є–љ—П—В–Њ –љ–∞–Ј—Л–≤–∞—В—М –∞—А—Е–Є–≤–∞—Ж–Є–µ–є) —П–≤–ї—П–µ—В—Б—П –і–Њ—Б—В–∞—В–Њ—З–љ–Њ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л–Љ –±–µ–љ—З–Љ–∞—А–Ї–Њ–Љ, —В–∞–Ї–ґ–µ –і–∞–≤–љ–Њ –Є–Ј–≤–µ—Б—В–љ–Њ, –Ї–∞–Ї–Є–µ –њ–∞—А–∞–Љ–µ—В—А—Л —Б–Є—Б—В–µ–Љ—Л —П–≤–ї—П—О—В—Б—П –і–ї—П –њ–Њ–і–∞–≤–ї—П—О—Й–µ–≥–Њ –±–Њ–ї—М—И–Є–љ—Б—В–≤–∞ –∞—А—Е–Є–≤–∞—В–Њ—А–Њ–≤ –Ї—А–Є—В–Є—З–љ—Л–Љ–Є: –љ–∞ –њ–µ—А–≤–Њ–Љ –Љ–µ—Б—В–µ —А–∞—Б–њ–Њ–ї–∞–≥–∞–µ—В—Б—П –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ–∞—П –Љ–Њ—Й–љ–Њ—Б—В—М —Ж–µ–ї–Њ—З–Є—Б–ї–µ–љ–љ—Л—Е —Д—Г–љ–Ї—Ж–Є–Њ–љ–∞–ї—М–љ—Л—Е —Г—Б—В—А–Њ–є—Б—В–≤ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞, –љ–∞ –≤—В–Њ—А–Њ–Љ вАФ –Њ–±—Й–Є–є —А–∞–Ј–Љ–µ—А –Є –±—Л—Б—В—А–Њ–і–µ–є—Б—В–≤–Є–µ –Ї—Н—И–µ–є –≤—Б–µ—Е —Г—А–Њ–≤–љ–µ–є, –љ–∞ —В—А–µ—В—М–µ–Љ вАФ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М –њ–Њ–і—Б–Є—Б—В–µ–Љ—Л –њ–∞–Љ—П—В–Є, –њ—А–Є—З—С–Љ –Ї—А–Є—В–Є—З–љ—Л –Ї–∞–Ї —Б–Ї–Њ—А–Њ—Б—В–Є –ї–Є–љ–µ–є–љ–Њ–≥–Њ —З—В–µ–љ–Є—П –Є –Ј–∞–њ–Є—Б–Є, —В–∞–Ї –Є –ї–∞—В–µ–љ—В–љ–Њ—Б—В—М. –†–µ–ґ–µ (–≤ –њ–Њ—Б–ї–µ–і–љ–µ–µ –≤—А–µ–Љ—П –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є –љ–Є–Ї–Њ–≥–і–∞) —Б–Ї–∞–Ј—Л–≤–∞–ї–∞—Б—М –њ—А–Њ–њ—Г—Б–Ї–љ–∞—П —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ–Њ–є —И–Є–љ—Л вАФ –≤–њ—А–Њ—З–µ–Љ, —Н—В–Њ –Њ—В–љ–Њ—Б–Є—В—Б—П –Ї —В–µ–Љ (–љ—Л–љ–µ —Г–ґ–µ –Њ—В—Е–Њ–і—П—Й–Є–Љ) –≤—А–µ–Љ–µ–љ–∞–Љ, –Ї–Њ–≥–і–∞ –Ї–Њ–љ—В—А–Њ–ї–ї–µ—А –њ–∞–Љ—П—В–Є —А–∞—Б–њ–Њ–ї–∞–≥–∞–ї—Б—П –≤ —З–Є–њ—Б–µ—В–µ.

–Э–∞—И –±–µ–љ—З–Љ–∞—А–Ї, —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ, —Б–Њ—Б—В–Њ–Є—В –≤ –∞—А—Е–Є–≤–∞—Ж–Є–Є —Б –њ–Њ–Љ–Њ—Й—М—О –Ї–∞–ґ–і–Њ–≥–Њ –Є–Ј –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л—Е –≤ —В–µ—Б—В–µ –∞—А—Е–Є–≤–∞—В–Њ—А–Њ–≤ –Њ–і–Є–љ–∞–Ї–Њ–≤–Њ–≥–Њ —Д–∞–є–ї–Њ–≤–Њ–≥–Њ –љ–∞–±–Њ—А–∞, —Б–Њ—Б—В–Њ—П—Й–µ–≥–Њ –Є–Ј –њ—А–Є–Љ–µ—А–љ–Њ —А–∞–≤–љ—Л—Е –Њ–±—К—С–Љ–Њ–≤ —Д–∞–є–ї–Њ–≤ —Б–ї–µ–і—Г—О—Й–Є—Е —В–Є–њ–Њ–≤: BMP (–љ–µ—Б–ґ–∞—В–∞—П –Ї–∞—А—В–Є–љ–Ї–∞), DBF (–±–∞–Ј–∞ –і–∞–љ–љ—Л—Е), DLL (–і–Є–љ–∞–Љ–Є—З–µ—Б–Ї–∞—П –±–Є–±–ї–Є–Њ—В–µ–Ї–∞), DOC (–і–Њ–Ї—Г–Љ–µ–љ—В Microsoft Word 97/2003), PDF (–і–Њ–Ї—Г–Љ–µ–љ—В —Д–Њ—А–Љ–∞—В–∞ PDF) –Є TXT (–њ—А–Њ—Б—В–Њ–є —В–µ–Ї—Б—В –≤ –Ї–Њ–і–Є—А–Њ–≤–Ї–µ Win-1251). –Т –љ—Л–љ–µ—И–љ–µ–є –Љ–µ—В–Њ–і–Є–Ї–µ –Љ—Л –і–Њ–±–∞–≤–Є–ї–Є –µ—Й—С –Њ–і–Є–љ –∞–Ї—В—Г–∞–ї—М–љ—Л–є —В–µ—Б—В: –љ–∞ —Б–Ї–Њ—А–Њ—Б—В—М —А–∞—Б–њ–∞–Ї–Њ–≤–Ї–Є –Ј–∞—И–Є—Д—А–Њ–≤–∞–љ–љ–Њ–≥–Њ –∞—А—Е–Є–≤–∞. –Ф–∞–љ–љ–∞—П –Њ–њ–µ—А–∞—Ж–Є—П –і–Њ—Б—В–∞—В–Њ—З–љ–Њ —А–µ—Б—Г—А—Б–Њ—С–Љ–Ї–∞ (—Б—Г—Й–µ—Б—В–≤–µ–љ–љ–Њ –±–Њ–ї–µ–µ, —З–µ–Љ –њ—А–Њ—Б—В–Њ —А–∞—Б–њ–∞–Ї–Њ–≤–Ї–∞), –Є, –Ї–∞–Ї –њ–Є—И—Г—В –љ–∞–Љ –љ–∞—И–Є —З–Є—В–∞—В–µ–ї–Є, –і–Њ—Б—В–∞—В–Њ—З–љ–Њ —З–∞—Б—В–Њ –≤—Б—В—А–µ—З–∞–µ—В—Б—П –љ–∞ –њ—А–∞–Ї—В–Є–Ї–µ. –Т –і–∞–љ–љ–Њ–Љ –њ–Њ–і—В–µ—Б—В–µ —Г—З–∞—Б—В–≤—Г–µ—В —В–Њ–ї—М–Ї–Њ RAR-–∞—А—Е–Є–≤ —В.–Ї. –∞—А—Е–Є–≤ 7-Zip, –і–∞–ґ–µ –Ј–∞—И–Є—Д—А–Њ–≤–∞–љ–љ—Л–є, –Њ–±—А–∞–±–∞—В—Л–≤–∞–µ—В—Б—П –њ–Њ—А–∞–Ј–Є—В–µ–ї—М–љ–Њ –±—Л—Б—В—А–Њ вАФ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ, –Є–Ј–Љ–µ—А–µ–љ–Є–µ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –≤ –і–∞–љ–љ–Њ–Љ —Б–ї—Г—З–∞–µ —В–µ—А—П–µ—В –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є–є —Б–Љ—Л—Б–ї. –Ґ–∞–Ї–ґ–µ –Љ–Њ–ґ–љ–Њ –Њ—В–Љ–µ—В–Є—В—М, —З—В–Њ –Ј–∞ —Б—З—С—В –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П –≤–µ—А—Б–Є–Є 7-Zip, –љ–∞—И —В–µ—Б—В –љ–∞ —Б–Ї–Њ—А–Њ—Б—В—М —Г–њ–∞–Ї–Њ–≤–Ї–Є —Б –њ–Њ–Љ–Њ—Й—М—О —Н—В–Њ–≥–Њ –∞—А—Е–Є–≤–∞—В–Њ—А–∞, —В–µ–Њ—А–µ—В–Є—З–µ—Б–Ї–Є, —В–µ–њ–µ—А—М –Љ–Њ–ґ–µ—В –Ј–∞–і–µ–є—Б—В–≤–Њ–≤–∞—В—М –і–Њ 16 –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤ (—П–і–µ—А). –Э–∞—Б–Ї–Њ–ї—М–Ї–Њ —Б–Є–ї—М–љ–Њ —Н—В–Њ —Б–Ї–∞–ґ–µ—В—Б—П –љ–∞ —А–µ–Ј—Г–ї—М—В–∞—В–∞—Е, –њ–Њ–Ї–∞–ґ–µ—В –њ—А–∞–Ї—В–Є–Ї–∞.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- 7-Zip 9.12 beta x64;

- WinRAR 3.93 x64.

–Ъ–Њ–Љ–њ–Є–ї—П—Ж–Є—П

–Ф–∞–љ–љ—Л–є —В–µ—Б—В –Њ—Б—В–∞–ї—Б—П –љ–µ–Є–Ј–Љ–µ–љ–љ—Л–Љ: –Љ—Л –њ–Њ-–њ—А–µ–ґ–љ–µ–Љ—Г –Ї–Њ–Љ–њ–Є–ї–Є—А—Г–µ–Љ —Б –Ј–∞–Љ–µ—А–Њ–Љ –≤—А–µ–Љ–µ–љ–Є —Б–≤–Њ–±–Њ–і–љ—Л–є –њ—А–Њ–µ–Ї—В —Б –Њ—В–Ї—А—Л—В—Л–Љ –Є—Б—Е–Њ–і–љ–Є–Љ –Ї–Њ–і–Њ–Љ Ogre 3D —Б –њ–Њ–Љ–Њ—Й—М—О –Ї–Њ–Љ–њ–Є–ї—П—В–Њ—А–∞ C++, –≤—Е–Њ–і—П—Й–µ–≥–Њ –≤ —Б–Њ—Б—В–∞–≤ Microsoft Visual Studio 2008.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- Microsoft Visual Studio 2008;

- Microsoft DirectX SDK;

- Ogre 3D sources.

Java

–≠—В–Њ—В –±–µ–љ—З–Љ–∞—А–Ї –≤–њ–µ—А–≤—Л–µ –±—Л–ї –Њ–њ—А–Њ–±–Њ–≤–∞–љ –≤ –Љ–µ—В–Њ–і–Є–Ї–µ –њ—А–Њ—И–ї–Њ–≥–Њ –≥–Њ–і–∞, –Є –≤–њ–Њ–ї–љ–µ ¬Ђ–њ—А–Є–ґ–Є–ї—Б—П¬ї –љ–∞ –љ–∞—И–Є—Е —В–µ—Б—В–Њ–≤—Л—Е —Б—В–µ–љ–і–∞—Е, –і–µ–Љ–Њ–љ—Б—В—А–Є—А—Г—П —Е–Њ—А–Њ—И—Г—О –њ–Њ–і–і–µ—А–ґ–Ї—Г –Љ–љ–Њ–≥–Њ–њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ–Њ—Б—В–Є, –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –љ–µ–є—В—А–∞–ї—М–љ–Њ–µ –Њ—В–љ–Њ—И–µ–љ–Є–µ –Ї –і–≤—Г–Љ –Њ—Б–љ–Њ–≤–љ—Л–Љ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—П–Љ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤, –Є —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М —Б–Њ–Ј–і–∞–≤–∞—В—М —Е–Њ—А–Њ—И—Г—О –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ—Г—О –љ–∞–≥—А—Г–Ј–Ї—Г. –Ґ–µ–Љ –±–Њ–ї–µ–µ —З—В–Њ —Б —В–Њ—З–Ї–Є –Ј—А–µ–љ–Є—П –≤—Л–њ–Њ–ї–љ–µ–љ–Є—П –љ–∞ –Ї–Њ–Љ–њ—М—О—В–µ—А–∞—Е –Ї–Њ–љ–µ—З–љ—Л—Е –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–µ–є, Java –і–µ–є—Б—В–≤–Є—В–µ–ї—М–љ–Њ —П–≤–ї—П–µ—В—Б—П —Б–∞–Љ—Л–Љ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ—С–љ–љ—Л–Љ –Є–Ј —П–Ј—Л–Ї–Њ–≤ –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є—П, –∞ –µ—С Windows-—А–µ–∞–ї–Є–Ј–∞—Ж–Є—П –Њ—В Sun Microsystems вАФ —Б–∞–Љ–Њ–є —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ—С–љ–љ–Њ–є —А–µ–∞–ї–Є–Ј–∞—Ж–Є–µ–є JRE (Java Runtime Environment). –Ь—Л –њ–Њ-–њ—А–µ–ґ–љ–µ–Љ—Г –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ –±–µ–љ—З–Љ–∞—А–Ї –Њ—В SPEC: SPECjvm2008. –Ю–љ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ–Њ–і—А–Њ–±–µ–љ, –Є –≤–Ї–ї—О—З–∞–µ—В –≤ —Б–µ–±—П –Љ–љ–Њ–≥–Њ –њ–Њ–і—В–µ—Б—В–Њ–≤ –Є–Ј —Б–∞–Љ—Л—Е —А–∞–Ј–љ—Л—Е –Њ–±–ї–∞—Б—В–µ–є: Compiler (–Ї–Њ–Љ–њ–Є–ї—П—Ж–Є—П —Б –њ–Њ–Љ–Њ—Й—М—О OpenJDK), Compress (—Б–ґ–∞—В–Є–µ –і–∞–љ–љ—Л—Е –њ–Њ –Љ–µ—В–Њ–і—Г LZW), Crypto (—И–Є—Д—А–Њ–≤–∞–љ–Є–µ –њ–Њ –њ—А–Њ—В–Њ–Ї–Њ–ї–∞–Љ AES/DES, RSA, –≤–µ—А–Є—Д–Є–Ї–∞—Ж–Є—П –њ–Њ –Љ–µ—В–Њ–і–∞–Љ MD5withRSA, SHA1withRSA, SHA1withDSA –Є SHA256withRSA), Derby (—В–µ—Б—В –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В open source –С–Ф, —Ж–µ–ї–Є–Ї–Њ–Љ –љ–∞–њ–Є—Б–∞–љ–љ—Г—О –љ–∞ Java), MPEGAudio (–і–µ–Ї–Њ–і–Є—А–Њ–≤–∞–љ–Є–µ mp3 –љ–∞ –±–∞–Ј–µ LGPL-–±–Є–±–ї–Є–Њ—В–µ–Ї–Є JLayer), Scimark (–њ–Њ–њ—Г–ї—П—А–љ—Л–є –≤ –љ–∞—Г—З–љ–Њ–є —Б—А–µ–і–µ –±–µ–љ—З–Љ–∞—А–Ї –≤—Л—З–Є—Б–ї–µ–љ–Є–є —Б –њ–ї–∞–≤–∞—О—Й–µ–є —В–Њ—З–Ї–Њ–є, –Ї—Б—В–∞—В–Є, вАФ –Љ—Л –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ –µ–≥–Њ –∞–і–∞–њ—В–Є—А–Њ–≤–∞–љ–љ—Г—О –њ–Њ–і MAPLE –≤–µ—А—Б–Є—О –≤ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–µ–Љ —В–µ—Б—В–µ), Serial (–њ–∞—А–∞–ї–ї–µ–ї—М–љ–Њ-–њ–Њ—Б–ї–µ–і–Њ–≤–∞—В–µ–ї—М–љ–Њ–µ –њ—А–µ–Њ–±—А–∞–Ј–Њ–≤–∞–љ–Є–µ), Sunflow (–≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є—П —Б –њ–Њ–Љ–Њ—Й—М—О –Љ–љ–Њ–≥–Њ–њ–Њ—В–Њ—З–љ–Њ-–Њ–њ—В–Є–Љ–Є–Ј–Є—А–Њ–≤–∞–љ–љ–Њ–≥–Њ –і–≤–Є–ґ–Ї–∞ —А–µ–љ–і–µ—А–Є–љ–≥–∞ —Б –њ–Њ–і–і–µ—А–ґ–Ї–Њ–є global illumination), XML (–љ–∞–ї–Њ–ґ–µ–љ–Є–µ —В–∞–±–ї–Є—Ж —Б—В–Є–ї–µ–є –љ–∞ XML-–і–Њ–Ї—Г–Љ–µ–љ—В—Л –Є –≤–∞–ї–Є–і–∞—Ж–Є—П XML-–і–Њ–Ї—Г–Љ–µ–љ—В–Њ–≤ –њ–Њ —Б—Е–µ–Љ–µ (xsd).–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- Java SE Runtime Environment 6u18 x64;

- SPECjvm2008.

–Р—Г–і–Є–Њ

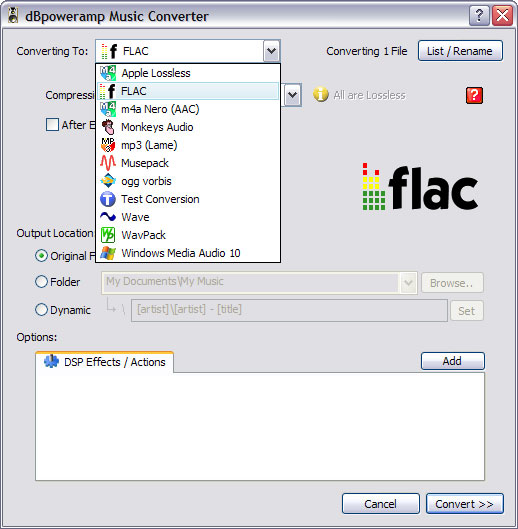

–Э–∞—З–Є–љ–∞—П —Б 2009 –≥–Њ–і–∞, –Љ—Л –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ –і–ї—П –Ї–Њ–і–Є—А–Њ–≤–∞–љ–Є—П –∞—Г–і–Є–Њ –Њ–±–Њ–ї–Њ—З–Ї—Г dBpoweramp, —В.–Ї. –Њ–љ–∞ —Г–Љ–µ–µ—В –Ј–∞–њ—Г—Б–Ї–∞—В—М –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ–≤ –Ї–Њ–і–Є—А–Њ–≤–∞–љ–Є—П –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ–Њ, –і–µ–ї–∞—П, —В–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –њ—А–Њ—Ж–µ—Б—Б –Ї–Њ–і–Є—А–Њ–≤–∞–љ–Є—П –Љ–љ–Њ–≥–Њ–њ–Њ—В–Њ—З–љ—Л–Љ, –і–∞–ґ–µ –њ—А–Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–Є –Њ–і–љ–Њ–њ–Њ—В–Њ—З–љ—Л—Е –Ї–Њ–і–µ–Ї–Њ–≤. –Ф–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ—Л–Љ –њ–ї—О—Б–Њ–Љ dBpoweramp —П–≤–ї—П–µ—В—Б—П —В–Њ, —З—В–Њ —Г –њ—А–Њ–≥—А–∞–Љ–Љ—Л –Є–Љ–µ–µ—В—Б—П —Б–Њ–±—Б—В–≤–µ–љ–љ—Л–є –±–µ–љ—З–Љ–∞—А–Ї, –≤—Л–і–∞—О—Й–Є–є –≤ –Ї–∞—З–µ—Б—В–≤–µ —А–µ–Ј—Г–ї—М—В–∞—В–∞ —Б–Њ–Њ—В–љ–Њ—И–µ–љ–Є–µ –Љ–µ–ґ–і—Г —Б–Ї–Њ—А–Њ—Б—В—М—О –Ї–Њ–і–Є—А–Њ–≤–∞–љ–Є—П –∞—Г–і–Є–Њ–њ–Њ—В–Њ–Ї–∞ –Є —Б–Ї–Њ—А–Њ—Б—В—М—О –µ–≥–Њ –њ—А–Њ–Є–≥—А—Л–≤–∞–љ–Є—П (—В–Њ –µ—Б—В—М, –љ–∞–њ—А–Є–Љ–µ—А, —А–µ–Ј—Г–ї—М—В–∞—В –≤ 20 –±–∞–ї–ї–Њ–≤ –Њ–Ј–љ–∞—З–∞–µ—В, —З—В–Њ –∞—Г–і–Є–Њ–њ–Њ—В–Њ–Ї –і–ї–Є—В–µ–ї—М–љ–Њ—Б—В—М—О 20 –Љ–Є–љ—Г—В –±—Л–ї –Ј–∞–Ї–Њ–і–Є—А–Њ–≤–∞–љ –Ј–∞ 1 –Љ–Є–љ—Г—В—Г). –Т –љ—Л–љ–µ—И–љ–µ–є –Љ–µ—В–Њ–і–Є–Ї–µ –љ–µ –Є–Ј–Љ–µ–љ–Є–ї–Њ—Б—М –љ–Є—З–µ–≥–Њ, –Ј–∞ –Є—Б–Ї–ї—О—З–µ–љ–Є–µ–Љ –≤–µ—А—Б–Є–є –Њ–±–Њ–ї–Њ—З–Ї–Є –Є –љ–µ–Ї–Њ—В–Њ—А—Л—Е –Ї–Њ–і–µ–Ї–Њ–≤.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- dBpoweramp Music Converter R13.4;

- FLAC 1.2.1;

- Monkeys Audio 3.99;

- LAME 3.98.3;

- Ogg 1.1.3, Vorbis 1.2.0.

- Nero AAC Encoder 1.5.3.0.

–Т–Є–і–µ–Њ

–Ф–Њ—Б—В–∞—В–Њ—З–љ–Њ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л–є –і–ї—П –љ–∞—И–Є—Е –Љ–µ—В–Њ–і–Є–Ї —А–∞–Ј–і–µ–ї, –Ї–Њ—В–Њ—А—Л–є –Њ—В –≤–µ—А—Б–Є–Є –Ї –≤–µ—А—Б–Є–Є —А–∞–Ј–≤–Є–≤–∞–µ—В—Б—П, —Б–Ї–Њ—А–µ–µ, —Н–≤–Њ–ї—О—Ж–Є–Њ–љ–љ–Њ, —З–µ–Љ —А–µ–≤–Њ–ї—О—Ж–Є–Њ–љ–љ–Њ. –Т –љ—Л–љ–µ—И–љ–µ–є –≤–µ—А—Б–Є–Є –Љ–µ—В–Њ–і–Є–Ї–Є, –љ–µ—Б–Љ–Њ—В—А—П –љ–∞ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ—Б—В—М –њ–Њ–і—Е–Њ–і–∞, –љ–∞–±–ї—О–і–∞–µ—В—Б—П –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –±–Њ–ї—М—И–Њ–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –Є–Ј–Љ–µ–љ–µ–љ–Є–є. –Т–Њ-–њ–µ—А–≤—Л—Е, –Њ–і–Є–љ –Є–Ј ¬Ђ—Б—В–∞—А—Л—Е¬ї —В–µ—Б—В–Њ–≤ –±—Л–ї –Є—Б–Ї–ї—О—З—С–љ вАФ —Н—В–Њ —В–µ—Б—В –љ–∞ —Б–Ї–Њ—А–Њ—Б—В—М –Ї–Њ–і–Є—А–Њ–≤–∞–љ–Є—П MPEG2 —Б –њ–Њ–Љ–Њ—Й—М—О Canopus ProCoder. –≠—В–Њ—В –њ–∞–Ї–µ—В —Г–ґ–µ –љ–Є —Б –Ї–∞–Ї–Є–Љ–Є –љ–∞—В—П–ґ–Ї–∞–Љ–Є –љ–µ –Љ–Њ–ґ–µ—В –±—Л—В—М –љ–∞–Ј–≤–∞–љ —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л–Љ, –Њ–±–ї–∞–і–∞–µ—В –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ—А–µ–і—Б–Ї–∞–Ј—Г–µ–Љ—Л–Љ –њ–Њ–≤–µ–і–µ–љ–Є–µ–Љ, –љ–µ –Њ—З–µ–љ—М-—В–Њ —Е–Њ—А–Њ—И–µ–є –Љ–љ–Њ–≥–Њ–њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ–Њ–є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–µ–є, –њ–Њ—Н—В–Њ–Љ—Г –љ–∞–Љ –њ–Њ–Ї–∞–Ј–∞–ї–Њ—Б—М –±–µ—Б—Б–Љ—Л—Б–ї–µ–љ–љ—Л–Љ –њ—А–Њ–і–Њ–ї–ґ–∞—В—М —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П —Б –µ–≥–Њ –њ–Њ–Љ–Њ—Й—М—О. –Т –Ї–Њ–љ—Ж–µ –Ї–Њ–љ—Ж–Њ–≤, –±–∞–Ј–∞ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є–є –њ–Њ —Б—В–∞—А—Л–Љ –Љ–µ—В–Њ–і–Є–Ї–∞–Љ —Г —Н—В–Њ–≥–Њ –Я–Ю –±–Њ–ї–µ–µ —З–µ–Љ —Б–Њ–ї–Є–і–љ–∞—П, —В–∞–Ї —З—В–Њ —В–µ, –Ї—В–Њ –њ–Њ-–њ—А–µ–ґ–љ–µ–Љ—Г –Є–љ—В–µ—А–µ—Б—Г—О—В—Б—П –µ–≥–Њ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М—О, –Є–Љ–µ—О—В –±–Њ–ї–µ–µ —З–µ–Љ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –і–∞–љ–љ—Л—Е –і–ї—П –і–µ–ї–∞–љ–Є—П —Б–Њ–±—Б—В–≤–µ–љ–љ—Л—Е –≤—Л–≤–Њ–і–Њ–≤.

–Я–µ—А–µ–Ї–Њ—З–µ–≤–∞–ї–Є –Є–Ј –њ—А–µ–і—Л–і—Г—Й–µ–є –Љ–µ—В–Њ–і–Є–Ї–Є (—А–∞–Ј—Г–Љ–µ–µ—В—Б—П, —Б –Њ–±–љ–Њ–≤–ї–µ–љ–Є–µ–Љ –Я–Ю –і–Њ –∞–Ї—В—Г–∞–ї—М–љ—Л—Е –≤–µ—А—Б–Є–є) —В–µ—Б—В—Л –љ–∞ —Б–Ї–Њ—А–Њ—Б—В—М –Ї–Њ–і–Є—А–Њ–≤–∞–љ–Є—П –≤ —Д–Њ—А–Љ–∞—В—Л DivX –Є XviD (–њ–Њ—Б—А–µ–і—Б—В–≤–Њ–Љ VirtualDub + Avisynth), x264, –Є VC-1 –њ–Њ—Б—А–µ–і—Б—В–≤–Њ–Љ Mainconcept Reference.

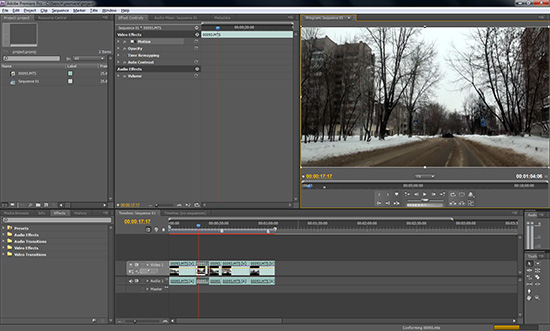

–Ф–Њ–±–∞–≤–Є–ї–Є—Б—М —В–µ—Б—В—Л –≤ Sony Vegas Pro –Є Adobe Premiere. –Ю–±–∞ —В–µ—Б—В–∞ –Њ–і–Є–љ–∞–Ї–Њ–≤—Л –њ–Њ —Б–Љ—Л—Б–ї—Г: –Ј–∞–Љ–µ—А—П–µ—В—Б—П –≤—А–µ–Љ—П —А–µ–љ–і–µ—А–Є–љ–≥–∞ –њ—А–Њ–µ–Ї—В–∞, —Б–Њ–і–µ—А–ґ–∞—Й–µ–≥–Њ —Б–љ—П—В—Л–є –љ–∞ –±—Л—В–Њ–≤—Г—О –Ї–∞–Љ–µ—А—Г –≤–Є–і–µ–Њ—А—П–і —Б –љ–∞–ї–Њ–ґ–µ–љ–Є–µ–Љ –љ–∞ –љ–µ–≥–Њ —А–∞–Ј–ї–Є—З–љ—Л—Е —Н—Д—Д–µ–Ї—В–Њ–≤.

–Ґ–∞–Ї–ґ–µ –Њ–±–љ–Њ–≤–Є–ї—Б—П —В–µ—Б—В –љ–∞ –њ—А–Њ–Є–≥—А—Л–≤–∞–љ–Є–µ –≤–Є–і–µ–Њ –≤—Л—Б–Њ–Ї–Њ–є —З—С—В–Ї–Њ—Б—В–Є. –°—Г—В—М –µ–≥–Њ, –љ–∞–њ–Њ–Љ–љ–Є–Љ, —Б–Њ—Б—В–Њ–Є—В –≤ —Б–ї–µ–і—Г—О—Й–µ–Љ: –њ—А–Є –њ–Њ–Љ–Њ—Й–Є –њ—А–Њ–≥—А–∞–Љ–Љ–љ–Њ–≥–Њ –њ–ї–µ–µ—А–∞ Media Player Classic Homecinema –њ—А–Њ–Є–≥—А—Л–≤–∞–µ—В—Б—П 10-–Љ–Є–љ—Г—В–љ—Л–є —А–Њ–ї–Є–Ї —Б –≤–Є–і–µ–Њ –≤—Л—Б–Њ–Ї–Њ–є —З—С—В–Ї–Њ—Б—В–Є, –Є –≤ —Н—В–Њ –≤—А–µ–Љ—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В—Б—П –Љ–Њ–љ–Є—В–Њ—А–Є–љ–≥ –њ–∞—А–∞–Љ–µ—В—А–∞ CPU usage (–≤—Б–µ—Е –Є–Љ–µ—О—Й–Є—Е—Б—П —П–і–µ—А). –Т –њ—А–Њ—И–ї–Њ–є –≤–µ—А—Б–Є–Є –Љ–µ—В–Њ–і–Є–Ї–Є –Љ—Л –Є–Љ–µ–ї–Є –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М —Б—А–∞–≤–љ–Є—В—М –Ј–∞–≥—А—Г–Ј–Ї—Г –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞ —В–Њ–ї—М–Ї–Њ –і–ї—П –і–≤—Г—Е —А–µ–ґ–Є–Љ–Њ–≤: –њ—А–Њ–≥—А–∞–Љ–Љ–љ–Њ–≥–Њ –Є –∞–њ–њ–∞—А–∞—В–љ–Њ–≥–Њ (DXVA) –њ—А–Њ–Є–≥—А—Л–≤–∞–љ–Є—П —А–Њ–ї–Є–Ї–∞ –≤ —Д–Њ—А–Љ–∞—В–µ H.264. –Т –љ—Л–љ–µ—И–љ–µ–є –Љ–µ—В–Њ–і–Є–Ї–µ –і–∞–љ–љ—Л–є —В–µ—Б—В —А–∞—Б—И–Є—А–µ–љ вАФ –і–Њ–±–∞–≤–Є–ї–Њ—Б—М —Б—А–∞–≤–љ–µ–љ–Є–µ –Ј–∞–≥—А—Г–Ј–Ї–Є –њ—А–Є –њ—А–Њ–≥—А–∞–Љ–Љ–љ–Њ–Љ –Є –∞–њ–њ–∞—А–∞—В–љ–Њ–Љ (—В–∞–Ї–ґ–µ —Б –њ—А–Є–Љ–µ–љ–µ–љ–Є–µ–Љ DXVA) –њ—А–Њ–Є–≥—А—Л–≤–∞–љ–Є—П —Д–Њ—А–Љ–∞—В–∞ VC-1.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- AVISynth 2.58;

- VirtualDub 1.9.8;

- DivX Pro 7;

- XviD 1.2.2;

- x264 rev 1510;

- Mainconcept Reference 2.0;

- Adobe Premiere CS4 / Encoder CS4;

- Sony Vegas Pro 9;

- Media Player Classic Home Cinema x64 1.3.1249.

–Ш–≥—А—Л

–Ш–≥—А–Њ–≤–Њ–є —А–∞–Ј–і–µ–ї вАФ –Њ–і–Є–љ –Є–Ј —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л—Е –і–ї—П –љ–∞—И–µ–є –Љ–µ—В–Њ–і–Є–Ї–Є, –Є —Б–∞–Љ—Л–Љ–Є –Ї—А—Г–њ–љ—Л–Љ–Є –љ–Њ–≤–Њ–≤–≤–µ–і–µ–љ–Є—П–Љ–Є –≤ –љ—С–Љ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ —П–≤–ї—П—О—В—Б—П —Б–∞–Љ–Є –Є–≥—А—Л. –Т —Н—В–Њ–Љ –≥–Њ–і—Г —Б–њ–Є—Б–Њ–Ї –Є–≥—А –±—Л–ї –≤–µ—Б—М–Љ–∞ —Б–Є–ї—М–љ–Њ –Њ–±–љ–Њ–≤–ї—С–љ, —Е–Њ—В—П –љ–µ–Ї–Њ—В–Њ—А—Л–µ –Њ—Б–Њ–±–µ–љ–љ–Њ –њ–Њ–Ї–∞–Ј–∞—В–µ–ї—М–љ—Л–µ ¬Ђ—Б—В–∞—А–Є—З–Ї–Є¬ї –Є –±—Л–ї–Є –Њ—Б—В–∞–≤–ї–µ–љ—Л. –Ґ–∞–Ї–ґ–µ –≤–њ–µ—А–≤—Л–µ –≤ –љ–∞—И–µ–є –њ—А–∞–Ї—В–Є–Ї–µ –Ј–і–µ—Б—М –њ—А–Є—Б—Г—В—Б—В–≤—Г–µ—В –±–µ–љ—З–Љ–∞—А–Ї –≤ –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ ¬Ђ–љ–µ—В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–є¬ї –і–ї—П –±–Њ–ї—М—И–Є–љ—Б—В–≤–∞ –≥–µ–є–Љ–µ—А–Њ–≤ –Є–≥—А–µ вАФ —Н—В–ЊвА¶ —И–∞—Е–Љ–∞—В—Л! –Т–њ—А–Њ—З–µ–Љ, –≤–њ–Њ–ї–љ–µ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л—Е –±–µ–љ—З–Љ–∞—А–Ї–Њ–≤ —В–Њ–ґ–µ –±–Њ–ї–µ–µ —З–µ–Љ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ. –Т—В–Њ—А—Л–Љ –љ–Њ–≤–Њ–≤–≤–µ–і–µ–љ–Є–µ–Љ —Б—В–∞–ї–Њ –њ–Њ–≤—Б–µ–Љ–µ—Б—В–љ–Њ–µ (–≥–і–µ —Н—В–Њ –Љ–Њ–ґ–љ–Њ) –≤–Ї–ї—О—З–µ–љ–Є–µ –≤ –Є–≥—А–∞—Е 2X AA. –Т—Б—С-—В–∞–Ї–Є 2010 –≥–Њ–і –љ–∞ –і–≤–Њ—А–µ вАФ –њ–Њ—А–∞ –±—Л, –љ–∞–≤–µ—А–љ–Њ–µвА¶ ;) –†–∞–Ј—А–µ—И–µ–љ–Є–µ –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –Њ–±—Й–µ–µ –і–ї—П –≤—Б–µ–є –Љ–µ—В–Њ–і–Є–Ї–Є вАФ 1680x1050 –њ—А–Є 32-–±–Є—В–љ–Њ–є –≥–ї—Г–±–Є–љ–µ —Ж–≤–µ—В–∞, –љ–∞—Б—В—А–Њ–є–Ї–Є –Ї–∞—З–µ—Б—В–≤–∞ –≥—А–∞—Д–Є–Ї–Є –≤ –Є–≥—А–∞—Е вАФ ¬Ђ–≤—Л—Б–Њ–Ї–Є–µ¬ї (–Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П —Б–ї–µ–і—Г—О—Й–µ–µ –њ—А–∞–≤–Є–ї–Њ: –µ—Б–ї–Є —Б–∞–Љ—Л–µ –≤—Л—Б–Њ–Ї–Є–µ –љ–∞—Б—В—А–Њ–є–Ї–Є —Г—Б–ї–Њ–≤–љ–Њ –Њ–±–Њ–Ј–љ–∞—З–µ–љ—Л –Ї–∞–Ї ¬Ђhigh¬ї, —В–Њ –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П –Њ–љ–Є, –µ—Б–ї–Є –ґ–µ —Б–∞–Љ—Л–µ –≤—Л—Б–Њ–Ї–Є–µ –љ–∞—Б—В—А–Њ–є–Ї–Є –Є–Љ–µ—О—В –і–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ—Л–є –∞—В—А–Є–±—Г—В –≤–Є–і–∞ ¬Ђultra¬ї –Є–ї–Є ¬Ђextra¬ї вАФ —В–Њ–≥–і–∞ –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П –њ—А–Њ—Б—В–Њ ¬Ђhigh¬ї –љ–∞—Б—В—А–Њ–є–Ї–Є —В.–µ. –љ–∞ –Њ–і–љ–Њ –і–µ–ї–µ–љ–Є–µ –Љ–µ–љ—М—И–µ –Љ–∞–Ї—Б–Є–Љ—Г–Љ–∞). –Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- Batman: Arkham Asylum (—Б PhysX –Є –±–µ–Ј );

- Borderlands;

- Colin McRae: DiRT 2;

- Far Cry 2;

- Fritz Chess Benchmark;

- Grand Theft Auto IV;

- Resident Evil 5;

- S.T.A.L.K.E.R.: Call of Pripyat Benchmark;

- Unreal Tournament 3 + PhysX Mod (c PhysX –Є –±–µ–Ј );

- Crysis: Warhead;

- World In Conflict.

–С—А–∞—Г–Ј–µ—А—Л

–°–Њ–≤–µ—А—И–µ–љ–љ–Њ –љ–Њ–≤–∞—П –≥—А—Г–њ–њ–∞ —В–µ—Б—В–Њ–≤, –Є–Ј–Љ–µ—А—П—О—Й–∞—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В—М —Б–Є—Б—В–µ–Љ –њ—А–Є –Є—Б–њ–Њ–ї–љ–µ–љ–Є–Є JavaScript –Є –њ—А–Њ–Є–≥—А—Л–≤–∞–љ–Є–Є flash-—А–Њ–ї–Є–Ї–Њ–≤ –≤ –±—А–∞—Г–Ј–µ—А–∞—Е. –Ч–і–µ—Б—М —Б—А–∞–Ј—Г –ґ–µ —Б–і–µ–ї–∞–µ–Љ –Њ–і–љ–Њ –љ–µ–±–Њ–ї—М—И–Њ–µ –ї–Є—А–Є—З–µ—Б–Ї–Њ–µ –Њ—В—Б—В—Г–њ–ї–µ–љ–Є–µ, —З—В–Њ–±—Л —А–∞–Ј–≤–µ—П—В—М –≤–µ—Б—М–Љ–∞ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ—С–љ–љ–Њ–µ, –Ї–∞–Ї –≤—Л—П—Б–љ–Є–ї–Њ—Б—М, –Ј–∞–±–ї—Г–ґ–і–µ–љ–Є–µ: Java –Є JavaScript –Є–Ј –Њ–±—Й–µ–≥–Њ, –Є–Љ–µ—О—В —В–Њ–ї—М–Ї–Њ –±—Г–Ї–≤–Њ—Б–Њ—З–µ—В–∞–љ–Є–µ ¬Ђ Java¬ї –≤ —Б–≤–Њ—С–Љ –љ–∞–Ј–≤–∞–љ–Є–Є. –Т –Њ—Б—В–∞–ї—М–љ–Њ–Љ —Н—В–Њ —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ —А–∞–Ј–љ—Л–µ —П–Ј—Л–Ї–Є, –њ—А–Є—З—С–Љ –µ—Б–ї–Є –Є—Б–њ–Њ–ї–љ–µ–љ–Є–µ–Љ –Ї–Њ–і–∞ Java –Ј–∞–љ–Є–Љ–∞–µ—В—Б—П —Б–њ–µ—Ж–Є–∞–ї–Є–Ј–Є—А–Њ–≤–∞–љ–љ–∞—П, –Њ—В–і–µ–ї—М–љ–Њ —Г—Б—В–∞–љ–∞–≤–ї–Є–≤–∞–µ–Љ–∞—П Java-–Љ–∞—И–Є–љ–∞, —В–Њ –Є—Б–њ–Њ–ї–љ–µ–љ–Є–µ–Љ –Ї–Њ–і–∞ JavaScript –Ј–∞–љ–Є–Љ–∞–µ—В—Б—П —Б–∞–Љ –±—А–∞—Г–Ј–µ—А (—Б–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ, –≤ —А–∞–Ј–ї–Є—З–љ—Л—Е –±—А–∞—Г–Ј–µ—А–∞—Е JavaScript –Љ–Њ–ґ–µ—В –Є—Б–њ–Њ–ї–љ—П—В—М—Б—П —Б —Б—Г—Й–µ—Б—В–≤–µ–љ–љ–Њ —А–∞–Ј–ї–Є—З–љ–Њ–є —Б–Ї–Њ—А–Њ—Б—В—М—О). –Т –Ї–∞—З–µ—Б—В–≤–µ —Н–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–∞, –Љ—Л —А–µ—И–Є–ї–Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –і–≤–∞ –Њ—В–љ–Њ—Б–Є—В–µ–ї—М–љ–Њ –њ–Њ–њ—Г–ї—П—А–љ—Л—Е Java Script-–±–µ–љ—З–Љ–∞—А–Ї–∞ –Њ—В Sun Microsystems (Spider) –Є –Њ—В Google (V8 Benchmark Suite). –Э—Г –Є —З—В–Њ–±—Л –љ–Є–Ї–Њ–Љ—Г –љ–µ –±—Л–ї–Њ –Њ–±–Є–і–љ–Њ, –Є—Б–њ–Њ–ї–љ—П—О—В—Б—П —Н—В–Є –±–µ–љ—З–Љ–∞—А–Ї–Є –≤–Њ –≤—Б–µ—Е 5 —Б–∞–Љ—Л—Е –њ–Њ–њ—Г–ї—П—А–љ—Л—Е –±—А–∞—Г–Ј–µ—А–∞—Е. –С–µ–љ—З–Љ–∞—А–Ї –і–ї—П flash –≤—Л–±—А–∞—В—М –±—Л–ї–Њ –Є –≤–Њ–≤—Б–µ –љ–µ—Б–ї–Њ–ґ–љ–Њ вАФ —З–µ—Б—В–љ–Њ –≥–Њ–≤–Њ—А—П, —Н—В–Њ –µ–і–Є–љ—Б—В–≤–µ–љ–љ—Л–є –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ—А–Є–ї–Є—З–љ–Њ —Б–і–µ–ї–∞–љ–љ—Л–є flash-–±–µ–љ—З–Љ–∞—А–Ї, –Ї–Њ—В–Њ—А—Л–є –љ–∞–Љ —Г–і–∞–ї–Њ—Б—М –Њ—В—Л—Б–Ї–∞—В—М –љ–∞ –њ—А–Њ—Б—В–Њ—А–∞—Е –Є–љ—В–µ—А–љ–µ—В–∞. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, —Б—Г–і—П –њ–Њ —А–µ–Ј—Г–ї—М—В–∞—В–∞–Љ –њ—А–µ–і–≤–∞—А–Є—В–µ–ї—М–љ—Л—Е —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є–є, –Њ–љ —Б–њ–Њ—Б–Њ–±–µ–љ —Б–Њ–Ј–і–∞–≤–∞—В—М –≤–µ—Б—М–Љ–∞ –і–Њ—Б—В–Њ–є–љ—Г—О –љ–∞–≥—А—Г–Ј–Ї—Г –і–∞–ґ–µ –і–ї—П —Б–∞–Љ—Л—Е –Љ–Њ—Й–љ—Л—Е —Б–Њ–≤—А–µ–Љ–µ–љ–љ—Л—Е —Б–Є—Б—В–µ–Љ.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- Sun Spider Benchmark;

- Google V8 Benchmark Suite;

- Flash Benchmark вАЩ08;

- Windows Internet Explorer 8;

- Mozilla Firefox 3.6.2;

- Opera 10.5;

- Google Chrome 4.1.249;

- Safari 4.0.5.

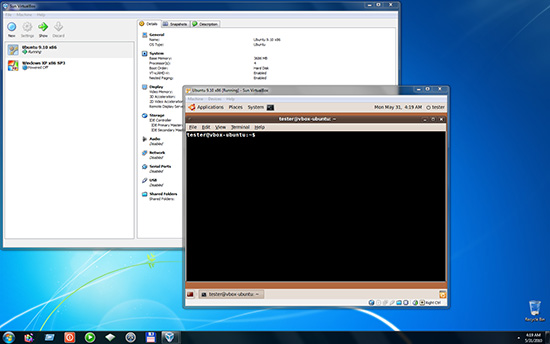

–Т–Є—А—В—Г–∞–ї–Є–Ј–∞—Ж–Є—П

–Х—Й—С –Њ–і–љ–∞ —Н–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–∞–ї—М–љ–∞—П –≥—А—Г–њ–њ–∞ —В–µ—Б—В–Њ–≤ –і–ї—П —А–∞–љ–µ–µ –љ–µ –Є—Б—Б–ї–µ–і–Њ–≤–∞–љ–љ–Њ–є –љ–∞–Љ–Є –Њ–±–ї–∞—Б—В–Є –њ—А–Є–Љ–µ–љ–µ–љ–Є—П. –Т–≤–Є–і—Г –≤—Л—И–µ—Б–Ї–∞–Ј–∞–љ–љ–Њ–≥–Њ, –Љ—Л —А–µ—И–Є–ї–Є, —З—В–Њ –љ–∞—З–Є–љ–∞—В—М –њ—А–Њ—Й–µ —Б –њ—А–Њ—Б—В–Њ–≥–Њ, –њ–Њ—Н—В–Њ–Љ—Г –Њ—Б–Њ–±–Њ–є –Є–Ј—Л—Б–Ї–∞–љ–љ–Њ—Б—В—М—О —А–∞–Ј—А–∞–±–Њ—В–∞–љ–љ—Л–µ –љ–∞–Љ–Є —В–µ—Б—В—Л –љ–µ –Њ—В–ї–Є—З–∞—О—В—Б—П: –≤ –і–∞–љ–љ–Њ–Љ —Б–ї—Г—З–∞–µ –≥–Њ—А–∞–Ј–і–Њ –≤–∞–ґ–љ–µ–µ –±—Л–ї–∞ —Б—В–∞–±–Є–ї—М–љ–Њ—Б—В—М —А–∞–±–Њ—В—Л –Є —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤, –Є –њ—А–µ–і—Б–Ї–∞–Ј—Г–µ–Љ–Њ—Б—В—М –њ–Њ–≤–µ–і–µ–љ–Є—П. –°—Г—В—М —В–µ—Б—В–Њ–≤ —Б–Њ—Б—В–Њ–Є—В –≤ —Б–ї–µ–і—Г—О—Й–µ–Љ: –љ–∞ —Б–Є—Б—В–µ–Љ—Г —Г—Б—В–∞–љ–∞–≤–ї–Є–≤–∞–µ—В—Б—П –±–µ—Б–њ–ї–∞—В–љ–∞—П –і–ї—П –љ–µ–Ї–Њ–Љ–Љ–µ—А—З–µ—Б–Ї–Њ–≥–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П (—Н—В–Њ, —Б–ї–µ–і—Г–µ—В –Ј–∞–Љ–µ—В–Є—В—М, –љ–µ–Љ–∞–ї–Њ–µ –і–Њ—Б—В–Њ–Є–љ—Б—В–≤–Њ) –≤–Є—А—В—Г–∞–ї—М–љ–∞—П –Љ–∞—И–Є–љ–∞ Sun VirtualBox, –њ–Њ—Б–ї–µ —З–µ–≥–Њ –љ–∞ –љ–µ—С –Є–љ—Б—В–∞–ї–ї–Є—А—Г—О—В—Б—П –і–≤–µ ¬Ђ–≥–Њ—Б—В–µ–≤—Л–µ¬ї –Ю–°: Windows XP Professional x86 SP3 –Є Ubuntu Linux x86. –Ф–∞–ї–µ–µ, –њ–Њ–і —Г–њ—А–∞–≤–ї–µ–љ–Є–µ–Љ –Њ–±–Њ–Є—Е ¬Ђ–≤–Є—А—В—Г–∞–ї—М–љ—Л—Е¬ї –Є –Њ—Б–љ–Њ–≤–љ–Њ–є ¬Ђ–љ–∞—В–Є–≤–љ–Њ–є¬ї –Ю–° (–љ–∞–њ–Њ–Љ–љ–Є–Љ, —З—В–Њ —Н—В–Њ Windows 7 Ultimate x64), –Є—Б–њ–Њ–ї–љ—П–µ—В—Б—П –Њ–і–Є–љ –Є —В–Њ—В –ґ–µ –±–µ–љ—З–Љ–∞—А–Ї, –њ–Њ—Б–ї–µ —З–µ–≥–Њ –Љ—Л –Є–Љ–µ–µ–Љ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –Њ—Ж–µ–љ–Є—В—М –њ—А–Њ—Ж–µ–љ—В –њ–∞–і–µ–љ–Є—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –њ–Њ–і ¬Ђ–≤–Є—А—В—Г–∞–ї—М–љ—Л–Љ–Є¬ї –Ю–°. –С–µ–љ—З–Љ–∞—А–Ї, –Ї–Њ—В–Њ—А—Л–є –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ–Њ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ—А–Њ—Б—В –Є –њ—А–µ–і—Б–Ї–∞–Ј—Г–µ–Љ, –љ–µ –Ј–∞–≤–Є—Б–Є—В –Њ—В –і–Є—Б–Ї–Њ–≤–Њ–є –њ–Њ–і—Б–Є—Б—В–µ–Љ—Л (—Б —Н—В–Є–Љ –∞—Б–њ–µ–Ї—В–Њ–Љ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є —Г –≤–Є—А—В—Г–∞–ї—М–љ—Л—Е –Љ–∞—И–Є–љ, –Є—Б–њ–Њ–ї–љ—П–µ–Љ—Л—Е –њ–Њ–і —Г–њ—А–∞–≤–ї–µ–љ–Є–µ–Љ –і—А—Г–≥–Њ–є –Ю–°, –і–µ–ї–∞ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ ¬Ђ–љ–µ –Њ—З–µ–љ—М¬ївА¶), —Б—Г—Й–µ—Б—В–≤—Г–µ—В –≤ –≤–µ—А—Б–Є–Є –Ї–∞–Ї –і–ї—П Windows, —В–∞–Ї –Є –і–ї—П Linux, –Є –њ—А–Є —Н—В–Њ–Љ —Б–Њ–Ј–і–∞—С—В –Њ—Й—Г—В–Є–Љ—Г—О –љ–∞–≥—А—Г–Ј–Ї—Г —Е–Њ—В—П –±—Л –љ–∞ –і–≤–µ –њ–Њ–і—Б–Є—Б—В–µ–Љ—Л вАФ –њ—А–Њ—Ж–µ—Б—Б–Њ—А –Є –њ–∞–Љ—П—В—М, –љ–∞–є—В–Є –±—Л–ї–Њ –љ–µ –Њ—З–µ–љ—М –ї–µ–≥–Ї–Њ, –љ–Њ –Љ—Л —Б –і–∞–љ–љ–Њ–є –Ј–∞–і–∞—З–µ–є —Б–њ—А–∞–≤–Є–ї–Є—Б—М. –≠—В–Њ –Њ–Ї–∞–Ј–∞–ї—Б—П –≤—Б—В—А–Њ–µ–љ–љ—Л–є –±–µ–љ—З–Љ–∞—А–Ї 7-Zip. –Ъ–Њ–љ–µ—З–љ–Њ, –Љ–Њ–ґ–љ–Њ –њ–Њ—Б–µ—В–Њ–≤–∞—В—М –љ–∞ —В–Њ, —З—В–Њ –Њ–љ –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ ¬Ђ—Б–Є–љ—В–µ—В–Є—З–µ–љ¬ї, –Њ–і–љ–∞–Ї–Њ –≤—Л—И–µ–њ–µ—А–µ—З–Є—Б–ї–µ–љ–љ—Л–є —Б–њ–Є—Б–Њ–Ї –і–Њ—Б—В–Њ–Є–љ—Б—В–≤, —Б –љ–∞—И–µ–є —В–Њ—З–Ї–Є –Ј—А–µ–љ–Є—П, –њ–µ—А–µ–≤–µ—И–Є–≤–∞–µ—В –љ–µ–і–Њ—Б—В–∞—В–Ї–Є.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- 7-Zip 9.04 beta x86 –і–ї—П Windows;

- P7zip 9.04 beta x86 –і–ї—П Linux (–њ–Њ—А—В);

- Sun VirtualBox 3.1.6;

- Windows XP Professional x86 SP3;

- Ubuntu Linux x86 9.10.

–°–Ї–Њ—А–Њ—Б—В—М –Ј–∞–≥—А—Г–Ј–Ї–Є –њ—А–Є–ї–Њ–ґ–µ–љ–Є–є

–Ф–∞–љ–љ—Л–є —Н–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–∞–ї—М–љ—Л–є —В–µ—Б—В —П–≤–ї—П–µ—В—Б—П, –њ–Њ–ґ–∞–ї—Г–є, –µ–і–Є–љ—Б—В–≤–µ–љ–љ—Л–Љ, –Ї–Њ—В–Њ—А—Л–є –Є–Ј–љ–∞—З–∞–ї—М–љ–Њ —А–∞–Ј—А–∞–±–∞—В—Л–≤–∞–ї—Б—П –љ–∞–Љ–Є –љ–µ –і–ї—П —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П –њ—А–Њ—Ж–µ—Б—Б–Њ—А–Њ–≤, –∞ —Б—А–∞–Ј—Г –ґ–µ –і–ї—П –Ї–Њ–Љ–њ–ї–µ–Ї—Б–љ–Њ–≥–Њ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П –≥–Њ—В–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ. –°—Г—В—М –µ–≥–Њ –њ—А–Њ—Б—В–∞: –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ–Њ –і–∞—С—В—Б—П –Ї–Њ–Љ–∞–љ–і–∞ –љ–∞ –Ј–∞–њ—Г—Б–Ї 10 –і–Њ—Б—В–∞—В–Њ—З–љ–Њ ¬Ђ—В—П–ґ—С–ї—Л—Е¬ї –њ—А–Є–ї–Њ–ґ–µ–љ–Є–є (—Б–њ–Є—Б–Њ–Ї —Б–Љ. –љ–Є–ґ–µ), –њ–Њ—Б–ї–µ —З–µ–≥–Њ –Ј–∞–Љ–µ—А—П–µ—В—Б—П –≤—А–µ–Љ—П –Њ—В –њ–Њ–і–∞—З–Є –Ї–Њ–Љ–∞–љ–і—Л –і–Њ –њ–Њ—П–≤–ї–µ–љ–Є—П –љ–∞ —Н–Ї—А–∞–љ–µ –Њ–Ї–љ–∞ –њ–Њ—Б–ї–µ–і–љ–µ–≥–Њ –Њ—В–Ї—А—Л–≤—И–µ–≥–Њ—Б—П –њ—А–Є–ї–Њ–ґ–µ–љ–Є—П. –Т–ї–Є—П—О—В –љ–∞ —А–µ–Ј—Г–ї—М—В–∞—В—Л —Н—В–Њ–≥–Њ —В–µ—Б—В–∞ –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є –≤—Б–µ –Ї–ї—О—З–µ–≤—Л–µ –њ–∞—А–∞–Љ–µ—В—А—Л —Б–Є—Б—В–µ–Љ–љ–Њ–≥–Њ –±–ї–Њ–Ї–∞, –Ј–∞ –Є—Б–Ї–ї—О—З–µ–љ–Є–µ–Љ, –њ–Њ–ґ–∞–ї—Г–є, –ї–Є—И—М –≤–Є–і–µ–Њ—Б–Є—Б—В–µ–Љ—Л: –Є –±—Л—Б—В—А–Њ–і–µ–є—Б—В–≤–Є–µ –Њ–і–Є–љ–Њ—З–љ–Њ–≥–Њ —П–і—А–∞, –Є –Є—Е –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ, –Є —А–∞–Ј–Љ–µ—А –њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ–Њ–≥–Њ –Ї—Н—И–∞, –Є –±—Л—Б—В—А–Њ–і–µ–є—Б—В–≤–Є–µ –ґ—С—Б—В–Ї–Њ–≥–Њ –і–Є—Б–Ї–∞, –Є –Њ–±—К—С–Љ –Ю–Ч–£. –†–∞–Ј—Г–Љ–µ–µ—В—Б—П, –Ї–∞–Ї —З–Є—Б—В–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ—А–љ—Л–є, –і–∞–љ–љ—Л–є —В–µ—Б—В –≤—А—П–і –ї–Є –њ—А–Є–Њ–±—А–µ—В—С—В –±–Њ–ї—М—И—Г—О –њ–Њ–њ—Г–ї—П—А–љ–Њ—Б—В—М, –Њ–і–љ–∞–Ї–Њ –і–ї—П —Б—А–∞–≤–љ–µ–љ–Є—П –≥–Њ—В–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ –Є–ї–Є –і–∞–ґ–µ –љ–Њ—Г—В–±—Г–Ї–Њ–≤, –Њ–љ –Љ–Њ–ґ–µ—В –Њ–Ї–∞–Ј–∞—В—М—Б—П –≤–µ—Б—М–Љ–∞ –њ–Њ–ї–µ–Ј–љ—Л–Љ.–Ш—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ —В–µ—Б—В—Л –Є –Я–Ю:

- Maya 2010 x64;

- Lightwave 3D 9.6 x64;

- Pro/ENGINEER Wildfire 5.0 x64;

- SolidWorks 2010 x64;

- UGS NX 6 x64;

- Adobe Photoshop CS4 x64;

- Corel PhotoImpact X3;

- Corel PaintShop Photo Pro X3;

- Microsoft Visual Studio 8 (IDE);

- Microsoft Visual Studio 8 (Developer Environment).

–Я—А–µ–і—Б—В–∞–≤–ї–µ–љ–љ–∞—П –≤–∞–Љ –Љ–µ—В–Њ–і–Є–Ї–∞ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –Ї–Њ–Љ–њ—М—О—В–µ—А–љ—Л—Е —Б–Є—Б—В–µ–Љ вАФ –Ј–∞–Ї–Њ–љ–Њ–Љ–µ—А–љ—Л–є –њ—А–Њ–і—Г–Ї—В —Н–≤–Њ–ї—О—Ж–Є–Є –њ—А–µ–і—Л–і—Г—Й–µ–є –≤–µ—А—Б–Є–Є, –Њ—В–ї–Є—З–∞—О—Й–Є–є—Б—П –Њ—В –љ–µ—С –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –Є–Ј–Љ–µ–љ—С–љ–љ—Л–Љ —Б–њ–Є—Б–Ї–Њ–Љ –Я–Ю –Є –±–Њ–ї—М—И–µ–є —И–Є—А–Њ—В–Њ–є –Њ—Е–≤–∞—В–∞ —А–∞–Ј–ї–Є—З–љ—Л—Е –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М—Б–Ї–Є—Е –Ј–∞–і–∞—З. –Ю–±–Њ–Ј–љ–∞—З–µ–љ–љ–∞—П –µ—Й—С –≤ –њ—А–Њ—И–ї–Њ–є –Љ–µ—В–Њ–і–Є–Ї–µ —В–µ–љ–і–µ–љ—Ж–Є—П –Њ—В—Е–Њ–і–∞ –Њ—В –Ј–∞–Љ—Л–Ї–∞–љ–Є—П –љ–∞ —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є–Є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї—М–љ–Њ—Б—В–Є –Є—Б–Ї–ї—О—З–Є—В–µ–ї—М–љ–Њ –Њ–і–љ–Њ–≥–Њ –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В–∞ (–њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞) вАФ –≤—Л—А–∞–ґ–µ–љ–∞ –µ—Й—С –±–Њ–ї–µ–µ —П–≤–љ–Њ, –≤ —В–Њ–Љ —З–Є—Б–ї–µ –њ–Њ—П–≤–ї–µ–љ–Є–µ–Љ –љ–Њ–≤—Л—Е —В–µ—Б—В–Њ–≤, –Ї–Њ—В–Њ—А—Л–µ –Є–Ј–љ–∞—З–∞–ї—М–љ–Њ —А–∞–Ј—А–∞–±–∞—В—Л–≤–∞–ї–Є—Б—М –Ї–∞–Ї –Ї–Њ–Љ–њ–ї–µ–Ї—Б–љ—Л–µ. –Т —В–Њ –ґ–µ –≤—А–µ–Љ—П, –Љ—Л –љ–∞–і–µ–µ–Љ—Б—П, –Ј–∞–њ–ї–∞–љ–Є—А–Њ–≤–∞–љ–љ—Л–є –љ–∞–Љ–Є –њ–µ—А–µ—Е–Њ–і –њ–Њ–ї—Г—З–∞–µ—В—Б—П –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ–ї–∞–≤–љ—Л–Љ, —З—В–Њ–±—Л –њ–Њ–Ї–ї–Њ–љ–љ–Є–Ї–Є —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–Њ–≥–Њ –њ–Њ–і—Е–Њ–і–∞ —Г—Б–њ–µ–ї–Є –њ–µ—А–µ—Б—В—А–Њ–Є—В—М—Б—П –±–µ–Ј —Б–ї–Є—И–Ї–Њ–Љ —Б–Є–ї—М–љ–Њ–≥–Њ –і–Є—Б–Ї–Њ–Љ—Д–Њ—А—В–∞ –і–ї—П —Б–µ–±—П.