Весна-лето 2000 года выдались не менее бурными для рынка 3D графических акселераторов, нежели в 1999 году. Первые скрипки на рынке играют все те же фирмы. За исключением двух особенностей:

- роль 3dfx сильно снизилась на рынке, фирма никак не может решить проблемы с производством новых плат на базе 3dfx VSA100,

- произошла замена одного игрока в "трио" ведущих фирм: вместо Matrox ныне выступает ATI Technologies (Matrox "ушел в подполье", обещая к осени шокировать всех своим G800).

Да, сильное отставание по времени выхода продукции фирмы ATI от конкурентов было заметно в течение последних полутора лет. Особенно "било" по репутации фирмы систематическое опаздывание выхода реальной продукции на прилавки магазинов относительно сроков анонсирования. Можно вспомнить про чип ATI RAGE 128 PRO, платы на базе которого были объявлены еще в октябре 1999 года, однако реально их купить стало возможно только весной этого года. Это положение вещей не могло не сказаться на финансовом состоянии компании, и мы вместе с инвесторами были свидетелями нерадостных финансовых отчетов ATI за последние кварталы. Как водится, фирма, не признает своей вины в этом, а все сваливает на поставщиков и производителей комплектующих.

И вот, весной этого года мы стали свидетелями того, что фирма ATI Technologies сделала рывок вперед и анонсировала графический процессор последнего поколения, по возможностям не уступающий новинкам от NVIDIA и 3dfx. Хочу отметить, что впервые это произошло не через полгода после выхода конкурирующих чипсетов, а буквально вслед за ними. Неофициальные спецификации нового GPU с кодовым именем RAGE6 и информация о карте на его базе еще в начале марта дали основания полагать, что фирма наконец-то "взялась" за ум по написанию драйверов, устойчиво работающих и позволяющих новому чипу реализовать свой потенциал. Уже тогда можно было предполагать, что производительность нового GPU от ATI будет на высоте.

К сожалению, все же задержки по времни возникли. Если новый чип от ATI был анонсирован в мае, то видеокарты на нем представлены только в середине июля. За это время платы на базе NVIDIA GeForce2 GTS уже успели изрядно подешеветь, поэтому новинкам от ATI будет не так просто занять достойное место на рынке. Но есть и отрадный момент для ATI: компания 3dfx не сильно торопится наводнить рынок своими картами Voodoo5 5500, которые только-только стали появляться на прилавках, причем по сверхвысоким ценам. Если ATI не упустит момент, то шанс пробиться на рынок и захватить его весомую часть у ее продуктов нового поколения имеется вполне хороший.

Однако это все были предположения, рассмотрим реалии, а именно возможности нового графического процессора от ATI — RADEON GRAPHICS. В дальнейшем я буду называть его просто RADEON.

Итак, посмотрим на основным характеристики GPU RADEON:

- 256 разрядное графическое ядро

- Технологический процесс: 0.18 мкм, позднее, по нашей информации, ожидается переход на 0.15 и 0.13 мкм

- Площадь ядра: 100 мм2

- Количество транзисторов: 30 млн.

- Число конвейеров рендеринга: два с тремя блоками текстурирования на каждом

- Частота ядра: 183 МГц (по нашей информации архитектура ядра рассчитана на частоты вплоть до 400 МГц)

- Частота работы шины памяти: до 200 Мгц

- Поддерживаемые типы памяти: DDR SDRAM (в будущем возможно использование памяти типа DDR FCDRAM) и стандартная SDR SDRAM/SGRAM

- Объем локальной видеопамяти: от 8 Мб до 128 Мб

- Поддерживается технология HyperZ, которая позволяет увеличить эффективность ширины полосы пропускания видеопамяти более чем на 20%.

- Ширина полосы пропускания памяти: 6.4 Гб в сек. (пиковая при частоте работы памяти 200 МГц), при использовании технологии HyperZ — до 8 Гб в сек.

- Pixel Fillrate: 366 млн. пикселей в секунду

- Texel Fillrate:

- 1 texel per 1 Pixel 366 млн. текселей в секунду

- 2 texel per 1 Pixel 733 млн. текселей в секунду

- 3 texel per 1 Pixel 1098 млн. текселей в секунду

- В чипе имеются кэши: текстурный, пиксельный и координат вершин (vertex cache)

- RAMDAC: 350 МГц, интегрирован в графическое ядро

- Максимальное разрешение: 2048x1536@75Hz

- Интегрированный в чип TMDS трансмиттер позволяет подключать DFP мониторы и поддерживает разрешение вплоть до 1600x1200

- Поддерживается технология MAXX, т.е. допускается установка двух чипов RADEON на одной карте

- Интерфейс внешней шины: полная поддержка AGP x2/x4 (включая SBA, DME и Fast Writes) и PCI 2.2 (включая Bus mastering). Режим AGP x4 Fast Writes позволяет использовать метод прямого обмена данными CPU и GPU, миную системную память компьютера со скоростью до 1 Гб/сек, что должно положительно сказываться на общей производительности и разгружать шину системной памяти.

3D графика:

- Геометрический движок Charisma Engine — аппаратная реализация преобразования координат, установка освещения, clipping (отсечение полигонов, не входящих в конечный кадр), vertex skinning, keyframe interpolation (интерполяция между ключевыми кадрами), perspective devide, triangle setup

- Поддержка до четырех skinning матриц, применяемых для интерполяции вершин полигонов (vertex blending)

- Производительность HW TCL: 30 млн. текстурированных полигонов в секунду (пиковая)

- Аппаратная установка 8 источников света для всей сцены (directional aka infinite и point Lights aka local)

- Полная поддержка OpenGL и DX7 — Tranform & Lighting, Cube environment mapping (кубического текстурирования картами окружения), projective textures (проекция текстур) и компрессия текстур

- Движок рендеринга Pixel Tapestry позволяющая использовать три блока текстурирования на каждом конвейере рендеринга пикселей

- Поддерживаются следующие методы наложения текстур: Сubic, Spherical и Dual-Paraboloid

- Рендеринг при 16 и 32 битной глубине представления цвета

- Аппаратная поддержки рельефного текстурирования следующих типов: Embosing, Dot Product3, EMBM

- Поддерживаются текстуры вплоть до 2048x2048 @ 32 bit

- Программируемые режимы смешивания нескольких текстур

- Поддерживаются 3D текстуры, это позволяет воспроизводить объемные эффекты, например туман или динамично изменяемы источник света, например огонь в камине

- Поддержка реализации аппаратных эффектов типа Motion Blur, Depth of Field, сглаживания всей сцены (FSAA) и т.д. через D3D8

- Буфер шаблонов (стенсель): 8 бит

- Z-буфер: 16/24/32 бит

- Наложение теней для каждого индивидуального источника света, для этого в чипе реализован специалный Priority Buffer

- Полная поддержка Direct3D модели освещения

- Поддержка табличного и вершинного тумана

Видео:

- Поддерживается аппаратное декодирование всех форматов HDTV

- Поддерживаются все разрешения ATSC, включая 1080i

- Благодаря поддержке формата YPrPb имеется возможность прямого подключения HDTV дисплеев

- Поддерживается технология Adaptive de-interlacing — уникальная технология от ATI позволяющая воспроизводить видео с высокой четкостью без артефактов или размытия

- Поддерживается 8-bit режим альфа смешивания видео и графики (например, это используется для наложения субтитров или анимационных меню)

- Полная совместимость с чипом-компаньоном Rage Theater от ATI

Подробное описание нового чипсета от ATI можно прочитать в нашем аналитическом обзоре "RADEON 256 — новый GPU от ATI". Здесь я затрону лишь основные характеристики и особенности RADEON.

Как можно видеть, список достоинств нового чипа чрезвычайно велик, и уже видится этакий "монстр", позволяющий создавать почти фотореалистичную графику. Разумеется, надо признать, что за последний год фирмы-производители графических процессоров заметно приблизились к вожделенному отточенному качеству трехмерной графики, позволяющих в реальном времени выполняя рендеринг сложнейших объектов и сцен. К сожалению, я должен еще и еще раз напомнить, что отнюдь не все зависит от желания и возможностей производителей GPU. Даже если и выйдет супермощный процессор, со сногсшибательными характеристиками, дающими как скорость свыше 100 fps во всех основных разрешениях, так и изумительное качество, то новых игр, реализующих эти возможности в полной мере, больше не станет. Пока производители игр не проснутся от спячки, ленности и желания зарабатывать деньги только на ширпотребных играх, воз будет и ныне там.

Я соглашусь, что все новейшие видеокарты имеют сверхвысокие цены, не позволяющие им стать массовыми акселераторами. Этим производители игр постоянно оправдывают свое нежелание тратить средства и время на разработку "крутых" игр "под GeForce или RADEON", которые могут не оправдать вложенных в них затрат. Однако я считаю, что этот факт ничуть не оправдывает нежелание производителей игр делать свою продукцию в расчете на множество 3D-ускорителей разных типов и возможностей. То есть, игра в идеале должна подстраиваться под видеокарту, и на NVIDIA GeForce256/2 GTS, ATI RADEON использовать многополигонные объекты, реалистичное освещение (используя возможность Hardware T&L), загружая центральный процессор системы более точным вычислением физики, например, движения воды (волн), самих героев в играх, даже мимики их лиц. А под Voodoo2/3, например, та же игра сможет использовать упрощенную графику, не задействую огромных текстур, снижая количество полигонов в объектах, чтобы и на этих акселераторах игра имела приличную скорость. Сделать такие игры очень сложно, однако их срок жизни и популярность будут настолько велики, что это может окупить все затраты. Пока же мы довольствуемся анонсами "суперкрутых" игр и ДЕМО-программами, показывающими нам возможности новейших GPU. Причем, каждая из демо-программ показывает только особенности "привязанного к ней" GPU, подчас демонстрируя на других чипах артефакты изображения. Ниже я продемонстрирую это на практике.

Что же нового нам дает ATI RADEON? Прежде всего это принципиально новое графическое ядро, которое не имеет ничего общего с предыдущими. Напрашивается аналогия: NVIDIA GeForce 256 и Riva TNT2. Действительно, рывок налицо, однако он намного более силен, нежели это было осенью 1999 года, когда появился NVIDIA GeForce 256.

Charisma Engine

Геометрический движок Charisma Engine имеет следующие возможности:

Аппаратная поддержка установки вершинного освещения. Ожидается, что при использовании более одного источник света типа Directional Lights (направленное освещение, aka Infinite; в этом случае источник света трактуется как точка, расположенная на бесконечном расстоянии от видимых объектов сцены) падение производительности будет менее существенным по сравнению с GeForce256.

Аппаратное преобразование координат вершин полигонов из 3D координат моделируемой сцены в 2D координаты экрана монитора с учетом коррекции расстояний, т.н. операция трансформации перспективы.

На аппаратном уровне поддерживается процесс отсечения невидимых в конечной сцене полигонов — Clipping.

Несмотря на то, что GeForce 256 поддерживает Clipping на аппаратном уровне, его геометрический сопроцессор обычно называют сокращенным именем HW T&L. Сейчас же все чаще блок геометрических операций и установки вершинного освещения называют сокращенно HW TCL, подчеркивая наличие аппаратного Clipping, хотя и старое сокращение "HW T&L" ничем не хуже.

Заявленная производительность HW TCL у RADEON — около 30 млн. полигонов в секунду. Если учесть, что для GeForce 2 GTS заявлена производительность в 25 млн. полигонов в секунду, то блок геометрических операций у RADEON потенциально является самым быстрым в индустрии на сегодня. Забегая вперед, скажу, что это мягко говоря не так.

На аппаратном уровне могут выполняться ряд специальных операций, поддержка которых реализована в Charisma Engine: Vertex Skinning и Keyframe Interpolation.

Аппаратная поддержка Triangle Setup, т.е. процесс преобразования плавающих координат вершин треугольников к целочисленным координатам в кадровом буфере и установки прочих параметров связанных с вершинами, например привязки текстур.

Vertex Skinning

Это метод правильной трансформации вершин геометрической сетки в местах сгиба модели, т.е. работа идет только с геометрией, а не с текстурами. Текстуры на корректно трансформированную геометрию натянутся правильно. Чтобы геометрия была трансформирована корректно, особенно на сгибах и сочленениях (например, все суставы при моделировании тела человека) применяется техника vertex skinning (single-skin effect). Заметим, что vertex skinning является подмножеством метода интерполяции вершин (vertex blending). По сути, vertex blending это как alpha blending, только для вершин, а не для пикселов (V = V1*alpha + V2*(1-alpha)). Метод vertex skinning это vertex blending для вершин, обработанных разными матрицами (V = V1*M1*alpha + V2*M2*(1-alpha)). Подчеркнем: корректность наложения текстур на сгибах является следствием правильного расположения вершин, которое и достигается при помощи vertex skinning. Применяется Vertex Skinning для того, чтобы на стыках текстур были плавные, естественные переходы, особенно во время движения. Интерполяция вершин осуществляется с помощью матриц, называемых Skinning Matrices.

Можно видеть, что слева интерполяция идет по 2-х матричной схеме, а справа — по 4-х, что позволяет у этой кошки убрать артефакты в виде острых углов на сгибах лап.

В D3D есть поддержка для 2-х, 3-х и 4-х матричной интерполяции вершин. В большинстве случаев хватает 2-х матричной интерполяции. Однако на стыке туловища с шеей и руками предпочтительнее использовать 4-х матричную интерполяцию, а на стыке туловища и двух ног — 3-х матричную интерполяцию. Тем не менее, улучшение от 3-х и 4-х матричной интерполяции вершин видны только при долгом рассмотрении персонажа размером во весь экран. В GeForce256 поддерживается на аппаратном уровне только 2-х матричная интерполяция.

Keyframe Interpolation

Интерполяция по ключевым кадрам позволяет реализовать на аппаратном уровне изменение внешнего вида отображаемого объекта за счет задания только начального изображения, конечного изображения и ключевых промежуточных кадров, все остальные преобразования выполняются автоматически. Иными словами Charisma Engine вставляет необходимое число интерполированных кадров между "ключевыми" и в результате, например, можно довольно просто реализовать изменение мимики на лице персонажа игры.

Понятно, что выполнение операций TCL, а также Vertex Skinning и Keyframe Interpolation требуют мощных вычислительных ресурсов. У RADEON, судя по всему, с этим нет никаких проблем. В результате разработчики игр смогут использовать большее число полигонов при тесселяции и применять различные специальные эффекты, что сделает 3D мир в игре более реальным.

Высвободившиеся ресурсы CPU разработчики игр могут использовать, например, для обсчёта AI. Для сравнения, в играх, не ориентированных на использование HW TCL на обсчет AI обычно отводится до 5% ресурсов CPU, зато в новых играх, ориентированных на использование возможностей HW TCL на обсчет AI можно уже будет отвести до 30-40% ресурсов CPU, а это значит, что ваши виртуальные противники станут коварнее и хитрее (по крайней мере, можно на это надеяться). Кроме того, высвобождаемые ресурсы CPU можно использовать для расчета физических эффектов повышенной сложности, например, гравитация, атмосферные эффекты. Стоит заметить, что если в игре используются возможности HW TCL, но не используются высвобождаемые ресурсы CPU, то пользователь все равно получит великолепную по качеству и очень быструю графику, хотя не заметит никаких других плюсов. Повторю, что это все станет возможным только в случае пересмотра производителями игр своего отношения к написанию игр, использующих все новации, имеющиеся в последних чипсетах.

Pixel Tapestry

Кроме возможности аппаратно ускорять геометрическую стадию при рендеринге изображения, RADEON, разумеется, умеет аппаратно ускорять стадию растеризации. Именно для этой цели и была создана архитектура рендеринга пикселей и движок с таким же названием — Pixel Tapestry. Этот движок рендеринга встроен в RADEON и был специально создан для реализации работы трех текстурных блоков на каждом из имеющихся конвейеров рендеринга. В RADEON имеется два конвейера рендеринга, на каждом из которых имеется по три блока текстурирования. Это позволяет:

- смешивать и фильтровать до трех текстур на пиксель без потерь в скорости

- аппаратно реализовать различные методы трансформации текстур (cubic environment mapping, projective texturing и т.д)

- реализовать однопроходное наложение рельефных текстур с помощью методов Emboss, Dot Product 3 и Environment Mapped Bump Mapping (EMBM)

- точно моделировать отражающие свойства материалов (вода, метал, дерево и т.д)

Кроме того, с помощью движка Pixel Tapestry реализована поддержка:

- Priority Buffer, который используется для наложения реалистичных теней shadow mapping от индивидуальных источников света

- 3D Textures (трехмерные текстуры), что позволяет создавать сложные, динамические источники освещения, а также объемный туман, дым, жидкости и упрощает обращение с объектами с изменяемой геометрией

Не секрет, что чем больше текстур можно наложить на пиксель за такт, тем реалистичнее и детальнее получается конечное изображение без потерь в общей производительности. Текстуры применяются для наложения карт освещенности, карт теней, моделирования отражений и зеркальных поверхностей, рельефа (bump maps) и т.д.

Особо стоит отметить поддержку рельефного текстурирования EMBM, который пока поддерживается только чипами серии G400 от Matrox, но зато используется в нескольких десятках игр.

Положительным моментом является поддержка RADEON метода кубического наложения карт среды, поддерживаемого в D3D 7.0. В этом методе нет зависимости от точки обзора, но зато используется 6 текстур. Кроме этого метода RADEON поддерживает еще и сферический метод (1 текстура, есть зависимость от точки обзора), двойной параболоидный метод (2 текстуры, зависимость от точки обзора).

Чтобы сцена в игре выглядела реалистично и имела глубину, применяют моделирование теней. Для наложения естественных теней, отбрасываемых объектами сцены в зависимости от удаленности от каждого источника света, в RADEON реализована поддержка специального Priority Buffer (приоритетный буфер). Этот буфер формируется за счет ресурсов локальной видеопамяти и позволяет накапливать информации по объектам, отбрасывающим тени. С помощью Priority Buffer определяется порядок использования данных, в результате первым начинает формироваться тень от объекта, наиболее приближенного к наблюдателю. Наложение теней осуществляется за счет трансформации текстур. Этот метод проще и эффективнее, чем использование традиционного буфера шаблонов.

RADEON имеет поддержку Range-Based Fog, т.е. наложения тумана, плотность которого зависит от удаленности объектов от игрока.

Одна из новых функциональных особенностей RADEON это поддержка 3D textures (трехмерные текстуры). 3D Texture — это текстура представляющая собой 3D массив пикселей, а не 2D как в обычном случае. Это нововведение в OpenGL1.2. До недавнего времени поддержка трехмерных текстур имелась только в Permedia3 от 3Dlabs. Этот тип текстур можно использовать для работы с вокселями (объемные пиксели), наложения сферических текстур для моделирования объемных источников света. Трехмерные текстуры упрощают использование деформируемой геометрии, например, можно отрезать или отщипнуть часть объекта без необходимости обновления текстуры.

В RADEON уже заложена поддержка ряда новшеств, которые будут реализованы в грядущем D3D8 из состава DirectX 8.0. Среди этих новшеств нужно отметить поддержку эффектов Motion Blur и Depth of Field, а также Sfull-scene Anti-aliasing. В API D3D8.0 будет введена поддержка эффектов T-Buffer от 3dfx.

Вообще, про FSAA в пресс-релизе RADEON говорится следующее: "Comprehensive support for full scene, order-independent anti-aliasing", что означает полную поддержку полносценного, независмого от порядка применения, сглаживания. Вполне логично ожидать существенного падения производительности (до 2 раз) при применении FSAA. Применять или не применять FSAA решать все равно пользователю. Ниже я покажу, что может дать FSAA на видеокарте, базируемой на ATI RADEON.

Пока неясна ситуация с поддержкой Pixel Shaders. Pixel Shaders это такой метод создания мультитекстурных эффектов "вручную", поддержка которого будет в DirectX 8.0. Суть в том, что раньше можно было смешивать текстуры только по нескольким заранее заданным формулам (как привило, состоящих из 1-2х операций), зато теперь Pixel Shader — это как бы "программа" смешивания текстур, заданная вручную (туда входят операции +, -, /, * и ещё несколько более экзотических и это можно комбинировать в любом количестве).

Pixel Shaders подразумевает работу на уровне пикселей при моделировании 3D графики, а не на уровне вершин полигонов. Судя по всему никакого специального блока для применения программируемых и заранее заданных мультитекстурных эффектов на уровне пикселей в RADEON нет, но есть возможность управлять процессом смешивания результатов работы тексельных блоков. Этого вполне достаточно для заявления в в пресс-релизе буквально следующего: "First with advanced DX8 pixel shader effects".

Не так давно вышла ДЕМО-программа NVIDIA Chapel, демонстрирующая в том числе и эти методы (скриншоты сняты при установленной видеокарте на NVIDIA GeForce2 GTS):

Эта же программа на ATI RADEON запускается только в оконном режиме довольно сильно тормозит и часть элементов вообще не прорисовываются, сказывается сырость драйверов в реализации части функций, в частности затенение на уровне пикслелей.

Hyper Z

Вообще-то ATI тщательно скрывает, что же из себя представляет эта технология. Из авторитетных западных источников можно получить некоторые сведения о HyperZ, хотя никто из них не доказал пока, что они правы. Итак, HyperZ работает на тайловой основе, т.е на основе разбиения экрана на квадратные фрагменты. RADEON вырисовывает полигон сначала в обычном порядке, затем в тайловом и если тайл полностью закрывает собой полигон, то он отбрасывается и исключается из дальнейшей обработки. Это простой, но очень эффективный трюк, так как сюжет большинства трехмерных игр разыгрывается в сценах содержащих стены, потолки и т.д. ATI сообщает, что такой подход экономит до 20% времени при рендеризации.

Что это означает, а скорее всего то, что алгоритм сохраняет значение только самого "удаленного" значения Z из всего тайла ( например 8х8 пикселей, какой именно размер использует ATI, я не знаю), и при рендеризации полигона, вычисляется его ближайшее значение для каждого тайла который он перекрывает. И если выясняется, что это ближайшее значение находится дальше самого удаленного для тайла, то мы сразу выбрасываем этот полигон. Он нам больше не нужен, т.к. мы его просто не видим. Участок стены покрывает часть экрана размером 8х8, тогда все что находится за этим участком будет отсечено всего одной операцией сравнения, вместо традиционного исследования всех 64 пикселей один за другим. HyperZ является частным воплощением технологии иерархического Z-буфера, о котором сможно прочитать в нашем аналитическом материале.

То есть, по сути, HyperZ нам экономит пропускную способность памяти, уменьшая поток проходящей через нее информации. Мы все знаем, как это важно, например, для NVIDIA GeForce256 SDR или GeForce2 GTS, когда низкие частоты видеопамяти (относительно мощности чипсета) не дают последнему реализовать свой потенциал прежде всего в 32-битном цвете. У ATI RADEON память работает на более высокой частоте (183 (366) МГц против 166 (333) МГц у GeForce2 GTS), а чип по скорости заполнения сцены (fillrate) менее мощный, чем GeForce2 GTS, поэтому по логике вещей, сбалансированность у RADEON намного выше, чем у чипсета от NVIDIA. Тем не менее, любопытно узнать, в каком разрешении RADEON тоже наталкивается на проблему нехватки пропускной способности видеопамяти, и где HyperZ может очень помочь.

Заканчивая рассматривать HyperZ, я хочу отметить, что несмотря на то, что несколько авторитетных западных обозревателей в Интернете заявили о том, что HyperZ по умолчанию включен в драйверах, никто этого так и не доказал. Представленные на сайте SharkyExtreme "ключи" для внесения в реестр по управлению HyperZ по-просту не работают. Поэтому я скажу, что не знаю, включен ли HyperZ был при тестировании или нет.

Таким образом, мы рассмотрели основные особенности нового чипсета ATI RADEON, дающего пользователям как новые возможности в 3D-графике, улучшающие качество трехмерных сцен, так и большой потенциал по производительности. Думается мне, однако, что пользователь уже устал читать периодически вспыхивающие бравады, рожденные в недрах маркетинговых отделов той или иной фирмы, посвященные новому чипу. Если послушать все эти лозунги и крики восторгов, то мы давно бы уже имели фотореалистичную графику с потрясающей скоростью. Однако, мало того, что нас постоянно обманывают, либо предлагая действительно мощный чип, обладающий фантастическими возможностями, но за неимоверные деньги (и ясно, что ни одна фирма, выпускающая игры, не станет под него делать свои продукты), либо выходит в свет чип с "липовыми" характеристиками прежде всего из-за кривости драйверов.

Возьмем два примера:

- известные ДЕМО-программы фирмы WxP Dagoth Moor Zoological Gardens и Isle of Morg;

- новую ДЕМО-программу от ATI Research RADEON's ARK.

Первые две были выпущены для чипов NVIDIA GeForce 256 и GeForce2 GTS, и поддерживают возможности этих чипов в части использования больших текстур, рельефного текстурирования и т.д.

Слева представлены два скриншота из Isle of Morg, полученные на NVIDIA GeForce2 GTS, а справа — на ATI RADEON. В этой "демке" смена дня и ночи идет в реальном времени (а можно этот процесс и ускорить при помощи клавиши F7), поэтому мы видим, как выглядит одна и та же сцена в разное время суток в этой игре:

День:

Ночь:

Как видим, у GeForce2 GTS все в порядке. Небо меняет свой окрас в соответствии с обшим затенением ночью, а вот у RADEON оно осталось того же цвета, что и днем, что как-то неприятно удивило.

Однако не все так плохо. У чипов есть и общие черты, например, реализация рельефного текстурирования по методу Dot Product:

Можем видеть, что в обоих случаях реализация этого эффекта проведена на высоте.

А вот в Dagoth Moor Zoological Gardens картина вообще резко отличается по графике. Слева будут представлены два скриншота, полученные на NVIDIA GeForce2 GTS, а справа — ATI RADEON.

Хорошо видно, что на скриншотах слева цвета все вполне естественные, соответствующие окрасу дня на закате солнца. А вот RADEON выдал настолько потрясающие краски, что вначале даже фальши не замечаешь, наоборот, эта яркость, сочность тонов притягивает к себе. Но по мере хождения по этому "парку" видишь, что огрехов довольно много.

Как можно догадаться, в RADEON's ARK все происходит с точностью до наоборот, когда уже NVIDIA GeForce2 GTS делает "ляпы" в реализации того или иного эффекта:

Очень похоже на то, что в формировании одежды и лица у этой девушки принимают участие 3D-текстуры, которых не "знает" GeForce2.

Мне могут на все это возразить: а чего, мол, я хочу? Это ж ДЕМО, призванные показать особенности того или иного чипа, и они вовсе не обязаны учитывать возможности конкурентов. Я это все привел для того, чтобы показать лишний раз: выходят новые чипы, обладающие разными возможностями, которые подчас являются уникальными технологиями, присущими только им. Да, много новых технологий уже стандартизировано через Microsoft DirectX, однако много еще вне этого инструментария, позволяющего разработчику быть уверенным, что использование в игре того или иного эффекта через Direct3D будет реализовано подавляющим большинством акселераторов. Плохо, что производители чипов либо очень вяло и медленно лицензируют свои наработки в DirectX, либо этого вообще не происходит. И тогда можно смело похоронить эти наработки и технологии. Пример: S3TC так и никому не была нужной, и уже про нее стали забывать, как наконец S3 удосужилась лицензировать технологию в Direct3D и получить DXTC, а также продать лицензию конкурирующим фирмам: ATI, NVIDIA, 3dfx. И вот мы можем видеть, что ныне S3TC начала пользоваться неплохим спросом.

Возвращаясь к объекту нашего сегодняшнего тестирования, рассмотрим непосредственно видеокарту на базе ATI RADEON.

Плата

Фирма ATI анонсировала сразу несколько видеокарт на базе нового чипа:

- ATI RADEON 64MB DDR VIVO

- ATI RADEON 32MB DDR

- ATI RADEON 32MB SDR

Как видим, навороченность плат уменьшается сверху вниз, как впрочем, и цена на эти карты. Первая плата предназначена для требовательных игроков-"профессионалов", а также людей, желающих извлечь из платы максимум возможностей и комфорта. Вторая плата — для основной массы игроков, представляет собой компромисс между ценой и возможностями. Третья плата — для малобюджетных систем.

К нам попал опытный образец видеокарты самого мощного уровня: RADEON 64MB DDR VIVO:

Плата имеет интерфейс AGP 2x/4x, 64 мегабайта DDR SDRAM памяти, размещенной в 8-ми 64-мегабитных модулях (по 4 на каждой стороне PCB).

На PCB установлен чип-компаньон RAGE THEATER, который отвечает за VIVO (Video In, Video Out):

Чип работает на частоте 183 МГц, на нем приклеен активный кулер. Очень похоже, что эту форму вентилятора фирма ATI разработала сама, так как больше ни на каких видеокартах такие кулеры не встречаются. Память работает на частоте 183 МГц или с результирующей частотой 366 МГц, в дальнейшем мы будем использовать именно результирующие значения частот DDR-памяти.

PCB имеет традиционный для ATI зеленый окрас, на плате размещены также элементы, отвечающие за регулировку питания.

Разгон

К сожалению для российского пользователя, компания ATI не предоставляет никаких возможностей для увеличения частот работы чипсета и памяти. Традиционная утилита PowerStrip в последней версии 2.70.05 уже имеет поддержку ATI RADEON, однако изменять можно только частоту работы памяти. При разгоне до 410 МГц видеокарта работает устойчиво. Разумеется, как и при всяком разгоне, без дополнительного охлаждения в виде вентилятора, обдувающего карту, не обойтись.

Установка и драйверы

Теперь перейдем к практической части нашего обзора.. Для начала представлю конфигурацию испытательных стендов:

- Стенд на базе Pentium III:

- процессор Intel Pentium III 733 MHz:

- системная плата Chaintech 6ATA4 (VIA Apollo Pro 133A);

- оперативная память 256 MB PC133;

- жесткий диск IBM DPTA 20GB;

- операционная система Windows 98 SE;

- Стенд на базе Athlon:

- процессор AMD Athlon 700 MHz;

- системная плата ASUS K7M (AMD750);

- оперативная память 256 MB PC100;

- жесткий диск Quantum FB CR 6.4GB;

- операционная система Windows 98 SE;

На обоих стендах использовались мониторы ViewSonic P810 (21") и NOKIA 447Xav (17").

Все основные испытания и исследования проводились на первом стенде, а второй стенд использовался для демонстрации безупречной работы видеокарты на платформе Athlon. Мы не преследовали цели сравнить платформы между собой.

Установка драйверов происходила по традиционному способу от ATI — через setup. Проблем с установкой не было, в результате мы получили доступ к следующим настройкам:

Direct3D:

OpenGL:

TV-out:

Как можно видеть, содержание настроек не сильно претерпело изменений по сравнению с ATI RAGE FURY PRO, которую мы некогда рассматривали. Поэтому я не стану подробно останавливаться на особенностях драйверов.

Результаты тестов

Начнем с 2D-графики. Прежде всего хочу отметить традиционное для ATI качество изображения и четкость картинки даже в разрешении 1600х1200. Скорость измерялась при помощи WinBench'99 (Graphics WinMark) и представлена в таблице ниже:

| WinBench 99 / Pentium III — 733 MHz 1600x1200x32 | ||||

|---|---|---|---|---|

| NVIDIA GeForce2 GTS | Creative 3D Blaster GeForce256 Annihilator Pro | 3dfx Voodoo5 5500 | ATI RADEON 64MB DDR VIVO | |

| Business Graphics WinMark | 329,0 | 326,0 | 321,0 | 307,0 |

| High-End Graphics WinMark | 909,0 | 907,0 | 896,0 | 812,0 |

Как видим, по скорости ATI RADEON отстает от соперников, однако все равно уровень акселерации двумерной графики настолько высок, что его достаточно для большинства пользователей.

Я еще раз хочу отметить отличное качество изображения и отсутствие "замыливания" на высоких разрешениях (до 1600х1200 включительно).

Для получения результатов тестирования в 3D использовались следующие инструменты:

- id Software Quake3 v.1.16n (OpenGL, demo002, настройки для 16-битного цвета — Fast, для 32-битного — High Quality);

- Rage Expendable (Direct3D, timedemo)

- NVIDIA TreeMark (Grove) (OpenGL, Hardware T&L);

- Interplay MDK2 demo (OpenGL, benchmark, Hardware T&L)

Для проведения сравнительного анализа были использованы данные по видеокартам NVIDIA GeForce2 GTS и 3dfx Voodoo5 5500.

Quake3

В этом тесте помимо традиционных снятий данных по производительности при стандартных режимах, я испытал RADEON в режиме анти-алиасинга, при включенной поддержке S3TC (в том числе и на уровнях S3TC от S3/Diamond Multimedia — demo annihilator), и при максимальных установках на уровне Q3DM9 (demo quaver).

Также приводятся данные, полученные при работе RADEON на разогнанных частотах. И еще: частота работы памяти у NVIDIA GeForce2 GTS довольно легко разгоняется до 366 МГц, то есть до значений частот памяти у RADEON, поэтому я привожу и эти результаты, чтобы можно было при определенной погрешности сравнить чипсеты GeForce2 GTS и RADEON.

Как можно видеть, в 16-битном цвете RADEON сильно отстает от GeForce2 GTS, опережая лишь Voodoo5 5500, зато в 32-битном цвете — это безусловный лидер! Разгон RADEON дает некоторый эффект, но не столь сильный (сказывается разгон только по памяти).

Для оценки работы RADEON в тяжелых условиях была использована demo Quaver, при этом использовались все максимальные установки уровня детализации текстур и геометрии (самое высшее качество):

И здесь картина повторяется: отставание в 16-битном и опережение в 32-битном цвете.

Как известно, при включении S3TC через видеокарту прогоняется меньший объем информации за счет сжатия текстур, что приводит к некоторому росту скорости за счет небольшого ухудшения качества.

Эти результаты еще раз подтвердили это.

Не так давно фирма S3/Diamond Multimedia выпустила несколько специальных уровней для Quake3, использующих технологию S3TC. Демо-бенчмарк Annihilator.dm3 базируется на уровне dmmq3dm5.pk3:

И даже тут RADEON подтвердил свое лидерство в 32-битном цвете. Хотя я должен отметить, что имели место артефакты с непрорисовкой некоторых анимированных текстур, а также отражающих свет объектов.

Любопытно еще было проследить падение в производительности при включении трилинейной и анизотропной фильтраций. Как известно, оба чипа (GeForce2 GTS и RADEON) поддерживают анизотропную фильтрацию. В драйверах от ATI была включен максимум качества по этой фильтрации.

Можно заметить, что при включении анизотропной фильтрации падение в скорости у RADEON несколько заметнее, чем у GeForce2 GTS.

Однако, реализация анизотропной фильтрации у RADEON весьма странная. Ниже, при рассмотрении качества в 3D-графике, я покажу это.

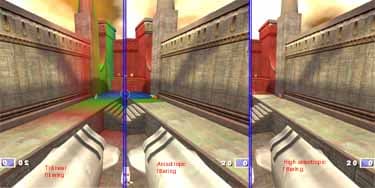

При включении режима анти-алиасинга (он производится по схеме OGSS супер-сэмплинга аналогично тому, как делает это NVIDIA) мы получаем следующее:

ATI называет режим анти-алиасинга с коэффициентом супер-сэмплинга 2х2 — FSAA4. По сути это одно и то же, что и FSAA 2x2 у NVIDIA. Как и следовало ожидать, RADEON оказался на высоте и здесь. Хочу отметить, что при анти-алиасинге требования к пропускной способности памяти еще больше возрастают, поэтому такие результаты неудивительны.

На примере Quake3 я провел и исследование влияния частоты процессора на производительность RADEON (масштабируемость):

Можно видеть, что в разрешениях от 1024х768 и выше частота процессора уже никакого влияния на скорость карты не оказывает. Разумеется, эти данные нельзя обобщать на более низкие частоты процессора, однако, думается мне, что обладатели процессоров с частотам ниже 500-550 МГц просто не купят такую дорогую видеокарту. Я уже говорил неоднократно о том, что нет никакого смысла тратить деньги на супернавороченный акселератор, имея при этом маломощный процессор.

Expendable

Эта игра по результатам тестирования может выдавать не только средние значения FPS, но и минимальные, что является довольно важным моментом. Ведь играбельность в том или ином разрешении как раз определяет минимальный FPS.

Можно видеть, что ситуация, показанная выше, повторяется. Снова отставание от GeForce2 GTS в 16-битном цвете и опережение в 32-битном. Играбельность по минимальному FPS находится на приличном уровне даже в 1280х1024х32.

MDK2

Эта игра через встроенный в нее бенчмарк может показать нам не только производительность видеокарты в OpenGL, но и позволяет сравнить скорость карты при использовании Hardware T&L и без оного.

Сразу бросается в глаза не столько повторение ситуации с отставанием в 16-битном и опережении в 32-битном цветах, а то, что у RADEON Hardware T&L нигде не дает преимущества, по сути он более слабый, чем у GeForce2 GTS. Это уже настораживает, потому как не соответствует обещаниям от ATI. Поэтому посмотрим работу Hardware T&L на примере TreeMark (Grove).

Grove

Этот бенчмарк позволяет проследить зависимость скорости работы карты при полноценном использовании Hardware T&L от сложности сцены и количества источников освещения.

Зависимость от сложности сцены:

Как мы видим, предчувствия неладного с T&L у RADEON оправдались. Геометрический сопроцессор у RADEON уступает по скорости конкуренту.

Зависимость от количества источников света:

Этот график подтверждает предыдущий тезис о слабости Hardware T&L у RADEON, однако видна реализация обещания фирмы, что у RADEON геометрический сопроцессор будет в меньшей степени зависеть от числа источников света. Мы видим, что падение по скорости минимально, и примерно на уровне 10 источников оба графика могут пересечься, так как GPU от NVIDIA уже не справляется с такой нагрузкой и скорость резко падает.

Таким образом, главный вывод по результатам тестирования скоростных параметров видеокарты ATI RADEON состоит в том, что он является на сегодня лидером среди игровых видеокарт в 32-битном цвете. Сильное отставание в 16-битном цвете не столь критично, и вы вскоре поймете почему.

Еще одним неожиданным результатом стала относительная слабость геометрического сопроцессора у RADEON, хотя нам обещалось прямо противоположное. Мне трудно судить, кто виноват: чип или недоотлаженность драйверов.

Качество 3D

Прежде всего я хотел коснуться темы фильтраций. Как известно, при использовании технологии MIP-mapping, то есть разделении всей сцены на уровни с разной детализацией становится очень важным качество фильтрации, сглаживающей границы между мип-уровнями. До недавнего времени все уповали на трилинейную фильтрацию, а анизотропную считали недоступной в виду как сложности ее алгоритма, так и требовательности к производительности, которая снижается при использовании этого вида фильтрации. Эпоха плат на базе NVIDIA GeForce2 GTS нам принесла настоящую полноценную анизотропную фильтрацию:

А что же RADEON? Ведь среди его особенностей есть и поддержка анизотропии. Да, и выше при рассмотрении производительности я говорил об этом. И что мы видим:

Весьма любопытную картину. Фильтрация настолько тщательно отработана, что технология показа мип-уровней через цвета просто не может показать где кончается один и начинается другой уровень. И только вдалеке от пользователя можно уже рассмотреть пару оставшихся уровней. Это дает нам основания говорить о прекрасном качестве исполнения анизотропной фильтрации у ATI RADEON.

Теперь рассмотрим причину, по которой я не хотел акцентировать внимание на отставания по скорости RADEON в 16-битном цвете. Это качество реализации этого режима:

Ну разве такой 16-битный цвет при убогом дизеринге кому-то нужен? Вряд ли. Я думаю, что будущие владельцы RADEON будут играть только в 32-битном цвете, благо карта по своим возможностям это позволяет. Я даже могу предположить, что авторы чипа нарочно не стали улучшать 16-битный цвет, чтобы показать его ненужность на данный момент и приучить пользователей "жить" постоянно в 32-битном цвете.

Однако это еще не худшая картинка. Посмотрите, что получается при включении режима анти-алиасинга в 16-битном цвете (левая часть скриншота):

Тут вообще такое ощущение, что перешли в 256-ти или даже в 16-цветный режим.

А вот в 32-битном цвете при включенном анти-алиасинге уже иная картина:

Вот тут качество уже более-менее приемлемое.

И напоследок хотелось бы отметить, что те огрехи, которые имелись у ATI RAGE FURY PRO в части реализации некоторых функций, приводившие к артефактам, в RADEON полностью исчезли. У меня лично вообще нет никаких нареканий к качеству 3D у RADEON в 32-битном цвете :

Конечно надо иметь в виду, что реализацию S3TC надо еще корректировать в драйверах (я говорил про артефакты при работе с S3TC-уровнями в Quake3). Я надеюсь, что ATI довольно быстро справится с этой задачей.

Дополнительные функции

Как я уже отметил в начале статьи, мультимедийный процессор RAGE THEATER обеспечивает как прием (Video In), так и выдачу на ТВ (Video Out) аналогового сигнала. Я не стану останавливаться на этих особенностях подробно в виду того, что в статье про ATI RAGE FURY PRO VIVO вы сможете все узнать о них. Все настройки и возможности этих функций не претерпели никаких изменений с того времени.

Что касается работы с DVD-Video, то тут есть некоторая сложность. Разумеется, поклонники продукции от ATI знают, что именно карты этой фирмы уже с давних пор наилучшим образом реализуют поддержку DVD. В состав ATI Multimedia Center входит и DVD-плеер, однако я так и не смог заставить его включить аппаратную поддержку со стороны видеокарты, видимо вновь сказывается сырость входящего в коплект программного обеспечения. Утилита DVD-Genie, с помощью которой можно управлять многими программными плеерами DVD, также не смогла ничем помочь. Я мог наблюдать лишь прекрасное качество картинки при довольно высоком проценте загрузки процессора — 75-78%.

Выводы

Через 2.5 месяца после выхода в свет видеокарт на базе NVIDIA GeForce2 GTS, фирма ATI нанесла ответный удар. Ее новое детище со странным названием RADEON бесцеремонно нарушило полновластие продуктов от NVIDIA, и GeForce2 GTS слетел с трона лидера в 3D-графике при 32-битном цвете. Да, это уже можно констатировать. Разумеется, если не будет подтверждения победы продукции ATI в виде правильной ценовой политики и быстрого появления видеокарт на прилавках магазинов (пока плат в продаже нет), то победа останется призрачной, и люди будут по-прежнему покупать более привычные им карты на чипах от NVIDIA. К слову, по неофициальной информации имеющейся у нас, реальные розничные цены на карты на базе RADEON будут существенно ниже объявленных ATI а пресс-релизе от 17 июля. Посмотрим.

Мы можем говорить про RADEON, что он лидер, но с оговорками:

- если производительность 32-мегабайтных карт не будет сильно ниже;

- если цена на 32-мегабайтные платы будет сильно ниже плат на базе NVIDIA GeForce2 GTS, а цена на 64-мегабайтные платы будет приближаться к ценам на GeForce2 GTS;

- если ATI доработает все огрехи в драйверах связанные с реализацией S3TC и др.

При выполнении всех этих условий мы сможем сказать, что конкуренции быть! И больше NVIDIA не пировать безраздельно на рынке видеокарт. У нее появится серьезный и даже где-то более сильный соперник. К сожалению, 3dfx со своей "тупой" политикой потерпела фиаско, и серьезным соперником ее уже назвать можно очень с большой натяжкой.

Плюсы:

- высочайшая на сегодня производительность в 3D при 32-битном цвете;

- поддержка передовых технологий в 3D;

- отличное качество 2D;

- отличное качество в 3D (за исключением S3TC-режима в OpenGL);

- комплектация набором VIVO, дающим пользователям дополнительные возможности по работе с аналоговым сигналом и созданию видеороликов;

Минусы:

- слишком завышенная цена согласно пресс-релизу ATI;

- недоработки в драйверах в части поддержки S3TC в OpenGL;

- медлительность в выходе на рынок видеокарт