Мы буквально на днях подробно рассмотрели новинку от NVIDIA — GPU GeForce3, а также видеокарты на его основе. Посетовав на то, что пока нет никакого программного обеспечения (игр, тестов и даже демонстрационных программ), использующего возможности нового графического процессора, мы исследовали GeForce3 на примерах классического Quake3 (OpenGL) и уже несколько начинающего надоедать 3DMark 2000 (DirectX). В силу вышесказанного, мы все новшества GPU GeForce3 рассмотрели на примерах из DirectX 8.0 SDK.

Следом за анонсом этого чипа и ряда видеокарт на нем от известных производителей компания MadOnion, автор 3DMark 2000, стала потчевать пользователей сладкими обещаниями скорейшего выхода просто суперграндиозного теста 3DMark 2001, использующего все возможности и преимущества DirectX 8.0. MadOnion заставляет любителей красивой 3D-графики просто "глотать слюнки", показав умопомрачительные скриншоты из бета-версии, а также выпустив видеоролик, демонстрирующий работу этой программы в демо-режиме. Однако, сроки выхода этого продукта так и остались тайной, и можно только догадываться о том, что не за горами CeBIT'2001, и анонс 3DMark 2001 может быть приурочен к началу работы этой крупнейшей выставки в компьютерной индустрии. Нам оставалось только ждать и надеяться…

И вот на первые страницы ведущих компьютерных электронных СМИ вышла доселе почти никому неизвестная фирма Vulpine из Германии (Гамбург), которая занимается разработкой 3D Rendering Engines на базе своей технологии Vulpine Vision technology. Фирма достаточно молода, да и работают в ней всего 15 человек, однако она уже довольно успешно ведет свой бизнес. Некоторые компании, занимающиеся разработкой игр, уже приобрели несколько продуктов Vulpine. Тем не менее, фирма не почивает на лаврах и, видимо, желая поднять популярность, объявляет о том, что она выпустила в свет бенчмарк Vulpine GLMark на основе одного из своих движков — The Vulpine Vision Game Engine. Базисом этого движка, как и остальных от Vulpine, является OpenGL. Таким образом, компания как бы в противовес MadOnion 3DMark 2001, рассчитанного на DirectX, выпускает аналог, но под OpenGL. Давайте же посмотрим, сможет ли столь юный продукт составить конкуренцию маститой и проверенной временем MadOnion (в прошлом FutureMark, а еще ранее — группа программистов и художников Future Crew, ставшая очень популярной выпусками нескольких хитовых демо-программ).

Должен отметить, что "изюминкой" GLMark является обещанная полноценная поддержка NVIDIA GeForce3, то есть демонстрация в действии вершинных и пиксельных шейдеров, а также рельефного текстурирования через Dot3 или EMBM (во всех случаях используются соответствующие расширения OpenGL). Вот почему мы решили непременно опробовать новый продукт и посмотреть, с одной стороны, на то, что может дать тестерам Vulpine GLMark, а с другой стороны, посмотреть на полноценную работу GeForce3.

Vulpine GLMark

Начну рассказ о самой программе с того, что на настоящий момент фирма выпустила лишь технологическую версию 1.1 этого продукта, поэтому, если будут иногда возникать ошибки или сбои в работе GLMark, то надо делать скидку на этой факт. Хотя у меня за все время тестирования всего лишь пару раз возникали ошибки, при которых происходил аварийный выход из программы в Windows.

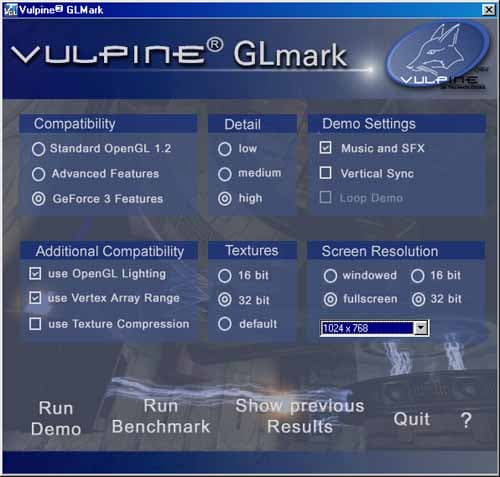

Итак, перед вами основное меню программы. Думаю, что все наглядно и понятно, какие настройки выбирать. Я прокомментирую лишь некоторые.

- GeForce3 (раздел Compatibility) — включение использования ряда уникальных для этого GPU расширений OpenGL (подробностей не сообщается)

- Программа умеет работать с автокомпрессией текстур (как и Quake3), поэтому пункт Use Texture Compression — как раз для активизации этого режима

- Пункт Vertex Array Range не доступен при работе с картами на базе ATI RADEON, из-за принадлежности соответствующего расширения NVIDIA. Будем надеяться, что в дальнейшей версии будет исправлен нынешний некоторый уклон в сторону NVIDIA-карт.

GLMark может сохранять полученные результаты тестов в своей базе, откуда их всегда можно потом посмотреть:

К сожалению, программа сама выбирает папки для сохранения результатов, и подчас получается путаница, т.к. GLMark периодически измеряет частоту работы центрального процессора, и эту частоту вставляет в название папки. А в результаты измерения этой частоты могут вноситься погрешности (например, 1000 МГц может получиться как 999 МГц или 1001 МГц), поэтому результаты по одной и той же видеокарте могут быть внесены в разные папки. К тому же, папки именуются по названию ICD OpenGL драйвера, а не самой видеокарты, поэтому, например, результаты тестирования видеокарт на базе GeForce2 GTS/Pro/Ultra будут размещены в одной папке, несмотря на то, что сами карты разные.

Условия тестирования

Конфигурация тестового стенда:

- процессор Intel Pentium III 1000 MHz:

- системная плата Chaintech 6OJV (i815);

- оперативная память 256 MB PC133;

- жесткий диск IBM DPTA 20GB;

- операционная система Windows 98 SE;

На стенде использовались мониторы ViewSonic P810 (21") и ViewSonic P817 (21").

Мы исследовали NVIDIA GeForce3 на примере видеокарты Leadtek WinFast GeForce3, для ряда сравнений использовались видеокарты Leadtek WinFast GeForce2 Ultra и ATI RADEON 64MB DDR (183MHz). Для карт на чипах от NVIDIA использовались драйверы версии 10.70, а для RADEON — драйверы версии 7.078 от ATI.

Результаты тестирования

Начнем мы с исследования общей производительности в High Detail режиме.

Сразу в глаза бросается, что абсолютные значения FPS довольно низкие. Это и неудивительно, так как сложность сцен чрезвычайно высока, особенно в таком режиме. Ниже мы приведем скриншоты, и вы сами убедитесь в этом. Результаты в целом повторяют картину, которую мы наблюдали в нашем первом обзоре GeForce3: падение производительности у этого GPU при переходе с 16 на 32-битный цвет ничтожно, а в 16-битном цвете имеется незначительное отставание от GeForce2 Ultra. Результаты видеокарты ATI RADEON 64MB DDR я привел потому, что это пока единственная карта, кроме NVIDIA GeForce3, поддерживающая ряд новшеств в области визуализации, в том числе и всевозможные виды рельефного текстурирования (bump mapping), поэтому эта карта будет принимать участие в дальнейшем исследовании. О результатах производительности RADEON лучше умолчать, так как это печальное зрелище (причины кроются не столько в возможностях самого RADEON, а в некорректной поддержке GLMark-ом ICD OpenGL от ATI).

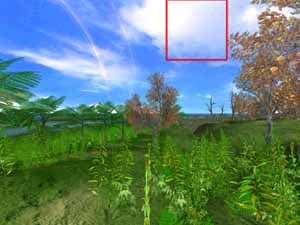

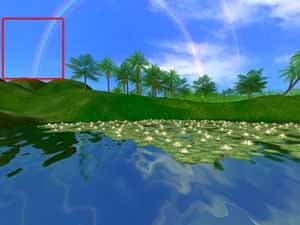

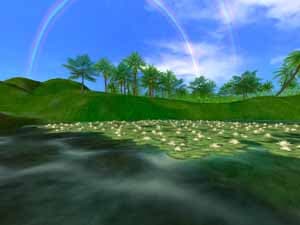

Что же означают эти пункты: Low, Medium и High Details? Давайте посмотрим на скриншоты, где слева представлен режим Low Details, а справа — Medium:

Ниже представлен High Details режим:

Наглядно видно, что режимы отличаются друг от друга насыщенностью объектов в сцене, что очень похоже на 3DMark 2000, где сложности сцен разделяются аналогично. Интересно, насколько сильно влияет сложность сцены на производительность в этом тесте?

Да, можно сказать, что результаты впечатляют. Обе карты, на базе GeForce3 и GeForce2 Ultra, показали резкие скачки в производительности при уменьшении числа объектов в сцене. К сожалению, мы не знаем, сколько полигонов в сцене при том или ином уровне сложности, поэтому судить о зависимости GPU от числа полигонов на примере GLMark невозможно. Просто надо иметь в виду, что эти три уровня дают нам представление о трех градациях сложности будущих и существующих игр. Если посмотреть на скриншоты ниже, то можно понять, что High Detail — это уровень будущих и даже далеко будущих игр.

На тех же диаграммах, что приведены в начале анализа производительности, можно видеть, каков аппетит у эффекта сглаживания, или анти-алиасинга. Мы уже говорили о новом виде АА, который называется Quincunx и поддерживается GeForce3. Режим Quincunx обеспечивает прекрасный компромисс между качеством и умеренным уровнем снижения производительности (читай скорости).

Ниже для сравнения я приведу фрагмент с включенным АА 4х (2х2).

Как говорится в одной рекламе по телевидению: "Если качество одно и то же, то зачем платить больше?" Так и здесь: визуальных различий по качеству между наиболее сильным режимом АА 4х и Quincunx практически нет, а величина падения скорости при использовании первого метода существенно выше.

Далее мы посмотрим, как работает анизотропная фильтрация на GeForce3, и что она дает в GLMark. Сразу обращаю внимание на то, что все последующие тесты, по понятным причинам, проводились только в 32-битном цвете (уже нет смысла столь мощные акселераторы гонять в 16-битном цвете).

Только прошу сразу не расстраиваться таким падением производительности при активизации анизотропии, особенно самой тяжелой, которая образуется при выборке 32-х текстурных сэмплов. Давайте посмотрим, что же на практике дает та или иная фильтрация:

Начнем с 8-точечной анизотропии:

Теперь посмотрим, что дает 16-точечная анизотропия:

И, наконец, 32-точечная анизотропия:

Прекрасно видно, что только на ровной, уходящей далеко вдаль поверхности (например, пол) можно различать эти виды фильтраций, а в подавляющем числе случаев этого просто невидно. И мы снова вспомним о "А зачем платить больше?". Действительно, я полагаю, что в большинстве игр и 8-сэмпловой анизотропной фильтрации будет вполне достаточно, ну, или можно при желании где-то включить 16-точечную.

Перед тем, как перейти к анализу качества изображения, обеспечиваемого всеми тремя картами, принимающими участие в данном тестировании, уделим внимание технологии S3TC. Как я уже отметил выше, GLMark осуществляет автокомпрессию текстур при активизации S3TC. На примере Quake3 мы все помним, какими огрехами в этом случае страдают карты на чипах GeForce в 32-битном цвете. Посмотрим, что происходит в GLMark:

Первый пример:

Второй пример:

Нетрудно убедиться, что некоторые огрехи имеются и в данном случае, однако не надо забывать и про то, что сама технология S3TC предусматривает некоторую потерю в качестве при ее использовании. Потери в качестве будут минимальными и применение S3TC принесет дивиденды, если в игре используются специально изготовленные и заранее скомпрессированные текстуры. Что касается данного случая, то по самой первой диаграмме видно, что включение S3TC в GLMark дает очень мало:

Возможности и качество

В этом разделе мы просто наглядно покажем, на что способны все три видеокарты, которые мы исследуем в данном материале, прежде всего, конечно — NVIDIA GeForce3.

Первый пример рельефного текстурирования (EMBM)

ATI RADEON NVIDIA GeForce2 Ultra

Второй пример рельефного текстурирования (EMBM)

ATI RADEON NVIDIA GeForce2 Ultra

Очень хорошо видно, как отлично реализован EMBM в GLMark, и как эту технологию прекрасно поддерживает NVIDIA GeForce3. То, что GeForce2 этого просто не умеет, тоже хорошо известно. Поэтому ничего удивительного в такой мрачной воде, которую мы видим на этой карте, нет. А вот почему RADEON не смог реализовать свой потенциал — непонятно. Вроде все полагающиеся расширения в его драйвере имеются. Причины может быть две:

- Виноваты драйверы RADEON, которые не реализовали заложенный потенциал (мы такое уже видели одно время на примере S3TC-технологии);

- Виноват сам GLMark, который использование EMBM заложил только в раздел для GeForce3.

Но эти примеры не единичны. Вот еще, и тоже с водой:

ATI RADEON NVIDIA GeForce2 Ultra

И снова мы видим, что вода на GeForce3 выглядит более реалистично. И вообще, на RADEON есть явные проблемы с воспроизводством эффектов освещения (впрочем, и NVIDIA GeForce2 Ultra не смогла достичь уровня GeForce3):

Первый пример

ATI RADEON NVIDIA GeForce2 Ultra

Второй пример

ATI RADEON NVIDIA GeForce2 Ultra

Выводы

Подведем итоги. Они довольно краткие и в тоже время емкие:

- Новый бенчмарк Vulpine GLMark удался. Это действительно хороший продукт, несмотря на ряд минусов, которые можно списать на неокончательную версию программы. GLMark может дать тестерам прекрасный материал для анализа, а также служить великолепной демо-программой, которая показывает высокий уровень мастерства дизайнеров и программистов. К сожалению, некоторый уклон в сторону NVIDIA-чипсетов портит в целом впечатление.

- NVIDIA GeForce3 продемонстрировала блестящее качество, а вот производительность не на столь высоком уровне, впрочем, как и у всех остальных рассмотренных нами карт. Безусловно, GeForce3 — это однозначный лидер, на видеокартах такого уровня можно играть в игры с очень высокой сложностью сцен при хорошей играбельности в популярных разрешениях.

- Некоторые неясности с ATI RADEON можно объяснить приведенными чуть выше причинами, поэтому мы надеемся на будущие версии GLMark, а также на соответствующие корректировки в нем в целях полноценной поддержки не только NVIDIA-карт.