erid: 2VtzqwGo5Ys

В последние годы тема гиперконвергентных систем – полностью программно‑определяемой инфраструктуры, включающей виртуализацию, хранилища и сети, – привлекает всё больше внимания компаний из различных отраслей.

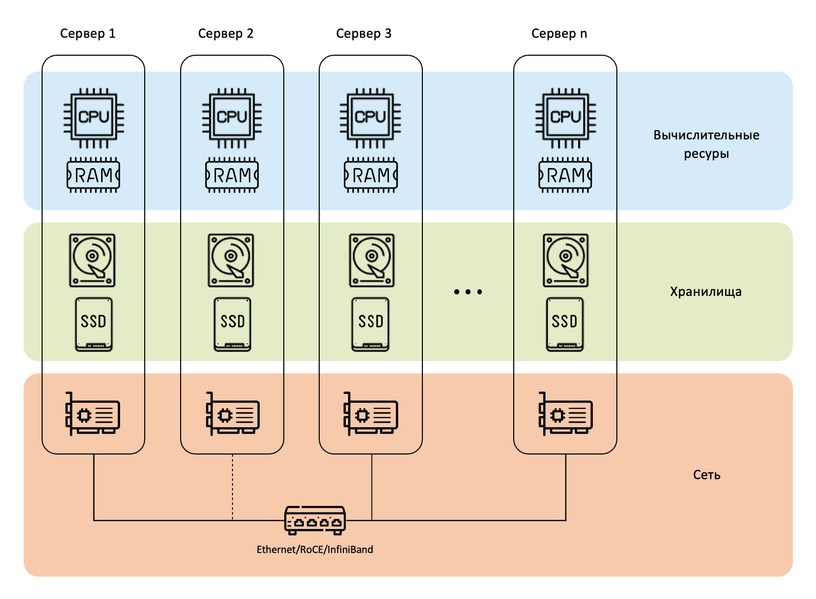

Гиперконвергентная инфраструктура – это инфраструктура, в которой вычислительные ресурсы серверов и устройств хранения данных объединены на программном уровне. При таком способе представления инфраструктуры в качестве аппаратной платформы используются только серверы стандартной архитектуры, что позволяет создать инфраструктуру любого масштаба для решения любых ИТ-задач.

Изначально многие компании развертывали инфраструктуру на базе систем виртуализации, в основном, продуктов компаний VMware и Microsoft, ставших де‑факто стандартом в области виртуализации. Но с недавнего времени отечественным компаниям приходится искать замену системам этих и других зарубежных производителей ПО, покинувших российский рынок.

Замена системного программного обеспечения – процесс сложный и ресурсоемкий, а помочь на этом пути могут гиперконвергентные решения. Примером такого решения является «Кибер Инфраструктура» от российской компании «Киберпротект».

Введение в гиперконвергентную инфраструктуру

В основе гиперконвергентной инфраструктуры лежит очень простая идея: берутся серверы (они могут быть от разных производителей, разной конфигурации), объединяются сетевыми интерфейсами, и на серверы, как на «голое железо», устанавливается программное обеспечение, которое объединяет их в кластер – надежный, производительный и отказоустойчивый. Все ресурсы, которые есть у этих серверов: вычислительные мощности, память и хранилища – объединяются в единый пул. Ресурсы из этого пула не закреплены за определенными устройствами, являются общими для всего кластера и предоставляются по требованию для решения тех или иных задач. В результате такого подхода ресурсы используются гораздо эффективнее, а сама система обладает большей надежностью и производительностью.

«Кибер Инфраструктура» основана на ОС семейства Linux и может быть установлена как на «голое железо», так и внутрь виртуальных машин (с некоторыми ограничениями). Единый кластер объединенных серверов легко масштабируется путем добавления узлов или отдельных дисков. Управление всем кластером осуществляется из единой веб‑консоли или через интерфейс командной строки.

Остановимся чуть более подробно на ключевых возможностях «Кибер Инфраструктуры»: масштабируемости, областях отказа и обеспечении сохранности данных.

Ключевые возможности «Кибер Инфраструктуры»

Масштабируемость

В «Кибер Инфраструктуре» существует несколько вариантов масштабирования кластера. Если нужен больший объем хранимых данных, просто добавляются диски и происходит горизонтальное масштабирование. Для повышения производительности используются более быстрые диски, добавляется память и так далее – это тоже вариант горизонтального масштабирования.

Также можно просто добавить дополнительные узлы в существующий кластер и при этом будет достигаться выигрыш и в объеме хранения, и в производительности, поскольку внутри узлов есть и ресурсы хранения, и ресурсы вычисления, и они будут доступны в общем пуле ресурсов.

Помимо этого, можно добавлять серверы, в которых нет локальных дисков, и тогда будет увеличиваться только производительность системы – в первую очередь это касается работы системы виртуализации. Или, например, можно добавить серверы, к которым подсоединены сотни дисков, для того чтобы существенно увеличить объем хранимой информации.

Области отказа

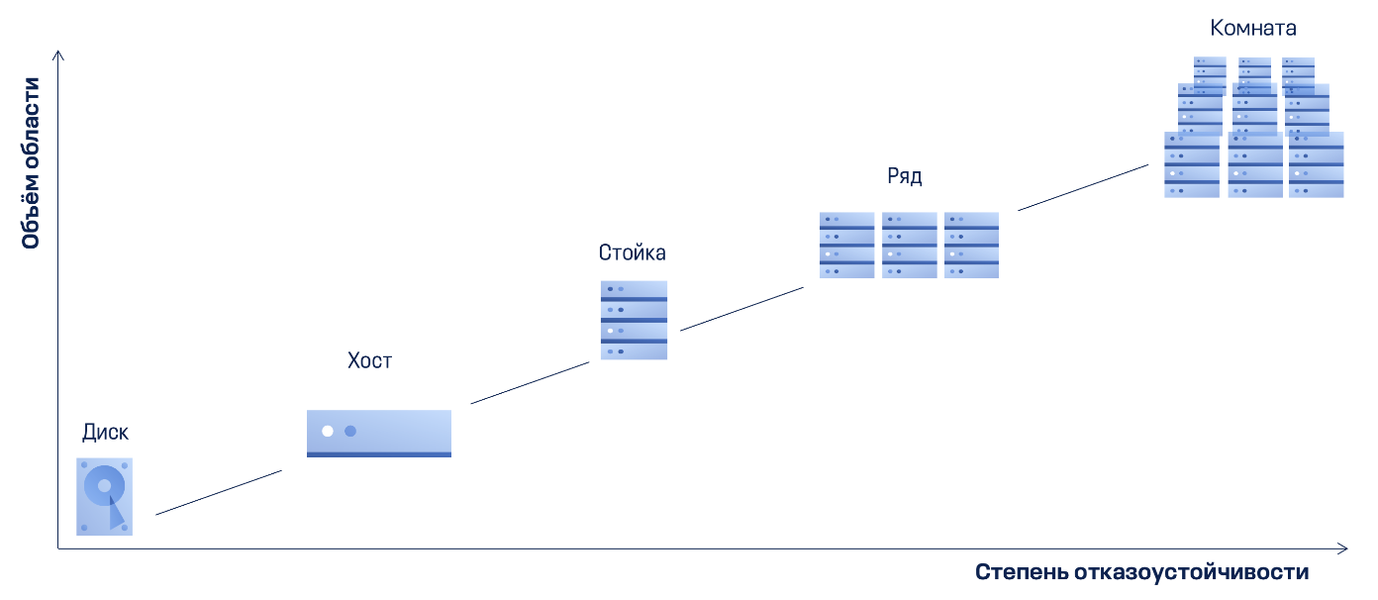

Высокая доступность системы обеспечивается за счет гибких настроек, среди которых можно выделить области отказа. Это те элементы системы, которые могут выйти из строя без потери данных и утраты системой работоспособности.

В качестве зоны отказа может быть выбран диск, хост, сервер или даже целая стойка. В этом случае данные распределяются между остальными компонентами того же уровня: дисками, серверами и т. д. Таким образом, выход из строя одного компонента не приведет к отказу всей системы.

Очевидно, что чем больше узлов в кластере, тем надежнее инфраструктура, тем выше степень избыточности и тем эффективнее можно настроить систему. При замене неисправного узла на исправный запускается встроенный в продукт механизм восстановления потерянных данных: данные перераспределяются по узлам, изменяется балансировка нагрузки, сама система при этом продолжает работать.

Обеспечение сохранности данных

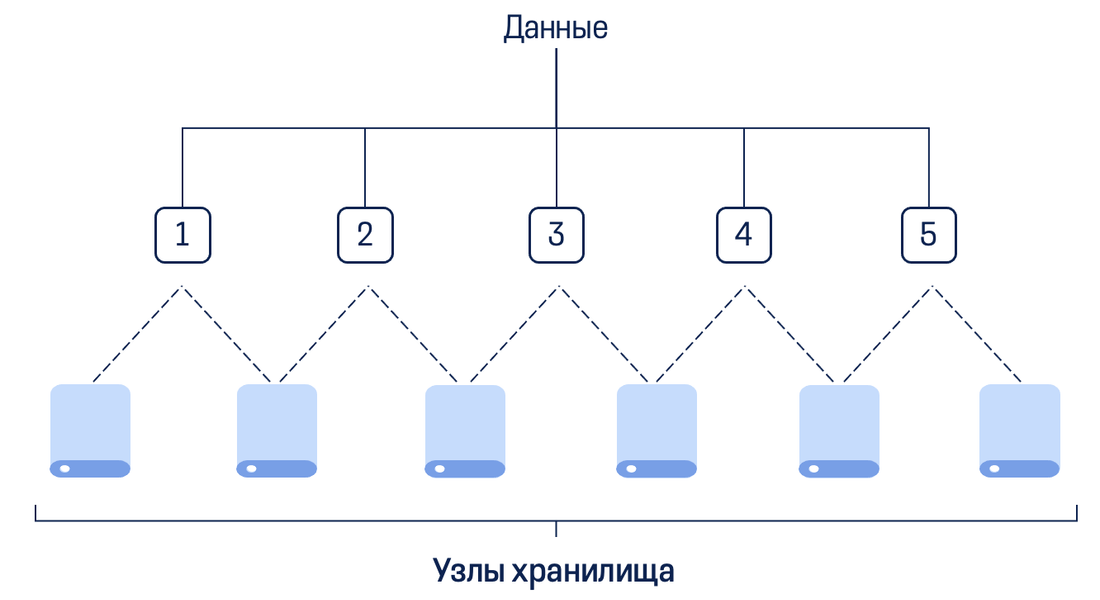

Сохранность данных в программно-определяемом хранилище обеспечивается двумя механизмами: репликацией и избыточным кодированием.

Репликация – это механизм деления потоков данных на отдельные блоки, каждый из которых сохраняется в два или три места. Таким образом, мы говорим о двух или трех репликах или избыточности в 100 или 200 процентов. Такой подход хорошо работает на «горячих» данных, например, для виртуальных машин или в нагрузках со случайным доступом.

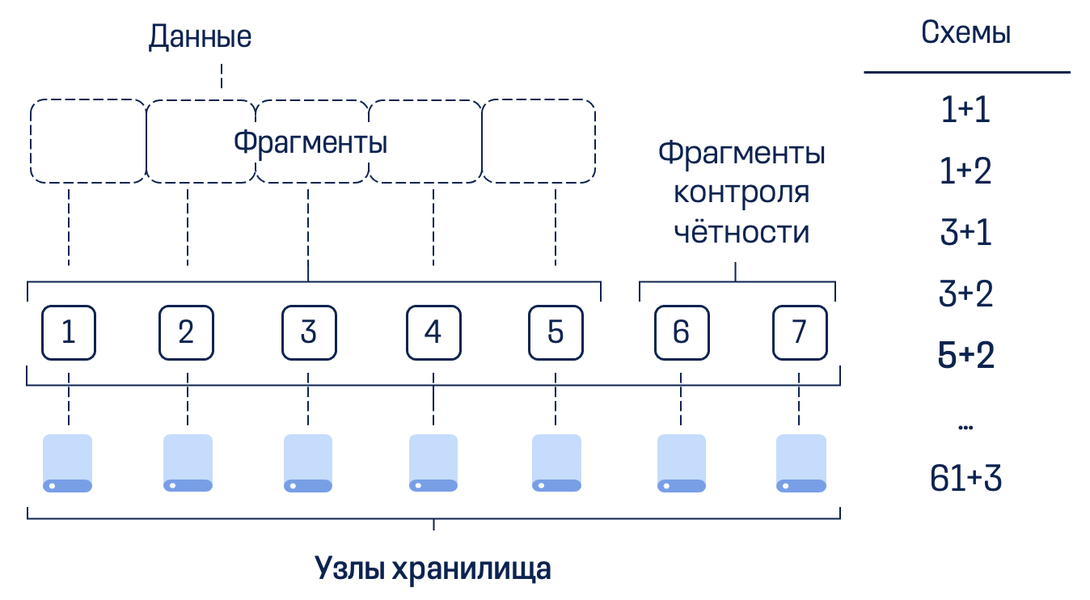

Избыточное кодирование – это механизм деления потоков данных на отдельные блоки по определенной схеме избыточности, например «5+2». В этом случае поток делится на 5 блоков, к ним рассчитываются 2 блока четности и итоговые 7 блоков распределяются по узлам кластера, каждый – на отдельном узле. Таким образом, при выходе из строя до двух хостов, потери данных не происходит, доступ к ним сохраняется. В случае потери хоста выполняется процедура самовосстановления, блоки пересчитываются и распределяются по оставшимся узлам.

В продукте поддерживаются различные схемы избыточности. Чем больше число фрагментов, тем выше производительность и надежность в сценариях с большими нагрузками, например, при резервном копировании, хранении видеоархивов, документообороте и т. п.

Ключевые сценарии использования «Кибер Инфраструктуры»

Перечислим основные сценарии, в которых может использоваться «Кибер Инфраструктура»:

- Хранение данных, в том числе резервных копий

- Виртуализация

- Виртуальные рабочие места (VDI)

Теперь рассмотрим эти сценарии более подробно.

Хранение данных

«Кибер Инфраструктура» позволяет создавать различные виды хранилищ с доступом по протоколам NFS, iSCSI и S3, в том числе специализированные хранилища резервных копий для других продуктов «Киберпротекта» – «Кибер Бэкапа» и «Кибер Бэкапа Облачного».

Хранилище «Кибер Инфраструктуры» обладает высокой масштабируемостью. В рамках одного кластера возможно масштабирование до десятков петабайтов, а линейное масштабирование по производительности достигается путем добавления новых узлов. В сценариях виртуализации программно-определяемое хранилище используется для размещения виртуальных машин. Ниже рассмотрим использование различных видов хранилищ более подробно.

Шлюз резервного копирования

Системы резервного копирования «Кибер Бэкап» и «Кибер Бэкап Облачный» в рамках задач резервного копирования и репликации передают резервные копии в шлюз. Задача шлюза – принять резервные копии на стороне гиперконвергентной инфраструктуры. Дальнейшие действия зависят от сценариев хранения резервных копий. Это может быть:

- Репликация в другой ЦОД.

- Постоянное хранение внутри локального кластера.

- Промежуточное хранение с последующей передачей во внешние хранилища:

- передача в S3-совместимое хранилище;

- передача в файловые хранилища по протоколу NFS, в том числе на СХД и NAS.

Сценарий передачи резервных копий в публичное облако по протоколу S3 достаточно популярен, так как позволяет использовать недорогое хранилище вне контура компании и при этом иметь приемлемую скорость резервного копирования. Как это работает? На уровне программно-определяемого хранилища обеспечивается объем данных, необходимый для хранения резервных копий, создаваемых за один или два дня. Эти данные очень быстро передаются системой резервного копирования. Затем, уже в фоне, шлюз резервного копирования переносит их в публичное S3-хранилище по более медленным каналам. Таким образом, заказчик получает быстрое резервное копирование и недорогое хранилище в публичном S3-облаке.

Блочное хранилище iSCSI

Хранилище «горячих» данных, подключаемое по протоколу iSCSI, подходит для обеспечения работы различных систем виртуализации, баз данных и транзакционных систем. Обмен данными с хранилищем происходит очень быстро за счет обеспечения высокой скорости чтения и записи. Для увеличения скорости можно использовать дополнительные средства, например, RDMA, которые работают поверх InfiniBand. Это позволит существенно снизить или даже полностью исключить задержки при обмене данными и разгрузить центральный процессор.

Объектное хранилище S3

Объектное хранилище, доступное по протоколу S3, поддерживает S3-подобный API и совместимо с большинством готовых приложений S3. Объектные, неструктурированные данные могут храниться в программно-определяемом хранилище «Кибер Инфраструктуры», а доступ к ним возможен по протоколу S3 из приложений, которые поддерживают этот протокол: Open-Xchange и других. Объектное хранилище может использоваться в качестве локального или удаленного, настраиваемого гибридного хранилища по модели STaaS, а также совместно с сервисом защищенного файлового обмена и совместной работы «Кибер Файлы». Для S3-хранилищ поддерживается асинхронная репликация в другой, географически распределенный кластер «Кибер Инфраструктуры» в режиме active-active, когда оба узла являются активными.

Файловое хранилище NFS

Для хранения любых типов корпоративных данных можно использовать файловое хранилище с доступом по протоколу NFS. Оно построено на базе объектного хранилища, может масштабироваться до миллиардов сущностей и обладает очень высокой производительностью. В таком хранилище обеспечивается возможность гибкого управления правами доступа к файлам и папкам, поддерживаются современные версии стандартов NFS – 4-я и старше. Файловое хранилище подходит для сценариев реализации файлового обмена, веб-хостинга и создания организованного файлового архива.

Виртуализация

«Кибер Инфраструктура» может использоваться как платформа виртуализации: в продукте есть встроенный гипервизор на базе KVM, переработанный и улучшенный с точки зрения производительности и работы в высоконагруженных системах. В качестве гостевых операционных систем могут выступать ОС семейства Windows, а также российские и зарубежные дистрибутивы Linux.

Продукт обладает всеми основными свойствами и функциями, которые должны быть у современной системы виртуализации. Поддерживается весь жизненный цикл виртуальных машин, создание ВМ из образов и шаблонов, включение-выключение и перенос машин между узлами.

Также существует возможность делать аппаратные снимки для резервного копирования машин или создания в дальнейшем образов ВМ. Таким образом, в продукте реализованы основные функции виртуализации, плюс есть еще некоторые дополнительные возможности, которыми обладает не каждая система виртуализации. Например, можно задать правила и политики хранения виртуальных машин. Если от виртуальной машины требуется высокая производительность, то ее можно расположить на определенном уровне хранения, т. е. задать в настройках этой ВМ, чтобы она хранилась и работала на самых быстрых SSD-дисках. В дальнейшем при миграции между узлами сети данные конкретной виртуальной машины будут располагаться на определенном уровне хранения.

Система виртуализации обеспечивает высокую степень доступности виртуальных машин, то есть при выходе из строя узла сервера, на котором находится ВМ, она будет автоматически эвакуирована на другой узел. За это отвечает специальный сервис, демон, который отслеживает состояние работы узла.

Для переноса виртуальных машин между узлами существуют различные режимы: «холодная» миграция и «горячая». После миграции можно указать, что будет с машиной: либо она будет автоматически перезапущена, либо будет находиться в выключенном состоянии. Всё это можно достаточно просто и гибко настраивать.

В продукте поддерживается механизм создания моментальных снимков ВМ, для чего используются нативные интерфейсы, также есть возможность делать снапшоты приложений и создавать несколько точек восстановления для виртуальных машин. Моментальные снимки могут быть использованы для создания образов, из которых потом будут созданы другие виртуальные машины.

Виртуальные рабочие места (VDI)

Новинкой в версии 5.5 является поддержка виртуальных рабочих мест (VDI). «Кибер VDI» – это ИТ-инфраструктура, позволяющая получать доступ к корпоративным компьютерным системам, серверам, файлам, приложениям и службам с любого разрешенного устройства через защищенный клиент для рабочего стола или браузер. Благодаря «Кибер VDI» сотрудники могут использовать корпоративные приложения и данные на своих устройствах без риска их смешения с личными приложениями и данными. Рабочими местами сотрудников при этом централизованно управляет администратор. Ниже перечислены основные преимущества использования «Кибер VDI».

- Безопасность. Администратор может использовать различные политики доступа (например, запрет копирования данных на внешние носители, запрет на выполнение опасных действий или запуск постороннего ПО).

- Централизованное управление. Использование «Кибер VDI» устраняет необходимость в настройке каждой системы вручную и обеспечивает быструю подготовку рабочих столов.

- Экономия. Процессы в основном выполняются на сервере – нет необходимости в дорогостоящем или новейшем оборудовании. Кроме того, «Кибер VDI» помогает сократить затраты на лицензирование, обновление и обслуживание оборудования, а также на приобретение устройств, выдаваемых сотрудникам в пользование.

- Конфиденциальность. «Кибер VDI» обеспечивает изоляцию пользователей друг от друга.

- Гибкость. «Кибер VDI» позволяет администраторам легко настраивать параметры сети, добавлять новых сотрудников и обновлять программное обеспечение из центрального расположения.

Отметим преимущества «Кибер VDI» перед другими системами виртуальных рабочих столов:

- Интеграция с «Кибер Инфраструктурой» позволяет развертывать «Кибер VDI» в режиме отказоустойчивого кластера.

- Готовые образы и автоматические скрипты обеспечивают удобство и простоту развертывания и обновления системы.

«Кибер VDI» поддерживается в системах Linux с версией ядра от 3.0 до 6.2 и glibc версии 2.3.4 или более поздней, включая следующие дистрибутивы x86 и x86-64: Astra Linux «Смоленск» 1.7.0–1.7.3, «Альт Сервер» 10, «Альт Рабочая станция» 10 и «РЕД ОС» 7.3.

В начале обзора мы упомянули веб-консоль как инструмент управления всей инфраструктурой. Давайте здесь более подробно остановимся на возможностях продукта в области управления и мониторинга.

Управление и мониторинг

Централизованное управление

Управление инфраструктурой осуществляется различными способами в зависимости от задачи: через веб-консоль, командную строку vinfra или OpenStack, программный интерфейс OpenStack API. Веб-консоль – это основной визуальный интерфейс управления вычислительным кластером и кластером хранилища. Также через веб-консоль доступно управление серверами, сетями, пользователями, самообслуживанием и безопасностью. Интерфейс командной строки – vinfra CLI – служит для управления кластером хранилища и вычислительным кластером, поддерживает единый синтаксис и выходной формат команд. Интерфейс командной строки включает расширенный набор операций и поддерживает их автоматизацию с помощью JSON-совместимых утилит. И наконец, в состав продукта входит OpenStack API – программный интерфейс управления вычислительным кластером. Использование OpenStack API позволяет реализовать простую интеграцию с внешними приложениями и системами распределения ресурсов.

Мониторинг

Подсистема мониторинга служит для отслеживания работоспособности инфраструктуры и ее компонентов и включает автоматизированный сбор метрик со всех компонентов системы: серверов, дисков, сети, хранилищ и вычислительных служб.

«Кибер Инфраструктура» позволяет просматривать все сведения о серверах, дисках, сети, задержке, производительности, хранилище и вычислительных службах, а также управлять пороговыми значениями для оповещений.

Мониторинг с помощью внешнего веб-приложения Grafana включает готовые подробные диаграммы для кластеров, серверов и хранилищ. Имеется возможность создания собственных панелей мониторинга и диаграмм.

Аппаратные требования

Как мы отметили выше, «Кибер Инфраструктуру» можно развернуть на стандартном серверном оборудовании x86. Системные требования зависят от выбранного сценария развертывания.

| Сценарий | Минимальные требования | Рекомендованные требования |

|---|---|---|

| Только кластеры хранения или хранение + управление |

|

|

| Хранение + вычисления или только вычисления |

|

|

| Хранение + вычисления + управление |

|

|

Здесь мы приводим усредненные требования. Более подробную информацию можно найти в руководстве администратора по «Кибер Инфраструктуре».

Лицензирование

«Кибер Инфраструктура» подходит для любой бизнес-модели благодаря прозрачному ценообразованию и гибкому лицензированию. Модель лицензирования включает бессрочную лицензию на продукт и сертификат на техническую поддержку сроком на 1 год с возможностью продления.

Программно-определяемое хранилище лицензируется по полезному объему пакетами от 10 до 1000 ТБ. Программно-определяемые вычисления лицензируются по числу сокетов (CPU): доступны пакеты от 1 до 50 CPU. Виртуализация не лицензируется отдельно от хранилища, тогда как хранилище может использоваться без виртуализации.

А еще «Киберпротект» приглашает желающих на презентацию новой версии «Кибер Инфраструктуры» 25 апреля. Эксперты компании расскажут о ключевых возможностях, продемонстрируют новые функции и улучшения в продукте и ответят на вопросы участников вебинара.

Реклама. ООО "Киберпротект" ИНН 9715274292