Содержание

- Часть 1 — Теория и архитектура

- Часть 2 — Практическое знакомство

- Часть 3 — Результаты игровых тестов и выводы

Представляем базовый детальный материал с исследованием Nvidia Geforce GTX Titan X.

Справочные материалы

Объект исследования: Ускоритель трехмерной графики (видеокарта) Nvidia Geforce GTX Titan X 12288 МБ 384-битной GDDR5 PCI-E

Сведения о разработчике: Компания Nvidia Corporation (торговая марка Nvidia) основана в 1993 году в США. Штаб-квартира в Санта-Кларе (Калифорния). Разрабатывает графические процессоры, технологии. До 1999 года основной маркой была Riva (Riva 128/TNT/TNT2), с 1999 года и по настоящее время — Geforce. В 2000 году были приобретены активы 3dfx Interactive, после чего торговые марки 3dfx/Voodoo перешли к Nvidia. Своего производства нет. Общая численность сотрудников (включая региональные офисы) около 5000 человек.

Часть 1: Теория и архитектура

Как вы уже знаете, ещё в середине прошлого месяца компания Nvidia выпустила новую топовую видеокарту под названием Geforce GTX Titan X, которая стала мощнейшей на рынке. У нас сразу же вышел подробный обзор по этой новинке, но он содержал лишь практические исследования, без теоретической части и синтетических тестов. Так получилось из-за разных обстоятельств, в том числе от нас не зависящих. Но сегодня мы исправляем этот недочёт и очень подробно рассмотрим мартовскую новинку — за месяц не произошло ничего такого, чтобы она потеряла актуальность.

Ещё в далёком 2013 году Nvidia выпустила первое решение новой марки видеокарт Geforce GTX Titan, названного по имени суперкомпьютера в Окриджской национальной лаборатории. Первая модель новой линейки установила новые рекорды, как по производительности, так и по цене — рекомендованная цена для рынка США была установлена в $999. Это была первая элитная видеокарта серии Titan, которая затем продолжилась не самой популярной двухчиповой Titan Z и ускоренной Titan Black, получившей полностью разблокированный графический процессор GK110 ревизии B.

И вот весной 2015 года настало время для ещё одной новинки Nvidia из «титановой» премиальной серии. Впервые GTX Titan X была показана президентом компании Дженсеном Хуангом на игровой конференции для разработчиков GDC 2015 на мероприятии по игровому движку Epic Unreal Engine. По сути, эта видеокарта в любом случае незримо участвовала на шоу, будучи установленной во многие демостенды, но Дженсен представил её официально.

До выхода Geforce GTX Titan X, быстрейшей одночиповой видеокартой являлась Geforce GTX 980, основанная на чипе GM204 той же графической архитектуры Maxwell, представленном в сентябре прошлого года. Эта модель является весьма энергоэффективной, обеспечивая приличную вычислительную мощь при потреблении всего лишь 165 Вт энергии — то есть, она вдвое более энергоэффективна по сравнению с предыдущим поколением Geforce.

При этом GPU архитектуры Maxwell поддерживают грядущий DirectX 12 (включая Feature Level 12.1) и другие новейшие графические технологии компании: имитацию глобального освещения Nvidia Voxel Global Illumination (VXGI, о нёй мы писали в статье по GTX 980), новый метод сглаживания Multi-Frame sampled AA (MFAA), динамическое повышенное разрешение Dynamic Super Resolution (DSR) и др. Сочетание производительности, энергоэффективности и возможностей сделало чип GM204 самым лучшим продвинутым графическим процессором на момент его выхода.

Но всё когда-то меняется, и на замену GPU с 2048 вычислительными ядрами и 128 текстурными модулями пришёл новый графический процессор на основе этой же архитектуры Maxwell второго поколения (первое мы помним по чипу GM107, на котором основана видеокарта Geforce GTX 750 Ti) и теми же возможностями, но уже с 3072 вычислительными ядрами CUDA и 192 текстурными блоками — всё это упаковали уже в 8 миллиардов транзисторов. Понятное дело, Geforce GTX Titan X сразу же стал самым мощным решением.

На самом деле, топовый чип второго поколения Maxwell, который мы теперь знаем под кодовым именем GM200, был готов у Nvidia ещё какое-то время до его анонса. Просто не было особого смысла выпускать ещё одну топовую модель видеокарты, когда даже Geforce GTX 980 на основе GM204 прекрасно справлялась с задачей быстрейшей одночиповой видеокарты в мире. Компания Nvidia какое-то время ждала выхода более мощного решения от AMD на базе GPU, произведённого по тому же 28 нм техпроцессу, но так и не дождалась.

Вероятно, чтобы продукт совсем не «прокис» в отсутствие реальной конкуренции, его всё же решили выпустить, закрепив за собой звание компании, выпускающей самые мощные GPU. И действительно, ждать решения соперника смысла не было, ведь его отложили как минимум до июня — столько времени ждать просто невыгодно. Ну а в случае чего, всегда можно выпустить ещё более мощную видеокарту на основе этого же графического процессора, но работающего на более высокой частоте.

Но зачем вообще нужны столь мощные решения в эпоху распространения мультиплатформенных игр с довольно средними требованиями к мощности GPU? Во-первых, совсем скоро должны появиться первые игровые приложения, использующие возможности DirectX 12, пусть даже и мультиплатформенные — ведь ПК-версии таких приложений практически всегда предлагают более качественную графику, дополнительные эффекты и текстуры более высокого разрешения. Во-вторых, уже сейчас вышли DirectX 11 игры, которые могут использовать все возможности мощнейших GPU — вроде Grand Theft Auto V, про которую мы подробнее расскажем ниже.

Важно, что графические решения архитектуры Maxwell от Nvidia полностью поддерживают так называемый уровень возможностей Feature Level 12.1 из DirectX 12 — максимальный из известных на данный момент. Компания Nvidia уже давно предоставляла игровым разработчикам драйверы с поддержкой будущей версии DirectX, а теперь они стали доступны и пользователям, установившим Microsoft Windows 10 Technical Preview. Неудивительно, что именно видеокарты Geforce GTX Titan X использовались для демонстрации возможностей DirectX 12 на игровой конференции разработчиков Game Developers Conference, где модель и была впервые показана.

Так как рассматриваемая модель видеокарты от компании Nvidia основана на топовом графическом процессоре архитектуры «Maxwell» второго поколения, которую мы уже рассматривали и которая в деталях схожа с предыдущей архитектурой «Kepler», то перед прочтением данного материала полезно ознакомиться с более ранними статьями о видеокартах компании Nvidia:

- [10.10.14] Nvidia Geforce GTX 970 — Неплохая замена GTX 770

- [19.09.14] Nvidia Geforce GTX 980 — Последователь Geforce GTX 680, обгоняющий даже GTX 780 Ti

- [12.03.14] Nvidia Geforce GTX 750 Ti — Maxwell начинает с малого... несмотря на Maxwell

- [22.03.12] Nvidia Geforce GTX 680 — новый однопроцессорный лидер 3D-графики

Итак, давайте рассмотрим подробные характеристики видеоплаты Geforce GTX Titan X, основанной на графическом процессоре GM200.

| Графический ускоритель Geforce GTX Titan X | |

|---|---|

| Параметр | Значение |

| Кодовое имя чипа | GM200 |

| Технология производства | 28 нм |

| Количество транзисторов | около 8 млрд. |

| Площадь ядра | около 600 мм2 |

| Архитектура | Унифицированная, с массивом общих процессоров для потоковой обработки многочисленных видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12, с поддержкой уровня возможностей Feature Level 12.1 |

| Шина памяти | 384-битная: шесть независимых контроллеров памяти шириной по 64 бита с поддержкой GDDR5-памяти |

| Частота графического процессора | 1000 (1075) МГц |

| Вычислительные блоки | 24 потоковых мультипроцессора, включающих 3072 скалярных ALU для расчетов с плавающей запятой одинарной и двойной точности (с темпом 1/32 от FP32) в рамках стандарта IEEE 754-2008; |

| Блоки текстурирования | 192 блока текстурной адресации и фильтрации с поддержкой FP16- и FP32-компонент в текстурах и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растеризации (ROP) | 6 широких блоков ROP (96 пикселей) с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16- или FP32-формате буфера кадра. Блоки состоят из массива конфигурируемых ALU и отвечают за генерацию и сравнение глубины, мультисэмплинг и блендинг |

| Поддержка мониторов | Интегрированная поддержка до четырех мониторов, подключенных по интерфейсам Dual Link DVI, HDMI 2.0 и DisplayPort 1.2 |

| Спецификации референсной видеокарты Geforce GTX Titan X | |

|---|---|

| Параметр | Значение |

| Частота ядра | 1000 (1075) МГц |

| Количество универсальных процессоров | 3072 |

| Количество текстурных блоков | 192 |

| Количество блоков блендинга | 96 |

| Эффективная частота памяти | 7000 (4×1750) МГц |

| Тип памяти | GDDR5 |

| Шина памяти | 384-бит |

| Объем памяти | 12 ГБ |

| Пропускная способность памяти | 336,5 ГБ/с |

| Вычислительная производительность (FP32) | до 7 терафлопс |

| Теоретическая максимальная скорость закраски | 96 гигапикселей/с |

| Теоретическая скорость выборки текстур | 192 гигатекселей/с |

| Шина | PCI Express 3.0 |

| Разъемы | Один разъем Dual Link DVI, один HDMI 2.0 и три DisplayPort 1.2 |

| Энергопотребление | до 250 Вт |

| Дополнительное питание | Один 8-контактный и один 6-контактный разъемы |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $999 (США), 74990 руб (Россия) |

Новая модель Geforce GTX Titan X получила наименование, продолжающее линейку премиальных решений Nvidia специфического позиционирования — к нему просто добавили букву X. Новинка пришла на замену модели Geforce GTX Titan Black, и в текущей продуктовой линейке компании располагается на самом верху. Выше её остаётся разве что двухчиповая Geforce GTX Titan Z (хотя её уже можно и не упоминать), а ниже — одночиповые модели GTX 980 и GTX 970. Рекомендованная цена на новую плату составляет $999, и это ожидаемо для платы линейки Titan, так как она является лучшим по производительности решением на рынке одночиповых видеокарт.

Рассматриваемая модель компании Nvidia сделана на базе чипа GM200, имеющего 384-битную шину памяти, а память работает на частоте 7 ГГц, что даёт пиковую пропускную способность в 336,5 ГБ/с — в полтора раза больше, чем в GTX 980. Это весьма впечатляющее значение, особенно если вспомнить новые методы внутричипового сжатия информации, используемые в Maxwell второго поколения, помогающие использовать имеющуюся ПСП куда эффективнее, чем GPU конкурента.

С такой шиной памяти, объём установленной на видеокарту видеопамяти мог быть 6 или 12 ГБ, но в случае элитной модели было принято решение по установке 12 ГБ, чтобы продолжить тренд, заданный первыми моделями GTX Titan. Этого более чем достаточно для запуска любых 3D-приложений без оглядки на параметры качества — такого объёма видеопамяти хватит абсолютно для любой существующей игры в любом разрешении экрана и при любых настройках качества, что делает видеокарту Geforce GTX Titan X особенно заманчивой с видом на перспективу — её владелец никогда не столкнётся с нехваткой видеопамяти.

Официальная цифра энергопотребления для Geforce GTX Titan X составляет 250 Вт — столько же, что и у других одночиповых решений элитной серии Titan. Интересно, что 250 Вт примерно на 50% больше по сравнению с GTX 980, на столько же выросло и количество основных функциональных блоков. Никаких проблем довольно высокое потребление не приносит, референсный кулер прекрасно справляется с рассеиванием такого количества тепла, а уж системы энтузиастов после GTX Titan и GTX 780 Ti давно готовы к подобному уровню энергопотребления.

Архитектура

Модель видеокарты Geforce GTX Titan X основана на новом графическом процессоре GM200, который включает все архитектурные возможности чипа GM204, поэтому всё сказанное в статье по GTX 980 относится в полной мере и к премиальной новинке — советуем ознакомиться сначала с тем материалом, в котором более полно рассмотрены именно архитектурные особенности Maxwell.

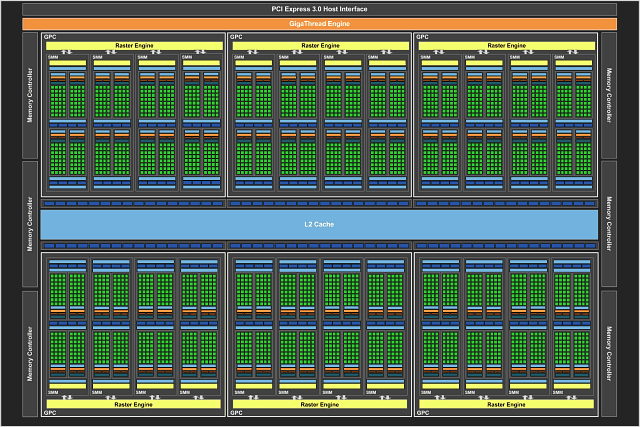

Графический процессор GM200 можно назвать экстремальной версией GM204, возможной в рамках технологического процесса 28 нм. Новый чип больше по размеру, значительно быстрее и более требователен к питанию. По данным компании Nvidia, «большой Maxwell» включает 8 миллиардов транзисторов, которые занимают площадь порядка 600 мм2 — то есть, это самый большой графический процессор компании. «Большой Maxwell» имеет на 50% больше потоковых процессоров, на 50% больше блоков ROP и на 50% большую ПСП, поэтому и имеет почти в полтора раза большую площадь.

Архитектурно видеочип GM200 полностью соответствует младшей модели GM204, он также состоит из кластеров GPC, в которые собрано по несколько мультипроцессоров SM. Топовый графический процессор содержит шесть кластеров GPC, состоящих из 24 мультипроцессоров, всего он имеет 3072 вычислительных CUDA ядер, а текстурные операции (выборка и фильтрация) производятся при помощи 192 текстурных модулей. И при базовой частоте в 1 ГГц, производительность текстурных модулей составляет 192 гигатекселя/сек, что более чем на треть превышает аналогичную характеристику предыдущей мощнейшей видеокарты компании — Geforce GTX 980.

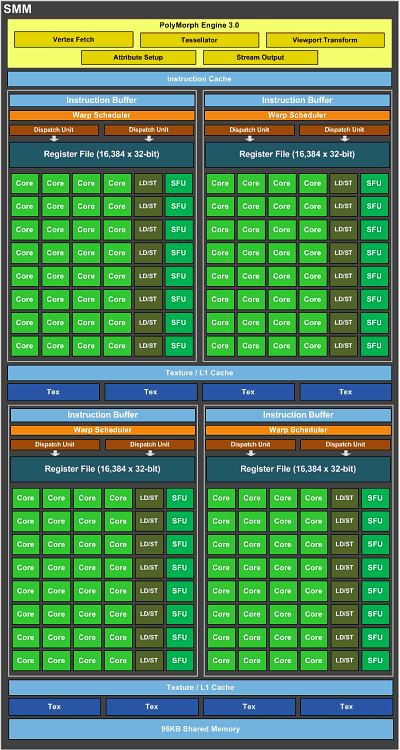

Мультипроцессор второго поколения Maxwell разбит на четыре блока CUDA-ядер по 32 штуки (всего 128 ядер на SMM), каждый из которых имеет собственные ресурсы для распределения команд, планирования обработки и буферизации потока инструкций. Благодаря тому, что каждый вычислительный блок имеет свои блоки диспетчера, вычислительные CUDA-ядра используются более эффективно, чем в Kepler, что также снижает и энергопотребление GPU. Сам по себе мультипроцессор по сравнению с GM204 не изменился:

Для улучшения эффективности использования кэшей в GPU, были сделаны многочисленные изменения в подсистеме памяти. Каждый из мультипроцессоров в GM200 имеет выделенные 96 КБ общей памяти, а кэши первого уровня и текстур объединены в 24 КБ блоки — по два блока в мультипроцессоре (всего 48 КБ на SMM). Графические процессоры предыдущего поколения Kepler имели лишь 64 КБ общей памяти, которая также выполняла функции кэш-памяти первого уровня. В результате всех изменений, эффективность CUDA-ядер Maxwell примерно в 1,4 раза выше, чем в аналогичном чипе Kepler, а энергоэффективность новых чипов примерно вдвое выше.

В целом, в графическом процессоре GM200 всё устроено точно так же, как и в рассмотренном нами в 2014 году чипе GM204. Не тронули даже вычислительные ядра, которые умеют выполнять операции с плавающей запятой двойной точности с темпом всего лишь 1/32 от скорости вычислений одинарной точности — точно как у Geforce GTX 980. Такое впечатление, что в Nvidia признали, что выпуск специализированных решений для профессионального рынка (GK210) и для игрового (GM200) вполне обоснован.

Подсистема памяти у GM200 по сравнению с GM204 усилена — она основана на шести 64-битных контроллерах памяти, что в сумме составляет 384-битную шину. Чипы памяти работают на эффективной частоте в 7 ГГц, что даёт пиковую пропускную способность в 336,5 ГБ/с, что в полтора раза выше, чем у Geforce GTX 980. Не забываем и о новых методах сжатия данных от Nvidia, которые позволяют добиться большей эффективной ПСП, по сравнению с предыдущими продуктами — на той же 384-битной шине. В обзоре Geforce GTX 980 мы тщательно рассматривали это нововведение второго поколения чипов Maxwell, которое обеспечивает им на четверть более эффективное использование видеопамяти, по сравнению с Kepler.

Как и все последние видеокарты Geforce, модель GTX Titan X имеет базовую частоту — минимальную для работы GPU в 3D-режиме, а также турбо-частоту Boost Clock. Базовая частота для новинки составляет 1000 МГц, а частота Boost Clock — 1075 МГц. Как и раньше, турбо-частота означает лишь среднюю частоту работы GPU для некоего набора игровых приложений и других 3D-задач, используемых в Nvidia, а реальная частота работы может быть и выше — она зависит от 3D-нагрузки и условий (температуры, потребления энергии и т.д.)

Получается, что частота GPU у новинки примерно на 10% выше, чем было у GTX Titan Black, но ниже, чем у GTX 980, так как большие графические процессоры всегда приходится тактовать на меньшей частоте (а GM200 по площади заметно больше, чем GM204). Поэтому общая 3D-производительность новинки будет примерно на 33% выше, чем у GTX 980, особенно если сравнивать Turbo Boost частоты.

Во всём остальном, чип GM200 ровно ничем не отличается от GM204 — по своим возможностям и поддерживаемым технологиям решения идентичны. Даже модули по работе с дисплеями и видеоданными оставили точно такими же, что и у GM204, на котором основана модель Geforce GTX 980. Соответственно, всё то, что мы писали про GTX 980 и GTX 970, в полной мере относится и к Titan X.

Поэтому по всем остальным вопросам функциональных тонкостей новинки вы можете обратиться к обзорам Geforce GTX 980 и GTX 750 Ti, в которых мы подробно писали об архитектуре Maxwell, устройстве потоковых мультипроцессоров (Streaming Multiprocessor — SMM), организации подсистемы памяти и некоторых других архитектурных отличиях. Там же вы можете ознакомиться и с функциональными возможностями, вроде аппаратной поддержки ускорения расчета глобального освещения VXGI, новых методов полноэкранного сглаживания и улучшенных возможностей графического API DirectX 12.

Решение проблем с освоением новых техпроцессов

Можно уверенно говорить о том, что на рынке видеокарт все давно устали от 28 нм техпроцесса — мы наблюдаем уже четвёртый год использования именно его, а шаг вперёд у TSMC сделать сначала не получалось вовсе, а потом вроде получилось начать 20 нм производство, но толку от него для больших GPU не было — выход годных довольно низкий, и преимуществ по сравнению с отработанным 28 нм не обнаружилось. Поэтому Nvidia и AMD пришлось выжимать из существующих возможностей как можно большее, и в случае чипов архитектуры Maxwell компания Nvidia явно преуспела в этом. По мощности и энергоэффективности GPU этой архитектуры стали явным шагом вперёд, на который AMD просто ничего не ответила — как минимум пока.

Так, из GM204 инженеры Nvidia смогли выжать гораздо больше производительности по сравнению с GK104, при том же уровне энергопотребления, хотя чип увеличился на треть, а большая плотность размещения транзисторов позволила поднять их число ещё больше — с 3,5 млрд. до 5,2 млрд. Понятно, что в таких условиях в составе GM204 оказалось куда больше исполнительных блоков, что вылилось и в большую 3D-производительность.

Но в случае самого большого чипа архитектуры Maxwell, конструкторы Nvidia не могли слишком сильно увеличивать размер чипа, по сравнению с GK110, он и так имеет площадь порядка 550 мм2, и увеличить его площадь на треть или хотя бы четверть не представлялось возможным — такой GPU стал бы слишком сложным и дорогим в производстве. Пришлось чем-то пожертвовать (по сравнению со старшим Kepler), и этим чем-то стала производительность вычислений с двойной точностью — её темп у GM200 точно такой же, что и у других решений Maxwell, хотя старший Kepler был универсальнее, подходя и для графических и для любых неграфических расчётов.

Такое решение далось для Kepler нелегко — уж слишком большая часть площади этого чипа была занята FP64-ядрами CUDA и другими специализированными блоками для вычислений. В случае большого Maxwell было решено обойтись графическими задачами и его сделали просто в виде укрупнённой версии GM204. Новый чип GM200 стал чисто графическим, в нём нет специальных блоков для FP64-вычислений, и их темп остался прежним — лишь 1/32 от FP32. Зато большая часть площади GK110, занятая FP64 ALU, освободилась и на их место было помещено большее количество важных для графики FP32 ALU.

Такой ход позволил заметно увеличить графическую (да и вычислительную, если брать FP32-вычисления) производительность по сравнению GK110 без роста энергопотребления и при незначительном увеличении площади кристалла — менее чем на 10%. Интересно, что Nvidia намеренно пошла на разделение графических и вычислительных чипов в этот раз. Хотя GM200 остаётся весьма производительным в FP32-вычислениях, и вполне возможен выход специализированных решений Tesla для вычислений с одинарной точностью, достаточных для многих научных задач, но Tesla K40 остаётся самой производительной для FP64-вычислений.

В этом и отличие от оригинальной Titan, кстати — первое решение линейки могло использоваться и в профессиональных целях для вычислений с двойной точностью, так как оно также имеет темп 1/3 для FP64-расчётов. И многие исследователи использовали GTX Titan в качестве начальной карты для своих CUDA-приложений и задач, при успехе переходя на решения Tesla. Вот для этого GTX Titan X уже не подойдёт, придётся ждать GPU следующих поколений. Если они не будут разделены на графические и вычислительные чипы изначально, конечно.

В картах расширения такое разделение есть уже сейчас — модель Tesla K80 содержит пару чипов GK210, не применяемых в видеокартах и отличающихся от GK110 удвоенным регистровым файлом и разделяемой памятью для большей производительности именно вычислительных задач. Получается, что GK210 можно считать исключительно «вычислительным» процессором, а GM200 — чисто «графическим» (с определённой долей условности, ведь оба GPU имеют одинаковые возможности, просто разной специализации).

Посмотрим, что получится в следующих поколениях графических архитектур компании Nvidia, производимых уже на более «тонком» техпроцессе — возможно, такое разделение в них не понадобится, по крайней мере поначалу. Или наоборот, мы сразу же увидим жёсткое разделение по моделям GPU с разной специализацией (в вычислительных моделях будет больше вычислительных возможностей, а в графических — TMU и ROP блоков, например), хотя архитектура останется единой.

Особенности конструкции видеокарты

Но вернёмся к Geforce GTX Titan X. Это мощнейшая видеокарта, предназначенная для энтузиастов ПК-игр, поэтому она должна иметь и соответствующий внешний вид — оригинальный и солидный дизайн платы и кулера. Как и предыдущие решения линейки Titan, модель Geforce GTX Titan X накрыта алюминиевым корпусом, который и придаёт тот самый премиальный вид видеокарте — она действительно смотрится солидно.

Весьма впечатляюще смотрится и система охлаждения — в конструкции кулера Titan X используется испарительная камера из медного сплава — она охлаждает графический процессор GM200. Испарительная камера соединена с большим двухслотовым радиатором из алюминиевого сплава, который рассеивает тепло, переданное от видеочипа. Вентилятор выводит нагретый воздух вне корпуса ПК, что положительно сказывается на общем температурном режиме в системе. Вентилятор работает очень тихо даже при разгоне и при длительной работе под нагрузкой, и в результате, GTX Titan X с потреблением 250 Вт является одной из самых тихих видеокарт в своём классе.

В отличие от референсной платы Geforce GTX 980, новинка не содержит специальную съёмную пластину, которой прикрыта задняя поверхность платы — это сделано для обеспечения максимального притока воздуха к PCB для её охлаждения. Для питания платы используется набор из одного 8-контактного и одного 6-контактного разъёмов дополнительного питания PCI Express.

Так как Geforce GTX Titan X предназначена для энтузиастов, предпочитающих решения с максимальной производительностью, то все компоненты новой видеокарты подбирались с этим расчётом и даже с некоторым запасом по возможностям и характеристикам.

Например, для обеспечения графического процессора в составе Geforce GTX Titan X энергией, используется 6-фазная система питания с возможностью дополнительного усиления. Для обеспечения работы GDDR5-памяти дополнительно применяется ещё одна двухфазная система питания. 6+2-фазная система питания видеокарты обеспечивает рассматриваемую модель более чем достаточным количеством энергии, даже с учётом разгона. Так, референсная плата Titan X способна подвести до 275 Вт питания к GPU при условии установки максимального значения целевого питания (power target) в 110%.

Также, для дальнейшего улучшения разгонного потенциала, было улучшено охлаждение всех компонентов новинки, по сравнению с оригинальной видеокартой Geforce GTX Titan — изменённый дизайн платы и кулера привёл к улучшению оверклокерских возможностей. В итоге, почти все образцы Titan X способны работать на частоте до 1.4 ГГц и более — при референсном же воздушном кулере.

Длина референсной платы Geforce GTX Titan X составляет 267 мм, на ней установлены следующие разъёмы для вывода изображения: один Dual-Link DVI, один HDMI 2.0 и три DisplayPort. Geforce GTX Titan X поддерживает вывод изображения на дисплеи с разрешением до 5K, и является очередной видеокартой с поддержкой HDMI 2.0, чего до сих пор нет у конкурента — это позволяет подключать новинку к 4K-телевизорам, обеспечивая максимальное качество картинки при высокой частоте обновления в 60 Гц.

Поддержка игровых разработчиков

Nvidia всегда была компанией, которая отличается очень тесной работой с производителями ПО, а особенно — игровыми разработчиками. Чего стоит только PhysX — самый популярный игровой движок физических эффектов, который применяется уже более 10 лет в более чем 500 играх. Широкое распространение PhysX связано в том числе с тем, что он интегрирован в одни из самых популярных игровых движков: Unreal Engine 3 и Unreal Engine 4. Так, на конференции игровых разработчиков Game Developers Conference 2015, компания Nvidia анонсировала свободный доступ к исходным кодам CPU-ориентированной части PhysX 3.3.3 для разработчиков на C++ в вариантах для Windows, Linux, OS X и Android.

Разработчики теперь смогут модифицировать код PhysX движка так, как они пожелают, и модификации даже могут быть затем включены в основной код Nvidia PhysX. Открыв исходники PhysX для всех желающих, Nvidia дала доступ к своему физическому движку ещё более широкому кругу разработчиков игровых приложений, которые могут использовать этот продвинутый физический движок в своих играх.

Nvidia продолжает продвигать и ещё одну свою технологию — довольно новый алгоритм имитации динамического глобального освещения VXGI, который включает поддержку специального аппаратного ускорения на видеокартах с графическими процессорами Maxwell второго поколения, таких как Geforce GTX Titan X.

Внедрение VXGI в игру позволит разработчикам обеспечить весьма качественный расчёт динамического глобального освещения в реальном времени, использующем все возможности современных GPU и обеспечивающем высочайшую производительность. Чтобы понять важность расчёта глобального освещения (рендеринга с учётом не только прямого освещения от источников света, но и его отражения от всех объектов сцены), достаточно посмотреть на пару картинок — с включенным GI и без него:

Понятно, что этот пример искусственный, и в реальности игровые дизайнеры используют специальные методы для имитации глобального затенения, расставляя дополнительные источники света или используя предварительный расчёт освещения — но до появления VXGI они или не были полностью динамическими (предварительно рассчитывались для статической геометрии) или не имели достаточную реалистичность и/или производительность. В будущих же играх вполне можно применять VXGI, и совсем не только на топовых GPU.

Техника VXGI очень понравилась игровым разработчикам. По крайней мере, многие из них попробовали метод в тестовых сценах, очень воодушевлены результатами и рассматривают возможность её включения в свои игры. А вот вам ещё одна сцена с качественным расчётом глобального освещения — по ней тоже видно, насколько важно учитывать лучи света, отражённые от всех поверхностей сцены:

Пока разработчики не внедрили VXGI в собственные движки, можно воспользоваться специальной версией движка Unreal Engine 4 VXGI GitHub, который предоставлен всем заинтересованным разработчикам — это даёт возможность быстрой интеграции VXGI в их игровые (и не только!) проекты, использующие этот популярный игровой движок — впрочем, для этого будут нужны некоторые модификации, VXGI нельзя просто «включить».

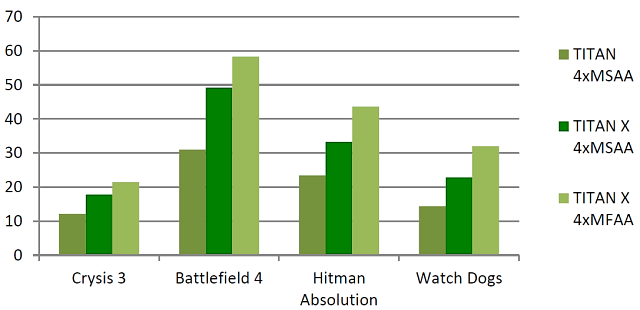

Рассмотрим ещё одну технологию Nvidia — полноэкранное сглаживание методом MFAA, обеспечивающее отличную производительность и при этом — приемлемое качество сглаживания. Мы уже писали об этом методе и лишь вкратце повторим суть и перспективы. Поддержка MFAA является одной из ключевых возможностей графических процессоров Maxwell, по сравнению с GPU предыдущих поколений. Используя возможность по программированию позиций для выборок сглаживания при методе MSAA, эти выборки меняются каждый кадр таким образом, что MFAA является практически полноценным MSAA, но при меньшей нагрузке на GPU.

В результате, картинка с включенным MFAA выглядит практически как с MSAA, но потери производительности при этом значительно ниже. К примеру, MFAA 4x обеспечивает скорость на уровне MSAA 2x, а качество сглаживания близко к MSAA 4x. Поэтому в тех играх, где производительности для достижения высокой частоты кадров недостаточно, применение MFAA будет вполне оправдано и может улучшить качество. Вот пример получаемой производительности с MSAA и MFAA на видеокарте Titan X по сравнению с обычной Titan (в 4К-разрешении):

Метод сглаживания MFAA совместим со всеми играми, использующими DirectX 10 и DirectX 11 и имеющими поддержку MSAA (за исключением редких проектов вроде Dead Rising 3, Dragon Age 2 и Max Payne 3). MFAA можно включить вручную в панели управления Nvidia. Также MFAA интегрирована в Geforce Experience, и этот метод автоматически включится для разных игр в случае оптимизации при помощи Geforce Experience. Единственной проблемой является то, что на данный момент MFAA всё ещё не совместима с технологией Nvidia SLI, что обещают исправить в будущих версиях видеодрайверов.

Современные игры на Geforce GTX Titan X

Со всей своей мощью и возможностями, Geforce GTX Titan X способен справиться не только с нынешними играми, но и будущими проектами с поддержкой грядущей версии DirectX 12. Но «поставить на колени» новинку можно и сейчас — с помощью самых требовательных современных игр при максимальных настройках качества, с включенным полноэкранным сглаживанием и высоким разрешением рендеринга — вроде 4K.

В условиях высоких разрешений и включенном сглаживании мощная подсистема памяти становится особенно важной, и у Geforce GTX Titan X с ней всё в полном порядке — 384-битный интерфейс памяти и чипы, работающие на эффективной частоте 7 ГГц обеспечивают пропускную способность в 336,5 ГБ/с — хоть это и не рекорд, но довольно прилично.

А ещё очень важно, чтобы все данные помещались в видеопамять, так как при включении MSAA в разрешении 4K во многих играх объёма видеопамяти просто не хватает — нужно более чем 4 ГБ памяти. И в Titan X есть не просто 6 ГБ, а целых 12 ГБ видеопамяти, ведь эта линейка создана для тех энтузиастов, которые не терпят компромиссов. Понятно, что с таким объёмом набортной памяти игроку не нужно задумываться о том, не снизится ли производительность игры в высоком разрешении при включении мультисэмплинга — во всех играх при любых настройках 12 ГБ будет более чем достаточно.

На данный момент, в абсолютно любой игре можно задавать любые настройки и выбирать любые разрешения — Titan X обеспечит достаточную частоту кадров при (почти) любых условиях. Вот какие игры выбрала Nvidia для демонстрации производительности своего решения:

Как видите, частота кадров в 40 FPS и более обеспечивается в большинстве самых «тяжёлых» современных игр, с включенным полноэкранным сглаживанием, в том числе таких проектах, как Far Cry 4 — в этой игре при Ultra-настройках и сглаживании в 4K-разрешении добиться приемлемой скорости рендеринга можно только на Titan X или на многочиповых конфигурациях.

А с выходом игр будущего, которые будут иметь поддержку DirectX 12, можно ожидать ещё большего роста требований к производительности GPU и видеопамяти — улучшение качества рендеринга «бесплатно» не даётся. Кстати, на тот момент Nvidia ещё не протестировала свою видеокарту Titan X в новейшей игре, вышедшей совсем недавно — ПК-версии Grand Theft Auto V. Эта серия игр является самой популярной среди современных проектов, в ней вы выступаете в роли различных криминальных элементов в декорациях города Лос-Сантос, подозрительно похожего на реальный Лос-Анджелес. ПК-версию GTAV очень ждали и она наконец-то вышла в середине апреля — через месяц после Titan X.

Даже консольные версии (речь о консолях текущего поколения, разумеется) игры Grand Theft Auto V были весьма неплохи по качеству картинки, а уж ПК-версия игры предлагает ещё несколько возможностей для её улучшения: значительно увеличенную дальность прорисовки (объектов, эффектов, теней), возможность игры при 60 FPS и более, в том числе в разрешениях вплоть до 4K. Кроме этого обещают богатый и плотный трафик, множество динамических объектов в сцене, улучшенные погодные эффекты, тени, освещение и т.д.

Применение пары технологий Nvidia GameWorks позволило ещё больше улучшить качество картинки в GTAV. Напомним, GameWorks — это специальная платформа для игровых и графических разработчиков, обеспечивающая их 3D-технологиями и утилитами, предназначенными для видеокарт Nvidia. Добавление технологий GameWorks в игры позволяет сравнительно просто добиться качественной имитации реалистичного дыма, шерсти и волос, волн, а также глобального освещения и других эффектов. GameWorks значительно облегчает задачу разработчиков, обеспечивая примерами, библиотеками и SDK, готовыми к применению в игровом коде.

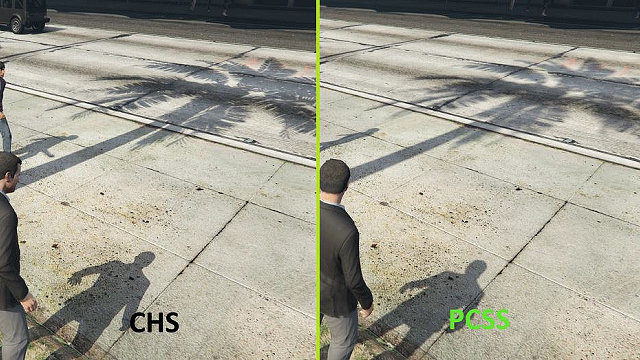

Игра Grand Theft Auto V использует пару таких технологий от Nvidia: ShadowWorks Percentage-Closer Soft Shadows (PCSS) и Temporal Anti-Aliasing (TXAA), которые улучшают и так неплохую графику в игре. PCSS — это специальная техника рендеринга теней, имеющая лучшее качество, по сравнению с типичными методами мягких теней. PCSS имеет три преимущества: степень мягкости краёв теней зависит от расстояния между объектом, отбрасывающим тень и поверхностью, на которой она рисуется, также обеспечивается более качественная фильтрация, снижающая количество артефактов в виде рваных краёв теней, а использование теневого буфера позволяет грамотно обрабатывать пересечения теней от разных объектов и не допускать появления «сдвоенных» теней.

В результате при включении PCSS в игре обеспечиваются мягкие реалистичные динамические тени, куда лучшего качества, по сравнению с тем, что мы видели на игровых консолях. А для игры вроде Grand Theft Auto V с постоянно перемещающимся по горизонту ярким солнцем качество теней весьма важно, они всегда на виду. По следующим скриншотам можно оценить разницу между двумя самыми качественными методами, применяющимися в игре (алгоритм AMD против метода Nvidia):

Явно видно, что метод PCSS позволяет получить мягкие края теней, которые прогрессивно замыливаются тем больше, чем дальше расстояние между объектом, от которого тень, и поверхностью, «принимающей» тень. При этом, включение PCSS почти не сказывается на итоговой производительности в игре. Хотя этот метод обеспечивает лучшее качество и реализм теней, включение этой опции практически «бесплатно» для производительности.

Ещё одним важным дополнением к ПК-версии игры GTAV можно назвать метод сглаживания Nvidia TXAA. Temporal Anti-Aliasing — это новый алгоритм сглаживания, созданный специально для устранения проблем обычных методов сглаживания, видимых в динамике — когда отдельные пиксели мерцают. Для фильтрации пикселей на экране при помощи этого метода используются сэмплы не только внутри пикселя, но и снаружи его, также совместно с сэмплами из предыдущих кадров, что позволяет получить «киношное» качество фильтрации.

Особенно хорошо преимущество метода перед MSAA заметно на таких объектах с полупрозрачными поверхностями, как трава, листья деревьев и сетки заборов. Также TXAA помогает качественно сгладить попиксельные эффекты. В целом, метод очень качественный и приближается по качеству к профессиональным методам, применяемым в 3D-графике, но результат после TXAA получается слегка более размытый, по сравнению с MSAA, что нравится не всем пользователям.

Падение производительности от включения TXAA зависит от игры и условий, и коррелирует в основном со скоростью MSAA, который также используется в этом методе. Но по сравнению с методами сглаживания чисто постобработкой, вроде FXAA, которые обеспечивают максимальную скорость при меньшем качестве, TXAA призван максимизировать качество при некотором дополнительном падении производительности. Но при таком богатстве и детализации мира, как мы видим в Grand Theft Auto V, включение качественного сглаживания будет весьма полезным.

ПК-версия игры имеет богатые графические настройки, позволяющие получить необходимое качество картинки с требуемой производительностью. Так, GTAV на ПК обеспечивает приемлемую скорость рендеринга и его качества на всех решениях компании Nvidia, начиная примерно с Geforce GTX 660. Ну а чтобы получить полноценное наслаждение всеми графическими эффектами игры, рекомендуется использовать что-то вроде Geforce GTX 970/980 или даже Titan X.

Для проверки настроек в игру встроен тест производительности — этот бенчмарк содержит пять сцен, близких к реальному геймплею, что позволит оценить скорость рендеринга в игре на ПК с разными аппаратными конфигурациями. Но обладателям видеокарт Nvidia можно поступить проще, оптимизировав игру для собственного ПК при помощи Geforce Experience. Это ПО подберёт и настроит оптимальные настройки при сохранении играбельной скорости рендеринга — и всё это делается нажатием одной кнопки. Geforce Experience найдёт лучшее сочетание характеристик и для Geforce GTX 660 с FullHD-монитором, и для Titan X с 4К-телевизором, обеспечив лучшие настройки для конкретной системы.

Полная поддержка игры GTAV появилась в новой сборке драйверов Geforce версии 350.12 WHQL, имеющей специальный оптимизированный профиль для этого приложения. Эта версия драйверов обеспечит оптимальную производительность в игре, в том числе с использованием других технологий компании Nvidia: 3D Vision, 4K Surround, Dynamic Super Resolution (DSR), GameStream, G-SYNC (Surround), Multi Frame Sampled Anti-Aliasing (MFAA), Percentage Closer Soft Shadows (PCSS), SLI и других.

Также, специальный драйвер версии 350.12 WHQL содержит обновленные SLI-профили для нескольких игр, включая и новый профиль для Grand Theft Auto V. В дополнение к SLI-профилям, драйвер обновляет и добавляет профили и для технологии 3D Vision, и профиль для GTAV получил оценку «Excellent», что означает отличное качество стереоизображения в данной игре — обладателям соответствующих очков и мониторов стоит попробовать!

Поддержка технологий виртуальной реальности

Тема виртуальной реальности (Virtual Reality — VR) сейчас является одной из самых громких в игровой индустрии. Во многом, в возрождении интереса к VR «виновата» компания Oculus, которую затем приобрел Facebook. До некоторого времени они показывали лишь прототипы или комплекты SDK, но у них есть планы и по выпуску коммерческой версии шлема Oculus Rift в конце текущего года. Другие компании также не остаются в стороне. К примеру, известная компания Valve анонсировала планы по партнёрству с компанией HTC для выпуска собственного шлема виртуальной реальности также к концу 2015 года.

Естественно, что и производители графических процессоров видят в VR перспективу, и компания Nvidia плотно работает с поставщиками программных и аппаратных решений для виртуальной реальности для того, чтобы обеспечить максимально комфортную их работу совместно с видеокартами Geforce (а то и Tegra, кто знает?). И это — не просто маркетинговые лозунги, ведь чтобы использование VR было комфортным, нужно решить несколько проблем, в том числе снизить задержки между действием игрока (движение головы) и результирующим отображением этого движения на дисплее — слишком большой лаг не просто портит впечатление от виртуальной реальности, но может вызвать так называемую морскую болезнь (укачивание, motion sickness).

Для того, чтобы снизить эту задержку, программное обеспечение VR Direct от Nvidia поддерживает такую возможность, как асинхронное искажение времени (asynchronous time warp). С применением асинхронного искажения времени, отрендеренная некоторое время назад сцена может сдвигаться, основываясь на более поздних движениях головы игрока, которую захватили сенсоры шлема. Это сокращает задержку между действием и выводом изображения, так как GPU не нужно перерасчитывать весь кадр полностью перед сдвигом. Компания Nvidia уже предоставляет драйверную поддержку для разработчиков VR-приложений, и они могут применить асинхронное искажение времени в своём ПО.

Кроме задержки вывода, очень важным для достижения комфортного геймплея в шлеме виртуальной реальности является не просто обеспечение высокой частоты кадров, а вывод кадров для каждого глаза с максимально плавной их сменой. Соответственно, после популяризации VR-шлемов будущего поколения, многие из игроков захотят опробовать из в современных играх, весьма требовательных к мощности GPU. И в некоторых случаях придётся создавать двухчиповую SLI-конфигурацию из пары мощнейших видеокарт вроде Geforce GTX Titan X.

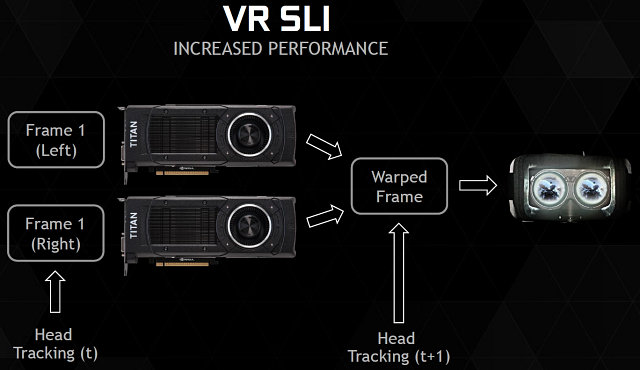

Чтобы обеспечить максимальный комфорт в таких случаях, Nvidia предлагает технологию VR SLI, позволяющую разработчикам игр назначить конкретный GPU из пары для каждого из глаз, чтобы снизить задержки и улучшить производительность. В таком случае, картинку для левого глаза будет рендерить один графический процессор, а для правого — второй GPU. Это очевидное решение снижает задержки и идеально для приложений виртуальной реальности.

Пока что VR SLI и asynchronous time warp недоступны в публичных драйверах Nvidia, но это и не особенно нужно, ведь для их использования требуется изменение исполнимого кода игр. А предварительные версии видеодрайверов для Geforce с поддержкой VR SLI и асинхронного искажения времени доступны для избранных партнёров Nvidia, таких как Epic, Crytek, Valve и Oculus. Ну а публичный драйвер выйдет ближе к выходу конечных VR-продуктов в продажу.

Добавим, что столь мощная видеокарта как Geforce GTX Titan X, применялась во многих демонстрациях виртуальной реальности на игровой конференции для разработчиков в этом году — Game Developers Conference 2015. Вот лишь несколько примеров: «Thief in the Shadows» — совместная разработка Nvidia, Epic, Oculus и WETA Digital – студии, создававшей визуальные эффекты в кинотрилогии «Хоббит», «Back to Dinosaur Island» — перезагрузка известной 14 лет назад демо-программы «X-Isle: Dinosaur Island» от Crytek, а также демонстрации от Valve: «Portal», «Job Simulator», «TheBluVR» и «Gallery». В общем, дело за выходом VR-шлемов в продажу, а уж Nvidia к этому будет готова.

Выводы по теоретической части

С архитектурной точки зрения, новый топовый GPU второго поколения архитектуры Maxwell получился весьма интересным. Как и его «родственники», GM200 взял всё самое лучшее из прошлых архитектур компании, получив дополнительную функциональность и все улучшения второго поколения Maxwell. Поэтому функционально новинка выглядит просто отлично, соответствуя моделям линейки Geforce GTX 900. При помощи серьёзной модернизации исполнительных блоков, инженеры компании Nvidia добились в Maxwell удвоения показателя соотношения производительности к потреблению энергии, прибавив при этом в функциональности — вспоминаем аппаратную поддержку ускорения глобального освещения VXGI и графического API DirectX 12.

Топовая видеокарта модели Geforce GTX Titan X предназначена для игроков-ультраэнтузиастов, которые хотят получить максимальное качество и производительность от самых современных ПК-игр, запущенных в высочайших разрешениях, с максимальными настройками качества, с полноэкранным сглаживанием, и всё это — с приемлемой частотой кадров. С одной стороны, столь мощный GPU требуется немногими играми, да и можно поставить пару менее дорогих видеокарт. С другой — из-за проблем многочиповых решений с увеличенными задержками и неплавностью смены кадров, многие игроки предпочтут один мощный GPU паре менее сильных. Не говоря уже о том, что одночиповая карта обеспечит ещё и меньшее энергопотребление и шум от системы охлаждения.

Естественно, в таких условиях главным вопросом Geforce GTX Titan X является цена решения. Но дело в том, что она продаётся в той нише, где понятия оправданности цены и соотношения цены и качества просто не нужны — решения максимальной производительности всегда стоят заметно дороже, чем близкие к ним, но всё же не такие производительные. И Titan X — это экстремально мощная и дорогая видеокарта, предназначенная для тех, кто готов платить за максимум скорости в 3D-приложениях.

Geforce GTX Titan X позиционируется как премиальная (люксовая, элитная — называйте как угодно) видеокарта, и к рекомендованной стоимости не должно быть никаких претензий — тем более, что предыдущие решения линейки (GTX Titan и GTX Titan Black) стоили поначалу ровно столько же — $999. Это решение для тех, кому нужен самый быстрый графический процессор из существующих, несмотря на его цену. Более того, для самых богатых энтузиастов и рекордсменов в 3D-бенчмарках, доступны системы из трёх и даже четырёх видеокарт Titan X — это просто быстрейшие видеосистемы в мире.

Вот такие запросы Titan X полностью оправдывает и обеспечивает — топовая новинка даже в одиночестве показывает высочайшую частоту кадров во всех игровых приложениях и почти во всех условиях (разрешение и настройки), а объём быстрой GDDR5-видеопамяти в 12 ГБ позволяет не думать о нехватке локальной памяти на несколько лет вперёд — даже игры будущих поколений, с поддержкой DirectX 12 и т.п., просто не смогут забить эту память настолько, что её не хватит.

Как и в случае с первым GTX Titan в 2013 году, новинка в лице GTX Titan X установила новую планку производительности и функциональности для сегмента премиальных видеокарт. В своё время GTX Titan стала довольно успешным продуктом для компании Nvidia, и нет никаких сомнений в том, что GTX Titan X повторит успех предшественницы. Тем более, что основанная на самом большом видеочипе архитектуры Maxwell модель стала самой производительной на рынке безо всяких оговорок. Так как видеокарты вроде GTX Titan X производит сама Nvidia и продаёт референсные образцы своим партнёрам, то с доступностью в магазинах нет никаких проблем с самого момента её анонса.

GTX Titan X соответствует своему высочайшему уровню по всем параметрам: мощнейший GPU семейства Maxwell, отличный дизайн видеокарт в стиле предыдущих моделей Titan, а также великолепная система охлаждения — эффективная и тихая. По скорости 3D-рендеринга это лучшая видеокарта современности, предлагающая более чем на треть большую производительность, по сравнению с лучшими моделями, вышедшими до Titan X — вроде Geforce GTX 980. И если не рассматривать двухчиповые видеосистемы (вроде пары тех же GTX 980 или одной Radeon R9 295X2 от конкурента, имеющих проблемы, присущие многочиповым конфигурациям), то Titan X можно назвать лучшим решением для небедных энтузиастов.

В следующей части нашего материала мы исследуем скорость рендеринга новой видеокарты Nvidia Geforce GTX Titan X на практике, сравнив её скорость с производительностью самых мощных видеосистем от компании AMD и со скоростными показателями предшественников производства Nvidia, сначала в нашем привычном наборе синтетических тестов, а потом и в играх.

| Средняя текущая цена (количество предложений) в московской рознице: | |

|---|---|

| Рассматриваемые карты | Конкуренты |

| GTX Titan X — $1095 (на 01.06.16) | R9 295 X2 — $1458(2) |

| GTX Titan X — $1095 (на 01.06.16) | GTX Titan Black — $1008 (на 01.05.16) |

| GTX Titan X — $1095 (на 01.06.16) | GTX Titan Z — Н/Д(0) |

и лично Ирину Шеховцову

за предоставленную на тестирование видеокарту

| 2 блока питания Thermaltake DPS G 1050W/Амур 1200 для тестового стенда предоставлены компанией Thermaltake | Корпус Corsair Obsidian 800D Full Tower для тестового стенда предоставлен компанией Corsair | Модули памяти Corsair Vengeance CMZ16GX3M4X1600C9 для тестового стенда предоставлены компанией Corsair | Corsair Hydro SeriesT H100i CPU Cooler для тестового стенда предоставлен компанией Corsair |

| Монитор Dell UltraSharp U3011 для тестовых стендов предоставлен компанией Юлмарт | Системная плата Asus Sabertooth X79 для тестового стенда предоставлена компанией Asustek | Системная плата MSI X79A-GD45(8D) для тестового стенда предоставлена компанией MSI | Жесткий диск Seagate Barracuda 7200.14 3 ТБ для тестового стенда предоставлен компанией Seagate |

| Накопитель SSD OCZ Octane 512 ГБ для тестового стенда предоставлен компанией OCZ Russia | 2 накопителя SSD Corsair Neutron SeriesT 120 ГБ для тестового стенда предоставлены компанией Corsair | Монитор Asus ProArt PA249Q для рабочего компьютера предоставлен компанией Asustek | Клавиатура Cougar 700K для рабочего компьютера предоставленa компанией Cougar |