Nvidia Geforce GTX 280 1024MB PCI-E

240 калифорнийских стрелков: Смогут ли одолеть предыдущее войско в виде 9800 GX2?

СОДЕРЖАНИЕ

- Часть 1 — Теория и архитектура

- Часть 2 — Практическое знакомство

- Особенности видеокарт

- Конфигурация стенда, список тестовых инструментов

- Результаты синтетических тестов

- Результаты игровых тестов (производительность)

Результаты тестов (ДИАГРАММЫ!): сравнение производительности

Конфигурацию стенда можно еще раз посмотреть здесь

Результаты тестов: сравнение производительности

В качестве инструментария мы использовали:

- Call Of Juarez (Techland/Ubisoft) — DirectX 9.0, shaders 3.0 (HDR),

demo (demo

Тестирование проводилось при настройках, выставленных на максимальное качество. Батник для прогона прилагается.

- S.T.A.L.K.E.R. 1.003 (GSC Game World/THQ) — DirectX 9.0,

демо для запуска. Файлы надо положить в рабочий каталог игры, где все savegames (Documents and settings). После запуска игры,

загрузить уровень ixbt3 и, выйдя в консоль, запустить демо: demo_play ixbt3. Настройки тестирования — maximum (ВКЛЮЧЕНО ДИНАМИЧЕСКОЕ ОСВЕЩЕНИЕ).

- 3DMark Vantage 1.00 (FutureMark) — DirectX 10.0, shaders 4.0, мультитекстурирование, настройки тестирования — Extreme

- CRYSIS 1.2 (Crytek/EA), DirectX 10.0, shaders 4.0,

(батник и демо для запуска), настройки тестирования — Very High, используется

два уровня RESCUE и HARBOR).

Выражаем благодарность компании CRYTEK за написание timedemo для iXBT.com.

- Company Of Heroes Opposing Fronts (Relic Entertainment/THQ) — DirectX 10.0, shaders 4.0,

батник для запуска. После вхождения в игру вызвать опцию настроек, выбрать раздел по графике и нажать на кнопку с тестом.

Тестирование проводилось при максимальном качестве.

- World In Conflict 1.007 (Massive Entertainment/Sierra) — DirectX 10.0, shaders 4.0,

После вхождения в игру вызвать опцию настроек, выбрать раздел по графике и нажать на кнопку с тестом.

Тестирование проводилось при максимальном качестве (very high с регулировкой АА и АФ).

- 3DMark06 1.10 (FutureMark) — DirectX 9.0c, мультитекстурирование, настройки тестирования — trilinear,

Производительность видеокарт

Читатели, которые хорошо разбираются в трехмерной графике, смогут разобраться, посмотрев диаграммы далее, и сделают для себя вывод. А для новичков и тех, кто только-только занялся вопросом выбора видеокарты, мы сделаем некоторые пояснения.

Во-первых, имеет смысл ознакомиться с нашими краткими справочниками по семействам современных видеокарт и процессоров, на основе которых они выпускаются. Следует отметить частоты работы, поддержку современных технологий (шейдеры), а также конвейерную архитектуру.

Справочник по ATI RADEON X1300-1600-1800-1900-х серий

Справочник по Nvidia Geforce 7300-7600-7800-7900-х серий

Во-вторых, в разделе 3D-Video наш читатель, который только-только столкнулся с проблемой выбора видеокарты, и растерян, может ознакомиться как с азами трехмерной графики (все равно они понадобятся, ведь запуская игру, и входя в ее настройки, пользователь столкнется с такими понятиями, как текстуры, освещение и т.д.), так и с базовыми материалами по новым продуктам. Всего компаний, выпускающих ныне популярные графические процессоры, две: AMD (графикой занимается подразделение ATI) и Nvidia (Есть еще Matrox, S3, однако их доля в дискретной графике сегодня меньше 1%, и потому их можно не брать во внимание). Поэтому основная масса информации разбита именно на две части. Ежемесячно выходит также 3DSpeed, где как бы сводятся в одно все сравнения различных карт для разных ценовых секторов.

В-третьих, посмотрим на тесты рассматриваемых сегодня карт.

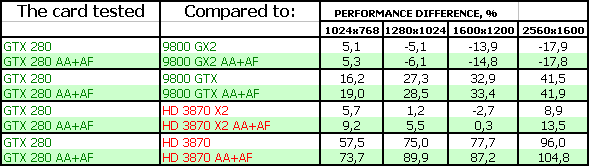

S.T.A.L.K.E.R.

Результаты тестов (ДИАГРАММЫ!!!): S.T.A.L.K.E.R.

Эта игра уже относительно устаревшая по своим технологиям, однако подобных игр еще много на рынке, поэтому результаты в ней весьма показательны. Очевидно, что в низких разрешениях производительность уперлась в системные ресурсы, в CPU, поэтому там почти нет никаких разниц. С ростом разрешения мы видим, как суммарная скорость заполнения сцены у 9800 GX2 начинает сказываться, и потому GTX 280 отстает. Когда как в случае с 9800 GTX у новинки есть явное преимущество. Да и в соперничестве с 3870 X2 нет проигрышей по сути (хотя там явно виновата плохая работа CrossFire в данной игре).

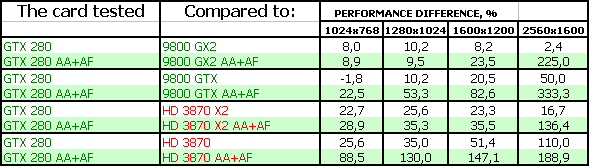

World In Conflict

Результаты тестов (ДИАГРАММЫ!!!): World In Conflict

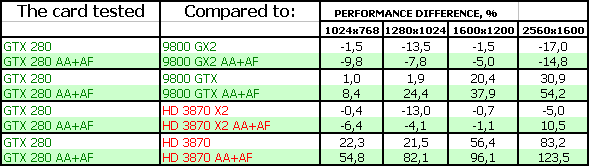

А вот эта игра поддерживает все современные новации, в т.ч. DX10, и мы видим, во-первых, как вырвалась новинка в лидеры по всем фронтам, во-вторых, как сработала высокая ПСП из-за 512-битной шины, и в режимах с АА+АФ приросты оказались вообще фантастическими. Особенно относительно 9800 GX2 из-за еще не до конца отлаженной технологии SLI в этой игре.

Очевидно, что конкуренты из стана ATI остались далеко позади.

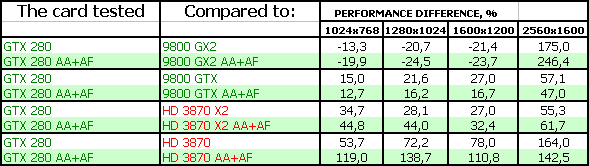

CRYSIS, Rescue, DX10, Very High

Результаты тестов (ДИАГРАММЫ!!!): CRYSIS, Rescue, DX10, Very High

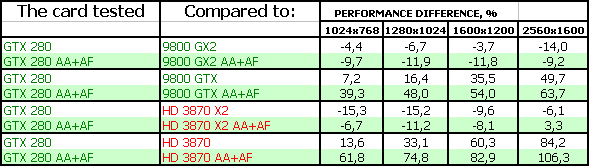

А вот в этой игре случилось что-то странное. Мы видим, что GTX 280 оказался почти посредине между 9800 GTX и GX2. Понятно, что в 2560х1600, где технология SLI дает сильный сбой (мы писали об этом ранее), там новый продукт демонстрирует лидерство, однако играбельность ниже критического уровня.

Одно из двух: или в игре велико влияние банальной скорости заполнения сцены, которая у GX2 явно больше, чем у нового продукта, или проблема с драйверами. Ну и следует также иметь в виду, что в любой игре средний FPS у SLI-систем может не отражать реально низкого мгновенного FPS, то есть средний FPS будет высокий, а играть тяжело из-за лагов.

CRYSIS, Harbor, DX10, Very High

Результаты тестов (ДИАГРАММЫ!!!): CRYSIS, Harbor, DX10, Very High

Собственно, другая сцена в этой же игре продемонстрировала такой же расклад сил, поэтому выводы аналогичные.

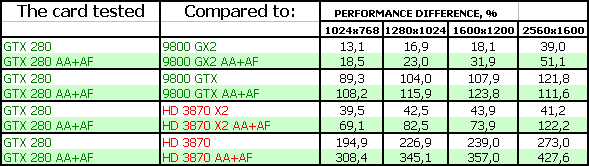

Call Of Juarez

Результаты тестов (ДИАГРАММЫ!!!): СoJ

Эта игра заточена под DX9, имеет сильное требование к скорости мультитекстурирования, поэтому GTX 280 не одолел более мощного с точки зрения филлрейта собрата, или же просто DX9-технологии совместно с SLI отлажены более сильно и выдают намного более высокие результаты, нежели в DX10. Последний вывод кажется более правомерным.

Именно потому и прогрыш сопернику в лице 3870 X2.

Company Of Heroes

Результаты тестов (ДИАГРАММЫ!!!): CoH

А вот как только встречается DX10-приложение, мы снова видим лидерство новинки. Особенно в режимах с АА+АФ.

Что касается 3870 Х2, то в данном случае дал сбой CrossFire, и потому такие низкие результаты у этой карты.

3DMark Vantage: Graphics MARKS

Результаты тестов (ДИАГРАММЫ!!!): 3DMark Vantage: Graphics MARKS

Вот, опять DX10-приложение, плюс оптимизации под новый «попугаемер» (ну куда ж без них, всегда на 3DMark работают целые отделы программистов как в Nvidia, так и в AMD), и мы лицезреем феноменальные результаты у GTX 280.

3DMark06: SHADER 2.0 MARKS

Результаты тестов (ДИАГРАММЫ!!!): 3DMark06 SM2.0 MARKS

И вот обратный пример. Как только дело вступают шейдерные дела предыдущих поколений — новинка спотыкается. И в лидерах ускорители прежних поколений.

3DMark06: SHADER 3.0 MARKS

Результаты тестов (ДИАГРАММЫ!!!): 3DMark06 SM3.0 MARKS

Аналогично.

Выводы

Итак, мы смогли убедиться, что Nvidia сама себя высекла, сродни унтер-офицерской вдове. То есть, погналась за лидерством 2-3 месяца назад, выпустила дорогущий по себестоимости двухпроцессорный гигант 9800 GX2, которому даже полгода не дадут пожить, который, собственно, и испортил малину торжества GTX 280.

Вы посмотрите — какие отменные результаты у нового ускорителя относительно 9800 GTX! Не было бы 9800 GX2, то можно сказать, что вышел второй G80 и принес не менее революционные приросты. Однако Nvidia, зная, что впереди GT200, зачем-то выпустила двухпроцессорный гигант из двух G92, владельцы которого уже могут не смотреть на GTX 280. Более того, новинка еще и дороже, а в ряде тестов проигрывает.

Впрочем, если как следует подумать и поразмыслить, то мы видим, что в DX10-приложениях у нового ускорителя все хорошо, и он впереди. Кроме CRYSIS. Тут явно какая-то проблема. Скорее всего с драйверами. Плюс не стоит забывать про ахиллесову пяту GX2 в виде лагов и резкого изменения мгновенного FPS, присущего всем многопроцессорным технологиям (не во всех, конечно, играх, но во многих).

Начальную цену на GTX 280 нельзя считать приемлемой, однако мы должны понимать, что она искуственно поднята для ограничения спроса, ибо карт в начале продаж будет очень и очень мало.

Возможно, что читатель, который наткнется на данный материал много позже, уже увидит иную картину соотношения цен, и потому сделает для себя иные выводы. Возможно, что последующие версии драйверов исправят ситуацию с проигрышами, и GTX 280 будет везде хорош и станет ярким лидером. Однако не следует забывать, что карта требует для себя 280Вт под нагрузкой, больших токов и наличия 8-пинового хвоста питания. Или наличия переходника на 8-пин.

Карта сам по себе весьма сложна, имеет большие размеры, поэтому еще раз напоминаю, что перед покупкой надо провести замеры в корпусе, и убедиться, что такой ускоритель поместится в нем. Как и то, что никакие разъемы за PCI-E слотом не помешают установке этой карты.

Выбор, как обычно, за нашими читателями. Мы лишь даем информацию о том или ином продукте, но не даем прямых указаний по выбору того или иного изделия.

Еще один момент, который мы будем повторять из обзора в обзор. Придя к решению о самостоятельном выборе трехмерного ускорителя, то бишь видеокарты в своем компьютере, пользователь должен осознавать, что он меняет одну из основных составляющих работы его системного блока, которая может потребовать дополнительной настройки для лучшего быстродействия или включения ряда качественных функций. Это не конечный потребительский продукт, а комплектующее звено. И поэтому пользователь должен понимать, что для получения наибольшей отдачи от новой видеокарты ему придется познать некоторые азы трехмерной графики. И графики в целом. Если он не хочет этим заниматься, то не стоит приступать к самостоятельному апгрейду в этом плане: лучше приобретать готовые системные блоки с настроенным ПО (также он будет обеспечен технической поддержкой со стороны компании-сборщика такого системника), либо приставки для игр, где не надо ничего настраивать, включено то, что надо в самой игре.

И еще: хотим отдельно сказать насчет набора тестовых инструментов:

В обновленном и дополненном материале, посвященном инструменту тестирования FRAPS, мы наглядно показали, как неточны и ненадежны тесты, полученные с помощью этой утилиты, а иного инструмента, кроме встроенных в игры бенчмарков, у тестеров и нет.

Из этой статьи, также из первичного материала становится понятно, что как-то еще сносно (хотя опять же, с огромным потенциалом ошибок, ибо точность измерения зависит от конкретного тестера: вовремя он запустит и выключит FRAPS или же по какой-либо причине опоздает или наоборот раньше положенного момента сделает это) можно тестировать игры со встроенными и ОДИНАКОВО повторяющимися демками. Однако я сам лично сталкивался со случаями, когда в начале прохода демки или в самом конце — идут резкие перепады по нагрузке. И ошибка тестера, который запустил или остановил утилиту на полсекунды или на секунду раньше или позже — приводит к изменению среднего FPS на 15-20%. Это уже не погрешность, а никуда не годный результат. На одной карте запустил чуть раньше, на другой — чуть позже (невольно, разумеется, без умысла) — и получил совсем иную картину соотношений.

Но и это не главное. Дело в том, что таких игр со встроенными демками уже почти не найти. И тестеры идут на соверщенно неприемлемый, с нашей точки зрения, шаг, когда замер в игре делается простым проходом по прямой линии от точки начала загрузки сцены до какой-то условной финишной точки (ближайщего забора, фонаря, дерева и т.д.).

Всем понятно, что нереально пройти ОДИН и тот же путь в игре ТОЧНО ДО МИЛЛИМЕТРА также на разных картах и разных разрешениях. Плюс такие игры всегда вносят элемент случайности в сцену, и объекты даже могут быть расположены чуть иначе на ТОЙ ЖЕ СЦЕНЕ.

К сожалению, читатель на ресурсах, предлагающих огромное число тестов, не найдет — как они тестировали в той или иной игре (кроме тех, где есть бенчмарк)

Поэтому мы считаем, что пусть будет не столь велик набор тестовых игр, но все тесты прозрачны, точны, и, главное, прекрасно отражают картину соотношения ускорителей.

Более полные сравнительные характеристики видеокарт этого и других классов вы можете увидеть также в

наших i3D-Speed и i3D-Quality.

По результатам исследования получает награду в номинации «Оригинальный дизайн» (за июнь) компания Nvidia и:

- Geforce GTX 280 1024MB PCI-E

За то, что смогли в рамках одной PCB уместить такого гиганта с 512-битной шиной, а также обеспечить почти бесшумное охлаждение.

Блок питания для тестового стенда предоставлен компанией TAGAN

Монитор Dell 3007WFP для тестовых стендов предоставлен компанией Nvidia

| Дополнительно |

|