Тестирование массива RAID60 из жестких дисков на двух контроллерах Adaptec

В прошлой публикации я проверил работу трех контроллеров Adaptec разных поколений на массиве RAID6 из восьми жестких дисков. При этом разница в производительности оказалась относительно невелика. Основной причиной является то, что по факту задача по обслуживанию массива такой конфигурации требует не так уж и много ресурсов. Это преимущественно связано с возможностями использованных накопителей — традиционных жестких дисков формата 3,5'' с 7200 RPM и интерфейсом SATA. Их сильной стороной является стоимость в расчете на объем, а никак не скорость. Второе ограничение — конфигурация массива. RAID6 имеет существенные накладные расходы, когда речь заходит об операциях записи, да и на случайных операциях ему особо нечего предложить.

Единственным вариантом увеличения производительности массива, при использовании только жестких дисков, являются конфигурации с цифрой «0» в названии, что означает массив с чередованием. Эта схема обеспечивает повышение скорости благодаря возможности одновременной и независимой работы контроллера с несколькими дисками.

Конечно обычный RAID0 сегодня мало кому интересен, если данные представляют хоть какую-то ценность. А вот RAID50 и RAID60 уже более актуальны. По сути эти конфигурации представляют собой сочетание нескольких групп из RAID5 или RAID6 в массив с чередованием. Плюсом является рост скорости, минусом — снижение полезной емкости массива.

Скажем если речь идет о 24-х дисках, то для них возможно несколько вариантов. Например, две группы по двенадцать дисков с полезной емкостью на 22 диска, или три группы по восемь дисков с полезной емкостью 21 диск и так далее до восьми групп по три диска с полезной емкостью в 16 дисков. При этом увеличение «уровня чередования», напрямую связанное со скоростью, сопровождается увеличением «потерь» на четность — в каждой группе должны быть свои диски четности. Аналогичная схема работает с с RAID60, но с большей избыточностью — от двух групп по двенадцать дисков с полезной емкостью в 20 дисков до шести групп по четыре диска с полезной емкостью в 12 дисков.

Популярные платформы формата 4U позволяют установить до 24 дисков формата 3,5'' с фронтальной стороны сервера и еще 12 можно поставить сзади, если уменьшить пространство для материнской платы до половинной высоты. Итого получается 36 винчестеров. Если речь о полке, где требуется иметь в корпусе только диски, бекплейны, блоки питания и минимальную электронику, то можно рассчитывать на 45 отсеков.

Посмотрим на примере подобного сервера, будут ли отличаться по скорости контроллеры Adaptec 6-й и 8-й серии. В этот раз используется платформа SuperMicro X10SLL-F, процессор Intel Xeon E3-1220 v3 и 32 ГБ оперативной памяти. В ней использовались два бекплейна с экстендерами — на 24 и 12 дисков. Последние были представлены HGST Ultrastar 7K4000 HUS724040ALA640 с интерфейсом SATA и объемом по 4 ТБ.

Конечно, может быть в определенной степени интересно исследовать разные варианты выбора числа дисков в группах, но в данном материале мы для начала ограничимся одним — RAID60 из трех групп по двенадцать дисков, размер блока составляет 128 КБ. Это позволяет получить 30 винчестеров полезной емкости, что в нашем случае составляет около 100 ТБ. Кроме того, часто в массивах предусмотрены диски горячей замены, которых в нашем случае тоже не будет (в частности потому, что тогда было бы максимум только 25 дисков полезной емкости в RAID60).

Остальные условия не изменились – операционная система Debian 9, тестовый пакет fio, работа с «сырым» массивом, проверка на нескольких вариантах параметра iodepth.

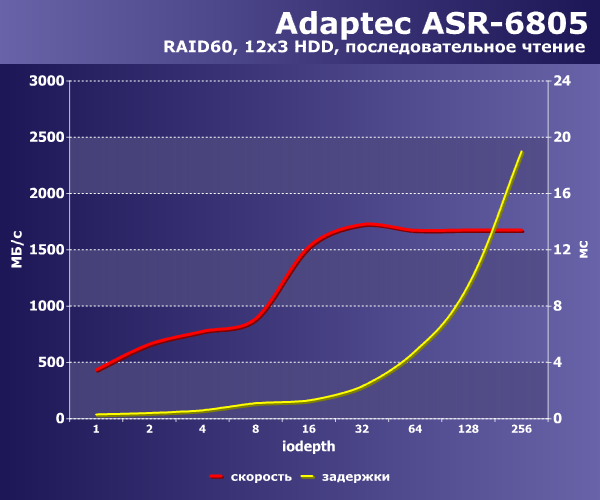

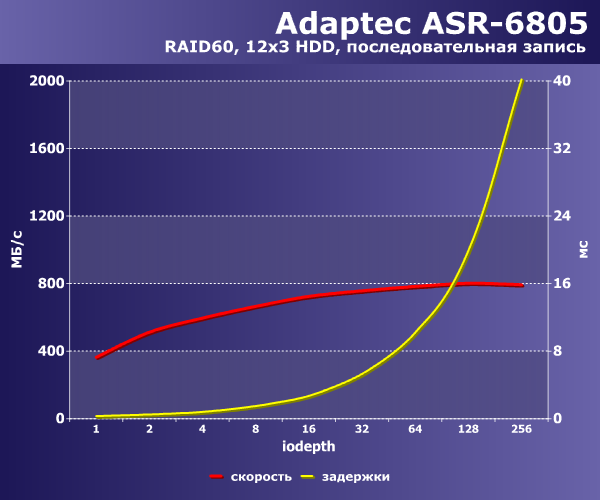

Итак, сначала Adaptec ASR-6508. Как и ранее, на графиках приводятся значения в МБ/с для последовательных операций с блоком 128 КБ (соответствующим размеру блока массива) и IOPS для случайных операций с блоком 4 КБ. Вторая кривая – средние задержки.

|  |

На последовательных операциях конфигурация выдает до 1700 МБ/с на чтение и до 800 МБ/с на запись. В целом неплохо и заметно больше, чем в прошлой статье. Если речь идет о сервере для хранения данных с доступом по сети, в том числе и 10 Гбит/с, контроллера должно хватать. Хотя конечно от такого большого числа винчестеров хочется чего-то большего.

|  |

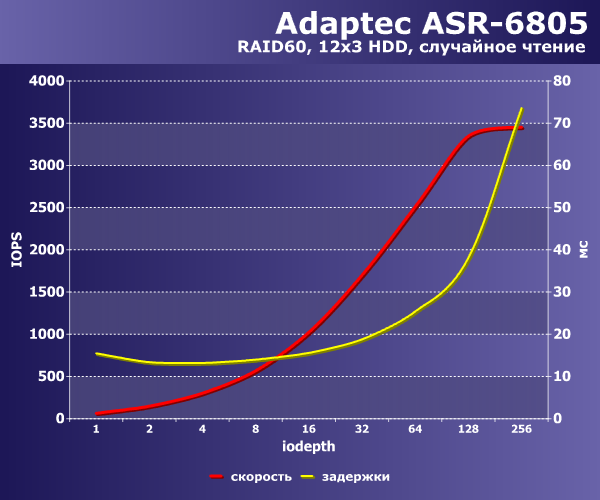

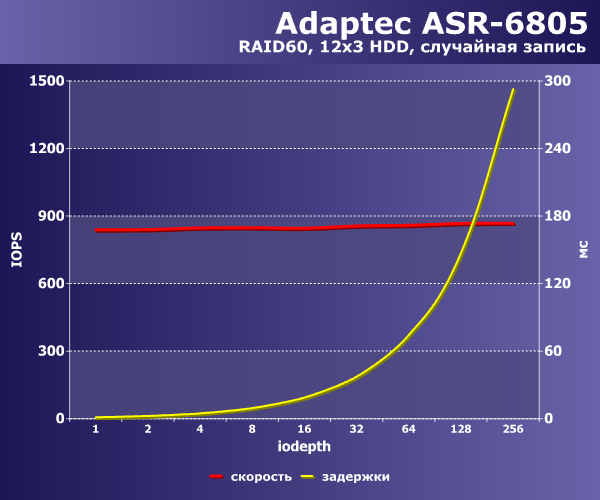

На случайных операциях записи верхняя граница IOPS проходит на значении немногим более 3000. Это почти в три раза больше, чем в прошлом тесте с массивом RAID6. Что касается случайной записи, то здесь стабильно около 850 IOPS, что также выше, чем в предыдущем материале.

Как мы видим, использование сочетания массива с двойной четностью и с чередованием способно улучшить все четыре исследуемых показателя. Ценой этого является увеличение числа дисков для хранения данных четности.

Посмотрим теперь, как поведет себя в этой конфигурации более современной контроллер.

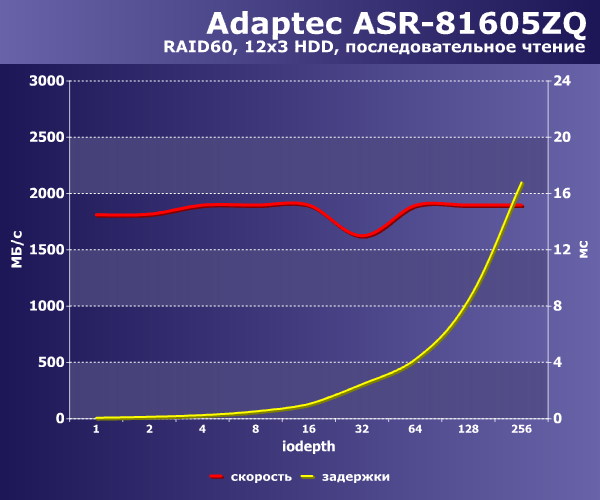

|  |

На последовательных операциях он обеспечивает до 1900 МБ/с на чтение и до 1400 МБ/с на запись. Стоит также обратить внимание на то, что задержки на операциях записи заметно меньше, что говорит о возможности справляться с более высокой нагрузкой. Сравнение с RAID6 такжепоказывает заметное преимущество.

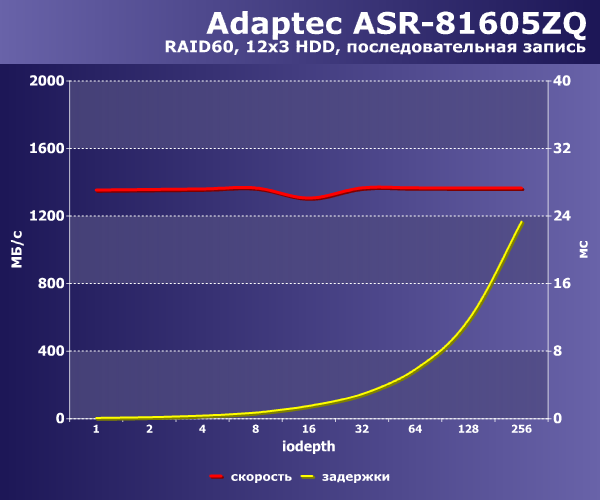

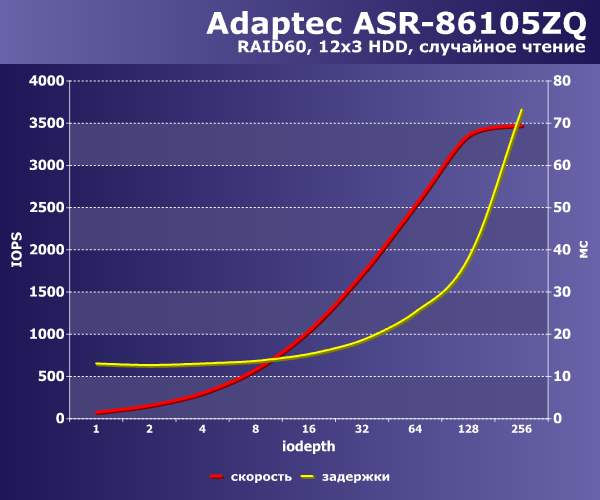

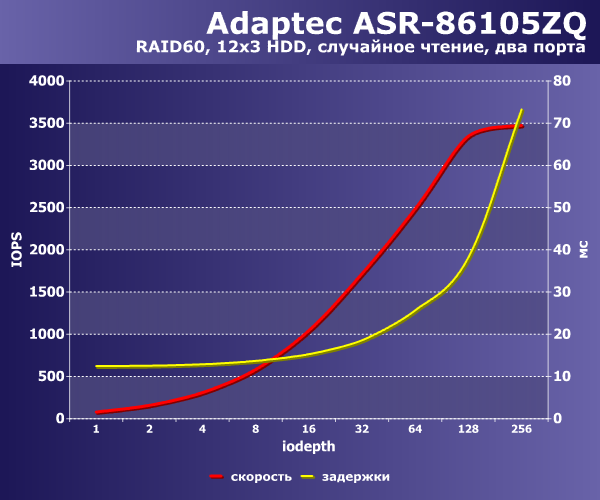

|  |

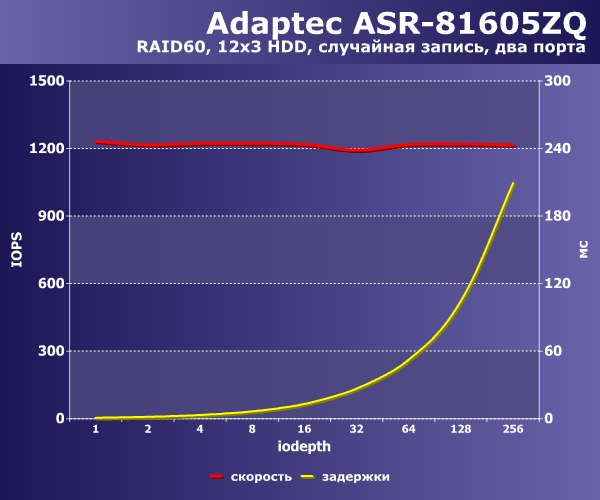

На операциях случайного чтения мы видим аналогичные первому контроллеру результаты – максимальное значение IOPS составляет около 3400 и задержки при большом числе запросов уже велики. А на записи этот контроллер справляется получше – IOPS составляет примерно 1200, что почти в полтора раза лучше, чем у ASR-6805. Напомним, что кроме более быстрого процессора в ASR-81605ZQ больше кэшпамяти.

Еще один вопрос, который мы затронем в этом материале – способы подключения бекплейнов к контроллеру. Вариант без экспандеров сегодня сложно рассматривать серьезно, поскольку RAID-контроллеры на большое число портов существенно дороже, да и ставить сразу несколько контроллеров не всегда удобно.

Поскольку в описываемой конфигурации у нас два бекплейна, то можно придумать два варианта их подключения к контроллеру – один через другой или каждый своим кабелем на отдельный порт контроллера. В описанных выше конфигурациях использовался первый вариант. Он может иметь смысл если только у вас контроллер только на четыре порта с одним разъемом или же если другие порты заняты, например для вывода порта на планку для подключения внешних корзин.

Подключение к разным портам на Adaptec ARS-6805 дает преимущество по производительности только в одном тесте – максимальная скорость последовательного чтения возрастает с 1700 до 2200 МБ/с. Учитывая, что это дается «бесплатно», стоит использовать именно этот вариант подключения, если есть доступные порты. Более интересно посмотреть на ASR-81605ZQ.

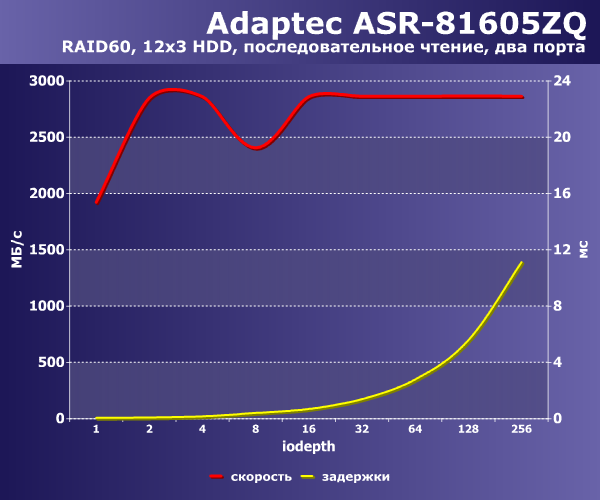

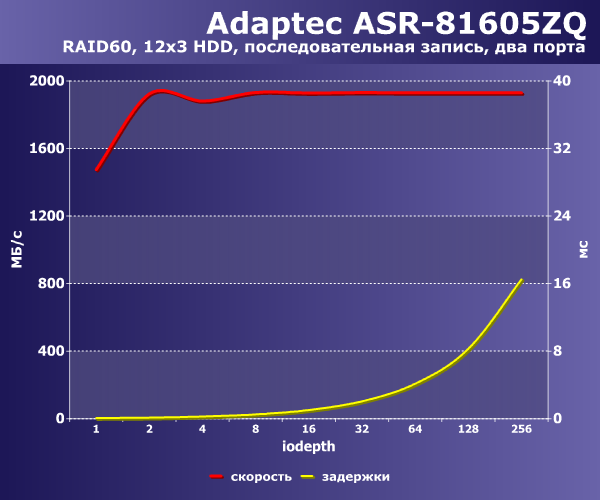

|  |

На последовательных операциях скорость чтения вырастает с 1900 МБ/с до 2900 МБ/с, а записи – с 1400 до 1900 МБ/с, что выглядит очень привлекательно.

|  |

Ну а на производительность случайных операций изменение конфигурации не влияет, что вполне логично, учитывая возможности жестких дисков.

Как мы видим по результатам данного тестирования, массивы с чередованием способны существенно улучшить скоростные показатели решения с традиционными жесткими дисками. Однако это будет связано с уменьшением полезной емкости массива в отказоустойчивой конфигурации. Кроме того, при таком числе винчестеров есть смысл использовать именно последние поколения RAID-контроллеров, которые способны эффективно работать с подобными конфигурациями. Заметное влияние на некоторые показатели имеет и выбранная схема подключения бекплейнов, на что стоит обратить внимание при сборке сервера.

29 комментариев

Добавить комментарий

Если уж сравнивать между собой два контроллера, то хотя бы не так, чтобы во всех тестах узким горлышком были не контроллеры.

Это все равно что сравнивать максимальную скорость двух спорткаров, когда оба с электронным ограничением скорости в 250км/ч.

Ответ Guest_N на коментарий

Да, второй, и разнести диски между ними. Потому когда дисков много, все упирается в скорости передачи.

И в чем смысл «тестировать» в «нерабочей» конфигурации 24 диска в RAID5?

Нагрузка всегда может быть высокой. Не думаю, что для дисков критична разница между «работа в штатном режиме» и «восстановление четности».

Не вопрос, что с 10-м спокойнее. Но стоимость…

Добавить комментарий