DX11 и DX12: а есть ли между ними разница?

Сменяются видеокарты, игры, процессоры, а смена DX11 на DX12 тянется еще с 2015 года, поэтому многие и забыли, чем эти версии отличаются друг от друга, и что же принесет новая API. В большей части на этом лежит вина и самого Microsoft, так как они сделали DX12 достоянием исключительно Win10, заявив что на более старых системах DX12 невозможно реализовать, но не так давно появилась информация, что поддержка DX12 все же появится на win7, и первой игрой будет World of Warcraft. В результате долгое время компьютеров с поддержкой DX12 было крайне мало, чтобы разработчикам игр вообще стоило обращать на этот сегмент свое внимание. Пожалуй, только сама Microsoft и ее дочерние игровые компании перешли на полноценный выпуск игр на DX12, но среди них не было значимых шедевров, и, пожалуй, самая узнаваемая серия — это Forza Horizon.

Однако, на начало 2019 года ситуация стала меняться, и, прежде всего, мы уже видим в статистике STEAM, что большинство компьютеров (64.53%) уже имеют как видеокарту так и операционную систему, совместимую с DX12, и стоит напомнить, что последнее поколение приставок Microsoft и Sony тоже поддерживают DX12, что в итоге дает нам абсолютное большинство игровых устройств DX12 ready.

В итоге мы видим, что на конец 18 и начало 19 года все больше и больше игр отказываются от DX11 как основного API в пользу как DX12, так и Vulkan. Вот их список:

- Lara Croft Shadow of the Tomb Raider

- Resident evil 2 (remake)

- Crackdown 3

- Metro Exodus

- The Division2

- Devil may cry 5

Готовятся к выходу и, скорее всего, будут иметь поддержку Vulkan или DX12

- DOOM Eternal

- Wolfenstein Youngblood

- Serious Sam 4

- Star wars fallen order

- Rage 2

Поскольку мы выяснили, что для полномасштабного ввода DX12 есть как готовность со стороны пользователей, так и достаточное кол-во крупных проектов, то стоит освежить знания о этом API. Вероятнее всего, вы считаете, что самым главным отличием DX12 от своего предшественника является возможность трассировки лучей, и на этом все отличия заканчиваются, но это вовсе не так. Давайте взглянем на отличия этих двух версий, чтобы нам лучше понимать, чего эти версии могут и не могут, и что реально принесет DX12.

Помимо упомянутой трассировки лучей DX12 включал в себя такую технологию как Multi Gpu — это возможность объединения нескольких видеокарт даже различных производителей для обработки изображения. Звучит здорово, но, на мой взгляд, технология имеет мало шансов на широкое применение, и вот почему. Для разработчика игр придется сначала заставить работать просто неимоверное кол-во различных вариаций видеокарт, потом еще это все протестировать, а это очень много времени и очень много затрат, а выгоды от введения сомнительны. Для разработчика GPU это будет означать, что можно купить менее мощную видеокарту и установить ее параллельно, причем это может быть видеокарта их конкурента, в итоге это будет влиять на среднюю цену купленных у них устройств — для достижения искомой производительности можно будет покупать видеокарту классом ниже. Вообще стоит вспомнить SLI и CrossFire - много ли игр поддерживают эти технологии? Вот мы и добрались до наиболее значимых отличий DX12 от предшественника — работа с потоками CPU.

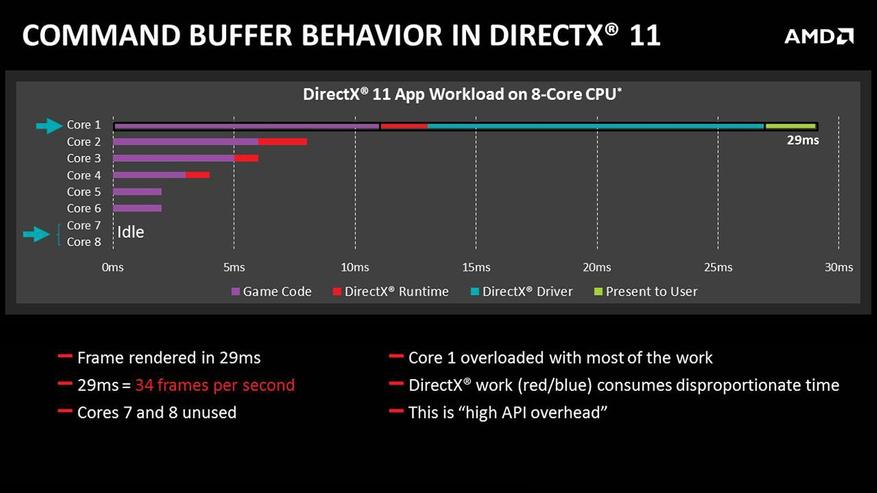

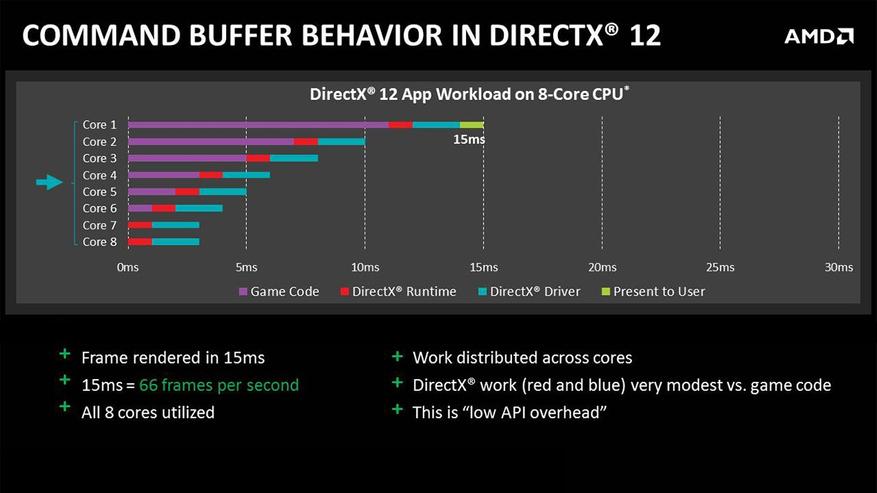

Таким образом выглядит пример работы игры с DX11: один поток отвечает за обработку видео, на остальных работают другие части движка, например звуковой движок, сетевая часть, расчет NPC и так далее, главное, что за самую емкую и сложную часть отвечает только 1 ядро процессора. Теоретически DX11 может работать максимум с двумя потоками, но, к сожалению, как показывает практика, это остается только теорией. DX12 уже способен работать с восемью потоками, и выглядит это так:

DX12 распределяет по потокам/ядрам самую объемную задачу по подготовке данных и последующей обработке их на GPU, что влияет положительно на производительность. Производительность, разумеется, не вырастает в 8 раз, так как этот процесс не идеально масштабируемый, и есть и другие узкие места. Забавно отметить, что результаты работы в случае всего одного потока или восьми отправляются на GPU о обрабатываются тысячами ядер CUDA или CU в зависимости от вендора GPU.

Что же происходит с данными попавшими в GPU?

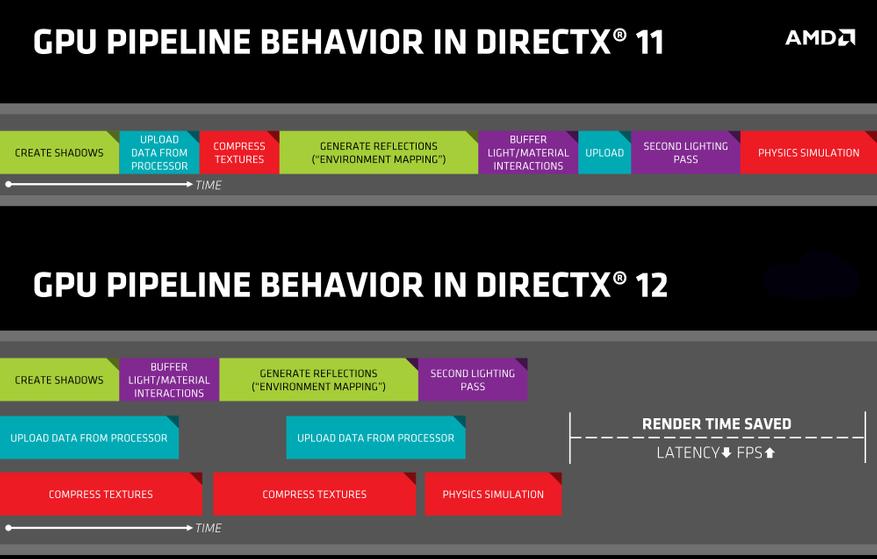

Вверху видна последовательность обработки данных DX11, которая происходит в строго установленном порядке, и без выполнения предыдущих задач следующие не могут быть реализованы, тогда как DX12 имеет возможность разделения и исполнения этих задач на разных ядрах нашего GPU, что обеспечивает большую загрузку самого GPU и приводит к уменьшению задержек и росту FPS. Важно отметить, что скорость исполнения самих элементов, из которых состоит вся задача, не увеличивается. Весь выигрыш в производительности достигается только за счет оптимизации очереди — это и называется асинхронные вычисления.

Давайте теперь взглянем на то, что же конкретно подготавливает CPU для последующей обработки на GPU, если конечную картинку мы видим в таком виде:

То процессор передает каркас изображения в виде сетки полигонов для последующей закраски — аналогия с деткой книжкой-раскраской более чем уместна.

Каждый из полигонов обрабатываются на CPU и называется вызовом отрисовки или draw call. Соответственно, чем больше полигонов в кадре мы видим, тем больше нагрузка на CPU, такие ситуации наиболее характерны для игр с открытым миром и появления большого количества объектов в кадре, особенно если это очень детализированные объекты как NPC. В других случаях — когда мы смотрим в небо или видим незначительное кол-во полигонов в каком-нибудь ограниченном пространстве, например, коридоре, где вызовов отрисовки не так много, преимущества DX12 тают. Давайте перейдем к выводам из теоретической части знакомства с DX12.

В визуальном плане DX12 имеет очень скудные преимущества перед DX11 - лучи это самое яркое отличие.

Программирование под DX12 сложнее, и все преимущества нового API раскрываются полностью, только когда движок изначально разрабатывается, а не адаптируется под него.

Для несложных сцен, где в кадре мало объектов/предметов и полигонов, DX12 может показывать меньшую производительность по сравнению с DX11, так как все вызовы отрисовки прекрасно успевают обрабатываться на 1 ядре процессора, а в случае с DX12 результаты работы восьми потоков надо еще синхронизировать. Это может быть верно для целых игр, а не просто сцен, если они в своей основе имеют несложную графику.

DX12 не снижает нагрузку на процессор, а, наоборот, увеличивает, только при этом нагрузка распределяется до 8ми ядер/потоков процессора а не ложится на 1 ядро.

Выигрыш от перехода на DX12 будет у процессоров с небольшой производительностью на ядро, но большим их количеством, например, как серия FX от AMD.

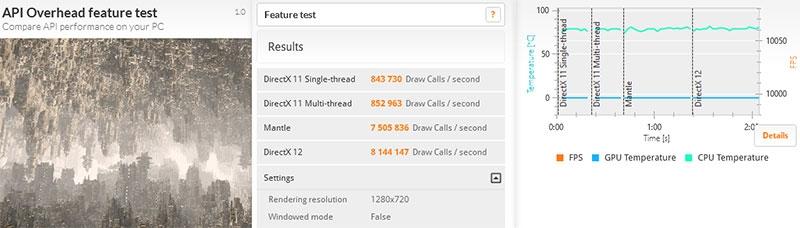

Синтетический тест 3D mark Api Overhead Test https://3dnews.ru/911658

Наблюдаем в кадре то самое большое количество объектов, и результат — отличие на порядок,- это действительно огромная разница, даже если сделать скидку на то, что это синтетический тест.

Игровые тесты

Тестовая конфигурация

- FX 6300 @4500

- DDR3 2133

- RX 580 8GB

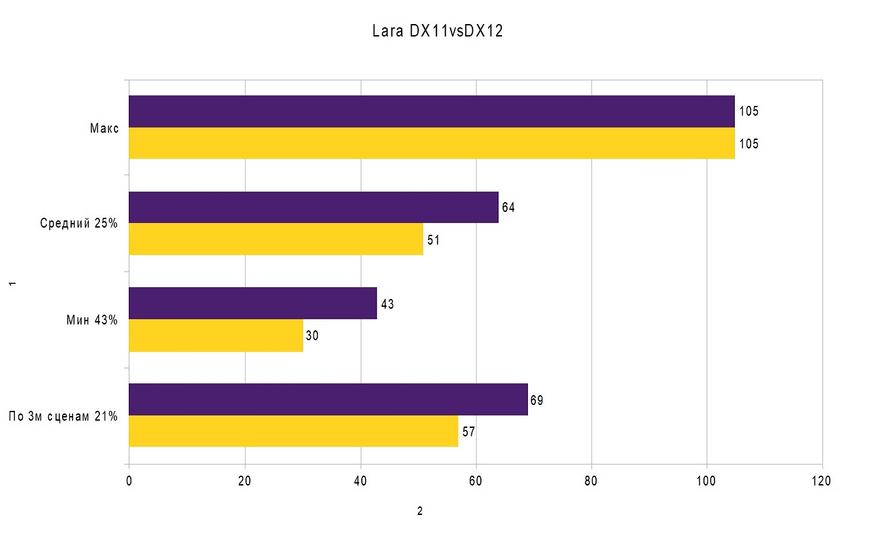

Lara Croft Shadow of the Tomb Raider

Для рассмотрения возьмем последнюю сцену из 3х тестовых отрезков — она наиболее характерна большим количеством вызовов отрисовок.

Обратите внимание на загрузку процессора: слева DX11 74%, справа DX12 100%.

Первые 3 значения относятся к последней сцене теста, четвертое же значение — это результат по всем трем сценам. Примечательно что максимальный кадр, который был отмечен, был в момент показа именно куска неба, и разницы между API нету, в то время как наибольшая разница отмечена именно в минимальных кадрах, и достигает она внушительных 43%. То есть, в самых графически нагруженных сложных сценах мы видим наибольшую пользу от перехода на DX12.

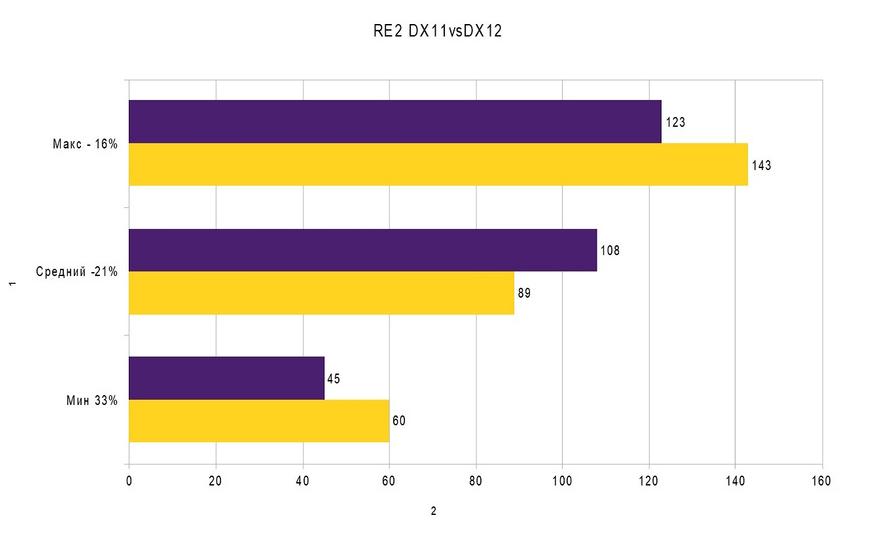

Resident Evil 2 remake

В этом тесте мы видим куда менее тривиальные результаты: падение максимального и среднего кадра, но и подъем минимальных значений аж на целых 33%. То есть, в моментах, где производительности 1 потока вполне хватает, DX11 даже быстрее, но как только сцена усложняется и производительности 1 потока недостаточно, DX12 раскрывается, что переносит весь игровой процесс до 60+ кадров, а DX11 опускается до условно неиграбельных 45. Боюсь именно с такими результатами и связана такая нелюбовь тестеров к DX12, так как в нем может быть меньше максимальных кадров, и даже, что может показаться совсем неприемлемым, и средние кадры, однако, как ни парадоксально, DX12 при этом более комфортен для игры.

Давайте перейдем к связкам с другим видеокартами и процессорами и понаблюдаем за результатами. Для этого выберем 4 игры:

- Lara Croft Shadow of the Tomb Raider

- Resident Evil 2 remake

- Division2

- Metro Exodus

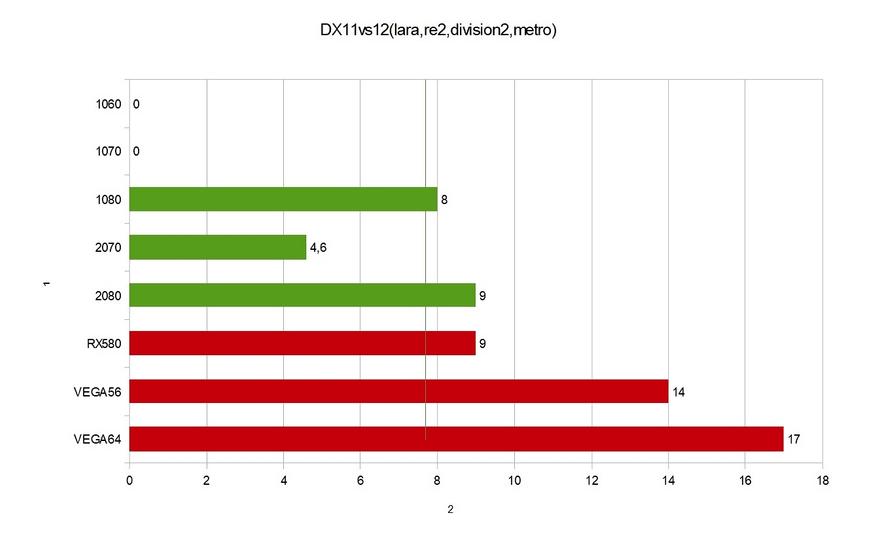

Все эти игры работают как в режиме DX11, так и DX12. Давайте сравним, каковы будут изменения от смены API. Во всех тестах в качестве CPU применялся 9900K в разгоне до 5.0. Другими словами, мы увидим ситуацию, когда процессор не ограничивал нашу производительность.

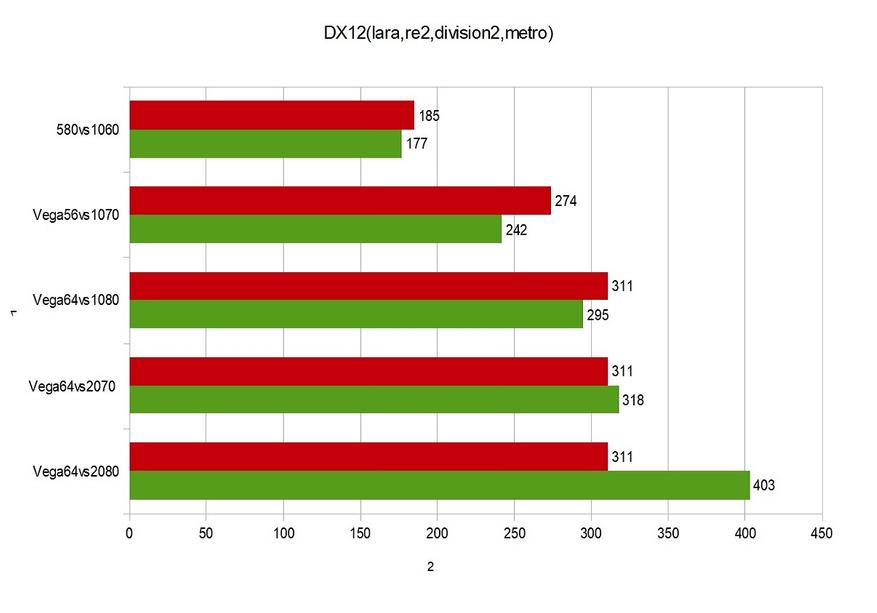

Данные в таблице — это изменения в % между API. Интересно, что видеокарты семейства Pascal по-разному реагируют на DX12, несмотря на одинаковую архитектуру в их основе, прироста на младших моделях нет, связано ли это с работой драйвера или аппаратной части, находится за рамками этого блога. Нужно констатировать только одно: на видеокартах, формально имеющих поддержку DX12_1, прироста от перехода на новый API может не быть. С другой стороны, видеокарта RX 580, формально имеющая поддержку только DX12_0, дает прирост в 9% как топовая GTX 2080, прирост у видеокарт Vega доходит до 17%, что является просто потрясающим результатом. В любом случае мы замечаем прирост на последних сериях видеокарт от 5% до почти 20% производительности, и это очень значительное изменение. Что можно сказать — даже в связке с мощным процессором на современных видеокартах переход на DX12 оправдан и увеличивает производительность, если провести подобные тесты с менее производительным процессором, то отличия будут еще более существенны.

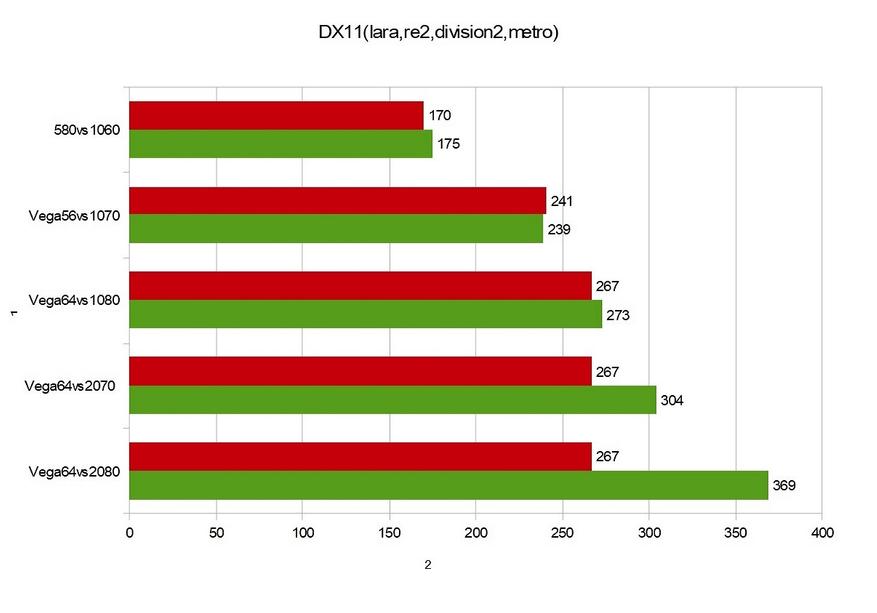

Справедливо будет заметить, что у компании Nvidia традиционно была хорошая производительность под DX11, и можно было бы предположить, что DX12 просто мог не давать таких преимуществ как у конкурентов. Давайте немного отвлечемся от темы сравнения API и взглянем более пристально на сами видеокарты.

Что ж, в DX11 видим тотальное доминирование продуктов Nvidia, и только Vega 56 немного опережает своего визави в виде GTX1070.

Однако при переходе на DX12 ситуация кардинально меняется, и Vega 56 опережает GTX 1070 уже на 13% и отстает на 7,6% от GTX1080, Vega 64 же опережает GTX 1080 5.4% и не дотягивает до RTX 2070 всего 2%! Да, похоже, AMD не зря в своих презентациях много внимание уделяла DX12 — действительно, их продукция намного лучше чувствует себя под новым API.

В качестве вывода можно сказать, что для владельцев старых процессоров, которые приобрели одни из последних серий видеокарт, переход на DX12 в любимой игре даст ощутимую прибавку производительности вплоть до 50%, при использовании DX12 на топовых видеокартах и процессорах выигрыш DX12 может составлять 10-20%, что тоже крайне не мало, поэтому все больше и больше разработчиков обращают внимание на новый API, и если в 19 году как минимум 50% из крупных, так называемых AAA, игр вышло с поддержкой DX12, то с выходом консолей нового поколения как от Microsoft, так и от Sony игровая индустрия окончательно перейдет на новый стандарт, поэтому при покупке видеокарты уже сейчас стоит обращать внимание преимущественно на тесты именно в этом API. Поэтому, скажем, новые серии Turing в виде 1660 1660ti 1650 1650ti могут быть намного привлекательнее, чем это могло бы казаться на первый взгляд т.к. по сравнению с 1050ti,1060, 1070 они действительно быстрее работают под новым API.

Результаты последних тестов взяты со страниц сайта gamegpu.com

Больше моих тестов и обзоров вы найдете на моем youtube канале.

P.S. Говоря о различиях Vulkan и DX12, надо упомянуть, что в состав последнего входит DirectX Audio, который стандартизирует работу с аудио, что очень сильно упрощает разработку, в Vulkan подобного нет. Так же эти API отличаются в топологии своей работы, и программирование под ними несколько разное, но основная цель DX12 и Vulkan - это отвязать работу вызовов отрисовки от одного лишь ядра, и с этой задачей оба API справляются.

36 комментариев

Добавить комментарий

В самом начале я сказал что текущие консоли уже поддерживают новые API.

Анонс нового Xbox стоит ожидать на E3 2019.

Теперь что касается приставок. Тут экономика АМД предлагает своей железе дешевле но как я сказал выше что оно поддерживает хорошо DX12 по вышеуказанной причине не означает что производители ПО будут это тотально использовать. Проще говоря я думаю большинство игр на приставках так останется DX11. Минусы останутся как было например с той же пс4. Когда из-за торзмонутого АМД железа пришлось в скором времени выпускать обновление т.н. ПРО версия. Со слегка обновленным железом в части быстродействия.

Ну и выводы какие. Так как это блог а следовательно СУБЪЕКТИВНОЕ МНЕНИЕ АВТОРА. То он имеет на это право как я имею право высказать свое мнение тут. Ну а выводы и свои мнения каждый сделает для себя сам.

https://www.guru3d.com/articles_pages/the_division_2_pc_graphics_performance_benchmark_review,7.html

было даже падение но при средней температуре этого разумеется не будет. Просто цифры роста будут меньше как и средняя температура по больнице где лишь из 10 пациентов 3 сдохли у 3 нормальная температура а у 4 жар. Отсюда и получается вполне нормальная температура 36,6.)))

Например тут и то и то было

https://www.guru3d.com/articles-pages/hitman-2-2019-pc-graphics-dx12-performance-update,1.html

Как видим DX12 не всегда дает реальный буст но нагружает систему больше. Бывает иногда что наоброт кол-во кадров катастрофически падает от перехода на него. Можно было бы сказать что он сырой но слишком много времени прошло. Скорей всего просто он не для игр как и мультипоточность сама по себе которая в нем заявлялась сразу как чудо. По крайне мере не для игр на той архитектуре которая сейчас есть. Поэтому аудитория как и игроделы относятся как вы правильно сказали скептичски и думаю будут продолжать это делать смотря тесты. DX12 повторяет историю DX10 по мне. Мелкие кстати недавно это поняли наконец поэтому и включили заднюю начиная внедрять поддержку DX12 в Windows 7.

А весь ваш блог это истеричная попытка оправдать DX12 потому что имено он по тестам и позволяет хоть как то конкурировать АМД с другими в играх. Но так как это блог поэтому в данном случае вы имеете на это право. В новостях же или обзорах по мне подобное не допустимо.

Что они сделали — протестили только 1660ti! (это легко понять перейдя в результаты теста только она дает 74 в hd 48 в 2к итд) и не нашли разницы, почему так получилось сказать сложно, т.к остальные тьюринги дают прирост в DX12

https://www.playground.ru/blogs/tom_clancys_the_division_2/raznitsa_v_proizvoditelnosti_tom_clancys_the_division_2_na_dx11_i_dx12_mozhet_dostigat_20_fps-341143/

«Разница в производительностиThe Division 2 на DX11 и DX12 может достигать 20 FPS

Журналисты, однако, отметили, что наибольший прирост наблюдается у минимальных значений счетчика кадров. Например, самым низким показателем при DirectX 11 является 59 FPS, в то время как на DirectX 12… целых 80 FPS. Впечатляющая разница.» — прям как в моем блоге))) И по дивизии огромное кол-ва тестов где dx12 видно что быстрее, так что пример с гуру 3д это реальное исключение.

Хитман 2 это пример старой игры к которой «прикрутили» dx12 и это пример ужасно криворуких разработчиков, в первом хитмане ввели dx12 у них он лагал они потом его убрали, не удивлюсь что и из этой части с такой-то «оптимизацией» они его уберут тоже.

p.s. игровой рынок все расставить точки над i. Хотя по мне это он уже давно сделал. Иначе бы DX11 давно бы каналу в лету как в свое время было с DX10.

p.s. ссылаться на плейгранду к тому же на блоги в нем это тот еще трешь по мне. Ибо там такую дикость порой пишут. Да кстати вот оригинал новости на которую твой блог плейграундовский ссылался

https://www.dsogaming.com/news/the-division-2-runs-significantly-faster-in-dx12-over-20fps-increase-in-cpu-ram-limited-scenarios/

там видюха 2080Ti использовалась. Неужели так и не понял почему DX12 в тени. Ответ такой же как и с CPU. Для получение разницы по сравнению с DX11 ему как и на CPU требуются значительно большие мощности. Я думаю причина в его мультипоточности. Ибо повторюсь чем больше потоков тем меньше эффективность каждого последующего. DX12 это своего рода медаль которая имеет две стороны.

))

В целом я оч рад опыту размещения на ixbt т.к. за 1.5 суток блог прочитали 2600 человек. Мое видео на youtube с аналогичным содержанием набрало 80 просмотров за 3 недели.

Зеленая компания уже даже диктует правила того, как надо тестировать видеокарты (кто не знает поищите ситуацию с Hardware Unboxed которые оч благоволили к зеленым) это вырвалось на свет только благодаря тому что они стати диктовать условия уж оч крупному изданию, а мне известно что и ранее они предоставляли свои карты по программе раннего доступа на условиях того что давались указания с тем как надо тестировать, все это искажает реальную ситуацию с производительностью. Тут можно вспомнить еще ситуацию с GPP… В общем ничего нового в этом мире)))))

Я бы мог продолжать этим всем заниматься, но для хобби это вызывает слишком много лютой ненависти у людей в интернетике, а доказывать доказывать что-то очередным ежикам это бессмысленно, его сейчас ткнуть в то что он писал что «DX12 не нужен» он скажет «я не это имел в виду» я как-то поймал представителя одной компании на том что он обмолвился про % того насколько их продукт превосходит в производительности конкурента, а я вот такой негодяй взял и посчитал % и у меня совершенно иной % получился!!! он такие пируэты мысли начал выдавать я такого честно в жизни не услышу никогда.

Почему — на 2? Между DX12 (8 144 147) и DX11 (843 730) отличие в 1 порядок.

Dx12 ускоряет работу как на CPU(больше потоков) так и на GPU(из-за асинхронных вычислений). На game developer conference 16 года https://cdn3.dualshockers.com/wp-content/uploads/2016/03/IMG_2050.jpg заявили что асинхронные вычисления приносят 5-10% производительности, но при этом их сложно настроить. Действительно старые видеокарты Nvidia не смотря на то что они формально DX12_1 совместимы не умеют корректно работать с асинхронными вычислениями, в том числе в этом заключается что прирост производительности в %м соотношении на видеокартах АМД выше.

Они примерно такого же уровня как и у Д.Прилепских. Методы аппроксимации, экстраполяции и т.д через эксель.

Да и эффект наблюдательной селекции никто не отменял. Для уровня понимания большинства это означает что «млрд мух не могут ошибаться».

Помнится такое было ещё при появлении первых Athlon X2, тогда тоже многие «эксперты» отрицали нужность многопоточности CPU в пользовательских компах. Потом на Windows XP быстро затычку выпустили, чтобы ОС могла юзать оба потока CPU.

То, что DX12 и даже DX12.1, а точнее игры с поддержкой этих API, ещё сырые — это никто не отрицает, но отрицать нужность многопоточности в играх в обсчёте графики — верх дЭбилизма! Вот скажите мне дураку, зачем напрягать только одно ядро многоядерного CPU на всё, когда можно передать, например, обсчёт NPC, погоды и т.д. на другие ядра CPU? Уж, например, состояние погоды в игре никак уж не нужно принципиально синхронизировать с действиями ГГ, то нахрена нагружать то единственное ядро CPU, что отвечает за геймплей ГГ?

Да, DX10 неудачен и был выпущен DX11, как его замена, но их обоих время прошло. Да, сложней правильно написать игру под DX12, но всё равно, все со временем перейдут на DX12, но скорей всего появится какой-нибудь DX13 взамен не удачному DX12, как это было с DX10 и DX11.

Я таких дурков нызваю «долбики» )

Добавить комментарий