Теоретическая часть: особенности архитектуры

Мы продолжаем рассматривать модели видеокарт нового семейства GeForce RTX 30, основанные на архитектуре Ampere, которые компания Nvidia представила в этом году. Предыдущие решения архитектуры Turing были революционными из-за аппаратной поддержки трассировки лучей и аппаратного ускорения задач искусственного интеллекта. Но производительности тех GPU порой не хватало, а в этом году стали доступны новые технологии производства полупроводников, что позволило улучшить в архитектуре Ampere именно производительность, хотя и некоторые новые возможности также появились.

Благодаря оптимизации и производству по более тонкому техпроцессу, игровые решения архитектуры Ampere примерно в 1,5-1,7 раза быстрее аналогичных Turing в традиционных задачах растеризации и до 2 раз быстрее при трассировке лучей. Еще одна важная характеристика нового семейства GeForce RTX 30 — приемлемые цены, принесшие значительное улучшение соотношения цены и производительности по сравнению с предыдущим семейством GeForce RTX 20.

Игровые видеокарты на базе архитектуры Ampere были анонсированы во время виртуального мероприятия в начале сентября, когда были представлено три модели: RTX 3070, RTX 3080 и RTX 3090. Мы уже рассмотрели две дорогие, основанные на разных модификациях чипа GA102, а сегодня у нас в обзоре, пожалуй, самая интересная видеокарта из анонсированных — RTX 3070, имеющая самую доступную цену. Она основана на графическом процессоре GA104, стоящем на шаг ниже GA102. Предварительные данные о производительности новинки говорят о том, что целью Nvidia было получение производительности топового решения GeForce RTX 2080 Ti из предыдущего поколения, но в ином ценовом сегменте.

При этом GA104 сохранил все ключевые особенности старшего чипа GA102, и RTX 3070 отличается от RTX 3080 и RTX 3090 разве что применением типа памяти GDDR6, а не нового GDDR6X. Но для ее уровня производительности этого вполне достаточно. Куда важнее то, что все технологии и особенности новой архитектуры Ampere остались и в младшем чипе. GeForce RTX 3070 не только обеспечивает производительность топовой видеокарты недавнего времени, но и поддерживает все новые технологии. Что касается скорости нового GPU, то при FP32-вычислениях он обеспечивает производительность более 20 терафлопс, а это больше, чем у RTX 2080 Ti. Но главное, что новинка будет продаваться за $499 (чуть больше 45 тысяч рублей)!

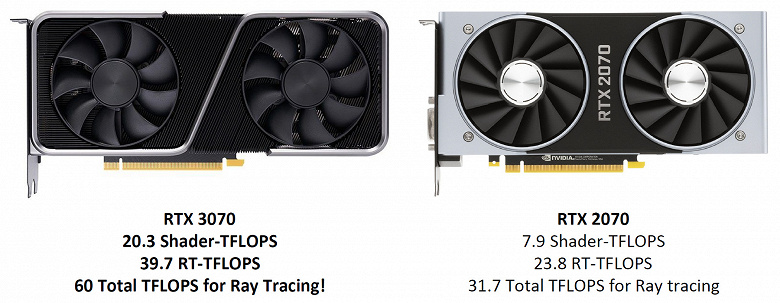

Сама Nvidia сравнивает Ampere с Pascal — графические процессоры той архитектуры были значительно быстрее предыдущей Maxwell. Nvidia считает, что Ampere дает скачок производительности даже еще больший, по сравнению с Turing. Посмотрите на показатели RTX 3070 сами — практически все они вдвое выше, чем у модели RTX 2070 семейства Turing. Похоже, настало самое удачное время для апгрейда! Правда, если не будет проблем с доступностью новых GPU в продаже, как это случилось со старшими моделями линейки GeForce RTX 30.

Понятно, что в играх у новинки все прекрасно — даже по нескольким примерам игр с применением растеризации и трассировки лучей хорошо видно преимущество GeForce RTX 3070 перед той моделью, последователем дела которой она является — GeForce RTX 2070. Разница между ними порядка 60% в пользу видеокарты семейства Ampere. По сути, новинка обеспечивает скорость RTX 2080 Ti (с вдвое более высокой ценой на момент ее выхода более двух лет назад) архитектуры Turing, что очень впечатляет.

Но не только игроков может заинтересовать сегодняшняя новинка. Все большее количество профессионалов используют графические процессоры для ускорения своей работы и повышения комфорта при разработке. Возможно, большинство из них выберет более мощные старшие варианты, но кому-то вполне хватит и RTX 3070 для их задач. Ведь она дает в 1,6-2,3 раза более высокую производительность в приложениях для создания 3D-контента по сравнению с RTX 2070, да и RTX 2080 Ti частенько обходит.

Основой рассматриваемой сегодня модели видеокарты стал новый графический процессор архитектуры Ampere, но так как она имеет достаточно много общего с предыдущими архитектурами Turing, Volta и местами даже Pascal, то перед прочтением материала мы советуем ознакомиться и с нашими предыдущими статьями:

- [30.09.20] Nvidia GeForce RTX 3090: самое производительное, но не чисто игровое решение

- [18.09.20] Nvidia GeForce RTX 3080, часть 2: описание карты Palit, игровые тесты, выводы

- [16.09.20] Nvidia GeForce RTX 3080, часть 1: теория, архитектура, синтетические тесты

- [08.10.18] Обзор новинки 3D-графики 2018 года — Nvidia GeForce RTX 2080

- [19.09.18] Nvidia GeForce RTX 2080 Ti — обзор флагмана 3D-графики 2018 года

- [14.09.18] Игровые видеокарты Nvidia GeForce RTX — первые мысли и впечатления

- [06.06.17] Nvidia Volta — новая вычислительная архитектура

- [09.03.17] GeForce GTX 1080 Ti — новый король игровой 3D-графики

| Графический ускоритель GeForce RTX 3070 | |

|---|---|

| Кодовое имя чипа | GA104 |

| Технология производства | 8 нм (Samsung «8N Nvidia Custom Process») |

| Количество транзисторов | 17,4 млрд (у TU104 — 13,6 млрд) |

| Площадь ядра | 392,5 мм² (у TU104 — 545 мм²) |

| Архитектура | унифицированная, с массивом процессоров для потоковой обработки любых видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12 Ultimate, с поддержкой уровня возможностей Feature Level 12_2 |

| Шина памяти | 256-битная: 8 независимых 32-битных контроллеров памяти с поддержкой памяти типа GDDR6 |

| Частота графического процессора | до 1725 МГц |

| Вычислительные блоки | 46 потоковых мультипроцессоров (из 48 в полном чипе), включающих 5888 CUDA-ядер (из 6144 ядер) для целочисленных расчетов INT32 и вычислений с плавающей запятой FP16/FP32/FP64 |

| Тензорные блоки | 184 тензорных ядер (из 192) для матричных вычислений INT4/INT8/FP16/FP32/BF16/TF32 |

| Блоки трассировки лучей | 46 RT-ядра (из 48) для расчета пересечения лучей с треугольниками и ограничивающими объемами BVH |

| Блоки текстурирования | 184 блоков (из 192) текстурной адресации и фильтрации с поддержкой FP16/FP32-компонент и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растровых операций (ROP) | 12 широких блоков ROP на 96 пикселей с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16/FP32-форматах буфера кадра |

| Поддержка мониторов | поддержка HDMI 2.1 и DisplayPort 1.4a (со сжатием DSC 1.2a) |

| Спецификации референсной видеокарты GeForce RTX 3070 | |

|---|---|

| Частота ядра | до 1725 МГц |

| Количество универсальных процессоров | 5888 |

| Количество текстурных блоков | 184 |

| Количество блоков блендинга | 96 |

| Эффективная частота памяти | 14 ГГц |

| Тип памяти | GDDR6 |

| Шина памяти | 256-бит |

| Объем памяти | 8 ГБ |

| Пропускная способность памяти | 448 ГБ/с |

| Вычислительная производительность (FP32) | до 20,3 терафлопс |

| Теоретическая максимальная скорость закраски | 166 гигапикселей/с |

| Теоретическая скорость выборки текстур | 317 гигатекселей/с |

| Шина | PCI Express 4.0 |

| Разъемы | один HDMI 2.1 и три DisplayPort 1.4a |

| Энергопотребление | до 220 Вт |

| Дополнительное питание | один 8-контактный разъем |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $499 (45 490 рублей) |

Наименование третьей модели из нового поколения соответствует принципу наименования решений компании, выше нее стоят только более дорогие RTX 3080 и RTX 3090. Рекомендованная цена для GeForce RTX 3070 составляет $499, да и ценовая рекомендация для нашего рынка в 45490 рублей кажется довольно выгодной, особенно с учетом падения курса национальной валюты в последнее время. О повышенном интересе покупателей именно к этой модели мы и не говорим — очень похоже, что она имеет все шансы стать бестселлером, если получится наладить стабильные поставки.

Пока что у RTX 3070 на рынке просто нет конкурентов. Модели предыдущего поколения в свое время продавались дороже, да и сейчас RTX 2080 Ti не осталось смысла покупать по цене RTX 3070. Топовый Turing имеет преимущество разве что по объему видеопамяти, и если кому-то недостаточно 8 ГБ видеопамяти у RTX 3070, то вполне можно обратить внимание и на модель прошлого поколения. Но по производительности новинка ей не уступит, а иногда будет быстрее, особенно при трассировке лучей. Да и технологии некоторые новые она поддерживает, которых нет у Turing.

В очередной раз нам пока что нечего сказать о конкурентах со стороны компании AMD, хотя они тоже вот-вот будут объявлены, а уж когда появятся в продаже — пока что неизвестно. Скорее всего, лишь в декабре. Что касается имеющегося на рынке, то Radeon VII давно устарел, а Radeon RX 5700 XT является решением более низкого уровня. Так что с большим нетерпением ждем аналогичных решений на базе архитектуры RDNA2, способных конкурировать с GeForce RTX 3070 по всем статьям.

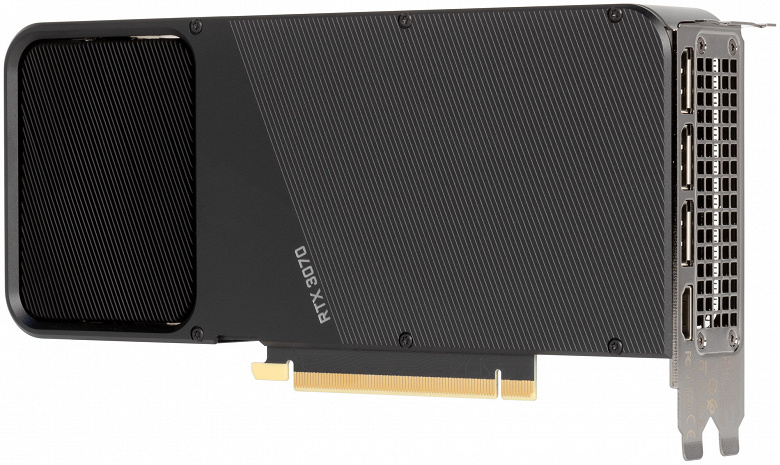

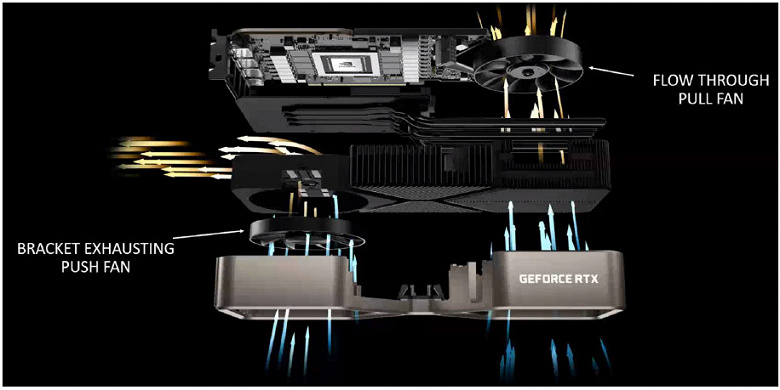

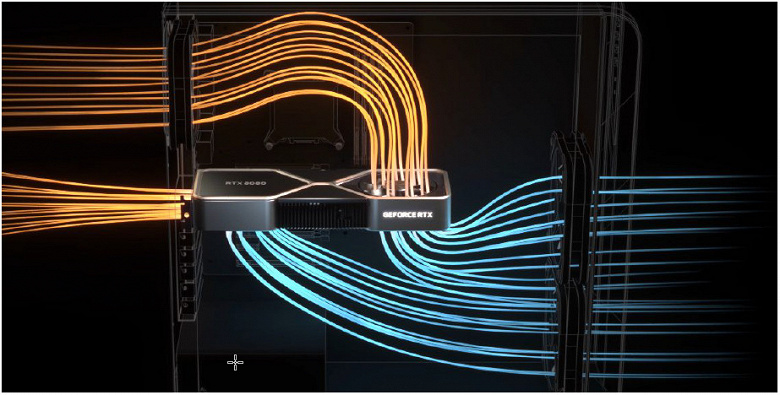

Аналогично моделям RTX 3080 и RTX 3090, компания Nvidia предлагает собственный вариант RTX 3070 Founders Edition. Такие видеокарты предлагают любопытные системы охлаждения и строгий дизайн, которого не найти у большинства производителей видеокарт, гонящихся за количеством и размером вентиляторов, а также разноцветной подсветкой. Самое интересное в GeForce RTX 30, продаваемых под собственным брендом Nvidia — совершенно новый дизайн системы охлаждения с двумя вентиляторами, один из которых привычно выдувает воздух через решетку с торца платы, а второй протягивает воздух прямо сквозь видеокарту. Единственная разница по сравнению со старшими моделями в том, что у RTX 3070 вентилятор установлен не с обратной стороны карты, но принцип его работы ровно тот же.

В результате RTX 3070 FE предлагает тихую и эффективную систему охлаждения, неплохо включающуюся в большинство систем охлаждения в корпусах ПК. Тепло отводится от различных компонентов на карте к радиатору, левый вентилятор выводит нагретый воздух через большие вентиляционные отверстия в рамке видеокарты, а правый направляет воздух к выдувному вентилятору в верхней части корпуса, где он обычно установлен в большинстве современных систем.

При создании этой модели Founders Edition, инженеры компании хорошо поработали над компактностью печатной платы — как и в старших видеокартах, это сделано для того, чтобы второй вентилятор продувал воздух через радиатор напрямую, без препятствий. В итоге, по замерам Nvidia, кулер RTX 3070 до 16 дБА тише и на 44% эффективнее охлаждает GPU, по сравнению с кулером RTX 2070 Founders Edition. Младшая из трех моделей семейства GeForce RTX 30 также использует новый формат 12-контактного разъема питания, позволяющий эффективнее разместить некоторые элементы на карте.

Видеокарта модели GeForce RTX 3070 в теории должна появиться в продаже в ближайшие дни, но в связи с возможным недостаточным объемом производства, огромным спросом и дефицитом старших видеокарт семейства GeForce RTX 30, достоверно что-то утверждать сложно. Скорее всего, эту видеокарту еще придется поискать в продаже, особенно по хорошей цене, но есть некоторые признаки того, что сделать это будет проще, чем с RTX 3080. Естественно, партнеры компании выпустили и карты собственного дизайна: Asus, Colorful, EVGA, Gainward, Galaxy, Gigabyte, Innovision 3D, MSI, Palit, PNY, Zotac и другие.

Архитектурные особенности

При производстве графического процессора GA104 используется все тот же техпроцесс 8 нм компании Samsung, оптимизированный для нужд Nvidia, который мы уже знаем по GA102. Младший чип Ampere содержит 17,4 миллиарда транзисторов и имеет площадь 392,5 мм² — это хороший шаг вперед по сравнению Turing, ведь примерно аналогичный по позиционированию TU104 имеет 13,6 млрд. транзисторов, а TU102 лишь чуть больше — 18,6 млрд. При этом, площадь схожего по сложности TU102 равна 754 мм², а менее сложного TU104 — 545 мм². Даже TU106 имеет площадь в 445 мм², а ведь он значительно проще и медленнее.

Так что по плотности размещения транзисторов техпроцесс Samsung довольно неплох, он позволил снизить площадь GPU при повышении количества транзисторов, а вот по параметрам максимальных частот и энергопотреблению он хоть и лучше, чем 12 нм у TSMC, но, судя по имеющимся данным, уступает техпроцессу 7 нм тех же тайваньцев. Скорее всего, Nvidia выбрала его исходя из себестоимости и доступности массового производства немаленьких чипов. Да и выход годных на заводе Samsung может быть лучше, и условия для Nvidia наверняка особые, тем более, что производственные мощности TSMC заняты другими компаниями.

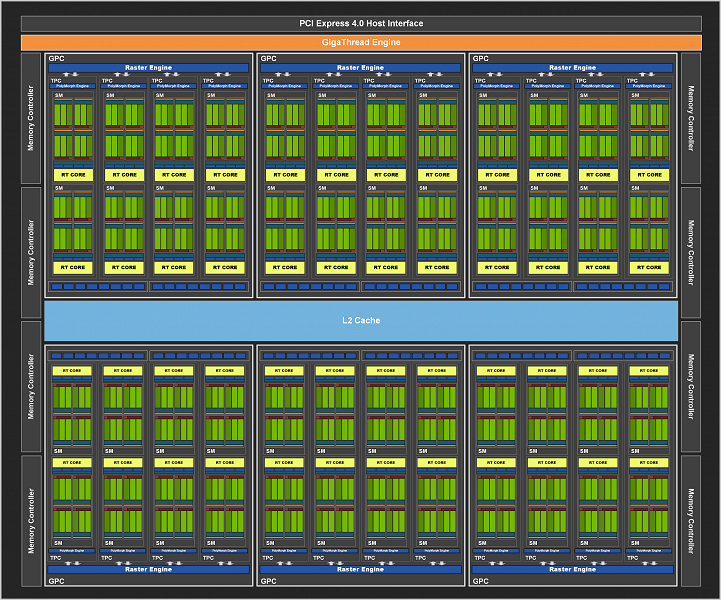

Как и все чипы Nvidia, GA104 состоит из укрупненных кластеров Graphics Processing Cluster (GPC), которые включают несколько кластеров текстурной обработки Texture Processing Cluster (TPC), содержащих потоковые процессоры Streaming Multiprocessor (SM), блоки растеризации Raster Operator (ROP) и контроллеры памяти. Полный чип GA104, схему которого мы видим ниже, содержит шесть кластеров GPC и 48 мультипроцессоров SM. Каждый GPC содержит по четыре TPC, состоящих из пары SM и движка PolyMorph Engine для работы с геометрией.

GPC — это высокоуровневый кластер, включающий все ключевые блоки для обработки данных внутри него, каждый из них имеет выделенный движок растеризации Raster Engine и в Ampere включает два раздела ROP по восемь блоков каждый. В итоге, полный GA104 содержит 6144 потоковых CUDA-ядра, 48 RT-ядер второго поколения и 192 тензорных ядра третьего поколения. Подсистема памяти GA104 содержит восемь 32-битных контроллеров памяти, что дает 256-бит в общем. Каждый 32-битный контроллер связан с разделом кэш-памяти второго уровня объемом в 512 КБ, и общий объем L2-кэша получается равным 4 МБ.

Но это мы говорили о полном чипе, а модель видеокарты GeForce RTX 3070 использует слегка урезанный по количеству блоков вариант GA104. Эта модификация получила количество блоков SM, меньшее на два — то есть, в одном из GPC просто отключили один кластер TPC с парой мультипроцессоров. Соответственно, отличается и количество остальных блоков, новый GPU имеет 5888 CUDA-ядер, 184 тензорных ядра и 46 RT-ядра. Текстурных блоков в этой модификации 184 штук, а вот блоки ROP активны все — 96.

Важное отличие RTX 3070 от старших моделей заключается в подсистеме памяти. У новинки в наличии 8 ГБ GDDR6-памяти, известной нам по предыдущим поколениям GPU, а не новой GDDR6X, которая была разработана совместно с Micron и применяется только в двух старших моделях. Память у RTX 3070 подключена по полной 256-битной шине, что дает чуть менее полутерабайта пропускной способности. Интересно, что у RTX 2080 Ti пропускная способность на четверть выше, но это не дает ей преимущества в большинстве реальных задач. Видимо, современные игры не слишком требовательны к ПСП, да и алгоритмы внутричипового сжатия достаточно эффективно работают.

Теперь что касается объема видеопамяти. Некоторым может показаться, что RTX 3070 будет не хватать 8 ГБ памяти. Но пока что игры даже в 4K-разрешении при максимальных настройках действительно не требуют большего объема памяти. Они могут занимать его и даже как-то использовать, но ускорения при увеличении объема от 8 до 16 ГБ никакого не будет. Есть лишь одна оговорка — скоро выйдут консоли нового поколения с большим объемом памяти и быстрыми SSD, и в будущем некоторые мультиплатформенные или портированные с консолей игры могут начать требовать большего, чем 8 ГБ локальной видеопамяти. Но пока что этого объема точно хватает.

Подробно рассматривать архитектурные улучшения Ampere в этой статье мы не будем, все уже было написано в теоретическом материале по GeForce RTX 3080. Основным нововведением Ampere является удвоение FP32-производительности для каждого мультипроцессора SM, по сравнению с семейством Turing, что привело к значительному повышению пиковой производительности. Почти то же самое касается и RT-ядер — хотя их число и не изменилось, внутренние улучшения привели к удвоению темпа поиска пересечений лучей с геометрией. Улучшенные тензорные ядра хоть и не удвоили производительность при обычных условиях, но темп таких вычислений удвоился, а также появилась возможность удвоения скорости обработки так называемых разреженных матриц.

Все остальные архитектурные особенности игровых решений Ampere, включая изменения в мультипроцессорах SM, блоках ROP, системе кэширования и текстурирования, тензорных и RT-ядрах, подробно рассмотрены в теоретическом обзоре RTX 3080. Все улучшения привели к достижению довольно высокой энергоэффективности, вся архитектура Ampere делалась с упором на это, включая доработанный техпроцесс Samsung, дизайн чипов и печатных плат, оптимизацию ПО и многое другое. Что получилось у Nvidia в результате — мы узнаем в практических частях материала.

Технологии и программная поддержка

Младшая модель GeForce RTX 3070 поддерживает все технологии, появившиеся и улучшенные в семействе Ampere. Мы еще раз отметим набор технологий RTX IO, который в будущем обеспечит быструю передачу и распаковку ресурсов на GPU, и повысит производительность системы ввода-вывода в десятки раз, по сравнению с привычными HDD и традиционными API. RTX IO в будущем обеспечит очень быструю загрузку ресурсов игры и позволит создавать более разнообразные и детализированные виртуальные миры.

RTX IO распаковывает данные при помощи потоковых процессоров GPU, это осуществляется асинхронно — при помощи высокопроизводительных вычислительных кернелов, используя механизмы прямого доступа к памяти архитектур Turing и Ampere, также помогает в процессе улучшенный набор инструкций и новая архитектура мультипроцессоров SM, позволяющая использовать расширенные асинхронные вычислительные возможности. Но без соответствующих изменений в операционной системе технологию использовать не получится. Разработчикам придется ждать, пока Microsoft реализует эти возможности в их собственном DirectStorage API.

Переходим к особенностям программной поддержки, которая всегда очень важна, ведь при любом аппаратном обеспечении его работа просто невозможна без соответствующего ПО. Так, весьма важно применение новых технологий Nvidia, появившихся в семействе Turing и имеющихся в Ampere: RTX и DLSS. Пожалуй, мы бы хотели еще более активного их внедрения в игры, но это тормозится как парком старых GPU в существующих игровых системах, так и отсутствием поддержки трассировки в консолях нынешнего поколения.

Тем не менее, Nvidia терпеливо занимается с разработчиками для внедрения их технологий в игры. И уже вышли или совсем скоро выйдут следующие проекты: Ghostrunner — с поддержкой трассированных отражений и теней, а также DLSS, инди-проект Pumpkin Jack, имеющий трассированные отражения и тени, а также улучшенное освещение и DLSS, и Xuan-Yuan Sword VII — который вот-вот выйдет и предложит трассированное глобальное освещение и технологию улучшения производительности DLSS.

Также будут обновлены в ноябре и получат поддержку технологий Nvidia еще четыре уже вышедшие игры: Edge of Eternity получит поддержку DLSS, Mortal Shell будет использовать трассировку для рендеринга теней, также в игре поддерживается и DLSS, в Mount & Blade II: Bannerlord добавится DLSS, а обновление World of Warcraft: Shadowlands принесет трассированные тени. Еще пара игр с поддержкой технологий RTX выйдут в ранний доступ или бета-тестирование: Enlisted — с трассированным глобальным освещением и DLSS, Ready or Not — с трассированными отражениями, тенями, глобальным затенением и DLSS. Эти игры станут доступны ближе к концу года.

Но самыми долгожданными являются такие хиты, как: Watch Dogs: Legion — выходящая 29 октября и предлагающая трассированные отражения и технологию DLSS, Call of Duty: Black Ops Cold War с датой выхода 13 ноября, предлагающая поддержку трассировки лучей и DLSS, ну и супермегапроект Cyberpunk 2077, выход которого назначен на 19 ноября. В самой ожидаемой игре года будет применяться трассировка лучей для рендеринга отражений, теней, глобального затенения и рассеянного освещения, также заявлена и поддержка DLSS.

Очень широкое распространение в последние месяцы получил киберспорт, чему изрядно помогла ситуация с карантинами и изоляциями, связанными с распространением коронавируса по нашей планете. Взять хотя бы автогонки — многие месяцы реальные гонки не проводились, а их заменили виртуальные, в которых участвовали гонщики различных серий, включая Формулу 1. Да и обычные пользователи не отставали — популярность сетевых сражений в этом году изрядно выросла. А рука об руку с сетевыми играми идет и стриминг и сетевое общение.

Но сначала поговорим о самом киберспорте. Вместе с Ampere компания Nvidia представила технологию Reflex, которая предназначена для того, чтобы игроки получили минимальные задержки при игре в соревновательных проектах. Чтобы ускорить реакцию ПК на действия игрока и предназначен новый набор технологий, оптимизирующих и измеряющих задержки системы. Технология Reflex Low-Latency, встроенная в популярные киберспортивные игры Apex Legends, Call of Duty: Warzone, Destiny 2, Fortnite и Valorant, значительно снижает задержки. Причем, технология не является уникальной для Ampere, а работает на всех видеокартах, начиная с серии GTX 900.

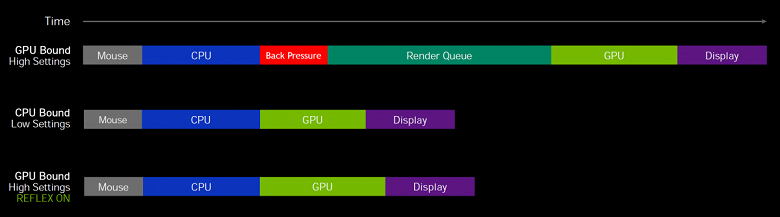

В киберспортивных состязаниях низкая задержка и лучшая отзывчивость системы приводит к лучшим результатам и победам, ведь там важна каждая миллисекунда. Более низкие системные задержки означают лучшую отзывчивость и это ощущается даже больше, чем высокая частота кадров. Последняя измеряет пропускную способность, а не задержку между действиями игрока и выводом на экран соответствующего действия.

Исследования показали, что снижение задержек приводит к улучшению точности прицеливания в играх, что вполне логично. Reflex — технология для снижения системной задержки, сочетающая оптимизации со стороны графического процессора и игр. В случаях, когда производительность ограничена графическим процессором, Reflex SDK позволяет CPU начать передачу работы по рендерингу в GPU сразу перед тем, как он завершит предыдущий кадр, что значительно сокращает, а зачастую и вовсе устраняет очередь рендеринга. Хотя это и похоже на режим сверхнизкой задержки в драйвере, он работает лучше, так как этот метод работает в самом игровом движке.

Nvidia Reflex SDK интегрируется или уже встроен во все популярные киберспортивные игры. Применение Reflex SDK также позволяет повысить частоты GPU для быстрого расчета и вывода подготовленных кадров на экран чуть раньше обычного — в некоторых случаях, когда общая производительность ограничена скоростью центрального процессора. Эта возможность аналогична ранее известной функции «Prefer Maximum Performance», доступной из панели настроек драйверов Nvidia.

Но самое заметное снижение задержек будет наблюдаться в сценариях, когда общее время рендеринга ограничено мощностью GPU, то есть в высоких разрешениях и при максимальных графических настройках, когда очереди рендеринга велики. GPU средней мощности, вроде GTX 1660 Super, получают приличное снижение задержек в Full HD-разрешении, даже по сравнению с технологией Nvidia Ultra Low Latency (NULL), а для мощных видеокарт типа RTX 3080, технология Reflex позволяет наслаждаться высоким разрешением рендеринга без соответствующих потерь в отзывчивости, которые обычно наблюдаются при росте разрешения.

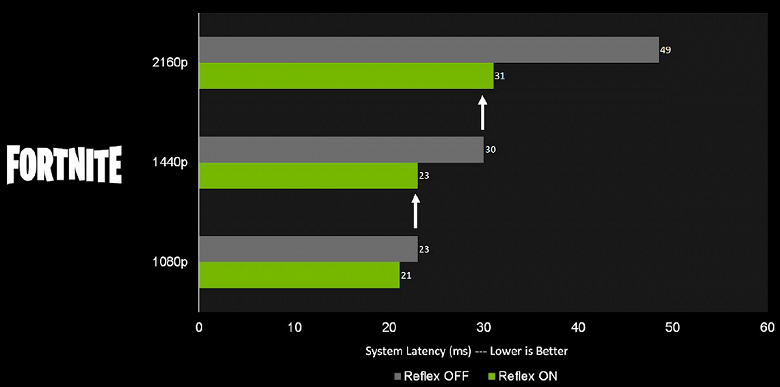

Как видно по диаграмме, чем выше разрешение, тем большее снижение задержек дает применение Reflex. Правда, нужно учитывать, что более низкое разрешение в любом случае даст меньшие задержки, чем применение Reflex в высоком разрешении. Но применение этого режима позволяет в 4K-разрешении получить отзывчивость, аналогичную разрешению 2560×1440 в обычном режиме, а в 2560×1440 задержки будут аналогичны тому, что обычно получаются в Full HD. А высокое разрешение имеет свои плюсы, ведь врагов будет проще рассмотреть с большого расстояния.

Ну а технология Reflex Latency Analyzer определяет входной сигнал с мыши и измеряет время до появления результата на экране — без необходимости использования специального оборудования вроде скоростных камер, как это было необходимо ранее. Эта технология встроена в новые 360-герцовые дисплеи Nvidia G-Sync Esports, которые появятся осенью у Acer, Alienware, Asus и MSI. Она поддерживается и в периферийных устройствах производства компаний Asus, Logitech, Razer и SteelSeries и позволяет оценить реальные задержки при игре.

А теперь перейдем к просмотру и трансляции виртуальных сражений. Игровых стримеров в этом году смотрят почти вдвое более массово, чем в прошлом, а число соответствующих каналов выросло почти в полтора раза. В мире более двух десятков миллионов стримеров разной популярности, и каждый игрок может им легко стать, особенно при помощи современных программных и аппаратных средств компании Nvidia.

Для этого можно использовать программное обеспечение Nvidia Broadcast — универсальный плагин, улучшающий качество звука с микрофонов и изображения с веб-камер при помощи ускоренных на решениях GeForce RTX инструментов с применением искусственного интеллекта — таких, как шумоподавление, наложение виртуальных фонов и автокадрирование камеры. Мы уже писали ранее об этом ПО.

Broadcast поддерживается на всех решениях GeForce, Titan и Quadro RTX, и использует выделенные тензорные ядра для работы нейросетей в реальном времени. А для самого стриминга можно использовать аппаратный кодировщик видеоданных Nvidia Encoder, разгружающий CPU от этой задачи и обеспечивающий приемлемое качество записи. Все популярные приложения для стриминга поддерживают технологию и оптимизированы для графических процессоров Nvidia.

Одной из возможностей Nvidia Broadcast стало шумоподавление, помогающее избавиться от нежелательных фоновых звуков при общении по сети или записи звука. По сравнению с ранней бета-версией RTX Voice, новые аппаратные и программные оптимизации привели к снижению нагрузки на систему вдвое (тестирование на GeForce RTX 3080 показывает падение FPS лишь на 3%), а число шумовых профилей выросло втрое — благодаря ранней поддержке от бета-тестеров. Также Broadcast включает новые возможности по замене фона и автоматическому кадрированию, но они пока что находятся в бета-стадии разработки и требуют дальнейшей оптимизации.

Также видеостримингу очень поможет полная аппаратная поддержка декодирования видеоданных в формате AV1. Да, пока что это «всего лишь» декодирование, но зато оно полностью аппаратное, а значит — максимально эффективное. Все решения семейства GeForce RTX 30 имеют поддержку этого формата, который более эффективен, по сравнению с существующими вариантами: H264, H265 и VP9. Применение AV1 позволяет снизить требования к битрейту для передачи видео высокого разрешения вплоть до 50%-55% по сравнению с H.264, что делает его отличным вариантом для видеороликов на YouTube в форматах 4K, 8K и 8K HDR.

Кроме этого, Nvidia работает с производителями телевизоров. Так, совместная работа с LG позволила получить поддержку технологии G-SYNC в 8K-разрешении на соответствующих OLED-телевизорах корейской компании. И если для игры в таком разрешении вам нужна GeForce RTX 3090, то уж видеоролики смотреть можно и при помощи RTX 3070. Вообще, именно OLED-телевизоры производства LG идеально подходят для нового семейства видеокарт Nvidia, они имеют очень низкие задержки и высокую отзывчивость в игровых режимах, поддерживают адаптивную частоту обновления G-SYNC Compatible, а также 4K- и 8K-разрешение с HDR.

Поддержка разъемов HDMI 2.1 всеми видеокартами семейства Ampere позволяет подключать 8K-телевизоры всего лишь по одному кабелю, а для 4K-разрешения доступна частота обновления 120 Гц, также поддерживаемая лучшими телевизорами LG. Также очень важно, что новые видеокарты GeForce RTX 30 умеют захватывать и записывать видео в 8K-разрешении для стриминга при помощи GeForce Experience и функции Shadowplay, которая поддерживает запись видео в форматы вплоть до 8K HDR с 30 FPS.

Особенности видеокарты Nvidia GeForce RTX 3070 Founders Edition

Сведения о производителе: Компания Nvidia Corporation (торговая марка Nvidia) основана в 1993 году в США. Штаб-квартира в Санта-Кларе (Калифорния). Разрабатывает графические процессоры, технологии. До 1999 года основной маркой была Riva (Riva 128/TNT/TNT2), с 1999 года и по настоящее время — GeForce. В 2000 году были приобретены активы 3dfx Interactive, после чего торговые марки 3dfx/Voodoo перешли к Nvidia. Своего производства нет. Общая численность сотрудников (включая региональные офисы) — около 5000 человек.

Объект исследования: ускоритель трехмерной графики (видеокарта) Nvidia GeForce RTX 3070 Founders Edition 8 ГБ 256-битной GDDR6

Характеристики карты

| Nvidia GeForce RTX 3070 Founders Edition 8 ГБ 256-битной GDDR6 | |

|---|---|

| GPU | GeForce RTX 3070 (GA104) |

| Интерфейс | PCI Express x16 4.0 |

| Частота работы GPU (ROPs), МГц | 1440—1725(Boost)—1950(Max) |

| Частота работы памяти (физическая (эффективная)), МГц | 3500 (14000) |

| Ширина шины обмена с памятью, бит | 256 |

| Число вычислительных блоков в GPU | 46 |

| Число операций (ALU/CUDA) в блоке | 128 |

| Суммарное количество блоков ALU/CUDA | 5888 |

| Число блоков текстурирования (BLF/TLF/ANIS) | 184 |

| Число блоков растеризации (ROP) | 96 |

| Число блоков Ray Tracing | 46 |

| Число тензорных блоков | 184 |

| Размеры, мм | 240×100×35 |

| Количество слотов в системном блоке, занимаемые видеокартой | 2 |

| Цвет текстолита | черный |

| Энергопотребление пиковое в 3D, Вт | 224 |

| Энергопотребление в режиме 2D, Вт | 30 |

| Энергопотребление в режиме «сна», Вт | 11 |

| Уровень шума в 3D (максимальная нагрузка), дБА | 34,4 |

| Уровень шума в 2D (просмотр видео), дБА | 18,0 |

| Уровень шума в 2D (в простое), дБА | 18,0 |

| Видеовыходы | 1×HDMI 2.1, 3×DisplayPort 1.4a |

| Поддержка многопроцессорной работы | нет |

| Максимальное количество приемников/мониторов для одновременного вывода изображения | 4 |

| Питание: 8-контактные разъемы | 1 (12-контактный) c адаптером на 8-контактный разъем |

| Питание: 6-контактные разъемы | 0 |

| Максимальное разрешение/частота, Display Port | 7680×4320@60 Гц |

| Максимальное разрешение/частота, HDMI | 7680×4320@60 Гц |

| Максимальное разрешение/частота, Dual-Link DVI | 2560×1600@60 Гц (1920×1200@120 Гц) |

| Максимальное разрешение/частота, Single-Link DVI | 1920×1200@60 Гц (1280×1024@85 Гц) |

| Ожидаемая розничная стоимость карты | около 50 тысяч рублей на момент подготовки обзора |

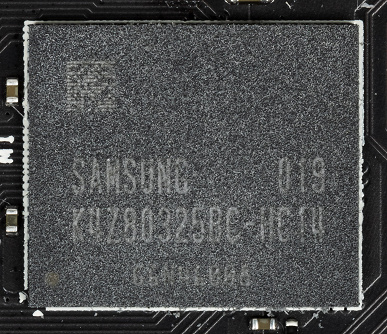

Память

Карта имеет 8 ГБ памяти GDDR6 SDRAM, размещенной в 8 микросхемах по 8 Гбит на лицевой стороне PCB. Микросхемы памяти Samsung (GDDR6, K4Z80325BC-HC14) рассчитаны на условную номинальную частоту работы в 3500 (14000) МГц.

Особенности карты и сравнение с Nvidia GeForce RTX 2070 Super Founders Edition

| Nvidia GeForce RTX 3070 Founders Edition 8 ГБ | Nvidia GeForce RTX 2070 Super Founders Edition 8 ГБ |

|---|---|

| вид спереди | |

|

|

| вид сзади | |

|

|

Прежде всего: почему мы сравниваем с GeForce RTX 2070 Super? Формально GeForce RTX 3070 является преемником как раз GeForce RTX 2070 Super (про GeForce RTX 2070 уже нет смысла вспоминать). И там, и там 8 гигабайт GDDR6, а также 256-битная шина обмена с памятью.

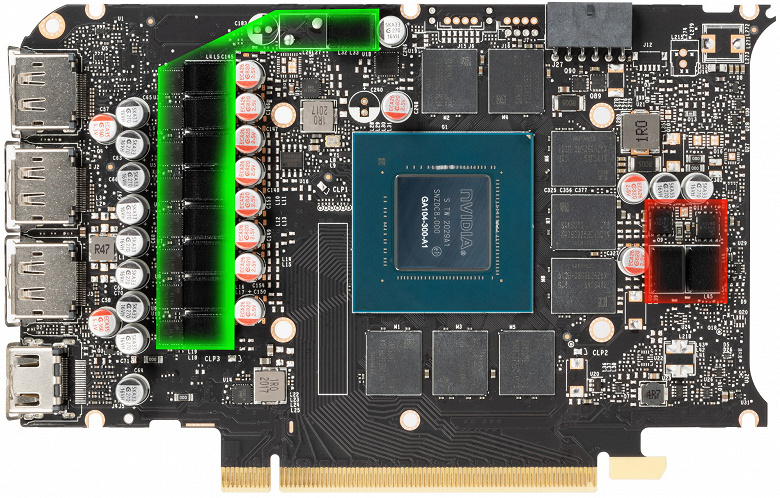

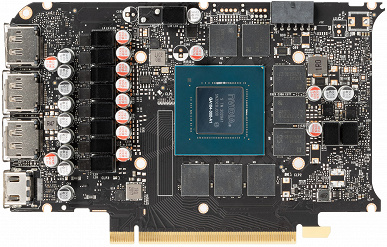

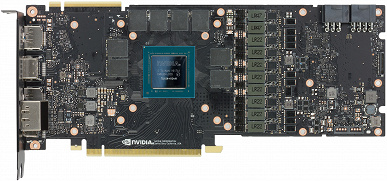

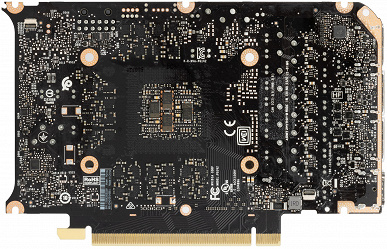

Мы уже отмечали, что для семейства GeForce RTX 30 инженеры Nvidia разработали кардинально новый референс-дизайн, и в данном случае мы видим развитие эталонного дизайна для продуктов, имеющих более простую компоновку, всего 8 микросхем памяти и систему питания попроще. Как и в случае с GeForce RTX 3080 и GeForce RTX 3090, в Nvidia сделали два варианта дизайна PCB: для своих карт Founders Edition и для партнеров. Относительно решения из прошлого поколения новая фирменная карта получилась очень компактной при той же шине обмена с памятью.

Суммарное количество фаз питания у GeForce RTX 3070 — 11 (это на 1 больше, чем у GeForce RTX 2070 Super). При этом распределение фаз у GeForce RTX 2070 Super — 8 фаз на ядро и 2 на микросхемы памяти, а у GeForce RTX 3070 — 9+2. Физически имеется возможность установки еще одной фазы (на ней сэкономили).

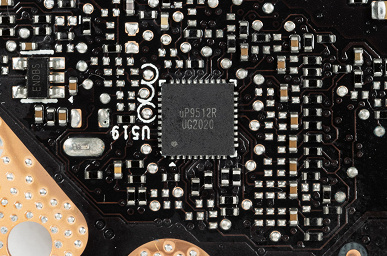

Зеленым цветом отмечена схема питания ядра, красным — памяти. Давайте разбираться, кто за что отвечает. На плате есть три ШИМ-контроллера: uP9512R (uPI Semiconductor), рассчитанный на управление максимум 8 фазами, uS5650Q и uP1666Q (той же uPI). Все они расположены на оборотной стороне PCB. Полагаем, что для управления схемой питания GPU используется uP9512R, а помогает ему uP1666Q.

Тогда как на uS5650Q возложено управление 2 фазами питания микросхем памяти.

Остался лишь вопрос: какой контроллер отвечает за мониторинг состояния платы? Обычно мы видели для этой цели второй uS5650Q, но на данной плате он лишь один. Вопрос остался без ответа.

В преобразователе питания, традиционно для всех видеокарт Nvidia, используются транзисторные сборки DrMOS — в данном случае мосфеты схемы питания GPU AOZ5311NGI (Alpha&Omega Semiconductor) и мосфеты схемы питания памяти SM7342EKKP (Sinopower).

Как и у предыдущих карт Founders Edition серии GeForce RTX 30, у этой карты 12-контактный коннектор питания. Кстати, можно оценить, насколько GeForce RTX 3070 меньше своего старшего собрата.

Еще в начальном видеоролике мы упомянули, что ряд производителей блоков питания, прежде всего Seasonic, объявили о выпуске отдельных кабелей («хвостов») для своих модульных БП для подключения к референс-картам серии GeForce RTX 30. А с самой картой, конечно же, поставляется переходник, позволяющий подключить 8-контактный коннектор к новому разъему.

Нагрев и охлаждение

Мы уже дважды писали, что PCB у новых карт Founders Edition стала более компактной, ведь для таких карт была задумана специальная система охлаждения.

Эта схема едина для карт всей серии, хотя в случае GeForce RTX 3070 в дизайне имеются некоторые нюансы.

Основной пластинчатый радиатор, выполненный из медного сплава, имеет тепловые трубки, подведенные к теплосъемнику на GPU. Массивная основа (рама) охлаждает также микросхемы памяти и преобразователи питания VRM. Задняя пластина участвует в охлаждении оборотной стороны PCB.

Вентиляторов здесь два (∅90 мм), в обоих используются двойные подшипники. Особенность данной СО состоит в том, что вентиляторы установлены уже не с разных сторон радиатора (см. схему выше), а с одной.

Однако изначальный замысел сохранился: правый вентилятор продувает радиатор (ту его часть, куда выведены тепловые трубки) насквозь (через решетку на оборотной стороне). Нагретый воздух остается в корпусе (при типовой установке видеокарты он выдувается вверх), и его должен подхватить вытяжной вентилятор в корпусе системного блока. Левый же вентилятор сразу выдувает горячий воздух за пределы корпуса сквозь отверстия в брекете карты.

Напомним, что обычно видеокарты останавливают свои вентиляторы в простое, при работе в 2D, если температура GPU опускается ниже примерно 60 градусов, и СО при этом становится бесшумной. В случае карты Nvidia GeForce RTX 3070 Founders Edition режим работы кулера иной: для остановки вентиляторов температура GPU должна быть ниже 50 °C, температура чипов памяти — ниже 80 °C, а энергопотребление самого GPU — ниже 30 Вт. Только при соблюдении всех трех условий вентиляторы остановятся. Ниже есть видеоролик на эту тему, где в конце вентиляторы все же останавливаются.

Мониторинг температурного режима с помощью MSI Afterburner:

После 6-часового прогона под нагрузкой максимальная температура ядра не превысила 76 градусов, что является приемлемым результатом для видеокарты такого уровня.

Мы засняли и ускорили в 30 раз 10-минутный прогрев:

Максимальный нагрев наблюдался в районе преобразователей питания.

Шум

Методика измерения шума подразумевает, что помещение шумоизолировано и заглушено, снижены реверберации. Системный блок, в котором исследуется шум видеокарт, не имеет вентиляторов, не является источником механического шума. Фоновый уровень 18 дБА — это уровень шума в комнате и уровень шумов собственно шумомера. Измерения проводятся с расстояния 50 см от видеокарты на уровне системы охлаждения.

Режимы измерения:

- Режим простоя в 2D: загружен интернет-браузер с сайтом iXBT.com, окно Microsoft Word, ряд интернет-коммуникаторов

- Режим 2D с просмотром фильмов: используется SmoothVideo Project (SVP) — аппаратное декодирование со вставкой промежуточных кадров

- Режим 3D с максимальной нагрузкой на ускоритель: используется тест FurMark

Оценка градаций уровня шума следующая:

- менее 20 дБА: условно бесшумно

- от 20 до 25 дБА: очень тихо

- от 25 до 30 дБА: тихо

- от 30 до 35 дБА: отчетливо слышно

- от 35 до 40 дБА: громко, но терпимо

- выше 40 дБА: очень громко

В режиме простоя в 2D температура была не выше 36 °C, вентиляторы не работали, уровень шума был равен фоновому — 18 дБА.

При просмотре фильма с аппаратным декодированием ничего не менялось, поэтому шум сохранялся на прежнем уровне.

В режиме максимальной нагрузки в 3D температура достигала 76 °C. Вентиляторы при этом раскручивались до 2060 оборотов в минуту, шум вырастал до 34,4 дБА: это отчетливо слышно, на грани громкого шума, но еще не раздражает. В видеоролике ниже видно, как растет шум (шум фиксировался пару секунд через каждые 30 секунд — правда, пришлось очень долго ждать, пока вентиляторы остановятся).

С учетом того, какие компактные размеры имеет данная карта, шум можно считать приемлемым.

Подсветка

Подсветки у карты нет в принципе.

Так что данная видеокарта может «светить» лишь отраженным светом, как Луна :)

Комплект поставки и упаковка

Комплект поставки, кроме традиционного руководства пользователя, включает переходник питания на новый 12-контактный разъем с 8-контактного коннектора.

Опять же, как и у GeForce RTX 3080/3090, стильная упаковка вызывает восторг. Ощущение премиального продукта создается еще при виде коробки. Распаковка и восторги — в начальном ролике :)

Тестирование: синтетические тесты

Конфигурация тестового стенда

- Компьютер на базе процессора Intel Core i9-9900K (Socket LGA1151v2):

- Компьютер на базе процессора Intel Core i9-9900KS (Socket LGA1151v2):

- процессор Intel Core i9-9900KS (разгон 5,1 ГГц по всем ядрам);

- ЖСО Cougar Helor 240;

- системная плата Gigabyte Z390 Aorus Xtreme на чипсете Intel Z390;

- оперативная память Corsair UDIMM (CMT32GX4M4C3200C14) 32 ГБ (4×8) DDR4 (XMP 3200 МГц) ;

- SSD Intel 760p NVMe 1 ТБ PCI-E;

- жесткий диск Seagate Barracuda 7200.14 3 ТБ SATA3;

- блок питания Seasonic Prime 1300 W Platinum (1300 Вт);

- корпус Thermaltake Level20 XT;

- операционная система Windows 10 Pro 64-битная; DirectX 12 (v.2004);

- телевизор LG 43UK6750 (43″ 4K HDR);

- драйверы AMD версии 20.9.2;

- драйверы Nvidia версии 456.55/456.96;

- VSync отключен.

- Компьютер на базе процессора Intel Core i9-9900KS (Socket LGA1151v2):

Тесты GeForce RTX 3070 проводились в закрытом, хорошо продуваемом корпусе.

Мы провели тестирование видеокарты GeForce RTX 3070 со стандартными частотами в нашем наборе синтетических тестов. Он продолжает постоянно меняться, добавляются новые тесты, а некоторые устаревшие постепенно убираются. Мы бы хотели добавить еще больше примеров с вычислениями, но с этим есть определенные сложности. Постараемся расширить и улучшить набор синтетических тестов, и если у вас есть четкие и обоснованные предложения — напишите их в комментариях к статье или отправьте авторам.

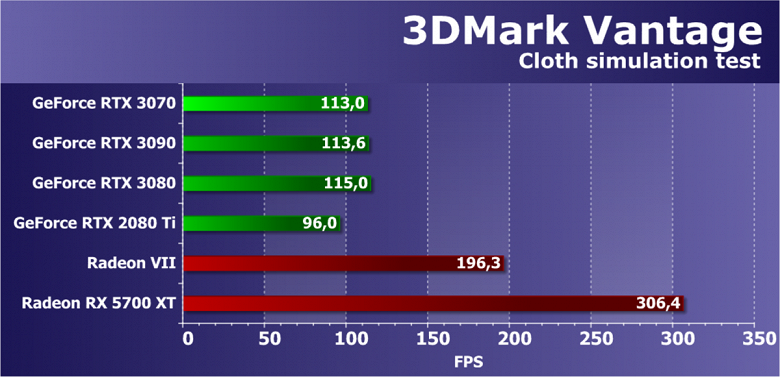

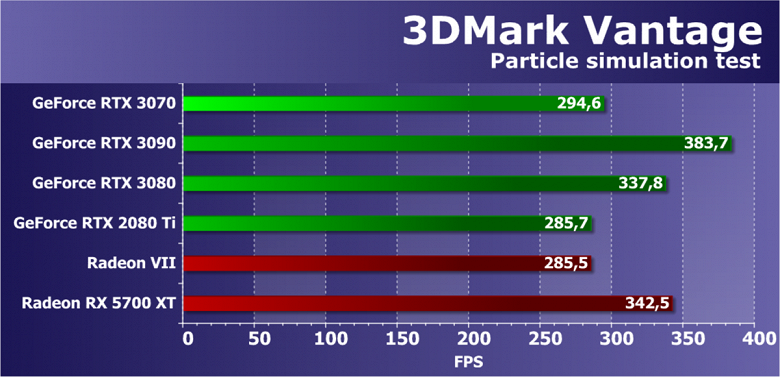

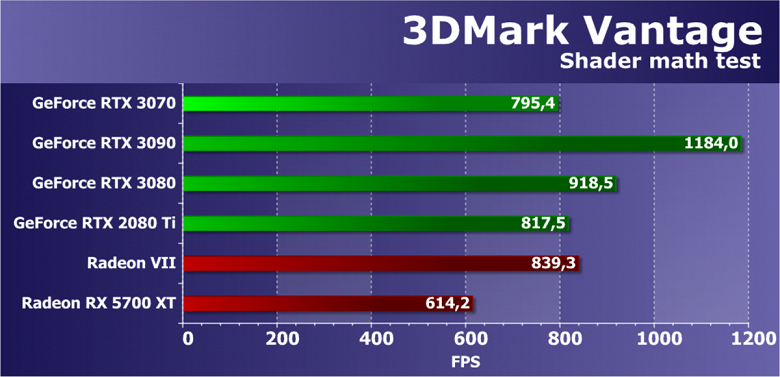

Мы полностью отказались от ранее активно использовавшихся нами тестов RightMark3D, так как они устарели слишком сильно, и на столь мощных GPU или не запускаются вообще, или упираются в различные ограничители, не загружая работой блоки графического процессора и не показывая его истинную производительность. А вот синтетические Feature-тесты из набора 3DMark Vantage мы все еще оставили в полном составе, так как заменить их попросту нечем, хотя и они уже изрядно устарели.

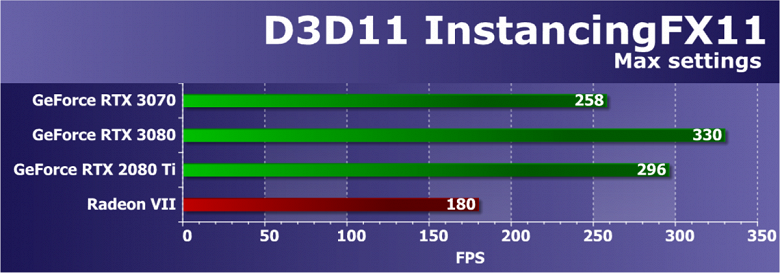

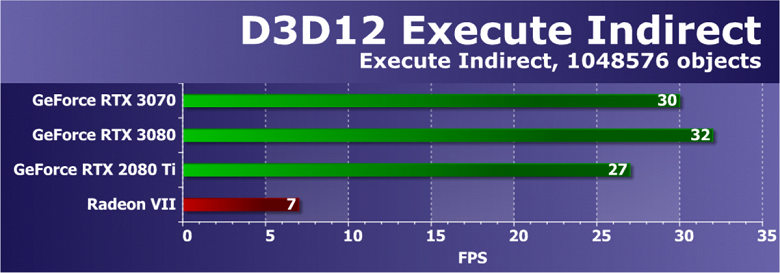

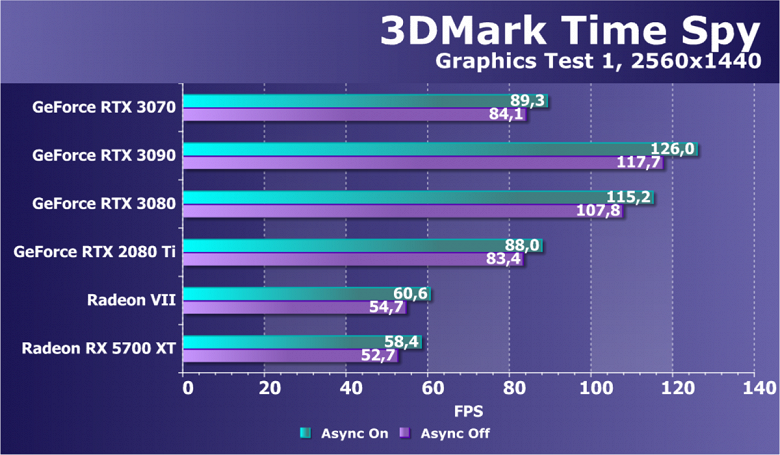

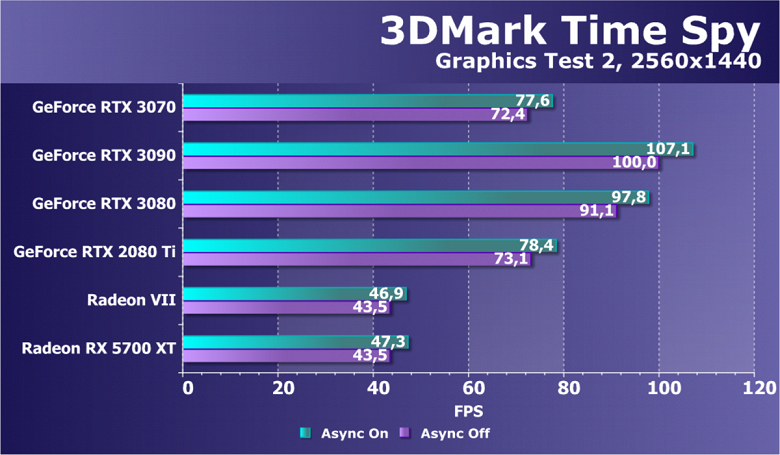

Из более-менее новых бенчмарков мы начали использовать несколько примеров, входящих в DirectX SDK и пакет SDK компании AMD (скомпилированные примеры применения D3D11 и D3D12), а также несколько разнообразных тестов для измерения производительности трассировки лучей, программной и аппаратной. В качестве полусинтетического теста у нас также используется и довольно популярный 3DMark Time Spy, а также некоторые другие — например, DLSS и RTX.

Синтетические тесты проводились на следующих видеокартах:

- GeForce RTX 3070 со стандартными параметрами (RTX 3070)

- GeForce RTX 3090 со стандартными параметрами (RTX 3090)

- GeForce RTX 3080 со стандартными параметрами (RTX 3080)

- GeForce RTX 2080 Ti со стандартными параметрами (RTX 2080 Ti)

- GeForce RTX 2070 Super со стандартными параметрами (RTX 2070 Super)

- Radeon VII со стандартными параметрами (Radeon VII)

- Radeon RX 5700 XT со стандартными параметрами (RX 5700 XT)

Для анализа производительности новой видеокарты GeForce RTX 3070 мы выбрали несколько видеокарт из разных поколений компании Nvidia. Для сравнения с относительно аналогичным по позиционированию решением мы взяли RTX 2070 Super, но его почти не использовали в итоге, так как сравнение с RTX 2080 Ti — самым дорогим решением предыдущего семейства Turing — еще более интересно. Также есть на диаграммах и результаты пары верхних моделей RTX 3080 и RTX 3090, чтобы определить, насколько медленнее них получился младший GPU архитектуры Ampere.

Как мы уже упоминали, соперников для GeForce RTX 3070 у компании AMD для нашего сегодняшнего сравнения просто не существует. Ждем выхода новых Radeon архитектуры RDNA2, а пока что снова сравниваем новинку Nvidia с тем, что есть — с парой видеокарт: Radeon VII присутствует в качестве самого быстрого решения, хоть уже и давно исчезнувшего из продажи, а Radeon RX 5700 XT выступает как наиболее производительный графический процессор архитектуры RDNA первого поколения.

Тестирование: игровые тесты

Список инструментов тестирования

Во всех играх использовалось максимальное качество графики в настройках.

- Gears 5 (Xbox Game Studios/The Coalition)

- Wolfenstein: Youngblood (Bethesda Softworks/MachineGames/Arkane Studios)

- Death Stranding (505 Games/Kojima Productions)

- Red Dead Redemption 2 (Rockstar)

- Star Wars Jedi: Fallen Order (Electronic Arts/Respawn Entertainment)

- Control (505 Games/Remedy Entertainment)

- Deliver Us The Moon (Wired Productions/KeokeN Interactive)

- Resident Evil 3 (Capcom/Capcom)

- Shadow of the Tomb Raider (Eidos Montreal/Square Enix), HDR включен

- Metro Exodus (4A Games/Deep Silver/Epic Games)

Стандартные результаты тестов без использования аппаратной трассировки лучей в разрешениях 1920×1200, 2560×1440 и 3840×2160

Как мы ранее неоднократно писали, в новом поколении GeForce RTX 30 улучшены технологии RT (расчет освещения с помощью трассировки лучей) и DLSS (интеллектуальная реализация антиалиасинга, обсчитываемая тензорными ядрами). Но поскольку конкурирующие решения AMD данные технологии пока не поддерживают (ждем новое поколение!), мы вынуждены для массового тестирования отключать как трассировку, так и DLSS для получения адекватного сравнения всех карт. Поэтому теперь мы будем проводить тесты не только с использованием обычных методов растеризации, но и с включением RT, а в ряде игр — и DLSS. Разумеется, видеокарты Nvidia при этом придется сравнивать только с другими видеокартами Nvidia. Для этого дополнительного тестирования мы взяли 4 игры, где технологии RT и DLSS уже обкатаны.

Результаты тестов с включенной аппаратной трассировкой лучей и DLSS в разрешениях 1920×1200, 2560×1440 и 3840×2160

Следует повторить, что серия карт GeForce RTX 30 работает с RT и DLSS 2.0 более эффективно, чем предыдущая: прирост производительности в таких тестах у GeForce RTX 30 относительно GeForce RTX 20 выше, нежели в тестах без RT/DLSS. Также надо отметить работу новой версии DLSS: в отличие от традиционных методов АА, здесь мы видим либо незначительное падение производительности, либо и вовсе отсутствие такого падения. При этом, как мы уже писали в материалах по исследованию новых технологий Nvidia, на качестве картинки применение DLSS почти не сказывается.

Рейтинг iXBT.com

Рейтинг ускорителей iXBT.com демонстрирует нам функциональность видеокарт друг относительно друга и нормирован по самому слабому ускорителю — Radeon RX 550 (то есть сочетание скорости и функций Radeon RX 550 приняты за 100%). Рейтинги ведутся по 28 ежемесячно исследуемым нами акселераторам в рамках проекта Лучшая видеокарта месяца. В данном случае из общего списка выбрана группа карт для анализа, в которую входят GeForce RTX 3070 и его конкуренты.

Для расчета рейтинга полезности использованы розничные цены на конец октября 2020 года. Рейтинг приведен суммарно для всех трех разрешений (на основе тестов без использования RT/DLSS).

| № | Модель ускорителя | Рейтинг iXBT.com | Рейтинг полезности | Цена, руб. |

|---|---|---|---|---|

| 03 | RTX 3070 8 ГБ, 1440—1950/14000 | 1780 | 356 | 50 000 |

| 04 | RTX 2080 Ti 11 ГБ, 1350—1950/14000 | 1770 | 242 | 73 000 |

| 05 | RTX 2080 Super 8 ГБ, 1650—1965/15500 | 1550 | 290 | 53 500 |

| 06 | RTX 2080 8 ГБ, 1515—1950/14000 | 1460 | 292 | 50 000 |

| 07 | RTX 2070 Super 8 ГБ, 1605—1950/14000 | 1350 | 338 | 40 000 |

| 10 | Radeon VII 16 ГБ, 1400—1750/2000 | 1140 | 238 | 48 000 |

| 11 | RX 5700 XT 8 ГБ, 1605—1905/14000 | 1100 | 297 | 37 000 |

Новый «середнячок» оказался на уровне недосягаемого флагмана предыдущего поколения — GeForce RTX 2080 Ti. То есть GeForce RTX 3070 быстрее не только своего формального предшественника GeForce RTX 2070 Super (согласно цифровому индексу в серии), но и пары GeForce RTX 2080 с GeForce RTX 2080 Super.

Рейтинг полезности

Рейтинг полезности тех же карт получается, если показатели предыдущего рейтинга разделить на цены соответствующих ускорителей. Учитывая возможности карты и ее явную нацеленность на использование в высоких разрешениях, приводим рейтинг только для разрешения 4К (поэтому цифры в рейтинге отличаются).

| № | Модель ускорителя | Рейтинг полезности | Рейтинг iXBT.com | Цена, руб. |

|---|---|---|---|---|

| 02 | RTX 3070 8 ГБ, 1440—1950/14000 | 613 | 3065 | 50 000 |

| 05 | RTX 2070 Super 8 ГБ, 1605—1950/14000 | 559 | 2236 | 40 000 |

| 07 | RX 5700 XT 8 ГБ, 1605—1905/14000 | 487 | 1802 | 37 000 |

| 08 | RTX 2080 Super 8 ГБ, 1650—1965/15500 | 486 | 2602 | 53 500 |

| 09 | RTX 2080 8 ГБ, 1515—1950/14000 | 484 | 2421 | 50 000 |

| 10 | RTX 2080 Ti 11 ГБ, 1350—1950/14000 | 418 | 3053 | 73 000 |

| 11 | Radeon VII 16 ГБ, 1400—1750/2000 | 399 | 1915 | 48 000 |

Рекомендованная розничная цена Nvidia на карты GeForce RTX 3070 — 45/47 тысяч рублей, так что с учетом ожидаемых на практике цен мы условно взяли для расчета рейтинга 50 тысяч. Конечно же, в дальнейшем в обзорах серийных карт и выпусках «Лучшей карты месяца» мы будем корректировать эту информацию в соответствии с реальными ценами. Однако если предположить, что GeForce RTX 3070 реально будет купить за 50 000 рублей, то это просто бомба! В общем рейтинге полезности первую строчку сохраняет за собой GeForce RTX 3080, новинка же сразу поднимается на вторую. Словом, не просто так за новыми видеокартами покупатели просто гоняются... GeForce RTX 3070 уничтожила не только более дорогих соперников, но и более дешевых: даже Radeon RX 5700 XT сильно отстал по рейтингу, к тому же у этого ускорителя нет поддержки технологии RT.

Выводы

Ранее мы уже говорили, что Nvidia GeForce RTX 3080 уже позволяет комфортно играть в 4К при максимальных настройках графики со включенной трассировкой лучей. К тому же при использовании тензорных ядер для реализации DLSS падение производительности от включения RT может быть полностью (и даже с излишком) компенсировано по сравнению с тем, что мы имеем без RT+DLSS.

Nvidia GeForce RTX 3070, по сути, повторяет результат прежнего лидера GeForce RTX 2080 Ti, который открыл разрешение 4К для геймеров, обеспечивая в нем очень хорошую производительность при условии, что игрок не будет включать трассировку лучей без одновременного включения DLSS. Но это было справедливо для GeForce RTX 2080 Ti, а GeForce RTX 3070 поднимает и эту планку, выдавая приемлемую производительность в 4К с использованием RT без DLSS и весьма хорошую скорость при сочетании RT c DLSS.

Мы уже писали ранее про перспективу трассировки лучей в играх. Очевидно, что индустрия приняла данную технологию как стандарт, и будет появляться все больше игр с RT. К тому же, мы ожидаем поддержку данной технологии даже в решениях конкурентов.

Что касается конкретной видеокарты Nvidia GeForce RTX 3070 Founders Edition (8 ГБ), то она хороша с точки зрения потребительских характеристик: плата компактная, занимает два слота в системном блоке. Да, шум есть, но не слишком высокий, а СО достаточно эффективна. Стоит отметить, что при использовании всех карт GeForce RTX 30 Founders Edition следует предусматривать продольную продувку в корпусе, и желательно применять для охлаждения процессора ЖСО либо не очень громоздкий воздушный кулер, чтобы горячий воздух от второго вентилятора видеокарты выносился наружу, не попадая к вентиляторам кулера процессора.

Наличие у видеокарты нестандартного пока 12-контактного разъема питания не является особой проблемой: во-первых, для него имеется переходник в комплекте поставки, а во-вторых, производители БП вскоре предоставят соответствующие решения.

В заключение еще раз констатируем: GeForce RTX 3070, как и GeForce RTX 3080, отлично подходит для игры в разрешении 4К! Даже с RT+DLSS новый ускоритель способен обеспечить приемлемый комфорт в играх в таком разрешении. Разумеется, в разрешении 2.5К эта видеокарта легко потянет игры с максимальным качеством графики с трассировкой лучей даже без DLSS! То есть новые технологии уверенно движутся по пути более широкого применения. Если раньше за приемлемый комфорт в высоких разрешениях на максимальных настройках требовалось платить очень много (когда-то GeForce RTX 2080 Ti стоили 100 тысяч рублей и выше, то есть были сильно дороже, чем нынешние GeForce RTX 3080!), то теперь и за 50 тысяч рублей можно получить отменный современный ускоритель для разрешения 2.5К и даже 4К.

На сегодня 4К-приемники (как мониторы, так и телевизоры) сильно упали в цене. Сейчас они представлены уже не только в премиальном ценовом сегменте, как это было 2 года назад при выходе GeForce RTX 2080 Ti (который тогда был единственным ускорителем, успешно тянущим разрешение 3840×2160 в играх с высокими настройками графики), когда 4К-мониторы и 4К-телевизоры с реальным HDR также имели стоимость около 100 тысяч рублей или выше. Сейчас нормальный 4К-монитор можно купить дешевле, чем любую видеокарту из линейки GeForce RTX 30. То есть сейчас возможность комфортно играть в 4К появилась и у потребителей среднего звена.

Возвращаясь к GeForce RTX 3070, нельзя забывать и про ряд сопутствующих семейству GeForce RTX 30 новых интересных решений Nvidia, включая поддержку стандарта HDMI 2.1, позволяющего выводить 4K-изображение с 120 FPS или 8K-разрешение при помощи одного кабеля. Также отметим поддержку аппаратного декодирования видеоданных в формате AV1, технологию RTX IO, способную обеспечить быструю передачу и распаковку данных с накопителей прямо в GPU, а также технологию снижения задержек Reflex, полезную для киберспортсменов.

В номинации «Оригинальный дизайн» карта Nvidia GeForce RTX 3070 Founders Edition (8 ГБ) получила награду:

Благодарим компанию Nvidia Russia

и лично Ирину Шеховцову

за предоставленную на тестирование видеокарту

Для тестового стенда:

блок питания Seasonic Prime 1300 W Platinum предоставлен компанией Seasonic