Что остановит ИИ от наводнения Интернета поддельными изображениями?

Google, Adobe, Microsoft и другие технологические компании пробуют новые способы маркировки контента, созданного искусственным интеллектом.

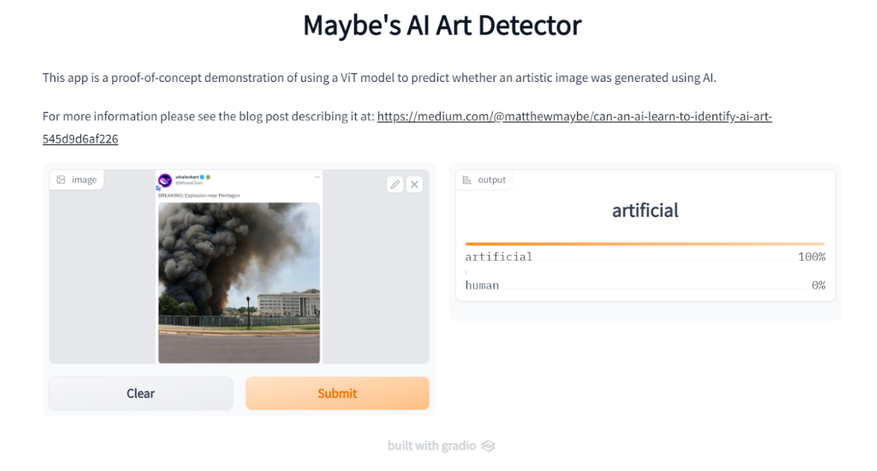

22 мая в Интернете произошел хаос из-за распространения фальшивой фотографии взрыва в Пентагоне.

Как только изображение, выглядевшее очень реалистично, было опубликовано в Twitter и других социальных сетях, оно быстро распространилось благодаря ретвитам популярных аккаунтов. Журналисты обратились к правительственным чиновникам, включая пресс-службу Белого дома, с вопросом о происходящем.

Сразу же стало ясно, что фотография является подделкой, вероятно, созданной искусственным интеллектом. Но за короткое время, пока она распространялась, фальшивое изображение оказало реальное влияние на американцев и даже незначительно повлияло на финансовые рынки.

Эта проблема не нова. Дезинформация в Интернете существует с самого начала его существования, и давно до появления широкого использования генеративного искусственного интеллекта, грубо подделанные изображения обманывали людей.

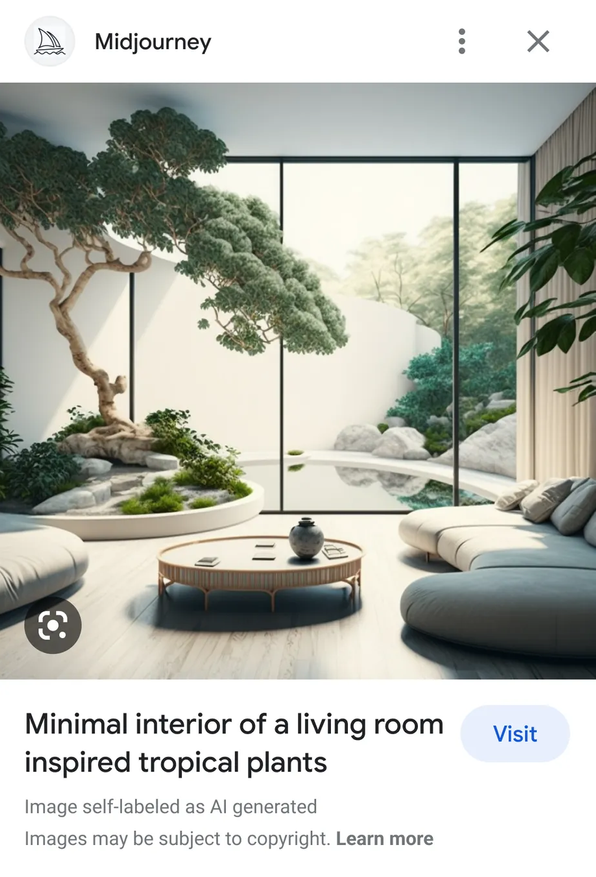

Но в последнее время такие инструменты, как ChatGPT, DALL-E, Midjourney и обновленные функции искусственного интеллекта в Photoshop, лишь усугубили проблему, упрощая и удешевляя создание гиперреалистичных поддельных изображений, видео и текстовых материалов. Эксперты предсказывают, что мы можем ожидать еще больше фальшивых изображений, подобных тому, что было опубликовано с видом на Пентагон. Особенно когда они могут вызвать такие политические потрясения.

В отчете Европола, правоохранительного органа Европейского союза, указывается, что к 2026 году до 90% контента в Интернете может быть создано или отредактировано искусственным интеллектом. Уже сегодня появляются спам-новостные сайты, которые, по всей видимости, полностью созданы искусственным интеллектом. Организация NewsGuard, занимающаяся борьбой с дезинформацией, начала отслеживать такие сайты и обнаружила их количество почти в три раза больше, чем несколько недель назад.

«Мы уже видели, что произошло в 2016 году, когда нас охватила первая волна дезинформации во время выборов», — отметил профессор и содиректор Центра социальных сетей и политики Нью-Йоркского университета Джошуа Такер. «Теперь настало время увидеть и другую сторону этого уравнения».

Один из подходов, который некоторые эксперты считают эффективным, заключается в использовании метаданных, водяных знаков и других технических систем для различения поддельных изображений от настоящих. Некоторые компании, такие как Google, Adobe и Microsoft, внедряют различные формы маркировки ИИ в свои продукты.

Например, на конференции Google I/O компания заявила, что в ближайшие месяцы предоставит письменное раскрытие информации, аналогичное уведомлению об авторских правах, для результатов, сгенерированных искусственным интеллектом в Google Images. Также популярная технология генерации изображений OpenAI DALL-E добавляет красочный водяной знак в виде полосы в нижней части всех создаваемых изображений.

Энди Парсонс, старший директор инициативной группы Adobe по аутентичности контента, подчеркивает важность права каждого на создание общей объективной реальности. Он говорит о необходимости знать, что представляет собой конкретный контент и, если это имеет смысл, кто его создал или откуда он взят.

В рамках усилий по борьбе с путаницей между поддельными и реальными изображениями, Adobe разработала инструмент, называемый учетными данными контента, который отслеживает редактирование изображений с использованием искусственного интеллекта. Это подобно этикетке, предоставляющей информацию о цифровом контенте, которая сохраняется вместе с файлом, где бы он ни был опубликован или сохранен.

Например, последнее обновление Photoshop включает функцию генеративной заливки, которая быстро создает новое содержимое в существующем изображении с помощью искусственного интеллекта. И учетные данные контента могут отслеживать эти изменения.

Однако инструменты маркировки ИИ, такие как Adobe, все еще находятся на начальных этапах развития, и нельзя полагаться на них, как на единственное решение проблемы дезинформации. Технически возможно обмануть водяной знак или метаданные. Кроме того, не все системы генерации ИИ захотят раскрывать свою методологию.

Как мы узнали из распространения теорий заговора в Интернете в последние годы, люди часто предпочитают верить в ложь, которая подтверждает их собственные убеждения, игнорируя факты. Однако, если эти маркировки будут внедрены надлежащим образом и будут рассматриваться как более нейтральные по сравнению с традиционной проверкой фактов в социальных сетях, раскрытие информации с помощью ИИ может стать одним из наших основных инструментов для ориентации в размытой реальности интернета, где смешиваются поддельные и реальные СМИ.

Вот как работают некоторые из ранних систем разметки ИИ, их ограничения, и что пользователи могут сделать, чтобы ориентироваться в этой запутанной интернет-реальности постправды.

Дьявол кроется в метаданных

Да, добавление метаданных об искусственном интеллекте к изображениям является одним из подходов, который используется некоторыми технологическими компаниями, чтобы помочь пользователям определить подлинность изображений. Google и другие компании начинают включать информацию о том, что изображение было создано с помощью их систем искусственного интеллекта.

Google, например, маркирует изображения, созданные его собственными системами ИИ, указывая это в метаданных исходных файлов изображений. Когда пользователь видит такое изображение в поиске Google, будет отображаться сообщение под ним, указывающее на то, что оно было сгенерировано с помощью искусственного интеллекта Google. Компания также сотрудничает с издателями и стоковыми фотографиями, чтобы позволить им самостоятельно помечать свои изображения как созданные искусственным интеллектом в поиске Google.

Согласно представителю Google Search, такая маркировка является частью общих усилий для предоставления пользователям больше информации об изображениях, которые они видят. Они стремятся не только предоставить «этикетки», указывающие на использование ИИ, но и предоставить дополнительную справочную информацию, которую можно определить независимо от метки.

Внедрение метаданных об искусственном интеллекте в изображения — это одна из стратегий, которая может помочь пользователям различать подлинные и поддельные изображения. Однако следует отметить, что это только один из многих возможных подходов и что технически возможно обойти или подделать такую информацию. Поэтому важно продолжать развивать и усовершенствовать технологии и методы проверки подлинности изображений и контента в целом.

Да, добавление функции «Об этом изображении» в результатах поиска изображений Google является еще одной инициативой, направленной на помощь пользователям в понимании контента и улучшении информационной грамотности. Эта функция позволяет пользователям узнать дополнительные сведения о происхождении и истории изображения, включая его первую индексацию Google, возможное место появления и обнаружение в Интернете.

Таким образом, при просмотре результатов поиска изображений пользователи могут получить проверенную фактами информацию, которая поможет им оценить достоверность изображения и его контекст.

Не только Google, но и другие ведущие компании в индустрии также работают над вопросом маркировки контента, созданного с помощью искусственного интеллекта. В 2021 году группа крупных компаний объединилась в коалицию C2PA (Coalition for Content Provenance and Authenticity), включающую Microsoft, Adobe, BBC и Intel. Целью коалиции является создание открытого стандарта для обмена информацией о происхождении и истории контента.

С помощью этого стандарта фотографы и другие создатели контента смогут отмечать метаданными информацию о времени создания изображения, авторе, а также вносить цифровые подписи, подтверждающие подлинность и изменения контента.

Например, новостные фотографы могут подписывать свои снимки цифровой подписью, указывая авторство и время создания, а редакторы могут вносить изменения и подписывать их печатью подлинности. Это помогает отслеживать происхождение и изменения контента и предоставляет информацию о его подлинности.

Внедрение стандарта C2PA позволяет пользователям «прочитать» всю историю цифрового контента и помогает различать разницу между синтетическим и подлинным контентом. Он использует криптографические методы для обеспечения конфиденциальности информации и подтверждения подлинности контента.

В целом, добавление функций метаданных и стандартов происхождения контента являются шагами в направлении повышения прозрачности и информационной грамотности пользователей, чтобы иметь возможность оценивать и проверять подлинность изображений и контента, особенно тех, которые созданы с помощью искусственного интеллекта.

Знание истории и происхождения изображений может быть полезным для пользователей в проверке достоверности различных контентов, от фотографий в приложениях для знакомств до изображений в новостях. Однако для эффективного функционирования такой системы необходимо установить стандарты.

В настоящее время компаниям следует принять стандарт C2PA и самостоятельно маркировать проверенный контент. Согласно заявлениям Мунира Ибрагима, организация также рассматривает возможность стандартизации внешнего вида учетных данных C2PA на изображениях. В будущем учетные данные C2PA могут быть представлены в виде небольшого значка, подобного замку, который отображается рядом с URL-адресом в браузере, указывая на проверку изображения.

На данный момент два крупных участника C2PA, Adobe и Microsoft, уже интегрировали стандарты C2PA в свои продукты для разметки контента, созданного искусственным интеллектом. Microsoft применяет маркировку для всего контента, созданного искусственным интеллектом, в Bing Image Generator и Microsoft Designer, в то время как Adobe использовала стандарты C2PA для учетных данных своего нового продукта AI Firefly.

Однако внедрение метаданных в стиле C2PA происходит за кулисами. Еще один подход заключается в добавлении видимых водяных знаков системами искусственного интеллекта.

Например, OpenAI применила радужную полосу в нижней части изображений DALL-E и работает над водяными знаками для своего текстового приложения ChatGPT. Тем не менее, проблема водяных знаков заключается в том, что они могут быть удалены, как показывают поисковые запросы в Google о способах обхода этих знаков.

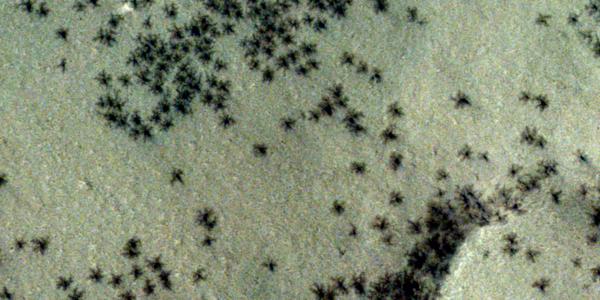

Еще один вариант состоит в использовании технологий, способных обнаруживать контент, созданный искусственным интеллектом, после его создания. В январе OpenAI представила инструмент, который позволяет проверять текст с целью определения, написан ли он искусственным интеллектом. Однако, по оценке OpenAI, этот инструмент не является полностью надежным, правильно идентифицируя только 26% текстов, созданных искусственным интеллектом, особенно эффективным он оказывается на более длинных текстах.

Несмотря на недостатки ранних систем маркировки и идентификации контента, созданного ИИ, они являются первым шагом в этом направлении.

Что будет дальше

Это по-прежнему ранний этап развития технических платформ, которые стремятся автоматизировать идентификацию контента, созданного ИИ. Однако, пока надежное решение не будет найдено, фактчекеры продолжают заполнять пробелы, разоблачая поддельные изображения, такие как Папа Римский в пуховом пиджаке или фальшивые аудиозаписи политиков.

Сэм Грегори, исполнительный директор правозащитной и гражданской журналистской сети Witness, которая сотрудничает с фактчекерами в основном за пределами США, отмечает, что, хотя технические решения, такие как водяные знаки, для идентификации контента, созданного искусственным интеллектом, обещают быть многообещающими, многие специалисты по проверке фактов беспокоятся о давлении дезинформации, которая может возникнуть вместе с использованием ИИ. Уже сейчас профессиональным фактчекерам приходится иметь дело с огромным объемом контента для проверки, которого физически невозможно проверить для человека.

«Будет ли человек обвинен в том, что не смог идентифицировать изображение, сгенерированное искусственным интеллектом? Или фактчекеры будут перегружены объемом работы и несением ответственности?» — спрашивает Грегори. Он также добавляет, что ответственность за борьбу с дезинформацией, связанной с искусственным интеллектом, должна лежать на людях, которые разрабатывают такие инструменты, создают модели и распространяют их.

Во многих случаях, по словам Грегори, неясно, какие конкретно правила установлены платформами социальных сетей для контента, созданного искусственным интеллектом.

Действительно, различные платформы, включая TikTok, работают над обновлением своих политик и правил в отношении контента, созданного искусственным интеллектом. TikTok внесла изменения в свою политику, требуя явного раскрытия синтетических медиа, особенно если они показывают реалистичные сцены, и запрещая использование изображений частных лиц или лиц моложе 18 лет. Они также сотрудничают с внешними партнерами для обеспечения соблюдения ответственной практики в области искусственного интеллекта.

Однако, как отмечает Сэм Грегори, остаются некоторые проблемы с политиками на других платформах, таких как Mеta (владельцы Facеbook и Instаgrаm) и YouTube. Хотя у них есть правила против манипулирования медиа, не всегда ясно, какое использование контента, созданного искусственным интеллектом, допустимо или недопустимо.

Несмотря на технические решения, такие как системы обнаружения ИИ и водяные знаки, которые помогают людям проверять факты, эффективность этих инструментов еще требует тщательного исследования. Некоторые исследования показывают, что ярлыки достоверности или раскрытие информации о том, что контент сгенерирован искусственным интеллектом, могут иметь ограниченное влияние на восприятие людьми и их привычки потребления контента.

Однако надежда заключается в том, что информация о том, что контент создан искусственным интеллектом, может быть представлена не как политическая проверка фактов, а как нейтральный контекст о происхождении контента. Дополнительные исследования необходимы для оценки того, как эти ярлыки воспринимаются людьми и влияют на их мнение.

Важно продолжать исследования и работу над этими проблемами, поскольку контент, созданный искусственным интеллектом, продолжает распространяться в Интернете. Технологические компании должны усиливать свои усилия для разработки эффективных механизмов обнаружения и борьбы с дезинформацией, связанной с искусственным интеллектом.

5 комментариев

Добавить комментарий

Добавить комментарий