Доклад Джастина Раттнер (Justin Rattner), директора Intel по технологиям, предварял последний третий день осеннего Форума Intel для разработчиков 2011. В своей речи Раттнер коснулся перспективных технологий, но начал все… с шутки.

Раттнер вышел на сцену в беретке наподобие той, что носит вице-президент Intel Мули Иден (Мooly Eden, он отметился своим докладом во второй день IDF 2011 в Сан-Франциско). Зал благосклонно принял пародию, после чего Раттнер снял беретку и начал выступление.

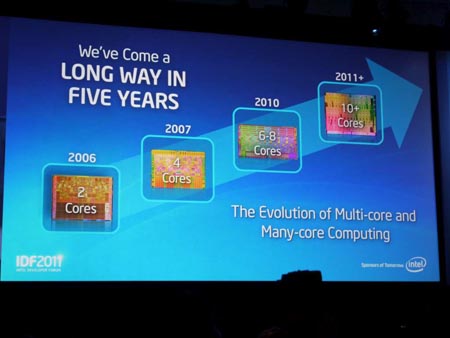

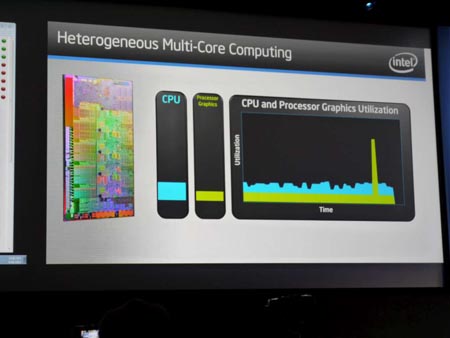

За прошедшие пять лет Intel прошла длинный путь: от двухъядерных процессоров в 2006 году до более чем десятиядерных в 2011 году. На смену решениям Multi-core уже идут Many-core с десятью вычислительными ядрами и более.

Интел продолжает исследования в области массивных вычислений с наращиванием мощностей – Terascale.

Для этих целей используется SCC - Single Chip Clud Computer — по сути, 48-процессорный чип, где каждый узел является полноценным процессором со своим контроллером памяти, но зато за счет размещения в одном корпусе устранены узкие места внутренних связей и обмена данными между процессорами.

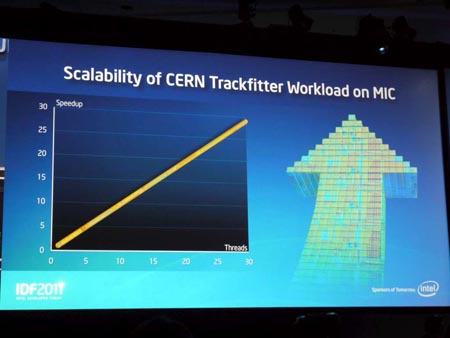

Масштабирование (рост скорости вычислений) наблюдается на целом спектре задач, но в некоторых случаях этот рост линеен!

Про такую ситуацию рассказал Анджей Новак (Andrzej Nowak) из CERN OpenLab.

Сначала Новак кратко рассказал, что такое OpenLab и Большой Адронный Коллайдер, после чего обратился к сути процесса регистрации, сбора и передачи данных в БАК.

Вкратце процесс выглядит следующим образом: в LHA частицы разгоняются почти до скорости света и сталкиваются, результат столкновения фиксируется датчиками, после чего данные сохраняются и анализируются. Это огромные массивы данных (15-25 петабайт данных в год), на обработку которых требуется много ресурсов и времени.

Intel проделала огромную работу, обеспечив возможность использования стандартных средств программирования для решений Many-core и их легкую интеграцию в существующую инфраструктуру. Главным образом, за счет компиляторов, позволивших использовать решения Many-core в одном кластере с обычными мультипроцессорными серверами на Xeon.

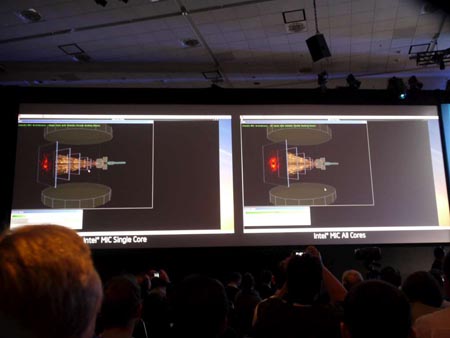

На картинке ниже показано, как идут расчеты на одном узле MIC (т.е. решениях Many-core и Multi-core) и на всех сразу (справа).

Как видно - масштабирование линейно: с ростом количества потоков (вычислительных ядер) пропорционально растет и скорость.

А ведь еще менее полугода назад много кто не верил, что такое возможно.

Затем Раттнер перешел к вопросу о том, какой уровень подготовки требуется от программистов, чтобы учитывать особенности MIC. Должен ли быть программист ниндзей в своей области?

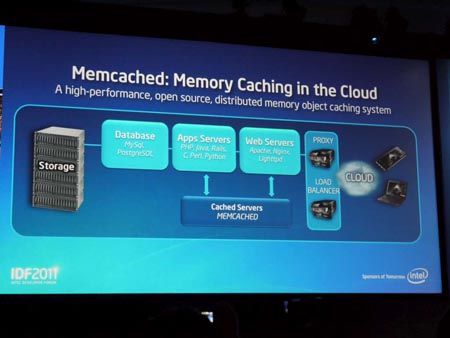

Но вначале Раттнер обозначил области, где уже сегодня можно получить положительный эффект от программирования с учетом решений MIC. Это мегадатацентры, веб-приложения, безопасность на ПК и беспроводные сети (LTE).

Задача кэширования памяти в случае с облачными сервисами является тем узким местом, при расшивке которого наблюдается впечатляющий прирост производительности. Потому что к облачным сервисам и приложениям обращаются много клиентов и их запросы легко кэшируются, т.к. повторяются.

Затем на сцену вышел Брендон Айк (Brendan Eich, создатель языка Javascript, а ныне – главный инженер Mozilla) и рассказал про библиотеку River Trail, позволяющую распараллеливать Javascript.

В обычном случае, если запустить Javascript-анимацю с расчетом движения частиц, то скорость будет низкой.

Однако при использовании распараллеливания скорость возрастает более чем в 10 раз!

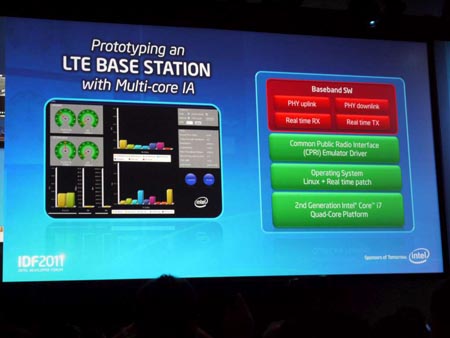

Затем Раттнер перешел к вопросу использования MIC в приложениях для станций беспроводной связи стандарта LTE.

Для решения этой задачи Intel скооперировалась с China Mobile и результаты были представлены на IDF в Пекине весной этого года.

На изображениях ниже наглядно показано, что компьютер на базе Xeon с адаптированным ПО прекрасно справляется с задачами, выполняемыми базовой станцией LTE.

Затем Ратннер перешел к задачам обеспечения безопасности на ПК.

Обратите внимание на изображения ниже: а экран компьютера по центру видны серые прямоугольники. На самом деле это превью фотографий, но их содержание зашифровано.

Авторизация осуществляется через распознавание лица пользователя через web-камеру. В данном случае (см. картинку ниже) после распознавания лица и авторизации пользователь получил доступ ко всем фотографиям - как видно все превью фото стали видны.

При этом ПО оптимизировано для конфигураций Multi-core (по сути, является многопоточным) и загрузка системы остается на приемлемом уровне.

Если же пользователь после распознавания лица и авторизации имеет ограниченный доступ, то он видит лишь те фотографии, к которым ему разрешили обращение.

Как видно, такой сценарий вполне применим в реальной жизни. Отметим также, что все это работает на текущем поколение процессоров Core.

После этого Раттнер решил заглянуть в будущее, к которому мы движемся.

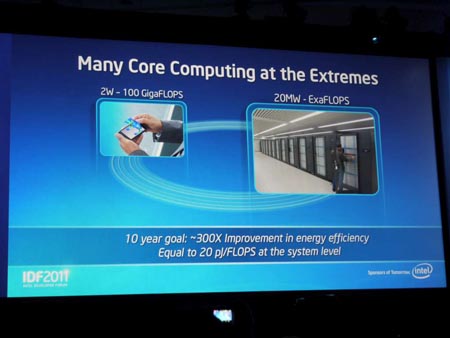

Рост вычислительной мощности за счет роста количества ядер неизбежно поднимает проблему энергоэффективности. Intel очень серьезно относится к решению этой проблемы.

Компанией поставлена задача свести энергопотребление вычислительных систем до 2 Вт на 100 Гигафлопс или 20 МВт на Экзафлопс. Задача, поставленная Intel перед собой на грядущие 10 лет: добиться 300-кратного роста энергоэффективности или 20 пДж на Флопс (на системном уровне).

На сцену вышел Шехар Бокар (Shekhar Borkar), исследователь Intel.

На данный момент положение дел с энергоэффективностью выглядит следующим образом: 200 Вт на 100 Гигафлопс. Заветное значение в 2 Вт Intel собирается достигнуть к 2018 году.

На картинке выше видно, на что расходуется энергия. Однако очевидно, что энергоэффективность процессора это не полное решение проблемы, нужно сокращать потребление и остальных компонентов системы.

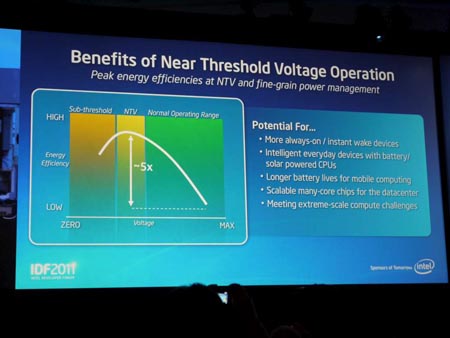

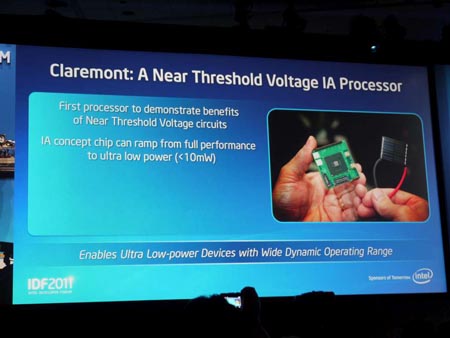

Чтобы повысить энергоэффективность вычислительных ядер, решено сокращать потери, возникающие при доставки электричества. Решение данной проблемы видится Intel в технологии Near Threshold Voltage operation, суть которой заключается в переключении транзисторов из одного состояния в другое при напряжении, близком к пороговому.

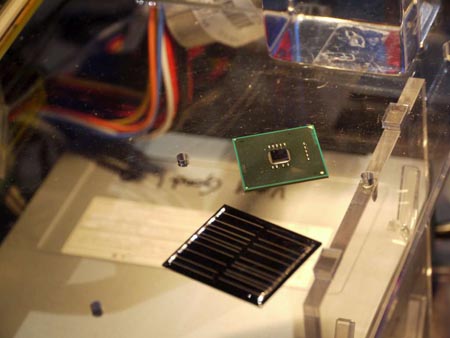

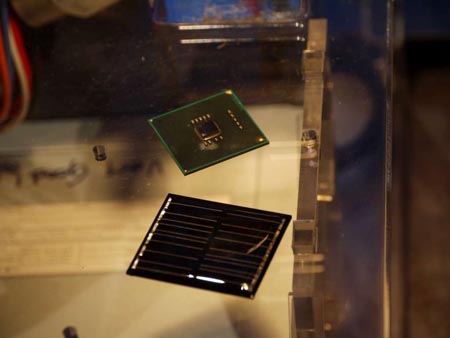

Ядро процессора, на котором все это отлаживают, условно назвали Claremont.

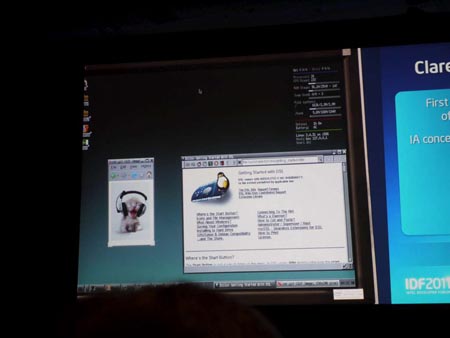

Это концепт-чип на старой архитектуре Intel Pentium, который в зависимости от нагрузки может снижать потребление до уровня в менее чем 10 мВт и при этом выполнять приложения. В данном случае на экране ПК, работавшего под управлением Ubuntu, «крутился» ролик кошки в наушниках.

Затем запустили Quake.

Интересно, что системными платами, на базе которых строились экспериментальные системы с Claremont, оказались довольно старые ASUS P2P55T. На вопрос, почему так, был получен ответ — просто потому, что там удобный регулятор напряжения, а для задач отладки этого достаточно, поэтому их и использовали.

Последней технологией, на которой заострил внимание Джастин Раттнер, стала Hyper Memory Cube. Подробнее о ней можно узнать здесь.